多标签(multi-label)数据问题常用的分类器或者分类策略

- 格式:docx

- 大小:101.95 KB

- 文档页数:3

多标签多分类算法

多标签多分类算法指的是同时将一个样本分到多个分类标签中的分类算法。

在传统的分类算法中,每个样本只能被分到一个分类标签中,而多标签多分类算法可以将一个样本分到多个分类标签中,从而更准确地描述样本的特征。

常见的多标签多分类算法包括:

1. One-vs-Rest (OvR):将每个分类标签作为一个二分类问题,训练多个分类器,将样本分到每个分类标签中的一个或多个分类器中。

2. Binary Relevance (BR):将多标签多分类问题转化为多个二分类问题,每个标签对应一个二分类问题,训练多个二分类器,将样本分到每个标签中的一个分类器中。

3. Classifier Chains (CC):将每个标签作为一个二分类问题,但是每个分类器的输入还包括前面的分类结果,训练多个二分类器,将样本按照一定的顺序传递给不同的分类器进行分类。

4. Label Powerset (LP):将每个样本的多个标签组合成一个新的标签,将多标签多分类问题转化为多分类问题,训练一个多分类器。

5. Random k-labelsets (RAkEL):随机选择k个标签子集,将多标签多分类问题转化为多个二分类问题,训练多个二分类器,根据预测结果组合成最终的标签集。

这些算法各有优缺点,适用于不同的问题和数据集。

在选择多

标签多分类算法时,需要根据实际情况考虑算法的复杂度、准确性和可扩展性等因素。

机器学习技术中的多标签分类问题解决方法在机器学习领域中,分类问题一直是一个重要的研究方向。

传统的分类问题通常是将输入样本分配到预定义的单个类别中。

然而,在现实生活中,很多样本可能属于多个不同的类别,这就引出了多标签分类问题。

多标签分类问题可以描述为给定一个样本,预测其对应的多个标签。

解决多标签分类问题的方法有很多种,下面将介绍几种常用的方法。

1. 问题转化方法问题转化方法是将多标签分类问题转化为多个独立的单标签分类问题。

常用的转化方法有二进制关联、标签级联和问题转变方法。

- 二进制关联是将每个标签视为一个独立的二分类问题。

对于每个标签,训练一个二分类模型来判断样本是否属于该标签。

这种方法简单直接,但忽略了标签之间的关联。

- 标签级联是依次训练多个分类器,每个分类器预测一个标签。

每个分类器的训练样本由前面的分类器预测的结果进行调整。

这种方法考虑了标签之间的顺序关系,但忽略了标签之间的相关性。

- 问题转变方法是将多标签分类问题转化为单标签分类问题。

根据样本的标签情况,将多标签问题转化为一系列的单标签问题。

例如,可以将多标签问题转化为多个二分类问题,每个二分类问题用来判断样本是否属于某个标签或不属于任何标签。

这种方法可以充分利用现有的单标签分类方法,但会引入标签之间的错误传播问题。

2. 算法改进方法除了问题转化方法,还有一些针对多标签分类问题的算法改进方法。

- One-vs-Rest (OvR) 方法:OvR 方法是将多标签问题转化为多个二分类问题。

对于每个标签,训练一个二分类模型以区分该标签是否出现。

最后,将每个二分类模型的预测结果组合起来得到最终的多标签分类结果。

- K-Nearest Neighbors (KNN) 方法:KNN 方法是一种基于实例的方法。

对于一个待分类的样本,KNN 方法会找出其最近的 K 个邻居,并基于这 K 个邻居的标签情况进行分类。

KNN 方法可以灵活地处理多标签问题,但对于大规模数据集可能计算开销较大。

机器学习技术中的多值分类方法比较在机器学习领域,分类是一种常见的任务,它将数据分为不同的类别。

然而,有些问题需要将数据分为多个类别,这就需要用到多值分类方法。

本文将对机器学习技术中的多值分类方法进行比较和介绍。

一、一对多方法(One-vs-Rest)一对多方法是最常见和简单的多值分类方法之一。

它将多值分类问题转化为多个二值分类问题。

具体来说,对于有N个类别的分类问题,该方法将数据分为一个正类别和N-1个负类别。

然后针对每个类别,训练一个二值分类器来判断数据是否属于该类别。

在预测阶段,将数据输入所有的二值分类器中并选择概率最高的类别作为最终分类结果。

优点:简单易实现,适用于各种分类算法。

缺点:在某些情况下,不同类别之间的相互关系可能被忽略。

二、多标签方法(Multi-label)多标签方法是另一种处理多值分类问题的方法。

与一对多方法不同,多标签方法允许一个样本属于多个类别。

这在某些场景下是非常有用的,比如图像分类中的物体识别,一个图像中可能同时包含多个物体。

常用的多标签方法包括二值化方法(Binary Relevance)和连续输出方法(Continuous Output)。

二值化方法将每个类别视为独立的二值分类问题,然后将多个二值分类结果合并成一个多标签分类结果。

而连续输出方法则使用多值回归技术,将每个类别的输出看作一个连续值,然后根据阈值将连续输出离散为多个类别。

优点:能够处理一个样本属于多个类别的情况。

缺点:类别之间的关联性可能被忽略。

三、多类别方法(Multi-class)多类别方法是直接处理多值分类问题的方法,它可以将数据划分为多个类别而不是通过转化为多个二值分类问题。

常见的多类别方法包括最大概率方法(One-vs-One)和最大边际方法(One-vs-All)。

最大概率方法将多值分类问题转化为多个二值问题,但是每次只训练两个类别之间的分类器,而不是所有类别之间的分类器。

在预测阶段,通过将数据输入所有二值分类器并计算各个类别的概率,选择概率最高的类别作为最终分类结果。

如何应对机器学习中的多类别分类问题机器学习中的多类别分类问题在实际应用中经常遇到。

在这个问题中,我们需要将数据实例分为三个或更多个不同的类别。

例如,在图像分类中,我们可能需要将图像分类为动物、交通工具和食品等多个类别。

本文将介绍一些常见的方法和技术,以帮助应对机器学习中的多类别分类问题。

首先,我们需要了解多类别分类问题的特点和挑战。

相比于二分类问题,多类别分类问题需要考虑更多的类别和更复杂的决策边界。

对于每个类别,我们需要学习到一组特定的特征和规律,以便对新的实例进行准确分类。

因此,多类别分类问题需要更复杂和精细的模型。

以下是一些应对多类别分类问题的方法和技术:1. 一对多方法(One-vs-Rest):这是一种常见的方法,它将多类别分类问题转化为多个二分类问题。

对于每个类别,我们训练一个分类器来区分该类别与其他所有类别的实例。

在预测时,我们使用这些分类器对新的实例进行分类,选择概率最高的类别作为最终分类结果。

虽然这种方法简单易懂,但是由于每个分类器只关注一对类别,可能会导致类别间的不平衡问题。

2. 多标签分类方法(Multilabel Classification):这种方法将多类别分类问题转化为多个二分类问题,每个二分类问题表示一个类别的存在与否。

不同于一对多方法,多标签分类方法允许一个实例属于多个类别。

在训练时,我们为每个类别训练一个二分类器,并且在预测时,我们可以根据需要选择一个或多个类别作为最终分类结果。

这种方法适用于存在重叠类别的情况,例如图像中的多个对象同时出现。

3. 多分类器方法(Multiple Classifier System):这种方法使用多个分类器来解决多类别分类问题。

每个分类器负责分类一部分类别,全部分类器的预测结果经过集成或投票得到最终分类结果。

这种方法可以降低每个分类器的复杂度,提高整体的分类精度。

常见的多分类器方法包括随机森林和AdaBoost等。

4. 神经网络方法(Neural Network):神经网络在多类别分类问题中表现良好。

多标签分类方法

多标签分类方法是一种机器学习技术,它可以将一个数据样本分配到多个标签中。

这种方法在现实生活中有很多应用,例如音乐、影视、图片和文本分类等。

多标签分类方法通常需要面对高维度和复杂的数据,因此需要采用一些有效的方法来处理这些数据。

传统的多标签分类方法包括二元关联规则、决策树和朴素贝叶斯等,但这些方法的准确率和效率都有所限制。

近年来,随着深度学习技术的发展,深度神经网络逐渐成为多标签分类方法的主流,其表现非常出色。

常见的深度神经网络模型包括卷积神经网络(CNN)、循环神经网络(RNN)和注意力机制(Attention)等。

除了深度神经网络,还有一些其他的多标签分类方法,例如标签传递算法、标签一致化和多输出学习等。

在选择多标签分类方法时,需要根据具体的数据特点和应用场景来选择最合适的方法。

- 1 -。

多标签分类(multi-labelclassification)综述意义⽹络新闻往往含有丰富的语义,⼀篇⽂章既可以属于“经济”也可以属于“⽂化”。

给⽹络新闻打多标签可以更好地反应⽂章的真实意义,⽅便⽇后的分类和使⽤。

难点(1)类标数量不确定,有些样本可能只有⼀个类标,有些样本的类标可能⾼达⼏⼗甚⾄上百个。

(2)类标之间相互依赖,例如包含蓝天类标的样本很⼤概率上包含⽩云,如何解决类标之间的依赖性问题也是⼀⼤难点。

(3)多标签的训练集⽐较难以获取。

⽅法⽬前有很多关于多标签的学习算法,依据解决问题的⾓度,这些算法可以分为两⼤类:⼀是基于问题转化的⽅法,⼆是基于算法适⽤的⽅法。

基于问题转化的⽅法是转化问题数据,使之使⽤现有算法;基于算法适⽤的⽅法是指针对某⼀特定的算法进⾏扩展,从⽽能够处理多标记数据,改进算法,适⽤数据。

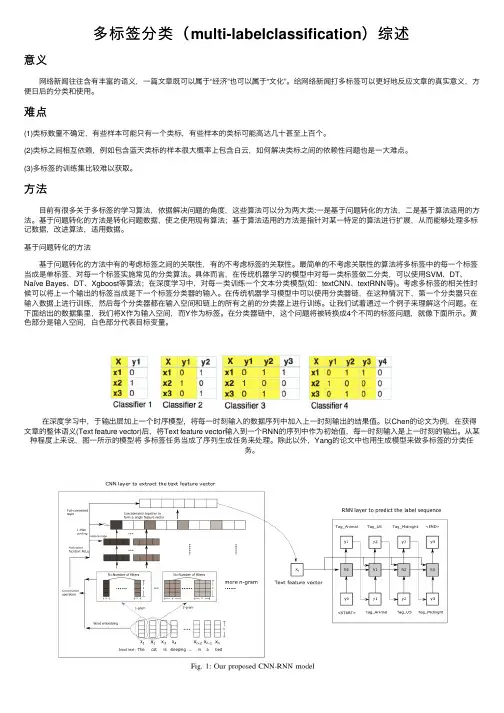

基于问题转化的⽅法基于问题转化的⽅法中有的考虑标签之间的关联性,有的不考虑标签的关联性。

最简单的不考虑关联性的算法将多标签中的每⼀个标签当成是单标签,对每⼀个标签实施常见的分类算法。

具体⽽⾔,在传统机器学习的模型中对每⼀类标签做⼆分类,可以使⽤SVM、DT、Naïve Bayes、DT、Xgboost等算法;在深度学习中,对每⼀类训练⼀个⽂本分类模型(如:textCNN、textRNN等)。

考虑多标签的相关性时候可以将上⼀个输出的标签当成是下⼀个标签分类器的输⼊。

在传统机器学习模型中可以使⽤分类器链,在这种情况下,第⼀个分类器只在输⼊数据上进⾏训练,然后每个分类器都在输⼊空间和链上的所有之前的分类器上进⾏训练。

让我们试着通过⼀个例⼦来理解这个问题。

在下⾯给出的数据集⾥,我们将X作为输⼊空间,⽽Y作为标签。

在分类器链中,这个问题将被转换成4个不同的标签问题,就像下⾯所⽰。

黄⾊部分是输⼊空间,⽩⾊部分代表⽬标变量。

在深度学习中,于输出层加上⼀个时序模型,将每⼀时刻输⼊的数据序列中加⼊上⼀时刻输出的结果值。

机器学习中的多标签分类问题解析一、引言机器学习是人工智能领域的重要分支,其在许多领域和任务中都取得了显著的成就。

多标签分类是机器学习中常见的问题之一,它在许多现实场景中都具有重要应用价值。

本文将对机器学习中的多标签分类问题进行解析和探讨。

二、多标签分类问题的定义多标签分类问题是指在给定一组输入样本的情况下,将每个样本分配给多个标签。

相比于传统的单标签分类问题,多标签分类问题的挑战在于一个样本可能属于多个类别,需要对这些类别进行准确的预测。

三、多标签分类的应用领域多标签分类在许多领域中都具有广泛的应用,包括文本分类、图像分类、音频分类等。

以文本分类为例,多标签分类可以应用于新闻分类、情感分析、垃圾邮件过滤等任务中。

在图像分类领域,多标签分类可以应用于物体识别、人脸识别等任务中。

四、传统方法在机器学习的早期阶段,研究人员主要使用传统的方法来解决多标签分类问题。

这些方法包括Binary Relevance、Label Powerset、Classifier Chains等。

这些方法将多标签分类问题转化为单标签分类问题的组合,通过建立多个分类器来预测每个标签的结果。

五、基于深度学习的方法随着深度学习的发展,越来越多的研究者将其应用于多标签分类问题中,并取得了显著的进展。

基于深度学习的方法利用深度神经网络的强大表示学习能力,能够从数据中自动学习到更加有用的特征表示。

目前,常用的基于深度学习的方法包括Multi-Layer Perceptron (MLP)、Convolutional Neural Network (CNN)、Recurrent Neural Network (RNN)等。

六、评价指标在多标签分类问题中,评价指标起着至关重要的作用。

常用的评价指标包括准确率、召回率、F1值等。

准确率衡量了预测值和真实值之间的匹配程度,召回率衡量了分类器对正样本的识别能力,F1值综合了准确率和召回率。

七、应对挑战在解决多标签分类问题时,研究人员面临着一些挑战。

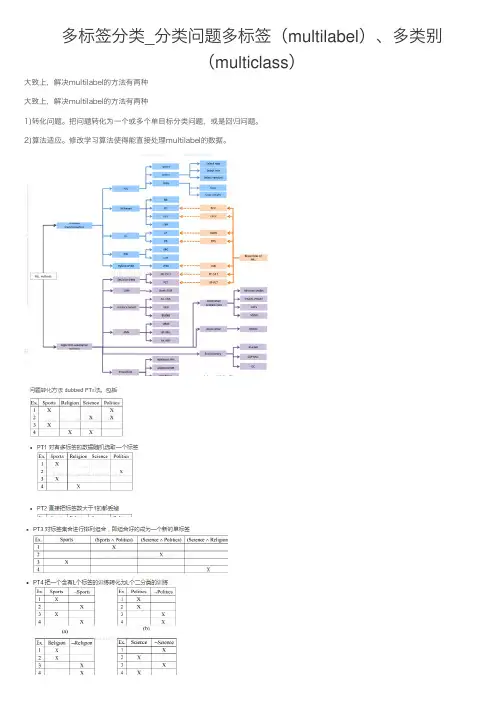

多标签分类_分类问题多标签(multilabel)、多类别(multiclass)⼤致上,解决multilabel的⽅法有两种⼤致上,解决multilabel的⽅法有两种1)转化问题。

把问题转化为⼀个或多个单⽬标分类问题,或是回归问题。

2)算法适应。

修改学习算法使得能直接处理multilabel的数据。

结论是PT3效果很好,PT4较好也应⽤⽐较⼴泛,PT6由于数据不平衡(如果标签密度太⼩会导致⼤量的-1)。

另外,以下⼏个问题是需要关注和进⼀步研究的Dimensionality Reduction 降维Label Dependence 标注依赖Active learning 主动学习Multi-instance multi-label learning (MIML) 多实例多标签Multi-view learning. 多视⾓Multi-task learning (MTL) 多任务Hierarchical multi-label classification (HMC) 多层多标签1、multilabel classification的⽤途多标签分类问题很常见, ⽐如⼀部电影可以同时被分为动作⽚和犯罪⽚, ⼀则新闻可以同时属于政治和法律,还有⽣物学中的基因功能预测问题, 场景识别问题,疾病诊断等。

2. 单标签分类在传统的单标签分类中,训练集中的每⼀个样本只有⼀个相关的标签 l ,这个标签来⾃于⼀个不重合的标签集合L,|L| > 1.当|L|=2时,这就是⼀个⼆分类问题,或⽂本和⽹页数据的过滤(filtering)问题。

当|L| > 2 时是多分类问题。

3、多标签分类问题的定义简单的说就是同⼀个实例,可以有多个标签, 或者被分为多个类。

和多分类的区别是, 多分类中每个实例只有⼀个标签。

下⾯是⼏个形式化的定义。

⽤代表样本空间,= 为有限标签集合, 我们假设中的样本实例和的⼀个⼦集相关,这个⼦集称作相关标签集。

multilabel classification多标签分类(MultilabelClassification)是机器学习中实现”标签”和”分类”之间的关联关系的一种技术。

它有助于对数据进行分析,并为业务提供有用的指导和信息。

多标签分类的概念可以追溯到19世纪,但直到20世纪末,它才被广泛采用。

多标签分类的基本思想是将数据中的项目分类成一组可以分析的标签。

简单来说,多标签分类是指把每个类别文件都分配一组标签,每个标签都表达不同的信息。

标签可以是相关词汇,关键字,属性,类别,时间戳等等。

多标签分类只有在每个类别下都有足够的标签可用时才能实现。

它还可以无限延伸,比如可以以层级结构的形式设计出更多的标签组合。

多标签分类的应用领域非常广泛,涉及计算机视觉,自然语言处理,文本挖掘,社交媒体,生物学和其他各种领域。

例如,在文本挖掘中,多标签分类可以用于对文档或评论进行标签分类;在计算机视觉领域,它可以用于图像分类;在自然语言处理中,它可以用于语义分析;社交媒体中,多标签分类可以应用于推文收集。

多标签分类有两种主要方法,一种是基于决策树的类型,另一种是基于支持向量机的类型。

决策树是一种以决策为基础的机器学习技术,通过构建决策树模型可以解释一组特征的相互关系,以达到对数据做出判断的目的。

而支持向量机的思想是,在数据空间中,可以找到一条超平面,将样本分成正确和错误两类,超平面相隔越远更容易分辨样本,可以通过不同的核函数,去拟合多维数据,来实现分类效果。

此外,多标签分类还有一些发展潜力,包括更高精度的分类性能和新的标签数据集的探索。

与传统的分类类似,多标签分类的错误也可以根据数据集的大小,模型的准确性等因素来衡量,也存在一些改进的方法,比如增强设计,模型集成,转移学习等等。

随着技术的进步,多标签分类技术将有望被应用到更多的场景中。

总之,多标签分类是机器学习中一个重要的技术,它可以将数据分类成一组标签,从而为业务提供有用的指导和信息。

“MLDS”这个缩写在不同的场景下有不同的含义,在这里我将对两种可能的含义进行详细分析:

1.多层决策系统(Multi-Level Decision System):这是一种系统设计策

略,尤其在机器学习和人工智能领域中广泛应用。

在MLDS中,问题的

决策被分解为多个层次或阶段,每个层次处理特定级别的抽象或复杂

性。

例如,在深度学习模型中,底层网络可能负责识别简单的特征,如线条、形状等,而高层网络则基于底层提取的特征做出更复杂的决策,如物体识别或场景理解。

这样做的好处是可以逐步提炼和抽象信息,提高系统的理解和决策能力。

2.多标签学习(Multi-Label Data Set)的策略:在机器学习任务中,多

标签学习是指每个样本可以同时关联多个类别标签的情况。

针对此类问题的策略包括:

o Binary Relevance (BR):将每个标签视为独立的二分类问题单独处理。

o Classifier Chains (CC):通过构建标签间的依赖关系,按顺序预测每个标签,后一个标签的预测会利用前一个标签的信息。

o Label Powerset (LP):将所有可能的标签组合视为一个新的类别,将多标签问题转化为多分类问题。

o Random K-Labelsets (RAKEL):将标签集分割成多个子集,然

后对每个子集训练一个多类分类器,最终结果是所有分类器输出

的集成。

具体使用哪种策略,需要根据实际的数据分布特性、任务需求以及计算资源等因素综合考虑。

如果你提到的“MLDS”有其他特定含义,请提供更多的上下文信息以便我能给出更准确的分析。

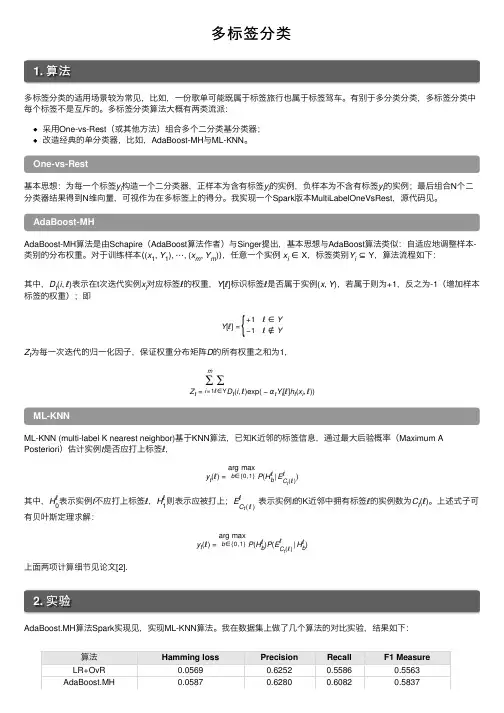

多标签分类1. 算法多标签分类的适⽤场景较为常见,⽐如,⼀份歌单可能既属于标签旅⾏也属于标签驾车。

有别于多分类分类,多标签分类中每个标签不是互斥的。

多标签分类算法⼤概有两类流派:采⽤One-vs-Rest(或其他⽅法)组合多个⼆分类基分类器;改造经典的单分类器,⽐如,AdaBoost-MH与ML-KNN。

One-vs-Rest基本思想:为每⼀个标签y i构造⼀个⼆分类器,正样本为含有标签y i的实例,负样本为不含有标签y i的实例;最后组合N个⼆分类器结果得到N维向量,可视作为在多标签上的得分。

我实现⼀个Spark版本MultiLabelOneVsRest,源代码见。

AdaBoost-MHAdaBoost-MH算法是由Schapire(AdaBoost算法作者)与Singer提出,基本思想与AdaBoost算法类似:⾃适应地调整样本-类别的分布权重。

对于训练样本⟨(x1,Y1),⋯,(x m,Y m)⟩,任意⼀个实例x i∈X,标签类别Y i⊆Y,算法流程如下:其中,D t(i,ℓ)表⽰在t次迭代实例x i对应标签ℓ的权重,Y[ℓ]标识标签ℓ是否属于实例(x,Y),若属于则为+1,反之为-1(增加样本标签的权重);即Y[ℓ]=+1ℓ∈Y −1ℓ∉YZ t为每⼀次迭代的归⼀化因⼦,保证权重分布矩阵D的所有权重之和为1,Z t=m∑i=1∑ℓ∈Y D t(i,ℓ)exp(−αt Y i[ℓ]h t(x i,ℓ))ML-KNNML-KNN (multi-label K nearest neighbor)基于KNN算法,已知K近邻的标签信息,通过最⼤后验概率(Maximum A Posteriori)估计实例t是否应打上标签ℓ,y t(ℓ)=arg maxb∈{0,1}P(Hℓb|EℓC t(ℓ))其中,Hℓ0表⽰实例t不应打上标签ℓ,Hℓ1则表⽰应被打上;EℓC t(ℓ)表⽰实例t的K近邻中拥有标签ℓ的实例数为C t(ℓ)。

多标签分类问题的解决方法多标签分类问题是机器学习和自然语言处理中常见的挑战之一。

在多标签分类问题中,每个样本可以被分配多个标签,与传统的单标签分类问题不同。

解决多标签分类问题需要使用特定的算法和技术来处理数据,从而准确地预测多个标签。

在本文中,我们将探讨几种常用的方法来解决多标签分类问题。

这些方法包括二进制方法、递归方法、问题转化方法和集成方法。

首先,我们来介绍二进制方法。

在这种方法中,将多标签分类问题转化为多个独立的二进制分类问题。

对于每个标签,训练一个二进制分类器来预测该标签的存在与否。

这种方法的优点是简单易懂,易于理解和实现。

然而,它忽略了标签之间的相关性,可能导致预测结果不够准确。

接下来,我们讨论递归方法。

递归方法是基于决策树的算法,通过递归地划分样本空间来预测多个标签。

该方法考虑了标签之间的相互关系,并通过递归地划分样本子集来预测每个标签。

递归方法的优点是能够准确地预测相关性较强的标签。

然而,该方法在处理大规模数据集时可能效率较低。

另一种常见的方法是问题转化方法。

在这种方法中,将多标签分类问题转化为其他类型的问题,例如多类分类或回归问题。

然后使用单标签分类或回归方法来解决转化后的问题。

问题转化方法的优点是可以使用各种现有的分类或回归算法来解决多标签分类问题。

然而,这种方法可能忽略了标签之间的相关性,导致预测结果不准确。

最后,我们介绍集成方法。

集成方法将多个独立的分类器组合起来,通过投票或权重相结合的方式来预测多个标签。

这种方法的优点是能够利用不同分类器之间的互补性,提高分类性能。

集成方法可以使用各种集成学习算法,例如随机森林、梯度提升树等。

然而,集成方法可能需要更多的计算资源和训练时间。

除了以上提到的方法,还有其他一些变种方法可以解决多标签分类问题,例如基于图的方法、深度学习方法等。

这些方法在不同的场景下可能具有更好的性能和效果。

选择合适的方法取决于数据集的特征、分类任务的复杂性和可用的计算资源等因素。

基于机器学习的多标签分类技术研究随着社会信息的爆炸式增长,人类已经无法通过单一指标进行任务分类。

然而多标签分类技术,可以在一个对象上应用多个标签,为人类解决了这个问题。

近年来随着机器学习技术的快速发展,基于机器学习的多标签分类(Multi-Label Classification,MLC)技术也得到了广泛的发展和应用。

一、多标签分类技术概述多标签分类是指对每个对象分别预测一个或多个类别,每个对象都有一组标签,这些标签可以是类别、属性、概念等。

多标签分类技术的最终目标是基于输入的多个标签来为新的实例预测多个可能的标签。

多标签分类技术在各个领域都得到了广泛的应用,如文本分类、图像标注、视频分类等。

多标签分类技术包括两个方面:标记表示、学习算法。

标记表示是指将标签或标签与特征的组合表示为统一的向量形式,学习算法是指利用机器学习或统计学习等方法将有标记表示的数据训练成模型,从而实现对新数据的多标签分类。

二、多标签分类技术中的问题在多标签分类过程中,存在一些麻烦的问题需要我们解决:1、标签依赖关系问题在多标签分类中,不同的标签可能存在依赖关系,如文本分类中可能同时出现“计算机”和“编程语言”两个标签。

解决标签依赖关系问题是多标签分类中的核心问题。

2、标签稀疏性问题在大规模多标签分类场景下,由于标签之间的相关性,标签的数量是非常庞大的,但每个数据点每个标签上的标注数据都是十分稀疏的,这使得训练一个有良好泛化能力的多标签分类模型变得更加困难。

3、多标签分类性能评估问题与传统的单标签分类问题不同,多标签分类问题的评估指标十分重要。

在传统的精度(Accuracy)指标的基础上,还可以使用其他的指标,如Hamming Loss,Macro-F1等。

三、常用的多标签分类技术在多标签分类技术中,主要有以下几种方法:1、One-Vs-AllOne-Vs-All 方法也称为 OvA,其思想是将多标签分类问题转化为多个二分类问题。

multi-labelimageclassification:多标签图像分类总结多标签图像分类总结⽬录1.简介2.现有数据集和评价指标3.学习算法4.总结(现在存在的问题,研究发展的⽅向)简介 传统监督学习主要是单标签学习,⽽现实⽣活中⽬标样本往往⽐较复杂,具有多个语义,含有多个标签。

荷兰城市图⽚ (1)传统单标签分类 city(person) (2)多标签分类 city , river, person, European style (3)⼈的认知 两个⼈在河道边⾛路 欧洲式建筑,可猜测他们在旅游 天很蓝,应该是晴天但不是很晒 相⽐较⽽⾔,单标签分类需要得到的信息量最少,⼈的认知得到的信息量最多,多标签分类在它们两者之间 问题描述: X=R d表⽰d维的输⼊空间,Y={y1,y2,...,yq}表⽰带有q个可能的标签的标签空间 训练集D={(x i,y i)|1≤ i ≤ m},m表⽰训练集的⼤⼩,上标表⽰样本序数 x i∈ X,是⼀个d维向量。

y i⊆Y,是Y的⼀个标签⼦集 任务就是学习要学习⼀个多标签集的分类器h(x),预测h(x)⊆Y作为x的正确标签集。

常见的做法是学习⼀个衡量x和y相关性的函数f(x,y j),希望f(x,y j1)>(x,y j2),其中y j1∈y,y j2∉y。

现有数据集和评价指标1.现有数据集 NUS-WIDE 是⼀个带有⽹络标签标注的图像数据,包含来⾃⽹站的 269648张图像,5018类不同的标签。

从这些图像中提取的六种低级特征,包括64-D颜⾊直⽅图,144-D颜⾊相关图,73-D边缘⽅向直⽅图,128-D⼩波纹理,225-D块颜⾊矩和500-D 基于SIFT描述的词袋。

⽹址:.sg/research/NUS-WIDE.htm MS-COCO 数据集包括91类⽬标,328,000影像和2,500,000个label。

所有的物体实例都⽤详细的分割mask进⾏了标注,共标注了超过 500,000 个物体实体. ⽹址:/ PASCAL VOC数据集该挑战的主要⽬标是在真实场景中识别来⾃多个视觉对象类的对象。

multi-label informed feature selection多标签(Multi-label)通常指的是一个样本可以同时属于多个类别,与传统的单标签分类不同。

而“信息驱动的特征选择”则是在特征选择的过程中,利用相关的信息、先验知识或领域专业知识来引导选择具有重要意义的特征。

将这两者结合起来,就形成了多标签信息驱动特征选择(Multi-label Informed Feature Selection)。

多标签问题简介:传统的分类问题通常是单标签分类,即每个样本只能属于一个类别。

而在现实场景中,很多问题都是多标签问题,一个样本可能属于多个不同的类别。

例如,在图像分类中,一张图像可能同时包含猫和树,而不是仅仅属于一个类别。

多标签问题更贴近实际应用,因为很多事物不是非黑即白,而是存在多个方面和属性。

信息驱动的特征选择简介:特征选择是在建模过程中选择最相关、最具代表性的特征,以提高模型的性能和泛化能力。

信息驱动的特征选择则是通过引入领域知识、先验信息或其他相关信息,来指导选择更有意义的特征。

这有助于过滤掉无关紧要的特征,提高模型的解释性和泛化性。

多标签信息驱动特征选择的挑战:1.标签相关性:在多标签问题中,不同的标签可能存在相关性。

选择一个标签的特征可能同时影响其他相关的标签,这增加了特征选择的难度。

2.维度爆炸:多标签问题通常伴随着高维度的特征空间,而维度爆炸会导致特征选择的计算复杂度增加,需要更高效的算法和方法。

3.信息不平衡:不同标签的样本分布可能不平衡,一些标签可能拥有较少的样本,这需要在特征选择时考虑样本的分布情况。

多标签信息驱动特征选择的方法:1.相关性分析:分析不同标签之间的相关性,以了解它们之间的联系,从而更好地选择具有代表性的特征。

2.信息增益:基于信息增益或其他信息论方法,评估每个特征对于每个标签的贡献,选择对标签有更大信息增益的特征。

3.领域专家知识:利用领域专家的知识,引入先验信息,指导特征选择的过程,使得选择的特征更符合实际需求。

多分类及多标签分类算法单标签⼆分类问题单标签⼆分类算法原理单标签⼆分类这种问题是我们最常见的算法问题,主要是指label标签的取值只有两种,并且算法中只有⼀个需要预测的label标签;直⽩来讲就是每个实例的可能类别只有两种(A or B);此时的分类算法其实是在构建⼀个分类线将数据划分为两个类别。

常见的算法:Logistic、SVM、KNN、决策树等。

Logistic算法原理单标签多分类问题单标签多分类问题其实是指待预测的label标签只有⼀个,但是label标签的取值可能有多种情况;直⽩来讲就是每个实例的可能类别有K种(t1 ,t2 ,...t k ,k≥3);常见算法:Softmax、KNN、决策树等;在实际的⼯作中,如果是⼀个多分类的问题,我们可以将这个待求解的问题转换为⼆分类算法的延伸,即将多分类任务拆分为若⼲个⼆分类任务求解,具体的策略如下:One-Versus-One(ovo):⼀对⼀One-Versus-All / One-Versus-the-Rest(ova/ovr):⼀对多Error Correcting Output codes(纠错码机制):多对多ovo原理:将K个类别中的两两类别数据进⾏组合,然后使⽤组合后的数据训练出来⼀个模型,从⽽产⽣K(K-1)/2个分类器,将这些分类器的结果进⾏融合,并将分类器的预测结果使⽤多数投票的⽅式输出最终的预测结果值。

def ovo(datas,estimator):'''datas[:,-1]为⽬标属性'''import numpy as npY = datas[:,-1]X = datas[:,:-1]y_value = np.unique(Y)#计算类别数⽬k = len(y_value)modles = []#将K个类别中的两两类别数据进⾏组合,并对y值进⾏处理for i in range(k-1):c_i = y_value[i]for j in range(i+1,k):c_j = y_value[j]new_datas = []for x,y in zip(X,Y):if y == c_i or y == c_j:new_datas.append(np.hstack((x,np.array([2*float(y==c_i)-1]))))new_datas = np.array(new_datas)algo = estimator()modle = algo.fit(new_datas)modles.append([(c_i,c_j),modle])return modlesdef argmaxcount(seq):'''计算序列中出现次数最多元素''''''超极简单的⽅法'''# from collections import Counter# return Counter(seq).values[0]'''稍微复杂的'''# dict_num = {}# for item in seq:# if item not in dict_num.keys():# dict_num[item] = seq.count(item)# # 排序# import operator# sorted(dict_num.items(), key=operator.itemgetter(1))'''字典推导'''dict_num = dict_num = {i: seq.count(i) for i in set(seq)}def ovo_predict(X,modles):import operatorresult = []for x in X:pre = []for cls,modle in modles:pre.append(cls[0] if modle.predict(x) else cls[1])d = {i: pre.count(i) for i in set(pre)} #利⽤集合的特性去重result.append(sorted(d.items(),key=operator.itemgetter(1))[-1][0])return resultfrom sklearn import datasetsfrom sklearn.multiclass import OneVsOneClassifierfrom sklearn.svm import LinearSVCfrom sklearn.neighbors import KNeighborsClassifier# 加载数据iris = datasets.load_iris()# 获取X和yX, y = iris.data, iris.targetprint("样本数量:%d, 特征数量:%d" % X.shape)# 设置为3,只是为了增加类别,看⼀下ovo和ovr的区别y[-1] = 3# 模型构建clf = OneVsOneClassifier(LinearSVC(random_state=0))# clf = OneVsOneClassifier(KNeighborsClassifier())# 模型训练clf.fit(X, y)# 输出预测结果值print(clf.predict(X))print("效果:{}".format(clf.score(X, y)))# 模型属性输出k = 1for item in clf.estimators_:print("第%d个模型:" % k, end="")print(item)k += 1print(clf.classes_)View Codeovr原理:在⼀对多模型训练中,不是两两类别的组合,⽽是将每⼀个类别作为正例,其它剩余的样例作为反例分别来训练K个模型;然后在预测的时候,如果在这K个模型中,只有⼀个模型输出为正例,那么最终的预测结果就是属于该分类器的这个类别;如果产⽣多个正例,那么则可以选择根据分类器的置信度作为指标,来选择置信度最⼤的分类器作为最终结果,常见置信度:精确度、召回率。

如何处理多标签分类问题在神经网络中在神经网络中处理多标签分类问题是一个具有挑战性的任务。

多标签分类是指将一个样本分配到多个标签中的问题。

与传统的单标签分类不同,多标签分类需要考虑样本可能属于多个类别的情况。

在处理多标签分类问题时,我们需要选择合适的神经网络架构和算法。

以下是一些常用的方法:1. 多标签二进制分类:这种方法将每个标签视为一个独立的二进制分类问题。

对于每个标签,我们可以使用逻辑回归或多层感知机等经典的分类算法。

这种方法简单直接,但是忽略了标签之间的相关性。

2. One-Vs-Rest分类:这种方法将每个标签视为一个独立的二分类问题。

对于每个标签,我们训练一个二分类器来判断样本是否属于该标签。

这种方法考虑了标签之间的相关性,但是可能会导致样本被分配到多个标签中。

3. 多标签分类器:这种方法使用一个单独的分类器来预测多个标签。

常见的多标签分类器包括k最近邻算法、决策树和随机森林等。

这种方法考虑了标签之间的相关性,并且可以为每个标签分配一个概率。

4. 神经网络模型:神经网络模型在处理多标签分类问题时表现出色。

例如,卷积神经网络(CNN)和循环神经网络(RNN)可以用于图像和文本数据的多标签分类。

此外,注意力机制和Transformer等模型也可以应用于多标签分类问题。

在处理多标签分类问题时,我们还需要考虑数据的不平衡性和噪声。

以下是一些处理方法:1. 数据平衡:多标签数据集中,不同标签的样本数量可能存在不平衡。

我们可以使用过采样或欠采样等方法来平衡数据集,以避免某些标签的样本数量过多或过少。

2. 标签相关性:标签之间可能存在相关性,我们可以使用相关矩阵或相关网络来捕捉标签之间的关系。

这些信息可以帮助我们更好地预测每个标签的概率。

3. 噪声处理:多标签数据集中可能存在噪声,例如标签错误或缺失。

我们可以使用标签平滑或标签修正等方法来处理噪声,以提高模型的性能。

在实际应用中,我们还可以结合迁移学习和模型融合等技术来进一步提高多标签分类的性能。

多标签(multi-label)数据问题常用的分类器或者分类策略

多标记分类和传统的分类问题相比较,主要难点在于以下两个方面:

(1)类标数量不确定,有些样本可能只有一个类标,有些样本的类标可能高达几十甚至上百个。

(2)类标之间相互依赖,例如包含蓝天类标的样本很大概率上包含白云,如何解决类标之间的依赖性问题也是一大难点。

对于多标记学习领域的研究,国外起步较早,起源于2000年Schapire R E等人提出的基于boost方法的文本多分类,著名的学者有G Tsoumakas、Eyke Hüllermeier、Jesse Read,Saso Dzeroski等等。

在国内,南京大学的周志华和张敏灵和哈工大的叶允明等等学者在这一领域较都有很好研究成果。

目前有很多关于多标签的学习算法,依据解决问题的角度,这些算法可以分为两大类:一是基于问题转化(Problem Transformation)的方法,二是基于算法适应的方法和算法适应方法(Algorithm Adaptation)。

基于问题转化的多标记分类是转化问题数据,使之适用现有算法;基于算法适应的方法是指针对某一特定的算法进行扩展,从而能够直接处理多标记数据,改进算法,适应数据。

基于这两种思想,目前已经有多种相对成熟的算法被提出,如下图所示:

问题转化方法(Problem Transformation):该类方法的基本思想是通过对多标记训练样本进行处理,将多标记学习问题转换为其它已知的学习问题进行求解。

代表性学习算法LP[1],Binary Relevance[2],Calibrated Label Ranking[3],Random k-labelsets[4]。

总体来说,这类方法有考虑类标之间的联系,但是对于类标较多、数据量较大的数据集,这类方法的计算复杂度是一个很明显的缺陷。

算法适应方法与问题转化方法不同,问题转化方法是将多标记问题转化成一个或者多个单类标问题,算法适应方法是在多标记的基础上研究算法。

近年来,用于多标记的算法适应的算法越来越多,代表性学习算法ML-kNN[5],Rank-SVM[6],LEAD[7],CML。

对于分类策略,基于考察标记之间相关性的不同方式,已有的多标记学习算法的策略思路大致可以分为以下三类[8]:

a) “一阶(first-order)”策略:该类策略通过逐一考察单个标记而忽略标记之间的相关性,如将多标记学习问题分解为个独立的二类分类问题,从而构造多标记学习系统。

该类方法效率较高且实现简单,但由于其完全忽略标记之间可能存在的相关性,其系统的泛化性能往往较低。

b) “二阶(second-order)”策略:该类策略通过考察两两标记之间的相关性,如相关标记与无关标记之间的排序关系,两两标记之间的交互关系等等,从而构造多标记学习系统。

该类方法由于在一定程度上考察了标记之间的相关性,因此其系统泛化性能较优。

c) “高阶(high-order)”策略:该类策略通过考察高阶的标记相关性,如处理任一标记对其它所有标记的影响,处理一组随机标记集合的相关性等等,从而构造多标记学习系统。

该类方法虽然可以较好地反映真实世界问题的标记相关性,但其模型复杂度往往过高,难以处理大规模学习问题。

[1] Madjarov G, Kocev D, Gjorgjevikj D, et al. An extensive experimental comparison

of methods for multi-label learning[J]. Pattern Recognition, 2012, 45(9): 3084-3104.

[2] Boutell M R, Luo J, Shen X, Brown C M. Learning multi-label scene classification.

Pattern Recognition, 2004, 37(9): 1757-1771.

[3] Fürnkranz J, Hüllermeier E, LozaMencía E, Brinker K. Multilabel classification via

calibrated label ranking. Machine Learning, 2008, 73(2): 133-153.

[4] Tsoumakas G, Vlahavas I. Random k-labelsets: An ensemble method for multilabel

classification. In: Kok J N, Koronacki J, de Mantaras R L, Matwin S, Mladenič D, Skowron A, eds. Lecture Notes in Artificial Intelligence 4701, Berlin: Spr inger,

2007, 406-417.

[5] Zhang M-L, Zhou Z-H. ML-kNN: A lazy learning approach to multi-label learning.

Pattern Recognition, 2007, 40(7): 2038-2048.

[6] Elisseeff A, Weston J. A kernel method for multi-labelled classification. In: Dietterich

T G, Becker S, Ghahramani Z, eds. Advances in Neural Information Processing Systems 14 (NIPS’01), Cambridge, MA: MIT Press, 2002, 681-687.

[7] Zhang M-L, Zhang K. Multi-label learning by exploiting label dependency. In: Pro

ceedings of the 16th ACM SIGKDD International Conference on Knowledge Discov ery and Data Mining (KDD’10), Washington, D. C., 2010, 999-1007.

[8] Zhang M L, Zhang K. Multi-label learning by exploiting label dependency[C]// ACM

SIGKDD International Conference on Knowledge Discovery and Data Mining.

ACM, 2010:999-1008.。