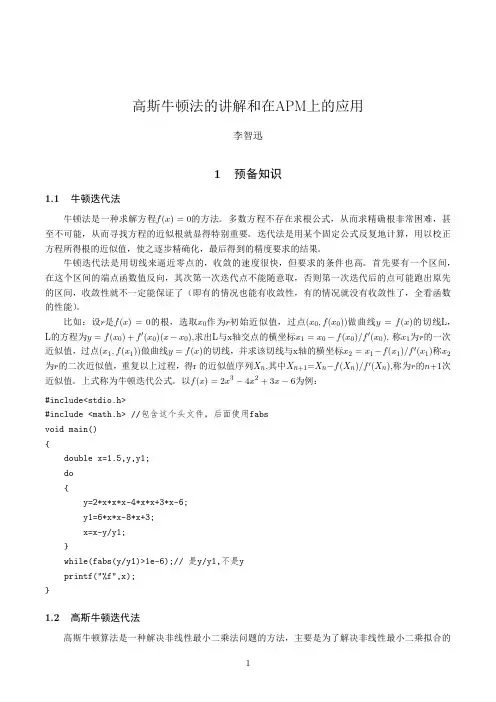

GaussNewton

- 格式:pdf

- 大小:154.58 KB

- 文档页数:17

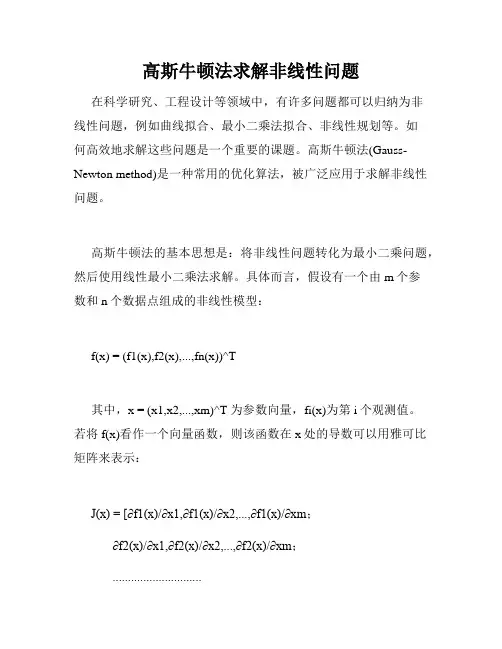

高斯牛顿法求解非线性问题在科学研究、工程设计等领域中,有许多问题都可以归纳为非线性问题,例如曲线拟合、最小二乘法拟合、非线性规划等。

如何高效地求解这些问题是一个重要的课题。

高斯牛顿法(Gauss-Newton method)是一种常用的优化算法,被广泛应用于求解非线性问题。

高斯牛顿法的基本思想是:将非线性问题转化为最小二乘问题,然后使用线性最小二乘法求解。

具体而言,假设有一个由m个参数和n个数据点组成的非线性模型:f(x) = (f1(x),f2(x),...,fn(x))^T其中,x = (x1,x2,...,xm)^T 为参数向量,fi(x)为第i个观测值。

若将f(x)看作一个向量函数,则该函数在x处的导数可以用雅可比矩阵来表示:J(x) = [∂f1(x)/∂x1,∂f1(x)/∂x2,...,∂f1(x)/∂xm;∂f2(x)/∂x1,∂f2(x)/∂x2,...,∂f2(x)/∂xm;.............................∂fn(x)/∂x1,∂fn(x)/∂x2,...,∂fn(x)/∂xm]雅可比矩阵是一个n×m的矩阵,表示参数向量对向量函数的导数。

对于非线性模型,其导数难以直接求解,因此需要采用近似方法。

高斯牛顿法采用的是一阶泰勒展开式,将非线性模型在x 处展开:f(x+Δx) ≈ f(x) + J(x)Δx其中,Δx为参数向量x的增量,即x+Δx为新的参数向量。

将上式两边平方,再加上一个权重矩阵W,得到最小二乘问题:min Δx ||sqrt(W)(f(x+Δx)-f(x))||^2上式中,||·||表示向量的欧几里得长度,W为一个n×n的对角矩阵,其作用是赋予不同观测值不同的权重。

将上式展开,得到:min Δx (f(x)+J(x)Δx-y)^TW(f(x)+J(x)Δx-y)其中,y为n×1的向量,表示原始数据点。

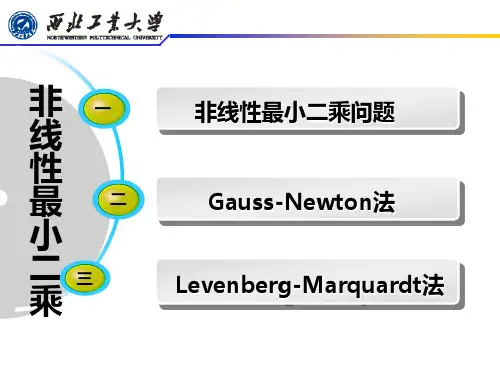

高斯牛顿法高斯牛顿法(Gauss-Newton method)是一种用于非线性最小二乘问题求解的数值优化方法。

它结合了高斯消元法和牛顿迭代法的特点,旨在寻找函数最小化的参数。

在本文中,我们将介绍高斯牛顿法的原理、步骤和应用。

原理在非线性最小二乘问题中,我们需要找到使得函数残差平方和最小的参数向量。

该问题通常表示为:equation其中,是残差向量函数,是参数向量。

高斯牛顿法通过迭代的方式逼近最优解,其主要思想是将非线性问题转化为一系列的线性问题,并通过逐步线性化来求解。

具体而言,它采用牛顿法中的线性化和高斯消元法来解决线性问题。

步骤高斯牛顿法的求解过程可以分为以下几个步骤:1.初始化参数:首先,需要对参数向量进行初始化,通常可以使用一些启发式的方法得到初始值。

2.线性化:在每一次迭代中,将残差函数进行线性化。

这意味着将非线性问题转化为一个线性问题,使其更易于求解。

线性化通常通过泰勒级数展开来实现。

3.构造线性方程组:通过线性化后的函数,可以构造出一个线性方程组。

该方程组的解将作为当前迭代中的修正量,用于更新参数向量。

4.求解线性方程组:使用高斯消元法等数值方法求解线性方程组,得到修正量。

5.参数更新:利用修正量更新参数向量,得到新的参数估计。

6.收敛判断:检查参数估计是否已经收敛。

如果满足收敛准则,则停止迭代;否则,返回第2步继续迭代。

应用高斯牛顿法在许多领域都有广泛的应用。

其中一个典型的应用是在计算机视觉中的相机标定问题,即通过已知的图像和相机参数来估计相机的内部和外部参数。

高斯牛顿法可以通过最小化重投影误差来估计这些参数,从而获得更准确的相机模型。

此外,高斯牛顿法还在机器学习中被广泛使用,例如参数估计和优化算法。

通过最小化损失函数,可以使用高斯牛顿法来确定模型中的参数,进而提高模型的拟合能力。

总结高斯牛顿法是一种有效的求解非线性最小二乘问题的数值优化方法。

它通过线性化和高斯消元法的结合,能够提供较快的收敛速度和较高的求解精度。

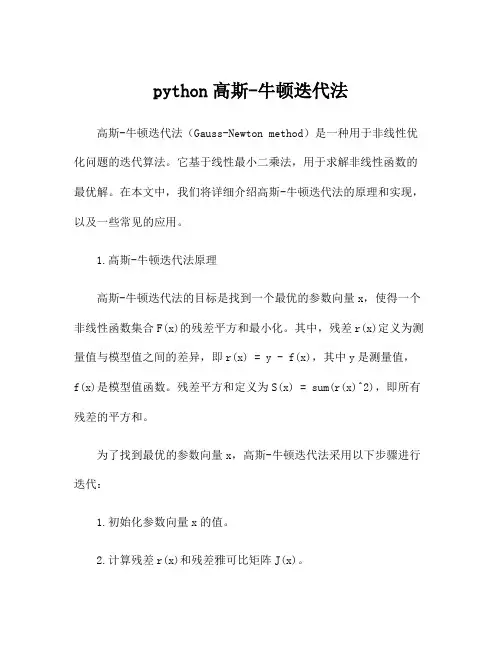

python高斯-牛顿迭代法高斯-牛顿迭代法(Gauss-Newton method)是一种用于非线性优化问题的迭代算法。

它基于线性最小二乘法,用于求解非线性函数的最优解。

在本文中,我们将详细介绍高斯-牛顿迭代法的原理和实现,以及一些常见的应用。

1.高斯-牛顿迭代法原理高斯-牛顿迭代法的目标是找到一个最优的参数向量x,使得一个非线性函数集合F(x)的残差平方和最小化。

其中,残差r(x)定义为测量值与模型值之间的差异,即r(x) = y - f(x),其中y是测量值,f(x)是模型值函数。

残差平方和定义为S(x) = sum(r(x)^2),即所有残差的平方和。

为了找到最优的参数向量x,高斯-牛顿迭代法采用以下步骤进行迭代:1.初始化参数向量x的值。

2.计算残差r(x)和残差雅可比矩阵J(x)。

3.求解线性最小二乘问题J(x)^T J(x) dx = -J(x)^T r(x),其中dx是参数的增量。

4.更新参数向量x = x + dx。

5.重复步骤2-4,直到满足停止条件(如参数更新小于某个阈值)。

2.高斯-牛顿迭代法的实现高斯-牛顿迭代法的实现需要计算残差和雅可比矩阵,通过求解线性最小二乘问题来更新参数向量。

以下是一个简单的实现示例:```pythonimport numpy as npdef gauss_newton(x0, y, f, f_prime, max_iterations=100,tol=1e-6):x = x0for i in range(max_iterations):r = y - f(x)J = f_prime(x)dx = np.linalg.lstsq(J, -r, rcond=None)[0]x = x + dxif np.linalg.norm(dx) < tol:breakreturn x```在上述代码中,x0是参数向量的初始值,y是测量值,f是模型值函数,f_prime是模型值函数的导数。

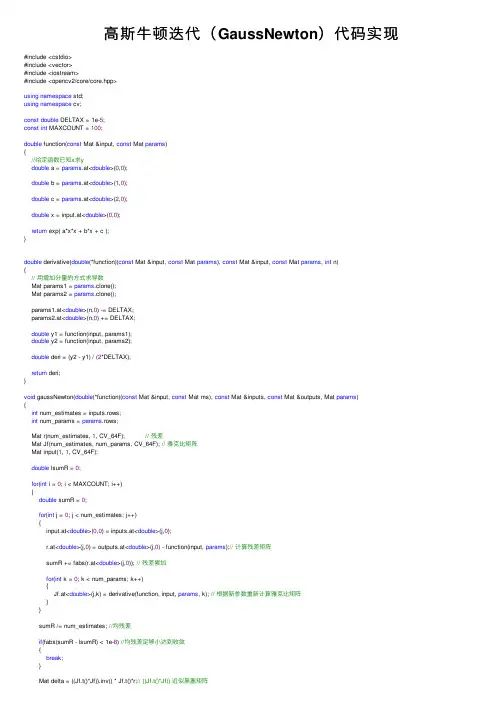

⾼斯⽜顿迭代(GaussNewton)代码实现#include <cstdio>#include <vector>#include <iostream>#include <opencv2/core/core.hpp>using namespace std;using namespace cv;const double DELTAX = 1e-5;const int MAXCOUNT = 100;double function(const Mat &input, const Mat params){//给定函数已知x求ydouble a = params.at<double>(0,0);double b = params.at<double>(1,0);double c = params.at<double>(2,0);double x = input.at<double>(0,0);return exp( a*x*x + b*x + c );}double derivative(double(*function)(const Mat &input, const Mat params), const Mat &input, const Mat params, int n){// ⽤增加分量的⽅式求导数Mat params1 = params.clone();Mat params2 = params.clone();params1.at<double>(n,0) -= DELTAX;params2.at<double>(n,0) += DELTAX;double y1 = function(input, params1);double y2 = function(input, params2);double deri = (y2 - y1) / (2*DELTAX);return deri;}void gaussNewton(double(*function)(const Mat &input, const Mat ms), const Mat &inputs, const Mat &outputs, Mat params){int num_estimates = inputs.rows;int num_params = params.rows;Mat r(num_estimates, 1, CV_64F); // 残差Mat Jf(num_estimates, num_params, CV_64F); // 雅克⽐矩阵Mat input(1, 1, CV_64F);double lsumR = 0;for(int i = 0; i < MAXCOUNT; i++){double sumR = 0;for(int j = 0; j < num_estimates; j++){input.at<double>(0,0) = inputs.at<double>(j,0);r.at<double>(j,0) = outputs.at<double>(j,0) - function(input, params);// 计算残差矩阵sumR += fabs(r.at<double>(j,0)); // 残差累加for(int k = 0; k < num_params; k++){Jf.at<double>(j,k) = derivative(function, input, params, k); // 根据新参数重新计算雅克⽐矩阵}}sumR /= num_estimates; //均残差if(fabs(sumR - lsumR) < 1e-8) //均残差⾜够⼩达到收敛{break;}Mat delta = ((Jf.t()*Jf)).inv() * Jf.t()*r;// ((Jf.t()*Jf)) 近似⿊塞矩阵params += delta;lsumR = sumR;}}int main(){// F = exp ( a*x*x + b*x + c )int num_params = 3;Mat params(num_params, 1, CV_64F);//abc参数的实际值params.at<double>(0,0) = 1.0; //aparams.at<double>(1,0) = 2.0; //bparams.at<double>(2,0) = 1.0; //ccout<<"real("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; int N = 100;double w_sigma = 1.0; // 噪声Sigma值cv::RNG rng; // OpenCV随机数产⽣器Mat estimate_x(N, 1, CV_64F);Mat estimate_y(N, 1, CV_64F);for ( int i = 0; i < N; i++ ){double x = i/100.0;estimate_x.at<double>(i,0) = x;Mat paramX(1, 1, CV_64F);paramX.at<double>(0,0) = x;estimate_y.at<double>(i,0) = function(paramX, params) + rng.gaussian ( w_sigma );}//abc参数的初值params.at<double>(0,0) = 0; //aparams.at<double>(1,0) = 0; //bparams.at<double>(2,0) = 0; //ccout<<"init("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; gaussNewton(function, estimate_x, estimate_y, params);cout<<"result("<<"a:"<< params.at<double>(0,0) <<" b:"<< params.at<double>(1,0) << " c:"<< params.at<double>(2,0) << ")"<< endl; return0;}# Project: GaussNewtonDemo## All rights reserved.cmake_minimum_required( VERSION 2.6 )cmake_policy( SET CMP0004 OLD )### initialize project ###########################################################################################SET(CMAKE_BUILD_TYPE "Debug")SET(CMAKE_CXX_FLAGS_DEBUG "$ENV{CXXFLAGS} -O0 -Wall -g2 -ggdb")SET(CMAKE_CXX_FLAGS_RELEASE "$ENV{CXXFLAGS} -O3 -Wall")project(GaussNewtonDemo)find_package(Eigen3 REQUIRED)find_package(OpenCV REQUIRED)set(CMAKE_INSTALL_PREFIX /usr)set(BUILD_SHARED_LIBS on)set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -fPIC -O0")include_directories(${EIGEN3_INCLUDE_DIR}${OpenCV_INCLUDE_DIR})add_definitions( "-DPREFIX=\"${CMAKE_INSTALL_PREFIX}\"" )### global default options #######################################################################################set(SOURCESmain.cpp)add_executable(GaussNewtonDemo ${SOURCES}) TARGET_LINK_LIBRARIES( GaussNewtonDemo ${OpenCV_LIBS} )。

gaussnewton法

高斯牛顿法是一种非线性最小二乘问题求解方法,它基于最小二乘中误差的平方和最小的原则,通过迭代优化参数,使得误差达到最小的方法。

同样也是一种梯度下降方法,但与传统的梯度下降法不同,高斯牛顿法可以适用于非线性问题,而且相对于梯度下降法有更快的收敛速度。

高斯牛顿法主要涉及到雅可比矩阵和海森矩阵的计算。

雅可比矩阵的求解用于求解问题的初始值,并在每次迭代时计算当前值,用于计算海森矩阵。

海森矩阵是损失函数的Hessian矩阵,是损失函数的二阶导数矩阵,其求解需要数值方法求解。

然后利用计算出的雅可比矩阵和海森矩阵进行迭代更新,不断逼近最优解。

在实际问题中,高斯牛顿法通常比梯度下降方法更有效,其因为高斯牛顿法能够利用二阶导数信息(海森矩阵)更好的逼近函数的曲率,因此将收敛速度大大提高。

但同时,高斯牛顿法缺点也明显:需要计算雅可比矩阵和海森矩阵,这会涉及到大量的矩阵运算,如果数据量很大则计算量也会很大;另外,当初始值很远离最终的最优值时,可能会出现海森矩阵为负定的情况,导致无法收敛。

因此,在实际使用中,需要根据具体问题的特征选择算法。

对于数据量较小,但是需要求解非线性参数的问题,高斯牛顿法是一种不错的选择,但在数据量较大的问题中,或存在局部极小值的情况下,可能需要选择其他算法进行求解。

总之,高斯牛顿法是一种广泛应用于非线性最小二乘问题的近似最优化算法。

通

过迭代优化参数,让误差达到最小,从而得到参数的最优估计值。

高斯牛顿法在实际问题中有很多应用,如数学建模、机器学习、计算机视觉、信号处理等领域都有广泛应用。

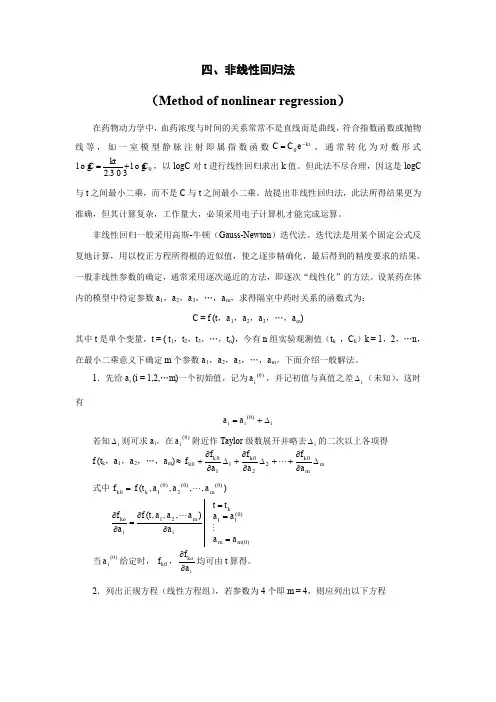

四、非线性回归法(Method of nonlinear regression )在药物动力学中,血药浓度与时间的关系常常不是直线而是曲线,符合指数函数或抛物线等,如一室模型静脉注射即属指数函数kt e C C -=0,通常转化为对数形式0l o g 303.2l o g C kt C +=,以log C 对t 进行线性回归求出k 值。

但此法不尽合理,因这是log C 与t 之间最小二乘,而不是C 与t 之间最小二乘。

故提出非线性回归法,此法所得结果更为准确,但其计算复杂,工作量大,必须采用电子计算机才能完成运算。

非线性回归一般采用高斯-牛顿(Gauss-Newton )迭代法。

迭代法是用某个固定公式反复地计算,用以校正方程所得根的近似值,使之逐步精确化,最后得到的精度要求的结果。

一般非线性参数的确定,通常采用逐次逼近的方法,即逐次“线性化”的方法。

设某药在体内的模型中待定参数a 1,a 2,a 3,…,a m ,求得隔室中药时关系的函数式为:C = f (t ,a 1,a 2,a 3,…,a m )其中t 是单个变量,t = ( t 1,t 2,t 3,…,t n ),今有n 组实验观测值(t k ,C k )k = 1,2,…n ,在最小二乘意义下确定m 个参数a 1,a 2,a 3,…,a m 。

下面介绍一般解法。

1.先给a i (i = 1,2,…m )一个初始值,记为)0(ia ,并记初值与真值之差i ∆(未知),这时有i i i a a ∆+=)0(若知i ∆则可求a i ,在)0(i a 附近作Taylor 级数展开并略去i ∆的二次以上各项得f (t k ,a 1,a 2,…,a m )m m k k k k a f a f a f f ∆∂∂++∆∂∂+∆∂∂+≈02201100 式中),,,,()0()0(2)0(10m k k a a a t f f =)0()0(1121),,,(m m k i m ikoa a a a t t a a a a t f a f ===∂∂=∂∂ 当)0(i a 给定时,0k f ,i koa f ∂∂均可由t 算得。

阻尼牛顿法例题讲解阻尼牛顿法(Damped Newton's Method)是一种用于求解非线性方程组的迭代方法。

它是牛顿法的一种改进,通过引入阻尼因子来增加算法的稳定性和收敛性。

假设我们要求解一个非线性方程组 F(x) = 0,其中 x 是一个n 维向量,F 是一个从 n 维向量到 n 维向量的函数。

阻尼牛顿法的迭代公式如下:x_{k+1} = x_k (J(x_k) + \lambda_k I)^{-1} F(x_k)。

其中,x_k 是第 k 次迭代的近似解,J(x_k) 是 F 在 x_k 处的雅可比矩阵,\lambda_k 是阻尼因子,I 是单位矩阵。

阻尼牛顿法的步骤如下:1. 初始化,选择初始点 x_0,设置迭代次数 k = 0。

2. 计算函数值和雅可比矩阵,计算 F(x_k) 和 J(x_k)。

3. 计算步长,计算步长 \Delta x_k = (J(x_k) + \lambda_kI)^{-1} F(x_k)。

4. 更新近似解,更新近似解 x_{k+1} = x_k \Delta x_k。

5. 判断终止条件,如果满足终止条件(如 \|\Delta x_k\| <\epsilon),则停止迭代;否则,令 k = k + 1,返回步骤 2。

阻尼因子 \lambda_k 的选择对算法的收敛性和稳定性有重要影响。

一般来说,\lambda_k 的取值范围在 0 到 1 之间,可以根据具体问题进行调整。

当 \lambda_k = 0 时,阻尼牛顿法退化为牛顿法;当 \lambda_k = 1 时,阻尼牛顿法退化为简化的牛顿法(也称为 Gauss-Newton 方法)。

阻尼牛顿法的优点是收敛速度快,通常比牛顿法更稳定。

然而,它也有一些缺点。

首先,计算雅可比矩阵和求解线性方程组的代价较大。

其次,阻尼因子的选择需要一定的经验和调试。

总结起来,阻尼牛顿法是一种求解非线性方程组的迭代方法,通过引入阻尼因子来提高算法的稳定性和收敛性。

反向高斯牛顿法-概述说明以及解释1.引言1.1 概述概述反向高斯牛顿法是一种优化算法,常用于解决非线性最小二乘问题。

它是对经典的高斯牛顿法的改进和扩展,通过使用矩阵的逆来代替原方法中的线性近似,从而提高了算法的鲁棒性和收敛速度。

在实际问题中,往往需要通过最小化非线性函数的平方差来获得最佳拟合结果。

而高斯牛顿法则是一种常用的优化方法,通过线性近似来求解该最小化问题。

然而,当函数的非线性程度比较高时,高斯牛顿法的线性近似效果就会受到限制,导致收敛速度较慢甚至无法收敛。

反向高斯牛顿法通过使用矩阵的逆来替代高斯牛顿法中的线性近似,在一定程度上缓解了上述问题。

具体而言,该方法在每一步迭代中,通过计算目标函数的海森矩阵的逆矩阵来近似非线性函数的梯度,从而更新参数。

相比于高斯牛顿法,反向高斯牛顿法不再受限于线性近似的效果,能够更好地适应函数的非线性特性。

反向高斯牛顿法在许多领域中都有广泛的应用。

例如,在计算机视觉中,它常被用于图像拼接、摄像头标定等问题的求解。

在机器学习领域,反向高斯牛顿法可以用于训练神经网络模型的参数。

此外,该方法还可以应用于地球物理勘探、信号处理等其他相关领域。

总之,反向高斯牛顿法通过改进传统的高斯牛顿法,提高了非线性最小二乘问题的求解效率和鲁棒性。

它在多个领域中都被广泛应用,并且在未来的研究中可能会有更多的发展和应用。

在接下来的章节中,我们将进一步探讨反向高斯牛顿法的原理和应用,并总结其优势,并展望未来的研究方向。

1.2 文章结构文章结构是写作过程中非常重要的一部分,它能够为读者提供一个清晰明了的框架,帮助读者更好地理解和掌握文章的内容。

本文以反向高斯牛顿法为主题,分为引言、正文和结论三个部分。

引言部分主要包括概述、文章结构和目的。

首先,我们会对反向高斯牛顿法进行简要的概述,介绍它的基本原理和应用领域。

接着,会详细描述本文的结构,包括各个部分的内容和组织方式。

最后,明确本文的目的,即通过对反向高斯牛顿法的探究,总结其优势并展望未来的研究方向。

高斯-牛顿法

高斯-牛顿法(Gauss-Newton Method,简称G-N方法)是一种用于求解非线性方程的迭代算法。

它结合了高斯消元法(Gaussian Elimination)和牛顿法(Newton's Method)的思想,通过在每次迭代过程中对非线性方程进行高斯消元,以提高收敛速度和精度。

高斯-牛顿法的基本步骤如下:

1. 初始化:给定一个初始近似解x_0 和迭代次数n。

2. 高斯消元:

a. 对非线性方程进行高斯消元,得到下三角形式的线性方程组Ax = b,其中A 是系数矩阵,b 是未知数向量,x_(k+1) 是当前近似解。

b. 计算误差平方和||x_(k+1) - x_0||^2 并更新近似解:

x_(k+1) = x_0 - (1/m) * (Ax_0)^(-1) * (df/dx_0)

其中:

m 是A 的行数,df/dx_0 是x_0 的导数,即雅可比矩阵(Jacobian)的逆矩阵的行列式。

注意:为了避免奇异情况(如雅可比矩阵的行列式为零),需要在求逆之前对雅可比矩阵进行一定的处理,以

保证其可逆。

3. 重复步骤2,直到满足停止条件或近似解的误差足够小。

停止条件可以是:迭代次数达到设定值;误差小于设定的阈值;算法运行时间达到最大值等。

高斯-牛顿法具有良好的收敛性和计算速度,因此在许多实际问题中都得到了广泛应用,如数值线性代数、机器学习、图像处理等。

opencv 高斯牛顿法【实用版】目录1.OpenCV 简介2.高斯牛顿法原理3.OpenCV 中的高斯牛顿法应用4.高斯牛顿法的优缺点5.总结正文1.OpenCV 简介OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉库,它包含了大量的图像处理和计算机视觉方面的算法。

OpenCV 的目的是为人工智能、机器视觉、图像处理等领域的研究人员和开发者提供一个通用且高效的平台。

它支持多种编程语言,如 C++、Python 等,使得开发者可以方便地在不同的操作系统上进行开发和测试。

2.高斯牛顿法原理高斯牛顿法(Gauss-Newton method)是一种用于求解非线性最小二乘问题的优化算法。

它的基本思想是通过对数据点进行加权最小二乘拟合,以求得参数的最优值。

在图像处理领域,高斯牛顿法常用于求解图像的参数,例如相机的内部参数和外部参数等。

3.OpenCV 中的高斯牛顿法应用在 OpenCV 库中,高斯牛顿法被广泛应用于以下领域:(1)相机标定:相机标定是计算机视觉领域的一个重要环节,其目的是通过拍摄包含已知几何形状的场景,求解相机的内部参数(如焦距、光心坐标等)和外部参数(如旋转和平移矩阵)。

OpenCV 提供了一系列的函数来实现相机标定,其中就包括了使用高斯牛顿法的函数。

(2)图像拟合:在图像处理中,常常需要对图像进行参数化的拟合,以求得图像中的关键点或者纹理等信息。

OpenCV 中提供了基于高斯牛顿法的图像拟合函数,可以对图像中的特征点进行精确的拟合。

(3)优化问题求解:OpenCV 中还提供了一些基于高斯牛顿法的优化问题求解函数,如求解线性或非线性最小二乘问题等。

4.高斯牛顿法的优缺点高斯牛顿法具有以下优缺点:(1)优点:高斯牛顿法是一种迭代法,其迭代公式具有较好的数值稳定性,可以快速地收敛到最小二乘解。

同时,高斯牛顿法具有一定的鲁棒性,对于存在噪声的数据点也能获得较好的拟合效果。

用线性拟合法及gauss-newton法计算正丁醇分子横截面积

正丁醇(1-Butanol)是一种重要的有机化合物,其分子横截面积对于研究其物理性质和化学反应有重要意义。

本文介绍了使用线性拟合法和Gauss-Newton法计算正丁醇分子横截面积的方法。

线性拟合法是一种简单的方法,用于估计正丁醇分子横截面积。

它基于假设正丁醇分子横截面积与其分子量之间存在线性关系。

因此,可以使用线性回归方法来拟合正丁醇分子横截面积与其分子量之间的关系,从而估计正丁醇分子横截面积。

Gauss-Newton法是一种迭代优化方法,用于估计正丁醇分子横截面积。

它基于假设正丁醇分子横截面积与其分子量之间存在非线性关系。

因此,可以使用Gauss-Newton法来拟合正丁醇分子横截面积与其分子量之间的关系,从而估计正丁醇分子横截面积。

综上所述,线性拟合法和Gauss-Newton法都可以用来估计正丁醇分子横截面积。

线性拟合法基于假设正丁醇分子横截面积与其分子量之间存在线性关系,而Gauss-Newton法基于假设正丁醇分子横截面积与其分子量之间存在非线性关系。

因此,根据实际情况,可以选择合适的方法来估计正丁醇分子横截面积。