信息论理论基础_3(1007).

- 格式:ppt

- 大小:966.00 KB

- 文档页数:73

信息论基础知识在当今这个信息爆炸的时代,信息论作为一门重要的学科,为我们理解、处理和传输信息提供了坚实的理论基础。

信息论并非是一个遥不可及的高深概念,而是与我们的日常生活和现代科技的发展息息相关。

接下来,让我们一同走进信息论的世界,揭开它神秘的面纱。

信息是什么?这似乎是一个简单却又难以精确回答的问题。

从最直观的角度来看,信息就是能够消除不确定性的东西。

比如,当我们不知道明天的天气如何,而天气预报告诉我们明天是晴天,这一消息就消除了我们对明天天气的不确定性,这就是信息。

那么信息论又是什么呢?信息论是一门研究信息的量化、存储、传输和处理的学科。

它由克劳德·香农在 20 世纪 40 年代创立,为现代通信、计算机科学、统计学等众多领域的发展奠定了基础。

在信息论中,有几个关键的概念是我们需要了解的。

首先是“熵”。

熵这个概念听起来可能有些抽象,但其实可以把它理解为信息的混乱程度或者不确定性。

比如说,一个完全随机的字符串,其中每个字符的出现都是完全不确定的,它的熵就很高;而一个有规律、可预测的字符串,其熵就相对较低。

信息的度量是信息论中的一个重要内容。

香农提出了用“比特”(bit)作为信息的基本度量单位。

一个比特可以表示两种可能的状态(0 或1)。

如果一个事件有8 种等可能的结果,那么要确定这个事件的结果,就需要 3 个比特的信息(因为 2³= 8)。

信息的传输是信息论关注的另一个重要方面。

在通信过程中,信号会受到各种噪声的干扰,导致信息的失真。

为了保证信息能够准确、可靠地传输,我们需要采用一些编码和纠错技术。

比如,在数字通信中,常常使用纠错码来检测和纠正传输过程中产生的错误。

信息压缩也是信息论的一个重要应用。

在数字化的时代,我们每天都会产生大量的数据,如图片、音频、视频等。

通过信息论的原理,可以对这些数据进行压缩,在不损失太多有用信息的前提下,减少数据的存储空间和传输带宽。

再来说说信息的存储。

信息论形成的背景与基础人们对于信息的认识和利用,可以追溯到古代的通讯实践可以说是传递信息的原始方式。

随着社会生产的发展,科学技术的进步,人们对传递信息的要求急剧增加。

到了20世纪20年代,如何提高传递信息的能力和可靠性已成为普遍重视的课题。

美国科学家N.奈奎斯特、德国K.屈普夫米勒、前苏联A.H.科尔莫戈罗夫和英国R.A.赛希尔等人,从不同角度研究信息,为建立信息论做出了很大贡献。

信息论是在人们长期的通信工程实践中,由通信技术和概率论、随机过程和数理统计相结合而逐步发展起来的一门学科。

信息论的奠基人是美国伟大的数学家、贝尔实验室杰出的科学家 C.E.香农(被称为是“信息论之父”),他在1948年发表了著名的论文《通信的数学理论》,1949年发表《噪声中的通信》,为信息论奠定了理论基础。

20世纪70年代以后,随着数学计算机的广泛应用和社会信息化的迅速发展,信息论正逐渐突破香农狭义信息论的范围,发展为一门不仅研究语法信息,而且研究语义信息和语用信息的科学。

近半个世纪以来,以通信理论为核心的经典信息论,正以信息技术为物化手段,向高精尖方向迅猛发展,并以神奇般的力量把人类社会推入了信息时代。

信息是关于事物的运动状态和规律,而信息论的产生与发展过程,就是立足于这个基本性质。

随着信息理论的迅猛发展和信息概念的不断深化,信息论所涉及的内容早已超越了狭义的通信工程范畴,进入了信息科学领域。

信息论定义及概述信息论是运用概率论与数理统计的方法研究信息、信息熵、通信系统、数据传输、密码学、数据压缩等问题的应用数学学科。

核心问题是信息传输的有效性和可靠性以及两者间的关系。

它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

基于这一理论产生了数据压缩技术、纠错技术等各种应用技术,这些技术提高了数据传输和存储的效率。

信息论将信息的传递作为一种统计现象来考虑,给出了估算通信信道容量的方法。

信息论基础

信息论是一门研究信息传输和处理的科学。

它的基础理论主要有以下几个方面:

1. 信息的定义:在信息论中,信息被定义为能够消除不确定性的东西。

当我们获得一条消息时,我们之前关于该消息的不确定性会被消除或减少。

信息的量可以通过其发生的概率来表示,概率越小,信息量越大。

2. 熵:熵是一个表示不确定性的量。

在信息论中,熵被用来衡量一个随机变量的不确定性,即随机变量的平均信息量。

熵越大,表示随机变量的不确定性越高。

3. 信息的传输和编码:信息在传输过程中需要进行编码和解码。

编码是将消息转换为一种合适的信号形式,使其能够通过传输渠道传输。

解码则是将接收到的信号转换回原始消息。

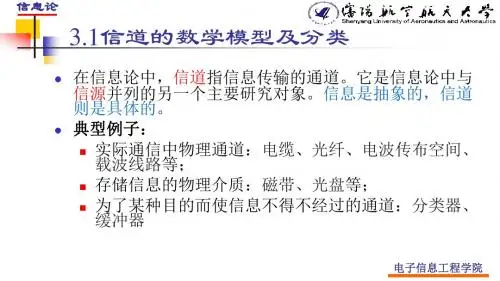

4. 信道容量:信道容量是指一个信道能够传输的最大信息量。

它与信道的带宽、噪声水平等因素相关。

信道容量的

计算可以通过香浓定理来进行。

5. 信息压缩:信息压缩是指将信息表示为更为紧凑的形式,以减少存储或传输空间的使用。

信息压缩的目标是在保持

信息内容的同时,尽可能减少其表示所需的比特数。

信息论还有其他一些重要的概念和理论,如互信息、信道

编码定理等,这些都是信息论的基础。

信息论的研究不仅

在信息科学领域具有重要应用,还在通信、计算机科学、

统计学等领域发挥着重要作用。

信息论形成的背景与基础人们对于信息的认识和利用,可以追溯到古代的通讯实践可以说是传递信息的原始方式。

随着社会生产的发展,科学技术的进步,人们对传递信息的要求急剧增加。

到了20世纪20年代,如何提高传递信息的能力和可靠性已成为普遍重视的课题。

美国科学家N.奈奎斯特、德国K.屈普夫米勒、前苏联A.H.科尔莫戈罗夫和英国R.A.赛希尔等人,从不同角度研究信息,为建立信息论做出了很大贡献。

信息论是在人们长期的通信工程实践中,由通信技术和概率论、随机过程和数理统计相结合而逐步发展起来的一门学科。

信息论的奠基人是美国伟大的数学家、贝尔实验室杰出的科学家 C.E.香农(被称为是“信息论之父”),他在1948年发表了著名的论文《通信的数学理论》,1949年发表《噪声中的通信》,为信息论奠定了理论基础。

20世纪70年代以后,随着数学计算机的广泛应用和社会信息化的迅速发展,信息论正逐渐突破香农狭义信息论的范围,发展为一门不仅研究语法信息,而且研究语义信息和语用信息的科学。

近半个世纪以来,以通信理论为核心的经典信息论,正以信息技术为物化手段,向高精尖方向迅猛发展,并以神奇般的力量把人类社会推入了信息时代。

信息是关于事物的运动状态和规律,而信息论的产生与发展过程,就是立足于这个基本性质。

随着信息理论的迅猛发展和信息概念的不断深化,信息论所涉及的内容早已超越了狭义的通信工程范畴,进入了信息科学领域。

信息论定义及概述信息论是运用概率论与数理统计的方法研究信息、信息熵、通信系统、数据传输、密码学、数据压缩等问题的应用数学学科。

核心问题是信息传输的有效性和可靠性以及两者间的关系。

它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

基于这一理论产生了数据压缩技术、纠错技术等各种应用技术,这些技术提高了数据传输和存储的效率。

信息论将信息的传递作为一种统计现象来考虑,给出了估算通信信道容量的方法。

1、信息科学是以信息作为主要研究对象、以信息过程的运动规律作为主要研究内容、以信息科学方法论作为主要研究方法、以扩展人的信息功能(全部信息功能形成的有机整体就是智力功能)作为主要研究目标的一门科学2、材料科学、能源科学、信息科学是现代文明的三大支柱3、信息科学的基础是三大论:系统论、控制论、信息理论4、香农狭义信息论上,也就是三大块内容:信息的统计测度、信道容量和信息率失真函数,以及香农的三个重要定理:无失真信源编码定理、有噪信道编码定理和保真度准则下的信源编码定理5、本体论定义事物的信息是该事物运动的状态和状态改变的方式6、认识论的意义上说,信息是认识主体(生物或机器)所感知的事物运动的状态和状态改变的方式,包括运动状态及其变化方式的形式、含义和效用。

7、认识论层次的信息是同时考虑语法信息(外在形式)、语义信息(内在含义)和语用信息(效用价值)的全信息8、信息最重要的是按照性质分类:语法信息、语义信息、语用信息。

语法信息又分成连续信息和离散信息。

信息理论研究的语法信息9、消息是信息的载荷者,信号是消息的载体10、 11、: 概率越小 不确定性越大 确定性越小 信息量越大 概率越大 不确定性越小 确定性越大 信息量越小 概率 = 1 没有不确定性 完全确定 信息量为零 12、自信息量的定义: ()log ()i i I x p x =- 注意:)(i x I 是)(i x p 的函数,而不是i x 的函数,)(i x p 代表信源发出第i 个符号的不确定性也就是它的概率。

13、对数运算的性质:说明自信息量公式}零和负数没有对数不等式换底公式对数恒等式降阶运算 (10)1log (9)01log (8)1n l (7) 1ln 11 (6) log log log (5) (4) log log (3)log log log (2)log log log (1)a a log ==='⎭⎬⎫-≤≤-⎭⎬⎫==⎪⎪⎭⎪⎪⎬⎫=-=+=⋅a xx x x x A B B B A B A B B A B A B A B A C C A B A A14、联合概率和条件概率计算的信息量分别称为联合自信息量和条件自信息量。

信息论的基本理论和应用信息论是研究信息传输和处理的数学分支,其基于对信息量和信息传输速率的量化分析,为通信、信息处理、控制系统等领域提供了一套理论框架。

信息论的重要性在于,它极大地促进了人类对信息科学发展的深入认识,丰富了我们对信息的理解和实际应用。

信息论的基本概念信息的基本单位是比特,是“Binary Digit”的缩写,表示用二进制数码表示的信息单元。

比特是最小的信息单元,一位二进制数可以表示两种状态(0或1),因此是最基本的信号元素。

信息量是指用比特表示的信息大小,是反映信息不确定性的度量。

信息量与概率有关,当事件发生的概率越小,所包含的信息量就越大。

以翻译为例,听到一个人说英文可以得出的信息较少,收到一封电报就不同了,文字比较准确地传递了信息,包含的信息量相对较大。

信息熵是对信息量的量化,它揭示了一个信源(发出消息的源头)内部自身的不确定性。

信息熵越大,信源的不确定性也越大,所包含的信息量也越大。

例如,在一个公平掷硬币的概率试验中,结果的不确定性很高,因此信息熵也很大,为1。

信息熵还与信息编码有关。

信息编码是将原信息用少量的比特来表示的一种方法,可以提高信息传输的效率和可靠性。

为了使编码的效率尽可能高,我们需要有一个标准,即编码的平均码长应该尽量短。

而通过定义信息熵可以得出信息编码的最低平均码长,这也称为信息编码理论。

信息论的应用信息论为通信领域提供了重要的理论基础,包括信道编码、信号传输、信道容量等研究。

信道编码是为了提高通信中的抗干扰能力,如当一段信号遭到干扰时,通过纠错码的检测和恢复,可以确保消息的完整性。

信号传输是使得消息信号在信道上传输得到的研究,其中工程学和物理学的知识密切相关。

传输通信中的信道包括光纤、卫星等,也包括更基本的有线和无线通信。

信道容量指的是特定信道上传输数据的最大速率,这是一个通信系统的重要性能指标。

例如,带宽表示信道传输的数据速率,其值受到信噪比、码率等因素的影响。