一元线性回归模型的置信区间与预测

- 格式:pdf

- 大小:188.43 KB

- 文档页数:10

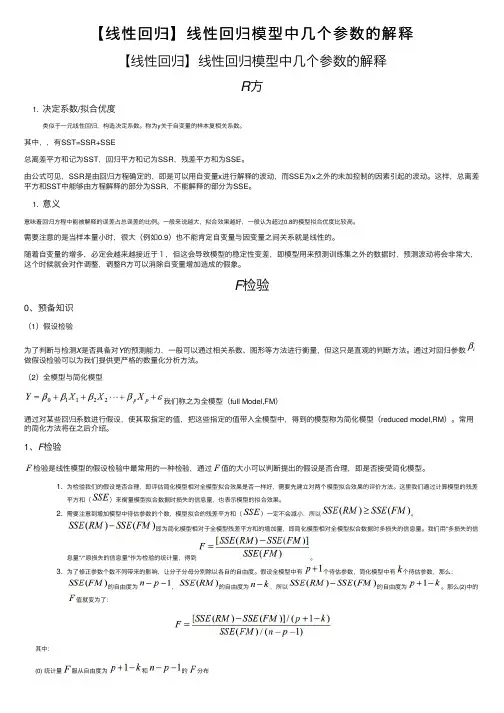

【线性回归】线性回归模型中⼏个参数的解释【线性回归】线性回归模型中⼏个参数的解释R ⽅1. 决定系数/拟合优度类似于⼀元线性回归,构造决定系数。

称为y 关于⾃变量的样本复相关系数。

其中,,有SST=SSR+SSE总离差平⽅和记为SST ,回归平⽅和记为SSR ,残差平⽅和为SSE 。

由公式可见,SSR 是由回归⽅程确定的,即是可以⽤⾃变量x 进⾏解释的波动,⽽SSE 为x 之外的未加控制的因素引起的波动。

这样,总离差平⽅和SST 中能够由⽅程解释的部分为SSR ,不能解释的部分为SSE 。

1. 意义意味着回归⽅程中能被解释的误差占总误差的⽐例。

⼀般来说越⼤,拟合效果越好,⼀般认为超过0.8的模型拟合优度⽐较⾼。

需要注意的是当样本量⼩时,很⼤(例如0.9)也不能肯定⾃变量与因变量之间关系就是线性的。

随着⾃变量的增多,必定会越来越接近于1,但这会导致模型的稳定性变差,即模型⽤来预测训练集之外的数据时,预测波动将会⾮常⼤,这个时候就会对作调整,调整R ⽅可以消除⾃变量增加造成的假象。

F 检验0、预备知识(1)假设检验为了判断与检测X 是否具备对Y 的预测能⼒,⼀般可以通过相关系数、图形等⽅法进⾏衡量,但这只是直观的判断⽅法。

通过对回归参数做假设检验可以为我们提供更严格的数量化分析⽅法。

(2)全模型与简化模型我们称之为全模型(full Model,FM )通过对某些回归系数进⾏假设,使其取指定的值,把这些指定的值带⼊全模型中,得到的模型称为简化模型(reduced model,RM )。

常⽤的简化⽅法将在之后介绍。

1、F 检验检验是线性模型的假设检验中最常⽤的⼀种检验,通过值的⼤⼩可以判断提出的假设是否合理,即是否接受简化模型。

1. 为检验我们的假设是否合理,即评估简化模型相对全模型拟合效果是否⼀样好,需要先建⽴对两个模型拟合效果的评价⽅法。

这⾥我们通过计算模型的残差平⽅和()来衡量模型拟合数据时损失的信息量,也表⽰模型的拟合效果。

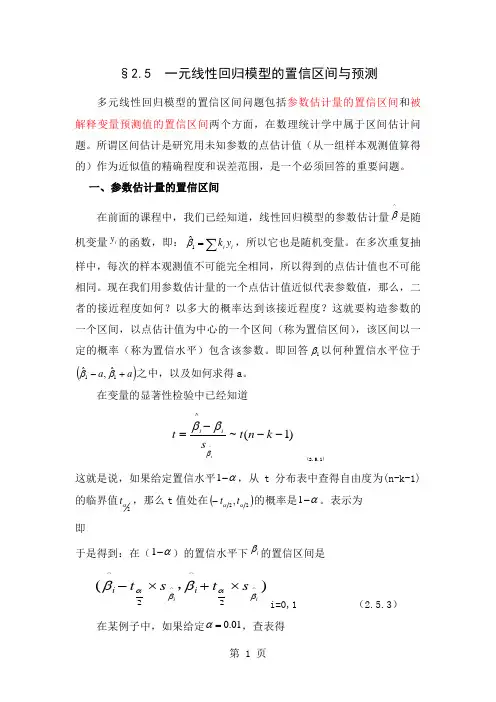

§2.5 一元线性回归模型的置信区间与预测多元线性回归模型的置信区间问题包括参数估计量的置信区间和被解释变量预测值的置信区间两个方面,在数理统计学中属于区间估计问题。

所谓区间估计是研究用未知参数的点估计值(从一组样本观测值算得的)作为近似值的精确程度和误差范围,是一个必须回答的重要问题。

一、参数估计量的置信区间在前面的课程中,我们已经知道,线性回归模型的参数估计量^β是随机变量i y 的函数,即:i i y k ∑=1ˆβ,所以它也是随机变量。

在多次重复抽样中,每次的样本观测值不可能完全相同,所以得到的点估计值也不可能相同。

现在我们用参数估计量的一个点估计值近似代表参数值,那么,二者的接近程度如何?以多大的概率达到该接近程度?这就要构造参数的一个区间,以点估计值为中心的一个区间(称为置信区间),该区间以一定的概率(称为置信水平)包含该参数。

即回答1β以何种置信水平位于()a a +-11ˆ,ˆββ之中,以及如何求得a 。

在变量的显著性检验中已经知道)1(~^^---=k n t s t iii βββ (2.5.1)这就是说,如果给定置信水平α-1,从t 分布表中查得自由度为(n-k-1)的临界值2αt ,那么t 值处在()22,ααt t -的概率是α-1。

表示为即于是得到:在(α-1)的置信水平下i β的置信区间是)(^^2^2^iis t s t i i βαβαββ⨯+⨯-,i=0,1 (2.5.3)在某例子中,如果给定01.0=α,查表得从回归计算中得到01.0,15,21.0ˆ,3.102ˆ1ˆˆ10====ββββS S 根据(2.5.2)计算得到10,ββ的置信区间分别为()48.147,12.57和(0.1799,0.2401)显然,参数1β的置信区间要小。

在实际应用中,我们当然希望置信水平越高越好,置信区间越小越好。

如何才能缩小置信区间?从(2.5.3)式中不难看出:(1)增大样本容量n 。

2017-10-27不少初学者往往混淆均值的置信区间和个体的预测区间(prediction interval),在有的统计软件中,同时给出回归线的置信区间和预测区间,致使有的初学者搞不懂它们有什么区别。

其实二者很容易区分,置信区间是针对因变量均值的区间,而预测区间是针对因变量个体值的区间。

不难理解,针对均值的置信区间肯定要窄一些,而具体想预测某一个体值,那区间肯定要宽,因为误差会很大。

比如,让你预测一个高中班级中学生的平均身高,跟让你预测该班级中具体某一个学生的身高,你觉得哪个误差更大呢?对于一个班级的均值,即使你什么信息都不知道,估计预测的也差不到哪儿去,而让你预测班中的张三同学的身高,那你可能就不知所措了。

(1)均值的置信区间线性回归中,我们假定,对于每一特定的x值,其对应的y值应该是来自一个服从某一均值和标准差的分布。

例如,调查温度与手足口发病率的关系,温度=10℃,假定其对应的手足口发病率是来自一个服从均值为10(1/10万),标准差为4(1/10万)的总体分布。

当我们调查这一数据时,得到的是这一总体分布中的某一随机数值(所以说y是随机变量)。

根据样本数据建立的回归方程,可以估计出当x等于某一数值时,y的估计值(也就是y的总体均值的估计值)。

比如根据方程式:发病率=-0.011+0.995*温度可以估计出,温度=10℃时,对应的手足口发病率的均值估计为9.94(1/10万)。

由于是总体均值的估计,那就必然会有估计的误差(标准误),这一标准误是可以计算出来的(公式略,格式不好调整,感兴趣的等本书出版后看书)。

因此根据标准误、均值估计值,便可以估计置信区间。

这一置信区间反映的是样本估计yi的均值的这一范围有多大的信心包含了总体均值。

如月份温度=10℃时,手足口发病率均值的95%置信区间为(6.64,16.25)。

这说明,对于温度=10℃这样的月份,我们有95%的信心认为,(6.64,16.25)这一区间包含了手足口发病率的总体均值。

回归95%置信区间的计算公式

回归95%置信区间的计算公式是:

置信区间=预测值±临界值*标准差

其中,预测值是模型对给定输入的预测结果,临界值是根据样本

数量和置信水平来确定的,标准差是模型的残差的标准差。

对于简单线性回归模型,临界值可以通过查找t分布表来确定,

该表给出了根据自由度(样本数量减去模型参数的个数减1)和置信水平得出的t值。

对于多元回归模型,临界值可以通过查找F分布表和t 分布表来确定。

拓展:

除了使用临界值乘以标准差的方法计算置信区间外,还有一种常

见的方法是使用Bootstrap方法。

Bootstrap通过从已有数据集中用有放回抽样的方法生成多个重复样本,然后对每个样本进行建模和预测,最后对这些预测结果进行统计,得到置信区间。

这种方法更加灵活,

可以用于更复杂的回归模型和数据集,但是计算量更大。

§2.5 一元线性回归模型的置信区间与预测多元线性回归模型的置信区间问题包括参数估计量的置信区间和被解释变量预测值的置信区间两个方面,在数理统计学中属于区间估计问题。

所谓区间估计是研究用未知参数的点估计值(从一组样本观测值算得的)作为近似值的精确程度和误差范围,是一个必须回答的重要问题。

一、参数估计量的置信区间在前面的课程中,我们已经知道,线性回归模型的参数估计量^β是随机变量i y 的函数,即:i i y k ∑=1ˆβ,所以它也是随机变量。

在多次重复抽样中,每次的样本观测值不可能完全相同,所以得到的点估计值也不可能相同。

现在我们用参数估计量的一个点估计值近似代表参数值,那么,二者的接近程度如何?以多大的概率达到该接近程度?这就要构造参数的一个区间,以点估计值为中心的一个区间(称为置信区间),该区间以一定的概率(称为置信水平)包含该参数。

即回答1β以何种置信水平位于()a a +-11ˆ,ˆββ之中,以及如何求得a 。

在变量的显著性检验中已经知道)1(~^^---=k n t s t iii βββ (2.5.1)这就是说,如果给定置信水平α-1,从t 分布表中查得自由度为(n-k-1)的临界值2αt ,那么t 值处在()22,ααt t -的概率是α-1。

表示为ααα-=<<-1)(22t t t P即αββαβα-=<-<-1)(2^2^t s t P iiiαββββαβα-=⨯+<<⨯-1)(^^2^2^iis t s t P i i i于是得到:在(α-1)的置信水平下i β的置信区间是)(^^2^2^iis t s t i i βαβαββ⨯+⨯-,i=0,1 (2.5.3)在某例子中,如果给定01.0=α,查表得012.3)13()1(005.02==--t k n t α 从回归计算中得到01.0,15,21.0ˆ,3.102ˆ1ˆˆ10====ββββS S 根据(2.5.2)计算得到10,ββ的置信区间分别为()48.147,12.57和(0.1799,0.2401) 显然,参数1β的置信区间要小。

第二章 回归分析概要第三节 一元线性回归模型的统计检验根据第一章第二节里,我们讲过的计量经济学模型检验规则可知,在利用OLS 法估计了一元线性回归模型的参数,并确定了样本回归线后,首先要根据经济理论及实际问题中X 和Y 的对应关系,对回归系数的符号、大小及相互关系进行直观判断,如果上述检验通过的话,还须对估计值进行统计学检验。

回归分析是要通过样本所估计的参数来代替总体的真实参数,或者说是用样本回归线来替代总体回归线。

尽管,从统计性质上已知,如果有足够多的重复抽样,参数的估计值的期望(均值)就等于总体的参数真值,但是,在一次抽样中,估计值不一定就等于该真值。

那么,在一次抽样中,参数的估计值与真值的差异有多大,是否显著,这就需要进一步进行统计检验,主要包括拟合优度检验、变量的显著性检验以及参数检验的置信区间估计。

一、拟合优度检验拟合优度检验,顾名思义,是检验模型对样本观测值的拟合程度(即回归直线对观测值的拟合程度)。

显然,若样本观测值离回归直线越近,则拟合优度越好,X 对Y 的解释程度越强;反之,则拟合优度差,X 对Y 的解释程度弱。

(参看课本44页图3.2.3)因为样本值太多,分别考察每一个离差是不切实际的,又为了克服绝对值符号在计算上带来的不便,因此,常使用离差平方和来考察总离差(推导过程课本44页)。

被解释变量的总离差平方和TSS可解释平方和(回归平方和)ESS 残差平方和RSS 因此,显然,ESS 在TSS 的构成中所占比例越大,RSS 在TSS 中所占的比例就越小,说明回归参数估计值的显著性越强,即样本回归线与真实回归线的拟合优度就越好。

因此,可以用ESS 在TSS 中所占的比例表示样本回归线与总体回归线的拟合程度。

二、变量的显著性检验 1. 相关系数的检验样本相关系数定义公式:)ˆ()ˆ(t t t t y y y y y y -+-=-RSS ESS TSS uRSS y yESS y y TSS t t t +==-=-=∑∑∑222)ˆ()ˆ()(100,01)()ˆ(22222≤≤∴≤≤≤≤-=--==∑∑R TSS ESS TSS RSS TSSRSS R y y y y TSS ESS R t t样本相关系数的性质:(1) r 的取值介于-1和1之间。

第十三讲简单线性相关(一元线性回归分析)对于两个或更多变量之间的关系,相关分析考虑的只是变量之间是否相关、相关的程度,而回归分析关心的问题是:变量之间的因果关系如何。

回归分析是处理一个或多个自变量与因变量间线性因果关系的统计方法。

如婚姻状况与子女生育数量,相关分析可以求出两者的相关强度以及是否具有统计学意义,但不对谁决定谁作出预设,即可以相互解释,回归分析则必须预先假定谁是因谁是果,谁明确谁为因与谁为果的前提下展开进一步的分析。

一、一元线性回归模型及其对变量的要求(一)一元线性回归模型1、一元线性回归模型示例两个变量之间的真实关系一般可以用以下方程来表示:Y=A+BX+方程中的 A 、B 是待定的常数,称为模型系数,是残差,是以X预测Y 产生的误差。

两个变量之间拟合的直线是:y a bxy 是y的拟合值或预测值,它是在X 条件下 Y 条件均值的估计a 、b 是回归直线的系数,是总体真实直线距,当自变量的值为0 时,因变量的值。

A、B 的估计值, a 即 constant 是截b 称为回归系数,指在其他所有的因素不变时,每一单位自变量的变化引起的因变量的变化。

可以对回归方程进行标准化,得到标准回归方程:y x为标准回归系数,表示其他变量不变时,自变量变化一个标准差单位( Z XjXj),因变量 Y 的标准差的平均变化。

S j由于标准化消除了原来自变量不同的测量单位,标准回归系数之间是可以比较的,绝对值的大小代表了对因变量作用的大小,反映自变量对Y 的重要性。

(二)对变量的要求:回归分析的假定条件回归分析对变量的要求是:自变量可以是随机变量,也可以是非随机变量。

自变量 X 值的测量可以认为是没有误差的,或者说误差可以忽略不计。

回归分析对于因变量有较多的要求,这些要求与其它的因素一起,构成了回归分析的基本条件:独立、线性、正态、等方差。

(三)数据要求模型中要求一个因变量,一个或多个自变量(一元时为 1 个自变量)。