回归分析中相关系数和相关指数的概念剖析

- 格式:pdf

- 大小:52.70 KB

- 文档页数:1

相关与回归分析相关与回归分析是统计学中常用的方法,用于研究两个或多个变量之间的关系。

通过这种分析方法,我们可以了解这些变量之间的相互作用、依赖程度以及预测未来可能的变化。

一、相关分析相关分析是一种用来衡量两个变量之间相关程度的方法。

通常情况下,我们可以通过计算相关系数来确定变量之间的关联程度,最常见的相关系数是皮尔逊相关系数。

皮尔逊相关系数的取值范围为-1到1之间,其中1表示完全正相关,-1表示完全负相关,0表示不相关。

通过计算样本数据的皮尔逊相关系数,我们可以得出结论,判断变量之间的关系是正相关还是负相关。

相关分析的应用非常广泛,可以用在市场调研、经济预测、医学研究等领域。

例如,在市场调研中,我们可以通过相关分析来了解广告投放与销售额之间的关系,进而优化广告策略。

二、回归分析回归分析是一种通过建立数学模型来研究自变量与因变量之间关系的方法。

回归分析主要用于预测与解释因变量的变化。

在回归分析中,根据自变量的类型,可以分为线性回归和非线性回归。

1. 线性回归线性回归是指自变量与因变量之间存在线性关系的回归模型。

线性回归模型可以用直线方程来表示,即y = a + bx。

其中,a表示截距,b表示斜率,x表示自变量,y表示因变量。

线性回归分析可以用于预测未来的趋势,以及通过自变量来解释因变量的变化。

在金融领域中,我们经常使用线性回归来预测股票价格的变化。

2. 非线性回归非线性回归是指自变量与因变量之间存在非线性关系的回归模型。

与线性回归不同,非线性回归的数学模型一般无法用简单的直线方程表示。

非线性回归分析可以用来研究自变量与因变量之间的复杂关系。

例如,在生物学研究中,我们可以使用非线性回归来研究温度与生物体生长速度之间的关系。

三、相关与回归分析实例为了更好地理解相关与回归分析的应用,我们来看一个实例。

假设我们有一份房屋销售数据,其中包括房屋面积、售价以及地理位置等信息。

我们可以使用相关与回归分析来探索这些变量之间的关系。

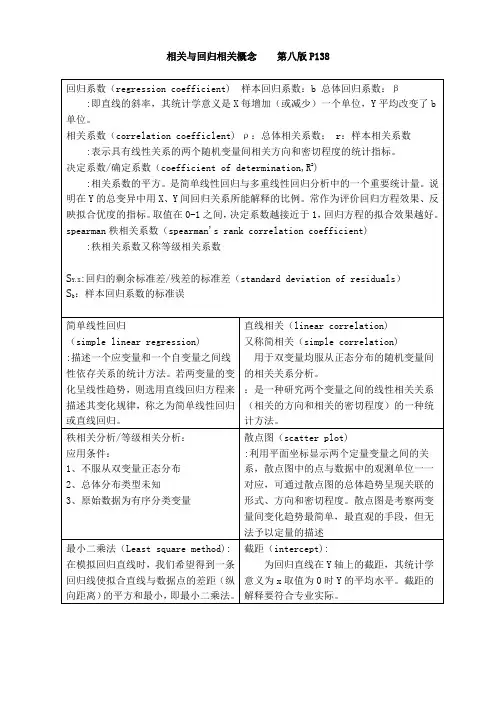

回归系数与相关系数的关系回归分析是一种常用的统计方法,它可以用来研究两个或多个变量之间的关系。

其中,回归系数和相关系数是回归分析中非常重要的概念,它们之间存在着密切的关系。

本文将从回归系数和相关系数的定义、计算方法以及意义等方面,探讨它们之间的关系。

一、回归系数和相关系数的定义回归系数是用来描述自变量与因变量之间关系的参数。

在一元线性回归中,回归系数通常表示为β1,它表示因变量y对自变量x的变化量,即y的平均值随着x的变化而变化的程度。

在多元回归中,回归系数通常表示为βi,表示因变量y对自变量xi的变化量,即y 的平均值随着xi的变化而变化的程度。

相关系数是用来描述两个变量之间线性相关程度的指标。

它通常用r表示,在一定程度上反映了两个变量之间的相似程度。

当r=1时,表示两个变量完全正相关;当r=-1时,表示两个变量完全负相关;当r=0时,表示两个变量之间不存在线性相关关系。

二、回归系数和相关系数的计算方法在一元线性回归中,回归系数β1的计算方法为:β1=Σ((xi- x)(yi- y))/Σ(xi- x)^2其中,x表示自变量的平均值,y表示因变量的平均值,xi和yi 分别表示第i个样本的自变量和因变量的值。

相关系数r的计算方法为:r=Σ((xi- x)(yi- y))/√(Σ(xi- x)^2Σ(yi- y)^2)在多元回归中,回归系数βi的计算方法为:βi=(XTX)^-1XTY其中,X表示自变量的矩阵,Y表示因变量的向量,T表示转置,-1表示矩阵的逆。

三、回归系数和相关系数的意义回归系数和相关系数都是用来描述两个变量之间关系的指标,但它们的意义有所不同。

回归系数描述的是因变量在自变量变化时的变化量,它可以用来预测因变量的变化情况。

例如,一个人的身高和体重之间存在一定的关系,假设我们已经建立了身高和体重之间的回归模型,其中回归系数为2.5,那么当这个人的身高增加1厘米时,他的体重预计会增加2.5公斤。

数据分析中的相关系数与回归分析数据分析是一门重要的学科,它通过收集、整理和分析数据来揭示数据背后的信息和规律。

在数据分析的过程中,相关系数和回归分析是两个常用的分析方法。

本文将介绍相关系数和回归分析的概念、计算方法以及应用场景。

一、相关系数相关系数用于衡量两个变量之间的相关性强度。

在数据分析中,我们经常会遇到多个变量之间的相互影响关系。

相关系数可以帮助我们了解这些变量之间的联系程度,从而更好地进行数据分析和决策。

计算相关系数的常用方法是皮尔逊相关系数(Pearson correlation coefficient)。

该系数的取值范围在-1到1之间,取值接近1表示两个变量呈正相关关系,取值接近-1表示两个变量呈负相关关系,取值接近0表示两个变量之间没有线性相关关系。

相关系数的计算可以使用公式:其中,n表示样本容量,X和Y分别表示两个变量的观测值,X的均值为μX,Y的均值为μY。

通过计算协方差和标准差,可以得到两个变量之间的相关系数。

相关系数在许多领域有着广泛的应用。

例如,在金融领域,相关系数可以用于衡量不同投资品之间的相关性,从而帮助投资者构建更加稳健和多样化的投资组合。

在医学研究中,相关系数可以用于分析药物疗效和副作用之间的关系。

在市场调研中,相关系数可以用于评估产品销售和广告投放之间的关联性。

二、回归分析回归分析是一种通过建立数学模型来预测和解释变量之间关系的方法。

它可以帮助我们了解一个或多个自变量对因变量的影响程度,并进行预测和推断。

回归分析的常用方法包括线性回归、多项式回归、逻辑回归等。

在这些方法中,线性回归是最常用的一种。

线性回归通过建立一个线性方程来描述自变量和因变量之间的关系。

例如,当只有一个自变量和一个因变量时,线性回归可以表示为:其中,Y表示因变量,X表示自变量,β0和β1表示回归系数,ε表示误差项。

回归分析的目标是通过拟合找到最佳的回归系数,使得拟合值尽可能接近实际观测值。

报告中的相关系数和回归分析相关系数和回归分析是统计学中常用的分析方法,用于研究变量之间的关系和预测变量的值。

在社会科学、经济学、医学等领域都有广泛的应用。

本文将围绕这一主题展开,论述相关系数和回归分析的基本概念、计算方法、应用场景以及局限性。

一、相关系数的概念和计算方法相关系数用来衡量两个变量之间的相关程度,常用的有皮尔逊相关系数和斯皮尔曼排名相关系数。

皮尔逊相关系数适用于两个连续变量,其取值范围为-1到1,正值表示正相关,负值表示负相关,绝对值越大表示相关程度越强。

斯皮尔曼排名相关系数则适用于两个有序变量或者对于连续变量不满足正态分布的情况,其取值范围为-1到1,含义与皮尔逊相关系数类似。

二、回归分析的概念和基本原理回归分析用于研究自变量与因变量之间的关系,并建立数学模型进行预测或者解释。

简单线性回归适用于自变量和因变量均为连续变量的情况,通过最小二乘法估计回归方程的系数。

多元线性回归则适用于自变量包含多个的情况,通过最小二乘法估计回归方程中各个自变量的系数来建立模型。

三、相关系数与回归分析的应用场景相关系数和回归分析在各个领域都有广泛的应用。

在社会科学中,可以用来探究教育和收入、人口和犯罪率等之间的关系。

在经济学中,可以用来研究需求和价格、利率和投资等之间的联系。

在医学研究中,可以用来分析疾病与遗传、环境因素之间的关联性。

四、相关系数与回归分析的优点和局限性相关系数和回归分析具有一定的优点,例如简单易懂、计算方法明确,能够为研究者提供相关关系的定量度量。

但是也存在一些局限性,例如相关系数只能揭示变量之间的线性关系,无法反映非线性关系;回归分析的模型假设常常需要满足一定的前提条件,而实际数据常常存在违背这些假设的情况。

五、相关系数与回归分析的注意事项在进行相关系数和回归分析时,需要注意选取适当的样本和变量,避免样本选择偏差和自变量的多重共线性问题。

同时还需要注意解释分析结果时避免过度解读,避免将关联性误解为因果性。

回归系数与相关系数回归系数和相关系数是统计学中常用的两个概念,它们在数据分析和建立数学模型方面起着重要的作用。

本文将为您详细介绍回归系数和相关系数的概念、计算方法以及它们的应用意义。

首先,让我们来了解什么是回归系数。

回归系数是用来度量自变量(也称为解释变量或预测变量)对因变量(也称为响应变量或被预测变量)的影响程度的指标。

在回归分析中,我们通常希望通过自变量的变化来预测因变量的变化,而回归系数就是衡量这种变化的关系强度和方向的指标。

回归系数的计算方法有很多种,最常用的是最小二乘法。

简单线性回归模型中,回归系数表示自变量每变化一个单位,因变量的平均变化量。

多元线性回归模型中,回归系数表示自变量每变化一个单位,因变量的平均变化量,同时考虑其他自变量的影响。

在回归分析中,回归系数的显著性检验是十分重要的,它可以帮助我们评估变量之间的关系是否真实存在。

接下来,我们来了解相关系数。

相关系数是评价两个变量之间线性关系强度的指标,用于度量两个变量的相关程度。

相关系数的取值范围为-1到1之间,其中-1表示完全负相关,0表示不相关,1表示完全正相关。

相关系数可以帮助我们判断两个变量之间的关系强度,以及它们的变化趋势。

计算相关系数的方法有很多种,其中最常用的是皮尔逊相关系数。

皮尔逊相关系数是根据变量之间的协方差来计算的,它的计算公式为相关系数=协方差/(标准差1 * 标准差2)。

相关系数的绝对值越接近1,表示变量之间的线性关系越强。

回归系数和相关系数在实际应用中有着广泛的用途。

例如,在经济学中,我们可以使用回归系数来分析不同变量对经济增长的影响,以及预测未来的经济趋势。

在市场研究中,我们可以使用相关系数来评估产品销售量与广告投入之间的关系,从而制定有效的市场推广策略。

总之,回归系数和相关系数是统计学中重要的概念,它们可以帮助我们建立数学模型、解释变量之间的关系,并预测未来的趋势。

在进行数据分析和研究时,我们应该掌握回归系数和相关系数的概念、计算方法以及它们的应用意义,以提高我们的数据分析能力和决策水平。

相关系数与回归系数的区别与联系一、引言在统计学中,相关系数与回归系数是两个非常重要的概念。

相关系数(r)是用来衡量两个变量之间线性关系强度的指标,而回归系数(β)则是用来表示自变量对因变量影响的程度。

尽管两者都与线性关系有关,但在实际应用中,它们有着明显的区别。

本文将阐述这两者的概念、计算方法以及它们在统计分析中的联系与区别。

二、相关系数的定义与计算1.相关系数的定义相关系数(r)是一个介于-1和1之间的数值,它反映了两个变量之间线性关系的强度和方向。

相关系数的绝对值越接近1,表示两个变量之间的线性关系越强;接近0时,表示两个变量之间几乎不存在线性关系。

2.相关系数的计算方法相关系数的计算公式为:r = ∑((x_i-平均x)*(y_i-平均y)) / (√∑(x_i-平均x)^2 * ∑(y_i-平均y)^2) 其中,x_i和y_i分别为变量X和Y的第i个观测值,平均x和平均y分别为X和Y的平均值。

三、回归系数的定义与计算1.回归系数的定义回归系数(β)是指在线性回归分析中,自变量每变动一个单位时,因变量相应变动的量。

回归系数可用于预测因变量值,从而揭示自变量与因变量之间的线性关系。

2.回归系数的计算方法回归系数的计算公式为:β= ∑((x_i-平均x)*(y_i-平均y)) / ∑(x_i-平均x)^2其中,x_i和y_i分别为变量X和Y的第i个观测值,平均x和平均y分别为X和Y的平均值。

四、相关系数与回归系数的关系1.两者在统计分析中的作用相关系数和回归系数都是在统计分析中衡量线性关系的重要指标。

相关系数用于衡量两个变量之间的线性关系强度,而回归系数则用于确定自变量对因变量的影响程度。

2.两者在实际应用中的区别与联系在实际应用中,相关系数和回归系数往往相互关联。

例如,在进行线性回归分析时,回归系数β就是相关系数r在X轴上的投影。

而相关系数r则可以看作是回归系数β的平方。

因此,在实际分析中,我们可以通过相关系数来初步判断两个变量之间的线性关系,进而利用回归系数进行更为精确的预测。

相关性分析及回归分析相关性分析和回归分析是统计学中常用的两种方法,用于研究变量之间的关系。

相关性分析可以帮助我们了解变量之间的关联程度,而回归分析则可以帮助我们预测一个变量对另一个变量的影响程度。

在本文中,我将介绍相关性分析和回归分析的基本概念和方法,并且提供一些实际应用的例子。

相关性分析是一种衡量两个变量之间关系强度和方向的统计分析方法。

它可以告诉我们两个变量是正相关、负相关还是没有相关性。

相关系数是衡量相关性的一个指标,常用的有皮尔逊相关系数和斯皮尔曼相关系数。

皮尔逊相关系数适用于两个连续变量之间的关系,它的取值范围从-1到1,正值表示正相关,负值表示负相关,而0表示没有相关性。

斯皮尔曼相关系数适用于两个顺序变量之间的关系,它的取值范围也是-1到1,含义和皮尔逊相关系数类似。

回归分析是一种建立一个或多个自变量与因变量之间关系的统计模型的方法。

回归模型可以用于预测一个变量对另一个变量的影响程度,并且可以检验自变量的显著性。

在回归分析中,自变量可以是连续变量或者分类变量,而因变量必须是连续变量。

回归模型的基本形式是y = b0 +b1x1 + b2x2 + … + bnxn + ε,其中y代表因变量,x1, x2, …, xn代表自变量,b0, b1, b2, …, bn代表回归系数,ε代表误差项。

一个例子可以更好地说明相关性分析和回归分析的应用。

假设我们想了解一个人的身高和体重之间的关系。

首先我们可以使用相关性分析来衡量身高和体重之间的相关性。

收集一组数据包括人们的身高和体重,然后使用皮尔逊相关系数计算它们之间的相关性。

如果相关系数是正值且接近1,则表示身高和体重呈强正相关;如果相关系数是负值且接近-1,则表示身高和体重呈强负相关;如果相关系数接近0,则表示身高和体重之间没有明显的相关性。

接下来,我们可以使用回归分析来构建一个预测一个人的体重的回归模型。

我们可以将身高作为自变量,体重作为因变量,然后拟合一个回归方程。

统计学中的相关系数与回归分析统计学是一门研究数据收集、分析和解释的学科,其中包括相关系数和回归分析这两个重要的概念。

相关系数和回归分析都是用于了解变量之间的关系以及预测未来趋势的工具。

本文将介绍相关系数和回归分析的基本概念、计算方法和应用场景。

一、相关系数相关系数衡量了两个变量之间的相关程度。

它反映了两个变量的线性关系强度和方向。

常见的相关系数有皮尔逊相关系数(Pearson correlation coefficient)、斯皮尔曼等级相关系数(Spearman's rank correlation coefficient)和切比雪夫距离(Chebyshev distance)等。

皮尔逊相关系数是最常用的相关系数之一。

它通过计算两个变量之间的协方差除以它们各自的标准差的乘积来衡量它们的线性关系。

皮尔逊相关系数的取值范围在-1到1之间,其中1表示完全正相关,-1表示完全负相关,0表示没有线性关系。

通过计算相关系数,我们可以判断变量之间的关系以及预测一个变量的变化情况受到其他变量的程度。

斯皮尔曼等级相关系数是一种非参数相关系数,它不要求变量服从特定的分布。

它通过将原始数据转化为等级来计算变量之间的关系。

斯皮尔曼等级相关系数的取值范围也在-1到1之间,其含义与皮尔逊相关系数类似。

切比雪夫距离是一种度量两个变量之间差异的方法,它不仅考虑了线性关系,还考虑了其他类型的关系,如非线性关系。

切比雪夫距离通常用于分类问题和模式识别领域。

二、回归分析回归分析是一种用于建立因变量和自变量之间关系的统计方法。

它通过寻找最合适的拟合曲线来描述变量之间的函数关系,并用此拟合曲线来预测未来的结果。

简单线性回归是回归分析的一种基本形式,它适用于只有一个自变量和一个因变量的情况。

简单线性回归可以用一条直线来描述变量之间的关系,其中直线的斜率表示了自变量对因变量的影响程度。

多元线性回归是回归分析的一种扩展形式。

它适用于多个自变量和一个因变量的情况。

相关系数和回归系数

相关系数和回归系数是统计学中两个重要的概念,它们能够帮助人们探索、诊断和预测两个变量之间的关系。

本文的目的是详细解释这两种概念,并讨论它们在统计分析中的应用。

首先,我们来谈谈相关系数。

它是一个统计指标,可以用来测量两个变量之间的线性相关性。

它用一个介于-1和+1之间的实数数字表示,如果大于0,表示正相关;如果小于0,表示负相关;如果等于0,表示不存在相关性。

其次,我们来谈回归系数。

回归系数也称为决定系数,它用来衡量因变量和自变量之间的线性关系,间接测量自变量的影响力。

它的取值范围介于0到1之间,其中0表示没有线性关系,1表示完全线性关系,它越接近1,表示自变量对因变量的影响越大。

最后,我们来谈谈这两个概念在统计分析中的应用。

相关系数在探索两个变量之间关系的程度、检验假定和进行类比研究等方面有重要作用;回归系数则被广泛用于回归分析,它衡量自变量预测因变量的程度,帮助我们推测因变量的变化。

总的来说,相关系数和回归系数是统计概念中的重要概念,它们有助于我们探索两个变量之间的关系,并帮助我们进行统计分析和预测。

- 1 -。

相关系数与回归分析是统计学中常用的两个工具,用于研究变量之间的关系和建立统计模型。

它们在实际应用中有着广泛的应用,不仅能够帮助我们理解变量之间的关系,还可以预测未知的数值。

本文将从基本概念、计算方法和应用角度介绍这两个重要的统计学工具。

相关系数是用来衡量两个变量之间关系的强度和方向。

它可以是正的,表示变量间呈正相关;也可以是负的,表示变量间呈负相关;还可以是零,表示变量间没有线性关系。

最常用的相关系数是皮尔逊相关系数,它基于变量的协方差和标准差计算。

皮尔逊相关系数的取值范围为-1到1,值为-1表示完全负相关,值为1表示完全正相关,值为0则表示无相关关系。

回归分析是一种建立统计模型的方法,用于预测和解释变量间的关系。

它通常用线性回归模型进行建模,假设变量之间的关系可以通过一条直线来表示。

线性回归分析的目标是找到最佳拟合直线,使得观测值和预测值之间的差异最小化。

回归分析可以用来研究单一变量对目标变量的影响,也可以通过多元回归来探索多个变量对目标变量的综合影响。

在实际应用中,相关系数和回归分析经常同时使用。

相关系数可以用来初步探索变量之间的关系,判断是否存在相关性。

如果相关系数较高,则可以进一步使用回归分析来建立模型,预测未知的数值。

回归分析可以提供更详细的信息,包括变量间的具体关系和系数的解释。

举一个实际的例子来说明相关系数和回归分析的应用。

假设我们想研究变量X (年龄)和变量Y(收入)之间的关系。

首先,我们可以计算X和Y的相关系数。

如果相关系数为正,并且接近1,则说明年龄和收入呈正相关关系,即年龄越大,收入越高。

接着,我们可以使用回归分析来建立一个线性模型,用年龄来预测收入。

通过回归分析,我们可以得到一个拟合直线,可以根据年龄来预测收入的数值。

例如,如果某个人的年龄为40岁,根据回归模型,我们可以预测他的收入大致在某个区间内。

这样的模型可以帮助我们预测未知的收入,并为相关决策提供参考。

综上所述,相关系数和回归分析是统计学中重要的工具。

相关系数与线性回归分析相关系数和线性回归分析是统计学中常用的方法,用于研究变量之间的关系和进行预测分析。

本文将介绍相关系数和线性回归分析的概念、计算方法和应用场景。

一、相关系数相关系数是用来衡量两个变量之间的相关性强弱的统计指标。

它的取值范围是-1到1之间,值越接近于1或-1,表示两个变量之间的相关性越强;值越接近于0,则表示两个变量之间的相关性越弱。

计算相关系数的方法有多种,常见的是皮尔逊相关系数。

它可以通过协方差和两个变量的标准差来计算。

具体公式如下:r = Cov(X,Y) / (σX *σY)其中,r表示相关系数,Cov(X,Y)表示变量X和Y的协方差,σX和σY分别表示变量X和Y的标准差。

相关系数的应用非常广泛。

例如,在金融领域,相关系数可以用来研究股票之间的关联程度,有助于投资者进行风险分析和资产配置;在医学领域,相关系数可以用来研究疾病因素之间的关系,帮助医生进行诊断和治疗决策。

二、线性回归分析线性回归分析是一种用来研究自变量与因变量之间关系的统计方法。

它通过建立一个线性方程,来描述自变量对因变量的影响程度和方向。

线性回归模型可以通过最小二乘法来估计模型参数。

最小二乘法的基本思想是通过使模型预测值与实际观测值的残差平方和最小化来确定模型参数。

具体公式如下:Y = β0 + β1*X + ε其中,Y表示因变量,X表示自变量,β0和β1表示模型的参数,ε表示误差项。

线性回归分析常用于预测和解释变量之间的关系。

例如,在市场营销中,可以通过线性回归分析来预测产品销售量与价格、广告投入等因素的关系;在经济学中,可以利用线性回归模型来研究GDP与就业率、通货膨胀率等经济指标之间的关系。

三、相关系数与线性回归分析的关系相关系数和线性回归分析常常一起使用,因为它们有着密切的关联。

相关系数可以用来衡量两个变量之间的相关性强弱,而线性回归分析则可以进一步分析两个变量之间的因果关系。

在线性回归分析中,相关系数经常作为检验模型是否适用的依据之一。

报告中如何解读和运用相关系数和回归系数相关系数和回归系数是统计学中常用的测量指标,可以用来描述和解释变量之间的关系。

在报告中,正确解读和运用相关系数和回归系数至关重要,可以帮助读者更加准确地理解数据分析结果和研究结论。

本文将从6个标题展开详细论述相关系数和回归系数的解读和运用。

一、相关系数及其解读相关系数是衡量两个变量之间相关性强弱的一种统计指标。

通过计算相关系数,我们可以了解两个变量之间的线性关系。

有多种相关系数,其中最常见的是皮尔逊相关系数。

1.1 皮尔逊相关系数的计算皮尔逊相关系数的取值范围为-1到1,其计算公式如下:ρ(X, Y) = cov(X, Y) / (σX · σY)其中,ρ(X, Y)表示X和Y的皮尔逊相关系数,cov(X, Y)表示X和Y的协方差,σX和σY分别表示X和Y的标准差。

1.2 相关系数的解读相关系数的绝对值越接近1,表示两个变量之间的相关性越强。

当相关系数接近1时,表示两个变量呈正相关,即随着一个变量的增加,另一个变量也增加;当相关系数接近-1时,表示两个变量呈负相关,即随着一个变量的增加,另一个变量减少;当相关系数接近0时,表示两个变量之间几乎没有线性关系。

二、回归系数及其解读回归系数是线性回归模型中的模型参数,用于描述自变量对因变量的影响。

回归模型可以帮助我们预测因变量的数值,并了解自变量对因变量的贡献程度。

2.1 线性回归模型线性回归模型的基本形式如下:Y = β0 + β1X1 + β2X2 + ... + βnXn其中,Y为因变量,X1、X2、...、Xn为自变量,β0、β1、β2、...、βn为回归系数。

2.2 回归系数的解读回归系数表示自变量对因变量的影响程度。

当回归系数为正时,表示自变量对因变量的增加有正向影响;当回归系数为负时,表示自变量对因变量的增加有负向影响。

回归系数的绝对值越大,表示自变量对因变量的影响越大。

三、运用相关系数进行变量选择在实际研究中,有时我们需要从多个自变量中选择出对因变量影响最显著的变量。

相关系数与回归系数的区别与联系

相关系数和回归系数都是用来描述变量之间关系的统计量,但它们有不同的含义和应用场景。

相关系数(correlation coefficient)是用来衡量两个变量之间线性相关程度的统计量。

它的取值范围在-1 到 1 之间,其中-1 表示完全负相关,1 表示完全正相关,0 表示没有线性相关性。

相关系数的计算方法是通过对变量之间的协方差和标准差进行标准化得到的。

回归系数(regression coefficient)是在回归分析中用来描述自变量对因变量影响大小的统计量。

它的取值范围也在-1 到 1 之间,但它的正负号表示的是自变量对因变量的影响方向,而不是相关性。

回归系数的计算方法是通过最小二乘法求解回归方程得到的。

相关系数和回归系数的区别在于:相关系数衡量的是变量之间的线性相关程度,而回归系数衡量的是自变量对因变量的影响大小。

此外,相关系数只能反映变量之间的线性关系,而回归系数可以反映变量之间的非线性关系。

尽管相关系数和回归系数有不同的含义和应用场景,但它们之间也有一定的联系。

在回归分析中,如果变量之间存在线性相关性,则回归系数的大小可以反映相关系数的大小。

也就是说,如果变量之间的相关系数较大,则回归系数也会较大,反之亦然。

此外,在多元回归分析中,相关系数还可以用来判断自变量之间是否存在多重共线性。

总之,相关系数和回归系数都是用来描述变量之间关系的统计量,但它们有不同的含义和应用场景。

在实际应用中,需要根据具体情况选择合适的统计量来描述变量之间的关系。

统计学的相关与回归分析统计学是一门研究数据收集、分析和解释的学科。

相关与回归分析是统计学中常用的两种方法,用于探索和解释变量之间的关系。

本文将介绍相关与回归分析的基本概念、应用和意义。

一、相关分析相关分析用于确定两个或多个变量之间的关联程度。

相关系数是用来衡量变量之间线性相关关系强弱的统计指标。

相关系数的取值范围为-1到+1,其中-1表示完全负相关,+1表示完全正相关,0表示无相关关系。

相关分析的步骤如下:1. 收集数据:收集相关的数据,包括两个或多个变量的观测值。

2. 计算相关系数:使用合适的统计软件计算相关系数,如皮尔逊相关系数(Pearson)或斯皮尔曼等级相关系数(Spearman)。

3. 判断相关性:根据相关系数的取值范围,判断变量之间的关系。

相关系数接近于-1或+1时,表明变量之间线性相关性较强,接近于0时表示无相关性。

4. 解释结果:根据相关分析的结果,解释变量之间关联的程度和方向。

相关分析的应用:- 市场调研:通过相关分析可以了解产品的市场需求和用户行为之间是否存在相关关系,以指导市场决策。

- 医学研究:相关分析可以帮助医学研究人员确定疾病与危险因素之间的相关性,从而提供预防和治疗方案。

二、回归分析回归分析用于描述和预测因变量与自变量之间的关系。

通过回归分析可以建立一个数学模型,根据自变量的取值来预测因变量的值。

回归分析常用的方法包括线性回归、多项式回归和逻辑回归等。

回归分析的步骤如下:1. 收集数据:收集因变量和自变量之间的观测数据。

2. 建立模型:选择适当的回归模型,如线性回归模型、多项式回归模型或逻辑回归模型。

3. 拟合模型:使用统计软件对回归模型进行拟合,得到回归系数和拟合优度指标。

4. 检验模型:通过假设检验和拟合优度指标来评估回归模型的适应程度和预测能力。

5. 解释结果:根据回归系数和显著性水平,解释自变量对因变量的影响程度和方向。

回归分析的应用:- 经济预测:回归分析可以用于预测国民经济指标、股票价格和消费行为等。

相关系数与线性回归分析数据分析是现代社会中不可或缺的一部分,它帮助我们了解事物之间的相互关系。

在数据分析中,相关系数与线性回归分析是常用的统计工具,它们可以揭示变量之间的关联和预测未来的趋势。

本文将以深入浅出的方式介绍相关系数与线性回归分析的原理、应用和局限性。

相关系数是用来衡量两个变量之间的统计依赖性的指标。

它的取值范围从-1到1,其中0表示没有线性关系,1表示完全正相关,-1表示完全负相关。

常用的相关系数有皮尔逊相关系数和斯皮尔曼等级相关系数。

皮尔逊相关系数是用来衡量两个连续变量之间线性关系的强弱的指标。

它的计算公式为cov(X,Y)/(σX σY),其中cov(X,Y)代表X和Y的协方差,σX和σY分别代表X和Y的标准差。

如果相关系数接近于1,则表示两个变量之间存在强正相关关系;如果接近于-1,则表示存在强负相关关系;如果接近于0,则表示两个变量之间没有线性关系。

斯皮尔曼等级相关系数是用来衡量两个有序变量之间的相关性的指标。

它通过将每个变量的原始值转换为等级值,并计算等级之间的差异来确定相关性。

斯皮尔曼等级相关系数的取值范围与皮尔逊相关系数相同,但它不要求变量之间呈现线性关系。

相关系数的应用非常广泛。

在金融领域中,相关系数可以用来衡量不同证券之间的关联性,帮助投资者构建更稳健的投资组合。

在医学研究中,相关系数可以用来分析不同变量对疾病风险的影响,为医生提供指导性建议。

在社会科学中,相关系数可以帮助研究者了解不同因素对人们态度和行为的影响,从而改善政策和社会管理的决策。

除了相关系数,线性回归分析也是一种常用的统计方法。

线性回归分析通过拟合一条直线来描述两个变量之间的关系,它的基本形式为Y = β0 + β1X + ε,其中Y表示因变量,X表示自变量,β0和β1表示回归系数,ε表示误差项。

线性回归分析的目标是找到最佳拟合线,使得回归系数能够准确地预测Y的变化。

线性回归分析的应用广泛。

在市场营销中,线性回归分析可以帮助企业了解消费者购买意愿与价格、促销活动等因素之间的关系,从而制定更有效的营销策略。

统计学中的回归分析与相关系数统计学中,回归分析和相关系数是两个重要的概念和方法,它们可以帮助我们理解数据之间的关系、预测未来趋势以及评估变量之间的相互作用。

本文将介绍回归分析的基本原理和应用,以及相关系数的定义和计算方法。

一、回归分析回归分析是一种统计方法,用于研究两个或多个变量之间的关系,并建立一个数学模型来描述这种关系。

在回归分析中,我们通常将一个变量称为因变量(dependent variable),将其他变量称为自变量(independent variable)。

回归分析的目标是找到一个关系模型,使得自变量能够解释因变量的变化。

在简单线性回归中,我们假设只有一个自变量和一个因变量之间存在线性关系。

回归模型可以表示为:Y = α + βX + ε其中,Y表示因变量,X表示自变量,α和β是待估计的参数,ε表示误差项。

通过最小二乘法估计参数α和β,我们可以得到最佳拟合直线,以描述自变量和因变量之间的关系。

除了简单线性回归,我们还可以进行多元线性回归,其中自变量可以是多个。

多元线性回归将回归模型拓展为:Y = α + β₁X₁ + β₂X₂ + ... + βₖXₖ + ε通过最小二乘法,我们可以估计所有的参数β₁,β₂,...,βₖ。

多元线性回归分析可以帮助我们更全面地理解多个自变量对因变量的影响。

回归分析不仅可以用于探索变量之间的关系,还可以用于预测未来的数值。

通过已知的自变量值,我们可以利用回归模型来预测因变量的值。

这使得回归分析在实际应用中非常有用,例如经济学、金融学、市场营销等领域。

二、相关系数相关系数是衡量两个变量之间线性关系强度的统计指标,常用于描述变量之间的相关程度。

最常用的相关系数是皮尔逊相关系数,表示为r。

皮尔逊相关系数的取值范围为-1到1之间,其中1表示完全正相关,-1表示完全负相关,0表示无线性关系。

皮尔逊相关系数可以通过以下公式计算:r = Σ((Xᵢ - X)(Yᵢ - Ȳ)) / √(Σ(Xᵢ - X)²Σ(Yᵢ - Ȳ)²)其中,Xᵢ和Yᵢ分别表示X和Y的观测值,X和Ȳ分别表示X和Y的平均值。