机器学习-朴素贝叶斯学习-原理分析与C语言代码实现

- 格式:pdf

- 大小:449.08 KB

- 文档页数:7

利用c++实现贝叶斯公式摘要:1.贝叶斯公式的介绍2.C++实现贝叶斯公式的步骤3.代码展示及解析4.结论正文:贝叶斯公式是概率论中一个非常重要的公式,它描述了在已知某条件概率的情况下,求解相关联的逆条件概率。

具体公式如下:P(A|B) = P(B|A) * P(A) / P(B)其中,P(A|B) 表示在已知事件B 发生的情况下,事件A 发生的概率;P(B|A) 表示在已知事件A 发生的情况下,事件B 发生的概率;P(A) 和P(B) 分别表示事件A 和事件B 的概率。

接下来,我们将介绍如何利用C++ 实现贝叶斯公式。

首先,我们需要定义一个结构体,用于存储事件的名称和发生的概率:```cppstruct Event {string name;double probability;};```接着,我们需要实现一个计算贝叶斯公式的函数:```cppdouble calculateBayes(const vector<Event>& events, string condition, string hypothesis) {// 计算P(B)double P_B = 0.0;for (const auto& event : events) {if ( == condition) {P_B += event.probability;}}// 计算P(A|B)double P_A_B = 0.0;for (const auto& event : events) {if ( == condition) {for (const auto& otherEvent : events) {if ( == hypothesis && != condition) {P_A_B += event.probability * otherEvent.probability;}}}}// 计算P(A)double P_A = 0.0;for (const auto& event : events) {if ( == hypothesis) {P_A += event.probability;}}// 返回贝叶斯公式结果return P_A_B / P_A;}```最后,我们可以通过以下方式使用这个函数:```cppvector<Event> events = {{"A", 0.2},{"B", 0.3},{"C", 0.5},{"D", 0.4},{"E", 0.1},};double result = calculateBayes(events, "B", "A");cout << "P(A|B) = " << result << endl;```以上代码首先定义了一个结构体Event,用于存储事件的名称和发生的概率。

朴素贝叶斯算法及其代码实现朴素贝叶斯朴素贝叶斯是经典的机器学习算法之⼀,也是为数不多的基于概率论的分类算法。

在机器学习分类算法中,朴素贝叶斯和其他绝多⼤的分类算法都不同,⽐如决策树,KNN,逻辑回归,⽀持向量机等,他们都是判别⽅法,也就是直接学习出特征输出Y和特征X之间的关系,要么是决策函数,要么是条件分布。

但是朴素贝叶斯却是⽣成⽅法,这种算法简单,也易于实现。

1.基本概念朴素贝叶斯:贝叶斯分类是⼀类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类。

⽽朴素贝叶斯分类时贝叶斯分类中最简单,也是最常见的⼀种分类⽅法。

贝叶斯公式:先验概率P(X):先验概率是指根据以往经验和分析得到的概率。

后验概率P(Y|X):事情已经发⽣,要求这件事情发⽣的原因是由某个因素引起的可能性的⼤⼩,后验分布P(Y|X)表⽰事件X已经发⽣的前提下,事件Y发⽣的概率,叫做事件X发⽣下事件Y的条件概率。

后验概率P(X|Y):在已知Y发⽣后X的条件概率,也由于知道Y的取值⽽被称为X的后验概率。

朴素:朴素贝叶斯算法是假设各个特征之间相互独⽴,也是朴素这词的意思,那么贝叶斯公式中的P(X|Y)可写成:朴素贝叶斯公式:2,贝叶斯算法简介 贝叶斯⽅法源域它⽣前为解决⼀个“逆概”问题写的⼀篇⽂章。

其要解决的问题: 正向概率:假设袋⼦⾥⾯有N个⽩球,M个⿊球,你伸⼿进去摸⼀把,摸出⿊球的概率是多⼤ 逆向概率:如果我们事先不知道袋⼦⾥⾯⿊⽩球的⽐例,⽽是闭着眼睛摸出⼀个(或者好⼏个)球,观察这些取出来的球的颜⾊之后,那么我们可以就此对袋⼦⾥⾯的⿊⽩球的⽐例做出什么样的推测。

那么什么是贝叶斯呢?1,现实世界本⾝就是不确定的,⼈类的观察能⼒是有局限性的2,我们⽇常观察到的只是事物表明上的结果,因此我们需要提供⼀个猜测 NaiveBayes算法,⼜称朴素贝叶斯算法。

朴素:特征条件独⽴;贝叶斯:基于贝叶斯定理。

属于监督学习的⽣成模型,实现监督,没有迭代,并有坚实的数学理论(即贝叶斯定理)作为⽀撑。

机器学习:贝叶斯分类器(⼆)——⾼斯朴素贝叶斯分类器代码实现⼀⾼斯朴素贝叶斯分类器代码实现⽹上搜索不调⽤sklearn实现的朴素贝叶斯分类器基本很少,即使有也是结合⽂本分类的多项式或伯努利类型,因此⾃⼰写了⼀遍能直接封装的⾼斯类型NB分类器,当然与真正的源码相⽐少了很多属性和⽅法,有兴趣的可以⾃⼰添加。

代码如下(有详细注释):class NaiveBayes():'''⾼斯朴素贝叶斯分类器'''def __init__(self):self._X_train = Noneself._y_train = Noneself._classes = Noneself._priorlist = Noneself._meanmat = Noneself._varmat = Nonedef fit(self, X_train, y_train):self._X_train = X_trainself._y_train = y_trainself._classes = np.unique(self._y_train) # 得到各个类别priorlist = []meanmat0 = np.array([[0, 0, 0, 0]])varmat0 = np.array([[0, 0, 0, 0]])for i, c in enumerate(self._classes):# 计算每个种类的平均值,⽅差,先验概率X_Index_c = self._X_train[np.where(self._y_train == c)] # 属于某个类别的样本组成的“矩阵”priorlist.append(X_Index_c.shape[0] / self._X_train.shape[0]) # 计算类别的先验概率X_index_c_mean = np.mean(X_Index_c, axis=0, keepdims=True) # 计算该类别下每个特征的均值,结果保持⼆维状态[[3 4 6 2 1]]X_index_c_var = np.var(X_Index_c, axis=0, keepdims=True) # ⽅差meanmat0 = np.append(meanmat0, X_index_c_mean, axis=0) # 各个类别下的特征均值矩阵罗成新的矩阵,每⾏代表⼀个类别。

朴素贝叶斯原理、实例与Python实现初步理解⼀下:对于⼀组输⼊,根据这个输⼊,输出有多种可能性,需要计算每⼀种输出的可能性,以可能性最⼤的那个输出作为这个输⼊对应的输出。

那么,如何来解决这个问题呢?贝叶斯给出了另⼀个思路。

根据历史记录来进⾏判断。

思路是这样的:1、根据贝叶斯公式:P(输出|输⼊)=P(输⼊|输出)*P(输出)/P(输⼊)2、P(输⼊)=历史数据中,某个输⼊占所有样本的⽐例;3、P(输出)=历史数据中,某个输出占所有样本的⽐例;4、P(输⼊|输出)=历史数据中,某个输⼊,在某个输出的数量占所有样本的⽐例,例如:30岁,男性,中午吃⾯条,其中【30岁,男性就是输⼊】,【中午吃⾯条】就是输出。

⼀、条件概率的定义与贝叶斯公式⼆、朴素贝叶斯分类算法朴素贝叶斯是⼀种有监督的分类算法,可以进⾏⼆分类,或者多分类。

⼀个数据集实例如下图所⽰:现在有⼀个新的样本, X = (年龄:<=30, 收⼊:中,是否学⽣:是,信誉:中),⽬标是利⽤朴素贝叶斯分类来进⾏分类。

假设类别为C(c1=是或 c2=否),那么我们的⽬标是求出P(c1|X)和P(c2|X),⽐较谁更⼤,那么就将X分为某个类。

下⾯,公式化朴素贝叶斯的分类过程。

三、实例下⾯,将下⾯这个数据集作为训练集,对新的样本X = (年龄:<=30, 收⼊:中,是否学⽣:是,信誉:中) 作为测试样本,进⾏分类。

我们可以将这个实例中的描述属性和类别属性,与公式对应起来,然后计算。

参考python实现代码#coding:utf-8# 极⼤似然估计朴素贝叶斯算法import pandas as pdimport numpy as npclass NaiveBayes(object):def getTrainSet(self):dataSet = pd.read_csv('F://aaa.csv')dataSetNP = np.array(dataSet) #将数据由dataframe类型转换为数组类型trainData = dataSetNP[:,0:dataSetNP.shape[1]-1] #训练数据x1,x2labels = dataSetNP[:,dataSetNP.shape[1]-1] #训练数据所对应的所属类型Yreturn trainData, labelsdef classify(self, trainData, labels, features):#求labels中每个label的先验概率labels = list(labels) #转换为list类型labelset = set(labels)P_y = {} #存⼊label的概率for label in labelset:P_y[label] = labels.count(label)/float(len(labels)) # p = count(y) / count(Y)print(label,P_y[label])#求label与feature同时发⽣的概率P_xy = {}for y in P_y.keys():y_index = [i for i, label in enumerate(labels) if label == y] # labels中出现y值的所有数值的下标索引for j in range(len(features)): # features[0] 在trainData[:,0]中出现的值的所有下标索引x_index = [i for i, feature in enumerate(trainData[:,j]) if feature == features[j]]xy_count = len(set(x_index) & set(y_index)) # set(x_index)&set(y_index)列出两个表相同的元素pkey = str(features[j]) + '*' + str(y)P_xy[pkey] = xy_count / float(len(labels))print(pkey,P_xy[pkey])#求条件概率P = {}for y in P_y.keys():for x in features:pkey = str(x) + '|' + str(y)P[pkey] = P_xy[str(x)+'*'+str(y)] / float(P_y[y]) #P[X1/Y] = P[X1Y]/P[Y]print(pkey,P[pkey])#求[2,'S']所属类别F = {} #[2,'S']属于各个类别的概率for y in P_y:F[y] = P_y[y]for x in features:F[y] = F[y]*P[str(x)+'|'+str(y)] #P[y/X] = P[X/y]*P[y]/P[X],分母相等,⽐较分⼦即可,所以有F=P[X/y]*P[y]=P[x1/Y]*P[x2/Y]*P[y] print(str(x),str(y),F[y])features_label = max(F, key=F.get) #概率最⼤值对应的类别return features_labelif__name__ == '__main__':nb = NaiveBayes()# 训练数据trainData, labels = nb.getTrainSet()# x1,x2features = [8]# 该特征应属于哪⼀类result = nb.classify(trainData, labels, features)print(features,'属于',result)#coding:utf-8#朴素贝叶斯算法贝叶斯估计,λ=1 K=2, S=3;λ=1 拉普拉斯平滑import pandas as pdimport numpy as npclass NavieBayesB(object):def__init__(self):self.A = 1 # 即λ=1self.K = 2self.S = 3def getTrainSet(self):trainSet = pd.read_csv('F://aaa.csv')trainSetNP = np.array(trainSet) #由dataframe类型转换为数组类型trainData = trainSetNP[:,0:trainSetNP.shape[1]-1] #训练数据x1,x2labels = trainSetNP[:,trainSetNP.shape[1]-1] #训练数据所对应的所属类型Yreturn trainData, labelsdef classify(self, trainData, labels, features):labels = list(labels) #转换为list类型#求先验概率P_y = {}for label in labels:P_y[label] = (labels.count(label) + self.A) / float(len(labels) + self.K*self.A)#求条件概率P = {}for y in P_y.keys():y_index = [i for i, label in enumerate(labels) if label == y] # y在labels中的所有下标y_count = labels.count(y) # y在labels中出现的次数for j in range(len(features)):pkey = str(features[j]) + '|' + str(y)x_index = [i for i, x in enumerate(trainData[:,j]) if x == features[j]] # x在trainData[:,j]中的所有下标 xy_count = len(set(x_index) & set(y_index)) #x y同时出现的次数P[pkey] = (xy_count + self.A) / float(y_count + self.S*self.A) #条件概率#features所属类F = {}for y in P_y.keys():F[y] = P_y[y]for x in features:F[y] = F[y] * P[str(x)+'|'+str(y)]features_y = max(F, key=F.get) #概率最⼤值对应的类别return features_yif__name__ == '__main__':nb = NavieBayesB()# 训练数据trainData, labels = nb.getTrainSet()# x1,x2features = [10]# 该特征应属于哪⼀类result = nb.classify(trainData, labels, features)print(features,'属于',result)参考链接:https:///ten_sory/article/details/81237169。

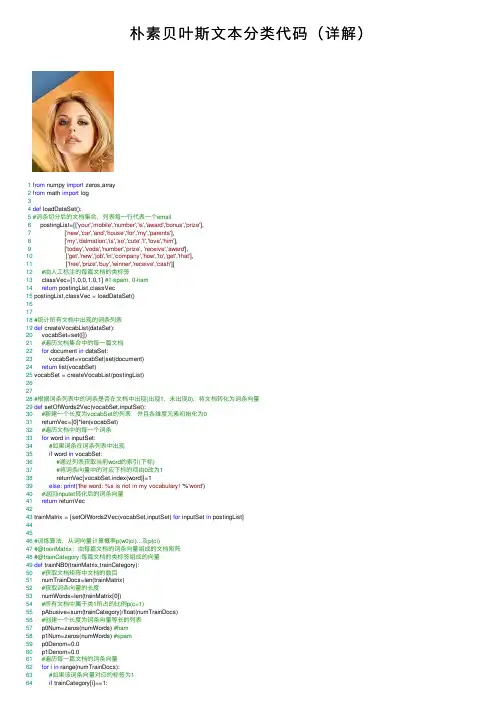

朴素贝叶斯⽂本分类代码(详解)1from numpy import zeros,array2from math import log34def loadDataSet():5#词条切分后的⽂档集合,列表每⼀⾏代表⼀个email6 postingList=[['your','mobile','number','is','award','bonus','prize'],7 ['new','car','and','house','for','my','parents'],8 ['my','dalmation','is','so','cute','I','love','him'],9 ['today','voda','number','prize', 'receive','award'],10 ['get','new','job','in','company','how','to','get','that'],11 ['free','prize','buy','winner','receive','cash']]12#由⼈⼯标注的每篇⽂档的类标签13 classVec=[1,0,0,1,0,1] #1-spam, 0-ham14return postingList,classVec15 postingList,classVec = loadDataSet()161718#统计所有⽂档中出现的词条列表19def createVocabList(dataSet):20 vocabSet=set([])21#遍历⽂档集合中的每⼀篇⽂档22for document in dataSet:23 vocabSet=vocabSet|set(document)24return list(vocabSet)25 vocabSet = createVocabList(postingList)262728#根据词条列表中的词条是否在⽂档中出现(出现1,未出现0),将⽂档转化为词条向量29def setOfWords2Vec(vocabSet,inputSet):30#新建⼀个长度为vocabSet的列表,并且各维度元素初始化为031 returnVec=[0]*len(vocabSet)32#遍历⽂档中的每⼀个词条33for word in inputSet:34#如果词条在词条列表中出现35if word in vocabSet:36#通过列表获取当前word的索引(下标)37#将词条向量中的对应下标的项由0改为138 returnVec[vocabSet.index(word)]=139else: print('the word: %s is not in my vocabulary! '%'word')40#返回inputet转化后的词条向量41return returnVec4243 trainMatrix = [setOfWords2Vec(vocabSet,inputSet) for inputSet in postingList]444546#训练算法,从词向量计算概率p(w0|ci)...及p(ci)47#@trainMatrix:由每篇⽂档的词条向量组成的⽂档矩阵48#@trainCategory:每篇⽂档的类标签组成的向量49def trainNB0(trainMatrix,trainCategory):50#获取⽂档矩阵中⽂档的数⽬51 numTrainDocs=len(trainMatrix)52#获取词条向量的长度53 numWords=len(trainMatrix[0])54#所有⽂档中属于类1所占的⽐例p(c=1)55 pAbusive=sum(trainCategory)/float(numTrainDocs)56#创建⼀个长度为词条向量等长的列表57 p0Num=zeros(numWords) #ham58 p1Num=zeros(numWords) #spam59 p0Denom=0.060 p1Denom=0.061#遍历每⼀篇⽂档的词条向量62for i in range(numTrainDocs):63#如果该词条向量对应的标签为164if trainCategory[i]==1:65#统计所有类别为1的词条向量中各个词条出现的次数66 p1Num+=trainMatrix[i]67#统计类别为1的词条向量中出现的所有词条的总数68#即统计类1所有⽂档中出现单词的数⽬69 p1Denom+=sum(trainMatrix[i])70else:71#统计所有类别为0的词条向量中各个词条出现的次数72 p0Num+=trainMatrix[i]73#统计类别为0的词条向量中出现的所有词条的总数74#即统计类0所有⽂档中出现单词的数⽬75 p0Denom+=sum(trainMatrix[i])76print(p1Num, p1Denom, p0Num,p0Denom )77#利⽤NumPy数组计算p(wi|c1)78 p1Vect=p1Num/p1Denom #为避免下溢出问题,需要改为log()79#利⽤NumPy数组计算p(wi|c0)80 p0Vect=p0Num/p0Denom #为避免下溢出问题,需要改为log()81return p0Vect,p1Vect,pAbusive8283 p0Vect,p1Vect,pAbusive= trainNB0(trainMatrix,classVec)848586#朴素贝叶斯分类函数87#@vec2Classify:待测试分类的词条向量88#@p0Vec:类别0所有⽂档中各个词条出现的频数p(wi|c0)89#@p0Vec:类别1所有⽂档中各个词条出现的频数p(wi|c1)90#@pClass1:类别为1的⽂档占⽂档总数⽐例91def classifyNB(vec2Classify,p0Vec,p1Vec,pClass1):92#根据朴素贝叶斯分类函数分别计算待分类⽂档属于类1和类0的概率93 p1=sum(vec2Classify*p1Vec)+log(pClass1)94 p0=sum(vec2Classify*p0Vec)+log(1.0-pClass1)95if p1>p0:96return'spam'97else:98return'not spam'99100101102 testEntry=['love','my','job']103 thisDoc=array(setOfWords2Vec(vocabSet,testEntry))104print(testEntry,'classified as:',classifyNB(thisDoc,p0Vect,p1Vect,pAbusive))。

朴素贝叶斯算法,贝叶斯分类算法,贝叶斯定理原理朴素贝叶斯算法,贝叶斯分类算法,贝叶斯定理原理贝叶斯分类算法是统计学的⼀种分类⽅法,它是⼀类利⽤概率统计知识进⾏分类的算法。

在许多场合,朴素贝叶斯(Naïve Bayes,NB)分类算法可以与决策树和神经⽹络分类算法相媲美,该算法能运⽤到⼤型数据库中,⽽且⽅法简单、分类准确率⾼、速度快。

由于贝叶斯定理假设⼀个属性值对给定类的影响独⽴于其它属性的值,⽽此假设在实际情况中经常是不成⽴的,因此其分类准确率可能会下降。

为此,就衍⽣出许多降低独⽴性假设的贝叶斯分类算法,如TAN(tree augmented Bayes network)算法。

朴素贝叶斯算法的核⼼思想:选择具有最⾼后验概率作为确定类别的指标。

--------------------朴素贝叶斯算法设每个数据样本⽤⼀个n维特征向量来描述n个属性的值,即:X={x1,x2,…,xn},假定有m个类,分别⽤C1, C2,…,Cm表⽰。

给定⼀个未知的数据样本X(即没有类标号),若朴素贝叶斯分类法将未知的样本X分配给类Ci,则⼀定是P(Ci|X)>P(Cj|X) 1≤j≤m,j≠i根据贝叶斯定理由于P(X)对于所有类为常数,最⼤化后验概率P(Ci|X)可转化为最⼤化先验概率P(X|Ci)P(Ci)。

如果训练数据集有许多属性和元组,计算P(X|Ci)的开销可能⾮常⼤,为此,通常假设各属性的取值互相独⽴,这样先验概率P(x1|Ci),P(x2|Ci),…,P(xn|Ci)可以从训练数据集求得。

根据此⽅法,对⼀个未知类别的样本X,可以先分别计算出X属于每⼀个类别Ci的概率P(X|Ci)P(Ci),然后选择其中概率最⼤的类别作为其类别。

朴素贝叶斯算法成⽴的前提是各属性之间互相独⽴。

当数据集满⾜这种独⽴性假设时,分类的准确度较⾼,否则可能较低。

另外,该算法没有分类规则输出。

在所有的机器学习分类算法中,朴素贝叶斯和其他绝⼤多数的分类算法都不同。

贝叶斯分类器(3)朴素贝叶斯分类器根据,我们对贝叶斯分类器所要解决的问题、问题的求解⽅法做了概述,将贝叶斯分类问题转化成了求解P(x|c)的问题,在上⼀篇中,我们分析了第⼀个求解⽅法:极⼤似然估计。

在本篇中,我们来介绍⼀个更加简单的P(x|c)求解⽅法,并在此基础上讲讲常⽤的⼀个贝叶斯分类器的实现:朴素贝叶斯分类器(Naive Bayes classifier)。

1 朴素贝叶斯分类原理1.1 分类问题回顾我们的⽬标是通过对样本的学习来得到⼀个分类器,以此来对未知数据进⾏分类,即求后验概率P(c|x)。

在中,我们描述了贝叶斯分类器是以⽣成式模型的思路来处理这个问题的,如下⾯的公式所⽰,贝叶斯分类器通过求得联合概率P(x,c)来计算P(c|x),并将联合概率P(x,c)转化成了计算类先验概率P(c)、类条件概率P(x|c)、证据因⼦P(x)。

h∗(x)=\argmax c∈Y P(c|x)=\argmax c∈Y P(x,c)P(x)=\argmaxc∈YP(c)∗P(x|c)P(x)其中的难点是类条件概率P(x|c)的计算,因为样本x本⾝就是其所有属性的联合概率,各种属性随意组合,变幻莫测,要计算其中某⼀种组合出现的概率真的是太难了,⽽朴素贝叶斯的出现就是为了解决这个问题的。

要想计算联合概率P(a,b),我们肯定是希望事件a与事件b是相互独⽴的,可以简单粗暴的P(a,b)=P(a)P(b),多想对着流星许下⼼愿:让世界上复杂的联合概率都变成简单的连乘!1.2 朴素贝叶斯朴素贝叶斯实现了我们的梦想!朴素贝叶斯中的朴素就是对多属性的联合分布做了⼀个⼤胆的假设,即x的n个维度之间相互独⽴:P([x1,x2,...,x n]|c)=P(x1|c)P(x2|c)...P(x1|c)朴素贝叶斯通过这⼀假设⼤⼤简化了P(x|c)的计算,当然,使⽤这个假设是有代价的,⼀般情况下,⼤量样本的特征之间独⽴这个条件是弱成⽴的,毕竟哲学上说联系是普遍的,所以我们使⽤朴素贝叶斯会降低⼀些准确性;如果实际问题中的事件的各个属性⾮常不独⽴的话,甚⾄是⽆法使⽤朴素贝叶斯的。

朴素贝叶斯分类算法python代码朴素贝叶斯分类算法是一种基于概率的统计分类算法,该算法的主要实现思想是对预测对象进行特征提取、概率计算和分类判断,以实现对对象的分类识别。

本文将重点介绍朴素贝叶斯分类算法在Python中的应用与实现,以帮助读者更好地理解该算法。

首先,我们需要了解Bayes理论,在Bayes理论中,条件概率是指在已知某些条件的情况下,某一事件发生的概率。

朴素贝叶斯分类算法是基于该理论的,以此为基础,实现了对预测对象的分类。

具体来说,朴素贝叶斯分类算法的过程如下:1. 建立分类模型:在统计学习中,首先需要建立一种分类模型,这种模型在朴素贝叶斯分类算法中是基于特征集的贝叶斯定理来定义的。

2. 提取特征:在对预测对象进行分类前,需要先对对象进行特征提取,将其转化为数值型特征,以便后续计算分析。

常用的特征提取方法包括文本处理技术、特征选择等。

3. 计算概率:得到特征集后,基于该特征集进行预测。

可以利用训练集中的概率分布计算当前对象的概率分布。

其中,朴素贝叶斯分类算法中的“朴素”指假设特征之间是独立的,即每个特征对目标类别的影响是相互独立的,这使得计算概率分布更为简单和快速。

4. 进行分类:根据最大化概率的准则,将对象分类到概率最高的类别中。

例如,若某对象概率最高的类别为“正常”,则将该对象分类到“正常”类别中。

在Python中,可以借助于sklearn包来实现朴素贝叶斯分类算法。

下面进行一些示例代码来对其进行解释:''' import numpy as np from sklearn.naive_bayes import GaussianNB from sklearn.model_selection import train_test_split from sklearn import datasets# 读取iris数据集 iris = datasets.load_iris() X = iris.data y = iris.target# 划分训练集和测试集 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3) # 建立高斯朴素贝叶斯分类器 gnb = GaussianNB() gnb.fit(X_train, y_train) # 训练模型# 对测试集进行预测 y_pred = gnb.predict(X_test)# 输出结果 print('Accuracy:', np.sum(y_pred == y_test) / len(y_test)) '''这段代码演示了如何使用sklearn包中的高斯朴素贝叶斯分类器进行分类。

常见机器学习算法的原理和应用分析机器学习(Machine Learning, ML)是人工智能(Artificial Intelligence, AI)的核心领域之一,是一种通过样本数据对机器进行训练、自主探索特征规律及进行预测、判断等任务的方法。

机器学习算法是机器学习的核心内容,针对不同的问题和数据,具有不同的算法模型。

本文将针对常见机器学习算法的原理和应用进行分析。

一、监督学习算法监督学习算法是最为常见的机器学习算法,它的训练样本包含输入和输出的对应关系。

在监督学习算法中,常用的模型有决策树、随机森林、朴素贝叶斯、支持向量机等。

1. 决策树决策树(Decision Tree)是一种基于树形结构进行决策分析的算法。

通过将数据样本划分成多个类别,并形成一颗树状结构,确定样本通过树状结构的哪个分支可归属于哪个类别。

在决策树的构建过程中,通常采用递归的形式,对样本数据进行分裂。

具体地,根据所有属性的每个划分,都计算一个信息增益,并选择信息增益最大的属性作为当前节点的划分属性,对该属性进行划分。

直到叶子节点的样本属于同一类,或者节点所代表的属性集合为空时迭代结束。

2. 随机森林随机森林(Random Forest)是一种基于多个决策树构建的集成模型,以降低模型方差,提高模型精度。

随机森林的构建方式是通过对多个决策树在选择属性、分裂点时采用随机方法,形成多个弱分类器,共同进行综合决策。

随机森林的训练过程中,先利用自助式(Bootstrap)采样原始数据形成数据集,再分别随机选择每棵树的属性和分裂点,构建决策树。

最后,通过投票方式将多个决策树的结果进行集成,形成一个最终的整体结果。

3. 朴素贝叶斯朴素贝叶斯(Naive Bayes)是一种基于贝叶斯定理而来的分类算法,其基本思想是通过先验概率和概率密度函数,通过样本数据推导后验概率,最后对样本进行分类。

朴素贝叶斯算法假设所有特征都是相互独立的,并把各个特征的概率合成后,再根据贝叶斯公式计算后验概率,进行分类。

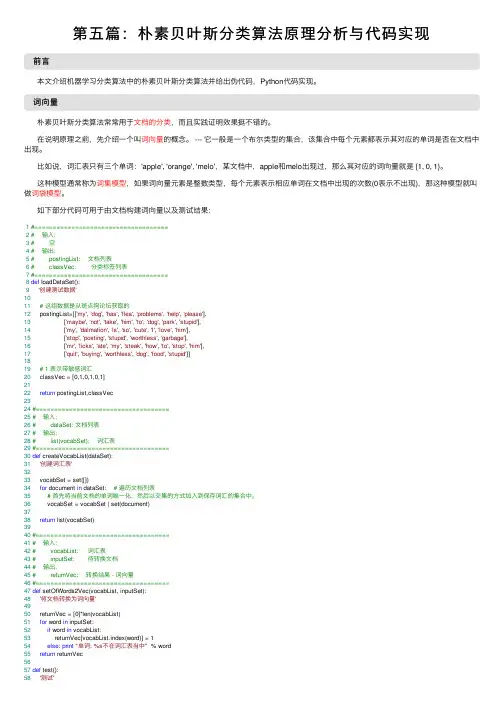

第五篇:朴素贝叶斯分类算法原理分析与代码实现前⾔本⽂介绍机器学习分类算法中的朴素贝叶斯分类算法并给出伪代码,Python代码实现。

词向量朴素贝叶斯分类算法常常⽤于⽂档的分类,⽽且实践证明效果挺不错的。

在说明原理之前,先介绍⼀个叫词向量的概念。

--- 它⼀般是⼀个布尔类型的集合,该集合中每个元素都表⽰其对应的单词是否在⽂档中出现。

⽐如说,词汇表只有三个单词:'apple', 'orange', 'melo',某⽂档中,apple和melo出现过,那么其对应的词向量就是 {1, 0, 1}。

这种模型通常称为词集模型,如果词向量元素是整数类型,每个元素表⽰相应单词在⽂档中出现的次数(0表⽰不出现),那这种模型就叫做词袋模型。

如下部分代码可⽤于由⽂档构建词向量以及测试结果:1#====================================2# 输⼊:3# 空4# 输出:5# postingList: ⽂档列表6# classVec: 分类标签列表7#====================================8def loadDataSet():9'创建测试数据'1011# 这组数据是从斑点狗论坛获取的12 postingList=[['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],13 ['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'],14 ['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'],15 ['stop', 'posting', 'stupid', 'worthless', 'garbage'],16 ['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],17 ['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]1819# 1 表⽰带敏感词汇20 classVec = [0,1,0,1,0,1]2122return postingList,classVec2324#====================================25# 输⼊:26# dataSet: ⽂档列表27# 输出:28# list(vocabSet): 词汇表29#====================================30def createVocabList(dataSet):31'创建词汇表'3233 vocabSet = set([])34for document in dataSet: # 遍历⽂档列表35# ⾸先将当前⽂档的单词唯⼀化,然后以交集的⽅式加⼊到保存词汇的集合中。

朴素贝叶斯c代码实现朴素贝叶斯分类器是一种常见的文本分类算法,它的主要思想是利用贝叶斯定理计算出文本属于某个类别的概率,然后选择概率最大的类别作为分类结果。

以下是一个使用 C 语言实现朴素贝叶斯分类器的示例代码:```c#include <stdio.h>#include <stdlib.h>#include <string.h>#include <math.h>#define MAX_FEATURES 1000#define MAX_SAMPLES 1000int num_features; // 特征数int num_samples; // 样本数int num_classes; // 类别数// 存储训练数据void train_data(char filename[]) {FILE *file = fopen(filename, "r");if (file == NULL) {printf("无法打开文件\n");exit(1);}char line[MAX_FEATURES];while (fgets(line, sizeof(line), file)) {char *token = strtok(line, "\t");if (token == NULL) {continue;}int feature = atoi(token);token = strtok(NULL, "\t");if (token == NULL) {continue;}int classlabel = atoi(token);add_sample(feature, classlabel);}fclose(file);}// 添加样本到训练数据中void add_sample(int feature, int classlabel) { if (num_samples >= MAX_SAMPLES) {printf("达到最大样本数\n");exit(1);}sample[num_samples].feature = feature;sample[num_samples].classlabel = classlabel; num_samples++;}// 对训练数据进行朴素贝叶斯分类void naive_bayes() {int i, j;double p[MAX_FEATURES];double likehood[MAX_FEATURES][num_classes]; // 初始化概率for (i = 0; i < num_features; i++) {p[i] = 1.0 / num_features;for (j = 0; j < num_classes; j++) {likehood[i][j] = 1.0;}}for (i = 0; i < num_samples; i++) {int feature = sample[i].feature;int classlabel = sample[i].classlabel;for (j = 0; j < num_features; j++) {if (j == feature) {likehood[j][classlabel] *= p[j];} else {likehood[j][classlabel] *= (1 - p[j]);}}for (j = 0; j < num_classes; j++) {p[j] *= num_samples / (num_samples + 1);p[j] += likehood[j][classlabel] / num_samples;}}// 分类结果int test_feature;printf("请输入测试特征:");scanf("%d", &test_feature);double max_prob = 0.0;int max_class = 0;for (i = 0; i < num_classes; i++) {double prob = p[test_feature] * likehood[test_feature][i]; if (prob > max_prob) {max_prob = prob;max_class = i;}}printf("属于类别%d 的概率最大\n", max_class);}int main() {// 特征数num_features = 5;// 样本数num_samples = 10;// 类别数num_classes = 3;// 训练数据文件名char filename[] = "train_data.txt";// 训练数据train_data(filename);// 朴素贝叶斯分类naive_bayes();return 0;}```在上述代码中,定义了一个`MAX_FEATURES`常量,表示特征的最大数量,`MAX_SAMPLES`常量,表示样本的最大数量,`num_features`,`num_samples`和`num_classes`分别表示特征数、样本数和类别数。

机器学习中的朴素贝叶斯算法应用案例分析朴素贝叶斯算法是机器学习领域中常用的分类算法之一。

它基于贝叶斯定理,通过计算给定特征条件下的类别概率来进行分类预测。

在本文中,我们将介绍几个使用朴素贝叶斯算法的应用案例,展示其在实际问题中的应用价值和效果。

1. 垃圾邮件过滤垃圾邮件是一个普遍存在的问题,给用户带来诸多不便。

朴素贝叶斯算法在垃圾邮件过滤中具有广泛的应用。

该算法通过分析邮件中的关键词和特征,建立垃圾邮件和正常邮件的概率模型,然后根据模型计算邮件属于垃圾邮件的概率,从而进行分类。

实际应用中,朴素贝叶斯算法能够较好地识别垃圾邮件,并且能够通过不断的学习和优化,提高过滤的准确率。

2. 文本分类文本分类是指根据文本内容将其归类到相应的类别中。

朴素贝叶斯算法在文本分类中被广泛使用。

例如,在新闻分类中,可以通过分析新闻标题、关键词等特征,建立一个包含不同类别新闻的概率模型,然后根据模型计算未知新闻属于各个类别的概率,从而分类新闻。

朴素贝叶斯算法在文本分类中有着高效的计算速度和较好的分类性能,可以应用于新闻、推荐系统、情感分析等领域。

3. 情感分析情感分析是指通过对文本中的情感进行识别和分类,判断文本的情感倾向。

朴素贝叶斯算法在情感分析中有着广泛的应用。

例如,在社交媒体上分析用户评论的情感,可以通过提取评论中的关键词和特征,建立一个情感情绪的概率模型,并根据模型计算未知评论的情感倾向。

朴素贝叶斯算法在情感分析中表现出较高的准确率和鲁棒性,可以帮助企业了解用户的反馈和态度,做出相应的决策。

4. 疾病诊断朴素贝叶斯算法在医学领域的应用也非常广泛,特别是在疾病诊断中。

对于一些已知的疾病,可以通过分析病人的症状特征,建立一个疾病的概率模型,然后根据模型计算未知症状属于各个疾病的概率,从而进行疾病诊断。

朴素贝叶斯算法在疾病诊断中具有高度的可解释性和分类准确性,能够帮助医生进行病情判断和诊断。

5. 客户推荐在电商领域,朴素贝叶斯算法也被广泛应用于客户推荐系统中。

贝叶斯分类器代码贝叶斯分类器是一种基于贝叶斯定理的机器学习算法,它可以用于分类、预测等任务。

在实际应用中,我们通常需要编写代码来实现贝叶斯分类器。

以下是一个简单的贝叶斯分类器代码示例:```import numpy as npclass NaiveBayesClassifier:def __init__(self):self.classes = Noneself.class_priors = Noneself.mean = Noneself.variance = Nonedef fit(self, X, y):self.classes = np.unique(y)n_classes = len(self.classes)# 计算每个类别的先验概率class_counts = np.zeros(n_classes)for i in range(n_classes):class_counts[i] = np.sum(y == self.classes[i])self.class_priors = class_counts / len(y)# 计算每个类别下每个特征的均值和方差n_features = X.shape[1]self.mean = np.zeros((n_classes, n_features)) self.variance = np.zeros((n_classes, n_features))for i in range(n_classes):X_i = X[y == self.classes[i], :]self.mean[i, :] = np.mean(X_i, axis=0)self.variance[i, :] = np.var(X_i, axis=0)def predict(self, X):n_samples, n_features = X.shapey_pred = np.zeros(n_samples)for i in range(n_samples):posteriors = []# 计算每个类别的后验概率for j in range(len(self.classes)):prior = np.log(self.class_priors[j])likelihood = np.sum(np.log(self._gaussian_pdf(X[i, :], self.mean[j, :], self.variance[j, :])))posterior = prior + likelihoodposteriors.append(posterior)# 选择后验概率最大的类别作为预测结果y_pred[i] = self.classes[np.argmax(posteriors)]return y_preddef _gaussian_pdf(self, x, mean, variance):exponent = -0.5 * ((x - mean) ** 2 / variance)coeff = 1.0 / np.sqrt(2.0 * np.pi * variance)return coeff * np.exp(exponent)```该代码实现了一个简单的高斯朴素贝叶斯分类器。

⾼斯朴素贝叶斯(GaussianNaiveBayes)原理与实现——垃圾邮件识别实战朴素贝叶斯(Naive Bayes):根据贝叶斯定理和朴素假设提出的朴素贝叶斯模型。

贝叶斯定理:朴素假设(特征条件独⽴性假设):代⼊可知朴素贝叶斯模型计算公式:因为朴素贝叶斯是⽤来分类任务,因此:化简可知:朴素贝叶斯模型除了上式所描述的以外,有三种常⽤的模型:1、⾼斯朴素贝叶斯2、多项式朴素贝叶斯3、伯努利朴素贝叶斯本篇主要是实现⾼斯朴素贝叶斯,因为它是最常⽤的⼀种模型。

⾼斯朴素贝叶斯:适⽤于连续变量,其假定各个特征 _ 在各个类别 下是服从正态分布的,算法内部使⽤正态分布的概率密度函数来计算概率。

_ :在类别为 的样本中,特征 _ 的均值。

_ :在类别为 的样本中,特征 _ 的标准差。

⾼斯朴素贝叶斯代码实现:注释:1、var_smoothing和epsilon的⽬的是防⽌⼀些特征的⽅差为0的情况(⽐如在垃圾邮件识别的时候,使⽤词袋模型很容易出现⽅差为0)2、计算联合概率时并不使⽤连乘,对概率取⾃然对数,乘法变加法,降低计算复杂度,使模型更稳定。

1import numpy as np2import collections3import math4class GaussianNB(object):5def__init__(self):6 self.mp = {} #把y值映射到0-n之间的整数7 self.n_class = None #类别数8 self.class_prior= None #先验概率P(Y)9 self.means = None #均值10 self.vars = None #⽅差11 self.var_smoothing =1e-9 #平滑因⼦12 self.epsilon = None #平滑值13def _get_class_prior(self,y):14 cnt = collections.Counter(y)15 self.n_class = 016for k,v in cnt.items():17 self.mp[k] = self.n_class18 self.n_class+=119 self.class_prior = np.array([ v/len(y) for k,v in cnt.items()])20pass21def _get_means(self,xx,y):22 new_y =np.array([self.mp[i] for i in y])23 self.means = np.array([ xx[new_y==id].mean(axis=0) for id in range(self.n_class)])24# self.means shape: n_class * dims25pass26def _get_vars(self,xx,y):27 new_y = np.array([self.mp[i] for i in y])28 self.vars = np.array([xx[new_y == id].var(axis=0) for id in range(self.n_class)])29# self.vars shape: n_class * dims30pass31def fit(self,X,Y):32# X 必须是numpy的array; Y为list,对于X中每个样本的类别33 self._get_class_prior(Y)34 self._get_means(X,Y)35 self._get_vars(X,Y)36 self.epsilon = self.var_smoothing * self.vars.max() #选取特征中最⼤的⽅差作为平滑37 self.vars = self.vars + self.epsilon #给所有⽅差加上平滑的值38pass39def _get_gaussian(self,x,u,var):40#计算在类别y下x的条件概率P(xj|y)的对数41#return math.log(1 / math.sqrt(2 * math.pi * var) * math.exp(-(x - u) ** 2 / (2 * var)))42return -(x - u) ** 2 / (2 * var) - math.log(math.sqrt(2 * math.pi * var))43def predict(self,x):44 dims = len(x)45 likelihoods = []46for id in range(self.n_class): #遍历每类yi,把每个特征的条件概率P(xj|yi)累加47 likelihoods.append(np.sum([self._get_gaussian(x[j], self.means[id][j], self.vars[id][j]) for j in range(dims)]))48# 对先验概率取对数49 log_class_prior = np.log(self.class_prior)50 all_pros = log_class_prior + likelihoods51#all_pros = self.standardization(all_pros)52 max_id = all_pros.argmax() #取概率最⼤的类别的下标53for k,v in self.mp.items(): #转换为可读的y值54if v== max_id:55return k56pass57def standardization(self,x):58 mu = np.mean(x)59 sigma = np.std(x)60return (x - mu) / sigma6162# nb = GaussianNB()63# xx = np.array([[1,2,3],[11,12,1],[2,1,4],[15,16,1],[8,6,6],[19,13,0]])64# y = ['min','max','min','max','min','max']65# nb.fit(xx,y)66# print(nb.predict(np.array([0,0,0])))View Code垃圾邮件识别实战:数据集:Trec06C数据集笔者获取的数据集是处理过的处理⽅式:随机选取:5000封垃圾邮件和5000封正常邮件;预处理提取邮件正⽂,去掉换⾏符、多余空格等UTF-8⽂本格式,每封邮件正⽂在⽂件中保存为⼀⾏⽂本其中前5000 条为垃圾邮件,后5000 条为正常邮件。

机器学习算法day02_贝叶斯分类算法及应用课程大纲课程目标:1、理解朴素贝叶斯算法的核心思想2、理解朴素贝叶斯算法的代码实现3、掌握朴素贝叶斯算法的应用步骤:数据处理、建模、运算和结果判定1. 朴素贝叶斯分类算法原理1.1 概述贝叶斯分类算法是一大类分类算法的总称贝叶斯分类算法以样本可能属于某类的概率来作为分类依据朴素贝叶斯分类算法是贝叶斯分类算法中最简单的一种注:朴素的意思是条件概率独立性1.2 算法思想朴素贝叶斯的思想是这样的:如果一个事物在一些属性条件发生的情况下,事物属于A的概率>属于B的概率,则判定事物属于A通俗来说比如,你在街上看到一个黑人,我让你猜这哥们哪里来的,你十有八九猜非洲。

为什么呢?在你的脑海中,有这么一个判断流程:1、这个人的肤色是黑色<特征>2、黑色人种是非洲人的概率最高<条件概率:黑色条件下是非洲人的概率>3、没有其他辅助信息的情况下,最好的判断就是非洲人这就是朴素贝叶斯的思想基础。

再扩展一下,假如在街上看到一个黑人讲英语,那我们是怎么去判断他来自于哪里?提取特征:肤色:黑语言:英语黑色人种来自非洲的概率:80%黑色人种来自于美国的概率:20%讲英语的人来自于非洲的概率:10%讲英语的人来自于美国的概率:90%在我们的自然思维方式中,就会这样判断:这个人来自非洲的概率:80% * 10% = 0.08这个人来自美国的概率:20% * 90% =0.18我们的判断结果就是:此人来自美国!其蕴含的数学原理如下:p(A|xy)=p(Axy)/p(xy)=p(Axy)/p(x)p(y)=p(A)/p(x)*p(A)/p(y)* p(xy)/p(xy)=p(A|x)p(A|y)朴素贝叶斯分类器朴素贝叶斯分类器的表示形式:当特征为为x时,计算所有类别的条件概率,选取条件概率最大的类别作为待分类的类别。

由于上公式的分母对每个类别都是一样的,因此计算时可以不考虑分母,即朴素贝叶斯的朴素体现在其对各个条件的独立性假设上,加上独立假设后,大大减少了参数假设空间。