第三章离散信源及离散熵

- 格式:ppt

- 大小:267.50 KB

- 文档页数:26

第三章 离散信源无失真编码3.2离散无记忆信源,熵为H[x],对信源的L 长序列进行等长编码,码字是长为n 的D 进制符号串,问:(1)满足什么条件,可实现无失真编码。

(2)L 增大,编码效率 也会增大吗? 解:(1)当log ()n D LH X ≥时,可实现无失真编码;(2)等长编码时,从总的趋势来说,增加L 可提高编码效率,且当L →∞时,1η→。

但不一定L 的每次增加都一定会使编码效率提高。

3.3变长编码定理指明,对信源进行变长编码,总可以找到一种惟一可译码,使码长n 满足D X H log )(≤n <D X H log )(+L 1,试问在n >D X H log )(+L1时,能否也找到惟一可译码? 解:在n >D X H log )(+L1时,不能找到惟一可译码。

证明:假设在n >D X H log )(+L1时,能否也找到惟一可译码,则由变长编码定理当n 满足D X H log )(≤n <D X H log )(+L 1,总可以找到一种惟一可译码知:在n ≥DX H log )( ① 时,总可以找到一种惟一可译码。

由①式有:Ln ≥L X H )(logD ② 对于离散无记忆信源,有H(x)=LX H )( 代入式②得:n L≥ D x H log )(即在nL≥Dx H log )(时,总可以找到一种惟一可译码;而由定理给定熵H (X )及有D 个元素的码符号集,构成惟一可译码,其平均码长满足D X H log )(≤n L <DX H log )(+1 两者矛盾,故假设不存在。

所以,在n >D X H log )(+L1时,不能找到惟一可译码。

3.7对一信源提供6种不同的编码方案:码1~码6,如表3-10所示信源消息 消息概率 码1 码2 码3 码4 码5 码6 u1 1/4 0 001 1 1 00 000 u2 1/4 10 010 10 01 01 001 U3 1/8 00 011 100 001 100 011 u4 1/8 11 100 1000 0001 101 100 u5 1/8 01 101 10000 00001 110 101 u6 1/16 001 110 100000 000001 1110 1110 u71/161111111000000000000111111111(1) 这些码中哪些是惟一可译码? (2) 这些码中哪些是即时码?(3) 对所有唯一可译码求出其平均码长。

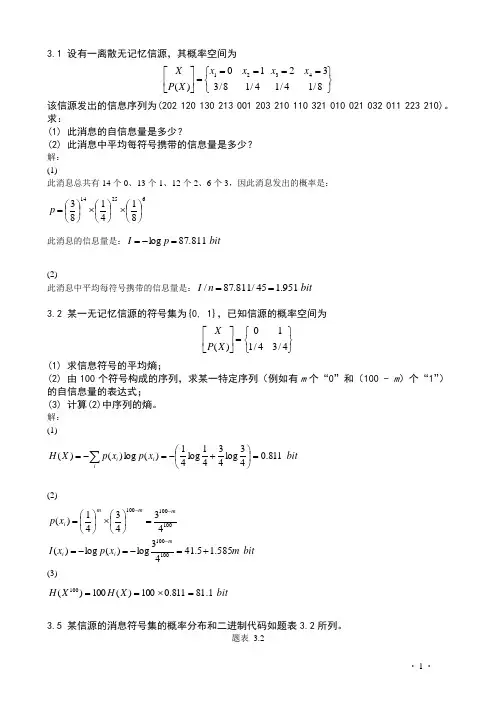

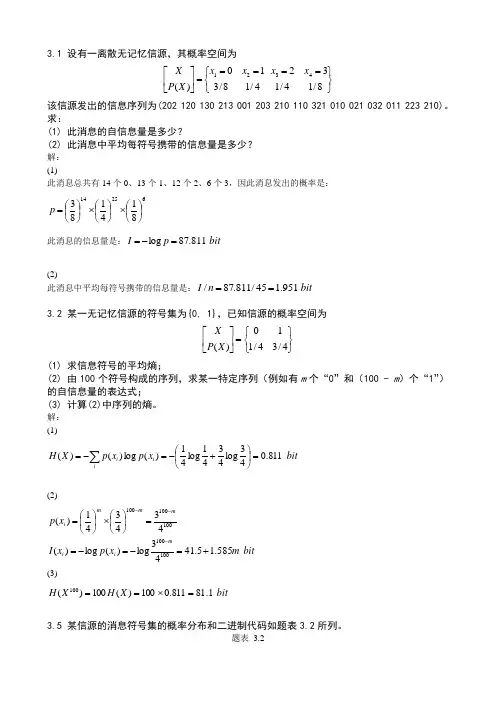

3.1 设有一离散无记忆信源,其概率空间为⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。

求:(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解: (1)此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2)此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==3.2 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡4/34/110)(X P X(1) 求信息符号的平均熵;(2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。

解: (1)bit x p x p X H ii i 811.043log 4341log 41)(log )()(=⎪⎭⎫ ⎝⎛+-=-=∑(2)bit m x p x I x p mi i m mm i 585.15.4143log)(log )(434341)(100100100100100+=-=-==⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=---(3)bit X H X H 1.81811.0100)(100)(100=⨯==3.5 某信源的消息符号集的概率分布和二进制代码如题表3.2所列。

题表 3.2(1) (2) 求每个消息符号所需要的平均二进制码的个数或平均代码长度。

进而用这一结果求码序列中的一个二进制码的熵;(3) 当消息是由符号序列组成时,各符号之间若相互独立,求其对应的二进制码序列中出现0和1的无条件概率0p 和1p ,求相邻码间的条件概率1/0p 、0/1p 、1/1p 、0/0p 。

3.1 设有一离散无记忆信源,其概率空间为⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。

求:(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解: (1)此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2)此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==3.2 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡4/34/110)(X P X(1) 求信息符号的平均熵;(2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。

解: (1)bit x p x p X H ii i 811.043log 4341log 41)(log )()(=⎪⎭⎫ ⎝⎛+-=-=∑(2)bit m x p x I x p mi i m mm i 585.15.4143log)(log )(434341)(100100100100100+=-=-==⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=---(3)bit X H X H 1.81811.0100)(100)(100=⨯==3.5 某信源的消息符号集的概率分布和二进制代码如题表3.2所列。

题表 3.2(1) (2) 求每个消息符号所需要的平均二进制码的个数或平均代码长度。

进而用这一结果求码序列中的一个二进制码的熵;(3) 当消息是由符号序列组成时,各符号之间若相互独立,求其对应的二进制码序列中出现0和1的无条件概率0p 和1p ,求相邻码间的条件概率1/0p 、0/1p 、1/1p 、0/0p 。

离散和连续信源熵的正负1. 介绍在信息论中,信源熵是衡量一个随机信源的不确定性的度量。

离散和连续信源是两种常见的信源类型,它们在计算熵时存在一些差异。

本文将详细介绍离散和连续信源熵的正负以及相关概念。

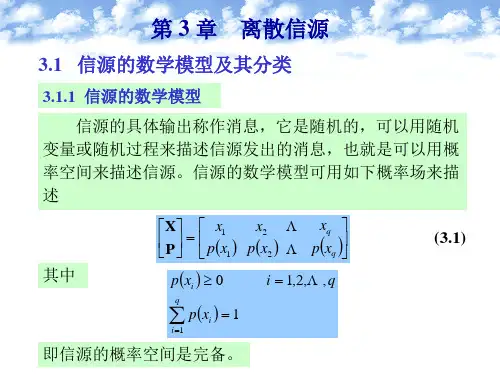

2. 离散信源熵的正负2.1 离散信源熵的定义离散信源是指输出符号有限且可数的信源。

假设我们有一个离散信源X,其输出符号集合为{a1, a2, …, an},每个符号ai发生的概率为pi。

离散信源熵H(X)定义为:H(X) = -Σ(pi * log2(pi))其中log2表示以2为底的对数运算。

2.2 离散信源熵的正负根据熵的定义可以发现,离散信源熵始终为非负值。

这是因为概率pi大于等于0且小于等于1,log2(pi)小于等于0,所以对每个pi求积后取负数得到的结果都是非负值。

当所有输出符号发生概率相等时,即pi = 1/n,其中n为输出符号的个数,离散信源达到最大不确定性,熵达到最大值log2(n)。

当某些输出符号的概率接近0时,离散信源趋向于确定性,熵趋向于0。

3. 连续信源熵的正负3.1 连续信源熵的定义连续信源是指输出符号是连续变量的信源。

在处理连续信源时,我们需要使用概率密度函数(probability density function, PDF)来描述随机变量X的概率分布。

假设X的概率密度函数为f(x),则连续信源熵H(X)定义为:H(X) = -∫(f(x) * log2(f(x)))dx其中∫表示积分运算。

3.2 连续信源熵的正负与离散信源不同,连续信源熵可以是正值、零或负值。

这是因为在连续情况下,概率密度函数f(x)可以超过1。

当概率密度函数f(x)集中在某个区域时,连续信源趋向于确定性,熵趋向于0甚至成为负值。

当概率密度函数均匀分布在整个定义域上时,连续信源达到最大不确定性,熵达到正无穷大。

需要注意的是,连续信源熵的计算需要对概率密度函数进行积分运算,这对于复杂的连续信源可能会很困难。

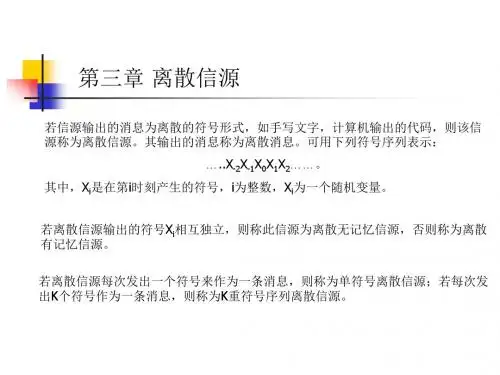

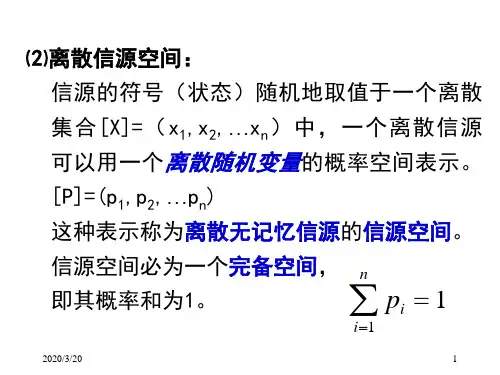

离散信源的分类和数学模型离散⽆记忆信源的熵1.离散信源的分类和数学模型 在离散时间发出离散符号的信源称为离散信源。

如果信源符号集为有限集,则称为有限离散信源。

如果信源符号集为⽆限可数集,则称为⽆限离散信源。

离散⽆记忆信源的N次拓展源:设信源为X,则由X构成的N维随机⽮量集合X N = X1X2X3...X N(其中X i与X同分布),称为信源X的N次扩展源。

2.离散⽆记忆信源的熵 2.1离散平稳信源若具有有限符号集A={a1,a2,a3,...,a n}的信源X产⽣的随机序列{x i},i=...1,2...且满⾜:对所有的i1,i2,...i n,h,j1,j2,...,j n及x i ε X,有p(x i1=a j1,x i2=a j2,x i3=a j3,...x i N=a jN) = p(x i1+h=a j1,x i2+h=a j2,...,x in+h=a jn)则称信源为离散平稳信源,所产⽣的序列为平稳序列。

平稳序列的统计特性与时间的推移⽆关,即序列中符号的额任意维联合概率分布与时间起点⽆关。

2.2离散平稳有记忆信源的熵设X为离散平稳有记忆信源,X的N次扩展源记为X N, X N=X1X2X3...X N. 根据熵的可加性,有H(X N)=H(X1X2X3...X N)=H(X1)+H(X2|X1)+...+H(X N|X1...X N-1) 定理1:对任意离散平稳信源,若H1(X)<∞,有以下结论:(1)H(X N|X1...X N-1)不随N⽽增加;(2)H N(X)≥H(X N|X1...X N-1); (3) H N(X)不随N⽽增加;(4)H∞(X)存在,且H∞(X)=limH(X N|X1...X N-1); 式(4)表明,有记忆信源的符号熵也可以通过计算极限条件熵得到。

3.有限状态马尔可夫链 3.1马⽒链的基本概念 设信源的符号集为{a1,a2,..,a q},信源的输出序列为x1,x2,...,x N,如果其中每个随机变量x n仅通过最接近的变量x n-1依赖于过去的随机变量x n-1,x n-2,...,即对所有的i,j,k,...有p(x n=j|x n-1=i,x n-2=k,...,x0=m ) = p(x n=j|x n-1=i) 则称{x n,n≥0}为马尔可夫链,简称马⽒链。