信息论中信源熵之间关系的证明

- 格式:pdf

- 大小:113.75 KB

- 文档页数:6

实验报告实验名称关于信源熵的实验课程名称信息论与编码姓名xxx 成绩90班级电子信息1102学号**********日期2013.11.22地点综合实验楼实验一关于信源熵的实验一、实验目的1. 掌握离散信源熵的原理和计算方法。

2. 熟悉matlab 软件的基本操作,练习使用matlab 求解信源的信息熵。

3. 自学图像熵的相关概念,并应用所学知识,使用matlab 或其他开发工具求解图像熵。

4. 掌握Excel的绘图功能,使用Excel绘制散点图、直方图。

二、实验原理1. 离散信源相关的基本概念、原理和计算公式产生离散信息的信源称为离散信源。

离散信源只能产生有限种符号。

随机事件的自信息量I(xi)为其对应的随机变量xi 出现概率对数的负值。

即: I (xi )= -log2p ( xi)随机事件X 的平均不确定度(信源熵)H(X)为离散随机变量 xi 出现概率的数学期望,即:2.二元信源的信息熵设信源符号集X={0,1} ,每个符号发生的概率分别为p(0)= p,p(1)= q,p+ q =1,即信源的概率空间为:则该二元信源的信源熵为:H( X) = - plogp–qlogq = - plogp –(1 - p)log(1- p)即:H (p) = - plogp –(1 - p)log(1- p) 其中 0 ≤ p ≤13. MATLAB二维绘图用matlab 中的命令plot( x , y) 就可以自动绘制出二维图来。

例1-2,在matlab 上绘制余弦曲线图,y = cos x ,其中 0 ≤ x ≤2。

>>x =0:0.1:2*pi; %生成横坐标向量,使其为 0,0.1,0.2,…,6.2>>y =cos(x ); %计算余弦向量>>plot(x ,y ) %绘制图形4. MATLAB求解离散信源熵求解信息熵过程:1) 输入一个离散信源,并检查该信源是否是完备集。

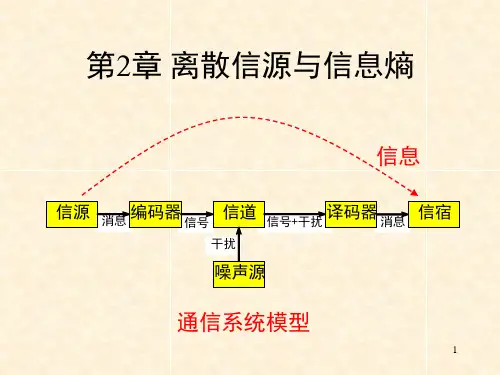

第2章离散信源与信息熵信号 信号+干扰 消息干扰消息 信源 编码器 信道 译码器 信宿 噪声源通信系统模型信息2.1 信源的分类和描述信源是信息的发源地,可以是人、生物、机器或其他事物。

信源的输出是包含信息的消息。

消息的形式可以是离散的或连续的。

信源输出为连续信号形式(如语音),可用连续随机变量描述。

连续信源←→模拟通信系统信源输出是离散的消息符号(如书信),可用离散随机变量描述。

离散信源←→数字通信系统离散信源…X i…X j…离散无记忆信源:输出符号Xi Xj之间相互无影响;离散有记忆信源:输出符号Xi Xj之间彼此依存。

3离散信源无记忆有记忆发出单个符号发出符号序列马尔可夫信源非马尔可夫信源y j将一粒棋子随意地放在棋盘中的某列;棋子放置的位置是一个随机事件;可看做一个发出单个符号的离散信源。

x i1212,,...,(),(),...,()m m x x x X P p x p x p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦就数学意义来讲,信源就是一个概率场,可用概率空间来描述信源。

由离散随机变量X 表示棋子位置:10()1,()1m i ii p x p x =≤≤=∑i x 其中,代表随机事件的某一结果。

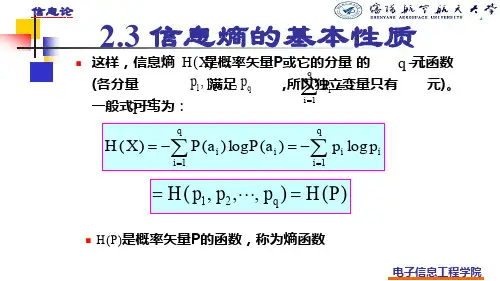

2.2离散信源的信息熵信息的可度量性是信息论建立的基础;香农的信息论用事件发生概率的对数来描述事件的不确定性,得到消息的信息量,建立熵的概念。

2.2.1自信息量–定义2.1 任意随机事件x i 的自信息量定义为:i i i 1(x )log log (x )(x )I P P ==-小概率事件所包含的不确定性大,自信息量大。

大概率事件所包含的不确定性小,自信息量小。

概率为1的确定性事件,自信息量为零。

i i i 1(x )log log (x )(x )I P P ==-信息量的单位与公式中的对数取底有关。

以2为底,单位比特(bit );以e 为底,单位奈特(nat );()22log log ,log log ln log c a c b b x e x a==⋅–例:棋盘共8列,甲随手一放,将一枚棋子放在了第3列。

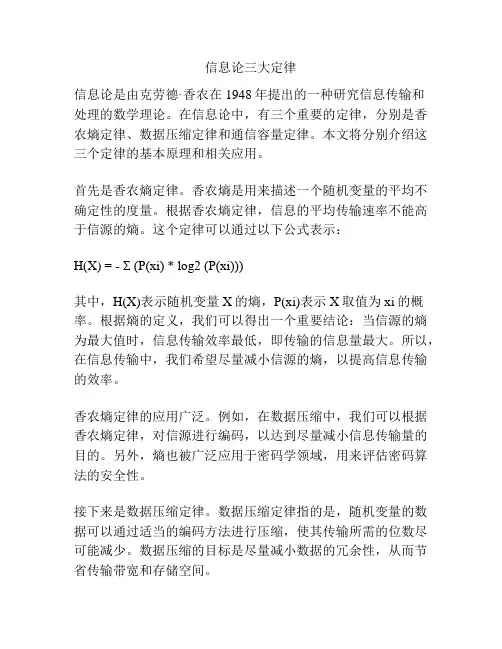

信息论三大定律信息论是由克劳德·香农在1948年提出的一种研究信息传输和处理的数学理论。

在信息论中,有三个重要的定律,分别是香农熵定律、数据压缩定律和通信容量定律。

本文将分别介绍这三个定律的基本原理和相关应用。

首先是香农熵定律。

香农熵是用来描述一个随机变量的平均不确定性的度量。

根据香农熵定律,信息的平均传输速率不能高于信源的熵。

这个定律可以通过以下公式表示:H(X) = - Σ (P(xi) * log2 (P(xi)))其中,H(X)表示随机变量X的熵,P(xi)表示X取值为xi的概率。

根据熵的定义,我们可以得出一个重要结论:当信源的熵为最大值时,信息传输效率最低,即传输的信息量最大。

所以,在信息传输中,我们希望尽量减小信源的熵,以提高信息传输的效率。

香农熵定律的应用广泛。

例如,在数据压缩中,我们可以根据香农熵定律,对信源进行编码,以达到尽量减小信息传输量的目的。

另外,熵也被广泛应用于密码学领域,用来评估密码算法的安全性。

接下来是数据压缩定律。

数据压缩定律指的是,随机变量的数据可以通过适当的编码方法进行压缩,使其传输所需的位数尽可能减少。

数据压缩的目标是尽量减小数据的冗余性,从而节省传输带宽和存储空间。

数据压缩定律的应用非常广泛。

在计算机领域,我们经常使用各种压缩算法对数据进行压缩,例如无损压缩算法(如ZIP)和有损压缩算法(如JPEG)。

此外,数据压缩也被广泛应用于通信领域,以提高数据传输的效率和速率。

最后是通信容量定律。

通信容量定律指的是,在给定的信道条件下,最大传输速率是有限的。

通信容量取决于信道的带宽和信噪比(信号与噪声比)。

通信容量定律的应用包括无线通信、光纤通信等领域。

通过优化通信系统的参数,如信噪比、调制方式等,可以提高通信容量,从而提高数据传输的速率和可靠性。

综上所述,信息论的三大定律分别是香农熵定律、数据压缩定律和通信容量定律。

这些定律在信息传输和处理中起到了重要的作用,相关应用广泛。

![[数学]信源与信息熵](https://uimg.taocdn.com/3a0f985bc381e53a580216fc700abb68a982adf4.webp)

[数学] 信源与信息熵1. 信源在信息论中,信源是指产生和发送信息的原始来源。

它可以是一个物理设备,如计算机、手机或者是一个概念、事件等。

无论信源是什么,它都可以看作是一个随机变量,可以取多个可能的取值。

举个例子,考虑一个硬币的抛掷过程。

在这个例子中,信源可以是硬币的结果,可以是正面或反面。

硬币抛掷过程是一个随机过程,因此信源可以看作是一个随机变量。

2. 信息熵信息熵是信息论中一个重要的概念,用于度量信源的不确定性或者信息的平均量。

它是由信源的概率分布决定的。

假设信源有n个可能的取值,记为$x_1, x_2, \\ldots, x_n$。

每个取值n n出现的概率为n(n n),满足$\\sum_{i=1}^n p(x_i)= 1$。

那么,信源的信息熵n定义为$$ H = -\\sum_{i=1}^n p(x_i) \\log p(x_i) $$信息熵的单位通常是比特(bits)或者纳特(nats)。

信息熵可以理解为平均需要多少比特或者纳特来表示信源的一个样本。

当信源的概率分布均匀时,信息熵达到最大值。

相反,当信源的概率分布集中在某几个取值时,信息熵较低。

3. 信息压缩信息熵在信息压缩中起到了重要的作用。

信息压缩是将信息表示为更短的形式,以便更有效地存储和传输。

根据信息论的哈夫曼编码原理,我们可以通过将频繁出现的符号用较短的二进制码表示,而将不经常出现的符号用较长的二进制码表示,从而实现信息的压缩。

在信息压缩过程中,我们可以根据信源的概率分布来选择合适的编码方式,以最小化编码长度和解码的平均长度之和。

4. 信息熵的应用信息熵在各个领域都有着广泛的应用。

在通信领域,信息熵可以用来评估信道的容量。

信道容量是一个信道在单位时间内可以传输的最大信息量。

通过计算信道的信息熵,我们可以确定如何更好地利用信道的带宽和传输速率。

在数据压缩领域,信息熵可以用来评估压缩算法的效果。

一个好的压缩算法应该能够将原始数据的信息量尽可能地减少,从而更高效地存储和传输数据。

信息熵的概念及其在信息论中的应用信息熵是信息论中一个重要的概念,它被用来衡量一段信息的不确定性或者说信息的平均编码长度。

熵的概念最早由克劳德·香农在1948年提出,对于信息的量化和信源编码具有重要的理论和实际应用。

本文将对信息熵的概念进行详细的介绍,并探讨其在信息论中的应用。

一、信息熵的定义信息熵可以看作是一个信源所产生的信息的不确定性度量。

当一个信源产生的符号具有均匀分布时,熵的值最大;而当信源的输出符号呈现高度集中的分布时,熵的值最小。

具体地,对于一个离散型信源,其熵的定义如下:H(X) = -Σp(x)log2p(x),其中,H(X)表示信源X的熵,p(x)表示信源X输出符号x出现的概率。

二、信息熵的解释信息熵可以理解为对信息的平均编码长度的期望。

在信息论中,我们可以通过霍夫曼编码等方法对信息进行编码,使得熵最小化,从而达到最高的编码效率。

假设信源X有n个符号,出现的概率分别为p1, p2, ..., pn,则信源X的平均编码长度L为:L = ΣpiLi,其中,Li为信源X的符号i的编码长度。

根据不等式关系log2(p1/p2) <= p1/p2,我们可以得到:H(X) = -Σp(x)log2p(x) <= Σp(x) * (-log2p(x)) = Σp(x)log2(1/p(x)) = Σp(x)log2n = log2n,即熵的值小于等于log2n,其中n为符号的个数。

当n个符号均匀分布时,熵的值达到最大,即log2n。

三、信息熵的应用信息熵在信息论中具有广泛的应用,下面将介绍几个常见的应用场景。

1. 数据压缩信息熵在数据压缩中起到重要的作用。

根据信息论的原理,我们可以利用数据的统计特性进行有损压缩。

对于频率出现较高的符号,我们可以分配较短的编码,而对于出现频率较低的符号,则分配较长的编码。

通过这种方式,我们可以大大减少数据的存储空间,提高传输效率。

2. 通信系统信息熵在通信系统中也有重要应用。

熵与信息论公式香农熵互信息的计算公式熵与信息论公式-香农熵与互信息的计算公式在信息论中,熵与互信息是两个重要的概念,它们经常被用于衡量信息的不确定性和相关性。

本文将详细介绍熵和互信息的定义和计算公式,并探讨它们在信息理论中的应用。

一、香农熵香农熵是信息论中用于度量随机变量不确定性的重要指标。

它可以理解为信息的平均度量,也可以理解为信息的缺乏度量。

对于离散型随机变量X,其熵H(X)的计算公式为:H(X) = -∑p(x)log2(p(x))其中,p(x)为随机变量X取某一值x的概率,log2表示以2为底的对数。

例如,假设有一个骰子,它的每个面出现的概率相等,即1/6。

那么骰子的熵可以通过以下计算得到:H(X) = -(1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6) - (1/6)log2(1/6)根据计算公式,我们可以得到该骰子的熵为log2(6)≈2.58。

香农熵的计算过程可以理解为对每个可能取值的概率乘以该取值的信息量,并对所有情况求和。

熵越高,表示随机变量的不确定性越大。

二、互信息互信息是用于度量两个随机变量之间相关性的概念。

假设有两个离散型随机变量X和Y,它们的联合概率分布为p(x, y),边缘概率分布分别为p(x)和p(y)。

那么X和Y的互信息I(X;Y)的计算公式为:I(X;Y) = ∑∑p(x, y)log2(p(x, y)/(p(x)p(y)))互信息可以理解为两个随机变量之间共享的信息量。

当两个随机变量完全独立时,互信息为0;而当它们之间存在依赖关系时,互信息大于0。

三、应用熵和互信息在信息论中有广泛的应用。

其中,香农熵常被用于衡量信源中的信息量,例如在数据压缩算法中,熵越高的信源可以被更好地压缩。

互信息则常被用于衡量两个随机变量之间的相关性。

例如在机器学习中,互信息可用于特征选择和聚类分析。

信源熵的原理及应用1. 介绍信源熵是信息论中一个重要的概念,它描述了一个随机信源所具有的信息量的平均度量。

信源的熵越大,表示信息的不确定性越高,需要更多的信息来描述。

本文将介绍信源熵的原理,并探讨其在通信、数据压缩以及密码学等领域的应用。

2. 信源熵的定义信源熵是正信息论中一个重要概念,它用来度量一个随机信源所具有的信息量的平均度量。

对于一个离散随机变量X,它的概率分布为P(X),则信源的熵定义如下:equationequation其中,xi是随机变量X的取值,P(xi)是xi对应的概率。

3. 信源熵的性质•信源熵的取值范围:信源的熵是非负的,即H(X) ≥ 0。

•最大熵原理:对于一个离散信源,当它的概率分布均匀时,即每个xi的概率相等时,信源熵达到最大值。

•如果一个信源越复杂,即其概率分布越不均匀,那么它的熵就越小。

4. 信源熵的应用4.1 通信系统在通信系统中,信源熵可以用来度量信道所传输信息的平均编码长度。

根据香农定理,信道传输的平均编码长度L与信源熵H(X)满足以下关系:equationequation当信道编码满足L = H(X)时,信道编码称为最优编码,即编码的平均长度等于信源熵。

4.2 数据压缩信源熵还可以应用于数据压缩领域。

数据压缩的目的是使用更少的位数来存储或传输数据。

通过统计一个数据源的概率分布,可以将出现概率低的数据编码为较长的二进制位,而出现概率高的数据编码为较短的二进制位。

信源熵提供了压缩算法的理论基础。

4.3 密码学在密码学中,信源熵用于度量消息或密码的随机性。

如果一个密码是完全随机的,并且每个密钥都是等概率选择的,那么这个密码的熵将达到最大值。

信源熵可以用来评估一个密码系统的安全性,以及密码生成算法的随机性。

5. 总结本文介绍了信源熵的原理及其应用。

信源熵是衡量信息量的重要度量指标,它在通信、数据压缩以及密码学等领域具有多种应用。

通过明确信源熵的定义和性质,我们可以更好地理解和应用它。