多元线性回归模型的各种检验方法

- 格式:doc

- 大小:283.00 KB

- 文档页数:17

第三节多元线性回归模型的检验本节基本内容:●多元回归的拟合优度检验●回归方程的显著性检验(F检验)●各回归系数的显著性检验(t检验)一、多元回归的拟合优度检验多重可决系数R 2:22222ˆ(-)ESS TSS-RSS 1-TSS(-)TSS i i i iY Y e R Y Y y====∑∑∑∑在实际应用中,随着模型中解释变量的增多,R 2往往增大。

这就给人一个错觉:要使得模型拟合得好,只要增加解释变量即可。

但是,由增加解释变量引起的R 2的增大与拟合好坏无关,所以R 2需调整。

修正的可决系数()222222(-)-1-11111(-1)--i i iie n k en n RR yn n kyn k=-=-=--∑∑∑∑修正的可决系数为特点:⏹⏹k 越大,越小。

综合了精度和变量数两个因素,兼顾了精确性和简洁性。

⏹R 2必定非负,但可能为负值。

2R 2R 2R 22R R≤信息准则为了比较解释变量个数不同的多元回归模型的拟合优度,常用的标准还有:赤池信息准则(Akaike information criterion, AIC )施瓦茨准则(Schwarz criterion ,SC )上述信息准则均要求仅当所增加的解释变量能够减少AIC 值、SC 值或HQC 值时才在原模型中增加该解释变量。

()()n ln n k n L SC 12++-=汉南-奎因准则(Hannan-Quinn criterion ,HQC )()()()n ln ln nk n L HQC 122++-=()n k n L AIC 122++-=()⎥⎥⎦⎤⎢⎢⎣⎡⎪⎪⎭⎫ ⎝⎛++-=∑n e ln ln n L i2212π其中对数似然函数二、回归方程显著性检验(F检验)基本思想在多元回归中有多个解释变量,需要说明所有解释变量联合起来对被解释变量影响的总显著性,或整个方程总的联合显著性。

对方程总显著性检验需要在方差分析的基础上进行F检验。

多元线性回归模型检验引言多元线性回归是一种常用的统计分析方法,用于研究两个或多个自变量对目标变量的影响。

在应用多元线性回归前,我们需要确保所建立的模型符合一定的假设,并进行模型检验,以保证结果的可靠性和准确性。

本文将介绍多元线性回归模型的几个常见检验方法,并通过实例进行说明。

一、多元线性回归模型多元线性回归模型的一般形式可以表示为:$$Y = \\beta_0 + \\beta_1X_1 + \\beta_2X_2 + \\ldots + \\beta_pX_p +\\varepsilon$$其中,Y为目标变量,$X_1,X_2,\\ldots,X_p$为自变量,$\\beta_0,\\beta_1,\\beta_2,\\ldots,\\beta_p$为模型的回归系数,$\\varepsilon$为误差项。

多元线性回归模型的目标是通过调整回归系数,使得模型预测值和实际观测值之间的误差最小化。

二、多元线性回归模型检验在进行多元线性回归分析时,我们需要对所建立的模型进行检验,以验证假设是否成立。

常用的多元线性回归模型检验方法包括:1. 假设检验多元线性回归模型的假设包括:线性关系假设、误差项独立同分布假设、误差项方差齐性假设和误差项正态分布假设。

我们可以通过假设检验来验证这些假设的成立情况。

•线性关系假设检验:通过F检验或t检验对回归系数的显著性进行检验,以确定自变量与目标变量之间是否存在线性关系。

•误差项独立同分布假设检验:通过Durbin-Watson检验、Ljung-Box 检验等统计检验,判断误差项是否具有自相关性。

•误差项方差齐性假设检验:通过Cochrane-Orcutt检验、White检验等统计检验,判断误差项的方差是否齐性。

•误差项正态分布假设检验:通过残差的正态概率图和Shapiro-Wilk 检验等方法,检验误差项是否满足正态分布假设。

2. 多重共线性检验多重共线性是指在多元线性回归模型中,自变量之间存在高度相关性的情况。

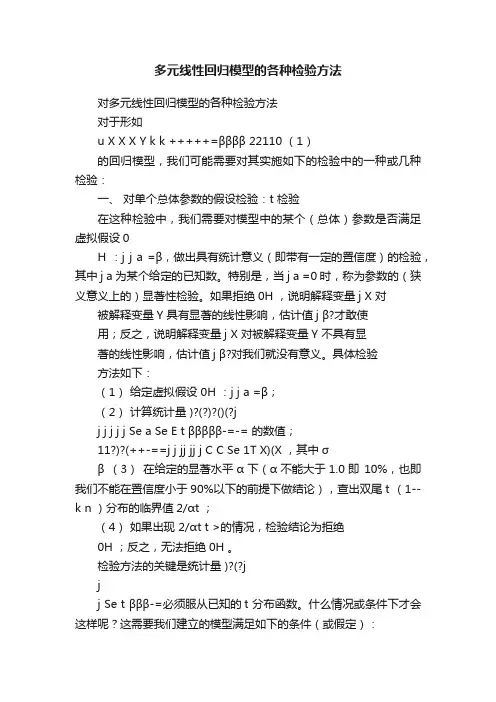

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββΛΛ22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21ΛΛ=。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

多元线性回归模型的各种检验方法多元线性回归模型是常用于数据分析和预测的方法,它可以用于研究多个自变量与因变量之间的关系。

然而,仅仅使用多元线性回归模型进行参数估计是不够的,我们还需要对模型进行各种检验以确保模型的可靠性和有效性。

下面将介绍一些常用的多元线性回归模型的检验方法。

首先是模型的整体显著性检验。

在多元线性回归模型中,我们希望知道所构建的模型是否能够显著解释因变量的变异。

常见的整体显著性检验方法有F检验和显著性检查表。

F检验是通过比较回归模型的回归平方和和残差平方和的比值来对模型的整体显著性进行检验。

若F值大于一定的临界值,则可以拒绝原假设,即模型具有整体显著性。

通常,临界值是根据置信水平和自由度来确定的。

显著性检查表是一种常用的汇总表格,它可以提供关于回归模型的显著性水平、标准误差、置信区间和显著性因素的信息。

通过查找显著性检查表,我们可以评估模型的显著性。

其次是模型的参数估计检验。

在多元线性回归模型中,我们希望知道每个自变量对因变量的影响是否显著。

通常使用t检验来对模型的参数估计进行检验。

t检验是通过对模型的回归系数进行检验来评估自变量的影响是否显著。

与F检验类似,t检验也是基于假设检验原理,通过比较t值和临界值来决定是否拒绝原假设。

通常,临界值可以通过t分布表或计算机软件来获取。

另外,我们还可以使用相关系数来评估模型的拟合程度。

相关系数可以用来衡量自变量与因变量之间的线性关系强度,常见的相关系数包括Pearson相关系数和Spearman相关系数。

Pearson相关系数适用于自变量和因变量都是连续变量的情况,它衡量的是两个变量之间的线性关系强度。

取值范围为-1到1,绝对值越接近1表示关系越强。

Spearman相关系数适用于自变量和因变量至少有一个是有序变量或者都是有序变量的情况,它衡量的是两个变量之间的单调关系强度。

取值范围也是-1到1,绝对值越接近1表示关系越强。

最后,我们还可以使用残差分析来评估模型的拟合程度和误差分布。

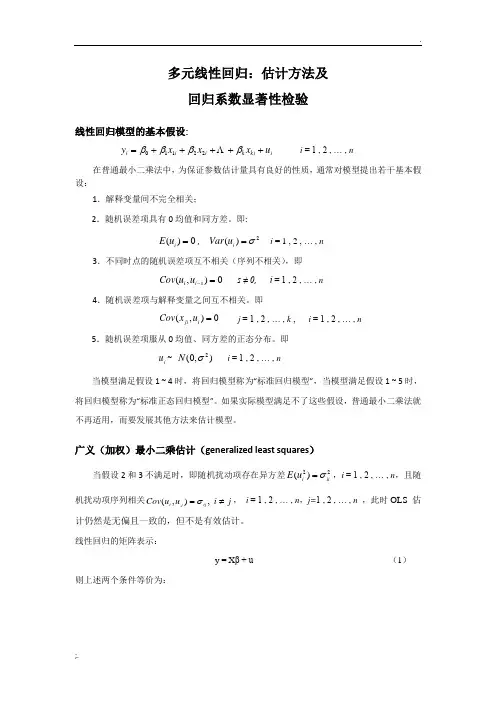

多元线性回归:估计方法及回归系数显著性检验线性回归模型的基本假设:i ki k i i i u x x x y +++++=ββββΛ22110 i = 1 , 2 , … , n在普通最小二乘法中,为保证参数估计量具有良好的性质,通常对模型提出若干基本假设:1.解释变量间不完全相关;2.随机误差项具有0均值和同方差。

即:0)(=i u E , 2)(σ=i u Var i = 1 , 2 , … , n 3.不同时点的随机误差项互不相关(序列不相关),即0),(=-s i i u u Cov s ≠ 0, i = 1 , 2 , … , n4.随机误差项与解释变量之间互不相关。

即0),(=i ji u x Cov j = 1 , 2 , … , k , i = 1 , 2 , … , n5.随机误差项服从0均值、同方差的正态分布。

即i u ~ ),0(2σN i = 1 , 2 , … , n当模型满足假设1 ~ 4时,将回归模型称为“标准回归模型”,当模型满足假设1 ~ 5时,将回归模型称为“标准正态回归模型”。

如果实际模型满足不了这些假设,普通最小二乘法就不再适用,而要发展其他方法来估计模型。

广义(加权)最小二乘估计(generalized least squares )当假设2和3不满足时,即随机扰动项存在异方差22)(ii i u E σ=,i = 1 , 2 , … , n ,且随机扰动项序列相关j i u u Cov ij j i ≠=,),(σ, i = 1 , 2 , … , n ,j=1 , 2 , … , n ,此时OLS 估计仍然是无偏且一致的,但不是有效估计。

线性回归的矩阵表示:y = X β + u (1)则上述两个条件等价为:Var(u )== ⎪⎪⎪⎪⎪⎭⎫ ⎝⎛nn T T n n σσσσσσσσσ..............212222111211 ≠ σ 2 I 对于正定矩阵存在矩阵M ,使得 1''-=⇒=M ΩM I M M Ω。

多元线性回归模型的各种检验方法对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j β?才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j β?对我们就没有意义。

具体检验方法如下:(1)给定虚拟假设 0H :j j a =β;(2)计算统计量 )?(?)?()(?jj j j j j Se a Se E t βββββ-=-= 的数值;11?)?(++-==j j jj jj j C C Se 1T X)(X ,其中σβ (3)在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4)如果出现2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

检验方法的关键是统计量 )?(?jjj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1)随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2)条件期望值为0。

给定解释变量的任何值,误差的期望值为零。

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1) 的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即 10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

多元线性回归模型的公式和参数估计方法以及如何进行统计推断和假设检验多元线性回归模型是一种常用的统计分析方法,它在研究多个自变量与一个因变量之间的关系时具有重要的应用价值。

本文将介绍多元线性回归模型的公式和参数估计方法,并讨论如何进行统计推断和假设检验。

一、多元线性回归模型的公式多元线性回归模型的一般形式如下:Y = β0 + β1X1 + β2X2 + ... + βkXk + ε其中,Y表示因变量,X1至Xk表示自变量,β0至βk表示模型的参数,ε表示误差项。

在多元线性回归模型中,我们希望通过样本数据对模型的参数进行估计,从而得到一个拟合度较好的回归方程。

常用的参数估计方法有最小二乘法。

二、参数估计方法:最小二乘法最小二乘法是一种常用的参数估计方法,通过最小化观测值与模型预测值之间的残差平方和来估计模型的参数。

参数估计的公式如下:β = (X^T*X)^(-1)*X^T*Y其中,β表示参数矩阵,X表示自变量的矩阵,Y表示因变量的矩阵。

三、统计推断和假设检验在进行多元线性回归分析时,我们经常需要对模型进行统计推断和假设检验,以验证模型的有效性和可靠性。

统计推断是通过对模型参数的估计,来对总体参数进行推断。

常用的统计推断方法包括置信区间和假设检验。

1. 置信区间:置信区间可以用来估计总体参数的范围,它是一个包含总体参数真值的区间。

2. 假设检验:假设检验用于检验总体参数的假设是否成立。

常见的假设检验方法有t检验和F检验。

在多元线性回归模型中,通常我们希望检验各个自变量对因变量的影响是否显著,以及模型整体的拟合程度是否良好。

对于各个自变量的影响,我们可以通过假设检验来判断相应参数的显著性。

通常使用的是t检验,检验自变量对应参数是否显著不等于零。

对于整体模型的拟合程度,可以使用F检验来判断模型的显著性。

F检验可以判断模型中的自变量是否存在显著的线性组合对因变量的影响。

在进行假设检验时,我们需要设定显著性水平,通常是α=0.05。

多元线性回归模型检验引言多元线性回归模型是一种常用的统计分析方法,用于研究多个自变量与因变量之间的关系。

在建立多元线性回归模型后,我们需要对其进行一系列的检验,以确保模型的准确性和可靠性。

本文将介绍多元线性回归模型的检验方法。

模型假设在进行多元线性回归模型检验前,我们首先需要明确模型所假设的条件。

多元线性回归模型假设以下几个条件:1.线性关系:自变量和因变量之间存在线性关系。

2.独立性:不同自变量之间相互独立。

3.同方差性:模型的误差项在自变量的每个取值下具有相同的方差。

4.正态性:误差项服从正态分布。

多元线性回归模型检验方法1. 相关系数检验在建立多元线性回归模型时,我们首先需要对自变量和因变量之间的相关关系进行检验。

常用的方法是计算各个自变量和因变量之间的相关系数,并通过假设检验确定其显著性。

2. 模型整体显著性检验在多元线性回归模型中,我们需要判断整体回归关系是否显著。

常用的方法是计算模型的F统计量,并通过显著性检验确定其结果。

F统计量的计算公式如下:$$ F = \\frac{(SSR/k)}{(SSE/(n-k-1))} $$其中,SSR为回归平方和,k为模型自变量个数,SSE为误差平方和,n为样本的观测值个数。

F统计量服从自由度为k和n-k-1的F分布。

3. 自变量的显著性检验除了整体显著性检验外,我们还可以对每个自变量进行显著性检验,以确定其对因变量的贡献程度。

常用的方法是计算自变量的t统计量,并通过显著性检验确定其结果。

t统计量的计算公式如下:$$ t = \\frac{\\hat{\\beta_j}}{\\sqrt{MSE \\cdot (X^TX)^{-1}_{jj}}} $$其中,$\\hat{\\beta_j}$为第j个自变量的估计系数,MSE为均方误差,(X T X)jj−1为自变量矩阵X的逆矩阵元素。

4. 模型的拟合度检验除了检验自变量的显著性外,我们还需要评估模型的拟合度。

多元线性回归模型的检验1多元性回归模型与一元线性回归模型一样,在得到参数的最小二乘法的估计值之后,也需要进行必要的检验与评价,以决定模型是否可以应用;1、拟合程度的测定;与一元线性回归中可决系数r2相对应,多元线性回归中也有多重可决系数r2,它是在因变量的总变化中,由回归方程解释的变动回归平方和所占的比重,R2越大,回归方各对样本数据点拟合的程度越强,所有自变量与因变量的关系越密切;计算公式为:其中,2.估计标准误差估计标准误差,即因变量y的实际值与回归方程求出的估计值之间的标准误差,估计标准误差越小,回归方程拟合程度越程;其中,k为多元线性回归方程中的自变量的个数;3.回归方程的显著性检验回归方程的显著性检验,即检验整个回归方程的显著性,或者说评价所有自变量与因变量的线性关系是否密切;能常采用F检验,F统计量的计算公式为:根据给定的显著水平a,自由度k,n-k-1查F分布表,得到相应的临界值Fa,若F > Fa,则回归方程具有显著意义,回归效果显著;F < Fa,则回归方程无显著意义,回归效果不显著;4.回归系数的显著性检验在一元线性回归中,回归系数显著性检验t检验与回归方程的显著性检验F检验是等价的,但在多元线性回归中,这个等价不成立;t检验是分别检验回归模型中各个回归系数是否具有显著性,以便使模型中只保留那些对因变量有显著影响的因素;检验时先计算统计量ti;然后根据给定的显著水平a,自由度n-k-1查t分布表,得临界值ta或ta / 2,t > t − a或ta / 2,则回归系数bi与0有显著关异,反之,则与0无显著差异;统计量t的计算公式为:其中,Cij是多元线性回归方程中求解回归系数矩阵的逆矩阵x'x − 1的主对角线上的第j 个元素;对二元线性回归而言,可用下列公式计算:其中,5.多重共线性判别若某个回归系数的t检验通不过,可能是这个系数相对应的自变量对因变量的影平不显著所致,此时,应从回归模型中剔除这个自变量,重新建立更为简单的回归模型或更换自变量;也可能是自变量之间有共线性所致,此时应设法降低共线性的影响;多重共线性是指在多元线性回归方程中,自变量之彰有较强的线性关系,这种关系若超过了因变量与自变量的线性关系,则回归模型的稳定性受到破坏,回归系数估计不准确;需要指出的是,在多元回归模型中,多重共线性的难以避免的,只要多重共线性不太严重就行了;判别多元线性回归方程是否存在严惩的多重共线性,可分别计算每两个自变量之间的可决系数r2,若r2 > R2或接近于R2,则应设法降低多重线性的影响;亦可计算自变量间的相关系数矩阵的特征值的条件数k = λ1 / λpλ1为最大特征值,λp为最小特征值,k<100,则不存在多重点共线性;若100≤k≤1000,则自变量间存在较强的多重共线性,若k>1000,则自变量间存在严重的多重共线性;降低多重共线性的办法主要是转换自变量的取值,如变绝对数为相对数或平均数,或者更换其他的自变量;检验当回归模型是根据动态数据建立的,则误差项e也是一个时间序列,若误差序列诸项之间相互独立,则误差序列各项之间没有相关关系,若误差序列之间存在密切的相关关系,则建立的回归模型就不能表述自变量与因变量之间的真实变动关系;检验就是误差序列的自相关检验;检验的方法与一元线性回归相同;。

第三章多元线性回归模型(stata)⼀、邹式检验(突变点检验、稳定性检验)1.突变点检验1985—2002年中国家⽤汽车拥有量(t y ,万辆)与城镇居民家庭⼈均可⽀配收⼊(t x ,元),数据见表。

表中国家⽤汽车拥有量(t y )与城镇居民家庭⼈均可⽀配收⼊(t x )数据年份 t y (万辆) t x (元)年份 t y (万辆) t x (元)1985 1994 1986 1995 4283 1987 1996 1988 1997 1989 1998 1990 1999 5854 1991 2000 6280 1992 2001 19932002下图是关于t y 和t x 的散点图:从上图可以看出,1996年是⼀个突变点,当城镇居民家庭⼈均可⽀配收⼊突破元之后,城镇居民家庭购买家⽤汽车的能⼒⼤⼤提⾼。

现在⽤邹突变点检验法检验1996年是不是⼀个突变点。

:两个字样本(1985—1995年,1996—2002年)相对应的模型回归参数相等HH:备择假设是两个⼦样本对应的回归参数不等。

1在1985—2002年样本范围内做回归。

在回归结果中作如下步骤(邹⽒检验):1、 Chow 模型稳定性检验(lrtest)⽤似然⽐作chow检验,chow检验的零假设:⽆结构变化,⼩概率发⽣结果变化* 估计前阶段模型* 估计后阶段模型* 整个区间上的估计结果保存为All* ⽤似然⽐检验检验结构没有发⽣变化的约束得到结果如下;(如何解释)2.稳定性检验(邹⽒稳定性检验)以表为例,在⽤1985—1999年数据建⽴的模型基础上,检验当把2000—2002年数据加⼊样本后,模型的回归参数时候出现显著性变化。

* ⽤F-test作chow间断点检验检验模型稳定性* chow检验的零假设:⽆结构变化,⼩概率发⽣结果变化* 估计前阶段模型* 估计后阶段模型* 整个区间上的估计结果保存为All* ⽤F 检验检验结构没有发⽣变化的约束*计算和显⽰ F 检验统计量公式,零假设:⽆结构变化然后 dis f_test 则得到结果;* F 统计量的临界概率然后得到结果* F 统计量的临界值然后得到结果(如何解释)⼆、似然⽐(LR )检验有中国国债发⾏总量(t DEBT ,亿元)模型如下:0123t t t t t DEBT GDP DEF REPAY u ββββ=++++其中t GDP 表⽰国内⽣产总值(百亿元),t DEF 表⽰年财政⾚字额(亿元),t REPAY 表⽰年还本付息额(亿元)。

对多元线性回归模型的各种检验方法对于形如LL uYXXX??????????k11k220)(1的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、对单个总体参数的假设检验:t检验在这种检验中,我们需要对模型中的某个(总体)?a?:,做出具有统计意参数是否满足虚拟假设H jj0a义(即带有一定的置信度)的检验,其中为某个给ja=0定的已知数。

特别是,当时,称为参数的(狭义j意义上的)显著性检验。

如果拒绝,说明解释变量H0Y?X具有显著的线性影响,估计值对被解释变量才?j jX Y不具对被解释变量敢使用;反之,说明解释变量j??对我们就没有意义。

具有显著的线性影响,估计值j体检验方法如下:a?;:)给定虚拟假设1(H?jj01.??a??E()???j j jj?t???的数值;计算统计量)(2(Se)Se)(??j j??1T?中,其X)?(XSe()?CC??1j?1jj jj j?j??0.1即(3)在给定的显著水平下(不能大于以下的前提下做90%,也即我们不能在置信度小于10%t;)t(分布的临界值双结论),查出尾1k?n??2/t?t的情况,检验结论为拒绝4)如果出现(?2/H H。

;反之,无法拒绝00????jj?t必须服从已检验方法的关键是统计量t?(Se)?j t分布函数。

什么情况或条件下才会这样呢?这需知的:要我们建立的模型满足如下的条件(或假定)n次观测的随机)随机抽样性。

我们有一个含(1????LL,X,X,nX,:1,2,,Yi?样。

这保证了误i1i i2iku差2.自身的随机性,即无自相关性,Cov(u?E(u))(u?E(u))?0。

jiji (2)条件期望值为0。

给定解释变量的任何值,误差u的期望值为零。

即有L,X)?,X,0E(uX k21L,,XX,X这也保证了误差独立于解释变量,即21uE(u)?0模型中的解释变量是外生性的,也使得。

(3)不存在完全共线性。

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

即有0),,,(21=k X X X u E这也保证了误差u 独立于解释变量X X X ,,,21 ,即模型中的解释变量是外生性的,也使得0)(=u E 。

(3) 不存在完全共线性。

在样本因而在总体中,没有一个解释变量是常数,解释变量之间也不存在严格的线性关系。

(4) 同方差性。

常数==221),,,(σk X X X u Var 。

(5) 正态性。

误差u 满足 ),0(~2σNormal u 。

在以上5个前提下,才可以推导出:1~)ˆ(/)ˆ()1,0(~)ˆ(/)ˆ()]ˆ(,[~ˆ----k n j j j jj j jj j t Se N Sd Var N βββββββββ由此可见,t 检验方法所要求的条件是极为苛刻的。

二、 对参数的一个线性组合的假设的检验需要检验的虚拟假设为 0H :21j j ββ=。

比如21ββ=无法直接检验。

设立新参数211ββθ-=。

原虚拟假设等价于0H :01=θ。

将211βθβ+=代入原模型后得出新模型:u X X X X Y k k ++++++=ββθβ )(212110 (2)在模型(2)中再利用t 检验方法检验虚拟假设0H :01=θ。

我们甚至还可以检验这样一个更一般的假设C H k k =+++=βλβλβλ 11000:λβt 统计量为)1(~ˆ2---=-k n t Se t T λX)λ(X λββλ1T三、 对参数多个线性约束的假设检验:F 检验需要检验的虚拟假设为 0H :0,,,021==+-+-k q k q k βββ 。

该假设对模型(1)施加了q 个排除性约束。

模型(1)在该约束下转变为如下的新模型:u X X X Y q k q k +++++=--ββββ 22110 (3) 模型(1)称为不受约束(ur )的模型,而模型(3)称为受约束(r )的模型。

模型(3)也称为模型(1)的嵌套模型,或子模型。

分别用OLS 方法估计模型(1)和(2)后,可以计算出如下的统计量:())1/(/---=k n RSS q RSS RSS F ur ur r关键在于,不需要满足t 检验所需要的假定(3),统计量F 就满足:1,~--k n q F F 。

利用已知的F 分布函数,我们就可以拒绝或接受虚拟假设0H :0,,,021==+-+-k q k q k βββ 了。

所以,一般来讲,F 检验比t 检验更先使用,用的更普遍,可信度更高。

利用关系式)1(2r r R TSS RSS -=,)1(2ur ur R TSS RSS -=,F 统计量还可以写成:())1/()1(/222----=k n R q R R F ur r ur四、 对回归模型整体显著性的检验:F 检验需要检验的虚拟假设为 0H :0,,,021==k βββ 。

相当于前一个检验问题的特例,k q =。

嵌套模型变为 u Y +=0β。

02=r R ,TSS RSS r =,22R R ur =。

F 统计量变为:)1/(/)1/()1(/22--=---=k n RSS kESS k n R k R F五、 检验一般的线性约束需要检验的虚拟假设比如为 0H :0,,,121==k βββ 。

受约束模型变为:u X Y ++=10β再变形为:u X Y +=-01β。

F 统计量只可用:())1/(/---=k n RSS qRSS RSS F ur ur r其中,[][]∑∑---=---==-211211)()()()(1X X Y Y X Y X Y TSS RSS i i i i X Y r 。

六、 检验两个数据集的回归参数是否相等:皱(至庄)检验虚拟假定是总体回归系数的真值相等。

步骤如下:(1) 基于两组样本数据,进行相同设定的回归,将二者的RSS 分别记为1RSS 和2RSS 。

(2) 将两组样本数据合并,基于合并的样本数据,进行相同设定的回归,将回归的RSS 记为T RSS 。

(3) 计算下面的F 统计量:)22/()()1/()(212121--+++--=k n n RSS RSS k RSS RSS RSS F T (4) 如果αF F ≥,拒绝原假定。

七、 非正态假定下多个线性约束的大样本假设检验:LM (拉格郎日乘数)检验F 检验方法需要模型(1)中的u 满足正态性假定。

在不满足正态性假定时,在大样本条件下,可以使用LM 统计量。

虚拟假设依然是0H :0,,,021==+-+-k q k q k βββ 。

LM 统计量仅要求对受约束模型的估计。

具体步骤如下:(ⅰ)将Y 对施加限制后的解释变量进行回归,并保留残差u ~。

即我们要进行了如下的回归估计 u X X X Y q k q k ~~~~~22110+++++=--ββββ(ⅱ)将u ~对所有解释变量进行辅助回归,即进行如下回归估计εααααˆˆˆˆˆ~22110+++++=k k X X X u并得到R-平方,记为2u R 。

(ⅲ)计算统计量 2u nR LM =。

(ⅳ)将LM 与2q χ分布中适当的临界值c 比较。

如果c LM >,就拒绝虚拟假设0H ;否则,就不能拒绝虚拟假设0H 。

八、 对模型函数形式误设问题的一般检验:RESET如果一个多元回归模型没有正确地解释被解释变量与所观察到的解释变量之间的关系,那它就存在函数形式误设的问题。

误设可以表现为两种形式:模型中遗漏了对被解释变量有系统性影响的解释变量;错误地设定了一个模型的函数形式。

在侦察一般的函数形式误设方面,拉姆齐(Ramsey ,1969)的回归设定误差检验(regression specilfication error test , RESET)是一种常用的方法。

RESET背后的思想相当简单。

如果原模型(1)满足经典假定(3),那么在模型(1)中添加解释变量的非线性关系应该是不显著的。

尽管这样做通常能侦察出函数形式误设,但如果原模型中有许多解释变量,它又有使用掉大量自由度的缺陷。

另外,非线性关系的形式也是多种多样的。

RESET则是在模型(1)中添加模型(1)的OLS拟合值的多项式,以侦察函数形式误设的一般形式。

为了实施RESET,我们必须决定在一个扩大的回归模型中包括多少个拟合值的函数。

虽然对这个问题没有正确的答案,但在大多数应用研究中,都表明平方项和三次项很有用。

令Y ˆ表示从模型(1)所得到的OLS 估计值。

考虑扩大的模型εδδββββ+++++++=322122110ˆˆY Y X X X Y k k (4)这个模型看起来有些奇怪,因为原估计的拟合值的函数现在却出作为解释变量出现。

实际上,我们对模型(4)的参数估计并不感兴趣,我们只是利用这个模型来检验模型(1)是否遗漏掉了重要的非线性关系。

记住,2ˆY 和3ˆY 都只是jX 的非线性函数。

对模型(4),我们检验虚拟假设0,0:210==δδH 。

这时,模型(4)是无约束模型,模型(1)是受约束模型。

计算F 统计量。

需要查3,2--k n F 分布表。

拒绝0H ,模型(1)存在误设,否则,不存在误设。

九、利用非嵌套模型检验函数形式误设寻求对函数形式误设的其他类型(比如,试图决定某一解释变量究竟应以水平值形式还是对数形式出现)作出检验,需要离开经典假设检验的辖域。

有可能要相对模型εββββ+++++=)log()log()log(22110k k X X X Y(5)检验模型(1),或者把两个模型反过来。

然而,它们是非嵌套的,所以我们不能仅使用标准的F 检验。

有两种不同的方法。

一种方法由Mizon and Richard (1986)提出,构造一个综合模型,将每个模型作为一个特殊情形而包含其中,然后检验导致每个模型的约束。

对于模型(1)和模型(5)而言,综合模型就是++++=k k X X Y γγγ 110μγγ++++++)log()log(11k k k k X X (6)可以先检验0,,0:10==++k k k H δγ ,作为对模型(1)的检验。

也可以通过对检验0,,0:10==k H δγ ,作为对模型(5)的检验。

另一种方法由Davison and MacKinnon (1981)提出。

认为,如果模型(1)是正确的,那么从模型(5)得到的拟合值在模型(1)中应该是不显著的。

因此,为了检验模型(1)的正确性,首先用OLS 估计模型(5)以得到拟合值,并记为Y ˆˆ。

在新模型μθββββ++++++=Y X X X Y k k ˆˆ122110 (7)中计算Y ˆˆ的t 统计量,利用t 检验拒绝或接受假定0:10=θH 。

显著的t 统计量就是拒绝模型(1)的证据。

类似的,为了检验模型(5)的正确性,首先用OLS 估计模型(1)以得到拟合值,并记为Y ˆˆ。