多元线性回归模型的各种检验方法-7页文档资料

- 格式:doc

- 大小:238.50 KB

- 文档页数:7

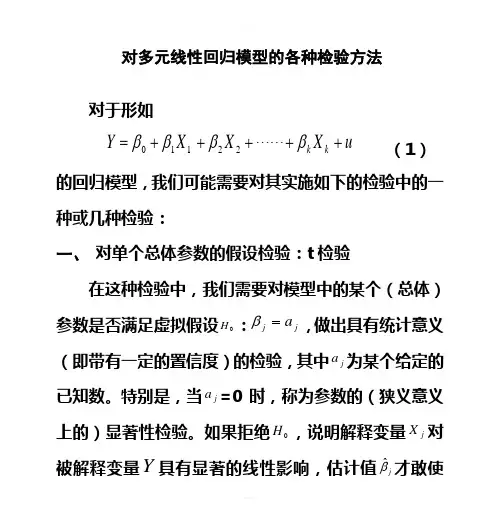

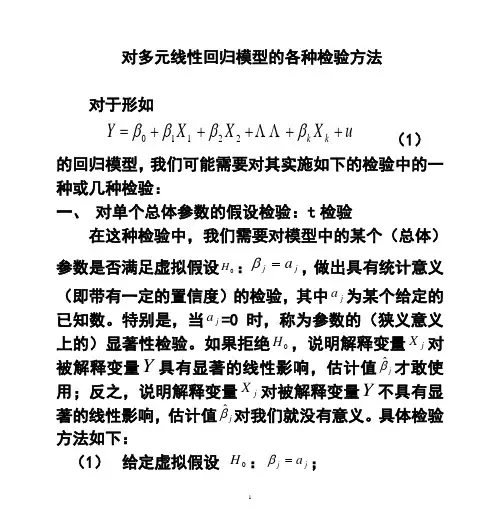

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

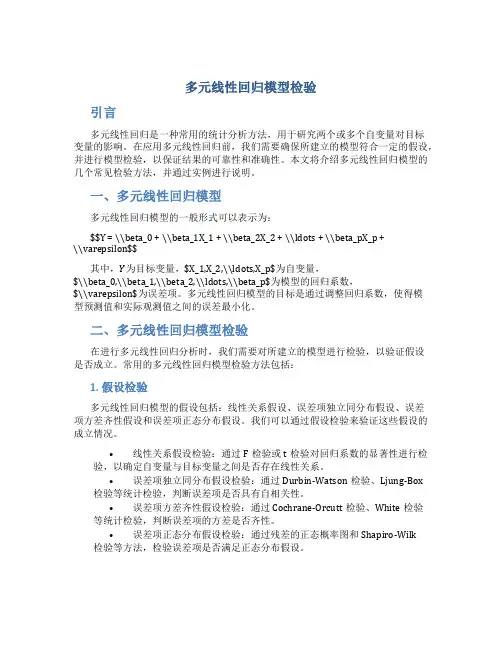

多元线性回归模型检验引言多元线性回归是一种常用的统计分析方法,用于研究两个或多个自变量对目标变量的影响。

在应用多元线性回归前,我们需要确保所建立的模型符合一定的假设,并进行模型检验,以保证结果的可靠性和准确性。

本文将介绍多元线性回归模型的几个常见检验方法,并通过实例进行说明。

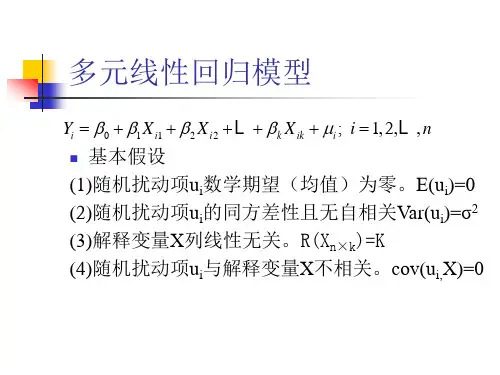

一、多元线性回归模型多元线性回归模型的一般形式可以表示为:$$Y = \\beta_0 + \\beta_1X_1 + \\beta_2X_2 + \\ldots + \\beta_pX_p +\\varepsilon$$其中,Y为目标变量,$X_1,X_2,\\ldots,X_p$为自变量,$\\beta_0,\\beta_1,\\beta_2,\\ldots,\\beta_p$为模型的回归系数,$\\varepsilon$为误差项。

多元线性回归模型的目标是通过调整回归系数,使得模型预测值和实际观测值之间的误差最小化。

二、多元线性回归模型检验在进行多元线性回归分析时,我们需要对所建立的模型进行检验,以验证假设是否成立。

常用的多元线性回归模型检验方法包括:1. 假设检验多元线性回归模型的假设包括:线性关系假设、误差项独立同分布假设、误差项方差齐性假设和误差项正态分布假设。

我们可以通过假设检验来验证这些假设的成立情况。

•线性关系假设检验:通过F检验或t检验对回归系数的显著性进行检验,以确定自变量与目标变量之间是否存在线性关系。

•误差项独立同分布假设检验:通过Durbin-Watson检验、Ljung-Box 检验等统计检验,判断误差项是否具有自相关性。

•误差项方差齐性假设检验:通过Cochrane-Orcutt检验、White检验等统计检验,判断误差项的方差是否齐性。

•误差项正态分布假设检验:通过残差的正态概率图和Shapiro-Wilk 检验等方法,检验误差项是否满足正态分布假设。

2. 多重共线性检验多重共线性是指在多元线性回归模型中,自变量之间存在高度相关性的情况。

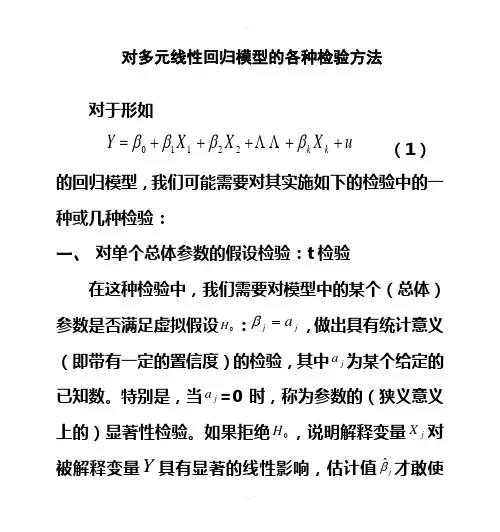

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββΛΛ22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21ΛΛ=。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

多元线性回归模型的各种检验方法多元线性回归模型是常用于数据分析和预测的方法,它可以用于研究多个自变量与因变量之间的关系。

然而,仅仅使用多元线性回归模型进行参数估计是不够的,我们还需要对模型进行各种检验以确保模型的可靠性和有效性。

下面将介绍一些常用的多元线性回归模型的检验方法。

首先是模型的整体显著性检验。

在多元线性回归模型中,我们希望知道所构建的模型是否能够显著解释因变量的变异。

常见的整体显著性检验方法有F检验和显著性检查表。

F检验是通过比较回归模型的回归平方和和残差平方和的比值来对模型的整体显著性进行检验。

若F值大于一定的临界值,则可以拒绝原假设,即模型具有整体显著性。

通常,临界值是根据置信水平和自由度来确定的。

显著性检查表是一种常用的汇总表格,它可以提供关于回归模型的显著性水平、标准误差、置信区间和显著性因素的信息。

通过查找显著性检查表,我们可以评估模型的显著性。

其次是模型的参数估计检验。

在多元线性回归模型中,我们希望知道每个自变量对因变量的影响是否显著。

通常使用t检验来对模型的参数估计进行检验。

t检验是通过对模型的回归系数进行检验来评估自变量的影响是否显著。

与F检验类似,t检验也是基于假设检验原理,通过比较t值和临界值来决定是否拒绝原假设。

通常,临界值可以通过t分布表或计算机软件来获取。

另外,我们还可以使用相关系数来评估模型的拟合程度。

相关系数可以用来衡量自变量与因变量之间的线性关系强度,常见的相关系数包括Pearson相关系数和Spearman相关系数。

Pearson相关系数适用于自变量和因变量都是连续变量的情况,它衡量的是两个变量之间的线性关系强度。

取值范围为-1到1,绝对值越接近1表示关系越强。

Spearman相关系数适用于自变量和因变量至少有一个是有序变量或者都是有序变量的情况,它衡量的是两个变量之间的单调关系强度。

取值范围也是-1到1,绝对值越接近1表示关系越强。

最后,我们还可以使用残差分析来评估模型的拟合程度和误差分布。

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1) 的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即 10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

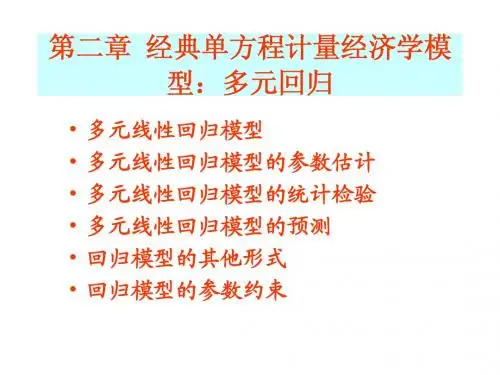

多元线性回归模型引言:多元线性回归模型是一种常用的统计分析方法,用于确定多个自变量与一个连续型因变量之间的线性关系。

它是简单线性回归模型的扩展,可以更准确地预测因变量的值,并分析各个自变量对因变量的影响程度。

本文旨在介绍多元线性回归模型的原理、假设条件和应用。

一、多元线性回归模型的原理多元线性回归模型基于以下假设:1)自变量与因变量之间的关系是线性的;2)自变量之间相互独立;3)残差项服从正态分布。

多元线性回归模型的数学表达式为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y代表因变量,X1,X2,...,Xn代表自变量,β0,β1,β2,...,βn为待估计的回归系数,ε为随机误差项。

二、多元线性回归模型的估计方法为了确定回归系数的最佳估计值,常采用最小二乘法进行估计。

最小二乘法的原理是使残差平方和最小化,从而得到回归系数的估计值。

具体求解过程包括对模型进行估计、解释回归系数、进行显著性检验和评价模型拟合度等步骤。

三、多元线性回归模型的假设条件为了保证多元线性回归模型的准确性和可靠性,需要满足一定的假设条件。

主要包括线性关系、多元正态分布、自变量之间的独立性、无多重共线性、残差项的独立性和同方差性等。

在实际应用中,我们需要对这些假设条件进行检验,并根据检验结果进行相应的修正。

四、多元线性回归模型的应用多元线性回归模型广泛应用于各个领域的研究和实践中。

在经济学中,可以用于预测国内生产总值和通货膨胀率等经济指标;在市场营销中,可以用于预测销售额和用户满意度等关键指标;在医学研究中,可以用于评估疾病风险因素和预测治疗效果等。

多元线性回归模型的应用可以为决策提供科学依据,并帮助解释变量对因变量的影响程度。

五、多元线性回归模型的优缺点多元线性回归模型具有以下优点:1)能够解释各个自变量对因变量的相对影响;2)提供了一种可靠的预测方法;3)可用于控制变量的效果。

然而,多元线性回归模型也存在一些缺点:1)对于非线性关系无法准确预测;2)对异常值和离群点敏感;3)要求满足一定的假设条件。

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββ 22110 (1) 的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y 具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值j βˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆjj j j j j Se a Se E t βββββ-=-= 的数值; 11ˆ)ˆ(++-==j j jj jj j C C Se 1T X)(X ,其中σβ(3) 在给定的显著水平α下(α不能大于1.0即 10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t 检验方法的关键是统计量 )ˆ(ˆj jj Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21 =。

这保证了误差u 自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u 的期望值为零。

多元线性回归模型的公式和参数估计方法以及如何进行统计推断和假设检验多元线性回归模型是一种常用的统计分析方法,它在研究多个自变量与一个因变量之间的关系时具有重要的应用价值。

本文将介绍多元线性回归模型的公式和参数估计方法,并讨论如何进行统计推断和假设检验。

一、多元线性回归模型的公式多元线性回归模型的一般形式如下:Y = β0 + β1X1 + β2X2 + ... + βkXk + ε其中,Y表示因变量,X1至Xk表示自变量,β0至βk表示模型的参数,ε表示误差项。

在多元线性回归模型中,我们希望通过样本数据对模型的参数进行估计,从而得到一个拟合度较好的回归方程。

常用的参数估计方法有最小二乘法。

二、参数估计方法:最小二乘法最小二乘法是一种常用的参数估计方法,通过最小化观测值与模型预测值之间的残差平方和来估计模型的参数。

参数估计的公式如下:β = (X^T*X)^(-1)*X^T*Y其中,β表示参数矩阵,X表示自变量的矩阵,Y表示因变量的矩阵。

三、统计推断和假设检验在进行多元线性回归分析时,我们经常需要对模型进行统计推断和假设检验,以验证模型的有效性和可靠性。

统计推断是通过对模型参数的估计,来对总体参数进行推断。

常用的统计推断方法包括置信区间和假设检验。

1. 置信区间:置信区间可以用来估计总体参数的范围,它是一个包含总体参数真值的区间。

2. 假设检验:假设检验用于检验总体参数的假设是否成立。

常见的假设检验方法有t检验和F检验。

在多元线性回归模型中,通常我们希望检验各个自变量对因变量的影响是否显著,以及模型整体的拟合程度是否良好。

对于各个自变量的影响,我们可以通过假设检验来判断相应参数的显著性。

通常使用的是t检验,检验自变量对应参数是否显著不等于零。

对于整体模型的拟合程度,可以使用F检验来判断模型的显著性。

F检验可以判断模型中的自变量是否存在显著的线性组合对因变量的影响。

在进行假设检验时,我们需要设定显著性水平,通常是α=0.05。

多元线性回归模型检验引言多元线性回归模型是一种常用的统计分析方法,用于研究多个自变量与因变量之间的关系。

在建立多元线性回归模型后,我们需要对其进行一系列的检验,以确保模型的准确性和可靠性。

本文将介绍多元线性回归模型的检验方法。

模型假设在进行多元线性回归模型检验前,我们首先需要明确模型所假设的条件。

多元线性回归模型假设以下几个条件:1.线性关系:自变量和因变量之间存在线性关系。

2.独立性:不同自变量之间相互独立。

3.同方差性:模型的误差项在自变量的每个取值下具有相同的方差。

4.正态性:误差项服从正态分布。

多元线性回归模型检验方法1. 相关系数检验在建立多元线性回归模型时,我们首先需要对自变量和因变量之间的相关关系进行检验。

常用的方法是计算各个自变量和因变量之间的相关系数,并通过假设检验确定其显著性。

2. 模型整体显著性检验在多元线性回归模型中,我们需要判断整体回归关系是否显著。

常用的方法是计算模型的F统计量,并通过显著性检验确定其结果。

F统计量的计算公式如下:$$ F = \\frac{(SSR/k)}{(SSE/(n-k-1))} $$其中,SSR为回归平方和,k为模型自变量个数,SSE为误差平方和,n为样本的观测值个数。

F统计量服从自由度为k和n-k-1的F分布。

3. 自变量的显著性检验除了整体显著性检验外,我们还可以对每个自变量进行显著性检验,以确定其对因变量的贡献程度。

常用的方法是计算自变量的t统计量,并通过显著性检验确定其结果。

t统计量的计算公式如下:$$ t = \\frac{\\hat{\\beta_j}}{\\sqrt{MSE \\cdot (X^TX)^{-1}_{jj}}} $$其中,$\\hat{\\beta_j}$为第j个自变量的估计系数,MSE为均方误差,(X T X)jj−1为自变量矩阵X的逆矩阵元素。

4. 模型的拟合度检验除了检验自变量的显著性外,我们还需要评估模型的拟合度。

对多元线性回归模型的各种检验方法对于形如LL uYXXX??????????k11k220)(1的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、对单个总体参数的假设检验:t检验在这种检验中,我们需要对模型中的某个(总体)?a?:,做出具有统计意参数是否满足虚拟假设H jj0a义(即带有一定的置信度)的检验,其中为某个给ja=0定的已知数。

特别是,当时,称为参数的(狭义j意义上的)显著性检验。

如果拒绝,说明解释变量H0Y?X具有显著的线性影响,估计值对被解释变量才?j jX Y不具对被解释变量敢使用;反之,说明解释变量j??对我们就没有意义。

具有显著的线性影响,估计值j体检验方法如下:a?;:)给定虚拟假设1(H?jj01.??a??E()???j j jj?t???的数值;计算统计量)(2(Se)Se)(??j j??1T?中,其X)?(XSe()?CC??1j?1jj jj j?j??0.1即(3)在给定的显著水平下(不能大于以下的前提下做90%,也即我们不能在置信度小于10%t;)t(分布的临界值双结论),查出尾1k?n??2/t?t的情况,检验结论为拒绝4)如果出现(?2/H H。

;反之,无法拒绝00????jj?t必须服从已检验方法的关键是统计量t?(Se)?j t分布函数。

什么情况或条件下才会这样呢?这需知的:要我们建立的模型满足如下的条件(或假定)n次观测的随机)随机抽样性。

我们有一个含(1????LL,X,X,nX,:1,2,,Yi?样。

这保证了误i1i i2iku差2.自身的随机性,即无自相关性,Cov(u?E(u))(u?E(u))?0。

jiji (2)条件期望值为0。

给定解释变量的任何值,误差u的期望值为零。

即有L,X)?,X,0E(uX k21L,,XX,X这也保证了误差独立于解释变量,即21uE(u)?0模型中的解释变量是外生性的,也使得。

(3)不存在完全共线性。

对多元线性回归模型的各种检验方法对于形如u X X X Y k k +++++=ββββΛΛ22110 (1)的回归模型,我们可能需要对其实施如下的检验中的一种或几种检验:一、 对单个总体参数的假设检验:t 检验在这种检验中,我们需要对模型中的某个(总体)参数是否满足虚拟假设0H :j j a =β,做出具有统计意义(即带有一定的置信度)的检验,其中j a 为某个给定的已知数。

特别是,当j a =0时,称为参数的(狭义意义上的)显著性检验。

如果拒绝0H ,说明解释变量j X 对被解释变量Y具有显著的线性影响,估计值j βˆ才敢使用;反之,说明解释变量j X 对被解释变量Y 不具有显著的线性影响,估计值jβˆ对我们就没有意义。

具体检验方法如下:(1) 给定虚拟假设 0H :j j a =β;(2) 计算统计量 )ˆ(ˆ)ˆ()(ˆj j j j j j Se a Se E t βββββ-=-= 的数值;(3) 在给定的显著水平α下(α不能大于1.0即10%,也即我们不能在置信度小于90%以下的前提下做结论),查出双尾t (1--k n )分布的临界值2/αt ;(4) 如果出现 2/αt t >的情况,检验结论为拒绝0H ;反之,无法拒绝0H 。

t检验方法的关键是统计量)ˆ(ˆjj j Se t βββ-=必须服从已知的t 分布函数。

什么情况或条件下才会这样呢?这需要我们建立的模型满足如下的条件(或假定):(1) 随机抽样性。

我们有一个含n 次观测的随机样(){}n i Y X X X i ik i i ,,2,1:,,,,21ΛΛ=。

这保证了误差u自身的随机性,即无自相关性,0))())(((=--j j i i u E u u E u Cov 。

(2) 条件期望值为0。

给定解释变量的任何值,误差u的期望值为零。

即有这也保证了误差u 独立于解释变量XX X ,,,21Λ,即模型中的解释变量是外生性的,也使得0)(=u E 。

(3) 不存在完全共线性。

在样本因而在总体中,没有一个解释变量是常数,解释变量之间也不存在严格的线性关系。

(4) 同方差性。

常数==221),,,(σk X X X u Var Λ。

(5) 正态性。

误差u 满足 ),0(~2σNormal u 。

在以上5个前提下,才可以推导出:由此可见,t检验方法所要求的条件是极为苛刻的。

二、 对参数的一个线性组合的假设的检验需要检验的虚拟假设为 0H :21j j ββ=。

比如21ββ=无法直接检验。

设立新参数211ββθ-=。

原虚拟假设等价于0H :01=θ。

将211βθβ+=代入原模型后得出新模型:uX X X X Y k k ++++++=ββθβΛΛ)(212110 (2)在模型(2)中再利用t 检验方法检验虚拟假设0H :01=θ。

我们甚至还可以检验这样一个更一般的假设t 统计量为三、 对参数多个线性约束的假设检验:F 检验 需要检验的虚拟假设为 0H :该假设对模型(1)施加了q 个排除性约束。

模型(1)在该约束下转变为如下的新模型:uX X X Y q k q k +++++=--ββββΛΛ22110 (3)模型(1)称为不受约束(ur )的模型,而模型(3)称为受约束(r )的模型。

模型(3)也称为模型(1)的嵌套模型,或子模型。

分别用OLS 方法估计模型(1)和(2)后,可以计算出如下的统计量:关键在于,不需要满足t 检验所需要的假定(3),统计量F 就满足:1,~--k n q F F 。

利用已知的F分布函数,我们就可以拒绝或接受虚拟假设 0H :0,,,021==+-+-k q k q k βββΛ了。

所以,一般来讲,F 检验比t 检验更先使用,用的更普遍,可信度更高。

利用关系式)1(2rr R TSS RSS -=,)1(2urur R TSS RSS -=,F 统计量还可以写成:四、 对回归模型整体显著性的检验:F 检验需要检验的虚拟假设为0H :0,,,021==k βββΛ。

相当于前一个检验问题的特例,k q =。

嵌套模型变为 uY+=0β。

02=rR ,TSS RSS r=,22R R ur =。

F 统计量变为:五、 检验一般的线性约束需要检验的虚拟假设比如为 0H :0,,,121==k βββΛ。

受约束模型变为:再变形为:uX Y +=-01β。

F 统计量只可用:其中,六、 检验两个数据集的回归参数是否相等:皱(至庄)检验 虚拟假定是总体回归系数的真值相等。

步骤如下: (1) 基于两组样本数据,进行相同设定的回归,将二 者的RSS 分别记为1RSS 和2RSS 。

(2) 将两组样本数据合并,基于合并的样本数据,进行相同设定的回归,将回归的RSS 记为T RSS 。

(3) 计算下面的F 统计量:(4) 如果αF F ≥,拒绝原假定。

七、 非正态假定下多个线性约束的大样本假设检验:LM (拉格郎日乘数)检验F 检验方法需要模型(1)中的u满足正态性假定。

在不满足正态性假定时,在大样本条件下,可以使用LM 统计量。

虚拟假设依然是H :0,,,021==+-+-k q k q k βββΛ。

LM 统计量仅要求对受约束模型的估计。

具体步骤如下:(ⅰ)将Y 对施加限制后的解释变量进行回归,并保留残差u ~。

即我们要进行了如下的回归估计(ⅱ)将u ~对所有解释变量进行辅助回归,即进行如下回归估计并得到R-平方,记为2u R。

(ⅲ)计算统计量2unR LM =。

(ⅳ)将LM 与2q χ分布中适当的临界值c 比较。

如果c LM >,就拒绝虚拟假设0H ;否则,就不能拒绝虚拟假设0H 。

八、 对模型函数形式误设问题的一般检验:RESET如果一个多元回归模型没有正确地解释被解释变量与所观察到的解释变量之间的关系,那它就存在函数形式误设的问题。

误设可以表现为两种形式:模型中遗漏了对被解释变量有系统性影响的解释变量;错误地设定了一个模型的函数形式。

在侦察一般的函数形式误设方面,拉姆齐(Ramsey ,1969)的回归设定误差检验(regression specilfication error test , RESET )是一种常用的方法。

RESET 背后的思想相当简单。

如果原模型(1)满足经典假定(3),那么在模型(1)中添加解释变量的非线性关系应该是不显著的。

尽管这样做通常能侦察出函数形式误设,但如果原模型中有许多解释变量,它又有使用掉大量自由度的缺陷。

另外,非线性关系的形式也是多种多样的。

RESET 则是在模型(1)中添加模型(1)的OLS 拟合值的多项式,以侦察函数形式误设的一般形式。

为了实施RESET ,我们必须决定在一个扩大的回归模型中包括多少个拟合值的函数。

虽然对这个问题没有正确的答案,但在大多数应用研究中,都表明平方项和三次项很有用。

令Yˆ表示从模型(1)所得到的OLS 估计值。

考虑扩大的模型εδδββββ+++++++=322122110ˆˆY Y X X X Y k k ΛΛ (4)这个模型看起来有些奇怪,因为原估计的拟合值的函数现在却出作为解释变量出现。

实际上,我们对模型(4)的参数估计并不感兴趣,我们只是利用这个模型来检验模型(1)是否遗漏掉了重要的非线性关系。

记住,2ˆY和3ˆY都只是j X 的非线性函数。

对模型(4),我们检验虚拟假设0,0:210==δδH 。

这时,模型(4)是无约束模型,模型(1)是受约束模型。

计算F 统计量。

需要查3,2--k n F 分布表。

拒绝0H ,模型(1)存在误设,否则,不存在误设。

九、利用非嵌套模型检验函数形式误设寻求对函数形式误设的其他类型(比如,试图决定某一解释变量究竟应以水平值形式还是对数形式出现)作出检验,需要离开经典假设检验的辖域。

有可能要相对模型εββββ+++++=)log()log()log(22110k k X X X Y ΛΛ (5)检验模型(1),或者把两个模型反过来。

然而,它们是非嵌套的,所以我们不能仅使用标准的F 检验。

有两种不同的方法。

一种方法由Mizon and Richard (1986)提出,构造一个综合模型,将每个模型作为一个特殊情形而包含其中,然后检验导致每个模型的约束。

对于模型(1)和模型(5)而言,综合模型就是++++=k k X X Y γγγΛ110μγγ++++++)log()log(11k k k k X X Λ (6)可以先检验0,,0:10==++k k k H δγΛ,作为对模型(1)的检验。

也可以通过对检验0,,0:10==k H δγΛ,作为对模型(5)的检验。

另一种方法由Davison and MacKinnon (1981)提出。

认为,如果模型(1)是正确的,那么从模型(5)得到的拟合值在模型(1)中应该是不显著的。

因此,为了检验模型(1)的正确性,首先用OLS 估计模型(5)以得到拟合值,并记为Yˆˆ。

在新模型μθββββ++++++=YX X X Y k k ˆˆ122110ΛΛ (7)中计算Yˆˆ的t 统计量,利用t 检验拒绝或接受假定0:10=θH 。

显著的t 统计量就是拒绝模型(1)的证据。

类似的,为了检验模型(5)的正确性,首先用OLS 估计模型(1)以得到拟合值,并记为Yˆˆ。

在新模型μθββββ++++++=YX X X Y k k ˆˆ)log()log()log(122110ΛΛ (8) 中计算Yˆˆ的t 统计量,利用t 检验拒绝或接受假定0:10=θH 。

以上两种检验方法可以用于检验任意两个具有相同的被解释变量的非嵌套模型。

非嵌套检验存在一些问题。

首先,不一定会出现一个明显好的模型。

两个模型可能都被拒绝,也可能没有一个被拒绝。

在后一种情形中,我们可以使用调整的R-平方进行选择。

如果两个模型都被拒绝,则有更多的工作要做。

不过,重要的是知道使用这种或那种函数形式的后果,如果关键性解释变量对被解释变量的影响没有多大差异,那么使用那个模型实际上并不要紧。

第二个问题是,比如说使用Davison and MacKinnon 检验拒绝了模型(5),这并不意味着模型(1)就是正确的模型。

模型(5)可能会因为多种误设的函数形式而被拒绝。

一个更为可能的问题是,在解释变量不同的模型之间进行比较时,如何实施非嵌套检验。

一个典型的情况是,一个解释变量是Y ,一个解释变量是)log(Y 。

使用调整的R-平方进行比较,需要小心从事。

希望以上资料对你有所帮助,附励志名言3条::1、世事忙忙如水流,休将名利挂心头。

粗茶淡饭随缘过,富贵荣华莫强求。

2、“我欲”是贫穷的标志。

事能常足,心常惬,人到无求品自高。

3、人生至恶是善谈人过;人生至愚恶闻己过。