基于降维的实验报告

- 格式:pdf

- 大小:286.53 KB

- 文档页数:15

PCA降维度实验报告一、实验目的本实验旨在通过PCA降维算法对高维数据进行降维处理,从而减少特征维度,保留主要信息的同时最大程度地降低数据的冗余度。

二、实验原理1.数据标准化:首先对原始数据进行标准化处理,使得每个特征具有相同的均值和方差,避免一些特征对PCA结果的影响过大。

2.计算协方差矩阵:根据标准化后的数据计算协方差矩阵,该矩阵描述了各个特征之间的相关性。

3.计算特征值和特征向量:对协方差矩阵进行特征值分解,得到特征值和对应的特征向量。

4.选择主成分:选取特征值最大的前k个特征向量作为主成分,这些主成分表示了原始数据中的大部分信息。

5.数据转换:通过将原始数据与选取的主成分进行线性变换,得到降维后的数据。

三、实验过程本实验使用Python编程语言进行实现,具体步骤如下:2.数据预处理:对数据进行标准化处理,使得每个特征的均值为0,方差为13.计算协方差矩阵:根据标准化后的数据计算协方差矩阵。

4.特征值分解:对协方差矩阵进行特征值分解,得到特征值和特征向量。

5.选择主成分:根据特征值大小,选择前k个特征向量作为主成分。

6.数据转换:将原始数据与选取的主成分进行线性变换,得到降维后的数据。

7.可视化展示:将降维后的数据可视化展示,观察不同类别的样本在降维空间中的分布情况。

四、实验结果经过PCA降维处理后,将原始数据的100个特征减少到了10个主成分。

我们对降维后的数据进行了可视化展示,发现不同类别的样本在降维空间中有较好的聚类效果,各类别样本之间的分离度较高。

五、结果分析和讨论通过PCA降维处理,我们成功将原始数据从100维降低到10维,减小了特征维度,同时保留了主要信息。

这不仅能提高模型的计算效率,还能避免过拟合等问题的发生。

此外,PCA降维还能提供一种可视化手段,通过降维后的数据在较低维度空间的分布情况,我们可以更直观地理解数据集中存在的模式或规律。

然而,PCA降维算法也存在一定的局限性,例如对非线性数据的处理效果不佳,可能会引入信息损失等问题。

一、实验背景随着遥感技术的快速发展,遥感图像数据在地理信息系统、环境监测、资源调查等领域得到了广泛应用。

然而,遥感图像数据通常具有高维、大数据量等特点,给数据处理和分析带来了巨大挑战。

主成分变换(PCA)作为一种有效的数据降维方法,能够将高维数据转化为低维数据,同时保留大部分信息,在遥感图像处理中具有广泛的应用。

二、实验目的本次实验旨在通过主成分变换方法对遥感图像进行降维处理,分析不同主成分对图像信息的贡献,并探讨主成分变换在遥感图像中的应用。

三、实验原理主成分变换是一种基于特征值分解的降维方法。

其基本原理如下:1. 对原始数据进行标准化处理,消除不同量纲的影响;2. 计算原始数据的协方差矩阵;3. 对协方差矩阵进行特征值分解,得到特征值和特征向量;4. 根据特征值的大小,选取前k个特征向量,构成主成分变换矩阵;5. 对原始数据进行主成分变换,得到降维后的数据。

四、实验步骤1. 读取遥感图像数据;2. 对图像数据进行预处理,包括去噪声、归一化等;3. 计算图像数据的协方差矩阵;4. 对协方差矩阵进行特征值分解;5. 根据特征值的大小,选取前k个特征向量,构成主成分变换矩阵;6. 对原始图像数据进行主成分变换;7. 分析不同主成分对图像信息的贡献;8. 生成降维后的图像,并进行可视化。

五、实验结果与分析1. 主成分分析结果:经过主成分变换后,前k个主成分的方差贡献率逐渐减小,其中第一主成分的方差贡献率最大,说明第一主成分包含了原始图像的大部分信息。

2. 主成分可视化:通过将主成分绘制成散点图,可以直观地观察到不同主成分之间的相关性。

可以发现,第一主成分与其他主成分之间的相关性较低,说明主成分变换有效地降低了数据之间的冗余。

3. 降维后的图像:将原始图像进行主成分变换后,得到的降维图像具有较低的分辨率,但能够保留原始图像的主要特征。

在遥感图像处理中,可以通过降维后的图像进行后续分析,如目标检测、分类等。

本科实验报告Principal Component Analysis一、实验题目1.实验4-1利用PCA 函数,对testSet.txt 中数据做降维分析:(1)可视化topNfeat 分别等于1、2 时,PCA 的输出数据;(2)通过与原始数据对比,讨论topNfeat 分别等于1、2 时的降维效果;2.实验4-2利用PCA,对secom.data 数据降维,(1)讨论topNfeat 取值对降维数据的影响;(2)找到降维后恢复的数据与原始数据相对误差小于9% 的topNfeat二、实验代码1.pca.pypca.py from numpy import ∗'''函数的map 函数是用的python2标准,python3无法正常使用。

''' def loadDataSet(fileName,delim=’\t’):fr = open (fileName) stringArr = [line.strip().split(delim) for linein fr.readlines()] datArr=[] for line in stringArr: data=[] for j inline:data.append(float (j))datArr.append(data) return mat(datArr) def pca(dataMat, topNfeat=9999999): meanVals = mean(dataMat, axis=0) meanRemoved = da taMat − meanVals #remove mean covMat = cov(meanRemoved, rowvar=0) eigVals,eigVects = linalg.eig(mat(covMat)) eigValInd = argsort(eigVals) #sort, sort goes smallest to largest eigValInd = eigValInd[:−(topNfeat+1):−1] #cut off unwanted dimensions redEigVects = eigVects[:,eigValInd] #reorganize eig vects largest to smallest lowDDataMat = meanRemoved ∗ redEigVects #transform data into new dimensions reconMat = (lowDDataMat ∗ redEigVects.T) + meanVals return lowDDataMat, reconMatdef replaceNanWithMean():datMat = loadDataSet(’secom.data’, ’ ’) numFeat =shape(datMat)[1]for i in range (numFeat):meanVal = mean(datMat[nonzero(~isnan(datMat[:,i].A))[0],i]) #values that are not NaN (a number) datMat[nonzero(isnan(datMat[:,i].A))[0],i] = meanVal #setNaN values to meanreturn datMat2. 实验 4-11 2 3 4 5 6 7 8 9 10 11 12 131415 16 17 18 19 20 21 22 2324 2526 27 28 29 30 31 32 33 34 35实验 4-1 from numpy import ∗import pcaimport matplotlib.pyplot as pltdataMat = pca.loadDataSet(’testSet.txt’)lowDMat, reconMat = pca.pca(dataMat, 2)shape(lowDMat) fig = plt.figure(1) ax =fig.add_subplot(1,1,1)ax.scatter(dataMat[:,0].tolist(), dataMat[:,1].tolist(), marker = ’^’, s = 90)ax.scatter(reconMat[:,0].tolist(), reconMat[:,1].tolist(), marker = ’o’, s = 50, c = ’red’) plt.savefig(”4−1−topNfeat(2).png”, dpi = 400) plt.show()3. 实验 4-2实验 4-2 import numpy as np import pcaimport matplotlib.pyplot as pltdataMat = pca.replaceNanWithMean() meanVals =np.mean(dataMat, axis = 0) meanRemoved = dataMat− meanVals covMat = np.cov(meanRemoved, rowvar =0) eigVals, eigVects =np.linalg.eig(np.mat(covMat))# 计算降维后恢复的数据与原始数据相对误差小于9%的topNfeat topNfeat = 0 Re_err = 0 for i inrange (999):lowDMat, reconMat = pca.pca(dataMat, i) Err = np.linalg.norm(dataMat − reconMat) / np.linalg.norm(dataMat) if Err < 0.09: topNfeat = i Re_err = Err break print (’降维后恢复的数据与原始数据相对误差小于9%的topNfeat 为:’,topNfeat) print (’此时相对误差为:%0.5f%%’ %(Re_err ∗100) )三、 实验结果1. 实验 4-1topNfeat = 1:1 2 3 45 6 7 8 9 10 111213 1 2 34 5 6 7 8 910 1112 13 14 15 1617 18 19 20 21 2223图1: topNfeat = 1 可视化topNfeat = 2:图2: topNfeat = 2 可视化从可视化图可以看出,topNfeat = 1 时,降维效果比较显著,而topNfeat = 2 时,数据和原始数据重合,降维效果不好,这是因为原始数据只有两个特征,而topNfeat = 2 并没有剔除任何特征。

一、实验背景随着数据量的不断增长,如何从大量数据中提取有价值的信息成为数据分析和处理的关键问题。

降维分析作为一种数据预处理方法,旨在减少数据集的维度,降低数据复杂度,提高数据分析的效率。

本实验通过降维分析,对原始数据进行处理,提取关键特征,为后续的数据挖掘和分析提供支持。

二、实验目的1. 了解降维分析的基本原理和方法;2. 掌握主成分分析(PCA)和因子分析(FA)两种降维方法;3. 通过实验验证降维分析在实际数据中的应用效果。

三、实验内容1. 数据集介绍:选取某电商平台用户购买行为的原始数据集,包含用户ID、商品ID、购买金额、购买时间等特征;2. 数据预处理:对原始数据进行清洗、缺失值处理和异常值处理;3. 主成分分析(PCA):(1)计算原始数据的协方差矩阵;(2)计算协方差矩阵的特征值和特征向量;(3)根据特征值选择主成分;(4)对原始数据进行主成分转换;4. 因子分析(FA):(1)计算原始数据的协方差矩阵;(2)提取因子;(3)对原始数据进行因子转换;5. 降维效果评估:比较原始数据集与降维后数据集的维度、方差解释率和模型拟合度等指标。

四、实验步骤1. 数据导入与预处理(1)使用Python的pandas库导入原始数据集;(2)对缺失值进行处理,采用均值、中位数或众数填充;(3)对异常值进行处理,采用Z-score或IQR方法剔除;(4)数据标准化,将特征值缩放到0-1之间。

2. 主成分分析(PCA)(1)计算原始数据的协方差矩阵;(2)计算协方差矩阵的特征值和特征向量;(3)根据特征值选择主成分,选取累计方差贡献率大于85%的主成分;(4)对原始数据进行主成分转换。

3. 因子分析(FA)(1)计算原始数据的协方差矩阵;(2)提取因子,采用主成分提取法;(3)对原始数据进行因子转换。

4. 降维效果评估(1)比较原始数据集与降维后数据集的维度;(2)计算方差解释率,评估降维后的数据集对原始数据的保留程度;(3)比较原始数据集与降维后数据集的模型拟合度。

一、引言主成分分析(PCA)是一种常用的数据降维方法,通过对原始数据进行线性变换,将高维数据投影到低维空间,从而简化数据结构,提高计算效率。

本文通过对主成分分析实验的剖析,详细介绍了PCA的基本原理、实验步骤以及在实际应用中的注意事项。

二、实验背景随着数据量的不断增长,高维数据在各个领域变得越来越普遍。

高维数据不仅增加了计算难度,还可能导致信息过载,影响模型的性能。

因此,数据降维成为数据分析和机器学习中的关键步骤。

PCA作为一种有效的降维方法,在众多领域得到了广泛应用。

三、实验目的1. 理解主成分分析的基本原理;2. 掌握PCA的实验步骤;3. 分析PCA在实际应用中的优缺点;4. 提高数据降维的技能。

四、实验原理主成分分析的基本原理是将原始数据投影到新的坐标系中,该坐标系由主成分构成。

主成分是原始数据中方差最大的方向,可以看作是数据的主要特征。

通过选择合适的主成分,可以将高维数据降维到低维空间,同时保留大部分信息。

五、实验步骤1. 数据准备:选择一个高维数据集,例如鸢尾花数据集。

2. 数据标准化:将数据集中的每个特征缩放到均值为0、标准差为1的范围,以便消除不同特征之间的尺度差异。

3. 计算协方差矩阵:计算标准化数据集的协方差矩阵,以衡量不同特征之间的相关性。

4. 特征值分解:对协方差矩阵进行特征值分解,得到特征值和特征向量。

5. 选择主成分:根据特征值的大小选择前k个特征向量,这些向量对应的主成分代表数据的主要特征。

6. 数据投影:将原始数据投影到选择的主成分上,得到降维后的数据。

六、实验结果与分析1. 实验结果:通过实验,我们得到了降维后的数据集,并与原始数据集进行了比较。

结果表明,降维后的数据集保留了大部分原始数据的信息,同时降低了数据的维度。

2. 结果分析:实验结果表明,PCA在数据降维方面具有良好的效果。

然而,PCA也存在一些局限性,例如:(1)PCA假设数据服从正态分布,对于非正态分布的数据,PCA的效果可能不理想;(2)PCA降维后,部分信息可能丢失,尤其是在选择主成分时,需要权衡保留信息量和降低维度之间的关系;(3)PCA降维后的数据可能存在线性关系,导致模型难以捕捉数据中的非线性关系。

降维分析报告引言降维分析是一种在机器学习和数据科学领域广泛应用的方法,它可以帮助我们从高维数据中提取主要特征,减少数据的维度,并保留尽可能多的有用信息。

在本报告中,我们将介绍降维分析的基本概念和常用算法,并通过一个具体的案例来示范如何应用降维分析。

降维分析的背景和意义在现实生活中,许多问题都涉及大量的特征或变量,这些特征可能存在冗余、噪声或不具有明确的解释。

此时,使用原始高维数据进行分析和建模将导致过拟合、维度灾难等问题。

因此,通过降维分析可以将复杂的高维数据转化为更加简洁、易理解的低维表示,帮助我们更好地理解数据并提取重要特征。

常用的降维分析方法主成分分析(PCA)主成分分析是一种常用的无监督降维算法,它通过线性变换将原始数据投影到新的正交特征空间,使得数据在新特征空间上的方差最大化。

通过计算主成分之间的协方差矩阵的特征值和特征向量,我们可以确定新特征空间的基向量,进而进行降维操作。

线性判别分析(LDA)线性判别分析是一种经典的监督降维算法,它将高维数据映射到一个低维空间中,使得不同类别的数据在该空间中的投影能够最大程度地区分开来。

和PCA相比,LDA在进行降维时考虑了类别信息,因此可能更适用于分类问题。

t分布邻域嵌入(t-SNE)t-SNE是一种非线性降维算法,它通过构建高维数据点之间的概率分布和低维数据点之间的概率分布,来保持高维数据的邻域结构。

t-SNE通常被应用于可视化高维数据,特别是在探索复杂数据集时非常有用。

降维分析的案例应用为了更好地理解降维分析的实际应用,我们以鸢尾花数据集为例进行分析。

鸢尾花数据集是一个经典的多分类问题,其中包含了四个特征:花萼长度、花萼宽度、花瓣长度和花瓣宽度。

我们可以使用降维分析方法对鸢尾花数据集进行可视化,并探索数据的结构和分布。

首先,我们使用主成分分析(PCA)对鸢尾花数据进行降维。

通过计算主成分之间的协方差矩阵的特征值和特征向量,我们可以选择保留的主成分数量,从而实现数据降维。

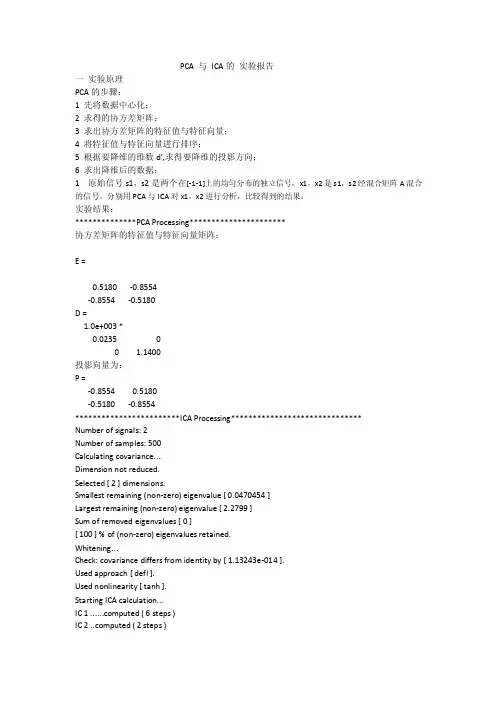

PCA 与ICA的实验报告一实验原理PCA的步骤:1 先将数据中心化;2 求得的协方差矩阵;3 求出协方差矩阵的特征值与特征向量;4 将特征值与特征向量进行排序;5 根据要降维的维数d’,求得要降维的投影方向;6 求出降维后的数据;1 原始信号s1,s2是两个在[-1-1]上的均匀分布的独立信号,x1,x2是s1,s2经混合矩阵A混合的信号。

分别用PCA与ICA对x1,x2进行分析,比较得到的结果。

实验结果:**************PCA Processing**********************协方差矩阵的特征值与特征向量矩阵:E =0.5180 -0.8554-0.8554 -0.5180D =1.0e+003 *0.0235 00 1.1400投影向量为:P =-0.8554 0.5180-0.5180 -0.8554************************ICA Processing******************************Number of signals: 2Number of samples: 500Calculating covariance...Dimension not reduced.Selected [ 2 ] dimensions.Smallest remaining (non-zero) eigenvalue [ 0.0470454 ]Largest remaining (non-zero) eigenvalue [ 2.2799 ]Sum of removed eigenvalues [ 0 ][ 100 ] % of (non-zero) eigenvalues retained.Whitening...Check: covariance differs from identity by [ 1.13243e-014 ].Used approach [ defl ].Used nonlinearity [ tanh ].Starting ICA calculation...IC 1 puted ( 6 steps )IC 2 puted ( 2 steps )Done.Adding the mean back to the data. ICA分解得到的混合矩阵A:A =1.1967 0.49870.6072 0.5268ICA分解得到的分离矩阵W:W =1.6084 -1.5228-1.8542 3.6539结果:从上面的结果可以看出:(1)ICA是假设信号源之间是相互独立的,基于四阶统计量(kurtosis);PCA是假设信号源之间是相互不相关的,基于二阶统计量(方差);(2)PCA的第一个主成分的方向是最大方差的方向,就是PC1 的方向,第二主成分的方向与PC1互相垂直,就是PC2的方向。

一、实验目的和要求(1)了解倒立摆控制系统的原理和系统组成(2)加深对实际控制系统物理组成部分的认识和理解(3)掌握线性系统控制器的设计、软件算法编制与实现要求针对直线型一级或二级倒立摆系统,设计状态反馈控制器和状态观测器,完成对小车倒立摆的稳定控制。

二、实验内容和原理以直线一级或二级倒立摆为研究对象,开展以下实验内容:(1)系统数学模型建模与分析(2)倒立摆经典控制设计(3)倒立摆状态反馈控制与状态观测器设计(4)倒立摆实物控制调试三、实验项目(1)倒立摆前馈控制起摆研究(2)能量控制起摆研究(3)倒立摆经典控制器设计及调试(4)倒立摆状态反馈控制器设计及调试四、实验器材倒立摆实验系统GLIP 一套计算机(MA TLAB)一台五、操作方法与实验步骤第一种起摆控制(一)模型建立一级倒立摆的模型示意图如下:图1 直线倒立摆一级模型由[1]可得到运动方程:222(cos (cos )()sin cos ()cos ()()()sin ml bx ml ml M m ml u I ml M m M m ml θθθθθθθθθ⋅+-⋅=+⋅+++++222222()()()()sin ()sin cos ()()(cos )I ml M m x I ml bx I ml ml ml g I ml M m u ml xθθθθθ++++-+-⋅=+++可以写成关于θ和x 的微分方程:222()cos ()sin cos ()sin cos (cos )()()M m ml u m M ml mlb x ml ml I ml M m θθθθθθθθ+⋅++-+⋅-++=222222()()()sin ()()sin cos (cos )()()M m I ml u I ml ml I ml bx ml gml I ml M m x θθθθθ-++⋅-+++-⋅-++=由[2]可得到运动方程:2()sin cos I ml mg b ml u θθθθ+=-+⋅根据本次试验对两种模型分别进行了输入输出观察,以[1]中的模型为主进行计算。

现代控制理论基础上机实验报告之二基于降维观测器的亚微米超精密车床振动控制院系航天学院专业姓名班号指导教师哈尔滨工业大学2014年06月01日1. 降维观测器设计的工程背景简介在实验一中针对亚微米超精密车床的振动控制系统,我们采用全状态反馈法设计了控制规律。

但是在工程实践中,传感器一般只能测量基座和床身的位移信号,不能测量它们的速度及加速度信号,所以后两个状态变量不能获得,换句话说全状态反馈很难真正实现。

为了解决这个问题,本实验设计一个降维(2维)状态观测器,用来解决状态变量2x 、3x 的估计问题,从而真正实现全状态反馈控制。

2. 实验目的通过本次上机实验,使同学们熟练掌握: ● 降维状态观测器的概念及设计原理; ● 线性系统分离原理的内涵;● 进一步熟悉极点配置及状态反馈控制律的设计过程; ● MATLAB 语言的应用。

3. 性能指标● 闭环系统渐近稳定; ● 降维观测器渐近稳定。

4. 给定的实际参数某一车床的已知参数:01200N/m k =,kg 120=m , 980N/A e k =,2.0=c ,Ω300=R ,H 95.0=L 。

5. 控制系统的开环状态空间模型根据实验一有:开环系统的状态空间表达式为:[]112233123x x 0100x =001x +0u -3157.9-10.5-315.8-8.6x x x y =100x x ⎧⎡⎤⎡⎤⎡⎤⎡⎤⎪⎢⎥⎢⎥⎢⎥⎢⎥⎪⎢⎥⎢⎥⎢⎥⎢⎥⎪⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎪⎣⎦⎣⎦⎨⎡⎤⎪⎢⎥⎪⎢⎥⎪⎢⎥⎪⎣⎦⎩6. 降维观测器方程的推导过程首先判断系统的能观性。

能观矩阵2100010001o C Q CA CA ⎡⎤⎡⎤⎢⎥⎢⎥==⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦所以系统完全能观,可以构造状态观测器。

由输出1y x = 可知,只需重构状态23x ,x ,即状态观测器是二维的。

据此,可将开环系统的矩阵分解:010A =001-3157.9-10.5-315.8⎡⎤⎢⎥⎢⎥⎢⎥⎣⎦,0B =0-8.6⎡⎤⎢⎥⎢⎥⎢⎥⎣⎦,[]C =100令110A ⎡⎤=⎣⎦ ,1210A ⎡⎤=⎣⎦,2103157.9A ⎡⎤=⎢⎥-⎣⎦,220110.5315.8A ⎡⎤=⎢⎥--⎣⎦10B ⎡⎤=⎣⎦,208.6B ⎡⎤=⎢⎥-⎣⎦11C ⎡⎤=⎣⎦,200C ⎡⎤=⎣⎦11x x = ,223x x x ⎡⎤=⎢⎥⎢⎥⎣⎦则有:11111221221122221x A x A x B ux A x A x B u y x ⎧=++⎪=++⎨⎪=⎩所以:1111222222212222y A y B u A x x A x A y B u A x u ω⎧=--=⎪=++=+⎨⎪⎩以ω为新的输出,以u 为新的输入,对2x 构造状态观测器,有:222122x (A LA )x u L ω=-++令22z x Ly,则:z=x Ly =--所以:22122212211121z (A LA )z [(A LA )L A LA ]y (B LB )u =-+-+-+-设12l L l ⎡⎤=⎢⎥⎢⎥⎣⎦则:122122l 1A LA 10.5l 315.8⎡⎤--=⎢⎥---⎢⎥⎣⎦不妨设观测器的极点为-100,-120,则12l 95.8L l 42243⎡⎤⎡⎤-==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦ 由此得到状态观测器的方程为:95.81330650z z y u 42243315.892956608.6⎡⎤⎡⎤⎡⎤=++⎢⎥⎢⎥⎢⎥----⎣⎦⎣⎦⎣⎦所以,状态估计为:100y x 95.8y 10z zLy 4224301⎡⎤⎡⎤⎡⎤⎢⎥⎢⎥==-+⎢⎥⎢⎥⎢⎥+⎣⎦⎢⎥⎢⎥⎣⎦⎣⎦7. 基于降维观测器的状态反馈控制律设计状态反馈控制律的极点配置同实验一,即状态反馈控制律为123u =2982.9x +311.5x -22.3x最终,带状态观测器的闭环状态反馈系统的状态空间表达式为:12233123111221212132123x x x x x 3157.9x 10.5x 315.8x 8.6u y x z 95.8z z 33065y z 42253z 315.8z 9295660y 8.6u x y x 95.8y z x 42243y z u 2982.9x 311.5x -22.3x ⎧⎧=⎪⎪=⎪⎪⎨⎪=----⎪⎪⎪⎪=⎩⎪⎪⎧=++⎪⎪⎨⎨=----⎪⎪⎩⎪⎧=⎪⎪⎪=-+⎨⎪⎪⎪=+⎩⎪=+⎪⎩ 8. 闭环系统的数字仿真给定初始条件:5551232212x (0)610m,x (0)210m /s,x (0)0.810,z(0) 1.810,z (0)610-----=⨯=⨯=-⨯=⨯=⨯(1) 利用matlab 编程仿真:第一个文件simu_reduce100function dx=simu_reduce(t,x) dx(1)=x(2); dx(2)=x(3);dx(3)=-3157.9*x(1)-10.5*x(2)-315.8*x(3)-8.6*(2982.9*x(1)+311.5*(-95.8*x(1)...+x(4))-22.3*(42243*x(1)+x(5))); dx(4)=95.8*x(4)+x(5)+33065*x(1);dx(5)=-42253*x(4)-315.8*x(5)-9295660*x(1)-8.6*(2982.9*x(1)+311.5*(-95.8*x(1)...+x(4))-22.3*(42243*x(1)+x(5))); dx=dx';第二个文件do_simu_reduce[t,x]=ode45('simu_reduce100',[0,5],[6*10^-5,2*10^-5,-0.8*10^-5,1.8*10^-2,6*10^-2]); figure(1); subplot(3,1,1); plot(t,x(:,1)); legend('x_1'); grid;title('State Variables');subplot(3,1,2);plot(t,x(:,2));legend('x_2');grid;subplot(3,1,3);plot(t,x(:,3));legend('x_3');grid;figure(2);subplot(2,1,1);plot(t,x(:,4));legend('z_1');grid;title('State Variables of Reduced-Order Observer');subplot(2,1,2);plot(t,x(:,5));legend('z_2');grid;运行第二个文件,可得:系统状态变量:00.51 1.52 2.53 3.54 4.55-4-202-3State Variables00.51 1.52 2.53 3.54 4.55-0.100.10.511.522.533.544.55-4-202状态观测器变量:00.511.522.533.544.55-0.4-0.3-0.2-0.100.1State Variables of Reduced-Order Observer0.51 1.52 2.53 3.54 4.55-50050100150由图可以看出,系统状态变量和状态观测器变量都收敛于零,所以系统渐近稳定,说明设计的状态观测器和状态反馈规律满足系统稳定要求。

现代控制理论基础上机实验报告之二基于降维观测器的亚微米超精密车床振动控制院系航天学院专业自动化姓名李蒙班号1004102指导老师王述一哈尔滨工业大学2013年6月5日一、工程背景介绍1.超精密车床隔振系统的作用超精密机床是实现超精密加工的关键设备,而环境振动又是影响超精密加工精度的重要因素。

为了充分隔离基础振动对超精密机床的影响,目前国内外均采用空气弹簧作为隔振元件,并取得了一定的效果,但是这属于被动隔振,这类隔振系统的固有频率一般在2Hz左右。

这种被动隔振方法难以满足超精密加工对隔振系统的要求。

为了解决这个问题,有必要研究被动隔振和主动隔振控制相结合的混合控制技术。

2.隔振系统的物理描述空气弹簧上图表示了亚微米超精密车床隔振控制系统的结构原理,其中被动隔振元件为空气弹簧,主动隔振元件为采用状态反馈控制策略的电磁作动器。

上图表示一个单自由度振动系统,空气弹簧具有一般弹性支承的低通滤波特性,其主要作用是隔离较高频率的基础振动,并支承机床系统;主动隔振系统具有高通滤波特性,其主要作用是有效地隔离较低频率的基础振动。

主、被动隔振系统相结合可有效地隔离整个频率范围内的振动。

床身质量的运动方程为:p a 0ms F F ++= (1)p F ——空气弹簧所产生的被动控制力; a F ——作动器所产生的主动控制力。

假设空气弹簧内为绝热过程,则被动控制力可以表示为:s sm机床质量c空气弹簧粘性阻尼系数 0k 空气弹簧刚度系数G主动隔振系统作动器(不表示参数)ss 地基位移机床位移p 0r r r e e {1[/()]}n F cy k y p V V A y A =++-+ (2)r V ——标准压力下的空气弹簧体积;0y s s =-——相对位移(被控制量);r p ——空气弹簧的参考压力;r A ——参考压力下单一弹簧的面积;e r 4A A =——参考压力下空气弹簧的总面积; n ——绝热系数。

电磁作动器的主动控制力与电枢电流、磁场的磁通量密度及永久磁铁和电磁铁之间的间隙面积有关,这一关系具有强非线性。

《电子商务》实验报告PCA降维题目(22)PCA成员2014年6月1日摘要为了提高统计模式识别的正确识别率,人们通常需要采集数量巨大的数据特征,使得原始空间或输入空间的维数可能高达几千维或万维。

如果直接在输入空间上进行分类器训练,就可能带来两个棘手的问题:(1)很多在低维空间具有良好性能的分类算法在计算上变得不可行;(2)在训练样本容量一定的前提下,特征维数的增加将使得样本统计特性的估计变得更加困难,从而降低分类器的推广能力或泛化能力,呈现所谓的“过学习”或“过训练”的现象。

要避免出现“过学习”的情况,用于统计分类器训练的训练样本个数必须随着维数的增长而呈指数增长,从而造成人们所说的“维数灾难”。

这一问题可以通过降维来解决。

因为高维数据中包含了大量的冗余并隐藏了重要关系的相关性,降维的目的就是消除冗余,减少被处理数据的数量,同时还能保持数据的特征完整性,本次实验使用26维度的语音参数MFCC验证PCA降维算法。

关键字:降维、PCA、MFCC1. 算法分析1.1 PCA 简介PCA 的目标是为了发现这种特征之间的线性关系,检测出这些线性关系,并且去除这线性关系。

PCA 称为主成分分析或者主元分析。

是一种数据分析的降维方法,一般常用于图像处理,它可以从多元事物中解析出主要影响因素,揭示事物的本质,简化复杂的问题。

计算主成分的目的是将高维数据投影到较低维空间。

一类事物的特征会很多,而每个特征也有很高的维数。

但有些维数之间有很大的相似性,相同的维数难以区分特性,所以PCA 的目标是为了发现这种特性维度之间的线性关系,检测出这些线性关系,并且去除这线性关系。

1.2 PCA 算法设X1、X2….,Xp 为原始变量,F1、F2…,Fm 为m 个主成分因子其使方差Var(F1)越大,表示F1包含的信息越多,故称F1为第一主成分。

(1) Fi 与Fj 互不相关,Cov(Fi ,Fj) = 0(2)F1是X1,X2,…,Xp 的一切线性组合中方差最大的,……,即Fm 是与F1,F2,……,Fm -1都不相关的X1,X2,…,XP 的所有线性组合中方差最大者。

降维算法实验报告总结与反思实验目的本次实验旨在探究降维算法在高维数据处理中的应用,并比较不同降维算法在数据压缩和特征选择方面的表现。

通过实验对比与分析,得到各算法的优劣以及适用场景,进一步理解和应用降维算法。

实验过程与结果我们选取了一份高维数据集,并采用了主成分分析(PCA)、线性判别分析(LDA)和t分布随机近邻嵌入(t-SNE)作为降维算法,进行了实验研究。

实验结果显示,PCA算法能够以较高的准确率对高维数据进行降维,并保留大部分的信息。

但是,PCA无法处理非线性数据或具有复杂数据结构的情况。

相比之下,LDA算法更适用于分类问题。

LDA在降维的同时还能保证样本的分类能力,通过最大化类间的散度和最小化类内的散度,能够有效地划分不同类别的样本。

然而,LDA算法在处理较大数据集时计算复杂度较高,需要考虑计算效率。

t-SNE算法是一种非线性降维算法,适用于探索数据的内部结构和样本的相似性。

t-SNE通过用户定义的相似度指标将高维数据映射到二维或三维空间中。

实验结果显示,t-SNE能够更好地保留数据局部结构,但在可解释性和计算效率上劣于PCA和LDA。

实验总结与反思通过本次实验,我对降维算法有了更深入的了解。

在实践中,选择适当的降维算法可以有效地处理高维数据,提升计算效率和模型性能。

以下是一些实验总结与反思:1. 准确性与可解释性:在选择降维算法时,需要根据具体任务需求权衡准确性和可解释性。

PCA算法既能达到较高的准确性,又能提供较好的可解释性。

而t-SNE算法虽然能更好地保留数据结构,但其结果难以解释。

2. 数据分布与算法选择:不同降维算法对数据的分布有不同的适应性。

LDA算法适合于分类问题,而PCA算法更适合于处理线性相关的数据。

因此,在选择算法时,需根据数据的分布和任务的需求综合考虑。

3. 计算效率:降维算法在处理大规模数据集时,计算复杂度是一个重要的指标。

LDA算法计算复杂度较高,在处理大规模数据时需考虑计算效率。

机器学习中的降维技术原理与应用案例分析近年来,随着数据量的爆炸性增长,对于高维数据的处理成为机器学习领域的重要挑战。

降维技术作为一种解决高维数据问题的有效手段,逐渐成为了研究和应用的热点。

本文将介绍机器学习中常用的降维技术原理,并通过实际应用案例分析其在实践中的应用。

降维技术的原理主要基于两个核心观点:数据的冗余性和数据的本质维度。

在高维数据中,往往存在大量的冗余信息,即一些特征之间存在线性或非线性的相关性。

通过降维,我们可以去除这些冗余信息,从而提取出更重要和有效的特征。

另一方面,数据的本质维度指的是数据在其空间中的固有特性。

通过降维,我们可以去除数据本质维度外的无关信息,从而更好地理解数据和发现数据的规律。

在机器学习中,常用的降维技术包括主成分分析(PCA)、线性判别分析(LDA)和 t-SNE 等。

主成分分析(PCA)是一种常用的无监督降维技术,通过线性变换将原始数据转换为一组新的正交变量,这些新变量被称为主成分。

主成分的选择是根据方差来确定的,我们选择具有最大方差的特征作为第一个主成分,然后在与第一个主成分正交的方向上选择具有最大方差的特征作为第二个主成分,依次类推。

通过选择方差较大的主成分,我们可以保留原始数据的较多信息,同时实现降维。

PCA 在图像处理、语音识别和生物医学中有广泛的应用。

线性判别分析(LDA)是一种常用的有监督降维技术,它在降维的同时能够最大化类别之间的差异。

LDA 的目标是将数据投影到一个低维空间,使得同类样本的投影点尽可能靠近且不同类样本的投影点尽可能远离。

通过最大化类别之间的散度和最小化同类样本之间的散度,LDA 能够找到最佳的投影方向。

LDA 在模式识别、人脸识别和文本分类等任务中具有重要意义。

t-SNE 是一种非线性的降维技术,它通过保持样本之间的相似性来进行降维,尤其适用于可视化高维数据。

t-SNE 首先计算样本之间的相似度,然后将相似度转换为概率分布,之后在低维空间中计算相对于原始空间的相似度。

基于流形学习的数据降维技术研究的开题报告一、选题背景随着信息技术的快速发展和普及,数据处理及分析已经成为现代社会中重要的研究方向。

由于现实中大量的数据集往往具有非线性及高维特征,因此数据降维成为数据处理和分析中不可缺少的一项重要技术。

目前数据降维技术中的主流方法是基于主成分分析(PCA)等线性降维方法,但这些方法存在着许多局限性,尤其是无法处理非线性及高维特征的数据。

因此,在这种情况下,研究基于流形学习的数据降维技术,通过对非线性流形进行建模和学习,以提高数据降维的效率和准确性,成为当前研究的热点问题。

二、选题意义数据降维技术在许多领域都有着广泛的应用,例如模式识别、数据挖掘、信号处理等。

在实际应用中,许多数据具有高维非线性特征,因此传统的线性降维方法已经不能满足需求。

通过基于流形学习的数据降维技术,可以有效地解决高维非线性数据降维的问题,提高数据处理的效率以及数据分析的准确性,具有广泛的应用前景。

三、研究内容本文研究基于流形学习的数据降维技术,重点探讨非线性流形的建模和学习方法,旨在提高数据降维的效率和准确性。

具体研究内容包括以下几个方面:1. 流形学习的基本理论和算法:对流形学习理论和算法进行深入研究,包括线性流形和非线性流形的概念、流形的局部特征和全局特征等。

2. 流形降维算法的研究:探讨基于流形学习的流形降维算法,包括LLE、Isomap、HLLE、Laplacian Eigenmaps等算法,分析它们的优缺点。

3. 非线性流形建模和学习方法:研究非线性流形模型的建模和学习方法,包括基于核函数的非线性流形学习方法、流形拟合方法、参数学习方法等。

4. 算法的实现和应用:在Matlab或Python平台上对研究的各种算法进行实现,并通过在数据挖掘、机器学习等实际领域的实际应用中进行测试和验证。

四、研究目标和可行性本文旨在研究基于流形学习的数据降维技术,其中重点探讨非线性流形的建模和学习方法。

《高维数据集降维优化研究》篇一一、引言随着大数据时代的到来,高维数据集在各个领域的应用越来越广泛。

然而,高维数据集的处理往往面临计算复杂度高、存储空间大、算法效率低下等问题。

为了解决这些问题,降维技术成为了重要的研究领域。

降维技术能够在保持数据集信息的前提下,减少数据的维度,从而简化数据处理过程,提高算法效率。

本文旨在研究高维数据集降维优化的方法,为相关领域的研究提供参考。

二、高维数据集的特点及挑战高维数据集具有数据量大、维度高、信息冗余等特点。

在处理高维数据集时,常常会遇到以下挑战:1. 计算复杂度高:随着维度的增加,计算成本呈指数级增长,导致处理效率低下。

2. 存储空间大:高维数据集需要大量的存储空间,给硬件设备带来压力。

3. 算法效率低下:高维数据集可能导致某些算法的效率降低,影响数据处理的速度和准确性。

三、降维技术概述降维技术是一种通过映射或转换高维数据到低维空间的方法,以简化数据处理过程。

常见的降维技术包括主成分分析(PCA)、t-分布邻域嵌入算法(t-SNE)、局部线性嵌入(LLE)等。

这些方法在降低维度的同时,能够保留数据集中的重要信息。

四、高维数据集降维优化方法为了解决高维数据集处理过程中的挑战,本文提出以下降维优化方法:1. 基于主成分分析(PCA)的降维优化:PCA是一种常用的降维方法,通过计算数据集的主成分,将原始数据投影到低维空间。

为了优化PCA的降维效果,可以引入正则化技术,以防止过拟合和噪声干扰。

此外,还可以通过选择合适的主成分数量,平衡降维效果和计算复杂度。

2. 基于特征选择的降维优化:特征选择是一种从原始特征中选取重要特征的方法。

通过选择与目标任务相关的特征,可以降低数据的维度。

在特征选择过程中,可以采用基于统计的方法、基于机器学习的方法等。

此外,还可以结合领域知识进行特征选择,以提高降维效果。

3. 基于深度学习的降维优化:深度学习在降维领域具有广泛应用。

通过构建深度神经网络模型,可以学习数据的内在表示和结构,从而实现降维。

《高维数据集降维优化研究》篇一一、引言在现今大数据的时代背景下,数据维度的爆炸式增长已经成为了一个不可忽视的问题。

高维数据集不仅增加了数据处理的复杂性,还可能导致“维数灾难”,即随着维度的增加,算法的效率和准确性会显著下降。

因此,高维数据集的降维优化成为了数据处理和分析中的一项重要研究内容。

本文将就高维数据集降维优化的基本原理、方法和相关技术进行研究。

二、高维数据集及其问题高维数据集普遍存在于许多领域中,如图像识别、生物信息学、医学研究等。

这些数据集通常包含大量的特征和属性,而这些特征之间可能存在高度的相关性或冗余性。

这导致了在处理和分析这些数据时,不仅计算量大,而且容易受到噪声和异常值的影响,从而影响模型的准确性和稳定性。

三、降维优化的基本原理和方法降维优化的基本原理是通过某种算法或技术,将高维数据映射到低维空间中,同时尽可能地保留原始数据中的信息。

这既包括数据的内在结构,也包括数据的分布特性。

在降维过程中,优化算法的目标是寻找一种最佳的映射关系,使得在低维空间中能够更好地表示和解释原始数据。

目前,常用的降维方法包括主成分分析(PCA)、线性判别分析(LDA)、流形学习等。

PCA是一种无监督的降维方法,它通过寻找数据中的主成分来降低数据的维度。

LDA是一种有监督的降维方法,它根据类别的信息来选择最能区分不同类别的特征进行降维。

流形学习则是一种基于流形假设的降维方法,它通过在流形上寻找低维嵌入来达到降维的目的。

四、高维数据集降维优化的技术发展随着技术的发展,高维数据集降维优化的方法也在不断更新和改进。

例如,基于深度学习的降维方法已经成为了一个研究热点。

这些方法通过构建深度神经网络来学习数据的内在表示,从而在降维的同时保留更多的信息。

此外,集成学习和迁移学习等技术在降维优化中也得到了广泛的应用。

五、实证研究与应用为了验证降维优化方法的有效性,本文进行了实证研究。

我们选择了某生物信息学领域的高维数据集作为研究对象,采用了PCA、LDA和基于深度学习的降维方法进行对比实验。