第九章 降维

- 格式:docx

- 大小:159.87 KB

- 文档页数:6

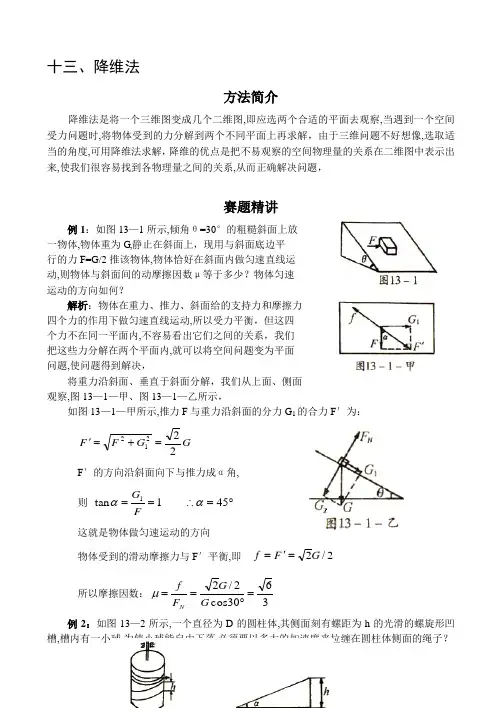

十三、降维法方法简介降维法是将一个三维图变成几个二维图,即应选两个合适的平面去观察,当遇到一个空间受力问题时,将物体受到的力分解到两个不同平面上再求解,由于三维问题不好想像,选取适当的角度,可用降维法求解,降维的优点是把不易观察的空间物理量的关系在二维图中表示出来,使我们很容易找到各物理量之间的关系,从而正确解决问题,赛题精讲例1:如图13—1所示,倾角θ=30°的粗糙斜面上放 一物体,物体重为G,静止在斜面上,现用与斜面底边平 行的力F=G/2推该物体,物体恰好在斜面内做匀速直线运 动,则物体与斜面间的动摩擦因数μ等于多少?物体匀速 运动的方向如何?解析:物体在重力、推力、斜面给的支持力和摩擦力 四个力的作用下做匀速直线运动,所以受力平衡,但这四 个力不在同一平面内,不容易看出它们之间的关系,我们 把这些力分解在两个平面内,就可以将空间问题变为平面 问题,使问题得到解决,将重力沿斜面、垂直于斜面分解,我们从上面、侧面 观察,图13—1—甲、图13—1—乙所示,如图13—1—甲所示,推力F 与重力沿斜面的分力G 1的合力F ′为:G G F F 22212=+=' F ′的方向沿斜面向下与推力成α角, 则 ︒=∴==451tan 1ααFG这就是物体做匀速运动的方向物体受到的滑动摩擦力与F ′平衡,即 2/2G F f ='=所以摩擦因数:3630cos 2/2=︒==G G F f N μ 例2:如图13—2所示,一个直径为D 的圆柱体,其侧面刻有螺距为h 的光滑的螺旋形凹槽,槽内有一小球,为使小球能自由下落,必须要以多大的加速度来拉缠在圆柱体侧面的绳子?解析:将圆柱体的侧面等距螺旋形凹槽展开成为平面上的斜槽,如图13—2—甲所示,当圆柱体转一周,相当于沿斜槽下降一个螺距h,当圆柱转n 周时,外侧面上一共移动的水平距离为22122at n D =π① 圆弧槽内小球下降的高度为221gt nh =② 解①、②两式,可得,为使螺旋形槽内小球能自由下落,圆柱体侧面绳子拉动的加速度应为hDga π=例3:如图13—3所示,表面光滑的实心圆球B 的半径 R=20cm,质量M=20kg,悬线长L=30cm ,正方形物块A 的 厚度△h=10cm,质量m=2kg,物体A 与墙之间的动摩擦因 数μ=0.2,取g=10m/s 2,求:(1)墙对物块A 的摩擦力为多大?(2)如果要物体A 上施加一个与墙平行的外力,使物体A 在未脱离圆球前贴着墙沿水平方向做加速度a =5m/s 2 匀加速直线运动,那么这个外力大小方向如何?解析:这里物体A 、B 所受的力也不在一个平面内,混起来考虑比较复杂,可以在垂直于墙的竖直平面内分析A 、B 间压力和A 对墙的压力;在与墙面平行的平面内分析A 物体沿墙水平运动时的受力情况,(1)通过受力分析可知墙对物块A 的静摩擦力大小等于物块A 的重力,(2)由于物体A 贴着墙沿水平方向做匀加速直线运动,所以摩擦力沿水平方向,合力也沿水平方向且与摩擦力方向相反,又因为物体受竖直向下的重力,所以推力F 方向应斜向上,设物体A 对墙的压力为N,则沿垂直于墙的方向,物体B 受到物体A 的支持力大小也为N,有θμtan ,Mg N N f ==而又因为43tan 53sin ==++∆=θθ所以R L R h 在与墙面平行的平面内,对物体A 沿竖直方向 做受力分析,如图13—3—甲所示有mg F =αsin沿水平方向做受力分析,有 ma f F =-αcos 由以上各式,解得 )5/5arcsin(,520)()(22==++=a N ma f mg F因此,对物体A 施加的外力F 的大小为205N,方向沿墙面斜向上且与物体A 水平运动方向的夹角为).5/5arcsin(例4:一质量m=20kg 的钢件,架在两根完全相同的平 行长直圆柱上,如图13—4所示,钢件的重心与两柱等距, 两柱的轴线在同一水平面内,圆柱的半径r=0.025m,钢件 与圆柱间的动摩擦因数μ=0.20,两圆柱各绕自己的轴线做 转向相反的转动,角速度./40s rad =ω若沿平行于柱轴的 方向施力推着钢件做速度为s m /050.00=υ的匀速运动, 求推力是多大?(设钢件不发生横向运动)解析:本题关键是搞清滑动摩擦力的方向,滑动摩擦力 的方向与相对运动的方向相反,由于钢件和圆柱都相对地面 在运动,直接不易观察到相对地面在运动,直接不易观察到 相对运动的方向,而且钢件的受力不在同一平面内,所以考 虑“降维”,即选一个合适的角度观察,我们从上往上看,画 出俯视图,如图13—4—甲所示,我们选考虑左边圆柱与钢件之间的摩擦力,先分析相对运动的方向,钢件有向前的速度0υ,左边圆住有向右的速度ωr ,则钢件相对于圆柱的速度是0υ与ωr 的矢量差,如图中△v ,即为钢件相对于圆柱的速度,所以滑动摩擦力f 的方向与△v ,的方向相反,如图13—4—甲所示,以钢件为研究对象,在水平面上受到推力F 和两个摩擦力f 的作用,设f 与圆柱轴线的夹角为θ,当推钢件沿圆柱轴线匀速运动时,应有22000)(22cos 2ωθr v v f vv ff F +=∆== ①再从正面看钢件在竖直平面内的受力可以求出F N , 如图13—4—乙所示,钢件受重力G 和两个向上的支 持力F N ,且G=2F N ,所以把N N F f GF μ==,2代入①式,得 推力N r v v mgr v v F F N 2)(22)(222002200=+⋅=+⋅=ωμωμ例5:如图13—5所示,将质量为M 的匀质链条套在一个表面光滑的圆锥上,圆锥顶角为α,设圆锥底面水平,链条静止时也水平,求链条内的张力,解析:要求张力,应在链条上取一段质量元m ∆进行研究,因为该问题是三维问题,各力不在同一平面内,所以用“降维法”作出不同角度的平面图进行研究,作出俯视图13—5—甲,设质量元m ∆两端所受张力为T,其合力为F,因为它所对的圆心角θ很小,所以2sin 2θT F =,即F=T θ,再作出正视图13—5—乙,质量元受重力m ∆g 、支持力N 和张力的合力F 而处于平衡状态,由几何知识可得:2cot 22cotαπθα⋅=⋅∆=Mg mg F 所以链条内的张力2cot 22απ⋅==MgF T例6:杂技演员在圆筒形建筑物内表演飞车走壁,演员骑摩托车从底部开始运动,随着速度增加,圈子越兜越大,最后在竖直圆筒壁上匀速率行驶,如图13—6所示,如果演员和摩托车的总质量为M,直壁半径为R,匀速率行驶的速率为v ,每绕一周上升的距离为h,求摩托车匀速走壁时的向心力,解析:摩托车的运动速度v ,可分解为水平速度v 1和竖直分速度为v 2,则向心力速度为Rv a 21=,处理这个问题的关键是将螺旋线展开为一个斜面,其倾角的余弦为22)2(2cos hR R a +=ππ,如图13—6—甲所示,所以有v hR R v v 221)2(2cos +==ππα向心加速度为:222221))2(2(h R R R v R v a +==ππ向心力 )4(422222h R RMv Ma F +==ππ 例7:A 、B 、C 为三个完全相同的表面光滑的小球,B 、C 两球各被一长为L=2.00m 的不可伸和的轻线悬挂于天花板上,两球刚好接触,以接触点O 为原点作一直角坐标系z Oxyz ,轴竖直向上,O x 与两球的连心线重合,如图13—7所示,今让A 球射向B 、C 两球,并与两球同时发生碰撞,碰撞前,A 球速度方向沿y 轴正方向,速率为s m v A /00.40=,相碰后,A 球沿y 轴负方向反弹,速率A v =0.40m/s ,(1)求B 、C 两球被碰后偏离O 点的最大位移量; (2)讨论长时间内B 、C 两球的运动情况,(忽略空气阻力,取g=10m/s 2) 解析:(1)A 、B 、C 三球在碰撞前、后的运动发生 在Oxy 平面内,设刚碰完后,A 的速度大小为A v ,B 、 C 两球的速度分别为B v 与C v ,在x 方向和y 方向的分速 度的大小分别为Bx v ,Cy Cx By v v v ,和,如图13—7—甲所示, 由动量守恒定律,有0=-Bx Cx mv mv ①A Cy By Ax mv mv mv mv -+= ②由于球面是光滑的,在碰撞过程中,A 球对B 球的作用力方向沿A 、B 两球的连心线,A 球对C 球的作用力方向沿A 、C 两球的连心线,由几何关系,得⎪⎪⎭⎪⎪⎬⎫==6tan 6tan ππCy Cx By Bx v v v v ③ 由对称关系可知 Cy Bx v v = ④解①、②、③、④式可得 s m v v Cy Bx /27.1==s m v v Cy Bx /20.2==由此解得 s m v v Cy Bx /54.2==图13—7甲设C 球在x >0, y>0, z >0的空间中的最大位移为,OQ Q 点的z 坐标为z Q ,则由机械能守恒定律可写出Q C mgz mv =221 ⑤ 所以 gv z CQ 22= 代入数值解得 z Q =0.32m而Q 点到O z 轴的距离为 )2()(22Q Q Q z L z z L L QD -=--=所以C 球离O 点的最大位移量 Q Q Lz OD z OQ 222=+= ⑥代入数值,得 m OQ 13.1= ⑦由对称性,可得B 球在0,0,0>><z y x 的空间的最大位移量OP 为m OQ OP 13.1== ⑧(2)当B 、C 两球各达到最大位移后,便做回到原点的摆动,并发生两球间的碰撞,两球第一次返回O 点碰撞前速度的大小和方向分别为s m v Bx /27.1= 方向沿正x 轴方向 By v =2.20m/s 方向沿y 轴方向s m v Cx /27.1= 方向沿正x 轴方向 Cy v =2.20m/s 方向沿y 轴方向设碰撞后的速度分别为11C B v v 和,对应的分速度的大小分别为x B v 1、y B v 1、x C v 1和y C v 1,由于两球在碰撞过程中的相互作用力只可能沿x 轴方向,故碰撞后,沿y 轴方向的速度大小和方向均保持不变(因为小球都是光滑的),即y B v 1=By v 方向沿负y 轴方向 ⑨ y C v 1=Cy v 方向沿负y 轴方向 ⑩碰撞过程中,沿x 轴方向的动量守恒,则 Cx Bx x B x C mv mv mv mv -=-11 因为Cx Bx v v = 所以x B x C v v 11=即碰撞后两球在x 方向的分速度大小也相等,方向相反,具体数值取决于碰撞过程中是否机械能损失,在A 球与B 、C 两球同时碰撞的过程中,碰撞前,三者的机械能m mv E AD 82121==碰撞后三者的机械能 12222259.6212121E E m mv mv mv E C B A <=++=表明在碰撞过程中有机械能损失,小球的材料不是完全弹性体,故B 、C 两球在碰撞过程中也有机械能损失,即)(21)(21)(212222221111Y X X X Y XB BC C B B v v m v v m v v m +<+++ ○11 由⑨、⑩和○11三式,和 Cx Bx C B v v v v x X =<=11 ○12或C B C B v v v v =<=11当B 、C 两球第二次返回O 点时,两球发生第二次碰撞,设碰撞后两球的速度分别为22C B v v 和,对应的分速度的大小分别为y C x C B B v v v v y X 22,,22和,则有y y y y C B C B v v v v 1122=== y x x x C B C B v v v v 1122=<= 或 12B B v v < 12C C v v <由此可见,B 、C 两球每经过一次碰撞,沿x 方向的分速度都要变小,即x x x x x x X C B C B C B Cx B v v v v v v v v 332211=>=>=>= ……而y 方向的分速度的大小保持不变,即y t y y y y y C B C B C B Cy B v v v v v v v v 332211======= ……当两球反复碰撞足够多次数后,沿x 方向的分速度为零,只有y 方向的分速度,设足够多的次数为n,则有 0==nx nx C B v v ○13 s m v v v y ny ny B C B /20.2=== ○14 即最后,B 、C 两球一起的Oyz 平面内摆动,经过最低点O 的速度由○14式给出,设最高点的z 轴坐标为Qn z ,则 Qn Cny mgz mv =221 得gv z Cny Qn 22=代入数值,得 m z Qn 24.0= ○15 最高点的y 坐标由下式给出:Qn Qn Qn Qn z z L z L L y )2()(22-±=--±=代入数值,得:m y Qn 95.0±= ○16 例8:一半径R=1.00m 的水平光滑圆桌面,圆心为O,有一竖直的立柱固定在桌面上的圆心附近,立柱与桌面的交线是 一条凸的平滑的封闭曲线C,如图13—8所示,一根不可伸 长的柔软的细轻绳,一端固定在封闭曲线上某一点,另一端系一质量为m=7.5×10—2kg 的小物块,将小物块放在桌面上并把绳拉直,再给小物块一个方向与绳垂直、大小为s m v /0.40=的初速度,物块在桌面上运动时,绳将缠绕在立柱上,已知当绳的张力为T 0=2.0N 时,绳即断开,在绳断开前物块始终在桌面上运动,(1)问绳刚要断开时,绳的伸直部分的长度为多少?(2)若绳刚要断开时,桌面圆心O 到绳的伸直部分与封闭曲线的接触点的连线正好与绳的伸直部分垂直,问物块的落地点到桌面圆心O 的水平距离为多少?已知桌面高度H=0.80m,物块在桌面上运动时未与立柱相碰,取重力加速度大小为10m/s 2,解析:(1)这一问题比较简单,绳断开前,绳的张力即为物块所受的向心力,因为初速度与绳垂直,所以绳的张力只改变物块的速度方向,而速度大小不变,绳刚要断开时,绳的伸直部分的长度可求出,设绳的伸直部分长为x ,则由牛顿第二定律得:xv m T 200=代入已知数值得:x =0.60m(2)选取桌面为分析平面,将物块的落地点投影到此分析平面上,然后由平抛运动的知识求解,如图13—8—甲所示,设绳刚要断开时物块位于 桌面上的P 点,并用A 点表示物块离开桌面时的位置, 先取桌面为分析平面,将物块的落地点投影到此分析 平面上,其位置用D 点表示,易知D 点应在直线PA 的延长线上,OD 即等于物块落地点与桌面圆心O 的水平距离,而AD 等于物块离开桌面后做平抛运动的 水平射程,即 gH v AD 20= 故20222)2(g H v x R x OD +-+= 代入已知数值得物块落地点到桌面圆心O 的水平距离 m OD 47.2=例9:如图13—9所示是一种记录地震装置的水平摆,摆球m 固定在边长为L,质量可忽略不计的等边三角形的顶点A 上,它的对边BC 跟竖直线成不大的夹角α,摆球可以绕固定轴图13—8BC 摆动,求摆做微小振动的周期,解析:若m 做微小振动,则其轨迹一定在过A 点,垂直于BC 的平面内的以O 为圆心,OA 为半径的圆弧上,因此我们可以作一个过A 点垂直于BC 的平面M,如图13—9—甲所示,将重力mg 沿M 平面和垂直于M 平面方向分解,则在平面M 内,m 的振动等效于一个只在重力αsin mg g m ='作用下简谐运动,摆长.2360sin L LL =︒='所以周期 αππsin 2322g Lg L T =''=例10:六个相同的电阻(阻值均为R )连成一个电 阻环,六个结点依次为1、2、3、4、5和6,如图13—10 所示,现有五个完全相同的这样的电阻环,分别称为D 1、 D 2、…、D 5,现将D 1的1、3、5三点分别与D 2的2、4、 6三点用导线连接,如图13—10—甲所示,然后将D 2的 1、3、5三点分别与D 3的2、4、6三点用导线连接……依次类推,最后将D 5的1、3、5三点分别连接到D 4的2、4、6三点上,证明:全部接好后,在D 1上的1、3、两点间的等效是电阻为R 627724, 解析:由于连接电阻R 的导线,连接环D 之间的导线均不计电阻,因此,可改变环的半径,使五个环的大小满足:D 1<D 2<…<D 5.将图13—10—甲所示的圆柱形网络变成圆台形网络,在沿与底面垂直的方向将此圆台形网络压缩成一个平面,如图13—10—乙所示的平面电路图,现将圆形电阻环变成三角形,1、3、5三点为三角形的顶点,2、4、6三点为三角形三边的中点,图13—10—乙又变为如图13—10—丙所示电路图,不难发现,图13—10—丙所示的电路相对虚直线3、6具有左右对称性,可以用多种解法求,如将电路等效为图13—10—丁, A 1B 1以内的电阻R R B A 5411=A 2B 2以内的电阻R R R R R R R R B A B A B A 1914)2()2(111122=+++=A 3B 3以内的电阻R R R R R R R R B A B A B A 7152)2()2(222233=++⋅+=A 4B 4以内的电阻R R R R R R R R B A B A B A 265194)2()2(333344=++⋅+=A 5B 5以内的电阻R RR R R R R R B A B A B A 627724)2()2(444455=++⋅+=即为D 1环上1、3两点间的等效电阻,例11:如图13—11所示,用12根阻值均为r 的相同的电阻丝构成正立方体框架,试求AG 两点间的等效电阻,解析:该电路是立体电路,我们可以将该立体电路“压扁”,使其变成平面电路,如图13—11—甲所示,考虑到D 、E 、B 三点等势,C 、F 、H 三点等势,则电路图可等效为如图13—11—乙所示的电路图,所以AG 间总电阻为 r r r r R 65363=++=例12:如图13—12所示,倾角为θ的斜面上放一木 制圆制,其质量m=0.2kg,半径为r,长度L=0.1m,圆柱 上顺着轴线OO ′绕有N=10匝的线圈,线圈平面与斜面 平行,斜面处于竖直向上的匀强磁场中,磁感应强度 B=0.5T,当通入多大电流时,圆柱才不致往下滚动?解析:要准确地表达各物理量之间的关系,最好画出正视图,问题就比较容易求解了,如图13—12—甲所示,磁场力F m 对线圈的力矩为M B =NBIL ·2r ·sin θ,重力对D 点的力矩为:M G =mgsin θ,平衡时有:M B =M G 则可解得:A NBL mg I 96.12== 例13:空间由电阻丝组成的无穷网络如图13—13所示,每段电阻丝的电阻均为r,试求A 、B 间的等效电阻R AB ,解析:设想电流A 点流入,从B 点流出,由对称性可知,网络中背面那一根无限长电阻丝中各点等电势,故可撤去这根电阻丝,而把空间网络等效为图13—13—甲所示的电路,(1)其中竖直线电阻r ′分别为两个r 串联和一个r 并联后的电阻值,所以 r r r r r 3232=⋅=' 横线每根电阻仍为r,此时将立体网络变成平面网络,(2)由于此网络具有左右对称性,所以以AB 为轴对折,此时网络变为如图13—13—乙所示的网络,其中横线每根电阻为21r r =竖线每根电阻为32r r r ='='' AB 对应那根的电阻为r r 32=' 此时由左右无限大变为右边无限大, (3)设第二个网络的结点为CD,此后均有相同的网络,去掉AB 时电路为图13—13—丙所示,再设R CD =R n -1(不包含CD 所对应的竖线电阻)则N B A R R =',网络如图13—13—丁所示,此时 1111111333222------++=+⋅+⋅=+''''+=n n n n n n n R r rR r R r R r r R r R r r R当∞→n 时,R n =R n -1 ∴ 上式变为n n n n n R r rR r R r rR r R 3432++=++=由此解得:r r R n 6213+= 即r r R B A 6213+=' 补上AB 竖线对应的电阻r 32,网络变为如图13—13—戊所示的电路, r r r r r r R r R r R B A B A AB 21212)321(21)213(221321)213(262133262133232322=++=++=+++⋅=+⋅='' 例14:设在地面上方的真空室内,存在匀强电场和匀强磁场,已知电场强度和磁感应强度的方向是相同的,电场强度的大小E=4.0V/m,磁感应强度的大小B=0.15T,今有一个带负电的质点以v =20m/s 的速度在此区域内沿垂直场强方向做匀速直线运动,求此带电质点的电量与质量之比q/m 以及磁场的所有可能方向(角度可用反三角函数表),解析:因为带负电的质点做匀速直线运动,说明此质点所受的合外力为零,又因为电场强度和磁感应强度的方向相同,所以该带电质点所受的电场力和洛仑兹力的方向垂直共面,且必受重力作用,否则所受合外力不可能为零,设质点速度方向垂直纸面向里,由此该带电质点的受力图如图13—14所示,由平衡条件有有水平方向:θθsin cos Bqv Eq = ①在竖直方向:mg Bqv Eq =+θθcos sin ②解得:34tan =θ 34arctan =θ q/m=2 同理,当质点速度方向垂直纸面向外时受力情况如图13—14—甲,由平衡条件可解出θ值与上式解出的一样,只是与纸平面的夹角不同,故此带电质点的电量与质量之比为2,磁场的所有可能方向与水平方向的夹角都是 34tan 34arctan ==θθ或针对训练1.如图13—15所示,一个重1000N的物体放在倾角为30°的斜面上,物体与斜面间的摩擦系数μ为1/3,今有一个与斜面最大倾斜线成30°角的力F作用于物体上,使物体在斜面上保持静止,求力F的大小,2.斜面倾角θ=37°,斜面长为0.8m,宽为0.6m,如图13—16所示,质量为2kg的木块与斜面间的动摩擦因数为μ=0.5,在平行于斜面方向的恒力F的作用下,沿斜面对角线从A 点运动到B点(g=10m/s2,sin37°=0.6),求:(1)力F的最小值是多大?(2)力F取最小值时木块的加速度,3.质量为0.8kg的长方形木块静止在倾角为30°的斜面上,若用平行于斜面沿水平方向大小等于3N的力推物体,它仍保持静止,如图13—17所示,则木块所受摩擦力大小为,方向为,4.如图13—18,四面体框架由电阻同为R的6个电阻连接而成,试求任意两个顶点AB间的等效电阻,5.如图13—19所示三棱柱由电阻同为R的电阻线连接而成,试求AB两个顶点间的等效电阻,6.将同种材料粗细均匀的电阻丝连接成立方体的形状,如图13—20所示,每段电阻丝电阻均为r,试求:(1)AB两点间等效电阻R AG;(2)AD两点间等效电阻R AD,。

PCA降维算法详解以及代码⽰例转载地址:1. 前⾔PCA : principal component analysis ( 主成分分析)最近发现我的⼀篇关于PCA算法总结以及个⼈理解的博客的访问量⽐较⾼,刚好⽬前⼜重新学习了⼀下PCA (主成分分析)降维算法,所以打算把⽬前掌握的做个全⾯的整理总结,能够对有需要的⼈有帮助。

⾃⼰再看⾃⼰写的那个关于PCA的博客,发现还是⽐较混乱的,希望这⾥能过做好整理。

本⽂的所有总结参考了Andrew Ng的PCA教程,有兴趣的可以⾃⼰学习。

上⼀篇关于PCA 的博客:,在这篇博客中,有关于我最初在读研的时候关于PCA的认识,但是不是很系统,然后⾥⾯却给出了很多我总结的⽹络上的资料,以及根据我个⼈使⽤的经验总结的感悟,所以还是收到了很多的好评, o(∩∩)o...哈哈,谢谢各位的⽀持。

@copyright by watkins.song ^_^2. PCA的应⽤范围PCA的应⽤范围有:1. 数据压缩1.1 数据压缩或者数据降维⾸先能够减少内存或者硬盘的使⽤,如果内存不⾜或者计算的时候出现内存溢出等问题,就需要使⽤PCA获取低维度的样本特征。

1.2 其次,数据降维能够加快机器学习的速度。

2. 数据可视化在很多情况下,可能我们需要查看样本特征,但是⾼维度的特征根本⽆法观察,这个时候我们可以将样本的特征降维到2D或者3D,也就是将样本的特征维数降到2个特征或者3个特征,这样我们就可以采⽤可视化观察数据。

3. PCA原理简介3.1 基础⼊门这⾥我只给出在需要使⽤PCA的时候需要了解的最基本的PCA的原理,了解这些原理后对于正常的使⽤没有问题,如果想要深⼊了解PCA,需要学习⼀些矩阵分析的知识,更加详细的PCA算法请见wikipedia。

⾸先,我们定义样本和特征,假定有 m 个样本,每个样本有 n 个特征,可以如下表⽰:由简到难,先看⼀下从2D 降维到1D的⽐较直观的表⽰:在上图中,假设只有两个特征x1, x2, 然后需要降维到1D,这个时候我们可以观察途中X所表⽰的样本点基本上分布在⼀条直线上,那么就可以将所有的⽤(x1, x2)平⾯表⽰的坐标映射到图像画出的直线z上,上图中的⿊⾊铅笔线表⽰样本点映射的过程。

数据降维的方法

数据降维的方法

数据降维是指将原有维数的数据,通过某种算法,转换到更低维数的数据,以达到某种目的。

数据降维的方法有多种,下面简要介绍一下几种常用的降维方法。

1. 主成分分析法:

主成分分析法是一种不改变原始数据分布的有效数据降维方法,是一种无监督学习方法。

它的基本思想是,在维数很高的时候,将原始的高维的数据映射到一个低维的空间中,使得原始数据尽可能的保留其内在的结构,同时又降低维数。

2. 降维投影:

降维投影是把原始数据集的更高维(比如三维)映射到更低维(比如二维)的过程,在映射过程中,尽可能地保留原始数据的结构。

这种方法主要是从空间上考虑,把原始数据从多维空间映射到低维空间,使得数据之间的相关性、结构等能尽可能的保留。

3. 局部线性嵌入:

局部线性嵌入是一种有监督的特征提取算法,它有效地将原有维数较高的数据映射到低维空间中,同时又能保留原有的关联结构,主要用于非线性问题。

4. 降维编码:

降维编码是指将原始数据投影到一个更低维空间中,使用某种编码规则对原始数据进行编码,以达到降维的目的。

总之,数据降维是一种常用的方法,用来简化复杂数据的处理。

它节省了计算量和存储空间,同时又能保留原来数据的结构,十分有用。

降维算法的原理和优势是什么在当今这个数据爆炸的时代,我们常常面临着处理海量高维数据的挑战。

想象一下,我们手中有一个包含众多特征的数据集,就好像一个错综复杂的迷宫,让我们在其中迷失方向,难以找到有用的信息和规律。

而这时,降维算法就像一把神奇的钥匙,能够帮助我们打开这个迷宫的大门,将复杂的数据变得更加简单和易于理解。

那么,降维算法到底是什么呢?简单来说,降维算法就是一种将高维数据转换为低维数据的方法。

我们生活中的很多数据,比如图像、文本、音频等,往往具有很高的维度。

以图像为例,一张小小的彩色图片可能就有成千上万的像素点,每个像素点都包含了颜色和亮度等信息,这就构成了一个高维的数据集。

而降维算法的目的,就是要在不丢失重要信息的前提下,尽可能地减少数据的维度,让我们能够更轻松地处理和分析这些数据。

降维算法的原理可以从多个角度来理解。

其中一种常见的方法是基于特征提取。

就好比我们在一堆杂物中挑选出最有价值的物品一样,降维算法会从众多的原始特征中挑选出那些最能代表数据本质的特征。

通过某种数学方法,计算出每个特征的重要性或者相关性,然后只保留那些最重要的特征,从而达到降维的目的。

另一种常见的原理是基于数据的投影。

想象一下,我们有一个三维的空间,里面充满了数据点。

现在我们想要把这些数据点映射到一个二维的平面上,这就需要找到一个合适的投影方向,使得在这个平面上能够最大程度地保留数据点之间的关系和差异。

通过这样的投影操作,原本高维的数据就被转换为了低维的数据。

那么,降维算法有哪些具体的方法呢?主成分分析(PCA)就是其中一种非常经典和常用的方法。

PCA 的基本思想是通过线性变换,将原始数据投影到一个新的坐标系中,使得投影后的方差最大。

也就是说,它试图找到数据的主要方向,然后将数据沿着这些方向进行投影,从而实现降维。

还有一种方法叫做线性判别分析(LDA)。

与 PCA 不同的是,LDA 不仅考虑了数据的方差,还考虑了数据的类别信息。

数据降维的通俗解释

数据降维是指通过某种方法将高维数据转换为低维的数据表示形式。

在现实生活中,我们经常面对的数据往往存在着很多特征变量,例如图片的像素值、文本的词频等。

这些高维数据不仅难以可视化展示,还可能导致计算问题的复杂性增加。

通俗来说,数据降维的过程就像是将一个复杂的立体模型变成一个简单的平面图。

假设你有一幅3D的艺术作品,它有高、宽、深三个维度。

但是,你可能希望将这幅作品用一张2D的图片来展示。

这时,你需要找到一个方法将原始的3D数据降低到2D的表示形式。

这样一来,你就可以更方便地对作品进行可视化展示或者进行进一步的分析。

在数据降维的过程中,通常会使用一些数学方法或者统计学原理,例如主成分分析(PCA)或者线性判别分析(LDA)。

这些方法可以通过一些数学上的变换将原始数据映射到一个低维的空间中,同时尽可能保留原始数据的信息。

这就像是通过某种方式将原始的3D作品映射到一个2D的平面上,保留了一部分作品的细节和特征。

数据降维的好处很明显,一方面,降低了数据的维度,可以提高计算的效率,减少计算的复杂性。

另一方面,数据降维还可以帮助我们更好地理解和分析数据,发现特征之间的关系,并且进行可视化展示。

所以,数据降维在很多领域中都有广泛的应用,例如图像处理、自然语言处理、推荐系统等,都离不开数据降维的技术。

什么是降维算法?随着数据量的不断增大和数据维度的不断提高,许多数据科学家和工程师面临的最大挑战之一就是如何有效地处理和分析高维数据。

这时就需要我们采用降维算法来解决这个问题。

降维算法的作用是将高维数据映射到低维空间,并保留最重要的信息。

这样既可以降低计算成本,提高算法的效率,又可以避免数据维度灾难。

本文将为您介绍降维算法的原理和应用,以及常用的降维算法。

1. 什么是降维算法?降维算法是一种基于数学变换的技术,用于将高维数据映射到低维空间。

通俗地说,就是将数据从复杂的多维空间中压缩到简单的低维空间中去。

降维算法不仅可以用于数据可视化,还可以用于机器学习、图像处理、聚类分析等领域。

降维算法的核心思想是在保留数据最重要的特征的同时,尽可能地压缩数据的维度,减少噪声的干扰,从而更好地解决问题。

2. 降维算法的原理在介绍具体的降维算法之前,我们先来了解一下降维算法的原理。

降维算法的原理是将高维数据映射到低维空间中,并通过一定的映射方式对数据进行压缩。

映射方式有很多种,常见的映射方式有PCA (主成分分析)、LDA(线性判别分析)等。

PCA是降维算法中最常用的一种方法。

其基本思想是通过正交变换将原数据转换为新的特征向量,使得新特征向量的维度尽可能小,并使得数据的信息损失最小。

LDA是一种有监督的降维算法,其基本思想是将原数据映射到一个能够区分不同类别数据的低维空间中去。

通过分析样本的蕴含关系,能够减少数据的维度,提高数据的解释性。

3. 常用的降维算法常用的降维算法有PCA、LDA、t-SNE等,下面我们来介绍一下常用的降维算法。

(1)PCAPCA是一种常用的无监督降维算法,其基本思想是通过正交变换将原数据转换为新的特征向量。

PCA可以将数据在原始空间中的方差最大化,从而尽可能保留原始数据的信息。

(2)LDALDA是一种有监督的降维算法,其基本思想是将原数据映射到一个能够区分不同类别数据的低维空间中去。

通过分析样本的蕴含关系,能够减少数据的维度,提高数据的解释性。

数据降维方法及其应用数据降维是在机器学习和数据分析中经常使用的一种技术,它可以帮助我们从海量的数据中提取出重要的特征,以减少数据的维度并保留数据的关键信息。

本文将介绍一些常用的数据降维方法,并探讨它们在实际应用中的作用和效果。

一、主成分分析法(Principal Component Analysis, PCA)主成分分析是一种经典的数据降维方法,它通过线性变换将高维数据映射到低维空间中。

其基本思想是找到一组新的正交基,使得数据在新的基上具有最大的方差。

这样做的好处是,我们可以只保留方差较大的主成分,而忽略方差较小的次要成分,从而达到降低数据维度的目的。

PCA的应用非常广泛,比如在图像处理中,可以利用PCA将高维图像数据降低到低维,以实现图像的压缩和去噪等功能。

此外,在生物信息学中,PCA也常被用于基因表达数据的降维和挖掘,以辅助研究人员发现潜在的基因调控模式。

二、独立成分分析法(Independent Component Analysis, ICA)独立成分分析是一种非线性的数据降维方法,它的目标是将高维数据分解为多个相互独立的成分。

与PCA不同的是,ICA假设数据是由多个独立的隐变量线性组合而成的,通过寻找这些隐变量的线性组合权重,可以将数据进行降维。

ICA在信号处理、盲源分离等领域有广泛的应用。

例如,在语音信号处理中,利用ICA可以将混合语音分解为原始的音频信号,有助于语音识别和语音增强等任务的完成。

三、线性判别分析法(Linear Discriminant Analysis, LDA)线性判别分析是一种经典的分类数据降维方法,它的目标是找到一个投影方向,使得同类别样本的投影点尽可能近,不同类别样本的投影点尽可能远,从而实现样本的有效分类。

LDA可以看作是PCA在分类问题上的扩展。

LDA在模式识别、人脸识别等领域有广泛的应用。

例如,在人脸识别中,利用LDA可以提取出具有判别性的特征,从而实现对人脸图像的分类和识别。

高维数据的降维方法

随着数据的爆炸式增长,高维数据的处理越来越受到关注。

然而,高维数据的处理也带来了一些挑战。

首先,高维数据的存储和计算成本很高。

其次,高维数据的可视化和分析也变得更加困难。

为了解决这些问题,一些降维方法被提出。

降维方法的目标是将高维数据映射到低维空间,同时尽可能地保留数据的关键信息。

主要的降维方法包括主成分分析(PCA)、线性判别分析(LDA)、t-SNE等。

PCA是一种无监督学习方法,通过找到数据中的主要成分来降低数据的维度。

LDA则是一种有监督学习方法,它将数据映射到一个低维空间,使得在该空间中不同类别的数据点能够被更好地区分。

t-SNE是一种非线性降维方法,它通过在高维空间中保持数据点之间的相对距离来将数据映射到低维空间。

除了上述方法,还有一些其他的降维方法,如多维缩放(MDS)、局部线性嵌入(LLE)等。

这些方法在不同的数据集和应用场景中都有着广泛的应用。

在实际应用中,我们需要根据数据的特点和应用需求来选择合适的降维方法。

- 1 -。

数学中的降维方法

在数学中,降维方法是一种重要的技术,它可以将高维数据映射到低维空间,从而方便对数据的分析和处理。

在实际应用中,高维数据往往会给数据分析带来很大的困难,因为高维数据的数据点较多,复杂度较高。

因此,为了更好地处理这些数据,研究人员提出了多种降维方法。

其中较为常见的方法包括主成分分析、线性判别分析、特征选择和特征提取等。

主成分分析(Principal Component Analysis,PCA)是一种常用的降维方法,该方法可以将高维数据转化为一组低维数据,同时保持数据的关键特征。

通过PCA方法,我们可以发现数据的主要方向,去除不必要的信息,获得更为简洁的数据表示,从而更容易地进行数据分析和处理。

另一种常用的降维方法是线性判别分析(Linear Discriminant Analysis,LDA),该方法通常用于分类问题和模式识别。

LDA将数据映射到低维空间中,同时保留数据分类信息,从而使数据更易于区分和分类。

特征选择和特征提取是另外两种常见的降维方法。

特征选择主要是根据某些标准选择最重要的特征,从而达到降维目的。

而特征提取则是根据某种映射方法,将原始数据映射到新的特征空间中,从而发现数据的最佳表示方式,也可以达到降维的效果。

总之,降维是数据科学和机器学习中的重要方法,它不仅可以帮助我们更好地理解和分析数据,还可以提升数据挖掘和模式识别的效果。

在实际应用中,我们要根据具体的问题和数据特征选择最适合的降维方法。

了解机器学习中的降维算法随着大数据时代的到来,数据的数量和复杂度都在不断地增加,这导致了在数据分析和处理方面的挑战变得越来越大。

为了应对这种情况,我们需要利用先进的技术和工具来处理这些海量数据,而机器学习就是这样一种技术。

机器学习可以让计算机自动学习和适应数据模式,从而实现数据分析、预测和优化等功能。

然而,随着数据的不断增加,机器学习中的维度灾难问题也越来越突出。

为了解决这个问题,我们需要使用降维算法。

一、维度灾难在机器学习中,常常需要处理上百万维度的数据,但是当维度增加时,算法的性能和效果都会大幅下降。

这是因为在高维空间中,数据是非常稀疏的,而且样本之间距离的差异变得相对较小。

这导致了很难获得可靠的模型或者预测结果。

这就是所谓的“维度灾难”。

二、降维算法的作用为了解决维度灾难问题,机器学习中引入了降维算法,降维算法的作用是通过降低数据的维度,让数据适合于计算机进行处理。

降维算法可以用来降低数据的维数,同时保留数据信息的主要部分,从而避免了过度拟合或低拟合的情况。

在机器学习应用中,常用的降维算法有主成分分析(PCA)、线性判别分析(LDA)等。

三、主成分分析(PCA)主成分分析是一种流行的降维算法,其基本思想是将高维数据映射到低维空间上,保留数据的主要成分。

主成分分析通过找到数据本征值最大的方向,在这个方向上完成映射,从而实现数据的降维。

这种算法的优点是可以减少数据冗余,快速计算,运算效果稳定,而且可以提高算法的鲁棒性和减小计算复杂度。

主成分分析广泛应用于机器学习、模式识别、数据挖掘、计算机视觉等领域。

四、线性判别分析(LDA)线性判别分析是一种常用的数据降维算法,其基本思想是将高维数据映射到低维空间上,同时保留数据的类别信息,从而实现数据分类的目的。

LDA在降维的同时,还可以减小数据的冗余,提高算法的准确性和泛化能力。

这种算法广泛应用于人脸识别、语音识别、图像识别、生物信息学等领域。

五、总结机器学习中的降维算法可以帮助我们处理高维的数据,从而提高算法的准确性和泛化能力。

高维数据分析中的降维与特征选择技术研究高维数据分析是指在数据集中存在大量的特征(维度)的情况下进行数据挖掘和分析的过程。

但是,高维数据分析面临着许多挑战,如计算复杂度增加、过拟合等问题。

为了克服这些挑战,降维和特征选择成为高维数据分析中十分重要的技术。

1. 降维技术降维技术旨在将高维数据映射到低维空间,同时保留数据的重要信息。

降维技术有两种主要方法:特征提取和特征投影。

特征提取通过将原始高维数据转换为一组新的维度来减少维度。

常见的特征提取方法有主成分分析(PCA)和线性判别分析(LDA)。

PCA通过线性变换将原始数据转换为新的正交特征,使得新特征能够尽量保留原始数据的方差。

LDA则是一种有监督的降维方法,它在保持类别间距离较大的同时,减小类别内部的方差。

特征投影是通过将原始高维数据映射到低维子空间来实现降维。

常见的特征投影方法有多维尺度变换(MDS)和随机投影。

MDS通过测量原始数据点之间的距离或相似性来构造一个低维度的表示。

随机投影是将原始数据点映射到一个随机生成的低维子空间中。

2. 特征选择技术特征选择技术是从原始高维数据中选择最相关或最具有代表性的特征子集。

目的是减少维度,并且能够保留原始数据的重要信息。

特征选择技术通常分为三类:过滤法、包装法和嵌入法。

过滤法通过计算每个特征与目标变量之间的相关性来选择特征。

常见的过滤法有相关系数、卡方检验和方差分析。

这些方法对特征与目标之间的关系进行统计分析,然后选择与目标变量相关性较高的特征。

包装法使用特定的学习算法来评估特征子集的性能,并根据评估结果选择特征。

这种方法通常基于预测模型的性能来选择特征子集。

常见的包装法有递归特征消除(RFE)和遗传算法。

嵌入法是在训练机器学习模型的过程中选择特征。

这种方法将特征选择过程嵌入到学习算法中,以优化模型的性能。

常见的嵌入法有L1正则化和决策树。

3. 降维与特征选择的应用降维和特征选择技术在高维数据分析中广泛应用于各个领域。

特征降维的方法特征降维的方法是一种在机器学习和数据分析领域广泛使用的技术。

在处理大量数据时,特征降维可以帮助我们减少数据的复杂度,提高模型的训练速度和准确度。

本文将介绍特征降维的几种常见方法及其优缺点。

1. 主成分分析(PCA)主成分分析是一种广泛使用的特征降维方法,其基本思想是将高维数据映射到低维空间,并保持数据的最大方差。

通过PCA,我们可以将数据的维度从n降至k(k<n)。

PCA的缺点是它假设数据服从高斯分布,如果数据不符合这个假设,PCA可能会失效。

2. 线性判别分析(LDA)线性判别分析是一种监督学习方法,它试图找到一个能够最大化类间距离和最小化类内距离的投影方向。

通过LDA,我们可以将数据的维度从n降至k(k<n)。

LDA的缺点是它需要数据具有明显的类别信息。

3. t-SNEt-SNE是一种非线性降维方法,它试图将高维数据映射到低维空间,并保持数据的局部结构。

通过t-SNE,我们可以将数据的维度从n 降至k(k<n)。

t-SNE的缺点是它的计算复杂度很高,需要大量的计算资源。

4. 随机投影随机投影是一种非常简单的特征降维方法,它使用随机矩阵将高维数据映射到低维空间。

通过随机投影,我们可以将数据的维度从n 降至k(k<n)。

随机投影的缺点是它可能无法保持数据的结构和信息。

5. 基于稀疏编码的特征降维基于稀疏编码的特征降维是一种基于字典学习的方法,它试图找到一个能够最小化数据重构误差的字典。

通过基于稀疏编码的特征降维,我们可以将数据的维度从n降至k(k<n)。

基于稀疏编码的特征降维的优点是它可以保持数据的结构和信息,但缺点是它需要大量的计算资源。

在实际应用中,我们需要根据具体情况选择不同的特征降维方法。

特征降维不仅可以提高模型的训练速度和准确度,还可以帮助我们更好地理解数据的结构和特征。

高维数据降维算法综述景明利【摘要】分类介绍了目前具有代表性的数据降维方法,重点阐述了一种新的数据降维方法-压缩感知,在此基础上,分析了各种数据降维算法的优缺点,并对数据降维研究中存在的问题进行了剖析.【期刊名称】《西安文理学院学报(自然科学版)》【年(卷),期】2014(017)004【总页数】5页(P48-52)【关键词】数据降维;线性;非线性;局部;压缩感知【作者】景明利【作者单位】西安财经学院统计学院,西安710100【正文语种】中文【中图分类】O241近年来,随着信息技术的飞速发展,高维数据已经广泛产生于模式识别、医学统计、计算机视觉、数字图像处理等领域.高维数据给数据的传输与存储带来了新的挑战.如何从高维数据中有效的找出其特征信息,是信息科学与统计科学领域中的基本问题,也是高维数据分析面临的主要挑战.应对这个挑战的首要步骤是对高维数据进行有效地降维处理.所谓降维是指将高维空间中的数据通过线性或非线性映射投影到低维空间中,找出隐蔽在高维观测数据中有意义的并且能揭示数据本质的低维结构.通过此方法能够减少高维数据的维数灾难问题,促进高维数据的分类、压缩和可视化.数据降维的数学本质可表示为[1]:假设X={xi,i=1,…,N}是D维空间的一个样本集合,Y={yi,i=1,…,N}是d维空间的一个数据集(d≪D),称F:X→Y是一个降维映射,表示为y=F(x),也称y为x的低维表示.针对数据降维问题,传统方法是假设数据具有低维的线性分布,代表性方法是主要成分分析(PCA)[2]和线性判别分析(LDA)[3].它们已经形成了完备的理论体系,并且在应用中也表现出了良好的性态.但由于现实数据的表示维数与本质特征维数之间存在非线性关系,因此近几年来由ST Roweis和JB Tenenbaum[4][5]提出来的流形学习方法,已经逐渐成为数据特征提取方法的研究热点问题.这类方法假设高维数据分布在一个本质上低维的非线性流形上,在保持原始数据表示空间与低维流形上的不变量特征的基础上来进行非线性降维.因此,流形学习算法也称之为非线性降维方法,其中代表性算法包括基于谱分析的算法、等距特征映射算法(ISOMAP)[4]、局部线性嵌入算法(LLE)[5]、局部切空间排列(LTSA)[6]、核主成分分析(KPCA)[7]、Laplacian特征映射[8]、Hessian特征映射[9]等.后来,基于概率参数模型的算法也相继出现,如Charting[10].然而,这些算法很难被应用于识别问题.但一些基于谱分析的算法由于具有特殊的分解特性能够简单的扩展为线性算法,通过解决优化过程中的线性逼近来实现.这些扩展化的方法使得流形思想更容易的应用到了实际中.流形化的学习从最初的非监督学习扩展到了监督学习和半监督学习,流形学习已经成为了机器学习相关领域的一个研究热点.对现有主流降维方法,可以从不同的角度进行分类.比如,从算法执行过程、从几何结构的保留角度、从待处理的数据特性等等.本文从待处理的数据特性出发对几种典型的线性和非线性降维方法进行了详细地阐述,着重分析讨论了压缩感知这种新的降维方法,分析并给出了各种算法的特性,最后指出了有待解决的问题.基于维数灾难和小样本问题的存在,许多基于统计或者几何理论的数据降维方法被提出.从待处理的数据性质考虑,将现有的降维方法分为线性和非线性两大类.1.1 线性降维算法1.1.1 PCAPCA于20世纪初由Hotelling提出,通过对原始变量的相关矩阵或协方差矩阵结构的研究,将多个原随机变量转换为少数几个新的随机变量(能够反映原始变量绝大部分信息),从而达到降维目的.设图像样本为X={x1,…,xN},xi∈Rm,N为总样本个数.根据最优重建准则,PCA目标函数为这里W∈Rm×m是变换阵,把样本从高维空间变换到低维空间.(1)式通过特征值分解得其中:其中是所有样本的均值,矩阵C是样本的协方差矩阵.事实上,W是C较大特征值对应的特征向量.1.1.2 LDALDA是根据著名的Fisher准则,对于二类(正类,负类)问题推广到多类问题,希望找到的优化方向是使得在低维空间中同类数据尽量靠近而非同类数据尽量分离,从而保留丰富的辨别信息,使投影后的数据具有最大的可分性.改进后的Fisher准则为:其中:[w1,w2,…,wd]是SB的前d个最大特征值对应的特征向量.也就是求SBwi=λiSWwi,i=1,…,d的特征值问题来求出最优的方向[w1,w2,…,wd],d≤C-1.求出特征向量后,观测数据在这些特征向量上的投影系数就是对观测数据所提取的低维嵌入坐标.1.2 非线性降维算法对非线性降维算法,从高维数据几何结构被保留至低维空间的角度对算法进行分类:1.2.1 全局分析的流形算法(1)ISOMAPISOMAP法主要思想是利用局部邻域距离近似计算数据点间的流形测地距离,同时将高维数据间的测地距离进行推导,将低维嵌入坐标的求解转化为矩阵的特征值问题.实现起来分为三步:第一步,对高维空间数据集上的每个数据点,判断其k邻近(距离数据点最近的前k个数据)或ε邻近数据(数据点距离小于ε的所有数据),然后连接并构成高维数据的带权邻域图;第二步,计算邻域图中任意数据对间的最短路径,将其作为近似测地线(所谓测地线就是一个曲面上,每一点处测地线曲率均为零的曲线)估计;第三步,利用多维尺度变换(MDS)算法对原数据集进行降维.(2)KPCAKPCA算法是对线性PCA的推广,使用了核方法即将核映射使用到数据处理方法中,其基本思想把输入数据x经过非线性映射Φ(x)映射到特征空间F上,在特征空间F上执行线性PCA.该算法的性能依赖于核的选取,核矩阵的大小与数据集中样本个数的平方成正比,但算法比较简单,能够处理非线性数据.1.2.2 局部分析的流形算法(1)LLELLE算法的主要思想是假设每个数据点与它邻近点位于流形的一线性或近似线性区域中,将全局非线性转换为局部线性.具体步骤分为三步:第一步,高维空间上建立原数据集的k邻近或ε邻近邻域图;第二步,计算数据的局部线性表示参数矩阵W,这可以通过求解下列约束优化问题:使得,且Wij=0,如果Xi,Xj互为邻域;第三步,将局部线性表示参数作为高维与低维数据的不变特征量,计算无约束优化问题获得降维结果Y(2)LTSALTSA算法主要思想是对每一个数据点构建一个局部切空间,然后对这些切空间进行一个放射变换从而得到一个全局嵌入的坐标.其主要步骤为三步:第一步,提取局部信息.对于样本点xi,选取k个邻近点(包含xi本身),并记为Xi 的均值.计算协方差矩阵ieT)的d个最大的单位特征向量g1,…,gd,并记;第二步,构造排列矩阵B.可根据此式构造,这里Ii为邻域索引;第三步,得到全部嵌入坐标.对B进行特征分解,选取对应于第2个到第d+1个最小的特征值构造成向量矩阵[u2,…,ud+1],则最终的嵌入坐标为T=[u2,…,ud+1]T.除了这两种算法,本类算法包括局部模型排列算法(ALM)[11]、局部线性坐标算法等.这些算法基本思想都是在局部分析后提取信息,在排列中使得这些信息在整体低维坐标中得到最大化保留.1.3 新的降维方法——压缩感知随着人们对信息需求量的增加,基于数据稀疏性提出一种新的采样理论——压缩感知(Compressed Sensing,CS),使得高维数据的采样与压缩成功实现.该理论指出:只要数据在某个正交变换域中或字典中是稀疏的,那么就可以用一个与变换基不相关的观测矩阵将变换所得高维数据投影到一个低维空间上,然后通过求解一个优化问题从这些少量的投影中以高概率重构出原数据,可以证明这样的投影包含了重构数据的足够信息.假设有一数据f(f∈RN),长度为N,基向量为Ψi(i=1,2,…,N),对数据进行变换:显然f是数据在时域的表示,α是数据在Ψ域的表示.若(5)式中的α只有K个是非零值(N≫K)且经排序后按指数级衰减并趋近于零,可认为数据是稀疏的.如何找到数据的最佳稀疏表示是CS理论和应用的基础前提.Candes和Tao[12]研究表明,具有幂次速度衰减的数据,可利用压缩感知理论恢复,并且重构误差满足下式假设数据是可压缩的(原始数据在某变换域中可快速衰减),则CS过程[13]可分为两步:(1)数据的低速采样问题:找一个与变换基不相关的M×N(M≪N)维测量矩阵对数据进行观测,保证稀疏向量从N维降到M维时,重要信息不被破坏.(2)数据的恢复问题:设计一个快速重构算法,由M维的测量向量重构原始数据.压缩感知理论以数据具有稀疏性为基础,有效缓解了高速采样实现的压力,达到了压缩的目的,为处理、传输、存储节约了大量的成本,这种新的采样理论的研究已经受到了多方关注,并取得了丰硕的成果.然而压缩感知理论目前面临的挑战为:电路中易于实现的采样矩阵的构造;鲁棒性强、算法复杂度低的恢复算法;非稀疏数据的稀疏化表示问题.压缩感知理论作为一种新的降维方法已经应用到数据处理等多个研究领域中,与此同时压缩感知理论与机器学习等领域的内在联系的研究工作已经展开.虽然上述各种数据降维算法被广泛应用于许多领域中,但是它们具有各自的优缺点,为了更好的应用这些算法,下面对这些算法的优缺点做一个简单的总结.PCA算法是一种无监督的学习方法,算法简单,具有线性误差等优点,但存在下述缺点:存储空间大,计算复杂度高,该算法中用到了线性映射也影响最后的效果,协方差矩阵的大小与数据点的维数成正比,导致了计算高维数据的特征向量是不可行的;LDA算法是一种有监督的学习方法,可以用于分类工作,但对于样本维数大于样本数的奇异值问题很敏感;ISOMAP算法虽具有拓扑不稳定性,计算复杂性大,对噪声敏感的局限性,但仍是一种优秀的方法,在许多研究领域被广泛采用,并取得了良好的效果;LLE算法具有以下优点:每个点的近邻权重在平移、旋转、缩放下保持不变;有解析的整体解,不需要进行迭代,复杂度较小,容易计算,但要求流形必须是不闭合且局部线性,要求观测的数据要稠密,对噪声也比较敏感;Laplacian特征映射的基本思想比较简单,计算起来也简单,但也要求观测数据采样稠密,对噪声敏感性很大;一般情况下,基于局部分析的算法在流形上的噪音数据较多,流形上的曲率较大,流形上的维数较高等情况下发挥不了优点,导致算法应用的失败;压缩感知算法是一种基于数据稀疏的优化计算恢复数据的过程,利用随机采样阵除去了冗余数据和无用的数据,缓解了高速采样的压力,减少了处理、存储、传输成本,不失为一种优秀的降维方法,但面临在噪声背景下,鲁棒性恢复算法的构想难题.本文对现有的分类方法进行了系统的分类,并对几种典型的线性和非线性降维方法进行了详细地阐述,着重分析讨论了一种新的降维方法即压缩感知,并指出了该算法的特性.目前降维算法仍在研究中,下列几个方面的研究值得关注:(1)非线性数据降维方法中都需要确定数据邻域尺寸和本质维数两个参数,如何确定更好的参数使得这些方法得到最大程度的改进.(2)前边提出的方法大多为局部方法,受噪音影响大,因此如何减少噪声的干扰、提高算法的鲁棒性是未来的研究方向.(3)现在的方法对动态增加的观测数据点不能快速的映射到低维空间中,因此学习改进增量算法具有一定的研究价值.(4)建立非凸的目标函数,不仅仅依赖于模型化数据流形的局部结构的邻域图,得到优化解.【相关文献】[1] 吴晓婷,闫德勤.数据降维方法分析与研究[J].计算机应用研究,2009,26(8):2832-2835.[2] HOTELLING H.Analysis of a complex of statistical variables into principal components[J].Journal of Educational Psychology,1993,24:417-441.[3] FISHER R A.The use of multiple measurements in taxonomic problems.Annals of Eugenics[J].Annals of eugenics,1936,7:179-188.[4] TENENBAUM J B,SILVA V D,LANGFORD J C.A global geometric framework fo nonlinear dimensionality reduction[J].Science,2000,5500(290):2319-2323.[5] ROWEIS S T,SAUL L K.Nonlinear dimensionality reduction by locally linearembedding[J].Science,2000,5500(290):2323-2326.[6] ZHANG Z.Principal manifolds and nonlinear dimensionality reduction via tangent space alignment[J].SIAM Journal on Scientific Computing,2004.26(1):313-338.[7] SCHOLKOPF B.Nonlinear component analysis as a kernel eigenvalue problem[J].Neural Computation,1998,10:1299-1319.[8] BELKIN M,NIYOGI placian eigenmaps and spectral techniques for embedding and clustering[J].Advances in Neural Information Processing System,2002,14:585-591.[9] DONOHO D L, GRIMES C.Hessian eigenmaps:new locally linear embedding techniques for high-dimensional data[J].Proc.National Academy of Sciences,2003,100(10):5591-5596.[10]TEH Y W,ROWEIS S.Automatic alignment of local representations[J].Advances in Neural Information Processing System,2002,15:841-848.[11]BRAND M.Charting a manifold[J].Advances in Neural Information Processing System,2002,15:961-968.[12]CANDES,TAO.Near optimal signal recovery from random projections:Universal encoding strategies[J].IEEE .Theory,2006,52(12):5406-5425.[13]石光明,刘丹华.压缩感知理论及其研究进展[J].电子学报,2009,37(5):1070-1080.。

数据降维的概念嘿,朋友们!今天咱来唠唠数据降维这个神奇的玩意儿。

你说数据就像那一大团乱麻,各种信息错综复杂地交织在一起。

想象一下,你面前有一堆乱七八糟的线团,你得从里面找出你需要的那根线,是不是感觉头都大了?这时候数据降维就像是一把神奇的剪刀,“咔嚓”一下,把那些不必要的、复杂的部分剪掉,让你能更清楚地看到关键的东西。

比如说,你去超市买东西,面对琳琅满目的商品,你不可能把每个商品的所有细节都记在脑子里吧?你只会关注一些重要的信息,比如价格、品牌、功能这些。

这其实就是一种降维呀!把复杂的数据简化成我们能轻松理解和处理的形式。

再想想看,我们的生活中不也经常在做数据降维吗?你认识一个新朋友,不可能一下子记住他所有的信息,你可能就记住他的名字、长相和一些主要特点,这不就是把他这个人的信息给降维了嘛!那数据降维到底有啥好处呢?哎呀,好处可多啦!它能让我们处理数据的速度大大加快呀!就像你走路,原本路上全是荆棘,走起来磕磕绊绊,现在把荆棘除掉了,那走起来不就顺畅多了嘛!而且它还能帮助我们更好地发现数据中的规律和模式呢!你看那些科学家们研究天文,面对那么多的数据,如果不降维,那不得看花眼呀!通过降维,他们就能更容易地找到那些隐藏在数据背后的秘密,就像在大海里捞到了珍贵的宝藏一样!数据降维也不是随随便便就能做的哦!这可得讲究方法和技巧呢。

要是乱降一通,那不就把重要的信息也给弄丢啦?那可就得不偿失咯!所以呀,我们得像个聪明的裁缝一样,精心地裁剪数据这团乱麻,留下最精华的部分。

这可不是一件容易的事儿,但一旦做好了,那可真是太棒啦!总之呢,数据降维就像是我们在数据世界里的一把利剑,能帮我们披荆斩棘,找到我们想要的答案和宝藏。

我们可得好好利用它,让我们的生活和工作变得更加轻松、高效!大家说是不是呀!。

第九章 降维 9.1k近邻学习 k近邻( k-Nearest Neighbor,简称KNN)学习是一种常用的监督学习方法,其工作机制非

常简单:给定测试样本,基于某种距离度量找出训练集中与其靠近的k个训练样本,然后基于k个“邻居”的信息来进行预测。在分类任务中一般使用“投票法”,在回归任务中使用“简单平均法”。还可以基于距离使用加权平均或加权投票。 9.2 低维嵌入 最近邻学习的一个重要建设:任意测试样本附近任意小的距离范围内总能找到一个训练样本,即训练样本的采样密度足够大。然而,这个假设在现实任务中通常很难满足。在低维数空间进行采样还比较容易满足一定条件,而在维数很高时,距离计算有时都面临困难。在高维情况下出现的数据样本稀疏、距离计算困难等问题,是所有机器学习共同面临的障碍, 被称为“维数灾难”。 缓解维数灾难的一个重要途径是降维(dimension reduction),亦称“维数简约”,即通过 某种数学变换将原始高维属性空间转变为一个低维“子空间”,在这个子空间中样本的密度大幅增高,距离计算也变得容易。为什么能降维?这是因为在很多时候,人们观测或收集到的数据样本虽是高维的,但与学习任务密切相关的也许是某个低维分布,即高维空间中的一个低维嵌入。 若要求原始空间中样本之间的距离在低维空间中得以保持,即得到“多维缩放”(Multiple Dimensional Scaling,简称MDS)[Cox,2001]这样一种经典的降维方法。

假定m个样本在原始空间的距离矩阵为mmRD,其元素ijd表示样本ix与jx之间的

距离,原始空间的维数为d。目标是获得样本在d维空间的表示ddRZmd,,且任意两个样本在d维空间中的欧式距离等于原始空间中的距离,即ijjidzz。 令mmTRZZB,其中B为降维后样本的内积矩阵,jTiijzzb,有

jTijiijzzzzd2222

ijjjiibbb2 (1)

为了便于讨论,令降维后的样本Z被中心化,即01miiz。显然矩阵B的行与列之和均为零,即mjmiijbijb110。易知

jjmiijmbBtrd)(12

(2)

iimjijmbBtrd)(12

(3) )(2112Bmtrdmimjij (4)

其中,21)(miizBtr。令 mjijidmd122

.

1

(5)

miijjdmd122

.

1

(6)

mimjijdmd11222

..

1

(7)

于是由(1)和式(2)-(7)可得 )(212..2.2.2ddddbjiijij, (8)

由此即可通过降维前后保持不变的距离矩阵D求取内积矩阵B。 对矩阵B做特征值分解,TVVB,其中),,,(21ddiag为特征值构成的对

角矩阵,d21,V为特征向量矩阵。假定其中有d个非零特征值,它们构成对角矩阵),,,(21ddiag,令V表示相应的特征向量矩阵,则Z可表示为 mdZRVT2

1

。

在现实应用中为了有效降维,往往仅需要降维后的距离与原始空间中的距离尽可能接近,而不必严格等待。此时可取dd个最大特征值构成的对角矩阵来表示Z。 一般来说,欲获得低维子空间,最简单的办法是对原始高维空间进行线性变换。给定d

维空间中的样本mdmRxxxX),,,(

21

,变换后得到dd维空间中的样本

XWZT,

其中ddRW是变换矩阵,mdRZ是样本在低维空间中的表示。基于线性变化的降维方法称为线性降维方法,对W施加不同的约束形成不同的降维方法。 9.3 流形学习 流形学习(manifold learning)是一类借鉴了拓扑流形概念的降维方法,“流形”是在局部与欧式空间同胚的空间,换言之,它在局部具有欧式空间的性质,能用欧式距离来进行距离计算。这给降维方法带来了很大的启发:若低维流形嵌入到高维空间,则数据样本在高维空间的分布虽然看上去非常复杂,但在局部上仍然具有欧式空间的性质,因此,很容易地在局部建立降维映射关系,然后再设法将局部映射关系推广到全局。当维数被降至二维或三维时,能对数据进行可视化展示,因此流形学习也可被用于可视化。 9.3.1 等度量映射 等度量映射(Isometric Mapping,简称Isomap)[Tenembaum et al.2000]的基本出发点,是认为低维流形嵌入到高维空间之后,直接在高维空间中计算直线距离具有误导性。比如, S曲面上的两点的测地线距离是两点之间的本真距离,显然在高维空间中计算直线距离是不

恰当的。测地线距离不能用高维空间的直线距离计算,但能用近邻距离来近似。这时利用流形在局部上与欧式空间同胚这个性质,对每个点基于欧式距离找出其临近点,然后就能建立一个近邻连接图,图中近邻点之间存在连接,而非近邻点之间不存在连接,于是,计算两点之间测地线距离的问题,就转变为计算近邻连接图上两点之间的最短路径问题。在得到任意亮点的距离后,就可以利用MDS方法来获得样本点在低维空间中的坐标。 需要注意的是,Isomap仅得到了训练样本在低维空间的坐标,对于新样本,如何将其映射到低维空间呢?这个问题的常用解决方案,是将训练样本的高维空间坐标作为输入、低维空间坐标作为输出,训练一个回归学习器来对新样本低维空间坐标进行预测。这显然是一个权宜之计,但目前似乎并没有更好的办法。 对近邻图的构建通常有两种方法,一种是指定近邻点个数,这样得到的近邻图称为k近邻图;另一种方法是指定距离小于事先给定的阈值的点为近邻点,这样得到的近邻图称为近邻图。两种方法均有不足,例如若近邻范围指定的较大,则距离很远的点可能被误认为

是近邻,这样就出现“短路”问题;近邻范围指定的较小,则可能出现“断路”问题。 9.3.2 局部线性嵌入 与Isomap试图保持近邻样本之间的距离不同,局部线性嵌入(Locally Linear Embedding,

简称LLE)[Roweis and Saul,2000]试图保持邻域内样本之间的线性关系。假定样本点ix的坐

标能通过它的邻域样本lkjxxx,,的坐标通过线性组合而重构出来,即 lilkikjijixwxwxwx LLE算法:

给定N个输入向量DiNRxxxxO,,,,21,输出DdNiRydi,,,2,1,。 (1)寻找每个样本点的k个近邻点; (2)计算出样本点的局部重建全脂矩阵,定义误差函数

Nikjijijixwxw11)(min

其中,),,2,1(kjxij为ix的k个近邻点,11kjijw。 令iiiijkjijxwNxw~1,其中),,,(21ikiiixxxN是一个kD阶矩阵, Tikiiiwwww),,,(

21,是一个1k的矩阵。令

iiixxxX,,,是kD维矩阵。

记221)(iiikjijijiiwNxxwxw iiTiiiiiiiwNXNXwwNXwNXwT)()((22

iiSwwT

其中,)()(iTiNXNXS。 引入Lagrange乘子,)11()(TTiiiiwSwwwL

112012)(cSwSwwwLiiii

,

只要求出矩阵S的逆矩阵即可。具体解法如下: 构造一个局部协方差矩阵iQS,其值为 )()(imiTijiijmxxxxQ 于是

1)()()()()()()()()(1112111212212111112111121kkikikikiiikiiiikiiiQQQQQQQQQSwwww

考虑到11kjijw,于是得

kpkqpqikmjmiijQQw11111

)()(

kkIrrIQQQiii是是正则化参数,此时必须正则化,可能是一个奇异矩阵,实际中,单位矩阵 (3)将所有样本点映射到低维空间中,映射条件满足 2

11)(minNikjijijiywyY

和避免数据集个近邻点,为了固定的是的输出向量是其中Ykykjyxyiijii),,2,1(,

在低维坍塌到坐标原点,满足两个限制条件:单位矩阵)。ddIyyNyNiTiiNii(1,011