数据挖掘实验1任务书

- 格式:docx

- 大小:229.21 KB

- 文档页数:4

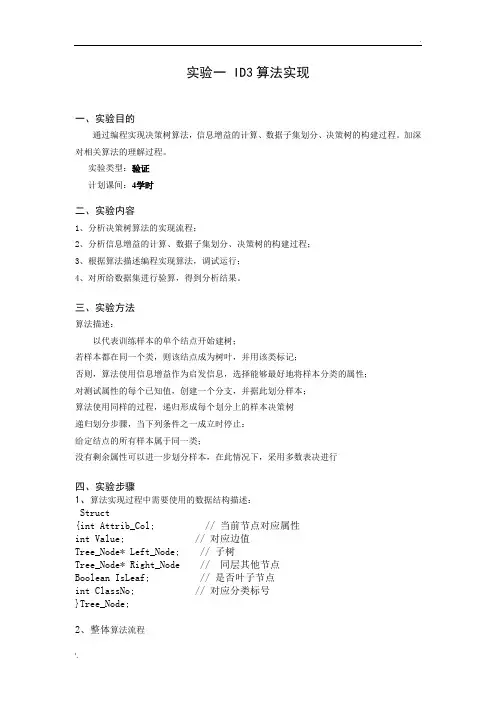

实验一 ID3算法实现一、实验目的通过编程实现决策树算法,信息增益的计算、数据子集划分、决策树的构建过程。

加深对相关算法的理解过程。

实验类型:验证计划课间:4学时二、实验内容1、分析决策树算法的实现流程;2、分析信息增益的计算、数据子集划分、决策树的构建过程;3、根据算法描述编程实现算法,调试运行;4、对所给数据集进行验算,得到分析结果。

三、实验方法算法描述:以代表训练样本的单个结点开始建树;若样本都在同一个类,则该结点成为树叶,并用该类标记;否则,算法使用信息增益作为启发信息,选择能够最好地将样本分类的属性;对测试属性的每个已知值,创建一个分支,并据此划分样本;算法使用同样的过程,递归形成每个划分上的样本决策树递归划分步骤,当下列条件之一成立时停止:给定结点的所有样本属于同一类;没有剩余属性可以进一步划分样本,在此情况下,采用多数表决进行四、实验步骤1、算法实现过程中需要使用的数据结构描述:Struct{int Attrib_Col; // 当前节点对应属性int Value; // 对应边值Tree_Node* Left_Node; // 子树Tree_Node* Right_Node // 同层其他节点Boolean IsLeaf; // 是否叶子节点int ClassNo; // 对应分类标号}Tree_Node;2、整体算法流程主程序:InputData();T=Build_ID3(Data,Record_No, Num_Attrib);OutputRule(T);释放内存;3、相关子函数:3.1、 InputData(){输入属性集大小Num_Attrib;输入样本数Num_Record;分配内存Data[Num_Record][Num_Attrib];输入样本数据Data[Num_Record][Num_Attrib];获取类别数C(从最后一列中得到);}3.2、Build_ID3(Data,Record_No, Num_Attrib){Int Class_Distribute[C];If (Record_No==0) { return Null }N=new tree_node();计算Data中各类的分布情况存入Class_Distribute Temp_Num_Attrib=0;For (i=0;i<Num_Attrib;i++)If (Data[0][i]>=0) Temp_Num_Attrib++;If Temp_Num_Attrib==0{N->ClassNo=最多的类;N->IsLeaf=TRUE;N->Left_Node=NULL;N->Right_Node=NULL;Return N;}If Class_Distribute中仅一类的分布大于0{N->ClassNo=该类;N->IsLeaf=TRUE;N->Left_Node=NULL;N->Right_Node=NULL;Return N;}InforGain=0;CurrentCol=-1;For i=0;i<Num_Attrib-1;i++){TempGain=Compute_InforGain(Data,Record_No,I,Num_Attrib); If (InforGain<TempGain){ InforGain=TempGain; CurrentCol=I;}}N->Attrib_Col=CurrentCol;//记录CurrentCol所对应的不同值放入DiferentValue[];I=0;Value_No=-1;While i<Record_No {Flag=false;For (k=0;k<Value_No;k++)if (DiferentValu[k]=Data[i][CurrentCol]) flag=true;if (flag==false){Value_No++;DiferentValue[Value_No]=Data[i][CurrentCol] } I++;}SubData=以Data大小申请内存空间;For (i=0;i<Value_No;i++){k=-1;for (j=0;j<Record_No-1;j++)if (Data[j][CurrentCol]==DiferentValu[i]){k=k++;For(int i1=0;i1<Num_Attrib;i1++)If (i1<>CurrentCol)SubData[k][i1]=Data[j][i1];Else SubData[k][i1]=-1;}N->Attrib_Col=CurrentCol;N->Value=DiferentValu[i];N->Isleaf=false;N->ClassNo=0;N->Left_Node=Build_ID3(SubData,k+1, Num_Attrib);N->Right_Node=new Tree_Node;N=N->Right_Node;}}3.3、计算信息增益Compute_InforGain(Data,Record_No, Col_No, Num_Attrib) {Int DifferentValue[MaxDifferentValue];Int Total_DifferentValue;Int s[ClassNo][MaxDifferentValue];s=0;// 数组清0;Total_DifferentValue=-1;For (i=0;i<Record_No;i++){J=GetPosition(DifferentValue,Total_DifferentValue,Data[i][Col_no]);If (j<0) {Total_DifferentValue++;DifferentValue[Total_DifferentValue]=Data[i][Col_no];J=Total_DifferentValue;}S[Data[i][Num_Attrib-1]][j]++;}Total_I=0;For (i=0;i<ClassNo;i++){Sum=0;For(j=0;j<Record_No;j++) if Data[j][Num_Attrib-1]==i sum++; Total_I=Compute_PI(Sum/Record_No);}EA=0;For (i=0;i<Total_DifferentValue;i++);{ temp=0;sj=0; //sj是数据子集中属于类j的样本个数;For (j=0;j<ClassNO;j++)sj+=s[j][i];For (j=0;j<ClassNO;j++)EA+=sj/Record_No*Compute_PI(s[j][i]/sj);}Return total_I-EA;}3.4、得到某数字在数组中的位置GetPosition(Data, DataSize,Value){For (i=0;i<DataSize;i++) if (Data[i]=value) return I;Return -1;}3.5、计算Pi*LogPiFloat Compute_PI(float pi){If pi<=0 then return 0;If pi>=1 then return 0;Return 0-pi*log2(pi);}五、实验报告要求1、用C语言实现上述相关算法(可选择利用matlab函数实现)2、实验操作步骤和实验结果,实验中出现的问题和解决方法。

《数据仓库与数据挖掘》实验指导书主编张磊审校2012-1-11目录实验报告模板 (1)实验一、SSIS教程1-3课 (3)实验二、SSAS教程1-3课 (5)实验三、数据挖掘教程 (10)实验报告模板见下页。

青岛大学实验报告年月日姓名系年级组别同组者科目题目仪器编号[注:下面空白处明确实验目的、内容和要求,简要概括实验过程,适量拷屏部分关键界面放到实验报告中,评价最终结果是否正确,记录实验过程遇到的问题及解决结果,简单总结心得体会。

必要时加页,每个实验报告1-3页篇幅为宜。

]实验一、SSIS教程1-3课实验目的:采用SQL Server 2005的Integration Service,熟悉ETL工具的功能和使用方法实验内容:结合教材的ETL知识,打开SQL Server 2005的SSIS教程,按教程步骤完成1-3课,4学时,其中第1课2学时,第2、3课2学时。

实验要求:每次实验课结束前5分钟关闭SQL Server Business Intelligence Development Studio和SQL Server Management Studio,将项目文件夹拷贝到U盘或压缩后发到自己邮箱保存起来,以便下次实验课可以继续往下做或最后上交。

每次实验课开始时先使用SQL Server Configuration Manager启动必需的SQL Server 服务。

按时完成实验内容,整理实验报告。

实验说明:注意SQL Server 2005与SQL Server 2000的差异,如“框架”,访问表时必须使用框架名来限定,如SalesOrders.Employee;注意因中文教程是由英文教程翻译而来,所以有些地方出现名称翻译不足(即软件界面上是中文而教程中是英文)或过翻译(即软件界面上是英文而教程中是中文),因为大家懂英文所以这点应该不成问题;注意因为我们安装的SQL Server不是采用默认实例名(而是DWDM),而教程中假设的是采用默认实例名,所以有些地方的配置受到影响,需要进行更改;注意解决方案、项目和项的区别:解决方案可以包含多个项目;每个项目包含一个或多个项;按下图打开SSIS教程,做的过程中,注意以下问题:(1)创建的项目放到一个方便找到的自定义文件夹中以便每次下课时可以拷贝带走(2)第1课的“添加和配置平面文件连接管理器”步骤中的“重新映射列数据类型”部分,将【但现在,请不要进行任何更改,单击“取消”返回“平面文件连接管理器编辑器”对话框的“高级”窗格,查看建议的列数据类型。

数据挖掘实验报告-实验1-W e k a基础操作学生实验报告学院:信息管理学院课程名称:数据挖掘教学班级: B01姓名:学号:实验报告课程名称数据挖掘教学班级B01 指导老师学号姓名行政班级实验项目实验一: Weka的基本操作组员名单独立完成实验类型■操作性实验□验证性实验□综合性实验实验地点H535 实验日期2016.09.281. 实验目的和要求:(1)Explorer界面的各项功能;注意不能与课件上的截图相同,可采用打开不同的数据文件以示区别。

(2)Weka的两种数据表格编辑文件方式下的功能介绍;①Explorer-Preprocess-edit,弹出Viewer对话框;②Weka GUI选择器窗口-Tools | ArffViewer,打开ARFF-Viewer窗口。

(3)ARFF文件组成。

2.实验过程(记录实验步骤、分析实验结果)2.1 Explorer界面的各项功能2.1.1 初始界面示意其中:explorer选项是数据挖掘梳理数据最常用界面,也是使用weka最简单的方法。

Experimenter:实验者选项,提供不同数值的比较,发现其中规律。

KnowledgeFlow:知识流,其中包含处理大型数据的方法,初学者应用较少。

Simple CLI :命令行窗口,有点像cmd 格式,非图形界面。

2.1.2 进入Explorer 界面功能介绍(1)任务面板Preprocess(数据预处理):选择和修改要处理的数据。

Classify(分类):训练和测试分类或回归模型。

Cluster(聚类):从数据中聚类。

聚类分析时用的较多。

Associate(关联分析):从数据中学习关联规则。

Select Attributes(选择属性):选择数据中最相关的属性。

Visualize(可视化):查看数据的二维散布图。

(2)常用按钮Openfile:打开文件Open URL:打开URL格式文件Open DB:打开数据库文件Generate:数据生成Undo:撤销操作Edit:编辑数据Save:保存数据文件,可实现文件格式的转换,比如csv 格式文件向ARFF格式文件转换等等。

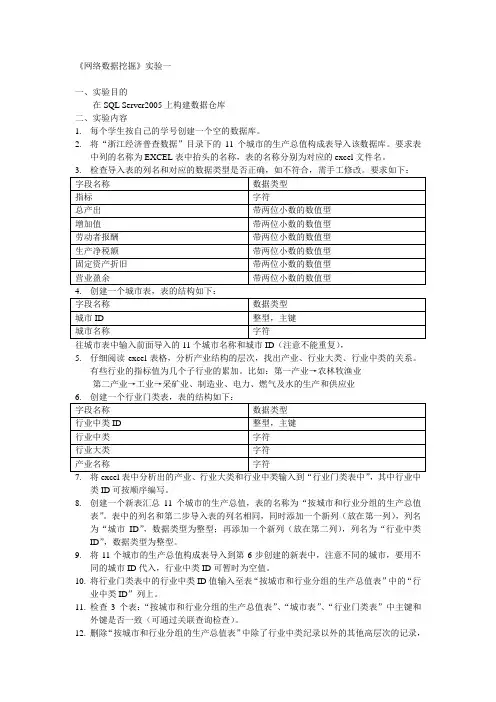

《网络数据挖掘》实验一一、实验目的在SQL Server2005上构建数据仓库二、实验内容1.每个学生按自己的学号创建一个空的数据库。

2.将“浙江经济普查数据”目录下的11个城市的生产总值构成表导入该数据库。

要求表中列的名称为EXCEL表中抬头的名称,表的名称分别为对应的excel文件名。

往城市表中输入前面导入的11个城市名称和城市ID(注意不能重复),5.仔细阅读excel表格,分析产业结构的层次,找出产业、行业大类、行业中类的关系。

有些行业的指标值为几个子行业的累加。

比如:第一产业→农林牧渔业第二产业→工业→采矿业、制造业、电力、燃气及水的生产和供应业类ID可按顺序编写。

8.创建一个新表汇总11个城市的生产总值,表的名称为“按城市和行业分组的生产总值表”。

表中的列名和第二步导入表的列名相同,同时添加一个新列(放在第一列),列名为“城市ID”,数据类型为整型;再添加一个新列(放在第二列),列名为“行业中类ID”,数据类型为整型。

9.将11个城市的生产总值构成表导入到第6步创建的新表中,注意不同的城市,要用不同的城市ID代入,行业中类ID可暂时为空值。

10.将行业门类表中的行业中类ID值输入至表“按城市和行业分组的生产总值表”中的“行业中类ID”列上。

11.检查3个表:“按城市和行业分组的生产总值表”、“城市表”、“行业门类表”中主键和外键是否一致(可通过关联查询检查)。

12.删除“按城市和行业分组的生产总值表”中除了行业中类纪录以外的其他高层次的记录,如指标为“第一产业”的行等等(如果不删除,将在汇总中出错)。

13.删除“按城市和行业分组的生产总值表”中原有的“指标”列(由于这列在行业门类表中已存在,因此是冗余的)。

14. 建立以下查询,和原EXCEL文件中的数据对比a)查询杭州市第二产业工业大类下各行业中类的总产出、增加值、劳动者报酬、营业盈余b)分别查询11个城市的第二产业总产出汇总值c)分别查询11个城市的工业劳动者报酬汇总值d)分别查询11个城市的第三产业增加值14.使用SSIS创建一个包,来完成第9步和第10步的过程,执行包,检查数据是否一致。

《数据挖掘课程设计》任务书课程名称:《数据挖掘课程设计》课程编码:JX030211课程类别:集中性实践教学环节学分数:1设计题目:手写数字的识别已知技术参数和设计要求:1. 问题描述(功能要求):本次课程设计的主要内容为:手写数字的识别。

该系统主要包括的基本功能有:1)图片格式的分析:了解bmp、jpg等图片文件格式内容;2)图片旋转:了解图片的旋转,如何实现手写体图片的最佳定位;3)特征选择:实现图片数据的特征提取功能;4)训练样本收集:实现对不同手写体图片的特征数据的采集过程;5)构建分类模型:利用训练数据进行训练,获得分类模型,并进行评价;应用:利用获得的模型对随机的手写数字图片进行识别。

2.界面要求:界面设计不做统一规定,但应做到界面友好,易于操作。

3. 技术要求:(1)完成图片的定位、旋转功能(2)完成特征选取功能(3)获取分类模型(4)进行实际应用。

(5)设计完成后,做好课程设计说明书,4. 课程设计报告要求文档规范正确、独立完成。

内容应包括:系统设计要求●需求分析●系统设计●编码●测试●总结●参考书目具体格式规定详见《长沙学院课程设计管理规定》。

5.成绩评定标准本次实训,考核标准共划分为5个等级:不及格、及格、中等、良好、优秀。

优秀标准:1、课堂积极认真,勤于动手、善于思考,并高质量完成阶段性任务。

2、软件设计合理。

3、软件功能上必须良好的实现业务规范中提出的各大功能,且界面友好,功能丰富饱满,软件正常运行,并开发规范。

4、答辩流畅、思路清晰。

5、文档撰写优良。

良好标准:1、课堂积极认真,勤于动手、善于思考,并基本完成阶段性任务。

2、软件设计合理。

3、软件功能上基本实现业务规范中提出的各大功能,软件正常运行,开发规范。

4、答辩顺利、思路清楚。

5、文档撰写良好。

中等标准:1、课堂积极认真,并基本完成阶段性任务。

2、软件设计合理。

3、软件功能上基本实现业务规范中提出的各大功能,软件允许出现少量缺陷,开发不甚规范。

实验一数据挖掘概念及Python初步(1)实验目的1.1上招聘网站,搜索“数据挖掘”、“数据仓库”,“Java软件工程师”,“C++软件工程师”,“会计”等关键词,了解招聘市场对该领域的技能要求。

1.2 阅读《集体智慧编程》第四章,了解“搜索引擎”构建的步骤与搜索结果的评价方法。

1.3 利用Wing IDE开发环境,调试并运行《集体智慧编程》第四章的程序。

(2)实验报告包括内容1.1数据挖掘——1.数学、统计学、计算机相关专业,本科及以上学历,两年以上互联网数据分析经验2.对数据驱动业务有深入理解,在数据与业务方面有很强的敏感度3.逻辑思维缜密,独立思考能力强,具有强烈的进取心4.掌握数据分析、挖掘方法,熟练使用SQL、Excel 等分析工具5.掌握下列脚本语言Python/R/PHP/Shell 之一6.熟悉基于MySQL/Oracle/Hadoop/Hive 平台的数据仓库数据仓库——职责:1.对业务数据进行分析、建模,为业务部门的数据化运营供技术支持2.设计合理的数据模型,支持对外的数据产品3.数据仓库平台、ETL流程设计、优化4.利用数据挖掘技术实现数据价值技能要求:1、有大型数据仓库或数据挖掘项目实施经验,熟悉数据仓库方法论和ETL构架,理解元数据管理2、至少熟悉一种数据库、熟悉Java、C/C++等语言之一3、熟悉linux平台,掌握Shell等脚本语言4、有分布式计算平台(Hadoop,Hive更佳)经验者优先5、性格积极乐观,诚信,有较强的语言表达能力Java软件工程师——岗位职责:1、负责项目中的JA V A编码工作;2、参与项目中JA V A开发部分程序的设计工作;3、制定作负责工作的工作计划,并按照计划执行;4、项目组其他人员所编写代码的检查、审核。

技能要求:1、本科或本科以上学历,计算机相关专业2、熟悉JSP/Servlet/EJB和JavaScript等WEB开发技术3、熟系Spring,Struts和Hibernate等主流的开发框架4、对Java面向对象软件结构有深入理解以及很强的应用能力5、熟系数据库oracle,mysql其中一种,拥有优秀的数据库设计能力6、熟练使用UNIX、LINUX,能进行shell编程7、了解TCPIP、HTTP等协议8、学习能力强,拥有优秀的逻辑思维能力,自我管理能力强,有良好的时间意识-有较好的沟通交流能力C++软件工程师——技能要求:1、熟悉C语言,或C++语言的开发流程2、性格开朗,有团队合作精神。

《数据挖掘与数据仓库》实验指导书2013年计算机学院计算应用实验1 Apriori算法实现一、实验目的1、掌握Apriori算法对于关联规则挖掘中频繁集的产生以及关联规则集合的产生过程;2、根据算法描述编程实现算法,调试运行。

并结合相关实验数据进行应用,得到分析结果。

数据和删除数据的操作。

实验类型:综合计划课间:2学时二、实验内容1、频繁项集的生成与Apriori算法实现;2、关联规则的生成过程与Rule-generate算法实现;3、结合样例对算法进行分析;三、实验步骤编写程序完成下列算法:1、Apriori算法输入:数据集D;最小支持数minsup_count;输出:频繁项目集LL1={large 1-itemsets}For (k=2; Lk-1≠Φ; k++)Ck=apriori-gen (Lk-1); // Ck是k个元素的候选集For all transactions t∈D dobegin Ct=subset(Ck,t); //Ct是所有t包含的候选集元素for all candidates c ∈Ct do c.count++;endLk={c ∈Ck| c.count ≧ minsup_count }EndL=∪Lk;2、apriori-gen (Lk-1) 候选集产生算法输入: (k-1)-频繁项目集Lk-1输出: k-频繁项目集CkFor all itemset p∈Lk-1 doFor all itemset q∈Lk-1 doIf p.item1=q.item1, p.item2=q.item2, …,p.itemk-2=q.itemk-2, p.itemk-1<q.itemk-1 thenbegin c=p∞qif has_infrequent_subset(c, Lk-1)then delete celse add c to CkEndReturn Ck3、has_infrequent_subset(c, Lk-1)功能:判断候选集的元素输入:一个k-频繁项目集Lk-1 ,(k-1)-频繁项目集Lk-1输出:c是否从候选集中删除的布尔判断For all (k-1)-subsets of c doIf Not(S∈Lk-1) THEN return TRUE;Return FALSE;4、Rule-generate(L,minconf)输入:频繁项目集;最小信任度输出:强关联规则算法:FOR each frequent itemset lk in Lgenerules(lk,lk);5、Genrules递归算法:Genrules(lk:frequent k-itemset, xm:frequent m-itemset)X={(m-1)-itemsets xm-1 | xm-1 in xm};For each xm-1 in XBEGIN conf=support(lk)/support(xm-1);IF (conf≧minconf) THENBEGIN输出规则:xm-1->(lk-xm-1),support,confidence;IF (m-1)>1) THEN genrules(lk,xm-1);END;END;结合相关样例数据对算法进行调试,并根据相关实验结果对数据进行分析,四、实验报告要求1、用C语言或者其他语言实现上述相关算法。

数据挖掘实验报告数据准备+关联规则挖掘+分类知识挖掘数据挖掘实验报告班级学号姓名课程数据挖掘实验名称实验⼀:数据准备实验类型实验⽬的:(1)掌握利⽤⽂本编辑软件⽣成ARFF⽂件的⽅法;(2)掌握将EXCEL表格⽂件转换为ARFF⽂件的⽅法;(3)掌握数据的预处理⽅法。

实验要求:(1)将下列表格中的数据利⽤⽂本编辑软件⽣成ARFF⽂件:姓名出⽣⽇期性别婚否⼯资职业信⽤等级黄⼤伟1970.05.08 男3580 教师优秀李明1964.11.03 男是4850 公务员优秀张明明1975.03.12 ⼥是职员优秀覃明勇1981.07.11 男是2980 职员良好黄燕玲1986.05.08 ⼥否2560 ⼯⼈⼀般表中没有填上的数据为缺失数据。

请列出你编辑ARFF⽂件并在WEKA中打开该⽂件。

(2)将EXCEL表格⽂件“bankdata.xls”转换为ARFF⽂件的⽅法,并将它另存为ARFF⽂件“bankdata.arff”, 在WEKA中打开该⽂件,写出操作过程。

(3)数值属性的离散化:在WEKA中打开ARFF⽂件“bankdata.arff”,对属性“age”和“income”分别按等宽分箱和等深分箱进⾏离散化为三个箱。

给出分箱的结果。

实验结果:(1) @relation book1@attribute 姓名{黄⼤伟,'李明',张明明,覃明勇,黄燕玲}@attribute 出⽣⽇期{1970.05.08,1964.11.03,1975.03.12,1981.07.11,1986.05.08}@attribute 性别{男,⼥}@attribute 婚否{是,否}@attribute ⼯资numeric@data黄⼤伟,1970.05.08,男,?,3580李',1964.11.03,男,是,4850张明明,1975.03.12,⼥,是,?覃明勇,1981.07.11,男,是,2980黄燕玲,1986.05.08,⼥,否,2560(2)先把bankdata.xls转化为CSV⽂件格式得到bankdata.csv,再在WEKA中打开,再另存为ARFF格式,就可以得到bankdata.arff。

数据仓库与数据挖掘实验指导书实验一数据仓库的建立一、实验目的理解数据库与数据仓库之间的区别与联系;掌握典型数据仓库系统的工作原理以及应用方法;掌握基于Analysis Service建立数据仓库和多维数据集的方法。

二、实验内容以Analysis Service为系统平台创建数据仓库,并创建多维数据集。

三、实验步骤1.启动Analysis Service2.建立系统数据源连接(1) “控制面板”,然后双击“管理工具”,再双击“数据源(ODBC)”。

(2) 在“系统DSN”选项卡上单击“添加”按钮。

(3) 选择“Microsoft Access 驱动程序(*.mdb)”,然后单击“完成”按钮。

(4) 在“数据源名”框中,输入“mySysDsn”,然后在“数据库”下,单击“选择”。

(5) 在“选择数据库”对话框中,浏览到“C:\Program Files\Microsoft Analysis Services\Samples”,然后单击“FoodMart 2000.mdb”。

单击“确定”按钮3.建立数据仓库⑪如何建立数据库结构①在Analysis Manager 树视图中展开“Analysis Servers”。

②单击服务器名称,即可建立与Analysis Servers 的连接。

③右击服务器名称,然后单击“新建数据库”命令。

④在“数据库”对话框中的“数据库名称”框中,输入“myWarehouse”,然后单击“确定”按钮。

⑤在Analysis Manager 树窗格中展开服务器,然后展开刚才创建的“myWarehouse”数据库。

⑫建立数据源在Analysis Manager 树窗格中,右击“myWarehouse”数据库下的“数据源”文件夹,然后单击“新数据源”命令。

在“数据链接属性”对话框中,单击“提供者”选项卡,然后单击“Microsoft OLE DB Provider for ODBC Drivers”。

《数据仓库与数据挖掘》课程实验报告一一、实验目的、内容、原理与环境1.实验目的:掌握在SQL Server 2005示例数据仓库环境下数据加载和建立多维数据模型过程的知识, 训练其把教材上的内容应用到实际中的技能, 为今后继续数据挖掘技术的学习奠定基础。

2.实验内容:在SQL Server 2005示例数据仓库环境下加载数据仓库, 建立多维数据模型。

具体内容包括:创建 Analysis Services 项目 , 定义数据源 , 定义数据源视图 , 修改表的默认名称, 定义多维数据集 , 检查多维数据集和维度属性 , 部署 Analysis Services 项目, 浏览已部署的多维数据集等知识。

3、实验原理与环境:数据仓库环境下数据加载过程和多维数据模型建立的方法。

SQL Server 2005示例数据仓库环境。

二、实验步骤(一)本实验的主要步骤(7步)分别介绍如下:(二)创建 Analysis Services 项目(二)创建数据源(三)定义数据源视图(四)定义多为数据源集(五)部署 Analysis Services 项目(六)浏览已部署的多维数据集(七)提高多维数据集的可用性和易用性三、实验总结通过数据仓库与数据挖掘的这门课的学习, 掌握了数据仓库与数据挖掘的一些基础知识和基本概念, 了解了数据仓库与数据库的区别。

下面谈谈我对数据仓库与数据挖掘学习心得以及阅读相关方面的论文的学习体会。

数据仓库是支持管理决策过程的、面向主题的、集成的、稳定的、不同时间的数据集合。

主题是数据数据归类的标准, 每个主题对应一个客观分析的领域, 他可为辅助决策集成多个部门不同系统的大量数据。

数据仓库包含了大量的历史数据, 经集成后进入数据仓库的数据极少更新的。

数据仓库内的数据时间一般为5年至10年, 主要用于进行时间趋势分析。

数据仓库的数据量很大。

数据仓库的特点如下:。

实验一、DTS的使用一、实验目的:1、了解MS SQL Server 2000的安装,熟悉MS SQL Server 2000数据库的使用环境2、理解数据库和数据仓库的关系,为数据仓库建立数据库3、熟练使用MS SQL Server 2000的DTS,能够将各种数据源的数据按照数据仓库设计的要求导入到数据仓库二、实验内容:1、熟悉MS SQL Server 2000数据库和表的基本操作。

2、为数据仓库建立新的数据库Mynorthwind。

3、使用DTS导入TXT文本文件到Mynorthwind。

4、使用DTS导入Access数据库到Mynorthwind。

5、使用DTS导入Excel文件到Mynorthwind。

6、使用DTS从Northwind导出Products和Categories两个表到Mynorthwind。

7、使用DTS查询导入,从Northwind导出Employees表到Mynorthwind,并将源表中first name和lastname列合成一个列fullname。

8、使用DTS的查询导入,从Northwind导出Orders表到Mynorthwind为Dates表,并将源表Orders表中OrderDate一列分成年、月、日、周、季五列,同时保留OrderDate一列。

9、使用DTS的查询导入,从Northwind导出Order Details表到Mynorthwind 为Facts表。

首先用Select语句将产品类别编号和员工编号等从各自表中取出,其次计算合计列值,计算方法为单价*(1-折扣)*数量,然后将Order Details表的内容复制到Facts表各列。

三、实验步骤:1、启动Microsoft SQL Server2000“服务管理器”,打开“企业管理器”,在出现的“SQL Server Enterprise Manager”窗口中,单击加号找到数据库,右键选择“新建数据库…”,打开对话框如图1.1所示,输入数据库名:Mynorthwind,点击确定完成创建。

湖南工程学院数据挖掘实验报告

图1

图2

数据的横向合并,将需要的2Excel个数据文件拖入数据编辑流窗口,在节点工具窗口中点击Record Ops选项卡中的Merge节点,并将其连接至Excel节点后面,右键点Edit选项。

点击Merge,将左边框的月份移动到右边框,然后点击Ok,将Table节点添加在Merge节点后,执行数据流,得到结果

图3

图4

4数据的缺失值替补:

将数据CCSS_Sample.sav拖入数据流编辑窗口,在后面添加个Table节点,执行数据,发现a3a_2数据有多个异常值,进行数据异常值的修改,将Table节点换成Data Audit 节点,执行数据流,在Quality中找到a3a_2数据,发现有多个异常值,在Impute Missing 中选取Blank&Null Value,选中这一个变量,点击Generate,Miss,,Values SuperNode,然后选择Selected fields only,回到数据流窗口,将出现的Missing Impute Value节点至于CCSS_Sample.sav节点后,最后添加个Table节点执行数据流,发现异常值消除。

图5。

数据仓库与数据挖掘实验报告书班级:姓名:学号:指导老师:一.数据的预处理1.1 数据的导入打开软件,在窗口中添加数据源,并进行编辑,在“文件”选项中找到需要添加的目录,录入数据源,即“信用卡交易-Data”数据文件,如图:1.2 抽样为了提高运行速度,减少数据记录数。

需要通过“抽样”节点抽取部分样本进行分析研究。

设定样本为随机抽取30%。

如图:1.3 过滤字段数据文件中有没有涉及到的一部分字段,所以应该在本次分析中把这部分字段过滤掉。

比如“都市化程度、退票、申请书来源、逾期”等。

设置如图所示:1.4 类型设置由于原始数据的类型全部为“连续型”,其中有一部分不符合数据实际特点,为了分析要求,并根据现实情况中数据取值特点,分别更改各个字段的类型,具体类型如图所示:1.5 汇总、重排字段通过汇总研究,求出个人月收入的平均值和标准差,个人月开销的平均值和标准差,月刷卡额的合计和平均值等等,如图:定制输出与学历的关系,排序字段首先显示。

将学历设为第一个字段,年龄平均值设为第二个字段,如图:1.6 数据的选择丢弃性别女,年龄大于20的数据,然后在突出显示性别男,年龄大于35的记录,设置如下图示执行后,弹出下图,显示记录皆为丢弃性别为女,年龄>20的记录之后的记录。

1.7 数据的抽样从数据中抽取一部分数据进行数据分析。

从第一条记录开始连续选取200条记录,如图:同时标注家庭月收入模拟少于6000元。

则下图表中,家庭月收入模拟这一栏红字数据全部是少于6000的记录。

1.8 汇总、选择、抽样数据预处理将整体数据进行了汇总,设置过程如下图所示:。

则显示的列表中有申请书来源、强制停卡记录、性别、个人月收入模拟等6个字段的记录记数。

二、各种图形分析2.1 散点图如图是信用卡交易中的性别与个人每月消费情况的分布情况。

X轴是性别,Y 轴是个人每月消费。

图中可看出男女的个人每月消费大体相等,其中大部分集中0-10000元/月和10000-20000元/月2.2 多重散点图如图是个人月收入、个人月开销、年龄模拟的多重散点图各个年龄段的信用卡交易使用的差异不大, 55岁以上信用卡消费相对来说比较少一些。

《数据挖掘》实验指导书2011年3月1日长沙学院信息与计算科学系前言随着数据库技术的发展,特别是数据仓库以及Web等新型数据源的日益普及,形成了数据丰富,知识缺乏的严重局面。

针对如何有效地利用这些海量的数据信息的挑战,数据挖掘技术应运而生,并显示出强大的生命力。

数据挖掘技术使数据处理技术进入了一个更高级的阶段,是对未来人类产生重大影响的十大新兴技术之一。

因此加强数据挖掘领域的理论与实践学习也已成为专业学生的必修内容。

本实验指导书通过大量的实例,循序渐进地引导学生做好各章的实验。

根据实验教学大纲,我们编排了五个实验,每个实验又分了五部分内容:实验目的、实验内容、实验步骤、实验报告要求、注意事项。

在实验之前,由教师对实验作一定的讲解后,让学生明确实验目的,并对实验作好预习工作。

在实验中,学生根据实验指导中的内容进行验证与总结,然后再去完成实验步骤中安排的任务。

实验完成后,学生按要求完成实验报告。

整个教学和实验中,我们强调学生切实培养动手实践能力,掌握数据挖掘的基本方法。

实验一 K-Means聚类算法实现一、实验目的通过分析K-Means聚类算法的聚类原理,利用Vc编程工具编程实现K-Means聚类算法,并通过对样本数据的聚类过程,加深对该聚类算法的理解与应用过程。

实验类型:验证计划课间:4学时二、实验内容1、分析K-Means聚类算法;2、分析距离计算方法;3、分析聚类的评价准则;4、编程完成K-Means聚类算法,并基于相关实验数据实现聚类过程;三、实验方法1、K-means聚类算法原理K-means聚类算法以k为参数,把n个对象分为k个簇,以使簇内的具有较高的相似度。

相似度的计算根据一个簇中对象的平均值来进行。

算法描述:输入:簇的数目k和包含n个对象的数据库输出:使平方误差准则最小的k个簇过程:任选k个对象作为初始的簇中心;Repeatfor j=1 to n DO根据簇中对象的平均值,将每个对象赋给最类似的簇for i=1 to k DO更新簇的平均值计算EUnitl E不再发生变化按簇输出相应的对象2、聚类评价准则:E的计算为:∑∑=∈-=ki Cx iix xE12| |四、实验步骤4.1 实验数据P192:154.2初始簇中心的选择选择k个样本作为簇中心For (i=0;i<k;i++)For (j=0;j<AttSetSize;j++)ClusterCenter[i][j]=DataBase[i][j]4.3 数据对象的重新分配Sim=某一较大数;ClusterNo=-1;For (i=0;i<k;i++)If (Distance(DataBase[j],ClusterCenter[i])<Sim){Sim=Distance(DataBase[j],ClusterCenter[i]);ClusterNo=i;}ObjectCluster[j]=ClusterNo;4.4 簇的更新For (i=0;i<k;i++){Temp=0;Num=0;For (j=0;j<n;j++)If (ObjectCluster[j]==i){Num++; Temp+=DataBase[j];}If (ClusterCenter[i]!=Temp) HasChanged=TRUE;ClusterCenter[i]=Temp;}4.5 结果的输出For (i=0;i<k;i++){Printf(“输出第%d个簇的对象:”,i);For (j=0;j<n;j++)If (ObjectCluster[j]==i) printf(“%d ”,j);Printf(“\n”);Printf(“\t\t\t 簇平均值为(%d,%d)\n”, ClusterCenter[i][0], ClusterCenter[i][1]);}五、注意事项1、距离函数的选择2、评价函数的计算实验二 DBSCAN算法实现一、实验目的要求掌握DBSCAN算法的聚类原理、了解DBSCAN算法的执行过程。

数据挖掘分析技术作业指导书第1章数据挖掘概述 (3)1.1 数据挖掘的基本概念 (3)1.2 数据挖掘的主要任务与过程 (3)1.3 数据挖掘的应用领域 (4)第2章数据预处理 (4)2.1 数据清洗 (4)2.1.1 缺失值处理 (4)2.1.2 异常值处理 (4)2.1.3 重复值处理 (4)2.2 数据集成 (4)2.2.1 数据集成方法 (4)2.2.2 数据集成策略 (5)2.2.3 数据集成质量控制 (5)2.3 数据变换 (5)2.3.1 数据规范化 (5)2.3.2 属性构造 (5)2.3.3 数据离散化 (5)2.4 数据归一化与离散化 (5)2.4.1 数据归一化 (5)2.4.2 数据离散化 (5)2.4.3 离散化方法 (5)2.4.4 离散化策略 (5)第3章数据仓库与联机分析处理 (5)3.1 数据仓库的基本概念 (5)3.1.1 定义与特点 (6)3.1.2 数据仓库架构 (6)3.1.3 数据仓库与操作型数据库的区别 (6)3.2 数据仓库的构建与维护 (6)3.2.1 数据仓库构建策略 (6)3.2.2 数据抽取与转换 (6)3.2.3 数据仓库维护 (6)3.3 联机分析处理技术 (6)3.3.1 基本概念与分类 (7)3.3.2 OLAP操作 (7)3.3.3 OLAP关键特性 (7)3.4 数据立方体的构建与应用 (7)3.4.1 数据立方体的构建 (7)3.4.2 数据立方体的应用 (7)3.4.3 数据立方体的优化 (7)第4章关联规则挖掘 (7)4.1 关联规则的基本概念 (7)4.2 Apriori算法 (8)4.3 FPgrowth算法 (8)4.4 关联规则挖掘的应用 (8)第5章分类与预测 (8)5.1 分类的基本概念 (8)5.2 决策树算法 (9)5.3 朴素贝叶斯算法 (9)5.4 支持向量机算法 (9)第6章聚类分析 (10)6.1 聚类的基本概念 (10)6.2 Kmeans算法 (10)6.3 层次聚类算法 (10)6.4 密度聚类算法 (11)第7章时间序列分析与预测 (11)7.1 时间序列的基本概念 (11)7.2 时间序列的预处理 (11)7.3 时间序列预测方法 (11)7.4 时间序列模型的选择与应用 (12)第8章异常检测与空间数据挖掘 (12)8.1 异常检测的基本概念 (12)8.2 基于距离的异常检测方法 (12)8.3 基于密度的异常检测方法 (13)8.4 空间数据挖掘及其应用 (13)第9章文本挖掘与情感分析 (13)9.1 文本挖掘的基本概念 (13)9.2 文本预处理技术 (13)9.3 文本分类与聚类 (14)9.4 情感分析与观点挖掘 (14)第10章数据挖掘项目实施与评估 (14)10.1 数据挖掘项目实施流程 (14)10.1.1 项目启动 (14)10.1.2 数据准备 (15)10.1.3 数据挖掘建模 (15)10.1.4 模型评估与优化 (15)10.1.5 模型部署与应用 (15)10.2 数据挖掘模型的评估与优化 (15)10.2.1 模型评估指标 (15)10.2.2 模型优化策略 (15)10.2.3 模型调参技巧 (15)10.3 数据挖掘项目的管理与风险控制 (15)10.3.1 项目管理 (15)10.3.2 风险识别与评估 (15)10.3.3 风险应对措施 (15)10.3.4 项目沟通与协作 (16)10.4 数据挖掘成果的应用与推广 (16)10.4.1 成果应用 (16)10.4.2 成果推广 (16)10.4.3 持续优化 (16)第1章数据挖掘概述1.1 数据挖掘的基本概念数据挖掘(Data Mining),又称知识发觉,是指从大量数据中通过算法和统计分析方法,挖掘出潜在的、有价值的信息和知识的过程。

数据预处理一、实验原理预处理方法基本方法1、数据清洗去掉噪声和无关数据2、数据集成将多个数据源中的数据结合起来存放在一个一致的数据存储中3、数据变换把原始数据转换成为适合数据挖掘的形式4、数据归约主要方法包括: 数据立方体聚集,维归约,数据压缩,数值归约,离散化和概念分层等二、实验目的掌握数据预处理的基本方法。

三、实验内容1、R语言初步认识(掌握R程序运行环境)2、实验数据预处理。

(掌握R语言中数据预处理的使用)对给定的测试用例数据集,进行以下操作。

1)、加载程序,熟悉各按钮的功能。

2)、熟悉各函数的功能,运行程序,并对程序进行分析。

对餐饮销量数据进统计量分析,求销量数据均值、中位数、极差、标准差,变异系数和四分位数间距。

对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。

3)数据预处理缺省值的处理:用均值替换、回归查补和多重查补对缺省值进行处理对连续属性离散化:用等频、等宽等方法对数据进行离散化处理四、实验步骤1、R语言运行环境的安装配置和简单使用(1)安装R语言R语言下载安装包,然后进行默认安装,然后安装RStudio 工具(2)R语言控制台的使用1.2.1查看帮助文档1.2.2 安装软件包1.2.3 进行简单的数据操作(3)RStudio 简单使用1.3.1 RStudio 中进行简单的数据处理1.3.2 RStudio 中进行简单的数据处理2、R语言中数据预处理(1)加载程序,熟悉各按钮的功能。

(2)熟悉各函数的功能,运行程序,并对程序进行分析2.2.1 销量中位数、极差、标准差,变异系数和四分位数间距。

, 2.2.2对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。

(3)数据预处理缺省值的处理:用均值替换、回归查补和多重查补对缺省值进行处理对连续属性离散化:用等频、等宽等方法对数据进行离散化处理五、实验结果按照实验步骤对餐饮销量数据进统计量分析,求出了销量数据均值、中位数、极差、标准差,变异系数和四分位数间距,并在上述报告中用表格显示出来;得到了餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析);最后进行数据预处理。

数据挖掘算法模型实验指导书目录实验一决策树和随机森林实验 (2)实验二逻辑回归分类实验 (8)实验三朴素贝叶斯分类器实验 (15)实验四svm分类器实验 (22)实验五K-means聚类实验 (29)实验六高斯混合模型实验 (35)实验七python线性回归实验 (40)实验八协同过滤实验 (51)实验九关联分析实验 (58)实验十TF-IDF实验 (63)实验十一BP神经网络实验 (68)实验十二LSTM神经网络实验 (77)实验一决策树和随机森林实验【实验名称】决策树和随机森林实验【实验目的】掌握决策树和随机森林实验模型应用过程,根据模型要求进行数据预处理,建模,评价与应用;【背景描述】决策树与随机森林,属于监督学习,通过纯化指标的计算,确定分支方式,逐步构建成树形结构。

决策树由节点(node)和有向边(directed edge)组成。

节点的类型有两种:内部节点和叶子节点。

其中,内部节点表示一个特征或属性的测试条件(用于分开具有不同特性的记录),叶子节点表示一个分类。

随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。

在得到森林之后,当有一个新的输入样本进入的时候,就让森林中的每一棵决策树分别进行一下判断,看看这个样本应该属于哪一类(对于分类算法),然后看看哪一类被选择最多,就预测这个样本为那一类。

【知识准备】了解决策树与随机森林模型的使用场景,数据标准。

了解Python/Spark数据处理一般方法。

了解spark模型调用,训练以及应用方法【实验要求】完成决策树和随机森林实验【实验设备】Windows或Linux操作系统的计算机。

部署Spark,Python,本实验提供centos6.8环境。

【实验说明】采用UCI机器学习库中的wine数据集作为算法数据,训练决策树与随机森林模型,对样本进行聚类。

【实验环境】Spark 2.3.1,Pyrhon3.X,实验在命令行pyspark中进行,或者把代码写在py脚本,由于本次为实验,以学习模型为主,所以在命令行中逐步执行代码,以便更加清晰地了解整个建模流程。

数据仓库与数据挖掘实验一任务书

多维数据集的建立以及数据的加载

一、目的和要求

(1)建立关系数据库,为多维数据集的建立做好准备。

(2)在没有数据源的情况下,创建一个多维数据集,熟悉多维数据集建立的过程。

(3)为创建的多维数据集添加数据源,并向关系架构加载数据。

二、实验内容

一)建立关系数据库

1.建立数据库my sales

数据库表如下

订单信息:订单号,订单日期,订单金额,商品号,单价,数量,客户号,员工号,付款状态

客户信息表:客户号,姓名,家庭地址,性别,联系电话,年龄,生日,文化程度商品信息表:商品号,商品名称,类别编号,大小范围,大小,颜色范围,颜色,照片,吊牌价,标准成本,开始销售日期,重量,销售状态

类别信息表:类别编号,类别名称,描述,小类别编号

小类别信息表:小类别编号,小类别名称,描述,大类别编号

大类别信息表:大类别编号,大类别名称,描述

2.建立外键关系,新建数据库关系图

3.输入数据库数据

二)根据分析需求收集数据源导入数据仓库并进行抽取,转换,集成。

1)打开Microsoft SQL Server Management Studio,创建一个新的数据库sales_DW.

2)右击数据源my sales,选择单击任务—导出数据,出现导出界面,单击“下一步”按钮,“选择数据源”页自动填入创建到my sales 的连接的数据源、服务器和数据库,单击“下一步”。

3)在“选择目标”页,从数据库下拉列表框中选择sales_DW.

4)在“指定表复制和查询”页可以选择“复制一个或多个表或视图的数据”,页可以选择“编写查询以指定要传输的数据”,如果选择后者,可以在下一步出现的对话框中输入“select……………from [数据表]”语句实现数据的抽取。

也可以选择前者,出现如下的对话框,根据任务选择要复制的数据表。

5) 两次单击“下一步”,完成源数据的复制以及初步抽取。

6)为了使多维数据集在分析时能够分析事实的时间维度,可以在sales_DW中添加一个时间表,其中有“订单时间”,“年”,“月”“日”等属性,以“订单时间”为主键。

7)由于对于钻取任务而言,一些属性例如商品信息表中的“标准成本”“重量”是不需要的,所以可以删除。

如果在复制数据源时在“指定表复制和查询”页选择“编写查询以指定要传输的数据”,则可以在复制初期就完成表中属性的选择。

8)建立关系数据库中的各表的关系,建立sales_DW的数据库关系图。

三)创建新项目,生成新的多维数据集

1.设置数据源

1)打开BIDS,单击“文件”—“新建”—“项目”,创建新项目,自取项目名。

2)创建新项目之后,在“解决方案资源管理器”窗口找到新建的项目,右击新建项目下的数据源,选择“新建数据源”命令,打开“数据源向导”对话框。

3)在“数据源向导”对话框“数据连接”列表中选择刚创建好的数据源“sales_DW”,接着单击“下一步”按钮,进入“模拟信息”界面。

选择“默认值”,单击下一步,进入完成向导界面,单击“完成”按钮,数据源就设置好了。

2.设置数据源视图

1)在“解决方案资源管理器”窗口,在新建的项目下,右击数据源视图文件夹,接着在弹出的快捷菜单中选择“新建数据源视图菜单”命令,打开“数据源视图向导”对话框,如下图所示:

2)单击“下一步”按钮,进入“选择表和视图”界面,使用“>”按钮可将可用对象列表框中表移动到“包含的对象”列表中,单击下一步,进入“完成向导”界面,可更改数据源视图名称,单击“完成”按钮,完成创建数据源视图的工作,双击新建的数据源视图,观察数据源视图窗口变化。

3.创建多维数据集

1)在“解决方案资源管理器”窗口,在新建的项目下,右击多维数据集文件夹,接着从弹出的快捷菜单中选择“新建多维数据集”命令,进入“多维数据集向导”界面,单击“下一步”按钮。

2)出现“选择生成方法”界面,选中“使用数据源生成多维数据集”单选按钮,并取消选中“自动生成”复选框。

3)单击下一步,进入“选择数据源视图”界面,选中刚建好的数据源视图,单击“下一步”,进入“标识事实数据表和维度表”界面,选择事实和维度,接着单击“下一步”按钮进入“选择度量值”界面,选择默认,单击下一步,进入查看“新建维度”界面。

4)接受默认值,单击“下一步”按钮,进入“完成向导”界面。

5)输入多维数据集名称,单击“完成”按钮,向导创建这个多维数据集以及其中包含的维度。

此时,设计器中会显示多维数据集的数据视图和结构,观察视图和结构。

4.为维度创建层次结构

1)双击需要创建层次的维度,界面就会出现一个维度窗口,单击“层次结构”标签。

2)展开维度节点,以时间维度为例,并单击“编辑时间”按钮,此时设计器窗口会显示“维度结构”选项卡。

3}将“年”,“月”,“日”属性拖拽到“层次结构和级别”列表中的“层次结构”组下。

那么时间维度层次就创建完成了。