第6章 逻辑斯蒂回归模型

- 格式:ppt

- 大小:1.03 MB

- 文档页数:28

多项逻辑斯蒂回归模型多项逻辑斯蒂回归模型(Multinomial Logistic Regression Model)是一种分类模型,用于将多个类别分别分配给一组预测变量。

它是逻辑斯蒂回归模型的进化,适用于分类问题中有多个可能的输出类别的情况。

在这个模型中,每个类别的概率是根据预测变量的线性组合计算的。

多项逻辑斯蒂回归采用类似于二项逻辑斯蒂回归(Logistic Regression)的思路来实现对于多个类别的分类,主要通过多个决策边界来实现类别的划分。

假设多项逻辑斯蒂回归模型有k个类别,对于第j个类别,其概率为:P(Y = j|X) = e^(β_j*X)/(∑_i=1^k e^(β_i*X))其中,β_j是与第j个类别关联的系数,X是特征矩阵,Y是响应变量。

通过这个公式可以得出每个类别的概率,然后根据概率大小判断属于哪一个类别。

多项逻辑斯蒂回归模型经常用于文本分类、医疗诊断、人脸识别等领域。

文本分类是多项逻辑斯蒂回归模型的一个应用场景。

在文本分类中,每个文本可以被分配到多个类别中的一个或多个,因此需要使用多项逻辑斯蒂回归模型对文本进行分类。

在医疗诊断中,多项逻辑斯蒂回归模型可以用于根据多项指标来预测一种疾病的可能性。

模型可以用于心脏病、癌症和糖尿病等疾病的诊断。

在人脸识别中,多项逻辑斯蒂回归模型可以用于将人脸分配到不同的类别中,例如年龄、性别、种族等。

需要注意的是,多项逻辑斯蒂回归模型的特征矩阵中一般需要进行独热编码(One-Hot Encoding),目的是为了将离散型变量映射成一个向量,从而在模型中进行计算。

同时,在多项逻辑斯蒂回归模型中,也需要进行特征选择和模型评估。

总之,多项逻辑斯蒂回归模型是一种用于多分类问题的回归模型,具有很好的解释性和灵活性,在许多领域都有广泛的应用。

逻辑斯蒂(logistic)回归深⼊理解、阐述与实现第⼀节中说了,logistic 回归和线性回归的区别是:线性回归是根据样本X各个维度的Xi的线性叠加(线性叠加的权重系数wi就是模型的参数)来得到预测值的Y,然后最⼩化所有的样本预测值Y与真实值y'的误差来求得模型参数。

我们看到这⾥的模型的值Y是样本X各个维度的Xi的线性叠加,是线性的。

Y=WX (假设W>0),Y的⼤⼩是随着X各个维度的叠加和的⼤⼩线性增加的,如图(x为了⽅便取1维):然后再来看看我们这⾥的logistic 回归模型,模型公式是:,这⾥假设W>0,Y与X各维度叠加和(这⾥都是线性叠加W)的图形关系,如图(x为了⽅便取1维):我们看到Y的值⼤⼩不是随X叠加和的⼤⼩线性的变化了,⽽是⼀种平滑的变化,这种变化在x的叠加和为0附近的时候变化的很快,⽽在很⼤很⼤或很⼩很⼩的时候,X叠加和再⼤或再⼩,Y值的变化⼏乎就已经很⼩了。

当X各维度叠加和取⽆穷⼤的时候,Y趋近于1,当X各维度叠加和取⽆穷⼩的时候,Y趋近于0.这种变量与因变量的变化形式就叫做logistic变化。

(注意不是说X各个维度和为⽆穷⼤的时候,Y值就趋近1,这是在基于W>0的基础上,(如果W<0,n那么Y趋近于0)⽽W是根据样本训练出来,可能是⼤于0,也可能是⼩0,还可能W1>0,W2<0…所以这个w值是样本⾃动训练出来的,也因此不是说你只要x1,x2,x3…各个维度都很⼤,那么Y值就趋近于1,这是错误的。

凭直觉想⼀下也不对,因为你连样本都还没训练,你的模型就有⼀个特点:X很⼤的时候Y就很⼤。

这种强假设肯定是不对的。

因为可能样本的特点是X很⼤的时候Y就很⼩。

)所以我们看到,在logistic回归中,X各维度叠加和(或X各维度)与Y不是线性关系,⽽是logistic关系。

⽽在线性回归中,X各维度叠加和就是Y,也就是Y与X就是线性的了。

混合效应逻辑斯蒂回归模型的原理及其应用

混合效应逻辑斯蒂回归模型是一种广义线性模型,它可以用于建立二分类或多分类的

预测模型。

与传统的逻辑斯蒂回归模型不同,混合效应逻辑斯蒂回归模型考虑了被观察单

位之间的相关性,采用了混合效应的方法来消除这种相关性的影响,从而提高了模型的准

确性和稳定性。

混合效应逻辑斯蒂回归模型的原理是将线性预测函数扩展到包含固定效应和随机效应。

固定效应是指在样本中所有观测量之间共享的影响因素,如环境、训练、学历等;而随机

效应是指在样本中不同个体之间的特定影响因素,如体重、年龄、性别等。

这种方法可以

将不同个体之间的差异归因于随机效应,从而提高模型的准确性。

混合效应逻辑斯蒂回归模型的应用非常广泛,尤其是在医学、社会科学、教育和生态

学领域。

例如,在医学领域,混合效应逻辑斯蒂回归模型可以用于评估不同药物的疗效,

发现与健康相关的因素,或预测病人的死亡率。

在社会科学领域,混合效应逻辑斯蒂回归

模型可以用于预测贫困、失业或犯罪率等社会问题。

在教育领域,混合效应逻辑斯蒂回归

模型可以用于评估教学质量、课程难度和学生表现等方面。

总之,混合效应逻辑斯蒂回归模型是一种有效的建模方法,它可以用于处理具有相关

性的数据,并且可以应用于许多领域。

随着数据科学的快速发展,混合效应逻辑斯蒂回归

模型将在未来继续发挥重要作用。

逻辑斯蒂回归参数估计

逻辑斯蒂回归(Logistic Regression)是一种常见的分类模型,它使用一个逻辑函数对输入特征进行建模并预测输出类别。

在给定训练数据和标签的情况下,我们可以通过最大似然估计方法来估计逻辑斯蒂回归模型的参数。

假设我们有一个二分类问题,输入特征为 x,标签为 y,逻辑斯蒂回归模型可以表示为:

h(x) = P(y=1|x) = 1 / (1 + exp(-wx))

h(x) 是通过逻辑函数(sigmoid函数)将输入特征与权重参数 w 结合后的预测结果。

我们的目标是通过最大似然估计方法来估计参数 w。

为了方便计算,我们引入对数似然函数:

L(w) = sum(y*log(h(x)) + (1-y)*(1-log(h(x))))

接下来,我们可以使用梯度下降算法来最大化对数似然函数,从而估计出参数 w。

梯度下降算法的更新规则如下:

w := w + alpha * sum((y - h(x)) * x)

alpha 是学习率,用于控制更新的步长。

通过重复执行上述更新规则,直到满足终止条件(如达到最大迭代次数或参数收敛),我们就可以得到逻辑斯蒂回归模型的参数估计值 w。

需要注意的是,在进行参数估计时,我们需要对输入特征进行适当的预处理(如标准化、归一化等),以确保模型的准确性和稳定性。

以上便是逻辑斯蒂回归参数估计的基本原理和方法,希望对您有所帮助。

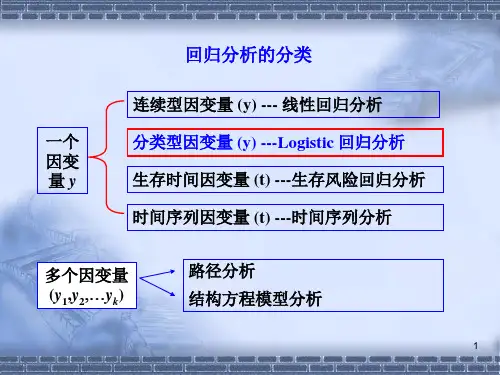

Logistic 回归模型1 Logistic 回归模型的基本知识 1.1 Logistic 模型简介主要应用在研究某些现象发生的概率p ,比如股票涨还是跌,公司成功或失败的概率,以及讨论概率p 与那些因素有关。

显然作为概率值,一定有10≤≤p ,因此很难用线性模型描述概率p 与自变量的关系,另外如果p 接近两个极端值,此时一般方法难以较好地反映p 的微小变化。

为此在构建p 与自变量关系的模型时,变换一下思路,不直接研究p ,而是研究p 的一个严格单调函数)(p G ,并要求)(p G 在p 接近两端值时对其微小变化很敏感。

于是Logit 变换被提出来:ppp Logit -=1ln)( (1)其中当p 从10→时,)(p Logit 从+∞→∞-,这个变化范围在模型数据处理上带来很大的方便,解决了上述面临的难题。

另外从函数的变形可得如下等价的公式:XT XT T ee p Xppp Logit βββ+=⇒=-=11ln )( (2)模型(2)的基本要求是,因变量(y )是个二元变量,仅取0或1两个值,而因变量取1的概率)|1(X y P =就是模型要研究的对象。

而Tk x x x X ),,,,1(21 =,其中i x 表示影响y 的第i 个因素,它可以是定性变量也可以是定量变量,Tk ),,,(10ββββ =。

为此模型(2)可以表述成:kx k x k x k x kk eep x x pp βββββββββ+++++++=⇒+++=- 11011011011ln (3)显然p y E =)(,故上述模型表明)(1)(lny E y E -是k x x x ,,,21 的线性函数。

此时我们称满足上面条件的回归方程为Logistic 线性回归。

Logistic 线性回归的主要问题是不能用普通的回归方式来分析模型,一方面离散变量的误差形式服从伯努利分布而非正态分布,即没有正态性假设前提;二是二值变量方差不是常数,有异方差性。

Logistic 回归模型一、 分组数据的Logistic 回归模型针对0-1型因变量产生的问题,我们对回归模型应该作两个方面的改进。

第一, 回归函数应该用限制在[0,1]区间内的连续曲线,而不能再沿用沿用直线回归方程。

限制在[0,1]区间内的连续曲线很多,例如所有连续变量的分布函数都符合要求,我们常用的是Logistic 函数与正如分布函数,Logistic 函数的形式为:()1xxe f x e =+Logistic 函数的中文名称逻辑斯蒂函数,简称逻辑函数 第二、因变量y 本身只取0、1两个离散值,不适合直接作为回归模型中的因变量,由于回归函数01()i i i E y x πββ==+表示在自变量为i x 的条件下i y 的平均值,而i y 是0-1型随机变量,因而()i i E y π=就是在自变量为i x 的条件下i y 等于1的比例.这就提示我们可以用i y 等于1的比例代替i y 本身作为因变量.二,例子 在一次住房展销会上,与房地产商签订初步购房意向书的共有325n =名顾客,在随后的3个月的时间内,只有一部分顾客确实购买了房屋.购买了房屋的顾客记为1,没有购买房屋的顾客记为0,以顾客的年家庭收入为自变量x,对下面表所示的数据,序号年家庭收入(万元)x 签订意向书人数n 实际购房人数m 实际购房比例p逻辑变换p′=ln(p/(1-p))权重w=np(1-p)1 1.52580.32-0.7537718 5.442 2.532130.40625-0.37948967.718753 3.558260.448276-0.207639414.344834 4.552220.423077-0.310154912.692315 5.543200.465116-0.139761910.697676 6.539220.5641030.257829119.58974477.528160.5714290.287682076.85714388.521120.5714290.287682075.14285799.515100.6666670.693147183.333333建立Logistic 回归模型:c i x x p i i i,,2,1,)exp(1)exp(1010 =+++=ββββ,其中,c 为分组数据的组数,本例中c=9.将以上回归方程作线性变换,令)1ln(iii p p p -=' 该变换称为逻辑变换,变换后的线性回归模型为 i i i x p εββ++='10该式是一个普通的一元线性回归模型。

逻辑回归模型逻辑回归模型是针对线性可分问题的⼀种易于实现⽽且性能优异的分类模型。

它假设数据服从伯努利分布,通过极⼤化似然函数的⽅法,运⽤梯度下降法来求解参数,来达到将数据⼆分类的⽬的。

算法推导引⼊⼏率⽐(odds):指⼀个事件发⽣的概率与不发⽣概率的⽐值。

对其求log,可得:logit(p) = \log{\frac{p}{1-p}}将对数⼏率记为输⼊特征值的线性表达式,可得logit(P(Y=1|X)) = w^Tx对于某⼀样本属于特定类别的概率,为logit函数的反函数,称为logistic函数,即sigmoid函数:\phi(x) = \frac{1}{1+e^{-z}}逻辑斯蒂回归采⽤sigmoid函数作为激励函数逻辑斯蒂回归模型定义:P(Y=1|X) = h_\theta(x)P(Y=0|X) = 1- h_\theta(x)可知,输出Y=1的对数⼏率是输⼊x的线性函数。

对于给定的训练数据集T,可以应⽤极⼤似然估计法估计模型参数,假设模型概率分布是:P(Y=1|X) =h_\theta(x)P(Y=0|X) = 1-h_\theta(x)似然函数为:\prod_{i=1}^N{[h_\theta(x_i)]^{y_i}[1-h_\theta(x_i)]^{1-y_i}}对数似然函数为:l(\theta)=\sum_{i=1}^N{[y_i\log{h_\theta(x_i)}+(1-y_i)\log{(1-h_\theta(x_i))}]}公式推导我们使⽤梯度下降的思想来求解此问题,变换的表达式如下:J(\theta)=-\frac{1}{m} l(\theta)因为我们要使⽤当前的\theta值通过更新得到新的\theta值,所以我们需要知道\theta更新的⽅向(即当前\theta是加上⼀个数还是减去⼀个数离最终结果近),所以得到J(\theta)后对其求导便可得到更新⽅向,求导过程如下:\frac{\partial J(\theta)} {\partial \theta_j} = -\frac{1}{m} \sum_{i=1}^m[(\frac{y_i}{h_\theta(x_i)}-\frac{1-y_i}{1-h_\theta(x_i)})*\frac{\partialh_\theta(x_i)}{\partial \theta_j}] \\ = -\frac{1}{m} \sum_{i=1}^m[(\frac{y_i}{h_\theta(x_i)}-\frac{1-y_i}{1-h_\theta(x_i)})*h_\theta(x_i)*(1-h_\theta(x_i))*x_i^j] \\ =\frac{1}{m} \sum_{i=1}^m (h_\theta(x_i)-y_i)x_i^j得到更新⽅向后便可使⽤下⾯的式⼦不断迭代更新得到最终结果:\theta_j:= \theta_j-\alpha \frac{1}{m}\sum_{i=1}^m (h_\theta(x_i)-y_i)x_i^j优缺点逻辑斯蒂回归模型的优点有:形式简单,模型的可解释性⾮常好。

逻辑斯蒂回归模型计算物种分布全文共四篇示例,供读者参考第一篇示例:逻辑斯蒂回归是一种常用的统计分析方法,常用于二分类问题的预测。

不仅在社会科学领域得到广泛应用,在生态学领域也被用来预测物种分布状况。

物种分布是指某一种生物在地理空间上的分布范围,了解物种分布对于保护生物多样性、生态环境恢复和管理资源具有重要意义。

逻辑斯蒂回归模型通过将自变量和因变量之间的关系建模为对数几率函数,来预测某一事件发生的概率。

在生态学中,研究者通常使用物种分布数据和环境因子数据来建立逻辑斯蒂回归模型,以预测某一物种在不同环境条件下的分布范围。

在构建逻辑斯蒂回归模型时,首先需要收集相关的环境因子数据,这些环境因子数据通常包括气候数据、土壤数据、地形数据等。

然后,将这些环境因子数据与物种分布数据进行关联分析,找出对物种分布有显著影响的环境因子。

接着,利用逻辑斯蒂回归模型来建立环境因子与物种分布之间的关系,从而预测物种在其他地理位置的分布情况。

逻辑斯蒂回归模型的预测能力取决于模型的质量和环境因子的选择。

在构建逻辑斯蒂回归模型时,需要注意以下几点:要选择合适的环境因子。

环境因子对物种分布的影响是复杂多样的,因此需要根据研究的具体问题选择合适的环境因子进行建模。

常用的环境因子包括气候因子、土壤因子、地形因子等。

选择环境因子的过程中,可以借助专业知识和统计分析方法进行辅助。

要注意环境因子之间的多重共线性。

环境因子之间可能存在相关性,如果存在严重的多重共线性问题,会影响逻辑斯蒂回归模型的稳定性和预测能力。

在建立模型时,需要对环境因子进行多重共线性检验,并对相关性较高的环境因子进行适当的处理。

还要考虑采样偏差和数据不平衡的问题。

在采集物种分布数据和环境因子数据时,可能存在采样偏差和数据不平衡的情况,这会影响逻辑斯蒂回归模型的建立和预测效果。

在进行数据的分析和建模时,需要针对采样偏差和数据不平衡问题进行修正,以提高模型的准确性和可靠性。

逻辑斯蒂回归模型在物种分布预测中的应用具有广泛的意义。

逻辑斯谛模型

逻辑斯蒂增长模型(Logistic growth model)逻辑斯蒂增长模型又称自我抑制性方程。

用植物群体中发病的普遍率或严重度表示病害数量(x),将环境最大容纳量k定为1(100%),逻辑斯蒂模型的微分式是:dx/dt=rx(1-x)式中的r为速率参数,来源于实际调查时观察到的症状明显的病害。

普朗克(1963)将r称作表观侵染速率(apparent infection rate),该方程与指数模型的主要不同之处,是方程的右边增加了(1-x)修正因子,使模型包含自我抑制作用。

逻辑斯蒂模型,又叫阻滞增长模型

逻辑斯蒂曲线通常分为5个时期:

1.开始期,由于种群个体数很少,密度增长缓慢,又称潜伏期。

2.加速期,随个体数增加,密度增长加快。

3.转折期,当个体数达到饱和密度一半(K/2)后,密度增长最快。

4.减速期,个体数超过密度一半(K/2)后,增长变慢。

5.饱和期,种群个体数达到K值而饱和。