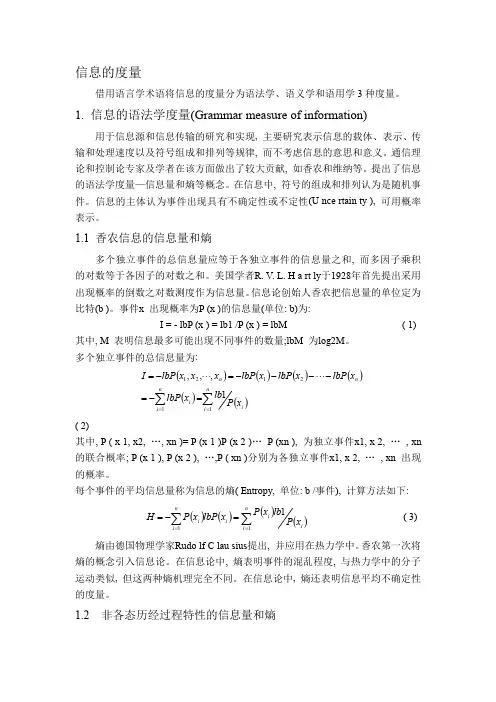

信息的度量

- 格式:ppt

- 大小:635.50 KB

- 文档页数:76

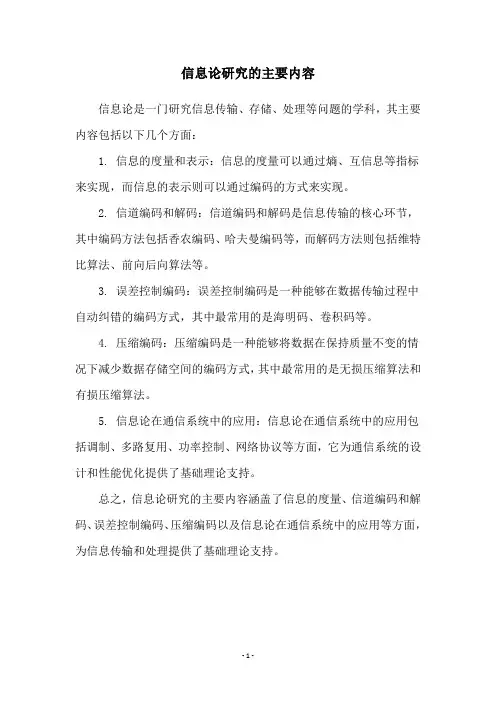

信息论研究的主要内容

信息论是一门研究信息传输、存储、处理等问题的学科,其主要内容包括以下几个方面:

1. 信息的度量和表示:信息的度量可以通过熵、互信息等指标来实现,而信息的表示则可以通过编码的方式来实现。

2. 信道编码和解码:信道编码和解码是信息传输的核心环节,其中编码方法包括香农编码、哈夫曼编码等,而解码方法则包括维特比算法、前向后向算法等。

3. 误差控制编码:误差控制编码是一种能够在数据传输过程中自动纠错的编码方式,其中最常用的是海明码、卷积码等。

4. 压缩编码:压缩编码是一种能够将数据在保持质量不变的情况下减少数据存储空间的编码方式,其中最常用的是无损压缩算法和有损压缩算法。

5. 信息论在通信系统中的应用:信息论在通信系统中的应用包括调制、多路复用、功率控制、网络协议等方面,它为通信系统的设计和性能优化提供了基础理论支持。

总之,信息论研究的主要内容涵盖了信息的度量、信道编码和解码、误差控制编码、压缩编码以及信息论在通信系统中的应用等方面,为信息传输和处理提供了基础理论支持。

- 1 -。

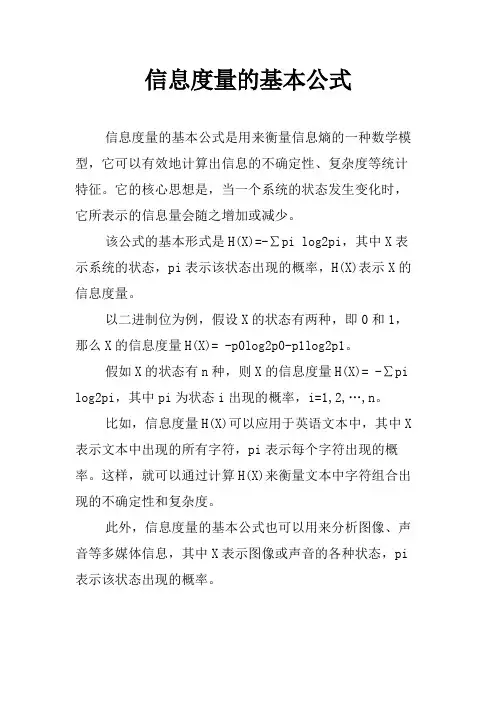

信息度量的基本公式

信息度量的基本公式是用来衡量信息熵的一种数学模型,它可以有效地计算出信息的不确定性、复杂度等统计特征。

它的核心思想是,当一个系统的状态发生变化时,它所表示的信息量会随之增加或减少。

该公式的基本形式是H(X)=-∑pi log2pi,其中X表示系统的状态,pi表示该状态出现的概率,H(X)表示X的信息度量。

以二进制位为例,假设X的状态有两种,即0和1,那么X的信息度量H(X)= -p0log2p0-p1log2p1。

假如X的状态有n种,则X的信息度量H(X)= -∑pi log2pi,其中pi为状态i出现的概率,i=1,2,…,n。

比如,信息度量H(X)可以应用于英语文本中,其中X 表示文本中出现的所有字符,pi表示每个字符出现的概率。

这样,就可以通过计算H(X)来衡量文本中字符组合出现的不确定性和复杂度。

此外,信息度量的基本公式也可以用来分析图像、声音等多媒体信息,其中X表示图像或声音的各种状态,pi 表示该状态出现的概率。

信息度量的基本公式对于衡量信息的复杂度和不确定性非常有效,它可以有效地用于计算机视觉、语音识别、机器学习等领域。

除此之外,信息度量的基本公式还可以用来分析网络流量的可信性和安全性,其中X表示网络流量中出现的数据包,pi表示数据包出现的概率。

总之,信息度量的基本公式是一个统计方法,可以有效地应用于衡量信息的复杂度和不确定性等方面,广泛应用于计算机视觉、语音识别、机器学习、网络流量安全性等领域。

信息论——信息的度量信息的度量 信息具可度量性,其⼤⼩取决于信息所消除的不确定性 举例如下: 消息A:中国⼥⼦乒乓球队夺取亚运会冠军。

消息B:中国男⼦⾜球队夺取世界杯赛冠军。

从事件的描述上来看,其主题内容⼤致相同,那么我们是否可以认为事件A和事件B具有相同的信息量呢?显然是不⾏的。

根据以往经验,我们可以认为事件A是⼀个⼤概率事件,所以事件A的不确定性⽐较⼩,故当事件A发⽣时,我们从这个消息中得到的信息(消除的不确定度)很⼩。

同理对事件B⽽⾔,由于是个极⼩概率事件,我们得到的信息很⼤。

由此我们可以推断:消息B的信息量⼤于消息A。

对于⼀个事件X,我们假设其不确定性为 I(p1) ,其中 p1 是事件X的先验概率。

对应于事件X的消息X所消除的不确定性为 I(p2)。

那么在我们获取了消息X之后,事件X的不确定性就变为了 I(p1)-I(p2) ,由此我们可以知道当我们对⼀个事物的信息获取的越多,其不确定性就越⼩,当其不确定性变为0时,该事件就被确定下来了,我们对其⽆法再获取更多的信息量了。

直观定义: 收到某消息获取的信息量=不确定性减少量=收到该消息前后某事件的不确定性差信息量的数学表⽰ 理论依据(信息量具有的性质): 1.⾮负性对于⼀个事件⽽⾔,当事件被完全确定时,即我们⽆法获取更多信息时,其信息量为0,因此⽆法⽐0更⼩。

2.单调性是先验概率的单调递减函数,即某事件的发⽣概率越⼤,其信息量就越⼩。

3.对于事件A 若 P(a)=0 则 I(Pa)=+∞ 若 P(a)=1 则 I(Pa)=0。

4.两个独⽴事件的联合信息量应等于它们分别的信息量之和。

I(xi)具有两个含义: 1.事件发⽣前,表⽰该事件发⽣的不确定性。

2.事件发⽣后,表⽰该事件所提供的信息量。

术语解释 先验概率(prior probability)是指根据以往经验和分析得到的概率。

2 信息的度量在信息论尚未作为一门学科建立起来之前,信息的度量一直是一个长期未能得到很好解决的问题,自l948年C.E .Shannon 发表了《通信的数学理论》后,才将信息量的定量描述确定下来。

信息量是恒量信息多少的物理量。

由于各种随机事件发生的概率不同,它们所包含的不确定性也就不同。

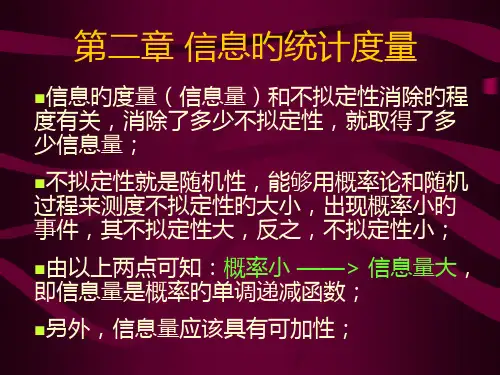

因此,一个事件所给予人们信息量的多少是与该事件发生的概率大小有关的。

出现概率小的事件包含的信息量大。

因此,信息量应该是概率的单调减函数。

2.1 自信息量设X 代表一组随机事件x 1,x 2,…,x n ,其中户p (x i )=p i (0<p i <1)是x i 出现的概率,且 P 1+ p 2+…+ p n =1则定义事件x i 的自信息为I (x i ).或者简写成I ,且I (x i )=-log p i (2-1) 在此定义中,没有指明对数的底。

自信息量的单位与所用对数的底有关。

(1)当取底为2时,自信息量的单位为比特(bit ),如p (x i )=1/2,则I (x i )=-log 1/2,=1bit ;(2)当取底为自然对数e 时,自信息量单位为奈特(Nat),且(3)当取底为l0时,自信息量的单位为哈特莱(Hartley),这是为了纪念哈待莱(Hartley ,L.V.R)在1928年最早给出信息的度量方法而取名的。

1奈持=log 2e 比特=1.443比特1哈持莱=log 210比特=3.322比特在实际电系统中,电位的高低、脉冲的有无、信号灯的明灭都是两种状态,目前的数字电子计算机也是以二电平逻辑来工作的,因此,以2为底的信息量单位比特是信息度量的基本单位。

对于信息量的理解,应注意以下问题。

(1)信息量是概率的函数,I =I [p (x i )];(2)p (x i )越小,I 越大;p (x i )越大,I 越小;(3)信息量的可加性,即若干个独立事件所含的信息量=每个独立事件所含信息量的和。

信息量的度量如何计算公式信息量的度量是指在一定的信息传输过程中,信息的多少和质量的度量。

在信息论中,我们通常使用熵来度量信息的多少,熵越大表示信息量越大。

下面我们将介绍信息量的度量以及相关的计算公式。

在信息论中,熵是度量信息量的一个重要概念。

熵的计算公式为:\[H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(H(X)\)表示随机变量\(X\)的熵,\(p(x_i)\)表示随机变量\(X\)取值为\(x_i\)的概率。

通过计算熵,我们可以得到随机变量\(X\)的信息量。

在实际应用中,我们经常使用二进制编码来表示信息。

在这种情况下,我们可以使用香农编码来计算信息量。

香农编码是一种使用变长编码来表示信息的编码方式,通过根据信息的概率分布来确定每个信息的编码长度,从而实现信息的高效表示。

香农编码的计算公式为:\[L = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(L\)表示信息的平均编码长度。

通过计算香农编码,我们可以得到信息的平均编码长度,从而可以评估信息的压缩效果和传输效率。

除了熵和香农编码,我们还可以使用信息熵来度量信息的多少。

信息熵是一种用于度量信息量的概念,它是对信息量的期望值。

信息熵的计算公式为:\[H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(H(X)\)表示随机变量\(X\)的信息熵,\(p(x_i)\)表示随机变量\(X\)取值为\(x_i\)的概率。

通过计算信息熵,我们可以得到随机变量\(X\)的平均信息量。

在实际应用中,我们可以使用信息熵来评估信息系统的复杂度和传输效率。

通过计算信息熵,我们可以得到系统中信息的平均复杂度,从而可以评估系统的性能和稳定性。

综上所述,信息量的度量是信息论中的重要概念,我们可以使用熵、香农编码和信息熵来度量信息的多少。

信息论度量方法

信息论中,信息的度量方法有多种,以下是几种主要的度量方式:

1. 信息量:信息量可以用比特(bit)来度量,比特是信息论中最基本的单位,表示二进制系统中的一个选择。

比特的数量表示传递或存储的信息量

的大小。

2. 信息熵:信息熵是信息理论中度量信息不确定性的概念。

熵的值越大,

表示信息的不确定性越高。

熵可以用来度量某个事件或数据集中的信息量。

3. 信噪比:信噪比是度量信号中有用信息与噪声比例的指标。

它可以用来

衡量信号中噪声对有用信息的影响程度。

4. 信息速率:信息速率是单位时间内传输或处理的信息量。

常用的单位是

比特每秒(bps)或字节每秒(Bps)。

5. 信息传输效率:信息传输效率是指在给定的带宽或资源条件下,能够传输的有效信息量。

它是通过传输速率和信道容量的比值来度量的。

以上信息仅供参考,如有需要,建议查阅相关书籍或咨询专业人士。

浅谈信息的度量就我个⼈⽽⾔觉得信息的度量是⼗分难量化的。

也的确是这样,平⽇⼀个⼈说的⼀句话有多少信息是很难度量得到的。

可是在⾃然语⾔处理中,信息度量的量化⼜⼗分重要。

《数学之美》⼀书中吴军先⽣举了⼀个⾮常好的例⼦。

他假设了⼀种情形,他向⼀个⼈猜测1-32号⾜球队伍中哪⽀队伍是世界杯的冠军,他如果采⽤五五分的⽅法逐步缩⼩范围那么需要五次就能知道哪⽀队伍是冠军,假设每向对⽅询问⼀次需要花费⼀元,那么谁是世界杯冠军这条信息则需要花费五元。

⽽⾹农在他的论⽂“通信的数学原理”中使⽤⽐特来度量信息量。

其实在上述例⼦中,是可以优化的。

每次的猜测不⼀定⼀定要五五分,可以将少数的夺冠热门分为⼀组,这样就可以⼤⼤降低猜测需要耗费的次数。

当每⽀队伍夺冠希望不等时,⾹农使⽤了⼀个公式来对这种情况的信息进⾏度量。

其中H为信息熵,单位是⽐特。

p1, p2....分别是这32⽀队伍夺冠的概率。

当概率相同时,信息的熵就是5⽐特。

⽽对于随机变量X,它的熵定义如下:变量的不确定性越⼤熵也越⼤事物往往是有许多不确定性的,这时需要引⼊信息I,当I>U时我们可以说不确定性被消除了,但是当I<U时,只能说这些信息消除了事物的⼀部分不确定性。

吴军先⽣举了⽹页搜索的例⼦,当⽤户只输⼊某些常⽤关键词,会出来许多的结果,这时需要挖掘隐藏的信息以确定⽤户真正想要查找的信息从⽽给⽤户提供正确的⽹页。

基于上述公式,如果我们知道⼀些情况Y,那么在Y条件下X的熵就是这时可以证明,H(X)>H(X|Y),也就是⼆元模型的不确定性要⼩于⼀元模型。

现在来谈谈互信息的概念,互信息⽤于对两个信息之间的相关性进⾏度量,⽐如“天⽓很闷热”和“要下⾬了”这两条信息的互信息就很⾼。

假定有两个随机事件X和Y,他们的互信息定义如下:其实这个互信息也可以看作是X的不确定性H(X)以及在知道Y的情况下X的不确定性H(X|Y)之间的差异。

也就是⽽在机器翻译中往往需要解决的⼆义性问题则可以通过这样的问题解决,⽐如美国总统Bush是翻译为⼈名还是灌⽊丛,就可以通过该词的上下⽂提取相关信息减⼩不确定性。