基于感知机模型藏文命名实体识别(华却才让)

- 格式:pdf

- 大小:1.87 MB

- 文档页数:6

基于机器学习的中文命名实体识别技术研究随着互联网的快速发展和普及,大量的数据被不断地产生和积累。

其中,文本数据占据了很大的比例,尤其是中文文本数据。

而命名实体识别(Named Entity Recognition,NER)作为文本处理和信息提取的基础和重要环节,对于有效处理和利用这些数据具有重要的作用。

本文将介绍基于机器学习的中文命名实体识别技术,重点探讨其技术原理、应用场景及发展前景。

一、机器学习的中文命名实体识别技术机器学习是指计算机通过学习数据模式和建立模型,进行自主的判断和决策,以达到优化目标的一种方法。

而中文命名实体识别技术则是指对于中文文本数据中的人名、地名、组织机构名等命名实体进行自动识别和标注的技术。

基于机器学习的中文命名实体识别技术包括以下步骤:1.数据预处理:包括中文分词和词性标注等处理,将原始文本划分成词语和相应的标签,如人名、地名、组织机构名等。

2.特征提取:从处理后的文本数据中提取相关的特征,如词语的形态、句法、语义等特征,以辅助后续的模型训练和预测。

3.模型训练:使用已标注的训练数据集,建立机器学习模型,如条件随机场(CRF)、支持向量机(SVM)等,以实现对文本数据的自动分类和识别。

4.预测和评估:使用训练好的模型对新的未标注文本数据进行分类和标注,并进行评估,如准确率、召回率、F1值等指标。

二、中文命名实体识别的应用场景中文命名实体识别技术具有广泛的应用场景。

以下是其中比较典型的几个方面:1.信息检索和分类:在文本搜索和分类领域,中文命名实体识别技术可以帮助提升检索和分类的准确率,优化用户体验。

2.社交网络分析:在社交网络分析中,中文命名实体识别技术可以辅助识别用户的身份、兴趣和关系等信息,以实现更为精准的社交网络分析和推荐。

3.媒体新闻分析:在新闻报道媒体等领域,中文命名实体识别技术可以帮助识别新闻中的人物、地点、事件等实体,建立知识图谱和实现智能分析。

4.金融风控领域:在金融风控领域,中文命名实体识别技术可以帮助识别客户的身份、背景和交易数据等信息,提高金融风控的效率和准确性。

基于机器学习的中文命名实体识别算法研究标题:基于机器学习的中文命名实体识别算法研究摘要:命名实体识别(Named Entity Recognition,NER)是自然语言处理中的重要任务之一,其目的是从给定的文本中识别并分类命名实体。

随着中文信息的快速增长,中文NER的研究也变得越来越重要。

本论文通过对中文NER算法的研究,基于机器学习的方法来识别中文命名实体,并对其中的关键技术和方法进行了探讨。

实验结果表明,所提出的中文NER算法在准确性和效率上相对于传统方法具有明显的优势。

一、引言随着人工智能和大数据技术的发展,自然语言处理领域获得了快速的发展。

命名实体识别作为其中的重要任务之一,对于实现智能化的文本分析和信息提取具有重要意义。

本章首先介绍了NER的定义、应用场景以及研究现状,然后提出了论文的主要目标和内容安排。

二、中文命名实体识别算法综述该章节主要对中文命名实体识别算法的研究现状进行综述,包括基于规则的方法、基于统计的方法以及基于深度学习的方法。

对于每个方法,分别介绍了其原理、优缺点以及在中文NER中的应用情况,并总结了各种方法的发展趋势和挑战。

三、基于机器学习的中文NER算法设计在本章中,我们介绍了基于机器学习的中文NER算法的设计思路和流程。

首先,从数据预处理开始,包括数据清洗、分词和特征提取等步骤。

然后,我们介绍了常用的机器学习算法,包括最大熵模型、支持向量机和条件随机场,并对其在中文NER中的应用进行了探讨。

四、实验与结果分析在本章中,我们设计了一系列实验,对所提出的中文NER算法进行了评估和比较。

实验数据集包括了常见的中文命名实体类别,如人名、地名和组织名等。

通过比较各种算法的准确性和效率,我们验证了所提出算法的优势,并分析了实验结果的原因和改进空间。

五、讨论与展望在本章中,我们对中文NER算法进行了综合讨论和总结,并对未来的研究方向进行了展望。

同时,我们也对本论文的不足之处提出了改进的建议,并探讨了相关问题的解决方案。

基于集成学习的中文命名实体识别方法梁兵涛;倪云峰【期刊名称】《南京师大学报:自然科学版》【年(卷),期】2022(45)3【摘要】针对中文命名实体识别经典的BiLSTM-CRF(bi-directional long short-term memory-conditional random field)模型存在的嵌入向量无法表征多义词、编码层建模时注意力分散以及缺少对局部空间特征捕获的问题,本文提出一种融合BERT-BiGRU-MHA-CRF和BERT-IDCNN-CRF模型优势的集成模型完成命名实体识别.该方法利用裁剪的BERT模型得到包含上下文信息的语义向量;再将语义向量输入BiGRU-MHA(bi-directional gated recurrent unit-multi head attention)及IDCNN(Iterated Dilated Convolutional Neural Network)网络.前者捕获输入序列的时序特征并能够根据字符重要性分配权值,后者主要捕获输入的空间特征,利用平均集成方式将捕获到的特征融合;最后通过CRF层获得全局最优的标注序列.集成模型在人民日报和微软亚洲研究院(Microsoft research asia, MSRA)数据集上的F1值分别达到了96.09%和95.01%.相较于单个模型分别提高了0.74%和0.55%以上,验证了本文方法的有效性.【总页数】9页(P123-131)【作者】梁兵涛;倪云峰【作者单位】杭州优行科技有限公司;西安科技大学通信与信息工程学院【正文语种】中文【中图分类】TP391【相关文献】1.基于词汇增强的中文命名实体识别方法2.基于ALBERT-BGRU-CRF的中文命名实体识别方法3.基于多颗粒度文本表征的中文命名实体识别方法4.面向教育领域的基于SVR-BiGRU-CRF中文命名实体识别方法5.基于ALBERT预训练模型的通用中文命名实体识别方法因版权原因,仅展示原文概要,查看原文内容请购买。

基于深度学习的命名实体识别算法研究近年来,随着机器学习技术的发展,基于深度学习的命名实体识别算法日益被人们所重视。

命名实体识别算法是自然语言处理领域中的一个重要研究方向,它可以将文本中的实体名称(人名、地名、组织机构名等)自动识别出来,并进行分类和标注。

准确地识别出各种实体名称,对于信息提取、文本分类、知识图谱构建等应用领域具有重要的意义。

本文将围绕基于深度学习的命名实体识别算法展开研究。

一、命名实体识别算法的研究现状最初的命名实体识别算法主要基于规则和模式匹配,这些方法需要人工设计特征和规则,难以处理复杂的句子结构和语言变化。

近年来,传统的基于统计机器学习的方法,如最大熵模型、条件随机场等,取得了较好的效果。

但是,这些方法需要对文本进行预处理,并采用手工工程特征,这限制了算法的泛化能力。

而基于深度学习的命名实体识别算法则可以使用端到端的方式进行模型训练和应用。

二、基于深度学习的命名实体识别算法基于深度学习的命名实体识别算法一般分为两类:基于卷积神经网络的方法和基于循环神经网络的方法。

1. 基于卷积神经网络的方法基于卷积神经网络的命名实体识别算法主要由卷积层、池化层和全连接层组成。

其中,卷积层可以提取文本中的特征,池化层可以降低特征的维度,全连接层可以进行分类和标注。

例如,Zhang等人提出的卷积神经网络命名实体识别算法(CNN-NER)可以通过学习句子中的词向量来识别命名实体,并将其分类为不同的类别。

2. 基于循环神经网络的方法基于循环神经网络的命名实体识别算法主要由循环层和全连接层组成。

循环层可以学习长期依赖和上下文信息,全连接层可以进行分类和标注。

例如,Lample等人提出的循环神经网络命名实体识别算法(LSTM-CRF)可以学习上下文信息和序列特征,并将命名实体识别结果与标注结果通过条件随机场进行融合,提高了算法的准确性。

三、算法效果的评价指标对于命名实体识别算法的效果评价指标主要包括准确率、召回率和F1值。

bert-base-chinese 使用案例随着自然语言处理技术的不断发展,深度学习模型成为了处理自然语言任务的重要工具。

BERT(Bidirectional Encoder Representations from Transformers)作为一种基于变压器的预训练模型,具有在各种自然语言处理任务上取得卓越性能的能力。

本文将介绍几个bert-base-chinese的使用案例,展示该模型在不同领域任务中的应用。

一、文本分类任务文本分类是自然语言处理中的一项重要任务,常见于新闻分类、情感分析等场景。

bert-base-chinese作为一种预训练模型,可以用于文本分类任务。

首先,我们需要将待分类的文本经过分词处理,然后输入到bert-base-chinese模型中。

模型将生成词向量表示,并通过多层感知机进行分类。

通过训练模型,可以获得一个高性能的文本分类器,对输入文本进行准确分类。

二、命名实体识别任务命名实体识别是信息抽取和自然语言处理领域的重要任务,其目标是从文本中识别并分类出实体的各个部分。

bert-base-chinese可以应用于命名实体识别任务并取得很好的效果。

首先,我们需要将待处理的文本进行分词,并使用标签对实体进行标注。

然后,将经过标注的文本输入到bert-base-chinese模型中进行训练。

通过学习,模型可以提取出文本中的实体,并进行准确的分类。

三、问答系统问答系统是人工智能领域的热门研究方向,旨在实现机器对自然语言问题的理解和准确回答。

bert-base-chinese可以用于问答系统的搭建。

首先,我们需要将问题和相关文本进行编码,然后将编码后的问题和文本输入到bert-base-chinese模型中。

模型将生成问题和文本之间的相似度得分,根据得分可以准确地选择和问题相关的答案。

四、机器翻译机器翻译是将一种语言的文本转化为另一种语言的过程。

bert-base-chinese可以应用于机器翻译任务,并取得不错的效果。

基于多级别特征感知网络的中文命名实体识别宋威;周俊昊【期刊名称】《中文信息学报》【年(卷),期】2022(36)9【摘要】当前中文命名实体识别方法仅采用字级别或词级别特征方法进行识别,不能兼顾字和词级别的优点,难以获取足够的字形或者词义信息。

针对此问题,该文提出一种基于多级别特征感知网络的中文命名实体识别方法。

首先提出一种双通道门控卷积神经网络,通过感知字级别特征,在减少了未登录词的同时,也表示了字的字形信息。

同时,为了获取词语的词义信息,该文在词级别的特征中嵌入对应位置信息。

为了赋予实体更多的权重,该文利用自注意力机制感知带有位置信息的词级别特征。

进一步,将上述得到的字级别和词级别信息融合,全面表示句子的语义信息。

由于采用字词结合的方法容易产生冗余信息,该文设计一种门控机制的Highway网络,来过滤冗余信息,减少冗余信息对命名实体识别的影响,再结合条件随机场学习到句子中的约束条件实现中文命名实体的识别。

实验结果表明,该文所提出的方法总体上优于目前主流的中文命名实体识别方法。

【总页数】9页(P84-92)【作者】宋威;周俊昊【作者单位】江南大学人工智能与计算机学院;江南大学江苏省模式识别与计算智能工程实验室【正文语种】中文【中图分类】TP3【相关文献】1.基于多特征融合的中文电子病历命名实体识别2.生物医学命名实体识别研究现状及中文生物医学命名实体识别难点与意义综述3.基于多维度特征融合的中文命名实体识别系统4.基于BERT与融合字词特征的中文命名实体识别方法5.基于调整方向感知的中文命名实体识别因版权原因,仅展示原文概要,查看原文内容请购买。

基于深度学习的中文命名实体识别研究的开题报告1.研究背景目前,由于互联网技术的不断发展和普及,文本信息的数量呈指数增长。

然而,大量的文本信息中包含着各种实体,例如人名、地名、组织机构等。

对这些实体进行自动识别并抽取出有用信息,不仅可以大大提高人们的信息检索效率,而且对于自然语言处理、知识图谱构建等领域也具有重要意义。

因此,中文命名实体识别(Chinese Named Entity Recognition,CNER)成为了自然语言处理研究中的一个核心问题。

该问题的解决对于机器理解文本的能力有很大帮助。

随着深度学习技术的兴起,其在该领域中也取得了很多进展。

因此,本研究将重点基于深度学习技术对中文命名实体识别算法进行研究和探讨。

2.研究目的本研究旨在探究基于深度学习的中文命名实体识别算法,通过对中文文本中的命名实体进行自动识别提取出有用信息,提高文本信息检索的效率和精度。

3.研究内容(1)中文命名实体识别的基本概念和算法;(2)深度学习技术在中文命名实体识别中的应用现状和发展趋势;(3)基于深度学习的中文命名实体识别算法的研究和探讨,包括基于循环神经网络(Recurrent Neural Networks,RNN)的模型和基于卷积神经网络(Convolutional Neural Networks,CNN)的模型;(4)基于公开数据集的实验和分析,对比不同模型在中文命名实体识别任务上的效果;(5)对研究结果进行总结和分析,提出未来研究的方向和深度学习在自然语言处理领域的应用前景。

4.研究方法本研究将主要采用如下方法:(1)数据预处理:收集、清洗并进行标注的数据集;(2)模型设计:基于深度学习方法,设计一些常用模型,如RNN、CNN等等;(3)模型训练:通过已经标注好的数据集进行训练,并结合优化方法进行模型的快速迭代;(4)模型评估:通过公开数据集进行模型的效果评估,比较不同模型在中文命名实体识别任务中的表现;(5)结果分析:分析研究结果,发掘深度学习在中文命名实体识别中的应用前景。

基于机器学习的中文命名实体识别研究近年来,机器学习技术在自然语言处理领域得到了广泛应用,其中命名实体识别(Named Entity Recognition,NER)作为自然语言处理的重要任务之一,也得到了越来越多的关注。

命名实体是指指代具体事物的名称,例如人名、地名、组织机构名等,识别这些实体对于很多应用场景来说都至关重要,如信息抽取、搜索引擎等。

在这篇文章中,我们将聚焦于基于机器学习的中文命名实体识别研究。

一、命名实体识别命名实体识别是自然语言处理任务中的一个子任务,它的目标是在文本中识别出指称某一类具体事物实体的字符串序列,例如人名、地名、组织机构名等。

一句话中可能包含多个实体,如“马云是阿里巴巴的创始人”,其中“马云”和“阿里巴巴”分别是人名和组织机构名。

为了实现命名实体识别,通常需要使用机器学习算法训练分类模型,这样可以从数据中自动学习实体的特征,如实体的词性、上下文信息等,进而对文本中的实体进行识别。

二、中文命名实体识别中文命名实体识别与英文相比,具有一些特殊性。

中文是汉字构成的语言,一个词可以由多个汉字组成,而且一个汉字本身就包含了大量的信息。

这些特点需要我们在命名实体识别时进行特殊的处理。

中文命名实体的主要类型包括人名、地名、组织机构名和专有名词等。

中文命名实体的识别方法可以分为基于规则和基于统计的方法。

基于规则的方法主要是通过定义一些规则来识别实体,虽然准确率高,但是需要人工编写规则并频繁更新,不利于系统的扩展。

基于统计的方法则是使用机器学习算法训练分类模型,这样可以从数据中自动学习实体的特征,准确率较高,并且可以进行在线学习,不需要频繁更新规则。

通常使用的中文命名实体识别技术包括条件随机场(Conditional Random Fields,CRF)、递归神经网络(Recurrent Neural Networks,RNN)等。

其中,CRF是基于标注的机器学习算法,通过考虑实体标注之间的关系,可以更好地识别实体。

第44卷㊀第3期㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀湖北科技学院学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀Vol.44,No.3㊀2024年6月㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀Journal of Hubei University of Science and Technology㊀㊀㊀㊀㊀㊀㊀㊀Jun.2024文章编号:2095-4654(2024)03-0151-06㊀㊀㊀㊀基于BERT-BiLSTM-CRF古籍文献命名实体识别㊀㊀㊀㊀蔡维奕(西北民族大学㊀数学与计算机科学学院,甘肃㊀兰州㊀730030)摘㊀要:古籍文献中存在着大量的多字词㊁歧义词㊁异体字等问题,使得古籍文献命名实体识别成为了一项具有挑战性的任务㊂本文提出一种基于BERT-BiLSTM-CRF模型的古籍文献命名实体识别方法㊂该方法首先用预训练语言模型BERT来建模字的上下文表示,然后通过BiLSTM模型对BERT的输出进行加工,解决长距离依赖问题,得到更加丰富的特征信息,最后通过CRF模型对这些特征进行联合建模,从而实现对古籍文献中命名实体的精确识别㊂实验结果显示,BERT-BiLSTM-CRF性能超过了所有基线模型㊂关键词:BiLSTM模型;BERT模型;古籍文献中图分类号:TP391.1㊀㊀㊀㊀㊀㊀㊀㊀文献标识码:A㊀㊀㊀㊀㊀开放科学(资源服务)标识码(OSID ):㊀㊀古籍文献包含了丰富的历史㊁文化和语言信息,对于人类文明的研究和传承具有重要意义㊂古籍文献的命名实体识别旨在自动识别出古籍文本中人名㊁地名㊁机构名等实体㊂它是正确分析处理古籍文献文本的基础步骤,也是深度挖掘㊁分析古代人文知识与文化的重要前提㊂然而,由于古籍文献的特殊性,如书写方式㊁语言习惯等,使得古籍文献命名实体识别(Named Entity Recognition,NER)成为了一项具有挑战性的任务㊂近年来,学界已有多项研究[1-3]关注史籍㊁方志㊁诗词㊁中医等类目的古籍命名实体识别,构建了一些针对垂直领域的小型标注数据集,实体标注的体系和规范有所差异,识别范围往往由三种基本实体类别扩充至人文计算研究所需的多种特殊类别,如书名㊁药物名㊁疾病名㊁动植物名等㊂这些研究所构建针对特殊领域的小型标注数据集,实体类型有差异㊂另一方面,古文字词含义的多样性㊁行文结构的连续性以及多用繁体字㊁无句点等特点,也增加了古籍文献命名实体识别任务的复杂和困难程度㊂在过去的几年中,深度学习技术在自然语言处理领域取得了巨大的成功,BERT(Bidirectional En-coder Representations from Transformers)模型[4]作为其中的代表之一,以其卓越的性能和广泛的应用受到了广泛关注㊂基于BERT的古籍文献NER任务[3]已经成为了当前研究的热点之一㊂然而,由于BERT模型本身是一个字词级别的模型,而古籍文献中存在着大量的多字词㊁歧义词㊁异体字等问题,这就需要我们对BERT进行改进和优化㊂本文提出了一种基于BERT-BiLSTM-CRF模型的古籍文献NER方法㊂该方法首先用预训练语言模型BERT来建模字的上下文表示的基础上,引入了BiLSTM[5](Bi-directional Long Short Term Memo-ry)和CRF[6](conditional Rondom Fields)模型,通过BiLSTM模型对BERT的输出进行加工,得到更加丰富的特征信息,然后通过CRF模型对这些特征进行联合建模,从而实现对古籍文献中命名实体的精确识别㊂本文的主要贡献包括:∗收稿日期:2023-12-08(1)提出了一种基于BERT-BiLSTM-CRF模型的古籍文献命名实体识别方法;(2)在公开数据集上进行了大量实验,并与其他方法进行了对比;(3)分析了实验结果,探讨了该方法的优缺点和改进方向㊂一㊁相关工作在自然语言处理领域,命名实体识别(NER)是一个重要的任务,其目的是从文本中识别出具有特定意义的实体,如人名㊁地名㊁机构名等㊂近年来,深度学习技术在自然语言处理领域取得了巨大的成功,其中基于预训练语言模型的NER方法已经成为了当前研究的热点之一㊂1.预训练语言模型预训练语言模型是指在大规模文本数据上进行无监督预训练的语言模型,它可以学习到丰富的语言知识,并将这些知识应用于各种自然语言处理任务中㊂其中BERT是一种基于Transformer架构的预训练语言模型,它通过双向编码器对输入序列进行编码,从而学习到上下文相关的词向量表示㊂BERT 模型在多项自然语言处理任务上取得了卓越的性能,如情感分析[7,8]㊁问答系统[9]㊁文本分类等[10]㊂2.基于BERT的命名实体识别方法基于BERT的命名实体识别方法是自然语言处理领域中的研究热点之一,在多个数据集上均取得了优秀的表现㊂目前,基于BERT的命名实体识别方法的研究现状主要包括以下几个方面: (1)模型结构的改进:通过引入不同的模型结构来提高命名实体识别的性能㊂例如,将BERT与BiLSTM㊁CRF等模型结合[11-13],可以更好地捕捉上下文信息和标签之间的依赖关系㊂(2)数据增强的研究:由于命名实体识别数据集通常较小,对模型的训练和泛化能力造成了一定的影响㊂因此,研究者通过数据增强等方法来扩充训练数据集[14],从而提高模型的性能㊂(3)多语言命名实体识别:由于BERT在多语言上均有较好的表现,因此研究者将其应用于多语言命名实体识别任务中㊂例如,通过使用跨语言预训练模型来进行多语言实体识别[15]㊂(4)迁移学习:在预训练阶段,BERT学习了大量无标签的语言数据,从而捕获了丰富的语言特征㊂然而,对于特定的下游任务,这些预训练的语言表示可能不够精确,因此需要进行微调㊂迁移学习是一种常用的微调方法,它利用预训练模型已经学习到的知识来帮助解决新的任务㊂在迁移学习中,预训练模型首先被加载并冻结(即不参与训练),然后使用任务特定的数据来微调模型的顶部层(通常是全连接层)㊂通过这种方式,模型可以利用已经学习到的知识来改善对新任务的适应能力㊂将BERT预训练模型进行微调,可用于不同领域和不同任务的命名实体识别[16,17]㊂本文把中文训练的BERT-Base-Chinese语言模型,运用于古籍文献,本质上将BERT预训练模型作微调,进行迁移学习,并结合BiLSTM㊁CRF等模型结合更好地捕捉上下文信息和标签之间的依赖关系㊂图1㊀模型总体结构图二㊁模型基于BERT-BiLSTM-CRF的古籍文献NER方法旨在提高古籍文献NER任务的准确性㊂它是一种基于预训练语言模型BERT㊁双向LSTM和条件随机场(CRF)的命名实体识别方法㊂该方法BERT-BiLSTM-CRF模型的结构如图1所示㊂首先使用BERT预训练语言模型对输入序列进行编码,然后将编码结果输入到BiLSTM序列模型中,从而学习到上下文相关的特征表示㊂最后,通过CRF模型对标签序列进行建模,从而实现对命名实体的识别㊂1.BERT层BERT是一种基于Transformer架构的预训练语言模型,它通过双向编码器对输入序列进行编码,在本文方法中主要学习古文字的上下文相关的向量表示㊂BERT通过两个阶段的训练来获得上下文相关的输出字向量表示:第一阶段是无监督的预训练,用于学习通用的语言知识;第二阶段是有监督的微调,用于将BERT模型应用于特定的自然语言处理任务㊃251㊃湖北科技学院学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀总第44卷中㊂在古籍文献NER任务中,一个输入可表示为s =(w1,w2, ,w n),其中w i表示输入的第i的字㊂每个字w i编码由三部分组成:(1)token embedding:将字转换成固定维度的向量㊂每个字会被转换成768维的向量表示㊂此外,两个特殊的token会被插入到tokenization的结果的开头([CLS])和结尾([SEP])㊂(2)segment embedding:用于区分一个token属于句子对中的哪个句子㊂Segment Embeddings包含两种向量表示㊂前一个向量是把0赋给第一个句子中的各个token,后一个向量是把1赋给第二个句子中的各个token㊂如果输入仅仅只有一个句子,那么它的segment embedding就是全0㊂(3)position embedding:由于Transformers无法编码输入的序列的顺序性,所以BERT在各个位置上学习一个向量表示来将序列顺序的信息编码进来㊂最终,古文字w i由三个embedding编码连接得到,即E i=E token E seg E pos㊂经过BERT层,得到每个字的向量表示:X i=Bert(E i)㊂2.Bi-LSTM层本文采用双向LSTM来学习每个古文字的中间表示,其优点可利用远距离的特征㊂对每一个LSTM 单元由多个实向量组合而成,包括输入门向量i t,忘记门向量f t,输出门向量o t,内存单元c t和隐藏状态h t㊂各变量内计算公式如下:i t=σ(W(i)x t+U(i)h t-1+b(i)f t=σ(W(f)x t+U(f)h t-1+b(f)o t=σ(W(o)x t+U(o)h t-1+b(o)u t=tanh(W(u)x t+U(u)h t-1+b(u)c i=i t☉u t+f t☉c t-1h t=o t☉tanh(c i)式中σ,tanh表示神经元的激活函数㊂W,U是权重矩阵,b是偏差向量㊂对于序列中的每个字,其输入为BERT层的输出,即x t㊂输出为h t,在Bi-LSTM网络中,其输出向量为左㊁右LSTM的输出连接组成,即h t=[h➝t,h t]㊂3.CRF层最后,本文采用CRF对标签序列进行全局建模,并考虑标签之间的依赖关系㊂具体地,对BiL-STM层的输出序列h1, ,h n作为CRF的特征输入,一个标签序列y=y1, ,y n的条件概率采用下面公式计算为:o i=Wh ip(y|s)=eði o i[y i]+T[y i,y i-1]ðy'eði o i[y'i]+T[y'i,y'i-1]其中y'=y'1, ,y'n是一个候选标签序列输出, W为发射矩阵,T为状态转移矩阵㊂在推断时,采用Viterbi算法发现概率最高的标签序列㊂在训练时,采用交叉熵损失,具体地,假设给定古文序列的黄金标签是g=g1, ,g n该实例的损失函数定义如下:L ner=-log p(g|s)三、实验与分析1.数据集文本采用2023中国计算语言学大会古籍命名实体识别评测数据集,由北京大学数字人文研究中心组织标注,语料来源是网络上公开的部分中国古代正史纪传文本㊂数据集以 二十四史 为基础语料,包含13部书中的22卷语料,随机截断为长度约100字的片段,标注了人名(PER)㊁书名(BOOK)㊁官职名(OFI)三种实体,总计15.4万字(计标点)㊂数据集统计如下:表1㊀实验用数据集统计总字数实例数人名数书名数官职数实体总数15.4万字23476670213336310246㊀㊀标签方案采用 BISO ,其中 B 表示实体的开始字符, I 表示实体的其它字符, S 表示只含单字实体, O 表示非实体字符㊂下面给出一个标签例子:友_B-PER倫_I-PER幼_O亦_O明_O敏_O,_ O通_O論_B-BOOK語_I-BOOK㊁_O小_B-BOOK 學_I-BOOK,_O曉_O音_O律_O㊂_O存_S-PER已_O死_O,_O太_B-PER祖_I-PER以_O友_B-PER 倫_I-PER為_O元_B-OFI從_B-OFI馬_I-OFI軍_I -OFI指_I-OFI揮_I-OFI使_I-OFI},_O表_O右_B -OFI威_I-OFI武_I-OFI將_I-OFI軍_I-OFI㊂2.实验设置实验时标注语料按8ʒ1ʒ1分别分为训练集㊁开发集和测试集㊂主要超参数设置如表2所示㊂㊃351㊃2024年第3期㊀㊀㊀㊀㊀㊀㊀㊀㊀蔡维奕:基于BERT-BiLSTM-CRF古籍文献命名实体识别表2㊀超参设置表超参值超参值dropout0.5L21e-8 Batch size16Learing rate1e-5 Optimizer Adm Learning rate decay0.05 Momentum0.9Learning rate clipping 5.0㊀㊀实验采用精度(P)㊁召回率(R)和F1值三个指标评估模型性能,分别表示如下:P=预测正确的实体数预测的总实体数R=预测正确的实体数总实体数F1=2∗P∗RP+R3.实验结果为了比较本文采用的模型,实验引入3个基线,分别描述如下:(1)CRF:结合了最大熵模型和隐马尔可夫模型的特点,在序列标注任务中取得了很好的效果,特征采用相连5个窗口内的字符及其组合㊂(2)BiLSTM-CRF:结合BiLSTM与CRF,字向量表示随机初始化㊂模型参数与本文所提出模型的对应组件相同㊂(3)BERT-CRF:使BERT学习到字符的表示,并做为特征直接输出到CRF㊂模型参数与本文所提出模型的对应组件相同㊂表3给出基线与本文所提模型的实验结果㊂可以发现,仅采用离散特征的CRF模型性能远低于采用密向量表示的模型㊂在三个密向量表示的模型,采用预训练语言模型的BERT-CRF的性能高于未采用预训练语言模型的BiLSTM-CRF㊂本文所采用模型充分利用BERT与BiLSTM的优点,在精度㊁召回率和F1值都取得最高的分数㊂表3㊀基线与本文所提模型的实验结果模型P R F1CRF82.4882.3282.40BiLSTM-CRF89.8787.5488.69BERT-CRF92.590.6591.57BERT-BiLSTM-CRF93.591.292.34 4.实验分析本节从学习率㊁训练批大小方面分析了超参对性能的影响,此外,也比较分析了不同实体类型㊁不同文本长度的性能㊂(1)学习率影响图2显示了不同学习率对性能的影响,可以看到,当学习率为1e-5时,本文模型在精度㊁召回率和F1值达到了最好的性能㊂图2㊀不同学习率的性能(2)批训练大小的影响批训练大小也是重要超参之一㊂图3显示了不同批训练大小的F1值,可以看出,当批训练大小为16时,模型取得了最好的性能㊂图3㊀不同批训练大小的性能(3)不同类型实体识别结果表3给出不同类型的命名实体的识别比较结果㊂可以看出,书名实体的识别效果最差,人名识别效果最好,主要原因是书名的训练实例太少,而人名的训练实例比较多㊂此外,本文采用模型在所有的类型上都超过了BERT-CRF的识别性能㊂表3㊀模型对不同类型命名实体的识别比较类型BERT-CRF BERT-BiLSTM-CRF 人名(PER)92.4593.86书名(BOOK)83.4685.6官职名(OFI)91.1391.65 (4)不同文本长度的实验结果BiLSTM能抓住长距离依存特征㊂实验比较了不同文本长度的识别性的影响㊂我们样本按句子长度分为4组:小于10㊁大于等于10及小于30㊁大于等于30及小于50㊁大于等于50.表4给出本文模型与BERT-CRF的比较结果㊂可以看出,当文本长度㊃451㊃湖北科技学院学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀总第44卷小于10时,两个模型性能基本相同㊂随着文本长度增大,两个模型的识别性能差距不断变大,当长度大于50时,本文模型超过BERT-CRF模型达到2.11%㊂这显示本文模型能有效抓住长文本的长距离依存信息㊂表4㊀不同长度文本的识别F1值比较文本长度BERT-CF BERT-BiLSTM-CRF<1097.3197.3410ɤ㊃ɤ3094.1094.2130<㊃ɤ5088.5389.04>5078.3580.46㊀㊀(5)实例分析为了更好地与基线进行比较,表5给出了本文方法与BiLSTM-CRF在古文命名实体识别的实例分析㊂在例子1中,BiLSTM-CRF方法由于缺少更多的上下文语义信息,并没有识别出人名{王鐵槍| PER}㊂在例子2中,本文所提方法识别出了所有的实体,而BiLSTM-CRF把两个OFI实体没有识别准确,这说明本文所提方法能获得更多边界信息㊂表5㊀实例分析与比较序号句子实例BiLSTM-CRF BERT-BiLSTM-CRF1持一鐵槍,騎而馳突,奮疾如飛,而佗人莫能舉也,軍中號{王鐵槍|PER}㊂持一鐵槍,騎而馳突,奮疾如飛,而佗人莫能舉也,軍中號王鐵槍㊂持一鐵槍,騎而馳突,奮疾如飛,而佗人莫能舉也,軍中號{王鐵槍|PER}㊂2壬午,{匡國軍節度使|OFI}{劉知俊|PER}爲{潞州行營招討使|OFI}㊂癸巳,改卜郊㊂{張文蔚|PER}薨㊂壬午,匡國軍{節度使|OFI}{劉知俊|PER}爲潞州行營{招討使|OFI}㊂癸巳,改卜郊㊂{張文蔚|PER}薨㊂壬午,{匡國軍節度使|OFI}{劉知俊|PER}爲{潞州行營招討使|OFI}㊂癸巳,改卜郊㊂{張文蔚|PER}薨四㊁结论古籍文献命名实体识别是正确分析处理古籍文献文本的基础步骤,也是深度挖掘㊁分析古代人文知识与文化的重要前提㊂本文采用BERT-BILSTM-CRF模型实现对古籍文献命名实体识别,实验表明模型的准确率㊁召回率和F1值均达到了较好的效果㊂此外实验也显示本模型能有效抓住长距离文本的依存信息㊂虽然书名实体识别性能不佳,这主要是由于训练语料太少,模型训练不充分所致㊂本文主要研究人名㊁书名㊁官职名三类古籍文献命名实体㊂后期研究工作中,将收集整理更大规模的古籍文献命名实体语料,研究更多的不同类型的古籍文献命名实体,并进一步研究模型各项参数,训练更好的模型,为古籍文献命名实体识别提供帮助㊂参考文献:[1]㊀崔丹丹,刘秀磊,陈若愚,等.基于Lattice LSTM的古汉语命名实体识别[J].计算机科学,2020,47(S2):18-22.[2]㊀胡为,刘伟,石玉敬.基于BERT-BiLSTM-CRF的中医医案命名实体识别方法[J].计算机时代,2022(9):119-122+135.[3]㊀余馨玲,常娥.基于DA-BERT-CRF模型的古诗词地名自动识别研究 以金陵古诗词为例[J].图书馆杂志,2023,42(10):87-94+73.[4]㊀Devlin J,Chang MW,Lee K.Bert:Pre-training of deepbidirectional transformers for language understanding[J/OL].https:///pdf/1810.04805.pdf.11Oct.2018.[5]㊀Schuster M,Paliwal KK.Bidirectional recurrent neuralnetworks[J].IEEE transactions on Signal Processing.1997,45(11):2673-2681.[6]㊀McCallum A.Efficiently inducing features of conditionalrandom fields[C].//Inproceedings of the Nineteenthconference on Uncertainty in Artificial Intelligence,USA,7Aug.2002.[7]㊀Gao Z,Feng A,Song X,etal.Target-dependent senti-ment classification with BERT[J].Ieee Access,2019(7):154290-154299.[8]㊀Catelli R,Pelosi S,Esposito M.Lexicon-based vs Bert-based sentiment analysis:A comparative study in Italian[J].Electronics,2022,11(3):374.[9]㊀Guven Z A,Unalir M O.Natural language based analysisof SQuAD:An analytical approach for BERT[J].ExpertSystems with Applications,2022,195:116592. [10]Esmaeilzadeh A,Taghva K.Text classification using neu-ral network language model(nnlm)and bert:An empiri-cal comparison[C].//Intelligent Systems and Applica-tions:Proceedings of the2021Intelligent Systems Confer-ence(IntelliSys)Volume3.Springer International Pub-lishing,2022:175-189.[11]Souza F,Nogueira R,Lotufo R.Portuguese named entityrecognition using BERT-CRF[J/OL].https://arxiv.㊃551㊃2024年第3期㊀㊀㊀㊀㊀㊀㊀㊀㊀蔡维奕:基于BERT-BiLSTM-CRF古籍文献命名实体识别org/pdf/1909.10649.pdf.23Sep.2019. [12]Alsaaran N,Alrabiah M.Arabic named entity recogni-tion:A BERT-BGRU approach[J].Computers,Materi-als and Continua,2022,68:471-485.[13]Jiang S,Zhao S,Hou K,etal.A BERT-BiLSTM-CRFmodel for Chinese electronic medical records named entityrecognition[C].//12th international conference on intelli-gent computation technology and automation(ICICTA).IEEE,2019:166-169.[14]Tikhomirov M,Loukachevitch N,Sirotina A,ingbert and augmentation in named entity recognition for cy-bersecurity domain[C].//Natural Language Processingand Information Systems:25th International Conference onApplications of Natural Language to Information Systems,Germany,24–26June,2020.[15]Hakala K,Pyysalo S.Biomedical named entity recogni-tion with multilingual BERT[C].//Proceedings of the5thworkshop on BioNLP open shared tasks.ACL,2019:56-61.[16]Labusch K,Kulturbesitz P,Neudecker C,etal.BERTfor named entity recognition in contemporary and historicalGerman[C].//Proceedings of the15th conference on nat-ural language processing.ACL,2019:8-11. [17]Montejo-Ráez,A and Jiménez-Zafra,S.M.Current Ap-proaches and Applications in Natural Language Processing[J].Applied Sciences,2022,12(10):4859.Named Entity Recognition in Ancient Books andLiterature Based on BERT-BiLSTM-CRFCAI Wei-yi(School of Mathematics and Computer Science Northwest Minzu University,Lanzhou730030,China)Abstract:There are a lot of complex words,ambiguous words,variant characters,and other problems in ancient texts,making named entity recognition in ancient texts a challenging task.This paper proposes a named enti-ty recognition method for ancient texts based on the BERT-BiLSTM-CRF model.This method first uses a pre-trained language model BERT to model the context representation of characters,then processes the output of BERT through a BiLSTM model to solve the problem of long-distance dependencies and obtain richer feature information. Finally,these features are jointly modeled through a CRF model to achieve accurate identification of named entities in ancient documents.Experimental results show that the performance of BERT-BiLSTM-CRF exceeds all baseline models.Key words:Bilstm model;Bert model;Ancient texts责任编辑:彭茜珍㊃651㊃湖北科技学院学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀总第44卷。

基于预训练的藏文命名实体识别研究基于预训练的藏文命名实体识别研究引言:命名实体识别(Named Entity Recognition,NER)是自然语言处理中的一个重要任务,旨在从文本中识别出具有特定命名实体的词汇。

藏文作为世界上重要的语言之一,其命名实体识别的研究受到了广泛的关注。

近年来,随着深度学习和预训练模型的发展,基于预训练的藏文命名实体识别逐渐成为研究热点。

本文将对基于预训练的藏文命名实体识别进行探讨和研究,分析其现状、挑战以及未来的发展方向。

一、基于预训练的藏文命名实体识别的现状1.1 藏文命名实体识别的传统方法传统的藏文命名实体识别方法主要基于规则和词典,通过人工构建规则和词典来识别文本中的命名实体。

然而,传统方法对于规模庞大的语料库和复杂的语言环境适应性较差,无法满足大规模数据处理的需求。

1.2 基于预训练模型的藏文命名实体识别近年来,随着深度学习和预训练模型的兴起,基于预训练的藏文命名实体识别取得了重要的突破。

这些模型通过在大规模语料上进行预训练,学习了丰富的语义信息和上下文关系,从而提高了命名实体识别的准确性和泛化能力。

二、基于预训练的藏文命名实体识别的方法和技术2.1 语言模型预训练语言模型预训练是基于大规模无标注数据对模型进行训练,使其学习到语言的统计规律和上下文关系。

在藏文命名实体识别中,可以使用预训练模型例如BERT(Bidirectional EncoderRepresentations from Transformers)等来提取特征和上下文信息。

2.2 迁移学习和微调迁移学习是指利用预训练的模型,在特定任务上进行微调,从而更好地适应该任务的需求。

在基于预训练的藏文命名实体识别中,可以使用迁移学习的方法,将在其他语种上预训练好的模型迁移到藏文命名实体识别任务中,并进行微调以适应藏文语境。

三、基于预训练的藏文命名实体识别的挑战3.1 数据稀缺性与其他一些常用语言相比,藏文的数据资源较为稀缺,这导致了基于预训练的藏文命名实体识别受到数据限制的挑战。

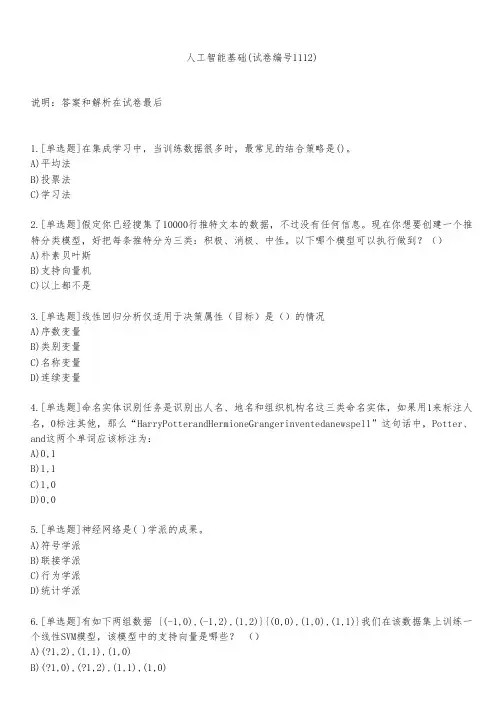

人工智能基础(试卷编号1112)说明:答案和解析在试卷最后1.[单选题]在集成学习中,当训练数据很多时,最常见的结合策略是()。

A)平均法B)投票法C)学习法2.[单选题]假定你已经搜集了10000行推特文本的数据,不过没有任何信息。

现在你想要创建一个推特分类模型,好把每条推特分为三类:积极、消极、中性。

以下哪个模型可以执行做到?()A)朴素贝叶斯B)支持向量机C)以上都不是3.[单选题]线性回归分析仅适用于决策属性(目标)是()的情况A)序数变量B)类别变量C)名称变量D)连续变量4.[单选题]命名实体识别任务是识别出人名、地名和组织机构名这三类命名实体,如果用1来标注人名,0标注其他,那么“HarryPotterandHermioneGrangerinventedanewspell”这句话中,Potter、and这两个单词应该标注为:A)0,1B)1,1C)1,0D)0,05.[单选题]神经网络是( )学派的成果。

A)符号学派B)联接学派C)行为学派D)统计学派6.[单选题]有如下两组数据 {(-1,0),(-1,2),(1,2)}{(0,0),(1,0),(1,1)}我们在该数据集上训练一个线性SVM模型,该模型中的支持向量是哪些? ()A)(?1,2),(1,1),(1,0)C)(?1,0),(1,2),(0,0),(1,1)D)(?1,0),(-1,2),(0,0),(1,0)7.[单选题]人工智能的目标是让机器能够(),以实现某些脑力劳动的机械化A)具有智能B)和人一样工作C)完全代替人的大脑D)模拟、延伸和扩展人的智能8.[单选题]下列关于可视化方法体系说法不正确的是()A)通常采用视觉图形元素和视觉通道两个维度进行视觉编码B)常用的共性方法有统计图表、图论方法、视觉隐喻和图形符号学等C)领域方法在所属领域内其可视化的信度和效果往往低于基础方法的直接应用D)视觉编码为其他数据可视化方法提供了方法学基础9.[单选题]生成对抗网络主要包含了一对相互对抗的网络模型:生成网络和()。

第28期2019年10月No.28October ,2019杨学斌1,贾磊2(1.西北民族大学民族语言与信息技术教育部重点实验室,甘肃兰州730000;2.长治学院,山西长治046000)引言图像识别是机器学习的一个重要分支。

近年来,图像识别神经网络也逐渐呈现出多样化态势。

其中,卷积神经网络(Convolutional Neural Network ,CNN )是深度前馈人工神经网络,并成功应用于图像识别领域,效果十分出众。

鉴于机器学习的发展十分迅速,很多新的机器学习工具应运而生,包括Keras 。

本研究将根据Keras 工具进行系统的设计与实现。

1图像识别技术从学术上来说,图像识别技术是模式识别技术的一种。

模式识别技术是一项为了辨认分类、描述解释表观事物或现象而先对其进行各种形式信息处理的分析技术,是人工智能的基础[1]。

图像识别技术,顾名思义就是对图像这一类模式进行识别的过程总称。

这一过程可分为训练阶段和测试阶段。

训练阶段将图像训练出易于后期分类的特征,测试阶段便可利用前面的分类特征达到识别的目的。

这两个阶段具体又可分为3个步骤:预处理、特征提取和分类。

第一步是预处理。

面对杂乱无章的图像群,预处理无疑最能为后面的图像识别工作减轻负担,也是首要的一步。

它是通过几何变换、图像滤波等方式对图像进行处理,最终只恢复或保留有用信息,从而易于后续操作甚至提高整体工作效率的过程[2]。

简单来说,预处理的结果是得到有效的点线图。

第二步是特征提取,在预处理的前提下,把得到的改进形式按照不同目标物或背景分为不同区域,根据目标得到各区域的不同代表特征,结果是将点线图分割成区别于其他图像本质特征的子集[4-5]。

进行完图像的特征提取,就要将具备同一目标或场景的不同影像进行匹配。

为了更深入地了解不同类图像,需要进行图像识别最后一步,即分类。

先借助分类器建立起分类模型,再对方才的目标物进行识别和分类。

通过理解不同的目标物,分析它们之间的关系,就有了进一步的规划。

基于深度学习的命名实体识别技术深度学习技术在自然语言处理领域中的应用越来越广泛。

命名实体识别(Named Entity Recognition, NER)作为自然语言处理的一个重要任务,涉及到从文本中识别出具有特定含义的实体名称,如人名、地名、组织机构名等。

本文将介绍基于深度学习的命名实体识别技术的背景、方法和应用。

一、引言命名实体识别是信息提取、问答系统、机器翻译等自然语言处理任务的基础,准确地识别出文本中的命名实体对于提升这些任务的性能至关重要。

传统的基于规则和特征工程的方法在面对语料复杂、歧义性高的情况下表现欠佳,而深度学习技术凭借其强大的表征学习能力逐渐成为解决这一问题的主流方法。

二、深度学习在命名实体识别中的应用深度学习在命名实体识别中的应用主要借助于神经网络模型,通过学习文本的分布式表示来识别命名实体。

常用的深度学习模型包括循环神经网络(Recurrent Neural Network, RNN)、长短时记忆网络(Long Short-Term Memory, LSTM)和卷积神经网络(Convolutional Neural Network, CNN)等。

1. 基于循环神经网络的命名实体识别循环神经网络是一种能够处理序列数据的神经网络模型,对文本的上下文进行建模,使得模型能够充分考虑句子中的语义信息。

在命名实体识别任务中,可以使用带有标签的训练数据对循环神经网络进行有监督的训练,通过学习文本的上下文信息来判断是否为命名实体。

2. 基于长短时记忆网络的命名实体识别长短时记忆网络是为了解决传统循环神经网络中的梯度消失和梯度爆炸问题而提出的一种模型。

它通过引入记忆单元和门控机制,能够更好地捕捉文本中的长距离依赖关系。

在命名实体识别任务中,长短时记忆网络可以对文本进行建模,同时对上下文信息和实体标签进行有效的关联。

3. 基于卷积神经网络的命名实体识别卷积神经网络是一种特别适合处理结构化数据的神经网络模型,对于命名实体识别任务中的文本序列,可以通过卷积操作学习出局部特征。

藏文人名自动识别研究作者:娘本先安见才让来源:《电子技术与软件工程》2015年第19期摘要目前的藏文人名识别研究大多通过英语、汉语等语种的方法来研究藏文人名的识别,虽然有着较好的识别效果,但对人名的用词、构词特点及应用藏文文法规则对人名上下文信息特征的分析较浅。

本文提出了通过建立藏文人名构成词的成分属性词典,动态生成人名库,利用传统文法中人名上下文信息特征的文法规则建立藏文人名上下文指示词库对人名自动识别的方法。

【关键词】藏文人名自动识别动态人名库指示词在进行藏文自然语言处理时,分词与标注是藏语语言信息处理的基础内容,也是藏语词法分析的核心。

藏文人名识别作为藏文分词与标注系统的重要处理内容,目前的藏文分词与标注系统在处理含有藏文人名等未登录词时,其效果一般难以满足实际的需求。

而藏文人名在未登录词中占有较大的比重,也是未登录词识别的主要难点。

因此,藏文人名的自动识别对于藏文未登录词识别以及藏文自动分词与标注具有重要的意义。

1 藏文人名识别的研究现状及难点1.1 藏文人名识别的研究现状目前国内外针对人名的自动识别主要有三种:基于规则方法、统计方法以及规则与统计相结合的方法。

藏文人名自动识别研究也以上述三种方法为主要研究方法,加上藏文人名的上下文信息特征来识别藏文人名为主。

1.2 藏文人名识别的难点人名等命名实体识别发展至今在英文和中文领域已经取得了很大的成果,但是由于藏文人名自身的特殊性,使得藏文人名识别研究进展缓慢,藏文人名识别中的难点包括:(1)音节长度不固定。

按照藏族的传统命名方式藏文人名在起名时大多以3-4个音节结构较为普遍,但是由于在现实生活中对称呼的变化,藏文的音节长度最短的2个音节,最长可达26个音节。

(2)藏文人名本身并无明显的特征。

藏文人名不同于英文和汉文人名,如英文人名在文本中出现时首字母为大写,汉文人名一般采用“姓氏+名字”的命名方式。

藏文人名不存在大小写等形式上的特征,也没有严格意义上的姓氏。

自然语言处理(Natural Language Processing, NLP)是人工智能领域的一个重要分支,通过计算机对人类语言进行处理和理解,使得计算机能够像人类一样处理自然语言。

命名实体识别(Named Entity Recognition, NER)是NLP中的一个重要任务,它旨在识别文本中特定类型的实体,如人名、地名、组织机构名等。

在本文中,我们将介绍几种常见的命名实体识别模型,并对它们的优缺点进行分析。

1. 基于规则的模型基于规则的命名实体识别模型是最早出现的模型之一。

它主要通过人工定义的规则来识别命名实体,如使用正则表达式、词典匹配等。

这种模型的优点是易于理解和解释,而且可以针对特定领域进行定制化。

然而,它的缺点是需要大量的人工工作和对领域知识的依赖,对于不同领域的文本效果可能不尽如人意。

2. 基于统计的模型基于统计的命名实体识别模型是使用统计模型来自动学习文本中的命名实体。

其中最常见的方法是使用隐马尔可夫模型(Hidden Markov Model, HMM)和条件随机场(Conditional Random Field, CRF)。

这种模型的优点是不需要手动定义规则,而是通过大量标注好的训练数据来学习文本中的模式,因此适用于各种领域的文本。

然而,它的缺点是需要大量的标注数据和特征工程,对于不同语种和领域的文本泛化能力有限。

3. 基于深度学习的模型随着深度学习的发展,基于深度学习的命名实体识别模型逐渐成为主流。

其中最常见的方法是使用循环神经网络(Recurrent Neural Network, RNN)和长短时记忆网络(Long Short-Term Memory, LSTM)来建模文本序列。

这种模型的优点是可以自动学习文本中的特征和模式,对于不同语种和领域的文本有很好的泛化能力。

然而,它的缺点是需要大量的计算资源和标注数据,模型的解释性较差。

4. 基于预训练模型的模型最近,基于预训练模型的命名实体识别模型受到了广泛关注。

专利名称:一种基于自然语言理解的藏语情感句自动分类系统专利类型:发明专利

发明人:华却才让

申请号:CN202110093952.2

申请日:20210125

公开号:CN112487792A

公开日:

20210312

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于自然语言理解的藏语情感句自动分类系统,包括:情感词典构建模块,用于构建包括基础情感词典,程度副词词典,否定和双否定词词典,转折词字典的藏文情感词典;藏文断句模块,用于利用藏文句子的句末规则以及藏文复句的特点实现藏文的自动断句,得藏文单句;分类模型构建模块,用于基于录入的藏语情感句分类标准和藏文情感词典实现藏语情感句分类模型的构建;藏语情感句分类模块,用于基于所述藏语情感句分类模型实现藏文单句情感类型的分类。

本发明基于录入的藏语情感句分类标准和藏文情感词典构建Bi‑LSTM+Attention模型,并基于模型实现了藏文单句情感类型的自动精准分类,分类准确率达93.6%左右。

申请人:青海师范大学

地址:810008 青海省西宁市城西区五四西路38号青海师范大学城西校区

国籍:CN

代理机构:西安合创非凡知识产权代理事务所(普通合伙)

代理人:于波

更多信息请下载全文后查看。

基于机器学习的自然语言处理中的命名实体识别技术研究在当今信息化时代,海量的数据引发了人们对信息处理的深入探究。

自然语言处理(Natural Language Processing,NLP)是语言学、计算机科学和人工智能交叉的一门学科,其目的是使计算机能够像人类一样,对自然语言进行理解、处理和生成。

在自然语言处理中,命名实体识别技术(Named Entity Recognition,NER)是其中非常重要的一个分支。

本文将从机器学习的角度探讨命名实体识别技术的相关问题。

一、命名实体识别技术简介NER技术是自然语言处理领域中的一个基础难点问题。

简单地理解,NER就是从自然语言文本中识别出具有特定语义的命名实体,如人名、地名、机构名等,并对它们做出归类和标注。

识别出这些实体的目的在于帮助机器理解文本中的主题和情感,以便做出更加准确的推理和分析。

NER技术的应用非常广泛,被广泛应用于搜索引擎、机器翻译、人机交互、智能客服等领域中。

一个成功的NER系统需要对文本理解和推断有深入的了解,包括自然语言处理、统计学、图形模型等多种技术。

二、命名实体识别技术的方法在实际应用中,NER技术可以分为两种方法:一种是规则驱动方法,另一种是基于机器学习技术的方法。

1.规则驱动方法规则驱动方法是基于人工制定规则,从而匹配出命名实体。

这种方法的特点在于对计算机算法的要求比较高,需要人类专家制定规则。

但也因为规则灵活性较高,可以针对性地改进规则,因此有着良好的可扩展性。

2.基于机器学习技术的方法基于机器学习技术的方法是通过对大量带有标签的训练数据进行学习,形成一个分类模型,从而对文本数据进行命名实体识别。

该方法的优点是可以自动化,无需耗费大量人力,同时也可以通过不断迭代优化模型,进一步提高准确度。

三、命名实体识别技术的性能指标命名实体识别技术的评估指标主要包括准确率、召回率和F1值。

其中,准确率是指NER系统正确识别命名实体的数量与识别出总数的比率;召回率是指NER系统识别出的命名实体数量与所有真实命名实体的数量比率;F1值是准确率和召回率的调和平均数。