视频摘要检索介绍

- 格式:doc

- 大小:15.00 KB

- 文档页数:3

视频字幕检索技术综述在各种多媒体的信息当中,视频内容通常具有比音频更为丰富的信息量。

作为快速浏览的手段和后续视频处理的重要依据,基于视频内容的信息检索得到人们广泛关注,日益成为国内外研究的热点课题,其中视频字幕检索是CBVR的重要方面。

字幕检索的基本过程视频字幕检索系统中的关键问题是字幕边缘分割与字符识别,需要用到字幕分离技术和图像处理技术。

其字幕检索的基本过程为:首先是检测视频字幕所在的关键帧;然后要对字幕在该帧内进行定位,同时进行阈值计算和水平垂直边沿修正限制;字幕区域提取是要分割、提取出字幕区域;然后对该区域进行后处理,包括区域合并、过滤、二值化等操作;最后是由OCR(Optical CharacterRecognition)软件进行字符的识别,过程如图1所示。

国内外视频检索研究及其应用现状(一)字幕检测现有的视频字幕检测方法主要是利用字幕的时间冗余来检测相同字幕存在的帧,然后利用帧内文字区域的特征来定位出文字的位置。

Dongqing Zhang等人结合由DCT(Discrete cosine Transform)系数和运动向量推导出的压缩域特征来定位字幕区域,采用长时间的一致性来增强定位精度。

Soo-Chang Pei等人提出一种利用MPEG(Moving Picture Experts Group)压缩视频比特流的宏块类信息的分析方法。

这种方法采用在运动预测过程中进行比较运算,当场景变换时或特定效果产生时得到宏块类信息中的精确特征。

这种方法用于分析快速场景变化、渐变、闪光和字幕检测,优点是它在vLC(Variable Length Code)解码后从MPEG比特流中直接提取,分析复杂度低,具有较高的灵敏度和帧检测的精确性。

蔡波周等人提出的字幕检测算法,结合了时间检测和空间边缘检测技术,首先进行文字事件检测,然后进行边缘检测、阈值计算和边缘尺寸限制,最后依据文字像素密度范围进一步滤去非文字区域的视频字幕。

![基于视频摘要、视频检索的视频分析方法[发明专利]](https://uimg.taocdn.com/1b3b140de009581b6ad9eb61.webp)

专利名称:基于视频摘要、视频检索的视频分析方法专利类型:发明专利

发明人:姚领众

申请号:CN201210578876.5

申请日:20121228

公开号:CN103020275A

公开日:

20130403

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于视频摘要、视频检索的视频分析方法,其包括以下步骤:步骤1)原始视频导入;步骤2)判断原始视频是否需要进行视频浓缩处理;步骤3)视频浓缩处理;步骤4)视频检索处理;步骤5)判断是否需要进行图像增强处理;步骤6)图像增强处理;步骤7)人像侦查处理。

该视频分析方法能提高了海量视频侦查的效率,减少目标遗漏的可能。

申请人:苏州千视通信科技有限公司

地址:215000 江苏省苏州市苏州高新技术产业开发区竹园路209号

国籍:CN

更多信息请下载全文后查看。

1、背景智能视频监控技术是安防行业技术发展的重要发展方向。

以前,广泛应用在平安城市、银行、商场等场合的视频监控系统通常只是个简单的录像,以便用于事后的取证,而这样的应用损失了图像的基本价值(一个动态的、实时的媒质),就如同把直播变成录像一样,这与人们对视频系统真正需求是有差距的。

无数事实证明,事后追查是必须的,但事前的预警更为重要,它可以把一些重大事件隐患抑制于萌芽之中,避免亡羊补牢。

因此监控系统智能化成为一个重要研究方向。

2、智能视频分析技术概述2.1智能视频分析技术定义:源自计算机视觉技术,利用智能分析算法对视频内容进行运算和分析,它的核心技术是对视频内容的行为进行识别和分析,以提取视频场景中发生的一些特定的事件或监控目标的特定行为。

视频分析方法主要有两类:一类是背景减除方法。

是利用当前图象和背景图象的差分(SAD)来检测出运动区域的一种方法。

可以提供比较完整的运动目标特征数据。

精确度和灵敏度比较高,具有良好的性能表现。

背景的建模是背景减除法的技术关键。

一般采用在系统设置时期设置系统自适应学习时间来建模,根据背景实际“热闹程度”选取3-5分钟的学习时间。

一般系统建模完成后,随着时间的变化,背景会有一些改变,系统具有“背景维护”能力,即可以将一些后来融入背景的图象,如云等自动加为背景。

另一类是时间差分方法,是高级的VMD,又称相邻贞差法,就是利用视频图象特征,从连续得到的视频流中提取所需要的动态目标信息。

实质就是利用相邻帧图象相减来提取前景目标移动的信息。

此方法不能完全提取所有相关特征象素点,在运动实体内部可能产生空洞,智能检测出目标的边缘。

2.2智能视频分析技术原理:智能视频分析技术,是通过对视频信号进行处理、分析及内容理解,提取视野范围内运动个体的运动特征,通过将运动特征与一定预设规则的比较,让计算机自动“理解”视频内容,当发现满足一定规则条件的“行为”时实现智能化自动报警。

2.3智能视频分析过程:智能视频分析是利用计算机视觉技术,对画面进行分析、处理、应用的过程、包含如下过程:●背景学习过程:自动学习监视场景的背景情况●目标提取跟踪程:提取跟踪前景变化目标,检测并分析目标的活动●视频分析判断过程:根据规则追踪目标的活动判断是否违反预定义规则●加载预处理过程:加载用户的预定义规则●触发报警过程:确定目标活动违反规则,根据预定义传输报警的指定的用户2.4智能视频分析主要目的:1、化“被动监控”为主动监控——事前预警;2、计算机代替人工完成实时监视任务——事中处理;3、在海量视频数据中快速搜索目标/事件——事后取证。

视频摘要技术在视频分析领域的作用文/周明耀杭州海康威视系统技术有限公司图像处理与智能分析部视频摘要的英文名是Video Abstract,它是一个可以概括原始视频主要内容的技术。

随着我们对视频数据处理的要求不断提高和视频数据量的不断增多,人们需要为一长段视频建立一段摘要来快速浏览以便更好地利用它。

通过视频摘要技术,让我们在基于内容的视频检索中不仅仅能利用文字,而且能够充分利用音视频信息。

视频摘要技术解决的问题是如何使视频数据有效的表示和快速的访问,它是利用对视频内容的分析来减小视频存储、分类和索引的代价,提高视频的使用效率、可用性和可访问性,它是基于内容的视频分析技术的发展。

一、视频摘要解释视频摘要技术的研究最早始于1994 年CMU 大学的Informedia工程, 随后德国曼海姆大学、FX Palo Alto 实验室、Minnesota大学、MITRE 公司、哥伦比亚大学与微软研究院等都在这方面进行了较为深入的研究, 分别提出了各自的视频摘要策略, 视频摘要的表现形式也由最初的静态摘要转变为现在的动态缩略视频。

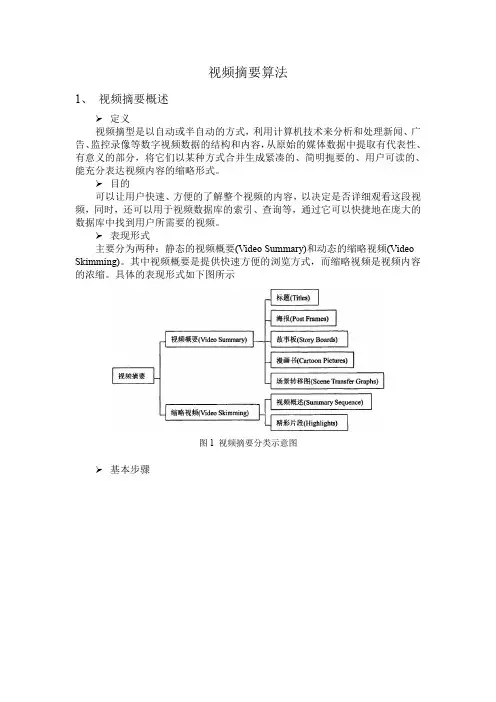

总的来说视频摘要是对一长段视频内容的简短总结,即:视频摘要就是一连串静止或运动的图像,分别称为静态视频摘要和动态视频摘要,它们用精简的方式代表了原视频的内容,同时保留了原内容的要点。

静态视频摘要是从原始视频中剪取而生成的一系列静止图像的集合,这些代表了原始视频的图像成为关键帧,动态视频摘要是由一些图像序列以及对应的音频组成,它本身是一个视频片断。

两者区别是静态视频摘要只考虑其关键帧,忽略了音频信息,生成摘要的速度比动态视频摘要快,动态视频摘要表现的内容比静态视频摘要丰富,通常以镜头的方式表示,融合了图像、声音和文字等信息。

视频摘要的作用主要是便于存储和视频的浏览或查找,相对于原始的视频资料,视频摘要的长度要短很多,节省了存储时间、空间。

视频摘要保留了原内容的要点,所以对于用户来说,浏览或查找视频摘要比浏览原始视频要节省时间。

DOI:10.13878/j.cnki.jnuist.2020.03.002刘波1,2视频摘要研究综述摘要近年来,随着计算机技术的发展和终端设备的广泛使用,视频摘要技术得到了广泛的研究.视频摘要是数据摘要的重要研究方向.首先介绍了静态视频摘要的基本概念,然后对研究静态视频摘要的凸松驰方法和行列式点过程法的最新研究进展进行了概述.对于动态视频摘要,主要对分割视频和个性化视频摘要的最新研究进展进行了介绍.最后对视频摘要面临的问题以及将来的研究方向进行了介绍.关键词视频分段;动态视频摘要;静态视频摘要;个性化中图分类号TP13文献标志码A收稿日期2020⁃01⁃01作者简介刘波,男,博士,副教授,主要研究方向为机器学习㊁视频分析.liubo7971@163.com1重庆工商大学人工智能学院,重庆,4000672重庆工商大学计算机科学与信息工程学院,重庆,4000670㊀引言㊀㊀随着互联网的快速发展以及计算机㊁终端设备的广泛使用,使得视频数据呈爆炸式增长.据统计,2018年中国观看网络视频的人数已经达到6.09亿,而著名的视频网站YouTube每分钟上传的视频有300小时左右.视频是人们共享和获取信息的有效载体.图像㊁声音和文字是构成视频内容的三个基本要素,这些信息可以构成事件㊁动作等连续的信息.对于海量的视频,人们若要获取它的主要信息,通常需要观看完整个视频,这将花费大量时间.因此,需要寻找方法来让人们能从视频中迅速获取主要内容.视频摘要是解决该问题的重要方法.所谓视频摘要,就是指从视频中提取包含视频主要内容的视频帧或视频段(VideoSegmentation).视频摘要主要涉及的视频类型包括:1)电影㊁电视节目(比如新闻㊁体育㊁娱乐等)的视频.2)视频监控领域.这类视频数量巨大,内容变化较少,视角通常固定.3)Egocentric视频[1],也称第一人称视频(theFirstPersonVideo),通常是指由可穿戴设备(比如Google眼镜㊁微软的AR眼镜)所摄像的视频.这类视频的特点是内容会出现较多的遮挡,视角变换频繁㊁视频内容变化明显㊁时间长.4)用户视频,通常包含一组有趣的事件,但未经编辑.这类视频通常比较长,存在大量冗余内容[2].Pfeiffer等在1996年首次提出了视频摘要的概念[3].目前,研究视频摘要主要有两类方法:1)静态视频摘要方法,也称关键帧选择方法.该方法通过提取或选择视频中具有代性的帧(即关键帧(KeyFrame))来精简视频的内容.这种方法获得的视频摘要不具有连贯的动态信息和语音信息,所表达的信息有限.2)动态视频摘要,也称为视频剪辑(VideoSkimming).该方法通过保留连续的小视频段来实现对视频内容的精简.本文将对这两种视频摘要方法进行详细介绍.1㊀静态视频摘要静态视频摘要的目标是从给定的视频中选择出具有代表性的帧,选择的标注是代表性(representative)和多样性(diversity),有些文献也称代表性为重要性(importance).如果把视频当成一个集合,则每一帧就是集合中的元素,因此选择关键帧的问题可以看成是子集选择(subsetselection)问题.子集选择又称为范例选择,在人工智能领域有着广泛的应用,比如从大量的图像中选择具有代表性的图像展示㊀㊀㊀㊀给不同用户就是一个子集选择问题[4].子集选择是一个NP难问题,人们通过各种优化方法来获得它的近似解.按照求解子集选择方法的不同,静态视频摘要的方法可分为凸松驰(ConvexRelaxation)优化㊁行列式点过程(DeterminantalPointProcess)等.下面分别对这些方法进行介绍.1 1㊀凸松驰的静态视频摘要通常子集选择问题都得不到全局最优解.为了解决这个问题,人们将子集问题转换为凸规划问题,以便能获取近似解,这种转换也称为凸松驰.2012年,Elhamifar等[5]在数据集X上通过构造样本点的不相似性来选择范例,将行稀疏作为目标函数的正则项,并通过凸优化方法来求解目标函数.该方法在视频摘要上取得了较好的效果.随后他们对原来的方法进一步改进[6],通过在原集合X和目标集合Y之间构造逐点不相似性(pairwisedissimilarities)来获得具有代表性的样本集,然后通过稀疏恢复的方法来求解目标函数.最近,范例选择被用于动态时序数据中[7],即对于给定的时序数据集X=[x1,x2, ,xn],p(xᶄ|xi1, ,xik),需要找出X中的范例来表示时序数据集Y=[y1,y2, ,yT]中的样本.目标函数由3个势函数相乘得到,这3个势函数分别为:编码势函数(EncodingPotential)㊁基数势函数(CardinalityPotential)和动态势函数(DynamicPotential).该问题最终可以转换为一个整数规划问题,并通过最大和消息传递(max⁃summessagepassing)来求解.当多个摄像头对同一位置进行监控时,由于每个摄像头拍摄的视角(ViewPoint)不一样,会呈现多个视图.在对这一位置的监控视频生成摘要时,需要考虑多个视图的相关性(correlation),这种视频摘要称为多视图视频摘要.多视图视频摘要面临两个重要的问题:1)数据量大;2)来自各个摄像头的数据具有一定的相关性.为了有效解决这些问题,Panda等[8]提出基于子空间嵌入和稀疏表示的多视图视频摘要方法.所提出的方法同时约束一个视频内的相关性和视频之间的相关性,从而提高了关键帧的差异性和稀疏性.凸松驰方法所找到关键帧通常含有的信息量比较大,具有很好的代表性,但有可能差异性不大.为了提高凸松驰方法所选择的帧的差异性,Wang等[9]采用结构稀疏作为目标函数的正则项,其中,结构稀疏正则项由行稀疏正则项㊁局部敏感正则项和差异性正则项组成.差异性正则项主要用于提高关键帧的差异性.具体而言,对于给定的两帧xi,xj,分别找到与这两帧最不相似的帧,并得到它们的不相似值d1,d2,如果xi,xj的相似度dij比d1,d2都大,则取dij作为线性组合的系数.最终得到的差异性正则项公式为Rdiv=ðijdijxi-xj1.1 2㊀行列式点过程的静态视频摘要行列式点过程是一种概率模型,它最早由Macchi于1975年提出[10].对于一个给定的整数集I={1,2, ,N},总共可以得到2N个子集,对于其中的一个子集y⊆X被选中的概率为Py;L()=detLy()det(L+I),其中,L是对称正定矩阵的相似矩阵,I是单位矩阵,Ly是子矩阵,它的行和列是根据y中的数字从L中抽取出来.将行列式点过程用于视频摘要的原理为:将y看成是提取的视频帧的编号集合,若提取了完全相同的两帧,Ly就有完全相同的两列和两行,因此它的行列为0,从而导致其对应的概率为零.在使用行列式点过程来选择关键帧时,需要构建矩阵L.Zhang等[11]通过监督方式来构建矩阵L.首先给出一组标注好的视频摘要,将测试视频中的第i帧和第j帧取出来与标注好的帧进行逐一比较,选对相似度最大的帧,并计算相似值,将这些相似值加到一起作为矩阵L的第i行㊁第j列的元素.构造好矩阵L后,再通过经典的行列式点过程算法来得到最终要选择的帧.由于视频的帧具有很强的时序性,因此一个自然的想法就是在基于行列式点过程中加入时序特性,以获得具有更好差异性的视频摘要.目前时序行列式点过程(SequentialDeterminantalPointProcesses,SeqDPP)是关键帧选择的重要研究方向.时序行列式点过程最早由Gong等[12]提出.对于一个给定的视频V,将其按时间分成T个不相交的视频段ɣTi=1vi=V,设t时刻从V选择的关键帧子集变量为Yt,并设t时刻vt对应的某个子集为yt,则给定t-1时刻的某个子集yi-1时,得到yt的条件概率为PYt=yt|Yt-1=yt-1()=detΩyt-1ɣytdetΩt+It,其中,Ωt表示yt-1ɣyt所对应的L矩阵.得到条件概率的定义之后,就可以得到所有子集的联合概率572学报(自然科学版),2020,12(3):274⁃278JournalofNanjingUniversityofInformationScienceandTechnology(NaturalScienceEdition),2020,12(3):274⁃278分布:PY1=y1,Y2=y2, ,YT=yT()=㊀㊀P(Y1=y1)ᵑi=2P(Yi=yi|Yt-1=yt-1).最后通过后验概率推理来求解联合概率分布:y∗1=argmaxyɪv1P(Y1=y),y∗2=argmaxyɪv2PY2=y|Y1=y∗1(),︙y∗t=argmaxyɪvtPYt=y|Yt-1=y∗t-1().Li等[13]在时序行列式点过程的基础上引入强化学习来解决视频段划分问题.经典的时序行列式点过程虽然考虑了视频的时序特性,但是并没有考虑如何将视频合理地划分成长度不相等的段.所提出的算法能通过隐变量来动态得到视频段的长度,然后划分视频段,整个过程能通过算法自动推理实现.他们还针对所提出的模型给出了一种有效的训练策略.Sharghi等[14]根据用户输入的查询信息来对长视频获得关键帧集合.所提出的算法总共分成两部分:1)在序列行列式点过程的基础上,将查询信息作为条件概率的一部分来得到视频段,这是通过Z层(Z⁃Layer)来完成的;2)对得到的视频段,通过时序行列式点过程来去掉不相关信息.提出的模型限制用户输入的查询信息只能是一个或多个名词组合.为了解决时序行列式点过程的偏差问题,Sharghi等[15]提出了一种基于大间隔的视频摘要算法,该算法能根据用户输入长度来执行视频摘要.2㊀动态视频摘要动态视频摘要主要包括视频分割㊁视频段重要性评价㊁选择视频段并形成视频摘要.其中视频分段和选择视频段是动态视频摘要最重要的部分.视频分段将视频分成多个场景或镜头(shots),是动态视频摘要的基础.选择视频段则是根据具体任务选择满足要求的视频段,这通常会很困难,因为不同的人喜欢不同的视频内容,选择出的视频不可能让大家都喜欢,因此,个性化视频摘要是动态视频摘要研究的重要方向.接下来将对视频分割和个性化视频摘要的相关研究进展进行介绍.2 1㊀分割视频段最初人们是通过直方图和图像强度来对结构化视频进行分段并取得了好的效果.2014年,Gygli等[2]通过超帧(superframe)来对视频分割,并通过定义的能量函数来评价视频段.为了计算超帧的评分,需对每帧进行评分,然后将这些帧的评分加起来得到超帧的评分.在计算每帧的评分时,会利用帧的低级特征(比如对比度和时空信息显著性等)和高级特征(比如动作和人脸等)的信息.最后利用整数规划来选择视频段.Potapov等[16]提出了一种变化点(changepoint)的视频段分割方法.变化点常被用来测信号中的跳跃.他们所提出的算法采用核变化点来检测视频帧的变化情况,在变化较大的地方作为视频帧分段的界线.Ngo等[17]对结构化视频用谱聚类和时间图分析来进行场景建模,然后通过动作注意建模来进行重要视段段的检测.该算法的具体过程为:1)将视频按时序分成不同的镜头(shots)和子镜头(sub⁃shots);2)用谱聚类对这些镜头聚类,用注意力模型得到这些镜头的注意力值;3)通过聚类信息和注意力值生成时空图;4)对场景建模和检测;5)生成视步摘要.Xu等[18]针对Egocentric视频摘要提出了基于凝视(gaze)跟踪信息的视频摘要方法.研究表明图像中内容的相对重要性与人在空间和时间上的注意力分布相关.通常的Egocentric视频由可穿戴设备生成,因此凝视产生的视频能够体现佩戴人的意图,从而实现个性化的视频摘要.通过镜头中注视帧(fixationframe)的数量可以得到镜头注意力的评分.所提出的算法通过凝视信息来分段,具体的操作过程为:1)提取每帧视频中的凝视跟踪信息(包括注视㊁扫视和眨眼);2)去掉有错误的眼部跟踪数据的帧;3)对得到的每段视频选择中心帧作为关键帧,通过深度神经网络R⁃CNN提取这些关键帧的特征,主要提取大小为100ˑ100的凝视区域的特征;4)计算关键帧之间的余弦相似度;5)将连续的视频段合并成子镜头,合并的原则是如果相邻视频段的相似距离是在0 5及以上,就合并,否则就不合并;6)对于合并后的子镜头,再次选择中心关键帧,并用R⁃CNN计算这些关键帧的特征描述符,若有k个子镜头,最后形成的子镜头描述符集合为V={v1,v2, ,vk}.2 2㊀个性化的动态视频摘要随着电子商务的普及,推荐系统成为研究热点,人们想根据每个人的爱好生成相应的视频摘要(即个性化视频摘要),这与个性化推荐相似.个性化视频摘要的研究属于视频摘要的新兴领域.Xiang等[19]从情绪基调(emotionaltone)㊁局部主要特性和全局主要特性出发,对视频的个性化推672刘波.视频摘要研究综述.LIUBo.Surveyofvideosummary.荐进行了研究.为了得到镜头的情感标记,分别提取相应的音频特征和图像特征,然后再由情感分析模型来对镜头进行标记.这个标记过程也会用到人脸数据.因此视频段对应两种标记:情感标记和人脸标记.通过稀疏情感标记来分析视频的情感状态.Darabi等[20]提出了一种根据用户爱好来定制视频摘要的方法.首先由10个人根据视频的音频㊁视觉和文本内容对6个不同类别的视频的帧进行评分.然后使用SIFT特征描述符按预定义类别来计算每个视频场景的相关性分数,并将这些分类保存在一个矩阵中.接下来以向量的形式得到用户对这些高级视觉概念(类别)的兴趣水平.通过这两组数据来确定用户帧不同视频段的优先级,并根据最终用户生成的配置文件来更新帧的初始平均分数,将得分最高的视频帧作为视频的摘要,并将音频信息和文本内容插入到最终的视频摘要中.Hant等[21]通过人工标注关键帧的方式来获得视频段.该方法首先会用图模型的显著性算法来构造显著性映射,该映射由特征映射和激活映射(acti⁃vationmap)组合而成;然后得到帧之间的双向相似性,这种相似性通过帧中图像块之间的余弦距离之和来进行计算.在些基础上,通过Isomap算法来完成帧的低维表示.为了计算帧的权重,首先计算帧在低维情形下的时序邻近距离,然后获得观众所选择帧的权重.将这两种权重相加得到帧的最终权重.为了选出关键的视频段,首先用层次聚类算法来找到视频的结构,然后再用整数规划来选择视频段.该论文采用人工方式选择关键帧,并计算这些关键帧的权重,再将这些权重与模型计算的权重融合,从而将个性化引入到视频摘要中.Yoshitaka等[22]通过捕获人的动作(比如眼睛移动㊁播放器操作等)来进行个性化视频摘要.播放操作主要有快进㊁快退㊁跳至下一节/上一节,以快速播放㊁暂停或以慢速播放.在观看视频时,如果不感兴趣,观众通常会进行快进;如果对播放的内容感兴趣,经常会倒回播放或采用慢速播放.所以可以认为倒回播放或慢速重播能表示观众注意力或偏好.作者通过实验说明了播放操作与用户偏好之间的关系.观众在观看视频时,人眼的运动方式也能反映出他对视频内容的偏好.眼睛扫视(saccade)指眼球快速从一个视点转移到另一点视.固视(fixation)是眼睛在注意某个视点(viewpoint)时处于不动状态.基于眼睛所处的状态就能得到观众对视频段的关注或喜爱程度.通过对观众观看足球比赛的视频节目进行测试,可以验证这一观点.基于以上的事实,作者给出了视频摘要的处理流程.个性化视频摘要还处于起步阶段,仍有很多问题需要解决,比如在根据用户的偏好来选择用户感兴趣的视频段(或关键帧)的研究中,目前的数据集非常有限,仅有的几个数据集都没有给出视频段的评分,更没有将这些视频段与用户的偏好结合起来.3 总结视频摘要属于数据摘要的一个分支.由于视频数据是带有时序结构的图像数据,因此很多时序处理的方法(比如长短记忆网络(LSTM)等)都可以用来对视频摘要进行研究,更重要的是很多计算机视觉的方法(比如语义分割㊁动作识别等)也可以用来对视频摘要进行研究.而视频摘要是一个子集选择问题,可用机器学习㊁最优化等理论来解决视频摘要的问题.由于视频包含有声音㊁文字㊁图像等数据,可将视频摘要看成是一个多模态问题,因此可用多模态方法来对视频摘要建模.虽然人们对视频摘要进行了广泛研究,但仍有很多问题没有解决,比如:1)随着网络直播的兴起,在线视频的摘要越来越受到重视,而这方面的研究非常少;2)随着监控设备的普及,多视图的视频摘要显得越来越重要,而多个摄像机数据融合,多个摄像机数据的相关性等问题都有待解决;3)目前用于视频摘要研究的数据集很少,著名的视频摘要数据集有TVSum[23]㊁SumMe[2].这些数据集都比较小,比如SumMe包括25个短视频,TVSum包含50个短视频.若需要利用深度学习技术来研究视频摘要,则需要建立更大的数据集.参考文献References[1]㊀BetancourtA,MorerioP,RegazzoniCS,etal.Theevolu⁃tionoffirstpersonvisionmethods:asurvey[J].IEEETransactionsonCircuitsandSystemsforVideoTechnolo⁃gy,2015,25(5):744⁃760[2]㊀GygliM,GrabnerH,RiemenschneiderH,etal.Creatingsummariesfromuservideos[M]ʊComputerVision⁃ECCV2014.Cham:SpringerInternationalPublishing,2014:505⁃520[3]㊀PfeifferS,LienhartR,FischerS,etal.Abstractingdigitalmoviesautomatically[J].JournalofVisualCommunicationandImageRepresentation,1996,7(4):772学报(自然科学版),2020,12(3):274⁃278JournalofNanjingUniversityofInformationScienceandTechnology(NaturalScienceEdition),2020,12(3):274⁃278345⁃353[4]㊀SimonI,SnavelyN,SeitzSM.Scenesummarizationforonlineimagecollections[C]ʊ2007IEEE11thInterna⁃tionalConferenceonComputerVision,2007:1⁃8[5]㊀ElhamifarE,SapiroG,VidalR.Seeallbylookingatafew:sparsemodelingforfindingrepresentativeobjects[C]ʊIEEEConferenceonComputerVisionandPatternRecognition,2012:1600⁃1607[6]㊀ElhamifarE,SapiroG,SastrySS.Dissimilarity⁃basedsparsesubsetselection[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2016,38(11):2182⁃2197[7]㊀ElhamifarE,KaluzaMCDP.Subsetselectionandsum⁃marizationinsequentialdata[C]ʊAdvancesinNeuralInformationProcessingSystems,2017:1035⁃1045[8]㊀PandaR,Roy⁃ChowdhuryAK.Multi⁃viewsurveillancevideosummarizationviajointembeddingandsparseopti⁃mization[J].IEEETransactionsonMultimedia,2017,19(9):2010⁃2021[9]㊀WangHX,KawaharaY,WengCQ,etal.Representativeselectionwithstructuredsparsity[J].PatternRecognition,2017,63:268⁃278[10]㊀MacchiO.Thecoincidenceapproachtostochasticpointprocesses[J].AdvancesinAppliedProbability,1975,7(1):83⁃122[11]㊀ZhangK,ChaoWL,ShaF,etal.Summarytransfer:ex⁃emplar⁃basedsubsetselectionforvideosummarization[J].arXiv,2016,arXiv:1603.03369[12]㊀GongB,ChaoWL,GraumanK,etal.Diversesequentialsubsetselectionforsupervisedvideosummarization[C]ʊAdvancesinNeuralInformationProcessingSystems,2014:2069⁃2077[13]㊀LiYD,WangLQ,YangTB,etal.Howlocalisthelocaldiversity?Reinforcingsequentialdeterminantalpointprocesseswithdynamicgroundsetsforsupervisedvideosummarization[M]ʊComputerVision⁃ECCV2018.Cham:SpringerInternationalPublishing,2018:156⁃174[14]㊀SharghiA,LaurelJS,GongBQ.Query⁃focusedvideosummarization:dataset,evaluation,andamemorynetworkbasedapproach[C]ʊIEEEConferenceonComputerVisionandPatternRecognition(CVPR),2017:4788⁃4797[15]㊀SharghiA,BorjiA,LiC,etal.Improvingsequentialde⁃terminantalpointprocessesforsupervisedvideosummari⁃zation[C]ʊProceedingsoftheEuropeanConferenceonComputerVision(ECCV),2018:517⁃533[16]㊀PotapovD,DouzeM,HarchaouiZ,etal.Category⁃specificvideosummarization[M]ʊComputerVision⁃ECCV2014.Cham:SpringerInternationalPublishing,2014:540⁃555[17]㊀NgoCW,MaYF,ZhangHJ.Videosummarizationandscenedetectionbygraphmodeling[J].IEEETransactionsonCircuitsandSystemsforVideoTechnology,2005,15(2):296⁃305[18]㊀XuJ,MukherjeeL,LiY,etal.Gaze⁃enabledegocentricvideosummarizationviaconstrainedsubmodularmaximi⁃zation[C]ʊIEEEConferenceonComputerVisionandPatternRecognition(CVPR),2015:2235⁃2244[19]㊀XiangX,KankanhalliMS.Affect⁃basedadaptivepresen⁃tationofhomevideos[C]ʊProceedingsofthe19thACMInternationalConferenceonMultimedia,2011:553⁃562[20]㊀DarabiK,GhineaG.Personalizedvideosummarizationusingsift[C]ʊProceedingsofthe30thAnnualACMSymposiumonAppliedComputing,2015:1252⁃1256[21]㊀HanB,HammJ,SimJ.Personalizedvideosummarizationwithhumanintheloop[C]ʊIEEEWorkshoponAppli⁃cationsofComputerVision,2011:51⁃57[22]㊀YoshitakaA,SawadaK.Personalizedvideosummarizationbasedonbehaviorofviewer[C]ʊEighthInternationalConferenceonSignalImageTechnologyandInternetBasedSystems,2012:661⁃667[23]㊀SongY,VallmitjanaJ,StentA,etal.Tvsum:summarizingwebvideosusingtitles[C]ʊProceedingsoftheIEEEConferenceonComputerVisionandPatternRecognition,2015:5179⁃5187SurveyofvideosummaryLIUBo1,21CollegeofArtificialIntelligence,ChongqingTechnologyandBusinessUniversity,Chongqing㊀4000672SchoolofComputerScienceandInformationEngineering,ChongqingTechnologyandBusinessUniversity,Chongqing㊀400067Abstract㊀Recently,withthedevelopmentofcomputertechnologyandthewidespreaduseofterminalequipment,videosummarytechnologyhasbeenextensivelystudied,whichisanimportantresearchdirectionofdatasummary.Thispaperintroducesthelatestresearchprogressofvideosummary.Firstly,thebasicconceptsofstaticvideosum⁃maryareintroduced,andthenthelatestresearchprogressontheconvexrelaxationmethodanddeterminantpointprocessmethodofstaticvideosummaryissurveyed.Fordynamicvideosummaries,themostrecentresearchadvancesinsegmentedandpersonalizedvideosummariesareintroduced.Finally,theproblemsfacingthevideosum⁃maryandfutureresearchdirectionsareintroduced.Keywords㊀videosegmentation;dynamicvideosummary;staticvideosummary;personalization872刘波.视频摘要研究综述.LIUBo.Surveyofvideosummary.。

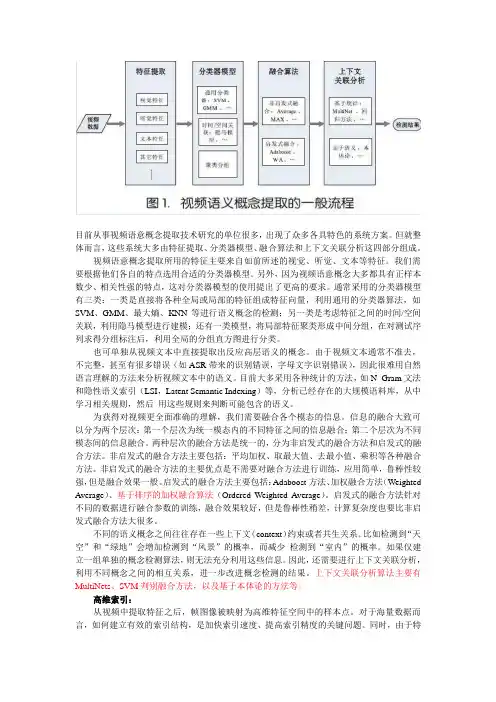

目前从事视频语意概念提取技术研究的单位很多,出现了众多各具特色的系统方案。

但就整体而言,这些系统大多由特征提取、分类器模型、融合算法和上下文关联分析这四部分组成。

视频语意概念提取所用的特征主要来自如前所述的视觉、听觉、文本等特征。

我们需要根据他们各自的特点选用合适的分类器模型。

另外,因为视频语意概念大多都具有正样本数少、相关性强的特点,这对分类器模型的使用提出了更高的要求。

通常采用的分类器模型有三类:一类是直接将各种全局或局部的特征组成特征向量,利用通用的分类器算法,如SVM、GMM、最大熵、KNN等进行语义概念的检测;另一类是考虑特征之间的时间/空间关联,利用隐马模型进行建模;还有一类模型,将局部特征聚类形成中间分组,在对测试序列求得分组标注后,利用全局的分组直方图进行分类。

也可单独从视频文本中直接提取出反应高层语义的概念。

由于视频文本通常不准去,不完整,甚至有很多错误(如ASR带来的识别错误,字母文字识别错误),因此很难用自然语言理解的方法来分析视频文本中的语义。

目前大多采用各种统计的方法,如N_Gram文法和隐性语义索引(LSI,Latent Semantic Indexing)等,分析已经存在的大规模语料库,从中学习相关规则,然后用这些规则来判断可能包含的语义。

为获得对视频更全面准确的理解,我们需要融合各个模态的信息。

信息的融合大致可以分为两个层次:第一个层次为统一模态内的不同特征之间的信息融合;第二个层次为不同模态间的信息融合。

两种层次的融合方法是统一的,分为非启发式的融合方法和启发式的融合方法。

非启发式的融合方法主要包括:平均加权、取最大值、去最小值、乘积等各种融合方法。

非启发式的融合方法的主要优点是不需要对融合方法进行训练,应用简单,鲁棒性较强,但是融合效果一般。

启发式的融合方法主要包括:Adaboost方法、加权融合方法(Weighted Average)、基于排序的加权融合算法(Ordered Weighted Average)。

视频检索综述视频检索综述随着互联网和多媒体技术的迅速发展,视频成为人们日常生活中不可或缺的一部分。

然而,随着视频数据的不断增长和视频内容的多样化,如何有效进行视频检索成为了一个值得研究的重要问题。

本文将对视频检索相关的技术和方法进行综述,旨在提供一个全面的了解和把握视频检索领域的现状和进展。

一、视频检索的概述视频检索是指从大规模视频数据集中,根据用户需求找到与之相关的视频片段的过程。

它具有很高的挑战性,主要源于视频数据包含的信息量大、内容复杂多样。

视频检索主要可以分为两个方面的研究,一是基于内容的视频检索,二是基于用户标记的视频检索。

基于内容的视频检索依靠计算机对视频内容的分析和理解,通过比对视频中的视觉特征、语义信息等,来进行检索。

而基于用户标记的视频检索则是依赖用户对视频的标记或注释信息,通过匹配标记与用户查询来实现检索。

二、基于内容的视频检索1. 视频特征提取为了使计算机能够对视频的内容进行分析,首先需要提取视频的特征。

视频特征可以从多个角度进行提取,包括低层次的视觉特征(如颜色、纹理等)、高层次的语义特征(如对象、行为等)以及混合特征。

低层次的视觉特征一般通过提取视频的帧间帧内差异、颜色直方图等来实现。

而高层次的语义特征则需要借助图像识别、行为分析等技术来提取。

2. 视频索引和检索视频索引是指将视频数据集转化为可用于检索的索引结构。

这一步通常包括对视频特征的描述和编码,以及构建索引结构。

视频检索则是在索引结构的基础上,根据用户查询进行匹配和检索。

常用的视频检索方法包括基于相似度的检索和基于学习的检索。

基于相似度的检索一般采用欧氏距离、余弦相似度等来度量视频之间的相似性,进而进行检索。

而基于学习的检索则通过训练分类器来学习视频的特征和标签之间的关系,以实现检索。

三、基于用户标记的视频检索除了基于内容的视频检索,基于用户标记的视频检索也是一种重要的检索方法。

用户标记是指用户对视频的注释或关键词信息。

视频内容检索与推荐方法综述与对比随着互联网的发展和视频平台的兴起,大量的视频内容涌现出来,用户面临着内容过载的问题。

为了帮助用户快速找到想要的视频内容,视频内容检索与推荐方法应运而生。

本文旨在综述当前常用的视频内容检索与推荐方法,并进行对比分析。

一、视频内容检索方法1. 基于文本信息的检索方法基于文本信息的视频内容检索方法是最早也是最简单的方法之一。

该方法通过对视频相关的文本信息(如标题、标签、描述等)进行建模和检索,根据用户输入的关键词进行匹配。

然而,这种方法往往会受限于文本信息的质量和准确性,容易产生干扰性结果。

2. 基于视觉特征的检索方法基于视觉特征的视频内容检索方法主要是通过分析视频的视觉内容,计算图像或帧的特征,如颜色、纹理、形状等,利用这些特征进行相似度匹配。

这种方法可以克服文本信息的局限性,但在视频内容丰富或变化剧烈的情况下,效果有限。

3. 基于语义理解的检索方法基于语义理解的视频内容检索方法通过对视频内容进行语义分析和理解,构建视频的语义模型,从而实现更准确的检索。

这种方法一般采用深度学习技术,如卷积神经网络(CNN)和循环神经网络(RNN),能够捕捉到视频中的更高层次的语义信息。

二、视频内容推荐方法1. 基于协同过滤的推荐方法基于协同过滤的视频内容推荐方法是最常用和经典的推荐方法之一。

该方法通过分析用户行为数据,找到与目标用户最相似的其他用户或视频内容,根据这些相似性进行推荐。

协同过滤方法有基于用户的协同过滤和基于物品的协同过滤两种形式。

2. 基于内容过滤的推荐方法基于内容过滤的视频内容推荐方法是在视频内容的基础上进行推荐的方法。

该方法通过分析视频的特征和属性,构建视频的内容模型,根据用户的偏好和历史行为进行匹配和推荐。

这种方法一般使用机器学习算法,如聚类算法和分类算法。

3. 基于深度学习的推荐方法基于深度学习的视频内容推荐方法使用深度神经网络模型,能够更好地挖掘用户和视频内容之间的潜在关系。

视频检索综述作者:弓洪玮来源:《人力资源管理·学术版》2009年第09期【中图分类号】TP39 【文献标识码】A 【文章编号】1673-8209(2009)9-0246-02作者简介:弓洪玮( 1982- ), 女(回), 籍贯北京,研究实习员, 主要研究方向机器人智能控制。

【摘要】视频检索把图像检索、模式识别、图像数据库技术等技术成果结合了起来,有着广阔的发展前景,并将在许多领域中道得到应用。

本文概述了视频检索的发展历史和研究状况,给出当前视频检索领域主要的研究方法和策略, 介绍了基于DCT压缩域图像检索新方案。

进一步结合视频检索自身的特点和难点,提出了今后视频检索研究的重点和方向。

【关键词】视频检索;图像特征;DCT压缩域图像视频检索就是要从大量的视频数据中找到所需的视频片断。

根据给出例子或是特征描述,系统就能够自动的找到所需的视频片断点,即实现基于内容的视频检索。

根据提交视频内容的不同,视频检索一般分为镜头检索和片段检索。

一般来说,片段的概念等价于场景的概念,也是由一连串语义相关的连续镜头构成,不同的是,片段可以是一段完整场景的部分或者全部。

目前视频检索的多数研究还集中在镜头检索上。

而片段检索方面的研究则刚刚开始。

实际上,从用户的角度分析,他们对视频数据库的查询通常会是一个视频片段而很少会是单个的物理镜头。

从信息量的角度分析,由几个镜头组成的视频片段有比单个镜头更多的语义,它可以表示用户感兴趣的事件,因此,查询的结果也比较有意义。

例如在新闻中检索感兴趣的事件、电影中检索喜欢的情节、体育节目中检索喜爱的体育运动、电视台检索某条广告是否播出等。

由于视频拍摄的多样性和后期编辑的复杂性,片段的相似性有多种可能。

把片段检索分为这样两种类型:(1)精确检索:要检索的片段与例子片段完全一样,具有同样的镜头和帧序列;(2)相似性检索:有这样两种情况:一种是对原视频进行了各种编辑,如插入删除帧(慢镜头快镜头)、插入删除镜头、交换帧镜头顺序等;另一种是不同拍摄的同类节目,如不同的足球比赛等。

随着科学技术的发展,视频监控得以在人们的生活中广泛应用的应用。

越来越多的监控摄像头安装在我们身边,随着电脑处理速度的大大提升,磁盘容量的增大、因特网的广泛使用,每天这些设备生成了成千上万的数据。

因此,从这些海量的数据中找到重要事件就变得异常困难。

所以,找出一种方法去压缩视频,甚至自动地搜索整个文件集就尤为紧迫监控录像的检索与查看依然是一项高成本的、耗时、费力的工作。

它往往需要一个庞大的团队来进行集中查看和分析捕获的视频录像,用于调查取证。

这样不仅使监控成本提高,且高强度的查看分析容易使人疲劳、出现纰漏、不利于安全监控。

深圳久凌技术软件有限公司视频摘要、检索软件的出现,解决了这个棘手的问题,使通过视频调查取证不在费时和繁琐。

智能视频分析是计算机视觉与人工智能领域研究的一个分支,融合了计算机视觉、人工智能及图形分析等多项技术,其发展目标是在监控场景与事件描述之间建立一种映射关系,实现从“看得见到看得明白”。

它突破了传统的视频监控中使用的移动侦测,上升到了“识别及分类”层级,能回答“检测到的是什么?”的问题,具有一定的人工智能,相比传统监控具有检测精度高、虚警相对少的特点,可过滤一些干扰因素,具有一定的适应能力。

智能视频分析行业技术及产品现状:在实际应用中,实时事件检测与目标检索,容易受到环境变化(包括光照,阴影,强光源,天气,风吹树摇等背景的动态变化)、摄像机的动态范围窄图像模糊及摄像机本身的抖动等多种因素的影响,智能视频分析往往会有误差;同时,从海量的视频文件中发现重要事件线索如同大海捞针。

另一方面,由于监控录像抓拍的人脸不是正面照,分辨率低,表情、姿态、光照以及拍摄年龄与身份证照片有差异,导致传统人脸识别有很大挑战。

上述两方面问题容易导致虚警,每天成百上千的误报容易导致用户的不信任度提升,影响智能视频分析技术的推广与普及。

视频摘要主要面临下列三方面挑战1.实时事件检测误警率高,2.事后线索查找犹如大海捞针,3.非受控监控环境下人脸识别率低。

深圳久凌软件技术有限公司针对上述情况展开了长期技术研究,推出了相关产品,以下介绍视频浓缩摘要的主要应用和目前可以达到的技术水准:

视频浓缩供快速检索:透过智能视频分析,实现将某个摄像机一天的录像压缩到1小时甚至数分钟以内,同时保留人/车辆或感兴趣目标的活动细节。

在视频摘要中,对于人或车辆目标,显示目标出现的时间,并且支持用户通过点击目标,播放目标出现前后的原始视频。

节省存储硬盘空间:数字摄像机产生的压缩视频按100:10:1的比例存储:为了节省海量视频的存储空间,

同时适度保存历史录像,对于高清摄像机产生的视频文件,按照100:10:1 的大致比例进行浓缩存储,即基本时间长度范围内(如最近一个月)的视频,按原始分辨率保存原始压缩视频(100%),超过基本时间长度(如一个月到3个月)的视频,只保存浓缩的摘要视频(10%),超过最大时间长度(如三个月以前)的视频,可以考虑保存转码压缩的摘要视频(1%)。

基本时间长度和最大时间长度可以由用户指定。

这是一种全新的智能转码技术,可以广泛用于3G媒体网关,给用户提供短小精炼的监控视频摘要,既节省带宽,又不会对移动终端的处理能力有过高的要求。

优化高清IP摄像机的动态码流设计:利用背景分析和前景提取技术,可以在摄像机侧实现分辨率和码率动态调整,对于没有前景活动的帧,可以采用比较小的分辨率,比较低的码率,从而节省传输带宽。

我公司智能视频分析系统工作原理:通过快速运动目标分割和特征提取所实现的实时目标自动索引方法,这样系统就可以实时对视频源目标进行索引,另外一个是基于目标的检索系统,包含基础特征比对的方法。

这样就可以使得用户通过提供目标特征(人车分类,颜色、高度、方向、速度等)、一幅样照或素描图来请求搜索。

这种采用分类检索或者样本检索的方法,可以多摄像机视频同步检索,对比原来由多个关联摄像机视频生成各自的浓缩摘要视频,一个一个观看,同步检索更加能够发挥云计算并行处理的优势,快速找到目标可能的所在位置,或者直接生成快照列表供用户查找。

我们公司推出的分类检索产品,既可以快照输出,也可以视频摘要输出,此项技术全球领先。

我们来模拟一个真实的场景,在一个酒店的免费停车场内,停了很多各式各样的车。

保安室在停车场出口。

保安室内有监控摄像显示屏,保安不巡逻,只负责观看各个摄像以防车辆被盗。

保安会因为长时间工作而感到无聊,会玩手机或者是看其他的杂志,保安晚上的交班时间是晚上00:00-00:15。

此时保安有可能不会注意视频。

而在保安交班的时候小偷偷了一辆车。

此时为00:06分。

十分钟以后,00:16分,车主发现车被盗,向保安问询。

保安调出监控录像。

据车主说车是下午18:00下班入库的,那么监控录像从18:00算起到00:16分,中间有6个小时视频要看。

且只是一个车位摄像头观察的时间。

加上车道摄像头,出口摄像头等摄像头的视频观察,加起来总共要十多个小时,估计此时小偷已经将被盗车辆出手。

这给破案增加了很大的难度。

而如果加装了深圳久凌软件技术有限公司的视频摘要软件,十多个小时的视频可以压缩为十几分钟观看,极大地减少了时间,切中了案件要点。

如果该名盗窃犯是有案底的,视频可通过面

部识别等技术进行分析,迅速地掌握案犯信息。

也可以通过输入车的类型,比如说白色越野车。

从开始看视频,到面部识别锁定案犯,或者是检索到车,只用了十几分钟的时间。

大大提升了破案的几率。

同时,在准确监控的同时,通过智能压缩技术节省了很大的存储空间,让后端存储设备"有容乃大"。

人类通过自己的聪明才智改变世界。

久凌视频摘要检索是一种新型的云平台监控软件,它能让监控人员在有效的时间达到最高的效率。

这样不仅提高了监控效果、质量,同时减低了监控成本,让视频监控上升到一个新台阶。