视觉测量技术(一)_视觉系统构成

- 格式:ppt

- 大小:6.67 MB

- 文档页数:73

机器视觉(相机、镜头、光源)全面概括分类:机器视觉2013-08-19 10:52 1133人阅读评论(0) 收藏举报机器视觉工业相机光源镜头1.1.1视觉系统原理描述机器视觉就是用机器代替人眼来做测量和判断。

机器视觉系统是指通过机器视觉产品(即图像摄取装置,分CMOS 和CCD 两种)将被摄取目标转换成图像信号,传送给专用的图像处理系统,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。

2.1.1视觉系统组成部分视觉系统主要由以下部分组成1.照明光源2.镜头3.工业摄像机4.图像采集/处理卡5.图像处理系统6.其它外部设备2.1.1.1相机篇详细介绍:工业相机又俗称摄像机,相比于传统的民用相机(摄像机)而言,它具有高的图像稳定性、高传输能力和高抗干扰能力等,目前市面上工业相机大多是基于CCD(ChargeCoupled Device)或CMOS(Complementary Metal OxideSemiconductor)芯片的相机。

CCD是目前机器视觉最为常用的图像传感器。

它集光电转换及电荷存贮、电荷转移、信号读取于一体,是典型的固体成像器件。

CCD的突出特点是以电荷作为信号,而不同于其它器件是以电流或者电压为信号。

这类成像器件通过光电转换形成电荷包,而后在驱动脉冲的作用下转移、放大输出图像信号。

典型的CCD相机由光学镜头、时序及同步信号发生器、垂直驱动器、模拟/数字信号处理电路组成。

CCD作为一种功能器件,与真空管相比,具有无灼伤、无滞后、低电压工作、低功耗等优点。

CMOS图像传感器的开发最早出现在20世纪70 年代初,90 年代初期,随着超大规模集成电路(VLSI) 制造工艺技术的发展,CMOS图像传感器得到迅速发展。

CMOS图像传感器将光敏元阵列、图像信号放大器、信号读取电路、模数转换电路、图像信号处理器及控制器集成在一块芯片上,还具有局部像素的编程随机访问的优点。

平行双目立体视觉是一种利用两个并行的摄像头来创建三维图像的技术。

它通过比较两个或更多摄像头捕获的图像来确定场景中的距离和形状。

这种技术通常用于计算机视觉和机器人视觉中,以实现物体识别、测量和导航。

基本构成:1. 摄像头:这是双目立体视觉系统的核心,它负责捕捉场景的图像。

通常,摄像头会安装在相同的距离和角度,以产生尽可能多的视差。

2. 图像处理:这部分包括对摄像头捕获的图像进行预处理,如去噪、对比度调整和色彩校正等。

这些处理步骤有助于提高后续图像分析的准确性。

3. 特征匹配:这一步骤涉及到将两个摄像头的图像进行匹配,以确定它们之间的视差。

通常使用特征检测算法,如SIFT(尺度不变特征变换)或SURF(加速稳健特征),来识别图像中的关键点。

4. 深度计算:基于匹配的特征点,系统会使用一种算法来估计它们在三维空间中的位置。

这通常涉及到三角测量,即通过两个摄像头的视差信息来计算深度。

5. 立体视觉系统:将两个摄像头的输出进行合并,形成一个立体视觉系统。

这个系统可以提供场景的三维视图,包括物体的距离、形状和纹理等信息。

测量原理:双目立体视觉的基本原理是基于视差,即两个不同角度观察到的图像之间的距离差异。

在双目立体视觉系统中,这种差异被用来创建深度信息。

具体来说:1. 双目立体视觉系统中的摄像头捕获同一场景的图像时,由于存在视角、距离和光线条件等因素的差异,导致图像中的特征点在两个摄像头中的位置略有不同。

2. 通过比较这两个图像的特征点,系统可以确定这些特征点在三维空间中的相对位置。

这个位置就是物体的距离和形状信息。

3. 基于这些信息,系统可以进一步推断出场景中其他物体的深度。

这是因为人类的视觉系统可以根据双眼接收到的视差信息来推断物体的距离和形状。

需要注意的是,双目立体视觉的准确性受到许多因素的影响,如光源条件、镜头畸变和噪声等。

因此,在实际应用中,通常会采用一些优化技术来提高系统的性能,如使用更先进的特征匹配算法、优化相机参数和采用稳健的深度计算方法等。

视觉检测原理

视觉检测原理是通过计算机视觉技术,对图像或视频进行分析和理解,从而实现目标物体的识别、分类和定位。

视觉检测系统通常包括图像获取、图像预处理、特征提取与描述、目标检测与识别、目标跟踪等组成部分。

在图像获取阶段,视觉检测系统通过相机等设备采集图像或视频。

而图像预处理阶段则对获取到的图像进行各种滤波、增强、降噪等操作,以提高后续处理的效果。

特征提取与描述阶段是将图像中的目标物体表示为计算机可识别的形式。

常用的特征包括形状、颜色、纹理和边缘等。

通过提取目标物体的特征并进行合适的描述,可以在后续的目标检测和识别过程中提供有效的信息。

目标检测与识别阶段是视觉检测系统的核心部分,主要通过使用机器学习、深度学习等算法来实现。

在目标检测中,系统将识别出图像中存在的目标物体,并给出它们的位置和边界框;在目标识别中,系统在目标物体检测的基础上,进一步进行物体的分类和标注。

目标跟踪阶段是对目标物体进行实时追踪,以保持目标在连续帧中的位置和状态的一致性。

通过使用各种跟踪算法,可实现目标的持续追踪,适用于视频监控、自动驾驶等场景。

综上所述,视觉检测原理是一种通过图像分析和理解来实现目

标物体检测、识别和跟踪的技术。

它在许多领域中得到广泛应用,为人们提供了更加智能化、高效化的解决方案。

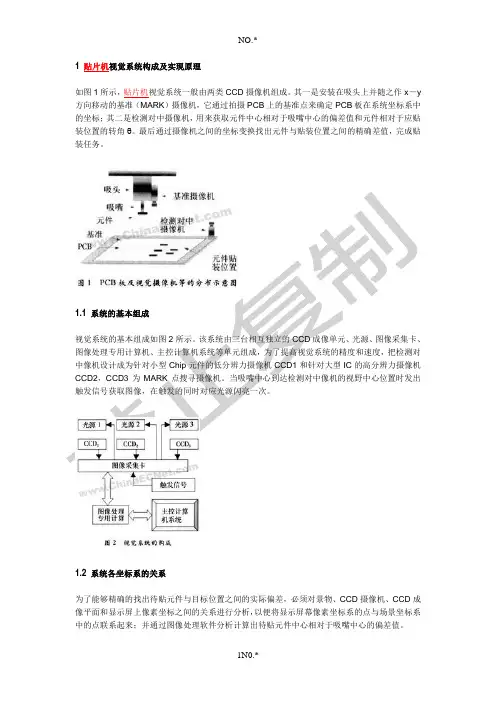

1 贴片机视觉系统构成及实现原理如图1所示,贴片机视觉系统一般由两类CCD摄像机组成。

其一是安装在吸头上并随之作x-y 方向移动的基准(MARK)摄像机,它通过拍摄PCB上的基准点来确定PCB板在系统坐标系中的坐标;其二是检测对中摄像机,用来获取元件中心相对于吸嘴中心的偏差值和元件相对于应贴装位置的转角θ。

最后通过摄像机之间的坐标变换找出元件与贴装位置之间的精确差值,完成贴装任务。

1.1 系统的基本组成视觉系统的基本组成如图2所示。

该系统由三台相互独立的CCD成像单元、光源、图像采集卡、图像处理专用计算机、主控计算机系统等单元组成,为了提高视觉系统的精度和速度,把检测对中像机设计成为针对小型Chip元件的低分辨力摄像机CCD1和针对大型IC的高分辨力摄像机CCD2,CCD3为MARK点搜寻摄像机。

当吸嘴中心到达检测对中像机的视野中心位置时发出触发信号获取图像,在触发的同时对应光源闪亮一次。

1.2 系统各坐标系的关系为了能够精确的找出待贴元件与目标位置之间的实际偏差,必须对景物、CCD摄像机、CCD成像平面和显示屏上像素坐标之间的关系进行分析,以便将显示屏幕像素坐标系的点与场景坐标系中的点联系起来;并通过图像处理软件分析计算出待贴元件中心相对于吸嘴中心的偏差值。

对于单台摄像机,针孔模型是适合于很多计算机视觉应用的最简单的近似模型[3]。

摄像机完成的是从3D射影空间P3到2D射影空间P2的线性变换,其几何关系如图3所示,为便于进一步解释,定义如下4个坐标系统:(1)欧氏场景坐标系(下标为w):原点在OW,点X和U用场景坐标系来表示。

(2)欧氏摄像机坐标系(下标为c),原点在焦点C=Oc,坐标轴Zc与光轴重合并指向图像平面外。

在场景坐标系和摄像机坐标系之间存在着唯一的关系,可以通过一个平移t和一个旋转R 构成的欧氏变换将场景坐标系转化为摄像机坐标。

其关系如式(1)所示:(3)欧氏图像坐标系(下标为i),坐标轴与摄像机坐标系一致,Xi和Yi位于图像平面上,Oi 像素坐标系的坐标为(xp0,yp0)。

一、实训背景随着工业自动化程度的不断提高,机器视觉检测技术在工业生产中的应用越来越广泛。

为了提高产品质量和生产效率,降低人工成本,我国各大企业纷纷引进视觉检测设备。

本实训旨在通过实际操作,使学生了解视觉检测的基本原理、设备配置及应用,掌握视觉检测系统的设计、调试和优化方法。

二、实训目标1. 理解视觉检测的基本原理和流程;2. 掌握视觉检测系统的硬件配置和软件应用;3. 学会使用视觉检测设备进行产品检测;4. 提高实际操作能力,为今后从事相关工作打下基础。

三、实训内容1. 视觉检测基本原理视觉检测系统主要由光源、相机、图像采集卡、图像处理软件和执行机构组成。

系统通过光源照亮被检测物体,相机捕捉图像,图像采集卡将图像传输到计算机,计算机通过图像处理软件对图像进行分析和处理,最后由执行机构进行相应动作。

2. 视觉检测设备配置(1)光源:根据被检测物体的表面特性和检测要求选择合适的光源,如白光、红外光、紫外光等。

(2)相机:根据检测精度和分辨率要求选择合适的相机,如CCD相机、CMOS相机等。

(3)图像采集卡:用于将相机捕捉的图像传输到计算机。

(4)图像处理软件:对图像进行预处理、特征提取、目标识别、定位和跟踪等操作。

(5)执行机构:根据检测结果进行相应动作,如剔除不良品、标记缺陷等。

3. 视觉检测系统设计(1)确定检测任务:根据产品特性和质量要求,明确检测任务,如尺寸测量、缺陷检测、外观检测等。

(2)选择检测方法:根据检测任务选择合适的检测方法,如基于模板匹配、基于特征匹配、基于机器学习等。

(3)搭建检测系统:根据检测方法和要求,搭建视觉检测系统,包括硬件配置和软件编程。

(4)系统调试与优化:对系统进行调试,确保检测精度和稳定性。

根据实际检测效果,对系统进行优化,提高检测效率和准确性。

4. 实训案例以某电子元件外观检测为例,具体步骤如下:(1)确定检测任务:检测电子元件的外观缺陷,如划痕、气泡、变形等。

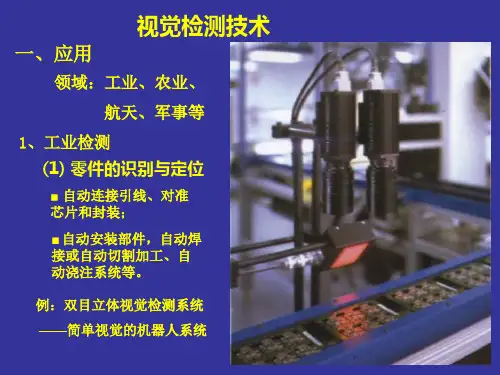

机器视觉检测系统1.引言现代工业自动化生产中涉及到各种各样的检验、生产监视和零件识别应用,如汽车零配件批量加工的尺寸检查和自动装配的完整性检查、电子装配线的元件自动定位、IC上的字符识别等。

通常这种带有高度重复性和智能性的工作是由肉眼来完成的,但在某些特殊情况下,如对微小尺寸的精确快速测量、形状匹配以及颜色辨识等,依靠肉眼根本无法连续稳定地进行,其它物理量传感器也难以胜任。

人们开始考虑用CCD照相机抓取图像后送入计算机或专用的图像处理模块,通过数字化处理,根据像素分布和亮度、颜色等信息来进行尺寸、形状、颜色等的判别。

这种方法是把计算机处理的快速性、可重复性与肉眼视觉的高度智能化和抽象能力相结合,由此产生了机器视觉检测技术的概念。

视觉检测技术是建立在计算机视觉研究基础上的一门新兴测试技术。

与计算机视觉研究的视觉模式识别、视觉理解等内容不同,视觉检测技术重点研究的是物体的几何尺寸及物体的位置测量,如轿车白车身三维尺寸的测量、模具等三维面形的快速测量、大型工件同轴度测量以及共面性测量等,它可以广泛应用于在线测量、逆向工程等主动、实时测量过程。

视觉检测技术在国外发展很快,早在20世纪80年代,美国国家标准局就曾预计未来90%的检测任务将由视觉检测系统来完成。

因此仅在80年代,美国就有100多家公司跻身于视觉检测系统的经营市场,可见视觉检测系统确实很有发展前途。

在近几届北京国际机床展览会上已经见到国外企业展出的应用视觉检测技术研制的先进仪器,如流动式光学三坐标测量机、高速高精度数字化扫描系统、非接触式光学三坐标测量机等。

2.机器视觉检测系统构成、分类及工作原理2.1 系统构成与工作原理(1)系统构成典型的视觉系统一般包括光源、镜头、CCD照相机、图像处理单元(或图像采集卡)、图像处理软件、监视器、通讯/输入输出单元等。

(2)工作原理视觉系统的输出并非图像视频信号,而是经过运算处理之后的检测结果(如尺寸数据)。

机器视觉系统的组成机器视觉系统是指用计算机来实现人的视觉功能,也就是用计算机来实现对客观的三维世界的识别。

按现在的理解,人类视觉系统的感受部分是视网膜,它是一个三维采样系统。

三维物体的可见部分投影到网膜上,人们按照投影到视网膜上的二维的像来对该物体进行三维理解。

所谓三维理解是指对被观察对象的形状、尺寸、离开观察点的距离、质地和运动特征(方向和速度)等的理解。

机器视觉系统的输入装置可以是摄像机、转鼓等,它们都把三维的影像作为输入源,即输入计算机的就是三维管观世界的二维投影。

如果把三维客观世界到二维投影像看作是一种正变换的话,则机器视觉系统所要做的是从这种二维投影图像到三维客观世界的逆变换,也就是根据这种二维投影图像去重建三维的客观世界。

机器视觉系统主要由三部分组成:图像的获取、图像的处理和分析、输出或显示。

将近80%的工业视觉系统主要用在检测方面,包括用于提高生产效率、控制生产过程中的产品质量、采集产品数据等。

产品的分类和选择也集成于检测功能中。

下面通过一个用于生产线上的单摄像机视觉系统,说明系统的组成及功能。

视觉系统检测生产线上的产品,决定产品是否符合质量要求,并根据结果,产生相应的信号输入上位机。

图像获取设备包括光源、摄像机等;图像处理设备包括相应的软件和硬件系统;输出设备是与制造过程相连的有关系统,包括过程控制器和报警装置等。

数据传输到计算机,进行分析和产品控制,若发现不合格品,则报警器告警,并将其排除出生产线。

机器视觉的结果是CAQ系统的质量信息来源,也可以和CIMS其它系统集成。

图像的获取图像的获取实际上是将被测物体的可视化图像和内在特征转换成能被计算机处理的一系列数据,它主要由三部分组成:*照明*图像聚焦形成*图像确定和形成摄像机输出信号1、照明照明和影响机器视觉系统输入的重要因素,因为它直接影响输入数据的质量和至少3 0%的应用效果。

由于没有通用的机器视觉照明设备,所以针对每个特定的应用实例,要选择相应的照明装置,以达到最佳效果。

机器人视觉系统的组成概述机器人视觉系统是现代机器人的重要组成部分之一,它模拟人类的视觉能力,通过计算机视觉和图像处理技术,使机器人能够感知和理解周围环境中的视觉信息。

机器人视觉系统的发展对于机器人在工业、军事、医疗等领域的应用起到了至关重要的作用。

组件机器人视觉系统主要由以下几个组件构成:1. 摄像头摄像头是机器人视觉系统的输入设备,用于获取周围环境的图像信息。

摄像头的选择对于机器人的视觉能力起到决定性的作用。

常见的摄像头类型包括CCD和CMOS传感器,它们具有不同的分辨率、帧率和灵敏度,以适应不同的应用场景。

2. 图像采集与预处理机器人摄像头获取的图像数据需要经过采集和预处理的步骤,以提高图像质量和信息的可用性。

图像采集和预处理包括白平衡、图像去噪、图像增强等操作,可以提高图像的清晰度、对比度和色彩准确性。

3. 物体检测与识别物体检测与识别是机器人视觉系统的核心任务之一,它通过分析图像中的像素信息,识别并定位图像中的物体。

常用的物体检测与识别算法包括卷积神经网络(CNN)、支持向量机(SVM)等。

这些算法通过机器学习的方法,从大量的训练数据中学习物体的特征,并能够在新的图像中对未知物体进行准确的识别。

物体检测与识别的技术1.特征提取:通过提取物体的颜色、纹理、形状等特征,将图像中的物体与背景进行区分。

2.物体定位:通过计算图像中物体的位置和姿态,确定物体在三维空间中的位置和姿态。

3.物体分类:通过对特征向量的分析和模式匹配,将物体分类为不同的类别。

4. 目标跟踪目标跟踪是机器人视觉系统的另一个重要任务,它可以追踪特定对象的运动轨迹,并实时更新物体的位置信息。

常见的目标跟踪算法包括卡尔曼滤波器、粒子滤波器等。

这些算法通过对物体位置的预测和测量,实现对物体运动的准确跟踪。

5. 场景理解与分析场景理解与分析是机器人视觉系统的高级功能之一,它通过对图像中的场景进行分析和推理,实现对环境的理解和认知。

场景理解与分析需要结合图像语义分割、目标识别和语义推理等技术,从图像中提取出语义信息并进行推理和决策。

无缺陷有缺陷的包装异物附着与盖子移位检验马达电线的包装或焊接缺陷C =B = 视野(Y)(Y)下表显示不同相机类型与视野所对应的最小可检测尺寸。

假定图像处理系统的最小可检测像素尺寸为理想值,即 2 个像素。

如果最小可检测像素尺寸假定是 4 个像素,则其结果将翻一倍。

上表中的数字仅为理论数字,具体由检测条件而定。

在本示例中,捕获目标的视野 (B) 在 10 mm 至 100 mm 之间不等,具体取决于应用所选定的镜头尺寸。

CCD 的像素数量根据所使用的相机而有所不同。

标准尺寸 24 万像素 CCD 在 Y 方向 (A) 上的像素数量为 480 个像素,而百万像素型,如二百万像素 CCD 的这个数量则是 1200 个像素。

CCD 上最小可检测尺寸 (C) 是1个像素,但最好给瑕疵检测应用设置2 至 4 个像素。

现在来估算一下使用百万像素相机在 60 mm 视野 (B) 时的最小可检测瑕疵尺寸。

假定最小可检测像素尺寸 (C) 为理想值,即 2 个像素。

如果将A = 1200 个像素、B = 60 mm 、C = 2 个像素指定给前述公式:相机24 万像素200 万像素CCD 的像素数量(Y 方向)480 个像素1200 个像素视野 [mm]1030501002005000.040.130.210.420.83 2.080.020.050.080.170.330.83基本原理最小可检测尺寸 = 60 x 2 ÷ 1200 = 0.1 mm图像模糊高速快门图像低速快门图像例如:要求的最小可检测瑕疵尺寸 = 1 mm生产线速度 = 1 m/sec.快门速度 = 1 mm ÷ 5 ÷ 1000 mm/sec. = 1/5000理想的快门速度是 1/5000。

最大生产线速度LED 上的瑕疵S检测原理(当检测方向指定为X时)KC1-0109 Copyright (c) 2007 KEYENCE CORPORATION. All rights reserved. CVInspection1-KC-L-CS 0129-1 E 642154 Printed in Japan*642154*。

机器⼈视觉系统组成及定位算法1.机器⼈视觉机器⼈研究的核⼼就是:导航定位、路径规划、避障、多传感器融合。

定位技术有⼏种,不关⼼,只关⼼视觉的。

视觉技术⽤到“眼睛”可以分为:单⽬,双⽬,多⽬、RGB-D,后三种可以使图像有深度,这些眼睛亦可称为VO(视觉⾥程计:单⽬or⽴体),维基百科给出的介绍:在机器⼈和计算机视觉问题中,视觉⾥程计就是⼀个通过分析处理相关图像序列来确定机器⼈的位置和姿态。

当今,由于数字图像处理和计算机视觉技术的迅速发展,越来越多的研究者采⽤摄像机作为全⾃主⽤移动机器⼈的感知传感器。

这主要是因为原来的超声或红外传感器感知信息量有限,鲁棒性差,⽽视觉系统则可以弥补这些缺点。

⽽现实世界是三维的,⽽投射于摄像镜头(CCD/CMOS)上的图像则是⼆维的,视觉处理的最终⽬的就是要从感知到的⼆维图像中提取有关的三维世界信息。

2.系统基本组成: CCD、PCI、PC及其外设等。

2.1 CCD/CMOS⼀⾏硅成像元素,在⼀个衬底上配置光敏元件和电荷转移器件,通过电荷的依次转移,将多个象素的视频信号分时、顺序地取出来,如⾯阵CCD传感器采集的图像的分辨率可以从32×32到1024×1024像素等。

2.2视频数字信号处理器图像信号⼀般是⼆维信号,⼀幅图像通常由512×512个像素组成(当然有时也有256×256,或者1024×1024个像素),每个像素有256级灰度,或者是3×8bit,红黄兰16M种颜⾊,⼀幅图像就有256KB或者768KB(对于彩⾊)个数据。

为了完成视觉处理的传感、预处理、分割、描述、识别和解释,上述前⼏项主要完成的数学运算可归纳为:(1)点处理常⽤于对⽐度增强、密度⾮线性较正、阈值处理、伪彩⾊处理等。

每个像素的输⼊数据经过⼀定关系映射成像素的输出数据,例如对数变换可实现暗区对⽐度扩张。

(2)⼆维卷积的运算常⽤于图像平滑、尖锐化、轮廓增强、空间滤波、标准模板匹配计算等。