3种线性分类器的设计及MATLAB建模

- 格式:pdf

- 大小:565.68 KB

- 文档页数:13

利用Matlab进行数据聚类与分类的方法导言在当今大数据时代,处理和分析庞大的数据成为许多领域的重要任务,而数据聚类与分类是其中重要的一环。

Matlab作为一种功能强大的编程语言和工具,在数据聚类与分类方面具有广泛的应用。

本文将介绍利用Matlab进行数据聚类与分类的常用方法和技巧。

一、数据聚类的概念与方法1.1 数据聚类的定义数据聚类是指将具有相似特征的数据对象自动分成若干组的过程,旨在将相似的数据归为一类,不相似的数据分开。

1.2 常用的数据聚类方法- K-means聚类算法:K-means是一种常见且简单的数据聚类方法,通过迭代优化的方式将数据划分成K个簇。

- 层次聚类算法:层次聚类是一种基于树形结构的聚类方法,它将数据逐步合并或分裂,直到得到最终的聚类结果。

- 密度聚类算法:密度聚类根据数据点的密度特征进行聚类,能够有效地发现任意形状和大小的聚类簇。

- 谱聚类算法:谱聚类结合图论的思想,通过计算数据的拉普拉斯矩阵特征向量,将数据聚类成多个划分。

二、利用Matlab进行数据聚类2.1 准备工作在使用Matlab进行数据聚类之前,需要准备好数据集。

通常,数据集需要进行预处理,包括数据清洗、特征选择和降维等步骤。

2.2 K-means聚类利用Matlab的统计工具箱,可以轻松实现K-means聚类算法。

首先,将数据集读入Matlab并进行必要的归一化处理。

然后,使用kmeans函数运行K-means聚类算法,指定聚类的簇数K和迭代次数等参数。

最后,根据聚类结果进行数据可视化或进一步的分析。

2.3 层次聚类Matlab中的cluster函数提供了层次聚类的功能。

将数据集转换为距离矩阵,然后调用cluster函数即可实现层次聚类。

该函数支持不同的聚类算法和距离度量方法,用户可以根据具体需求进行调整。

2.4 密度聚类实现密度聚类可以使用Matlab中的DBSCAN函数。

DBSCAN是一种基于密度的聚类算法,它通过确定数据点的领域密度来判定是否为核心对象,并通过核心对象的连接性将数据点分为不同的簇。

三分类混淆矩阵计算matlab1. 介绍三分类混淆矩阵是在机器学习和统计学中经常使用的一种工具,用于评估分类模型的性能。

在实际应用中,我们经常会遇到多分类的问题,而混淆矩阵可以帮助我们直观地了解分类模型的分类准确度和误差情况。

在本文中,我们将介绍如何使用Matlab来计算三分类混淆矩阵。

2. 数据准备在计算混淆矩阵之前,我们首先需要准备好分类模型的预测结果和真实标签。

假设我们有一个三分类的问题,那么我们的真实标签一般是一个包含三个类别的向量,而预测结果也是一个包含三个类别的向量。

在Matlab中,我们可以使用以下代码来生成一个示例的真实标签和预测结果:```matlabtrue_labels = [1, 2, 3, 1, 2, 3, 1, 2, 3]; 真实标签predicted_labels = [1, 2, 3, 1, 1, 2, 3, 2, 1]; 预测结果```3. 计算混淆矩阵计算混淆矩阵是计算分类模型性能的第一步。

在Matlab中,我们可以使用confusionmat函数来计算混淆矩阵。

该函数的输入是真实标签和预测结果,输出是一个三行三列的混淆矩阵,每行代表一个真实类别,每列代表一个预测类别。

以下是使用confusionmat函数计算混淆矩阵的代码:```matlabC = confusionmat(true_labels, predicted_labels); 计算混淆矩阵 disp(C); 显示混淆矩阵```4. 混淆矩阵结果解读当我们得到混淆矩阵之后,我们就可以根据混淆矩阵来评估分类模型的性能。

在混淆矩阵中,每个元素代表了模型将一个类别误分为另一个类别的次数。

通过仔细观察混淆矩阵的结果,我们可以得出模型的准确率、召回率、F1值等性能指标。

我们还可以根据混淆矩阵来调整分类模型的参数,以提高模型的分类准确度。

5. 总结本文介绍了如何使用Matlab来计算三分类混淆矩阵。

通过计算混淆矩阵,我们可以直观地了解分类模型的性能,从而可以根据混淆矩阵来优化分类模型。

matlab数学建模100例Matlab是一种强大的数学建模工具,广泛应用于科学研究、工程设计和数据分析等领域。

在这篇文章中,我们将介绍100个使用Matlab进行数学建模的例子,帮助读者更好地理解和应用这个工具。

1. 线性回归模型:使用Matlab拟合一组数据点,得到最佳拟合直线。

2. 多项式拟合:使用Matlab拟合一组数据点,得到最佳拟合多项式。

3. 非线性回归模型:使用Matlab拟合一组数据点,得到最佳拟合曲线。

4. 插值模型:使用Matlab根据已知数据点,估计未知数据点的值。

5. 数值积分:使用Matlab计算函数的定积分。

6. 微分方程求解:使用Matlab求解常微分方程。

7. 矩阵运算:使用Matlab进行矩阵的加减乘除运算。

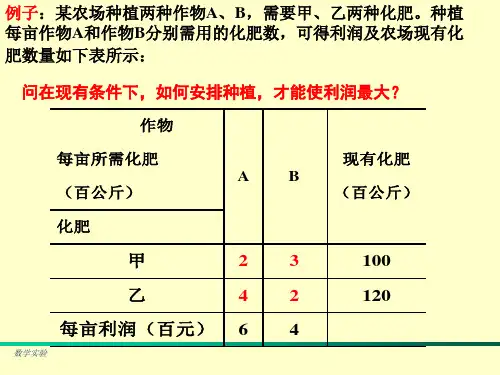

8. 线性规划:使用Matlab求解线性规划问题。

9. 非线性规划:使用Matlab求解非线性规划问题。

10. 整数规划:使用Matlab求解整数规划问题。

11. 图论问题:使用Matlab解决图论问题,如最短路径、最小生成树等。

12. 网络流问题:使用Matlab解决网络流问题,如最大流、最小费用流等。

13. 动态规划:使用Matlab解决动态规划问题。

14. 遗传算法:使用Matlab实现遗传算法,求解优化问题。

15. 神经网络:使用Matlab实现神经网络,进行模式识别和预测等任务。

16. 支持向量机:使用Matlab实现支持向量机,进行分类和回归等任务。

17. 聚类分析:使用Matlab进行聚类分析,将数据点分成不同的类别。

18. 主成分分析:使用Matlab进行主成分分析,降低数据的维度。

19. 时间序列分析:使用Matlab进行时间序列分析,预测未来的趋势。

20. 图像处理:使用Matlab对图像进行处理,如滤波、边缘检测等。

21. 信号处理:使用Matlab对信号进行处理,如滤波、频谱分析等。

22. 控制系统设计:使用Matlab设计控制系统,如PID控制器等。

matlab数学建模常用模型及编程摘要:一、引言二、MATLAB 数学建模的基本概念1.矩阵的转置2.矩阵的旋转3.矩阵的左右翻转4.矩阵的上下翻转5.矩阵的逆三、MATLAB 数学建模的常用函数1.绘图函数2.坐标轴边界3.沿曲线绘制误差条4.在图形窗口中保留当前图形5.创建线条对象四、MATLAB 数学建模的实例1.牛顿第二定律2.第一级火箭模型五、结论正文:一、引言数学建模是一种将现实世界中的问题抽象成数学问题,然后通过数学方法来求解的过程。

在数学建模中,MATLAB 作为一种强大的数学软件,被广泛应用于各种数学问题的求解和模拟。

本文将介绍MATLAB 数学建模中的常用模型及编程方法。

二、MATLAB 数学建模的基本概念在使用MATLAB 进行数学建模之前,我们需要了解一些基本的概念,如矩阵的转置、旋转、左右翻转、上下翻转以及矩阵的逆等。

1.矩阵的转置矩阵的转置是指将矩阵的一行和一列互换,得到一个新的矩阵。

矩阵的转置运算符是单撇号(’)。

2.矩阵的旋转利用函数rot90(a,k) 将矩阵a 旋转90 的k 倍,当k 为1 时可省略。

3.矩阵的左右翻转对矩阵实施左右翻转是将原矩阵的第一列和最后一列调换,第二列和倒数第二列调换,依次类推。

matlab 对矩阵a 实施左右翻转的函数是fliplr(a)。

4.矩阵的上下翻转matlab 对矩阵a 实施上下翻转的函数是flipud(a)。

5.矩阵的逆对于一个方阵a,如果存在一个与其同阶的方阵b,使得:a·bb·a=|a|·|b|·I,则称矩阵b 是矩阵a 的逆矩阵。

其中,|a|表示矩阵a 的行列式,I 是单位矩阵。

在MATLAB 中,我们可以使用函数inv(a) 来求解矩阵a 的逆矩阵。

三、MATLAB 数学建模的常用函数在MATLAB 数学建模过程中,我们经常需要使用一些绘图和数据处理函数,如绘图函数、坐标轴边界、沿曲线绘制误差条、在图形窗口中保留当前图形、创建线条对象等。

BP-ANN分类器设计1.引言从深层意义上看,模式识别和人工智能本质都是在解决如何让用机器模拟人脑认知的过程。

一方面,从需要实现的功能出发,我们可以将目标分解为子功能,采用自定而下的的分解法实现我们需要的拟合算法。

而另一方面,无论人脑多么复杂,人类的认知过程都可以认为若干个神经元组成的神经网络在一定机制下经由复杂映射产生的结果。

从神经元的基本功能出发,采用自下而上的设计方法,从简单到复杂,也是实现拟合算法的一条高效途径。

1.1什么是人工神经网络人工神经网络(Artificial Neural Network,ANN)是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型。

在工程与学术界也常直接简称为神经网络或类神经网络。

神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。

每个节点代表一种特定的输出函数,称为激励函数(activation function)。

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。

网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

人工神经网络是由大量处理单元互联组成的非线性、自适应信息处理系统。

它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理、记忆信息的方式进行信息处理。

人工神经网络具有四个基本特征:(1)非线性非线性关系是自然界的普遍特性。

大脑的智慧就是一种非线性现象。

人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系。

具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量。

(2)非局限性一个神经网络通常由多个神经元广泛连接而成。

一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定。

通过单元之间的大量连接模拟大脑的非局限性。

matlab分类器算法Matlab是一种常用的科学计算工具,广泛应用于数据分析、图像处理、机器学习等领域。

其中,分类器算法是机器学习中常用的一种技术,可以根据已有的数据集对新的数据进行分类。

本文将介绍几种常用的Matlab分类器算法,并分析其原理和应用。

一、K近邻算法K近邻算法是一种基本的分类器算法,其原理是找出与待分类样本最相似的K个训练样本,然后根据这K个样本的标签进行投票决定待分类样本的类别。

在Matlab中,可以使用fitcknn函数实现K近邻分类器。

该函数可以设置K值、距离度量方法等参数,以适应不同的分类任务。

二、支持向量机算法支持向量机是一种经典的二分类算法,其目标是找到一个超平面,将两个不同类别的样本分隔开来,并使得超平面到最近样本的距离最大化。

在Matlab中,可以使用fitcsvm函数实现支持向量机分类器。

该函数可以设置核函数、惩罚系数等参数,以适应不同的分类任务。

三、决策树算法决策树是一种简单而有效的分类器算法,其原理是通过对特征的逐次划分,将数据集划分为不同的子集,直到子集中的样本属于同一类别或无法再进行划分为止。

在Matlab中,可以使用fitctree函数实现决策树分类器。

该函数可以设置最大深度、最小叶节点数等参数,以控制决策树的复杂度和泛化能力。

四、朴素贝叶斯算法朴素贝叶斯算法是一种基于贝叶斯定理和特征条件独立性假设的分类器算法,其原理是通过计算待分类样本属于每个类别的概率,并选择概率最大的类别作为分类结果。

在Matlab中,可以使用fitcnb函数实现朴素贝叶斯分类器。

该函数可以设置类别先验概率、特征条件概率等参数,以适应不同的分类任务。

五、神经网络算法神经网络是一种模拟生物神经网络结构和功能的计算模型,具有良好的非线性拟合能力和适应性。

在Matlab中,可以使用patternnet函数实现基于多层感知器的神经网络分类器。

该函数可以设置隐藏层数、神经元个数等参数,以控制神经网络的复杂度和性能。

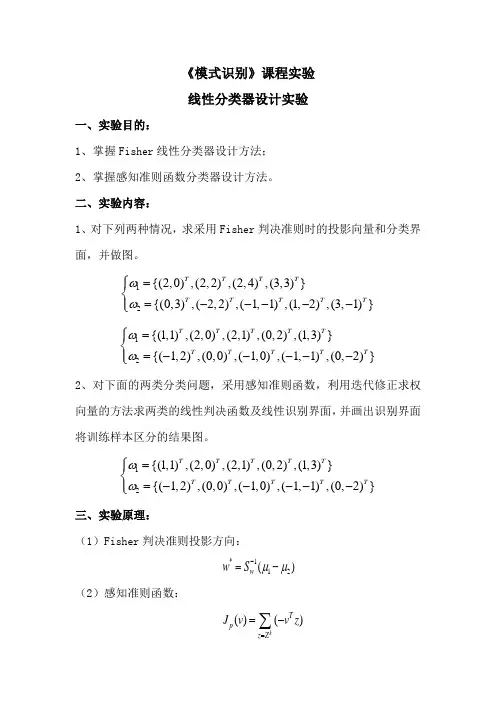

《模式识别》课程实验线性分类器设计实验一、实验目的:1、掌握Fisher 线性分类器设计方法;2、掌握感知准则函数分类器设计方法。

二、实验内容:1、对下列两种情况,求采用Fisher 判决准则时的投影向量和分类界面,并做图。

12{(2,0),(2,2),(2,4),(3,3)}{(0,3),(2,2),(1,1),(1,2),(3,1)}T T T T T T T T T ωω⎧=⎪⎨=-----⎪⎩ 12{(1,1),(2,0),(2,1),(0,2),(1,3)}{(1,2),(0,0),(1,0),(1,1),(0,2)}T T T T T T T T T T ωω⎧=⎪⎨=-----⎪⎩ 2、对下面的两类分类问题,采用感知准则函数,利用迭代修正求权向量的方法求两类的线性判决函数及线性识别界面,并画出识别界面将训练样本区分的结果图。

12{(1,1),(2,0),(2,1),(0,2),(1,3)}{(1,2),(0,0),(1,0),(1,1),(0,2)}T T T T T T T T T T ωω⎧=⎪⎨=-----⎪⎩ 三、实验原理:(1)Fisher 判决准则投影方向:*112()w w S μμ-=-(2)感知准则函数:()()kT p z Z J v v z ==-∑当k Z为空时,即()0J v ,*v即为所求p四、解题思路:1、fisher线性判决器:A.用mean函数求两类样本的均值B.求两类样本的均值的类内离散矩阵SiC.利用类内离散矩阵求总类内离散矩阵SwD.求最佳投影方向WoE.定义阈值,并求得分界面2、感知准则函数分类器:A.获得增广样本向量和初始增广权向量B.对样本进行规范化处理C.获得解区,并用权向量迭代修正错分样本集,得到最终解区五、实验结果:1、fisher线性判决分类器:条件:取pw1=pw2=0.5,阈值系数为0.5A.第一种情况B.第二种情况2、感知准则函数判决:条件:取步长row为1判决结果:六、结果分析:1、fisher线性判决器中,调整阈值系数时,分界面会随之平行上下移动,通过调整阈值系数的大小,就能比较合理的得到分界面。

题目: 最小二乘法线性分类器设计讲课老师:学生姓名:所属院系:专业:学号:最小二乘法线性分类器设计1 描述1.1最小二乘法原理的概述最小二乘法原理是指测量结果的最可信赖值应在残余误差平方和为最小的条件下求出。

从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =。

函数()p x 称为拟合函数或最小二乘解,求拟合函数()p x 的方法称为曲线拟合的最小二乘法。

1.2 最小二乘法的基本原理最小二乘法又称曲线拟合,所谓“拟合”即不要求所作的曲线完全通过所有的数据点,只要求所得的曲线能反映数据的基本趋势。

曲线拟合的几何解释:求一条曲线,使数据点均在离此曲线的上方或下方不远处。

从整体上考虑近似函数()p x 同所给数据点(,),i i x y m L (i=0,1,)误差()(0,1,,)i i i r p x y i m =-=L 的大小,常用的方法有以下三种:一是误差 ()(0,1,,)i i i r p x y i m =-=L 绝对值的最大值1max i i mr ≤≤,即误差向量01(,,,)T m r r r r =L 的∞—范数;二是误差绝对值的和mii r=∑,即误差向量r 的1—范数;三是误差平方和20mi i r =∑的算术平方根,即误差向量r 的2—范数;前两种方法简单、自然,但不便于微分运算 ,后一种方法相当于考虑 2—范数的平方,因此在曲线拟合中常采用误差平方和20mi i r =∑来 度量误差i r (i=0,1,…,m)的整体大小。

数据拟合的具体作法是:对给定数据(,)i i x y (i=0,1,…,m),在取定的函数类Φ中,求()p x ∈Φ,使误差()i i i r p x y =- (i=0,1,…,m)的平方和最小,即从几何意义上讲,就是寻求与给定点(,)i i x y (i=0,1,…,m)的距离平方和为最小的曲线()y p x =(图1)。

线性分类算法举例1.用于回归的线性模型线性模型也广泛应用于分类问题,预测公式如下:这个公式看起来与线性回归公式非常相似,但是我们没有返回特征的加权求和,而是为预测设置了阈值(0)。

如果函数值小于0,我们就预测类别-1;若函数值大于0,我们就预测类别+1。

对于用于回归的线性模型,输出y是特征的线性函数,是直线,平面或者超平面(对于更高维的数据集)对于用于分类的线性模型,决策边界是输入的线性函数。

换句话说,(二元)线性分类器是利用直线,平面或者超平面来分开两个类别的分类器。

学习线性模型有很多算法,这些算法的区别在于以下两点:系数和截距的特定组合对训练数据拟合好坏的度量方法;是否使用正则化,以及使用哪种正则化方法。

最常见的两种线性分类算法是**Logistic回归**(logistic regression)和线性支持向量机(linear support vector machine,线性SVM)我们将LogisticRegression和LinearSVC模型应用到forge数据集,并将线性模型找到的决策边界可视化:图为线性SVM和Logistic回归在forge数据集上的决策边界在这张图中,forge数据集的第一个特征位于x轴,第二个特征位于y轴,与前面相同。

位于黑线上方的新数据点被划为类别1,而在黑线下方的数据点会被划为类别0。

两个模型都得到了相似的决策边界,都默认使用L2正则化对于LogisticRegression和LinearSCV,决定正则化强度的权衡参数叫做C。

C值越大,对应正则化越弱,也就是说,参数C的值较大,那么两个模型将尽可能将训练集拟合到最好;如果C的值较小,那么模型更强调是系数w接近于0.参数C的作用还有另一个有趣之处。

较小的C可以让算法尽量适应“大多数”数据点,而较大的C值更强调每个数据点都分类正确的重要性。

在左图中,C的值最小,对应强正则化;大部分属于类别0的点都位于底部,大部分属于类别1的点都位于顶部。

线性分类器设计(张天航空天科学技术研究院201121250314)1 问题描述对“data1.m”数据,分别采用感知机算法、最小平方误差算法、线性SVM算法设计分类器,分别画出决策面,并比较性能。

(注意讨论算法中参数设置的影响。

)2 方法描述2.1 感知机算法线性分类器的第一个迭代算法是1956年由Frank Rosenblatt提出的,即具有自学习能力的感知器(Perceptron)神经网络模型,用来模拟动物或者人脑的感知和学习能力。

这个算法被提出后,受到了很大的关注。

感知器在神经网络发展的历史上占据着特殊的位置:它是第一个从算法上完整描述的神经网络,是一种具有分层神经网络结构、神经元之间有自适应权相连接的神经网络的一个基本网络。

感知器的学习过程是不断改变权向量的输入,更新结构中的可变参数,最后实现在有限次迭代之后的收敛。

感知器的基本模型结构如图1所示:图1 感知器基本模型其中,X输入,Xi表示的是第i个输入;Y表示输出;W表示权向量;w0是阈值,f 是一个阶跃函数。

感知器实现样本的线性分类主要过程是:特征向量的元素x1,x2,……,xk是网络的输入元素,每一个元素与相应的权wi相乘。

,乘积相加后再与阈值w0相加,结果通过f函数执行激活功能,f为系统的激活函数。

因为f是一个阶跃函数,故当自变量小于0时,f= -1;当自变量大于0时,f= 1。

这样,根据输出信号Y,把相应的特征向量分到为两类。

然而,权向量w并不是一个已知的参数,故感知器算法很重要的一个步骤即是寻找一个合理的决策超平面。

故设这个超平面为w,满足:12*0,*0,T Tw x x w x x ωω>∀∈<∀∈ (1)引入一个代价函数,定义为:()**T x x YJ w w xδ∈=∑ (2)其中,Y 是权向量w 定义的超平面错误分类的训练向量的子集。

变量x δ定义为:当1x ω∈时,x δ= -1;当2x ω∈时,x δ= +1。

matlab多分类方法Matlab是一种常用的科学计算软件,广泛应用于工程、数学、物理等领域的数据分析和模型建立。

在机器学习中,多分类问题是一个重要的研究方向。

本文将介绍一些常用的Matlab多分类方法,并探讨它们的优缺点。

1. 逻辑回归(Logistic Regression)逻辑回归是一种广义线性模型,常用于解决二分类问题。

通过对输入数据进行线性组合并经过sigmoid函数映射(将输出限制在0到1之间),可以得到分类结果。

在Matlab中,可以使用fitglm函数实现逻辑回归,并利用分类评估指标(如准确率、查准率和查全率)来评估模型的性能。

2. 支持向量机(Support Vector Machine)支持向量机是一种常用的分类算法,在多分类问题中也有广泛的应用。

它通过找到一个最优超平面将不同类别的样本分开,从而实现分类。

在Matlab中,可以使用fitcecoc函数实现支持向量机的多分类,其中cecoc表示错误纠错输出码。

支持向量机在处理高维数据和非线性问题上表现较好,但对于大规模数据集可能计算复杂度较高。

3. 决策树(Decision Tree)决策树是一种基于树状结构的分类方法,通过一系列的特征判断逐步分类数据。

在Matlab中,可以使用fitctree函数实现决策树算法。

决策树易于理解和解释,但容易产生过拟合,并且对于噪声较大的数据可能不稳定。

4. 集成学习(Ensemble Learning)集成学习通过组合多个基分类器的预测结果,提高分类的准确性和鲁棒性。

常见的集成学习方法包括随机森林(Random Forest)和Adaboost。

在Matlab中,可以使用TreeBagger函数实现随机森林,在fitensemble函数中选择Adaboost算法。

集成学习适用于高维数据和复杂分类问题,能够有效地减少过拟合。

5. 神经网络(Neural Network)神经网络是一种模拟生物神经系统工作原理的机器学习算法。

一 、基于F i s h e r 准则线性分类器设计1、 实验内容:已知有两类数据1ω和2ω二者的概率已知1)(ωp =0.6,2)(ωp =0.4。

1ω中数据点的坐标对应一一如下:数据:x =0.2331 1.5207 0.6499 0.7757 1.0524 1.1974 0.2908 0.2518 0.6682 0.5622 0.9023 0.1333 -0.5431 0.9407 -0.2126 0.0507 -0.0810 0.7315 0.3345 1.0650 -0.0247 0.1043 0.3122 0.6655 0.5838 1.1653 1.2653 0.8137 -0.3399 0.5152 0.7226 -0.2015 0.4070 -0.1717 -1.0573 -0.2099 y =2.3385 2.1946 1.6730 1.6365 1.7844 2.0155 2.0681 2.1213 2.4797 1.5118 1.9692 1.8340 1.8704 2.2948 1.7714 2.3939 1.5648 1.9329 2.2027 2.4568 1.7523 1.6991 2.4883 1.7259 2.0466 2.0226 2.3757 1.7987 2.0828 2.0798 1.9449 2.3801 2.2373 2.1614 1.9235 2.2604 z =0.5338 0.8514 1.0831 0.4164 1.1176 0.5536 0.6071 0.4439 0.4928 0.5901 1.0927 1.0756 1.0072 0.4272 0.4353 0.9869 0.4841 1.09921.02990.71271.01240.45760.85441.12750.77050.41291.00850.76760.84180.87840.97510.78400.41581.03150.75330.9548数据点的对应的三维坐标为2x2 =1.40101.23012.08141.16551.37401.18291.76321.97392.41522.58902.84721.95391.25001.28641.26142.00712.18311.79091.33221.14661.70871.59202.93531.46642.93131.83491.83402.50962.71982.31482.03532.60301.23272.14651.56732.9414 y2 =1.02980.96110.91541.49010.82000.93991.14051.06780.80501.28891.46011.43340.70911.29421.37440.93871.22661.18330.87980.55920.51500.99830.91200.71261.28331.10291.26800.71401.24461.33921.18080.55031.47081.14350.76791.1288 z2 =0.62101.36560.54980.67080.89321.43420.95080.73240.57841.49431.09150.76441.21591.30491.14080.93980.61970.66031.39281.40840.69090.84000.53811.37290.77310.73191.34390.81420.95860.73790.75480.73930.67390.86511.36991.1458数据的样本点分布如下图:1)请把数据作为样本,根据Fisher选择投影方向W的原则,使原样本向量在该方向上的投影能兼顾类间分布尽可能分开,类内样本投影尽可能密集的要求,求出评价投影方向W的函数,并在图形表示出来。

matlab对三维数据的svm分类1.引言1.1 概述概述部分的内容可以包括对SVM分类算法和三维数据的概述。

在本文中,我们将探讨如何使用MATLAB来对三维数据进行支持向量机(SVM)分类。

SVM是一种常用的机器学习算法,可以用于二分类和多分类问题。

它通过寻找一个最优的超平面来将不同类别的数据分开,从而实现分类的目的。

三维数据是指具有三个特征向量的数据集。

这种类型的数据在许多领域中都很常见,例如医学图像处理、计算机视觉和工程分析等。

对于三维数据的分类,我们需要首先对数据进行表示和处理,以便用于SVM算法的输入。

本文的目的是介绍如何使用MATLAB对三维数据进行SVM分类。

我们将从SVM分类算法的基本原理开始,然后讨论如何表示和处理三维数据。

通过实验和结果分析,我们将评估SVM在三维数据分类中的性能,并总结结论。

通过本文的阅读,读者将能够了解SVM算法的基本原理、三维数据的表示和处理方法以及MATLAB在这方面的应用。

这将有助于读者在实际问题中应用SVM算法进行三维数据的分类分析。

1.2文章结构文章结构部分的内容可以按照以下方式编写:本文主要分为引言、正文和结论三个部分。

具体结构如下:2.正文正文部分主要包括两个主题:SVM分类算法和三维数据的表示和处理。

2.1 SVM分类算法在这个部分中,将介绍SVM分类算法的基本原理和步骤。

首先,会对支持向量机(SVM)进行简要的概述,包括其分类原理和优点。

然后,会详细介绍SVM分类算法的步骤,包括数据预处理、选择适当的核函数以及参数的调优等。

同时,还会讨论如何解决线性不可分数据和多类别分类的问题,并列举一些常用的SVM分类器的变形和扩展。

2.2 三维数据的表示和处理在这一部分中,将探讨如何在Matlab中表示和处理三维数据。

首先,会介绍三维数据的基本概念和特点,以及在实际应用中的重要性。

然后,会详细介绍在Matlab中如何使用矩阵和数组表示三维数据,并介绍一些常用的数据结构和操作。