最优化共轭梯度法

- 格式:ppt

- 大小:703.00 KB

- 文档页数:5

最优化问题的算法迭代格式最优化问题的算法迭代格式最优化问题是指在一定的条件下,寻找使某个目标函数取得极值(最大值或最小值)的变量取值。

解决最优化问题的方法有很多种,其中较为常见的是迭代法。

本文将介绍几种常用的最优化问题迭代算法及其格式。

一、梯度下降法梯度下降法是一种基于负梯度方向进行搜索的迭代算法,它通过不断地沿着目标函数的负梯度方向进行搜索,逐步接近极值点。

该方法具有收敛速度快、易于实现等优点,在许多应用领域中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和学习率 $\alpha$,梯度下降算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 更新当前点 $x_k$ 为 $x_{k+1}=x_k-\alpha\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则返回第 1 步。

2. 算法特点- 沿着负梯度方向进行搜索,能够快速收敛;- 学习率的选择对算法效果有重要影响;- 可能会陷入局部极小值。

二、共轭梯度法共轭梯度法是一种基于线性方程组求解的迭代算法,它通过不断地搜索与当前搜索方向共轭的新搜索方向,并在该方向上进行一维搜索,逐步接近极值点。

该方法具有收敛速度快、内存占用少等优点,在大规模问题中被广泛使用。

1. 算法描述对于目标函数 $f(x)$,初始点 $x_0$ 和初始搜索方向 $d_0$,共轭梯度算法可以描述为以下步骤:- 计算当前点 $x_k$ 的梯度 $\nabla f(x_k)$;- 如果满足停止条件,则输出结果;否则进行下一步;- 计算当前搜索方向 $d_k$;- 在当前搜索方向上进行一维搜索,得到最优步长 $\alpha_k$;- 更新当前点为 $x_{k+1}=x_k+\alpha_k d_k$;- 计算新的搜索方向 $d_{k+1}$;- 返回第 2 步。

2. 算法特点- 搜索方向与前面所有搜索方向都正交,能够快速收敛;- 需要存储和计算大量中间变量,内存占用较大;- 可以用于非线性问题的求解。

共轭梯度法在优化问题中的应用共轭梯度法是一种高效的优化算法,在许多优化问题中都得到了广泛的应用。

它是一种迭代方法,用于解决最小化二次函数的优化问题。

在本文中,我将介绍共轭梯度法的原理和算法,并探讨它在优化问题中的应用。

一、共轭梯度法的原理共轭梯度法的核心思想是通过迭代的方式,找到一个与之前迭代步骤方向相互垂直的搜索方向,以加快收敛速度。

在每一次迭代中,共轭梯度法根据当前的搜索方向更新搜索点,直到找到最优解或达到预定的收敛标准。

具体来说,共轭梯度法从一个初始搜索点开始,计算对应的梯度,并沿着负梯度方向进行搜索。

通过一定的方法找到一个与之前搜索方向相互垂直的新搜索方向,并以一定步长更新搜索点。

迭代过程将重复进行,直到满足收敛标准或达到最大迭代次数。

二、共轭梯度法的算法共轭梯度法的算法包括以下几个步骤:1. 初始化搜索点x0和梯度g0,设置迭代次数k=0。

2. 计算当前搜索方向d_k=-g_k(k为当前迭代次数)。

3. 通过一维搜索方法找到最佳步长α_k。

4. 更新搜索点x_k+1 = x_k + α_k * d_k。

5. 计算更新后的梯度g_k+1。

6. 判断是否满足收敛标准,若满足则算法停止,否则转到步骤7。

7. 计算新的搜索方向β_k+1。

8. 将迭代次数k更新为k+1,转到步骤3。

这个算法保证了每一次迭代中的搜索方向都是彼此相互垂直的,从而加快了收敛速度。

三、共轭梯度法的应用共轭梯度法在优化问题中有广泛的应用,特别是在二次规划、线性规划和非线性规划等领域。

在二次规划问题中,共轭梯度法可以高效地求解线性系统Ax=b,其中A是一个对称正定的矩阵。

由于共轭梯度法的特性,它只需要进行n 次迭代,其中n是问题的维度,就能得到精确的解。

这使得共轭梯度法在大规模线性系统求解中具有重要的应用价值。

在线性规划问题中,共轭梯度法可以用于求解带有线性约束的最小二乘问题。

共轭梯度法通过将线性约束转化为一系列的正交子空间,从而在求解最小二乘问题时能够更快地收敛。

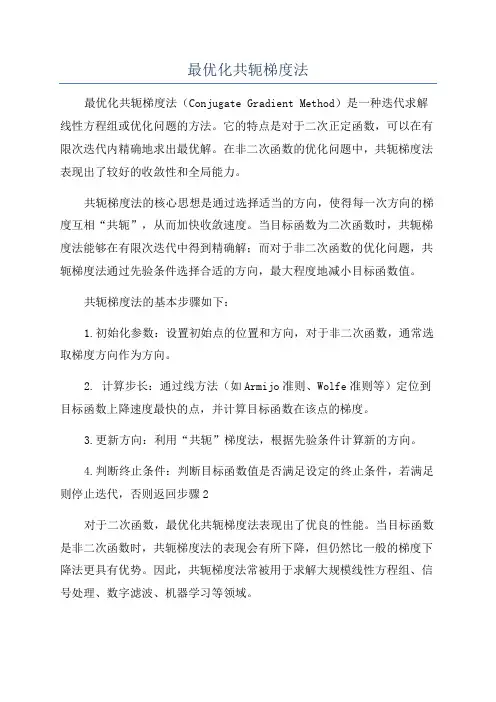

最优化共轭梯度法最优化共轭梯度法(Conjugate Gradient Method)是一种迭代求解线性方程组或优化问题的方法。

它的特点是对于二次正定函数,可以在有限次迭代内精确地求出最优解。

在非二次函数的优化问题中,共轭梯度法表现出了较好的收敛性和全局能力。

共轭梯度法的核心思想是通过选择适当的方向,使得每一次方向的梯度互相“共轭”,从而加快收敛速度。

当目标函数为二次函数时,共轭梯度法能够在有限次迭代中得到精确解;而对于非二次函数的优化问题,共轭梯度法通过先验条件选择合适的方向,最大程度地减小目标函数值。

共轭梯度法的基本步骤如下:1.初始化参数:设置初始点的位置和方向,对于非二次函数,通常选取梯度方向作为方向。

2. 计算步长:通过线方法(如Armijo准则、Wolfe准则等)定位到目标函数上降速度最快的点,并计算目标函数在该点的梯度。

3.更新方向:利用“共轭”梯度法,根据先验条件计算新的方向。

4.判断终止条件:判断目标函数值是否满足设定的终止条件,若满足则停止迭代,否则返回步骤2对于二次函数,最优化共轭梯度法表现出了优良的性能。

当目标函数是非二次函数时,共轭梯度法的表现会有所下降,但仍然比一般的梯度下降法更具有优势。

因此,共轭梯度法常被用于求解大规模线性方程组、信号处理、数字滤波、机器学习等领域。

最优化共轭梯度法的优点在于:收敛速度较快,全局能力较强,不需要存储海量信息。

然而,该方法也存在一些缺点。

首先,共轭梯度法对目标函数的性质有一定的要求,例如目标函数必须是光滑的,并且梯度向量必须是有效的。

其次,共轭梯度法对初始点的选择较为敏感,不同的初始点可能导致不同的解。

总结来说,最优化共轭梯度法是一种高效的优化算法,可以加快目标函数收敛速度,尤其适用于解决二次函数优化问题。

在非二次函数的优化问题中,共轭梯度法以其较好的收敛性和全局能力在实际应用中发挥着重要作用。

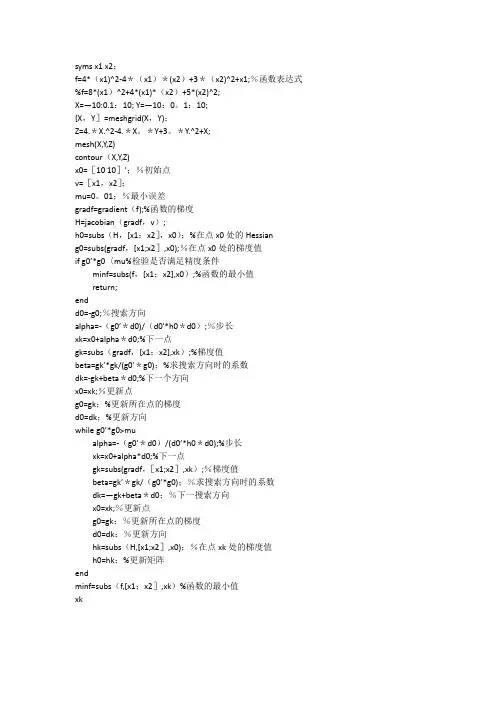

syms x1 x2;f=4*(x1)^2-4*(x1)*(x2)+3*(x2)^2+x1;%函数表达式%f=8*(x1)^2+4*(x1)*(x2)+5*(x2)^2;X=—10:0.1:10; Y=—10:0。

1:10;[X,Y]=meshgrid(X,Y);Z=4.*X.^2-4.*X。

*Y+3。

*Y.^2+X;mesh(X,Y,Z)contour(X,Y,Z)x0=[10 10]';%初始点v=[x1,x2];mu=0。

01;%最小误差gradf=gradient(f);%函数的梯度H=jacobian(gradf,v);h0=subs(H,[x1;x2],x0);%在点x0处的Hessiang0=subs(gradf,[x1;x2],x0);%在点x0处的梯度值if g0’*g0〈mu%检验是否满足精度条件minf=subs(f,[x1;x2],x0);%函数的最小值return;endd0=-g0;%搜索方向alpha=-(g0’*d0)/(d0'*h0*d0);%步长xk=x0+alpha*d0;%下一点gk=subs(gradf,[x1;x2],xk);%梯度值beta=gk’*gk/(g0'*g0);%求搜索方向时的系数dk=-gk+beta*d0;%下一个方向x0=xk;%更新点g0=gk;%更新所在点的梯度d0=dk;%更新方向while g0’*g0>mualpha=-(g0’*d0)/(d0’*h0*d0);%步长xk=x0+alpha*d0;%下一点gk=subs(gradf,[x1;x2],xk);%梯度值beta=gk’*gk/(g0’*g0);%求搜索方向时的系数dk=—gk+beta*d0;%下一搜索方向x0=xk;%更新点g0=gk;%更新所在点的梯度d0=dk;%更新方向hk=subs(H,[x1;x2],x0);%在点xk处的梯度值h0=hk;%更新矩阵endminf=subs(f,[x1;x2],xk)%函数的最小值xk。

共轭梯度法是一种在求解最优化问题时常用的算法。

下面是一个在MATLAB 中实现共轭梯度法的简单示例。

请注意,这个示例是为了教学目的而编写的,可能不适用于所有最优化问题。

首先,假设我们有一个目标函数f(x),我们需要找到使得f(x) 最小化的x。

假设f(x) 是一个二次函数,形式为f(x) = x^T Ax + b^T x + c,其中A 是对称正定矩阵,b 和c 是常数向量和标量。

以下是一个使用MATLAB 实现共轭梯度法的示例代码:```matlabfunction [x, iter] = conjugate_gradient(A, b, x0, tol, max_iter)% A -目标函数的系数矩阵% b -目标函数的常数向量% x0 -初始解% tol -容忍的误差% max_iter -最大迭代次数x = x0;r = b - A*x;p = r;iter = 0;while (norm(r) > tol) && (iter < max_iter)Ap = A*p;alpha = (p'*r) / (p'*Ap);x = x + alpha*p;r = r - alpha*Ap;beta = (r'*r) / (p'*r);p = r + beta*p;iter = iter + 1;endend```这个函数接受一个对称正定矩阵A,一个常数向量b,一个初始解x0,一个容忍的误差tol,和一个最大迭代次数max_iter 作为输入,并返回最优解x 和迭代次数iter。

注意,这个函数没有包括一些可能的特殊情况处理,例如如果A 是奇异的或者接近奇异的,那么这个函数可能无法正确地收敛。

在使用这个函数之前,你可能需要根据你的具体问题对其进行一些修改和增强。

无约束优化方法—共轭梯度法1.共轭梯度法共轭梯度法是介于最速下降法与牛顿法之间的一个方法,它仅需利用一阶导数信息,但克服了最速下降法收敛慢的缺点,又避免了牛顿法需要存储和计算海赛矩阵并求逆的缺点,共轭梯度法不仅是解决大型线性方程组最有用的方法之一,也是解大型非线性最优化最有效的算法之一。

其基本思想是利用负梯度方向,构造一共轭方向,使其尽快达到最优点。

共轭梯度法迭代过程如图1所示。

1X 2图1 共轭梯度法迭代过程()k 1x +点是沿()k x 点负梯度方向()()K k Sg =-搜索到的极值点。

如果接着从()k 1x +点出发,不是按着其负梯度方向()kg -搜索,而是沿着通过*x 点的方向()1K S +搜索,显然立即就能搜索到极值点*x 。

根据共轭理论,它们应当满足()()(1)1k Tk SAS+=即()KS 与()1K S +是互为共轭方向,新构造的共轭方向()1K S +,可由矢量合成,()(1)(1)()()2k k k k SgSβ++=-+()k β值可根据在极值点附近目标函数等值线近似为二次型函数的道理,推到出:()(1)(1)(1)2()()()()2||||3||||k T k k k k T k k gg g g g g β+++==利用两个点的梯度()k g和(1)k g+,就可以构造一个与梯度矢量为共轭的矢量()1K S +,沿着该方向搜索,即可求得极值点。

共轭梯度法程序框图如图2所示。

图2 共轭梯度法程序框图2. 共轭梯度法的应用用共轭梯度法计算22121212()52410f X x x x x x x =+---+ 的最优解,其中:初始点()0[1,1]T X =。

收敛精度ε=0.0001(1).共轭梯度法程序设计#include "stdio.h" #include "math.h"double fun1(double x1,double x2) {double y;y=x1*x1+x2*x2-5*x1*x2-2*x1-4*x2+10; return y; }double fun2(double g[],double d[]) {double buchang;buchang=-(g[0]*d[0]+g[1]*d[1])/(d[0]*(2*d[0]-5*d[1])+d[1]*(-5*d[0]+2*d[1])); return buchang; }main(){ double t, beta,x1=1,x2=1,d[2],g[4], y, m,e=0.0001; int k=1;g[0]=2*x1-5*x2-2; g[1]=2*x2-5*x1-4; m=(sqrt(g[0]*g[0]+g[1]*g[1]));while(m>e&&k<=200) { if (k==1) {d[0]=-g[0]; d[1]=-g[1];beta=0; } else {beta=(g[0]*g[0]+g[1]*g[1])/(g[2]*g[2]+g[3]*g[3]); d[0]=-g[0]+beta*d[0]; d[1]=-g[1]+beta*d[1]; }t=fun2(g,d); x1=x1+d[0]*t; x2=x2+d[1]*t; g[2]=g[0]; g[3]=g[1];g[0]= 2*x1-5*x2-2;g[1]= 2*x2-5*x1-4;m=sqrt(g[0]*g[0]+g[1]*g[1]); k++; }y=fun1(x1,x2);printf("迭代次数为k=%d\n",k);printf("分别输出x1=%f,x2=%f\n",x1,x2); printf("极小值y=%f",y); }(2).程序运行结果(3).结 论用共轭梯度法计算22121212()52410f X x x x x x x =+---+的最优解为*( 1.142857,0.857143)X =-- ,*()12.857143F X = 。

最优化问题共轭梯度法法代码x本文介绍了最优化问题共轭梯度法法的代码实现,以及如何使用代码解决最优化问题。

一、共轭梯度法简介共轭梯度法是一种常用的最优化算法,它是一种经典的迭代方法,用于求解凸函数的极值问题。

其基本思想是:在每一步,沿着梯度下降的方向迭代,直到梯度为零就停止迭代。

共轭梯度法的迭代公式为:$$x_{k+1}=x_k+alpha_k p_k$$其中,$alpha_k$ 是步长参数,$p_k$ 是当前搜索方向,$x_k$ 是当前点的位置。

二、代码实现1.函数定义```python# 共轭梯度法# 入参:函数func,梯度函数grad,初始点x0,步长参数alpha,精度epsilon# 出参:求解的最优点xdef conjugate_gradient_method(func, grad, x0, alpha, epsilon):```2.初始化搜索方向```python# 初始化搜索方向p_k = -grad(x_k)```3.更新迭代点```python# 更新迭代点x_k = x_k + alpha * p_k```4.更新搜索方向```python# 更新搜索方向beta_k = (grad(x_k) * grad(x_k)) / (grad(x_k_prev) * grad(x_k_prev))p_k = -grad(x_k) + beta_k * p_k_prev```5.检查终止条件```python# 检查终止条件if np.linalg.norm(grad(x_k)) < epsilon:break```6.完整代码```python# 共轭梯度法# 入参:函数func,梯度函数grad,初始点x0,步长参数alpha,精度epsilon# 出参:求解的最优点xdef conjugate_gradient_method(func, grad, x0, alpha, epsilon):x_k = x0p_k = -grad(x_k)while np.linalg.norm(grad(x_k)) > epsilon:x_k_prev = x_kp_k_prev = p_kline_search = line_search_method(func, grad, p_k, x_k, alpha)x_k = x_k + line_search * p_kbeta_k = (grad(x_k) * grad(x_k)) / (grad(x_k_prev) * grad(x_k_prev))p_k = -grad(x_k) + beta_k * p_k_prevreturn x_k```三、如何使用代码解决最优化问题1.确定问题首先,我们需要确定最优化问题,即构造一个函数,其中包含我们想要优化的目标函数以及约束条件。

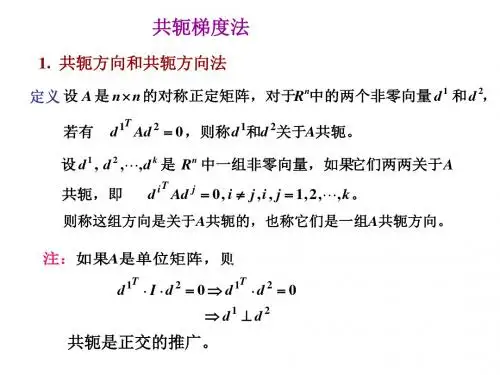

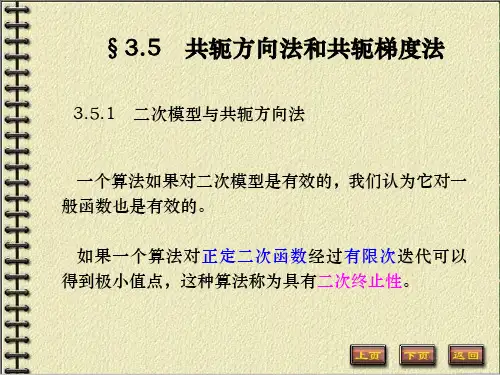

第四章 共轭梯度法§ 共轭方向法共轭方向法是无约束最优化问题的一类重要算法。

它一方面克服了最速下降法中,迭代点列呈锯齿形前进,收敛慢的缺点,同时又不像牛顿法中计算牛顿方向花费大量的工作量,尤其是共轭方向法具有所谓二次收敛性质,即当将其用于二次函数时,具有有限终止性质。

一、共轭方向概念 设G 是n n ⨯对称正定矩阵,1d ,2d 是n 维非零向量,假设120T d Gd = ()那么称1d ,2d 是G -共轭的。

类似地,设1,,m d d 是n R 中一组非零向量。

假设0T i j d Gd =()i j ≠ ()那么称向量组1,,m d d 是G -共轭的。

注:(1) 当G I =时,共轭性就变成正交性,故共轭是正交概念的推行。

(2) 若1,,m d d G -共轭,那么它们必线性无关。

二、共轭方向法共轭方向法确实是依照一组彼此共轭方向依次搜索。

模式算法:1)给出初始点0x ,计算00()g g x =,计算0d ,使000Td g <,:0k = (初始共轭方向); 2)计算k α和1k x +,使得0()min ()k k k k k f x d f x d ααα≥+=+,令1k k k k x x d α+=+;3)计算1k d +,使10Tk j d Gd +=,0,1,,j k =,令:1k k =+,转2)。

三、共轭方向法的大体定理共轭方向法最重要的性质确实是:当算法用于正定二次函数时,能够在有限多次迭代后终止,取得最优解(固然要执行精准一维搜索)。

定理 关于正定二次函数,共轭方向法最多通过n 步精准搜索终止;且对每一个1i x +,都是()f x 在线性流形00,i j j j j x x x d αα=⎧⎫⎪⎪=+∀⎨⎬⎪⎪⎩⎭∑中的极小点。

证明:首先证明对所有的1i n ≤-,都有10T i j g d +=,0,1,,j i =(即每一个迭代点处的梯度与以前的搜索方向均正交)事实上,由于目标函数是二次函数,因此有()11k k k k k k g g G x x Gd α++-=-=1)当j i <时, ()1111iTTT i j j j k k j k j g d gd g g d +++=+=+-∑110iT T j j kkj k j gd dGd α+=+=+=∑2)当j i =时,由精准搜索性质知:10T i j g d +=综上所述,有 10T i j g d += (0,1,,)j i =。

最优化算法【共轭梯度法】特点:具有超线性收敛速度,只需要计算梯度,避免计算⼆阶导数算法步骤step0:给定初始值x_0,容许误差\epsilonstep1:计算梯度g_k=\nabla f(x_k),if norm(g_k)<=\epsilon,break;输出当前值x_kelse to step2step2:\begin{cases} d_k=-g_k, & \text {$k$=0} \\ d_k=-g_k+\beta_{k-1}d_{k-1}, & \text {$k$>=1} \end{cases} \beta_{k-1}=\frac{g_k^Tg_k}{g_{k-1}^Tg_{k-1}}step3:利⽤线搜索技术确定\alpha_kx_{k+1}=x_k+\alpha_kd_kk=k+1,to step 1;matlab codefunction [x,val,fun_t] = conjugate_gradient(fun,gfun,x0,max_ite)%myFun - Description%% Syntax: [x,val,fun_t] = myFun(fun,gfun,x0)%% conjugate gradient algorithmmaxk=max_ite;rho=0.6;Sigma=0.4;k=0;epsilon=1e-4;n=length(x0);fun_t=zeros(1,max_ite);while k<maxkg=gfun(x0);itern=k-(n+1)*floor(k/(n+1));itern=itern+1;if(itern==1)d=-g;elseBeta=(g'*g)/(g0'*g0);d=-g+Beta*d0;gd=g'*d;if gd>=0.0d=-g;endendif norm(g)<epsilonbreak;endm=0;mk=0;while m<20if fun(x0+rho^m*d)<fun(x0)+Sigma*rho^m*g'*dmk=m;break;endm=m+1;endx0=x0+rho^mk*d;g0=g;d0=d;k=k+1;fun_t(1,k)=fun(x0);endx=x0;val=fun(x0);endmain code%%%%%%%%conjugate gradient algorithmclc;close all;fun=@(x) 100*(x(1)^2-x(2))^2+(x(1)-1)^2;gfun=@(x) [400*(x(1)^2-x(2))*x(1)+2*(x(1)-1);-200*(x(1)^2-x(2))];x0=[0;0];max_ite=200; %%number of iterations[x,val,fun_t] = conjugate_gradient(fun,gfun,x0,max_ite);disp(x);disp(val);figure(1);plot(1:max_ite,fun_t);set(get(gca, 'XLabel'), 'String', 'number of iterations');set(get(gca, 'YLabel'), 'String', 'function value');resultconclusion共轭梯度算法介于梯度下降和⽜顿法之间,快于线性收敛,只需要梯度,不⽤计算⼆阶导数;reference《最优化⽅法及其matlab程序设计》Processing math: 0%。

共轭梯度最优化方法

共轭梯度法呢,它主要是用来解决最优化问题的。

想象一下,你在一个超级复杂的迷宫里找宝藏,这个宝藏就是那个最优解。

普通的方法可能就像没头苍蝇乱撞,但是共轭梯度法就像是有个小机灵鬼在给你指路。

它有个很厉害的地方,就是利用了之前搜索的信息。

就好比你前面走过的路不是白走的,它会根据之前的经验来决定下一步往哪走。

比如说,你第一次往左边走了一段,发现不太对,那这个方法就会把这个信息记下来,下一次就不会再傻乎乎地一直往左边走啦。

在数学上呢,它是基于一些向量之间的特殊关系,也就是共轭关系。

这就像是一群小伙伴,他们之间有着某种默契,互相配合来找到那个最优解。

共轭梯度法的优点可不少呢。

它比一些传统的最优化方法要快很多。

就像跑步比赛,别人还在慢悠悠地起步,它已经像小火箭一样冲出去了。

而且,它不需要太多的存储空间,就像一个很会整理东西的小能手,不会把空间弄得乱七八糟。

不过呢,它也不是完美无缺的。

有时候在一些特别复杂的情况下,它可能也会有点小迷糊。

但是总体来说,在很多领域都超级有用。

还有在机器学习里,要调整那些复杂的模型参数,让模型预测得更准。

共轭梯度法也能来帮忙,它就像一个小导师,告诉那些参数应该怎么调整才能让整个模型变得更优秀。