回归分析简答题演示教学

- 格式:docx

- 大小:26.73 KB

- 文档页数:4

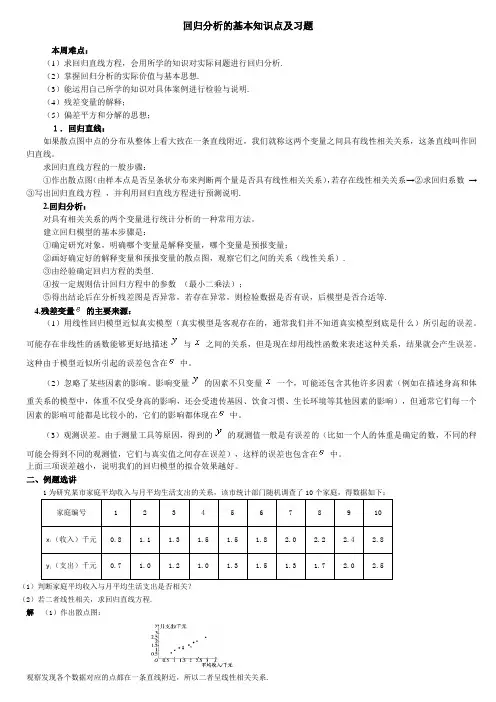

回归分析的基本知识点及习题本周难点:(1)求回归直线方程,会用所学的知识对实际问题进行回归分析.(2)掌握回归分析的实际价值与基本思想.(3)能运用自己所学的知识对具体案例进行检验与说明.(4)残差变量的解释;(5)偏差平方和分解的思想;1.回归直线:如果散点图中点的分布从整体上看大致在一条直线附近,我们就称这两个变量之间具有线性相关关系,这条直线叫作回归直线。

求回归直线方程的一般步骤:①作出散点图(由样本点是否呈条状分布来判断两个量是否具有线性相关关系),若存在线性相关关系→②求回归系数→③写出回归直线方程,并利用回归直线方程进行预测说明.2.回归分析:对具有相关关系的两个变量进行统计分析的一种常用方法。

建立回归模型的基本步骤是:①确定研究对象,明确哪个变量是解释变量,哪个变量是预报变量;②画好确定好的解释变量和预报变量的散点图,观察它们之间的关系(线性关系).③由经验确定回归方程的类型.④按一定规则估计回归方程中的参数(最小二乘法);⑤得出结论后在分析残差图是否异常,若存在异常,则检验数据是否有误,后模型是否合适等.4.残差变量的主要来源:(1)用线性回归模型近似真实模型(真实模型是客观存在的,通常我们并不知道真实模型到底是什么)所引起的误差。

可能存在非线性的函数能够更好地描述与之间的关系,但是现在却用线性函数来表述这种关系,结果就会产生误差。

这种由于模型近似所引起的误差包含在中。

(2)忽略了某些因素的影响。

影响变量的因素不只变量一个,可能还包含其他许多因素(例如在描述身高和体重关系的模型中,体重不仅受身高的影响,还会受遗传基因、饮食习惯、生长环境等其他因素的影响),但通常它们每一个因素的影响可能都是比较小的,它们的影响都体现在中。

(3)观测误差。

由于测量工具等原因,得到的的观测值一般是有误差的(比如一个人的体重是确定的数,不同的秤可能会得到不同的观测值,它们与真实值之间存在误差),这样的误差也包含在中。

回归分析的基本知识点及习题本周难点:(1)求回归直线方程,会用所学的知识对实际问题进行回归分析.(2)掌握回归分析的实际价值与基本思想.(3)能运用自己所学的知识对具体案例进行检验与说明.(4)残差变量的解释;(5)偏差平方和分解的思想;1.回归直线:如果散点图中点的分布从整体上看大致在一条直线附近,我们就称这两个变量之间具有线性相关关系,这条直线叫作回归直线。

求回归直线方程的一般步骤:①作出散点图(由样本点是否呈条状分布来判断两个量是否具有线性相关关系),若存在线性相关关系→②求回归系数→③写出回归直线方程,并利用回归直线方程进行预测说明.2.回归分析:对具有相关关系的两个变量进行统计分析的一种常用方法。

建立回归模型的基本步骤是:①确定研究对象,明确哪个变量是解释变量,哪个变量是预报变量;②画好确定好的解释变量和预报变量的散点图,观察它们之间的关系(线性关系).③由经验确定回归方程的类型.④按一定规则估计回归方程中的参数(最小二乘法);⑤得出结论后在分析残差图是否异常,若存在异常,则检验数据是否有误,后模型是否合适等.4.残差变量的主要来源:(1)用线性回归模型近似真实模型(真实模型是客观存在的,通常我们并不知道真实模型到底是什么)所引起的误差。

可能存在非线性的函数能够更好地描述与之间的关系,但是现在却用线性函数来表述这种关系,结果就会产生误差。

这种由于模型近似所引起的误差包含在中。

(2)忽略了某些因素的影响。

影响变量的因素不只变量一个,可能还包含其他许多因素(例如在描述身高和体重关系的模型中,体重不仅受身高的影响,还会受遗传基因、饮食习惯、生长环境等其他因素的影响),但通常它们每一个因素的影响可能都是比较小的,它们的影响都体现在中。

(3)观测误差。

由于测量工具等原因,得到的的观测值一般是有误差的(比如一个人的体重是确定的数,不同的秤可能会得到不同的观测值,它们与真实值之间存在误差),这样的误差也包含在中。

应用回归分析简答题1. 回归分析与相关分析的区别与联系是什么?回归分析与相关分析的区别与联系是什么?答:相关分析与回归分析有密切的联系,它们都是对变量间相关关系的研究,二者可以相互补充。

相关分析可以表明变量间相关关系的性质和程度,只有当变量间存在一定程度的相关关系时,进行回归分析去寻求相关的具体数学形式才有实际的意义。

同时,在进行相关分析时如果要具体确定变量间相关的具体数学形式,又要依赖于回归分析,而且相关分析中相关系数的确定也是建立在回归分析基础上的。

二者的区别:(1)相关分析中,变量x 和变量y 处于平等的地位;回归分析中,变量y 称为因变量,处在被解释的地位,x 称为自变量,用于预测因变量的变化;(2)相关分析中所涉及的变量x 和 y 都是随机变量;回归分析中,因变量 y 是随机变量,自变量 x 可以是随机变量,也可以是非随机的确定变量; (3)相关分析主要是描述两个变量之间线性关系的密切程度;回归分析不仅可以揭示变量 x 对变量 y 的影响大小,还可以由回归方程进行预测和控制。

制。

2. 线性回归模型的基本假设是什么?线性回归模型的基本假设是什么?(1)Gauss-Markov 假设:a. 误差项e i是一个期望值为0的随机变量,即()0e =i E ;b. 对于自变量12,,,p x xx 的所有值,e i的方差都相同,即2()e s =i D ; c.误差项e i 是彼此相互无关的,即(,)0,=¹i j Cov i j e e (2)解释变量12,,,p x x x 是非随机变量,观测值12,,,i i ip x x x是常数;(3)正态分布的假定:2(0,)es iN ;(4)为了便于数学上的处理,要求>n p 。

3. Gauss-Markov 假设中的三个条件的统计意义是什么?答:a. 误差项e i 是一个期望值为0的随机变量,即()0e =i E ,其统计意义是表明误差项不包含任何系统的趋势,观测值i y 小于或大于均值()i E y 的波动完全是一种随机性; b. 对于自变量12,,,p x x x 的所有值,e i 的方差都相同,即2()e s =i D ,表明要求不同次的观测i y 在其均值附近波动的程度是一样的;c.误差项e i 是彼此相互无关的,即(,)0,e e =¹i j Cov i j ,表明要求不同次的观 测i y 是互不相关的。

应用回归分析简答题及答案4.为什么要对回归模型进行检验答:当模型的未知参数估计出来后,就初步建立了一个回归模型。

建立回归模型的目的是应用他来研究经济问题,但如果马上就用这个模型去做预测、控制和分析,显然是不够慎重的。

因为这个模型是否真正揭示了被解释变量与解释变量之间的关系,必须通过对模型的检验才能决定。

5.讨论样本容量n与自变量个数p的关系,他们对模型的参数估计有何影响答:在多元线性回归模型中,样本容量n与自变量个数p的关系是:n>p。

如果n<=p对模型的参数估计会带来严重的影响。

因为:(1)在多元线性回归模型中,有p+1个待估参数B,所以样本容量的个数应该大于解释变量的个数,否则参数无法估计。

(2)解释变量X 是确定性变量,要求rank(X)=p+1<n,表明设计矩阵X中的自变量列之间不相关,样本容量的个数应该大于解释变量的个数,X是一个满秩矩阵。

7.如何正确理解回归方程显着性检验拒绝Ho,接受Ho答:(1)一般情况下,当Ho:B1=0被接受时,表明y的取值倾向不随x的值按线性关系变化,这种状况的原因可能是变量y与x之间的相关关系不显着,也可能虽然变量y与x之间的相关关系显着,但这种相关关系不是线性的而是非线性的。

(2)当Ho:B1=0被拒绝时,没有其他信息,只能认为因变量y对自变量x是有效的,但并没有说明回归的有效程度,不能断言y与x之间就一定是线性相关关系,而不是曲线关系或其他的关系。

8.一个回归方程的复相关系数R=,样本决定系数R8=, 我们能断定这个回归方程就很理想吗答:1.在样本容量较少,变两个数较大时,决定系数的值容易接近1,而此时可能F检验或者关于回归系数的t检验,所建立的回归方程都没能通过。

2.样本决定系数和复相关系数接近1只能说明Y 与自变量XI,X2,…,Xp整体上的线性关系成立,而不能判断回归方程和每个自变量都是显着的,还需进行F检验和t检验。

3.在应用过程中发现,在样本量一定的情况下,如果在模型中增加解释变量必定使得自由度减少,使得R。

1、作多元线性回归分析时,自变量与因变量之间的影响关系一定是线性形式的吗?多元线性回归分析中的线性关系是指什么变量之间存在线性关系?答:作多元线性回归分析时,自变量与因变量之间的影响关系不一定是线性形式。

当自变量与因变量是非线性关系时可以通过某种变量代换,将其变为线性关系,然后再做回归分析。

多元线性回归分析的线性关系指的是随机变量间的关系,因变量y与回归系数B i 间存在线性关系。

多元线性回归的条件是:(1)各自变量间不存在多重共线性;(2)各自变量与残差独立;(3)各残差间相互独立并服从正态分布;(4)Y 与每一自变量X 有线性关系。

2、回归分析的基本思想与步骤基本思想:所谓回归分析,是在掌握大量观察数据的基础上,利用数理统计方法建立因变量与自变量之间的回归关系函数表达式(称回归方程式)。

回归分析中,当研究的因果关系只涉及因变量和一个自变量时,叫做一元回归分析;当研究的因果关系涉及因变量和两个或两个以上自变量时,叫做多元回归分析。

此外,回归分析中,又依据描述自变量与因变量之间因果关系的函数表达式是线性的还是非线性的,分为线性回归分析和非线性回归分析。

通常线性回归分析法是最基本的分析方法,遇到非线性回归问题可以借助数学手段化为线性回归问题处理。

步骤:1)确定回归方程中的解释变量和被解释变量。

2)确定回归模型根据函数拟合方式,通过观察散点图确定应通过哪种数学模型来描述回归线。

如果被解释变量和解释变量之间存在线性关系,则应进行线性回归分析,建立线性回归模型;如果被解释变量和解释变量之间存在非线性关系,则应进行非线性回归分析,建立非线性回归模型。

3)建立回归方程根据收集到的样本数据以及前步所确定的回归模型,在一定的统计拟合准则下估计出模型中的各个参数,得到一个确定的回归方程。

4)对回归方程进行各种检验由于回归方程是在样本数据基础上得到的,回归方程是否真实地反映了事物总体间的统计关系,以及回归方程能否用于预测等都需要进行检验。

5)利用回归方程进行预测3、多重共线性问题、不良后果、解决方法多重共线性是指线性回归模型中的自变量之间由于存在精确相关关系或高度相关关系而使模型估计失真或难以估计准确。

常见的是近似的多重共线性关系,即存在不全为0的p个常数C i,C2,…,Cp使得C i X ii+C2X i2 +…+CpXip ~0,i=1,2,…n不良后果:模型存在完全的多重共线性,则资料阵X的秩<p+1,从而无法得到回归参数的估计量。

对于近似多重共线性情况,虽有r(X)=p+1,但|X T X| ~ 0,从而矩阵( X T X)-1的主对角线上的元素很大,使得估计的参数向量的协方差阵的对角线上的元素也很大,导致普通最小二乘参数估计量并非有效。

检验方法:方差扩大因子( VIF )法和特征根判定法方差扩大因子表达式为:VIF i=1/(1-R i2),其中R i为自变量xi对其余自变量作回归分析的复相关系数。

当VIF i很大时,表明自变量间存在多重共线性。

解决方法:当发现自变量存在严重的多重共线性时,可以通过剔除一些不重要的自变量、增大样本容量、对回归系数做有偏估计(如采用岭回归法、主成分法、偏最小二乘法等)等方法来克服多重共线性。

4、为什么要进行回归方程的显著性检验?答:对于任意给定的一组观测数据(xi1,xi2,...,xip;yi) ,(i=1,2,...,n) ,我们都可以建立回归方程。

但实际问题很可能y 与自变量x1,x2,...,xp 之间根本不存在线性关系,这时建立起来的回归方程的效果一定很差,即回归值yi 实际上不能拟合真实的值yi。

即使整个回归方程的效果是显著的,在多元的情况下,是否每个变量都起着显著的作用呢?因此还需要对各个回归系数进行显著性检验,对于回归效果不显著的自变量,我们可以从回归方程中剔除,而只保留起重要作用的自变量,这样可以使回归方程更简练。

5、统计性的依据是什么?给出一个回归方程如何做显著性检验?统计性的依据是方差分析。

对于多元线性回归方程作显著性检验就是要看自变量x1,x2,...xp从整体上对随机变量y 是否有明显的影响,即检验假设H0: B 1=B 2=...= B p=0 H1:至少有某个B i 工0,1<=i<=p如果H0被接受,则表明y与x1,x2,...xp之间不存在线性关系,为了说明如何进行检验,我们首先要建立方差分析表。

在进行显著性检验中,我们可以用F统计量来检验回归方程的显著性,也可以用P 值法做检验。

F 统计量是:F=MSR/MSE=[SSR/p]/[SSE/(n-p-1)]当H0为真时,F~F(p,n-p-1)。

给定显著性水平a,查F分布表得临界值F1-a (p,n-p-1),计算F的观测值,若F0<= F1-a (p,n-p-1),贝U接受H0,即认为在显著性水平a之下,认为y与x1,x2,...xp之间线性关系不显著。

利用P值法做显著性检验十分方便,这里的P值是P(F>F0),定显著性水平a,若p<a,则拒绝H0,反之接受H0。

6、回归系数的显著性检验回归方程通过了显著性检验并不意味着每个自变量xi都对y有显著影响。

而回归系数的显著性检验的目的就是从回归方程中剔除那些对y的影响不显著的自变量,从而建立一个较为有效的回归方程。

如果自变量xi对y无影响,则在线性模型中,B i=0检验xi的影响是否显著等价于检验假设HO:B i=0 , H1:B i工0对给定的显著性水平a,当|ti|>t a 12(n-p-1)时,拒绝H0。

反之,则接受H0。

7、数据的中心化和标准化目的:解决利用回归方程分析实际问题时遇到的诸多自变量量纲不一致的问题。

数据中心化处理的几何意义:相当于将坐标原点移至样本中心,而坐标系的平移并不改变直线的斜率,只改变了截距。

8、通过对残差进行分析,可以在一定程度上回答下列问题:1) 回归函数线性假定的可行性;2) 误差项的等方差假设的合理性;3) 误差项独立性假设的合理性;4) 误差项是否符合正态分布;5) 观测值中是否存在异常值;6) 是否在模型中遗漏了某些重要的自变量9、标准化回归方程与非标准化回归方程有何不同?在怎样的情况下需要将变量标准化?标准化回归方程就是将自变量因变量都标准化后的方程。

在SPSS输出的回归系数中有一列是标准化的回归系数,由于都标准化了,因此标准化方程中没有常数项了。

对数据标准化,即将原始数据减去相应变量的均数后再除以该变量的标准差,计算得到的回归方程称为标准化回归方程,相应的回归系数为标准化回归系数。

一般情况下的回归,并不必须标准化,直接回归即可。

在做主成分分析包括因子分析时,则必须标准化。

10、回归分析和相关分析的区别和联系相关分析和回归分析都是对客观事物数量依存关系的分析,均有一元和多元,线性与非线性之分,在应用中相互结合渗透,但仍有差别,主要是:(1)相关分析主要刻画两类变量间线性相关的密切程度,而回归分析则是揭示一个变量如何与其他变量相联系,并可由回归方程进行控制和预测(2)在相关分析中,变量y与x处于平等的地位,在回归分析中,因变量y处于被解释的特殊地位( 3)在相关分析中所涉及的变量y 与x 完全是随机变量;而在回归分析中因变量y 是随机变量,自变量可以是随机变量也可以是非随机变量。

一般来说,只有存在相关关系才可以进行回归分析,相关程度越高,回归分析的结果就越可靠。

11、回归方程的基本假定?(1)回归函数的线性假设(2)误差项的等方差假设(3)误差项的独立性假设(4)误差项的正态分布假设12、运用回归分析解决问题时,回归变量的选择理论依据的什么?选择回归变量时应注意哪些问题?(1)从拟合角度考虑,可以采用修正的复相关系数达到最大的准则准则1:修正的复相关系数R a2达到最大。

因为:R a2=1-MSE/(SST/(n-1))从这个关系式容易看出,R a2达到最大时,MSE达到最小(2)从预测的角度考虑,可以采用预测平方和达到最小的准则及C p准则准则2:预测平方和PRES$达到最小准则3: (C p准则)( 3)从极大似然估计角度考虑,可以采用赤池信息量化准则( AIC 准则)准则4:赤池信息量达到最小AIC=nln(SSE p)+2p选择AIC值最小的回归方程为最优回归方程自变量的选择问题可以看成是应该采用全模型还是选模型的问题全模型正确误用选模型:全模型相应参数为有偏估计,选模型预测也是有偏的。

选模型的参数估计和预测残差以及均方差都有较小的方差。

选模型正确误用全模型,全模型参数估计和预测是有偏估计,而全模型预测值的方差和均方差大于选模型相应的方差。

上述结论说明丢掉那些对应变量影响不大的,或虽有影响,但难于观测的自变量是有利的。

13、逐步回归方法的基本思想与步骤基本思想:有进有出。

具体做法是将变量一个一个引入,引入变量的条件是通过了偏F 统计量的检验,同时,每引入一个新变量后,对已入选方程的老变量进行检测,将经检验认为不显著的变量剔除,此过程经过若干步,直到既不能引入新变量又不能剔除老变量为止。

基本步骤:(1)对于每个自变量x i(1< i < m),拟合m个一元线性回归模型,若F I(1)>F E,则所选择含有自变量x i1的回归模型为当前模型,否则,没有变量引入模型,选择过程结束,即认为所有自变量对y 的影响均不显著。

(2)在第一步的基础上,再将其余的m-1个自变量分别加入此模型中,得到m-1 个二元回归方程,若若F i1⑵〉F E则将自变量X i2引入模型,进一步考察X i2引入模型后,X ii对y的影响是否仍显著,若F l⑵< F D,贝捌除X i。

(3)在第二步的基础上再将其余的m-2个自变量分别加入此模型中,拟合各个模型并计算偏F统计量值,与F E比较决定是否又新变量引入,如果有新的变量引入,还需要检验原模型中的老变量是否因为这个新变量的引入而不再显著,那样就应该被剔除。

重复以上步骤,直到没有新的变量进入模型,同时在模型中的老变量都不能被剔除,贝结束选择过程。