第二章矩阵分解4 矩阵的奇异值分解

- 格式:ppt

- 大小:182.50 KB

- 文档页数:4

![[整理]矩阵的奇异值分解](https://uimg.taocdn.com/afe785200a4c2e3f5727a5e9856a561253d3215f.webp)

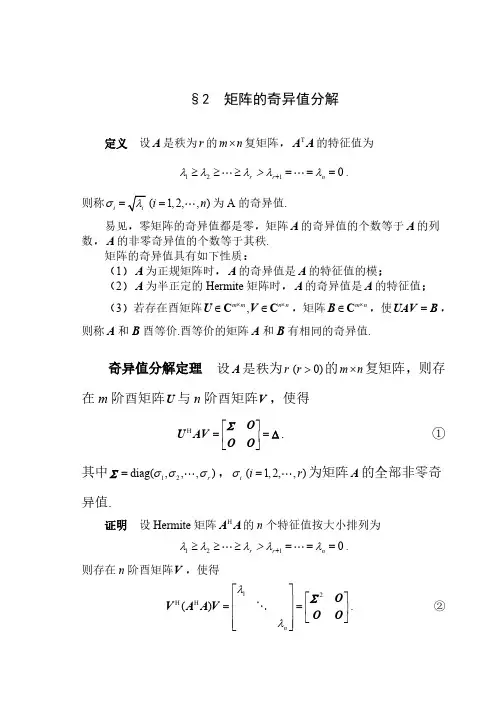

§2 矩阵的奇异值分解定义 设A 是秩为r 的m n ⨯复矩阵,T A A 的特征值为1210r r n λλλ>λλ+≥≥≥=== .则称i σ=(1,2,,)i n = 为A 的奇异值.易见,零矩阵的奇异值都是零,矩阵A 的奇异值的个数等于A 的列数,A 的非零奇异值的个数等于其秩.矩阵的奇异值具有如下性质:(1)A 为正规矩阵时,A 的奇异值是A 的特征值的模;(2)A 为半正定的Hermite 矩阵时,A 的奇异值是A 的特征值;(3)若存在酉矩阵,m m n n ⨯⨯∈∈U V C C ,矩阵m n ⨯∈B C ,使=UAV B ,则称A 和B 酉等价.酉等价的矩阵A 和B 有相同的奇异值.奇异值分解定理 设A 是秩为r (0)r >的m n ⨯复矩阵,则存在m 阶酉矩阵U 与n 阶酉矩阵V ,使得H⎡⎤==⎢⎥⎣⎦O U AV O O ∑∆. ①其中12diag(,,,)r σσσ= ∑,i σ(1,2,,)i r = 为矩阵A 的全部非零奇异值.证明 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为 12()=V V V ,其中1V ,2V 分别是V 的前r 列与后n r -列.并改写②式为2H⎡⎤=⎢⎥⎣⎦O A AV V O O ∑.则有H 2H 112==A AV V A AV O , ∑. ③由③的第一式可得H H 2H 1111()()r ==V A AV AV AV E , 或者∑∑∑.由③的第二式可得H 222()() ==AV AV O AV O 或者.令111-=U AV ∑,则H 11r =U U E ,即1U 的r 个列是两两正交的单位向量.记作112(,,,)r =U u u u ,因此可将12,,,r u u u 扩充成m C 的标准正交基,记增添的向量为1,,r m +u u ,并构造矩阵21(,,)r m +=U u u ,则12121(,)(,,,,,,)r r m +==U U U u u u u u是m 阶酉矩阵,且有 H H1121 r ==U U E U U O ,.于是可得H HH1121H 2()()⎡⎤⎡⎤===⎢⎥⎢⎥⎣⎦⎣⎦O U U AV U AV AV U O O O U ,,∑∑.由①式可得H H HH 111222r r r σσσ⎡⎤==+++⎢⎥⎣⎦O A U V u v u v u v O O ∑. ④称④式为矩阵A 的奇异值分解.值得注意的是:在奇异值分解中121,,,,,,r r m +u u u u u 是H AA 的特征向量,而V 的列向量是H A A 的特征向量,并且H AA 与H A A 的非零特征值完全相同.但矩阵A 的奇异值分解不惟一.证明2 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为12(,,,)n =V v v v ,它的n 个列12,,,n v v v 是对应于特征值12,,,n λλλ 的标准正交的特征向量.为了得到酉矩阵U ,首先考察m C 中的向量组12,,,r Av Av Av ,由于当i 不等于j 时有H H H H H (,)()()0i j j i j i j i i i j i λλ=====Av Av Av Av v A Av v v v v所以向量组12,,,r Av Av Av 是m C 中的正交向量组.又 2H H H 2||||i i i i i i iλσ===Av v A Av v v ,所以 ||||i i i σ=Av .令1i i i=u Av σ,1,2,,i r = ,则得到m C 中的标准正交向量组12,,,r u u u ,把它扩充成为m C 中的标准正交基11,,,,r r m +u u u u ,令11(,,,,)r r m +=U u u u u则U 是m 阶酉矩阵.由已知及前面的推导可得i i i σ=Av u ,1,2,,i r = ;i =Av 0,1,,i r n =+ ;从而 121(,,,)(,,,,,)n r ==AV A v v v Av Av 0011120(,,,,,)(,,,)0r m r σσσσ⎛⎫⎪ ⎪== ⎪ ⎪ ⎪⎝⎭O u u u u u O O 00 ⎛⎫= ⎪⎝⎭ΣO U O O故有=AV U Δ,即H =U AV Δ.例1 求矩阵120202⎡⎤=⎢⎥⎣⎦A 的奇异值分解.解 T52424044⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦A A 的特征值为1239,4,0λλλ===, 对应的单位特征向量依次为T T T 1231,1),(2,1,2)3==-=-v v v .所以5052643⎡-⎢=⎥⎥-⎥⎣⎦V .于是可得()2r =A ,3002∑⎡⎤=⎢⎥⎣⎦.计算111221∑-⎡⎤==⎢⎥-⎣⎦U AV ,则A 的奇异值分解为T 300020⎡⎤=⎢⎥⎣⎦A U V .在A 的奇异值分解中,酉矩阵V 的列向量称为A 的右奇异向量,V 的前r 列是H A A 的r 个非零特征值所对应的特征向量,将他们取为矩阵V 1,则12(,)=V V V .酉矩阵U 的列向量被称为A 的左奇异向量,将U 从前r 列处分块为12(,)=U U U ,由分块运算,有H H H H1111212H H H22122()⎡⎤⎛⎫⎡⎤=== ⎪⎢⎥⎢⎥⎣⎦⎣⎦⎝⎭O U U AV U AV U AV AV AV O O U U AV U AV ,∑ 从而 211=A V A V U Σ,=0.正交基;(2)1U 的列向量组是矩阵A 的列空间(){}R =A Ax 的一组标准正交基;(1)1V 的列向量组是矩阵A 的零空间(){}N ==A x Ax 0正交补H ()R A 的一组标准正交基;(1)2U 的列向量组是矩阵A 的列空间(){}R =A Ax 正交补H ()N A 的一组标准正交基.在A 的奇异值分解中,酉矩阵U 和V 不是惟一的.A 的奇异值分解给出了矩阵A 的许多重要信息.更进一步,由于12(,,)m =U u u u ,12(,,,)n =V v v v ,可借助于奇异值分解,将A 表示为H 11H 212H 0(,,,)0m r n σσ⎛⎫⎛⎫⎪ ⎪ ⎪ ⎪= ⎪ ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭⎝⎭v O v A u u u O O v H HH 111222r r r σσσ=+++u v u v u v归纳这一结果,有如下定理.定理 设m n ⨯∈A C ,A 的非零奇异值为12r σσσ≥≥≥ ,12,,ru u u 是应于奇异值的左奇异向量,12,,,r v v v 是应于奇异值的右奇异向量,则T TT 111222r r r σσσ=+++A u v u v u v .上式给出的形式被称为矩阵A 的奇异值展开式,对一个k r ≤,略去A 的一些小的奇异值对应的项,去矩阵k A 为T T T111222k k k kσσσ=+++A u v u v u v .则k A 是一个秩为k 的m ×n 矩阵.可以证明,k A 是在所有秩为k 的m ×n 矩阵中,从Frobenius 范数的意义下,与矩阵A 距离最近的一个矩阵.这在实际中应用广泛.例如,在图像数字化技术中,一副图片可以转换成一个m ×n 阶像素矩阵来储存,存储量m ×n 是个数.如果利用矩阵的奇异值展开式,则只要存储A 的奇异值i σ,奇异向量,i i u v 的分量,总计r (m +n +1)个数.取m =n =1000,r =100作一个比较, m ×n =1000000,r (m +n +1)=100(1000+1000+1)=200100.取A 的奇异值展开式,,存储量较A 的元素情形减少了80%.另外,可取k r <,用k A 逼近A ,能够达到既压缩图像的存储量,又保持图像不失真的目的.由矩阵A 的奇异值分解可得T TT 111222r r r σσσ=+++A u v u v u v可见,A 是矩阵T TT 1122,,,r r u v u v u v 的加权和,其中权系数按递减排列120r σσσ≥≥≥> .显然,权系数大的那些项对矩阵A 的贡献大,因此当舍去权系数小的一些项后,仍然能较好的“逼近”矩阵A ,这一点在数字图像处理方面非常有用.矩阵的秩k 逼近定义为T T T111222 1k k k k r σσσ=+++≤≤A u v u v u v秩r 逼近就精确等于A ,而秩1逼近的误差最大.矩阵的奇异值分解不但在线性方程组,矩阵范数,广义逆,最优化等方面有着广泛的应用.而且在数字计算,数字图像处理,信息检索,心里学等领域也有着极重要的应用.有兴趣的读者可参阅有关教科书,如Steven J.Leon 的《线性代数》.3 矩阵A的奇异值分解与线性变换T A设A 是一个秩为r 的m ×n 复矩阵,即m n⨯∈A C,rank()r =A ,则由()T ==A A βαα可以定义线性变换:n m T →A C C .设矩阵A 有奇异值分解H=A U ΣV ,则将矩阵n n⨯∈V C 的列向量组12,,,n v v v 取作空间nC 的标准正交基;则将矩阵m m⨯∈U C的列向量组12,,m u u u 取作空间mC的标准正交基,则在所取的基下,线性变换T A 对应的变换矩阵就是Σ.设n ∈C α,α在基12,,,n v v v 下坐标向量为T12(,,,)n x x x =x ,=Vx α.那么α在线性变换T A 下的像β具有形式:11H()()()00r r x x T σσ⎛⎫ ⎪ ⎪ ⎪===== ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭A A U ΣV Vx U Σx U βαα.其中12,,,r σσσ 是A 的非零奇异值,所以,α的像()T =A βα在m C 中基12,,m u u u 下的坐标是T 11(00)r rx x σσ==y Σx .从中可以看出,当rank()r =A 时,在取定的基下,线性变换()T A α的作用是将原像坐标中的前r 个分量分别乘以A 的非零奇异值12,,,r σσσ ,后(n-r )分量化为零.如果原像坐标满足条件:222121n x x x +++= ,则像坐标满足条件:2221212()()()1rry y y σσσ+++≤ .在rank()r n ==A 时,等式成立.因此,有如下定理.定理 设H=A U ΣV 是m ×n 实矩阵A 的奇异值分解,rank()r =A ,则nR 中的单位圆球面在线性变换T A 下的像集合是:(1)若r n =,则像集合是mR 中的椭球面;(2)若r n <,则像集合是mR 中的椭球体.例2 设矩阵120202⎡⎤=⎢⎥⎣⎦A ,求3R 中的单位圆球面在线性变换:T A y =Ax 下的像的几何图形.解 由例1,矩阵A 有如下奇异值分解T5012300262102043⎛⎫⎡-⎪⎢⎛⎫⎡⎤⎡⎤⎪=⎥⎪⎢⎥⎢⎥-⎪⎣⎦⎣⎦⎥⎭⎪-⎥⎣⎦⎝⎭A. rank()23,n=<=A由定理,单位球面的像满足不等式221222132y y+≤.即单位球面的像是实心椭圆2212194y y+≤.。

矩阵的奇异值分解(SVD)及其应用版权声明:本文由LeftNotEasy发布于, 本文可以被全部的转载或者部分使用,但请注明出处,如果有问题,请联系*******************前言:上一次写了关于PCA与LDA的文章,PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。

在上篇文章中便是基于特征值分解的一种解释。

特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。

而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。

奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。

就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。

在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Semantic Indexing)另外在这里抱怨一下,之前在百度里面搜索过SVD,出来的结果都是俄罗斯的一种狙击枪(AK47同时代的),是因为穿越火线这个游戏里面有一把狙击枪叫做SVD,而在Google上面搜索的时候,出来的都是奇异值分解(英文资料为主)。

想玩玩战争游戏,玩玩COD不是非常好吗,玩山寨的CS有神马意思啊。

国内的网页中的话语权也被这些没有太多营养的帖子所占据。

真心希望国内的气氛能够更浓一点,搞游戏的人真正是喜欢制作游戏,搞Data Mining的人是真正喜欢挖数据的,都不是仅仅为了混口饭吃,这样谈超越别人才有意义,中文文章中,能踏踏实实谈谈技术的太少了,改变这个状况,从我自己做起吧。

奇异值分解定理奇异值分解(Singular Value Decomposition,简称SVD)是线性代数中一种重要的矩阵分解方法,常用于数据分析、信号处理、图像压缩等领域。

SVD的定理表明,任何矩阵都可以分解成三个矩阵的乘积,其中一个矩阵是正交矩阵,另外两个矩阵是对角矩阵,且对角线上的元素称为奇异值。

奇异值分解定理的数学概念比较复杂,需要一定的线性代数基础。

下面将对奇异值分解定理进行详细解释。

给定一个m行n列的实数矩阵A,假设rank(A)为r.那么存在两个实数方阵U(m×r)和V(n×r),使得:A = UΣV^T其中,U的每一列是A^TA的特征向量,V的每一列是AA^T的特征向量,Σ是一个对角矩阵,对角线上的元素称为奇异值。

奇异值分解定理的证明比较复杂,这里只给出一个简要的证明思路。

假设A的列向量为{a1, a2, ..., an},它们构成了一个n维向量空间的一组基。

我们可以将这组基转化为标准正交基,得到一组正交矩阵U和V。

然后我们可以通过对U和V进行一些数学操作,得到UΣV^T形式的矩阵。

最后,我们可以证明这个矩阵确实满足奇异值分解定理的要求。

奇异值分解定理在数据分析中有广泛的应用。

例如,在推荐系统中,我们可以通过SVD将用户对物品的评分矩阵分解,得到用户和物品的特征矩阵,从而进行个性化推荐。

在语音识别中,我们可以通过SVD将语音信号分解成一组基本声音的叠加,从而实现语音信号的降噪和特征提取。

在图像压缩中,我们可以通过SVD将图像分解成一组基本的图像模式,从而实现图像的降噪和压缩。

奇异值分解定理的应用不仅局限于上述领域,还可以应用于信号处理、图像处理、文本处理等其他领域。

通过奇异值分解,我们可以将复杂的问题转化为简单的线性代数运算,从而大大简化问题的求解过程。

然而,奇异值分解也有一些限制。

首先,奇异值分解是一种数值方法,对计算精度要求较高。

其次,奇异值分解的计算复杂度较高,对于大规模矩阵的分解可能会很耗时。

矩阵分解奇异值分解法SVD分解作者:XIAOFU 发表时间:九月- 13 - 2009 | 人气: 2,451 VIEWS |矩阵分解(decomposition, factorization), 顾名思义, 就是将矩阵进行适当的分解, 使得进一步的处理更加便利。

矩阵分解多数情况下是将一个矩阵分解成数个三角阵(triangular matrix)。

依使用目的的不同,一般有三种矩阵分解方法:1)三角分解法(Triangular decomposition),2)QR 分解法(QR decomposition),3)奇异值分解法(Singular Value Decompostion)。

1) 三角分解法(Triangular decomposition)三角分解法是将方阵(square matrix)分解成一个上三角矩阵﹝或是排列(permuted) 的上三角矩阵﹞和一个下三角矩阵,该方法又被称为LU分解法。

例如, 矩阵X=[1 2 3;4 5 6;7 8 9], 运用该分解方法可以得到:上三角矩阵L=[0.1429 1.0000 00.5714 0.5000 1.00001.0000 0 0]和下三角矩阵U=[7.0000 8.0000 9.00000 0.8571 1.71430 0 0.0000]不难验证L* U = X.该分解方法的用途主要在简化大矩阵的行列式值的计算,矩阵求逆运算和求解联立方程组。

需要注意的是, 这种分解方法所得到的上下三角形矩阵不是唯一的,我们还可找到若干对不同的上下三角矩阵对,它们的乘积也会得到原矩阵。

对应MATLAB命令: lu2) QR分解法QR分解法是将矩阵分解成一个单位正交矩阵(自身与其转置乘积为单位阵I)和一个上三角矩阵。

对应MATLAB命令: qr3) 奇异值分解法(SVD)奇异值分解(sigular value decomposition,SVD) 是另一种正交矩阵分解法;SVD是最可靠的分解法,但是它比QR 分解法要花上近十倍的计算时间。

奇异值分解公式

奇异值分解(Singular Value Decomposition,简称SVD)是一种矩阵分解的方法,用于将一个矩阵分解成三个矩阵的乘积。

其公式如下:

假设有一个 m × n 的实数矩阵 A,则它的奇异值分解可以表示为:A = UΣV^T

其中,U 是一个 m × m 的正交矩阵,Σ是一个 m × n 的对角矩阵,V 是一个 n × n 的正交矩阵。

^T 表示矩阵的转置。

对角矩阵Σ的对角线上的元素称为奇异值(singular values),按照从大到小的顺序排列。

U 的列向量称为左奇异向量(left singular vectors),V 的列向量称为右奇异向量(right singular vectors)。

奇异值分解在数据压缩、降维、推荐系统等领域具有广泛应用,可以帮助我们提取出矩阵的主要特征,并且能够有效地减少数据的维度。

矩阵的奇异值分解(SVD)及其应用版权声明:本文由LeftNotEasy发布于, 本文可以被全部的转载或者部分使用,但请注明出处,如果有问题,请联系*******************前言:上一次写了关于PCA与LDA的文章,PCA的实现一般有两种,一种是用特征值分解去实现的,一种是用奇异值分解去实现的。

在上篇文章中便是基于特征值分解的一种解释。

特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。

而且线性代数或者矩阵论里面,也很少讲任何跟特征值与奇异值有关的应用背景。

奇异值分解是一个有着很明显的物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性。

就像是描述一个人一样,给别人描述说这个人长得浓眉大眼,方脸,络腮胡,而且带个黑框的眼镜,这样寥寥的几个特征,就让别人脑海里面就有一个较为清楚的认识,实际上,人脸上的特征是有着无数种的,之所以能这么描述,是因为人天生就有着非常好的抽取重要特征的能力,让机器学会抽取重要的特征,SVD是一个重要的方法。

在机器学习领域,有相当多的应用与奇异值都可以扯上关系,比如做feature reduction的PCA,做数据压缩(以图像压缩为代表)的算法,还有做搜索引擎语义层次检索的LSI(Latent Semantic Indexing)另外在这里抱怨一下,之前在百度里面搜索过SVD,出来的结果都是俄罗斯的一种狙击枪(AK47同时代的),是因为穿越火线这个游戏里面有一把狙击枪叫做SVD,而在Google上面搜索的时候,出来的都是奇异值分解(英文资料为主)。

想玩玩战争游戏,玩玩COD不是非常好吗,玩山寨的CS有神马意思啊。

国内的网页中的话语权也被这些没有太多营养的帖子所占据。

真心希望国内的气氛能够更浓一点,搞游戏的人真正是喜欢制作游戏,搞Data Mining的人是真正喜欢挖数据的,都不是仅仅为了混口饭吃,这样谈超越别人才有意义,中文文章中,能踏踏实实谈谈技术的太少了,改变这个状况,从我自己做起吧。

矩阵的奇异值分解(singular value decomposition, SVD)是线性代数中的一种重要的矩阵分解方法,它在很多领域中都具有广泛应用,包括图像处理、数据压缩、信号处理等。

奇异值分解不仅是矩阵的一种表达形式,还可以帮助我们理解矩阵的结构,从而更好地应用于实际问题中。

奇异值分解的基本思想是将一个矩阵分解成三个矩阵的乘积。

对于一个m×n的矩阵A,它的奇异值分解可以表示为A=UΣV^T,其中U和V是m×m和n×n维的酉矩阵,Σ是一个m×n的对角矩阵,对角线上的元素称为奇异值。

通常情况下,奇异值按照从大到小的顺序排列。

奇异值分解的一个重要应用是矩阵的降维。

对于一个m×n的矩阵A,我们可以选择保留其中最大的k个奇异值,然后将矩阵A分解为UkΣkVk^T,其中Uk、Σk和Vk分别是U、Σ和V的前k列构成的矩阵。

这样得到的矩阵Ak=UkΣkVk^T可以近似地表示原始矩阵A,且Ak是一个更低维度的矩阵。

通过选择合适的k值,可以在保留较高精度的情况下大大降低矩阵的存储和计算复杂度。

奇异值分解还可以用来解决线性方程组的最小二乘解问题。

对于一个m×n的矩阵A和一个m维的向量b,我们可以将矩阵A分解为A=UΣV^T,然后将方程组Ax=b转化为Σy=Ub,其中y=V^Tx。

求解线性方程组Σy=Ub相对简单,通过计算得到向量y后,再通过y=V^Tx计算得到向量x,就得到了原始线性方程组的最小二乘解。

此外,奇异值分解还可以用于计算矩阵的伪逆。

对于一个m×n的矩阵A,它的伪逆A^+可以通过奇异值分解得到。

具体地,如果A的奇异值分解为A=UΣV^T,那么A^+可以表示为A^+=VΣ^+U^T,其中Σ^+是Σ的逆矩阵的转置。

伪逆矩阵在很多问题中都有重要应用,比如在解决过约束线性方程组和最小二乘解的问题中。

总之,矩阵的奇异值分解是线性代数中的一种重要的矩阵分解方法,它具有广泛的应用价值。

矩阵的奇异值分解高等代数知识点详解矩阵的奇异值分解(Singular Value Decomposition,简称SVD)是一种重要的矩阵分解方法,它在高等代数中具有广泛应用。

本文将详细介绍矩阵的奇异值分解原理、性质以及在实际问题中的应用。

一、奇异值分解的原理奇异值分解是将一个复杂的矩阵分解为三个简单矩阵的乘积,其基本原理可以用以下公式表示:A = UΣV^T在公式中,A是一个m×n的实数矩阵,U是一个m×m的正交矩阵,Σ是一个m×n的对角矩阵,V^T是一个n×n的正交矩阵,其中^T表示转置。

二、奇异值分解的性质1.奇异值在奇异值分解中,Σ是一个对角矩阵,对角线上的元素称为奇异值。

奇异值是非负实数,按照大小排列,通常用σ1 ≥ σ2 ≥ ... ≥ σr来表示。

其中r是矩阵A的秩。

2.奇异向量在奇异值分解中,U的列向量称为左奇异向量,V的列向量称为右奇异向量。

左奇异向量和右奇异向量都是单位向量,且对应不同的奇异值。

3.特征值与奇异值对于一个方阵A,奇异值与它的特征值有一定的联系。

若A是一个n×n的方阵,那么它的非零奇异值是A^T × A的非零特征值的平方根。

三、奇异值分解的应用奇异值分解在数据降维、图像压缩、推荐系统等领域具有广泛的应用。

1.数据降维在高维数据分析中,经常需要将高维数据转化为低维,以便于可视化和分析。

奇异值分解可以对数据矩阵进行降维,得到矩阵的主要特征。

通过保留较大的奇异值和对应的奇异向量,可以实现对数据的有效降维。

2.图像压缩奇异值分解可以对图像进行压缩,将原始图像表示为几个主要特征的叠加。

通过保留较大的奇异值和对应的奇异向量,可以在减小图像存储空间的同时,尽可能地保留图像的主要信息。

3.推荐系统在推荐系统中,奇异值分解可以对用户-物品评分矩阵进行分解,得到用户和物品的隐含特征。

通过计算用户-物品评分的近似矩阵,可以预测用户对未评分物品的评分,从而实现个性化推荐。

线性代数中的矩阵分解与奇异值分解-教案一、引言1.1矩阵分解与奇异值分解的重要性1.1.1矩阵分解是线性代数中的核心概念之一,它将复杂的矩阵问题转化为更易处理的形式。

1.1.2奇异值分解(SVD)是矩阵分解的一种,它对于数据压缩、信号处理等领域至关重要。

1.1.3理解矩阵分解和奇异值分解有助于深入掌握线性代数的应用,尤其是在工程和科学领域。

1.2教学目标1.2.1使学生理解矩阵分解的基本概念和性质。

1.2.2培养学生运用奇异值分解解决实际问题的能力。

1.2.3强化学生对线性代数理论在实际应用中的认识。

1.3教学难点与重点1.3.1教学难点:矩阵分解的数学推导和奇异值分解的物理意义。

1.3.2教学重点:矩阵分解的类型和奇异值分解的应用。

二、知识点讲解2.1矩阵分解的类型2.1.1对角化分解:将矩阵分解为对角矩阵和可逆矩阵的乘积。

2.1.2QR分解:将矩阵分解为正交矩阵和上三角矩阵的乘积。

2.1.3LU分解:将矩阵分解为下三角矩阵和上三角矩阵的乘积。

2.1.4奇异值分解:将矩阵分解为正交矩阵、对角矩阵和另一个正交矩阵的乘积。

2.2奇异值分解的数学原理2.2.1奇异值分解的定义:任何矩阵都可以分解为三个矩阵的乘积。

2.2.2奇异值的物理意义:奇异值表示矩阵变换的强度。

2.2.3奇异值分解的计算方法:使用特征值分解和正交变换。

2.2.4奇异值分解的应用:数据压缩、图像处理、信号处理等。

2.3矩阵分解与奇异值分解的应用实例2.3.1数据压缩:通过奇异值分解减少数据维度,去除噪声。

2.3.2图像处理:利用奇异值分解进行图像重建和增强。

2.3.3信号处理:通过奇异值分解提取信号的主要成分。

2.3.4机器学习:奇异值分解用于特征提取和降维。

三、教学内容3.1矩阵分解的基本概念和性质3.1.1矩阵分解的定义:将一个矩阵表示为若干个简单矩阵的乘积。

3.1.2矩阵分解的性质:保持矩阵的秩和行列式不变。

3.1.3矩阵分解的应用:简化计算、解决方程组、分析矩阵特性等。