矩阵的奇异值分解

- 格式:ppt

- 大小:2.21 MB

- 文档页数:92

奇异值分解的几何解释

奇异值分解(Singular Value Decomposition,SVD)是一种矩阵分解的方法,可以将一个矩阵分解成三个矩阵的乘积。

在几何上,SVD可以用于对数据集进行降维,以及在数据集上进行主成分分析。

在几何上,矩阵可以被视为表示线性变换的操作。

奇异值分解将矩阵分解成三个基本的线性变换的乘积:旋转、缩放和旋转的逆操作。

这三个变换可以用来描述原始矩阵的几何性质。

具体来说,给定一个矩阵A,SVD将其分解为以下形式:

A = UΣV^T

其中,U和V是正交矩阵,Σ是一个对角矩阵,对角线上的元素称为奇异值。

在几何上,矩阵A的列空间由矩阵U的列向量确定,而A的行空间由矩阵V的列向量确定。

奇异值则表示了变换过程中的缩放因子,可以用来量化数据的重要程度。

SVD的几何解释可以理解为对原始数据进行一系列变换,从而找到对数据进行紧凑表示的最佳方式。

这种变换可以帮助我们找到数据中的主要模式和特征,从而进行数据压缩、降噪、特征提取等任务。

矩阵的奇异值分解(Singular Value Decomposition,SVD)是一种重要的矩阵分解方法,可以将一个复杂的矩阵分解为三个简单的矩阵相乘的形式。

SVD 可以应用于各种领域,如图像处理、语音识别、推荐系统等。

SVD 分解将一个m × n 的矩阵 M 分解为U × Σ × V^T 的形式,其中 U 是一个m × m 的酉矩阵(unitary matrix),Σ 是一个m × n 的矩阵,只有对角线上的元素大于等于 0,V^T 是一个n × n 的酉矩阵。

通常情况下,SVD 可以通过奇异值分解定理进行求解。

首先,我们需要计算矩阵M × M^T 和M^T × M 的特征向量和特征值。

设 M 是一个m × n 的矩阵,M^T 是它的转置矩阵,那么M × M^T 是一个m × m 的矩阵,M^T × M 是一个n × n 的矩阵。

我们可以通过特征值分解方法求解这两个矩阵的特征向量和特征值。

然后,我们可以将M × M^T 和M^T × M 的特征向量和特征值组成两个酉矩阵 U 和 V。

特征值的平方根构成了Σ 矩阵的对角线元素。

我们可以将 U 和V 按照特征值降序排列,以保证U × Σ × V^T 是一个矩阵。

最后,我们可以利用奇异值分解定理,将 M 分解为U × Σ × V^T 的形式。

这样的分解可以帮助我们理解原始矩阵的结构和特征,提取重要信息,并进行维度降低等操作。

在某些情况下,SVD 还可以作为矩阵的伪逆(pseudo-inverse),帮助我们解决线性方程组等问题。

SVD 分解在各个领域都有广泛的应用。

在图像处理中,SVD 可以用于图像压缩和降噪等操作。

在语音识别中,SVD 可以用于语音特征提取和模式匹配。

矩阵奇异值分解的实际应用

矩阵奇异值分解(SVD)在实际中有很多应用,下面是其中的一些例子:

- 图像压缩:SVD可以将图像的大小最小化到可接受的质量水平,从而在相同磁盘空间中存储更多图像。

它利用了在SVD之后仅获得的一些奇异值很大的原理,通过修剪三个矩阵中的前几个奇异值,可以获得原始图像的压缩近似值,人眼无法区分一些压缩图像。

- 数据降维:在大多数应用中,我们希望将高秩矩阵缩减为低秩矩阵,同时保留重要信息。

SVD可以实现这一目标,通过保留前r个较大的奇异值,来近似表示原始矩阵,从而达到降维的目的。

- 推荐系统:在推荐系统中,SVD可以用于计算用户和项目之间的相似度。

通过将用户和项目的矩阵进行奇异值分解,可以得到一个包含奇异值和左右奇异向量的矩阵。

这些奇异值和奇异向量可以用于计算用户和项目之间的相似度,从而为用户推荐类似的项目。

总之,矩阵奇异值分解在数据压缩、数据降维、推荐系统等方面都有重要的应用,它可以帮助我们从高维数据中提取关键信息,同时保持数据的重要特征。

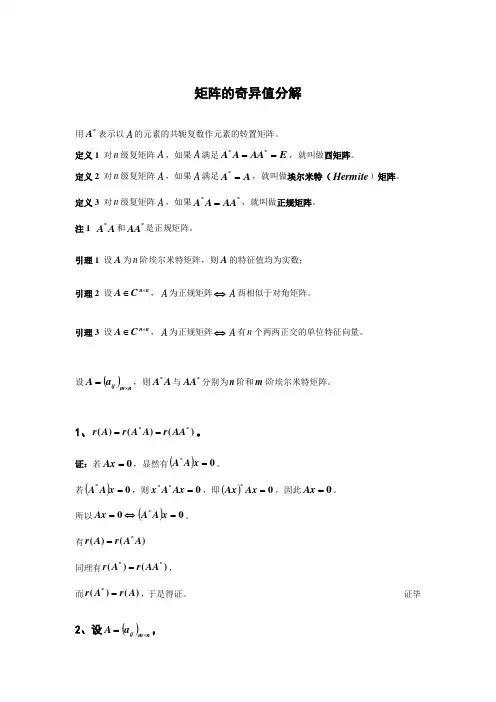

矩阵的奇异值分解用*A 表示以A 的元素的共轭复数作元素的转置矩阵。

定义1 对n 级复矩阵A ,如果A 满足E AAA A ==**,就叫做酉矩阵。

定义2 对n 级复矩阵A ,如果A 满足A A =*,就叫做埃尔米特(Hermite )矩阵。

定义3 对n 级复矩阵A ,如果**AA A A =,就叫做正规矩阵。

注1 A A *和*AA 是正规矩阵。

引理1 设A 为n 阶埃尔米特矩阵,则A 的特征值均为实数;引理2 设nn C A ⨯∈,A 为正规矩阵⇔A 酉相似于对角矩阵。

引理3 设n n C A ⨯∈,A 为正规矩阵⇔A 有n 个两两正交的单位特征向量。

设()nm ij a A ⨯=,则A A *与*AA 分别为n 阶和m 阶埃尔米特矩阵。

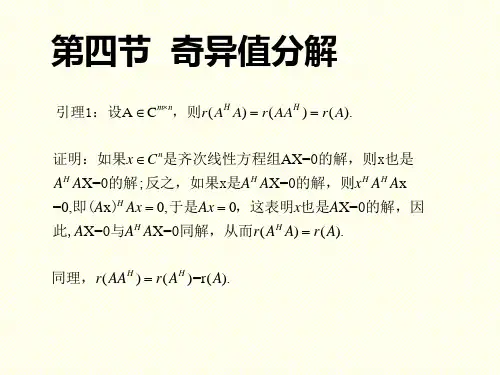

1、)()()(**AA r A A r A r ==。

证:若0=Ax ,显然有()0*=x A A 。

若()0*=x A A ,则0**=Ax A x ,即()0*=Ax Ax ,因此0=Ax 。

所以()00*=⇔=x A A Ax 。

有)()(*A A r A r = 同理有)()(**AA r A r =,而)()(*A r A r =,于是得证。

证毕2、设()nm ija A⨯=,证明:*AA 与A A *有完全相同的非零特征值r λλλ,,,21 (其中)(A r r=,相同的按重数计算)。

证:因*AA 与A A *均为正规矩阵,根据引理2知它们酉相似与对角矩阵,且对角线元素为其特征值。

由第1题,*AA 与A A *的非零特征值的个数为r 。

设λ为A A *的一个非零特征值,相应的线性无关的特征向量为k ααα,,,21 。

则i i A A λαα=*,k i ≤≤1, (1) 因而()()i i A A AA αλα=*,k i ≤≤1。

(2)设有一组数k a a a ,,,21 ,使02211=+++k k A a A a A a ααα , 左乘*A ,得到0*2*21*1=+++k k A A a A A a A A a ααα , 由(1)得到()02211=+++k k a a a αααλ , 进而02211=+++k k a a a ααα 。

![[整理]矩阵的奇异值分解](https://uimg.taocdn.com/afe785200a4c2e3f5727a5e9856a561253d3215f.webp)

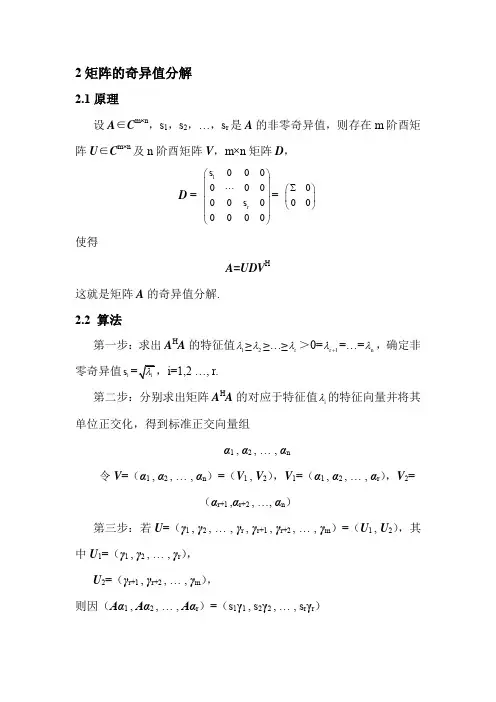

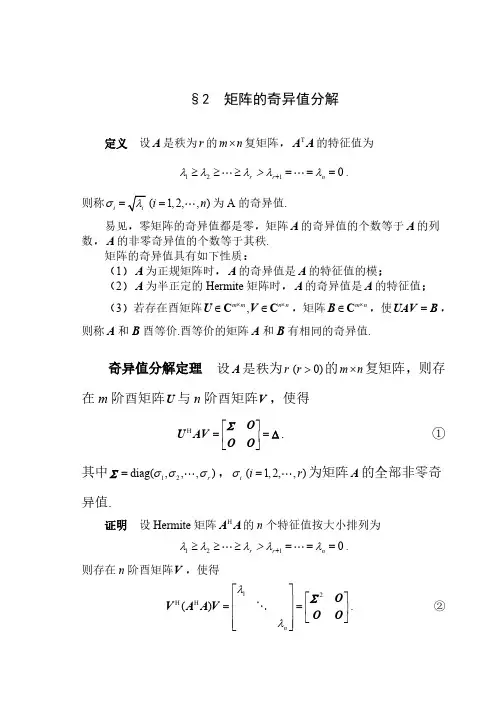

§2 矩阵的奇异值分解定义 设A 是秩为r 的m n ⨯复矩阵,T A A 的特征值为1210r r n λλλ>λλ+≥≥≥=== .则称i σ=(1,2,,)i n = 为A 的奇异值.易见,零矩阵的奇异值都是零,矩阵A 的奇异值的个数等于A 的列数,A 的非零奇异值的个数等于其秩.矩阵的奇异值具有如下性质:(1)A 为正规矩阵时,A 的奇异值是A 的特征值的模;(2)A 为半正定的Hermite 矩阵时,A 的奇异值是A 的特征值;(3)若存在酉矩阵,m m n n ⨯⨯∈∈U V C C ,矩阵m n ⨯∈B C ,使=UAV B ,则称A 和B 酉等价.酉等价的矩阵A 和B 有相同的奇异值.奇异值分解定理 设A 是秩为r (0)r >的m n ⨯复矩阵,则存在m 阶酉矩阵U 与n 阶酉矩阵V ,使得H⎡⎤==⎢⎥⎣⎦O U AV O O ∑∆. ①其中12diag(,,,)r σσσ= ∑,i σ(1,2,,)i r = 为矩阵A 的全部非零奇异值.证明 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为 12()=V V V ,其中1V ,2V 分别是V 的前r 列与后n r -列.并改写②式为2H⎡⎤=⎢⎥⎣⎦O A AV V O O ∑.则有H 2H 112==A AV V A AV O , ∑. ③由③的第一式可得H H 2H 1111()()r ==V A AV AV AV E , 或者∑∑∑.由③的第二式可得H 222()() ==AV AV O AV O 或者.令111-=U AV ∑,则H 11r =U U E ,即1U 的r 个列是两两正交的单位向量.记作112(,,,)r =U u u u ,因此可将12,,,r u u u 扩充成m C 的标准正交基,记增添的向量为1,,r m +u u ,并构造矩阵21(,,)r m +=U u u ,则12121(,)(,,,,,,)r r m +==U U U u u u u u是m 阶酉矩阵,且有 H H1121 r ==U U E U U O ,.于是可得H HH1121H 2()()⎡⎤⎡⎤===⎢⎥⎢⎥⎣⎦⎣⎦O U U AV U AV AV U O O O U ,,∑∑.由①式可得H H HH 111222r r r σσσ⎡⎤==+++⎢⎥⎣⎦O A U V u v u v u v O O ∑. ④称④式为矩阵A 的奇异值分解.值得注意的是:在奇异值分解中121,,,,,,r r m +u u u u u 是H AA 的特征向量,而V 的列向量是H A A 的特征向量,并且H AA 与H A A 的非零特征值完全相同.但矩阵A 的奇异值分解不惟一.证明2 设Hermite 矩阵H A A 的n 个特征值按大小排列为1210r r n λλλ>λλ+≥≥≥=== .则存在n 阶酉矩阵V ,使得12H H()n λλ⎡⎤⎡⎤⎢⎥==⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦O V A A V OO ∑. ②将V 分块为12(,,,)n =V v v v ,它的n 个列12,,,n v v v 是对应于特征值12,,,n λλλ 的标准正交的特征向量.为了得到酉矩阵U ,首先考察m C 中的向量组12,,,r Av Av Av ,由于当i 不等于j 时有H H H H H (,)()()0i j j i j i j i i i j i λλ=====Av Av Av Av v A Av v v v v所以向量组12,,,r Av Av Av 是m C 中的正交向量组.又 2H H H 2||||i i i i i i iλσ===Av v A Av v v ,所以 ||||i i i σ=Av .令1i i i=u Av σ,1,2,,i r = ,则得到m C 中的标准正交向量组12,,,r u u u ,把它扩充成为m C 中的标准正交基11,,,,r r m +u u u u ,令11(,,,,)r r m +=U u u u u则U 是m 阶酉矩阵.由已知及前面的推导可得i i i σ=Av u ,1,2,,i r = ;i =Av 0,1,,i r n =+ ;从而 121(,,,)(,,,,,)n r ==AV A v v v Av Av 0011120(,,,,,)(,,,)0r m r σσσσ⎛⎫⎪ ⎪== ⎪ ⎪ ⎪⎝⎭O u u u u u O O 00 ⎛⎫= ⎪⎝⎭ΣO U O O故有=AV U Δ,即H =U AV Δ.例1 求矩阵120202⎡⎤=⎢⎥⎣⎦A 的奇异值分解.解 T52424044⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦A A 的特征值为1239,4,0λλλ===, 对应的单位特征向量依次为T T T 1231,1),(2,1,2)3==-=-v v v .所以5052643⎡-⎢=⎥⎥-⎥⎣⎦V .于是可得()2r =A ,3002∑⎡⎤=⎢⎥⎣⎦.计算111221∑-⎡⎤==⎢⎥-⎣⎦U AV ,则A 的奇异值分解为T 300020⎡⎤=⎢⎥⎣⎦A U V .在A 的奇异值分解中,酉矩阵V 的列向量称为A 的右奇异向量,V 的前r 列是H A A 的r 个非零特征值所对应的特征向量,将他们取为矩阵V 1,则12(,)=V V V .酉矩阵U 的列向量被称为A 的左奇异向量,将U 从前r 列处分块为12(,)=U U U ,由分块运算,有H H H H1111212H H H22122()⎡⎤⎛⎫⎡⎤=== ⎪⎢⎥⎢⎥⎣⎦⎣⎦⎝⎭O U U AV U AV U AV AV AV O O U U AV U AV ,∑ 从而 211=A V A V U Σ,=0.正交基;(2)1U 的列向量组是矩阵A 的列空间(){}R =A Ax 的一组标准正交基;(1)1V 的列向量组是矩阵A 的零空间(){}N ==A x Ax 0正交补H ()R A 的一组标准正交基;(1)2U 的列向量组是矩阵A 的列空间(){}R =A Ax 正交补H ()N A 的一组标准正交基.在A 的奇异值分解中,酉矩阵U 和V 不是惟一的.A 的奇异值分解给出了矩阵A 的许多重要信息.更进一步,由于12(,,)m =U u u u ,12(,,,)n =V v v v ,可借助于奇异值分解,将A 表示为H 11H 212H 0(,,,)0m r n σσ⎛⎫⎛⎫⎪ ⎪ ⎪ ⎪= ⎪ ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭⎝⎭v O v A u u u O O v H HH 111222r r r σσσ=+++u v u v u v归纳这一结果,有如下定理.定理 设m n ⨯∈A C ,A 的非零奇异值为12r σσσ≥≥≥ ,12,,ru u u 是应于奇异值的左奇异向量,12,,,r v v v 是应于奇异值的右奇异向量,则T TT 111222r r r σσσ=+++A u v u v u v .上式给出的形式被称为矩阵A 的奇异值展开式,对一个k r ≤,略去A 的一些小的奇异值对应的项,去矩阵k A 为T T T111222k k k kσσσ=+++A u v u v u v .则k A 是一个秩为k 的m ×n 矩阵.可以证明,k A 是在所有秩为k 的m ×n 矩阵中,从Frobenius 范数的意义下,与矩阵A 距离最近的一个矩阵.这在实际中应用广泛.例如,在图像数字化技术中,一副图片可以转换成一个m ×n 阶像素矩阵来储存,存储量m ×n 是个数.如果利用矩阵的奇异值展开式,则只要存储A 的奇异值i σ,奇异向量,i i u v 的分量,总计r (m +n +1)个数.取m =n =1000,r =100作一个比较, m ×n =1000000,r (m +n +1)=100(1000+1000+1)=200100.取A 的奇异值展开式,,存储量较A 的元素情形减少了80%.另外,可取k r <,用k A 逼近A ,能够达到既压缩图像的存储量,又保持图像不失真的目的.由矩阵A 的奇异值分解可得T TT 111222r r r σσσ=+++A u v u v u v可见,A 是矩阵T TT 1122,,,r r u v u v u v 的加权和,其中权系数按递减排列120r σσσ≥≥≥> .显然,权系数大的那些项对矩阵A 的贡献大,因此当舍去权系数小的一些项后,仍然能较好的“逼近”矩阵A ,这一点在数字图像处理方面非常有用.矩阵的秩k 逼近定义为T T T111222 1k k k k r σσσ=+++≤≤A u v u v u v秩r 逼近就精确等于A ,而秩1逼近的误差最大.矩阵的奇异值分解不但在线性方程组,矩阵范数,广义逆,最优化等方面有着广泛的应用.而且在数字计算,数字图像处理,信息检索,心里学等领域也有着极重要的应用.有兴趣的读者可参阅有关教科书,如Steven J.Leon 的《线性代数》.3 矩阵A的奇异值分解与线性变换T A设A 是一个秩为r 的m ×n 复矩阵,即m n⨯∈A C,rank()r =A ,则由()T ==A A βαα可以定义线性变换:n m T →A C C .设矩阵A 有奇异值分解H=A U ΣV ,则将矩阵n n⨯∈V C 的列向量组12,,,n v v v 取作空间nC 的标准正交基;则将矩阵m m⨯∈U C的列向量组12,,m u u u 取作空间mC的标准正交基,则在所取的基下,线性变换T A 对应的变换矩阵就是Σ.设n ∈C α,α在基12,,,n v v v 下坐标向量为T12(,,,)n x x x =x ,=Vx α.那么α在线性变换T A 下的像β具有形式:11H()()()00r r x x T σσ⎛⎫ ⎪ ⎪ ⎪===== ⎪ ⎪ ⎪ ⎪ ⎪⎝⎭A A U ΣV Vx U Σx U βαα.其中12,,,r σσσ 是A 的非零奇异值,所以,α的像()T =A βα在m C 中基12,,m u u u 下的坐标是T 11(00)r rx x σσ==y Σx .从中可以看出,当rank()r =A 时,在取定的基下,线性变换()T A α的作用是将原像坐标中的前r 个分量分别乘以A 的非零奇异值12,,,r σσσ ,后(n-r )分量化为零.如果原像坐标满足条件:222121n x x x +++= ,则像坐标满足条件:2221212()()()1rry y y σσσ+++≤ .在rank()r n ==A 时,等式成立.因此,有如下定理.定理 设H=A U ΣV 是m ×n 实矩阵A 的奇异值分解,rank()r =A ,则nR 中的单位圆球面在线性变换T A 下的像集合是:(1)若r n =,则像集合是mR 中的椭球面;(2)若r n <,则像集合是mR 中的椭球体.例2 设矩阵120202⎡⎤=⎢⎥⎣⎦A ,求3R 中的单位圆球面在线性变换:T A y =Ax 下的像的几何图形.解 由例1,矩阵A 有如下奇异值分解T5012300262102043⎛⎫⎡-⎪⎢⎛⎫⎡⎤⎡⎤⎪=⎥⎪⎢⎥⎢⎥-⎪⎣⎦⎣⎦⎥⎭⎪-⎥⎣⎦⎝⎭A. rank()23,n=<=A由定理,单位球面的像满足不等式221222132y y+≤.即单位球面的像是实心椭圆2212194y y+≤.。

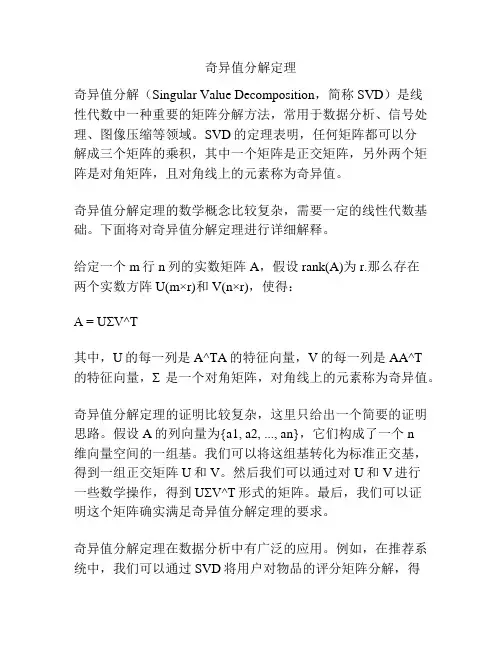

奇异值分解定理奇异值分解(Singular Value Decomposition,简称SVD)是线性代数中一种重要的矩阵分解方法,常用于数据分析、信号处理、图像压缩等领域。

SVD的定理表明,任何矩阵都可以分解成三个矩阵的乘积,其中一个矩阵是正交矩阵,另外两个矩阵是对角矩阵,且对角线上的元素称为奇异值。

奇异值分解定理的数学概念比较复杂,需要一定的线性代数基础。

下面将对奇异值分解定理进行详细解释。

给定一个m行n列的实数矩阵A,假设rank(A)为r.那么存在两个实数方阵U(m×r)和V(n×r),使得:A = UΣV^T其中,U的每一列是A^TA的特征向量,V的每一列是AA^T的特征向量,Σ是一个对角矩阵,对角线上的元素称为奇异值。

奇异值分解定理的证明比较复杂,这里只给出一个简要的证明思路。

假设A的列向量为{a1, a2, ..., an},它们构成了一个n维向量空间的一组基。

我们可以将这组基转化为标准正交基,得到一组正交矩阵U和V。

然后我们可以通过对U和V进行一些数学操作,得到UΣV^T形式的矩阵。

最后,我们可以证明这个矩阵确实满足奇异值分解定理的要求。

奇异值分解定理在数据分析中有广泛的应用。

例如,在推荐系统中,我们可以通过SVD将用户对物品的评分矩阵分解,得到用户和物品的特征矩阵,从而进行个性化推荐。

在语音识别中,我们可以通过SVD将语音信号分解成一组基本声音的叠加,从而实现语音信号的降噪和特征提取。

在图像压缩中,我们可以通过SVD将图像分解成一组基本的图像模式,从而实现图像的降噪和压缩。

奇异值分解定理的应用不仅局限于上述领域,还可以应用于信号处理、图像处理、文本处理等其他领域。

通过奇异值分解,我们可以将复杂的问题转化为简单的线性代数运算,从而大大简化问题的求解过程。

然而,奇异值分解也有一些限制。

首先,奇异值分解是一种数值方法,对计算精度要求较高。

其次,奇异值分解的计算复杂度较高,对于大规模矩阵的分解可能会很耗时。

矩阵的奇异值分解

奇异值分解(Singular Value Decomposition,SVD)是一种常见的矩阵分解技术,也被称为矩阵奇异值分解。

它是一种比较复杂的矩阵运算技术,它的本质是将一个矩阵通过线性变换分解成三个不同的矩阵,这三个矩阵有特定的性质,可以用来进一步进行矩阵操作。

最常见的应用场景是用来压缩数据,通常先将原始数据进行SVD 分解,然后再去掉一些次要的特征,从而进行数据压缩。

此外,SVD还可用于探索数据之间的关系、数据预测,它也是推荐系统及机器学习中的一种常用技术手段。

不管是在压缩空间还是数据处理上,都可以利用这一技术。

虽然它的表面上看起来很复杂,但SVD实际上具有很多共享的特性,它可以将任何m × n的实矩阵分解为矩阵的乘积。

它也是有着丰富的表示力,可以把其它分解算法通过一种简单统一的视角来分析。

总的来说,奇异值分解是一种有着广泛应用场景的计算技术,即使是比较复杂的数据处理,也可以利用它来获得有效的结果。

它可以帮助我们分析数据之间的关系,发现有价值的洞察,从而辅助机器学习和推荐引擎,使它们的效果更加的出色。

矩阵的奇异值分解应用

奇异值分解(Singular Value Decomposition,SVD)是一种重要的矩阵分解技术,被广泛应用于数据压缩、降维、特征提取等领域。

在实际应用中,SVD不仅可以用于矩阵的逼近表示,还可以用于推荐系统、图像处理、自然语言处理等多个领域。

1. 数据降维

SVD可以将一个大矩阵分解为三个矩阵的乘积,其中一个矩阵是对角阵,对角元素称为奇异值。

这个过程可以帮助我们发现数据中的主要特征,并实现数据的降维。

在机器学习中,数据降维可以提高模型的训练效率和泛化能力。

2. 推荐系统

在推荐系统中,我们常常需要处理用户对物品的评分数据,这些数据通常表示为一个用户-物品评分矩阵。

通过对这个矩阵进行SVD分解,可以得到用户和物品的潜在特征向量,从而实现对用户和物品的推荐,提高推荐的准确性和个性化。

3. 图像压缩

SVD还广泛应用于图像处理领域。

通过对图像的像素矩阵进行SVD分解,可以提取图像的主要特征,实现图像的压缩和重建。

这种方法不仅可以减小图像的存储空间,还可以减少传输时的带宽消耗。

4. 自然语言处理

在自然语言处理中,SVD也被用于词向量的表示。

通过对文本语料矩阵进行SVD分解,可以得到词语的语义特征向量,实现词向量间的语义相似度计算和文本分类等任务。

总之,矩阵的奇异值分解是一种强大的数学工具,在各个领域都有着广泛的应用。

通过对数据进行SVD分解,我们可以实现数据的降维、推荐系统的个性化推荐、图像的压缩和重建、以及自然语言处理中的词向量表示等多个重要任务。

随着数据量的不断增大和机器学习领域的进步,SVD的应用前景将更加广阔。

矩阵的奇异值分解(singular value decomposition, SVD)是线性代数中的一种重要的矩阵分解方法,它在很多领域中都具有广泛应用,包括图像处理、数据压缩、信号处理等。

奇异值分解不仅是矩阵的一种表达形式,还可以帮助我们理解矩阵的结构,从而更好地应用于实际问题中。

奇异值分解的基本思想是将一个矩阵分解成三个矩阵的乘积。

对于一个m×n的矩阵A,它的奇异值分解可以表示为A=UΣV^T,其中U和V是m×m和n×n维的酉矩阵,Σ是一个m×n的对角矩阵,对角线上的元素称为奇异值。

通常情况下,奇异值按照从大到小的顺序排列。

奇异值分解的一个重要应用是矩阵的降维。

对于一个m×n的矩阵A,我们可以选择保留其中最大的k个奇异值,然后将矩阵A分解为UkΣkVk^T,其中Uk、Σk和Vk分别是U、Σ和V的前k列构成的矩阵。

这样得到的矩阵Ak=UkΣkVk^T可以近似地表示原始矩阵A,且Ak是一个更低维度的矩阵。

通过选择合适的k值,可以在保留较高精度的情况下大大降低矩阵的存储和计算复杂度。

奇异值分解还可以用来解决线性方程组的最小二乘解问题。

对于一个m×n的矩阵A和一个m维的向量b,我们可以将矩阵A分解为A=UΣV^T,然后将方程组Ax=b转化为Σy=Ub,其中y=V^Tx。

求解线性方程组Σy=Ub相对简单,通过计算得到向量y后,再通过y=V^Tx计算得到向量x,就得到了原始线性方程组的最小二乘解。

此外,奇异值分解还可以用于计算矩阵的伪逆。

对于一个m×n的矩阵A,它的伪逆A^+可以通过奇异值分解得到。

具体地,如果A的奇异值分解为A=UΣV^T,那么A^+可以表示为A^+=VΣ^+U^T,其中Σ^+是Σ的逆矩阵的转置。

伪逆矩阵在很多问题中都有重要应用,比如在解决过约束线性方程组和最小二乘解的问题中。

总之,矩阵的奇异值分解是线性代数中的一种重要的矩阵分解方法,它具有广泛的应用价值。