基于标签相关性的K近邻多标签分类方法

- 格式:pdf

- 大小:392.85 KB

- 文档页数:6

多标签多分类算法

多标签多分类算法指的是同时将一个样本分到多个分类标签中的分类算法。

在传统的分类算法中,每个样本只能被分到一个分类标签中,而多标签多分类算法可以将一个样本分到多个分类标签中,从而更准确地描述样本的特征。

常见的多标签多分类算法包括:

1. One-vs-Rest (OvR):将每个分类标签作为一个二分类问题,训练多个分类器,将样本分到每个分类标签中的一个或多个分类器中。

2. Binary Relevance (BR):将多标签多分类问题转化为多个二分类问题,每个标签对应一个二分类问题,训练多个二分类器,将样本分到每个标签中的一个分类器中。

3. Classifier Chains (CC):将每个标签作为一个二分类问题,但是每个分类器的输入还包括前面的分类结果,训练多个二分类器,将样本按照一定的顺序传递给不同的分类器进行分类。

4. Label Powerset (LP):将每个样本的多个标签组合成一个新的标签,将多标签多分类问题转化为多分类问题,训练一个多分类器。

5. Random k-labelsets (RAkEL):随机选择k个标签子集,将多标签多分类问题转化为多个二分类问题,训练多个二分类器,根据预测结果组合成最终的标签集。

这些算法各有优缺点,适用于不同的问题和数据集。

在选择多

标签多分类算法时,需要根据实际情况考虑算法的复杂度、准确性和可扩展性等因素。

机器学习经典分类算法——k-近邻算法(附python实现代码及数据集)⽬录⼯作原理存在⼀个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每⼀数据与所属分类的对应关系。

输⼊没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进⾏⽐较,然后算法提取样本集中特征最相似数据(最近邻)的分类特征。

⼀般来说,我们只选择样本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不⼤于20的整数。

最后选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

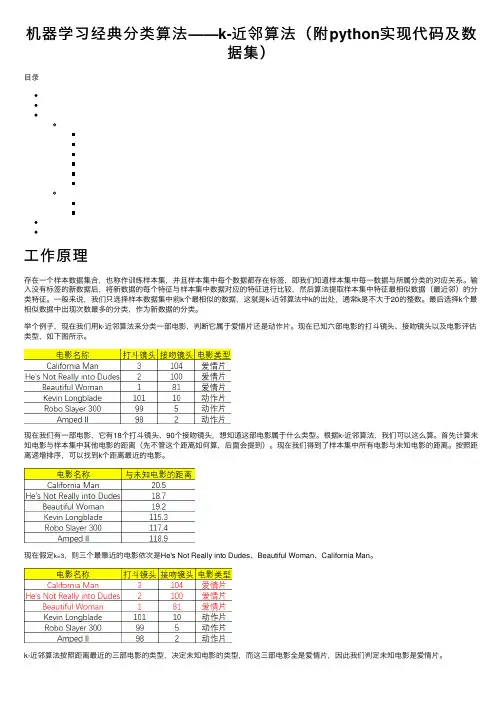

举个例⼦,现在我们⽤k-近邻算法来分类⼀部电影,判断它属于爱情⽚还是动作⽚。

现在已知六部电影的打⽃镜头、接吻镜头以及电影评估类型,如下图所⽰。

现在我们有⼀部电影,它有18个打⽃镜头、90个接吻镜头,想知道这部电影属于什么类型。

根据k-近邻算法,我们可以这么算。

⾸先计算未知电影与样本集中其他电影的距离(先不管这个距离如何算,后⾯会提到)。

现在我们得到了样本集中所有电影与未知电影的距离。

按照距离递增排序,可以找到k个距离最近的电影。

现在假定k=3,则三个最靠近的电影依次是He's Not Really into Dudes、Beautiful Woman、California Man。

python实现⾸先编写⼀个⽤于创建数据集和标签的函数,要注意的是该函数在实际⽤途上没有多⼤意义,仅⽤于测试代码。

def createDataSet():group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])labels = ['A','A','B','B']return group, labels然后是函数classify0(),该函数的功能是使⽤k-近邻算法将每组数据划分到某个类中,其伪代码如下:对未知类别属性的数据集中的每个点依次执⾏以下操作:(1)计算已知类别数据集中的点与当前点之间的距离;(2)按照距离递增次序排序;(3)选取与当前点距离最⼩的k个点;(4)确定前k个点所在类别的出现频率;(5)返回前k个点出现频率最⾼的类别作为当前点的预测分类。

多标签文本分类匹配方法比赛方案在自然语言处理领域,多标签文本分类是一项具有挑战性的任务。

为了提高分类的准确性和效率,研究者们提出了各种各样的匹配方法和比赛方案。

本文将详细介绍多标签文本分类中的匹配方法以及一些典型的比赛方案。

一、多标签文本分类概述多标签文本分类是指在一个文本中同时存在多个标签,且这些标签之间具有一定的关联性。

与传统的单标签分类不同,多标签分类任务需要模型能够识别出文本中所有的相关标签。

例如,在新闻分类任务中,一篇文章可能同时属于“体育”、“娱乐”和“财经”等多个类别。

二、匹配方法在多标签文本分类任务中,匹配方法的选择至关重要。

以下是一些常见的匹配方法:1.基于集合的方法:将标签看作一个集合,通过计算文本与每个标签的相似度,选择相似度最高的标签集合作为预测结果。

常见的基于集合的方法有K 近邻(KNN)和基于聚类的分类方法。

2.基于规则的方法:通过预定义的规则对文本进行分类。

这些规则可以是基于词汇、语法或语义的。

例如,使用正则表达式或条件随机字段(CRF)进行分类。

3.基于模型的方法:利用机器学习模型对文本进行分类。

常见的模型包括朴素贝叶斯、支持向量机(SVM)、决策树、随机森林和深度学习方法(如卷积神经网络、循环神经网络等)。

4.基于注意力机制的方法:通过为文本中的不同部分分配不同的权重,提高分类的准确性。

注意力机制可以与深度学习模型结合使用,如基于注意力机制的卷积神经网络(ACNN)和基于注意力机制的循环神经网络(ARNN)。

5.基于图的方法:将文本表示为图结构,利用图神经网络(GNN)等模型进行分类。

三、比赛方案在多标签文本分类比赛中,参赛者通常会采用以下方案:1.数据预处理:对原始数据进行清洗、去重、分词等操作,提高数据质量。

2.特征工程:从文本中提取有助于分类的特征,如词袋模型、TF-IDF、词嵌入等。

3.模型选择与调优:根据任务特点选择合适的模型,并通过交叉验证等方法对模型参数进行调优。

k-近邻分类算法K近邻分类算法是一种基于实例的分类算法,它的主要思想是通过计算每个样本点与其周围的k个最近邻点的距离来确定该点的类别。

该算法主要应用于分类问题中,并且在实际应用过程中具有很好的可用性、易实现性和理解性。

算法原理算法首先通过确定k值来确定分类的邻域大小,以及根据k值的选择来确定分类的准确性和鲁棒性。

之后通过计算每个样本点与其邻域内k个最近邻点之间的距离来确定该样本点所属的分类。

具体流程如下:1.确定数据集中的k值和距离度量标准;2.对于每个待分类的样本点,计算与其邻域中k个最近邻点之间的距离;3.根据邻域中k个最近邻点的类别来确定该样本点所属的类别;4.重复步骤2和3,直到所有待分类的样本点均被分类完毕;5.给出分类结果。

距离度量标准在k-近邻分类算法中,距离度量标准是非常重要的,因为它决定了样本点之间距离的计算方式。

目前常见的距离度量标准有欧式距离、曼哈顿距离和切比雪夫距离。

欧式距离:$d=\sqrt{{\sum_{i=1}^{n}{(x_i-y_i)^2}}}$优缺点1.基于实例,不需要对数据进行任何假设和理论分析;2.算法的可预测性高,具有很好的分类性能;3.没有过拟合的现象,可以对复杂的数据集进行分类;4.整体而言,k-近邻分类算法非常容易理解和实现。

1.计算量比较大,对于大型数据集而言,算法的效率较低;2.对于高维数据集而言,容易出现维数灾难问题,即算法的效果会逐渐降低;3.容易受到异常值的影响,且在分类决策区域方面可能存在不连续的问题。

应用场景k-近邻分类算法广泛应用于模式识别、数据挖掘和生物信息学等领域,特别适合处理较小的数据集。

目前该算法已被应用于医疗诊断、电子商务、物联网等领域,既可以用于分类问题,也可以用于回归问题。

同时,对于分类问题而言,该算法并不适用于类别数比较多或类别间存在相互交叉的情况。

因此,在实际应用过程中,应根据具体情况来选择算法,以达到最佳的分类效果。

knn算法的例子k-最近邻算法(k-nearest neighbors,简称k-NN)是一种常用的分类和回归算法。

它基于一个简单的假设:如果一个样本的k个最近邻属于某个类别,那么该样本也很可能属于该类别。

k-NN算法非常直观和易于理解,因此被广泛应用于各种领域。

下面将以几个具体的例子来说明k-NN算法的应用。

1. 手写数字识别在机器学习领域,手写数字识别是一个经典的问题。

k-NN算法可以用于将手写数字图片分类成0到9之间的数字。

基于已有的数字图片数据集,可以计算待分类图片与每个已有图片的距离,并找出k 个最近邻。

然后根据这k个最近邻的标签来判断待分类图片的数字。

2. 电影推荐系统在电影推荐系统中,k-NN算法可以根据用户的历史评分和其他用户的评分来预测用户可能喜欢的电影。

通过计算待推荐电影与用户历史评分电影的相似度,找出k个最相似的电影,并根据这些电影的评分来预测用户对待推荐电影的评分。

3. 股票市场预测k-NN算法可以用于预测股票市场的趋势。

基于已有的股票数据,可以计算待预测股票与历史股票的相似度,并找出k个最相似的股票。

然后根据这k个股票的涨跌情况来预测待预测股票的涨跌。

4. 医学诊断在医学诊断中,k-NN算法可以帮助医生根据患者的各项指标来预测患有哪种疾病。

通过计算待预测患者与已有患者的相似度,找出k 个最相似的患者,并根据这些患者的疾病情况来预测待预测患者的疾病。

5. 文本分类k-NN算法可以用于文本分类,例如将新闻文章分类成不同的主题。

基于已有的训练数据,可以计算待分类文本与每个已有文本的相似度,并找出k个最相似的文本。

然后根据这k个文本的主题来预测待分类文本的主题。

6. 信用评估在信用评估中,k-NN算法可以用于预测申请贷款的人是否具有良好的信用记录。

通过计算待评估人员与已有人员的相似度,找出k个最相似的人员,并根据这些人员的信用记录来预测待评估人员的信用状况。

7. 图像处理k-NN算法可以用于图像处理,例如图像分类和图像检索。

k近邻算法模型

K近邻算法(K-Nearest Neighbors, KNN)是一种基于实例的学习方法,它通过计算输入样本与训练样本之间的距离,找到与输入样本距离最近的K个训练样本,然后根据这K个样本的标签进行分类或回归。

K近邻算法的基本思想是:如果一个样本在特征空间中的K个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

K近邻算法的模型可以分为两种:分类模型和回归模型。

1. 分类模型

K近邻算法的分类模型是指将输入样本分到K个最近邻样本所属的类别中的多数类别。

具体步骤如下:

(1)计算训练样本集中每个样本与输入样本之间的距离。

(2)按照距离从小到大的顺序,选取K个距离最近的样本。

(3)统计这K个样本所属类别的出现次数。

(4)将输入样本分到出现次数最多的类别中。

2. 回归模型

K近邻算法的回归模型是指根据K个最近邻样本的标签值,预测输入样本的标签值。

具体步骤如下:

(1)计算训练样本集中每个样本与输入样本之间的距离。

(2)按照距离从小到大的顺序,选取K个距离最近的样本。

(3)计算这K个样本的标签值的平均值。

(4)将输入样本的标签值预测为平均值。

K近邻算法是一种简单而有效的模型,但是它也有一些缺点,比如计算复杂度高、存储空间大、容易受到噪声干扰等。

在实际应用中,需要根据具体情况选择合适的K值和距离度量方法,以取得更好的分类或回归效果。

多标签分类(multi-labelclassification)综述意义⽹络新闻往往含有丰富的语义,⼀篇⽂章既可以属于“经济”也可以属于“⽂化”。

给⽹络新闻打多标签可以更好地反应⽂章的真实意义,⽅便⽇后的分类和使⽤。

难点(1)类标数量不确定,有些样本可能只有⼀个类标,有些样本的类标可能⾼达⼏⼗甚⾄上百个。

(2)类标之间相互依赖,例如包含蓝天类标的样本很⼤概率上包含⽩云,如何解决类标之间的依赖性问题也是⼀⼤难点。

(3)多标签的训练集⽐较难以获取。

⽅法⽬前有很多关于多标签的学习算法,依据解决问题的⾓度,这些算法可以分为两⼤类:⼀是基于问题转化的⽅法,⼆是基于算法适⽤的⽅法。

基于问题转化的⽅法是转化问题数据,使之使⽤现有算法;基于算法适⽤的⽅法是指针对某⼀特定的算法进⾏扩展,从⽽能够处理多标记数据,改进算法,适⽤数据。

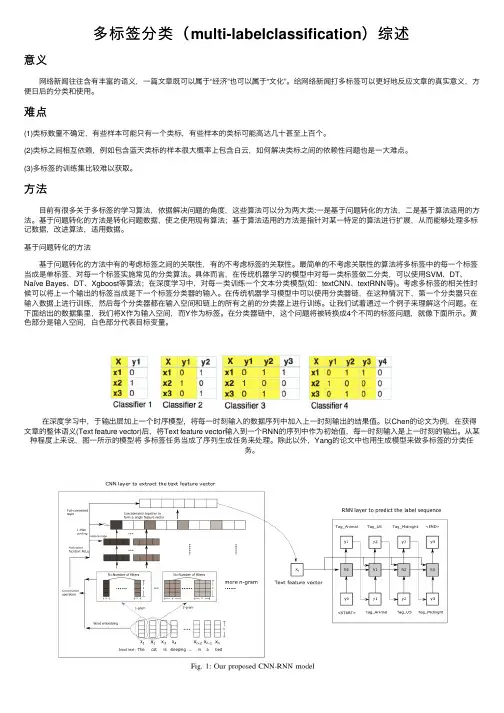

基于问题转化的⽅法基于问题转化的⽅法中有的考虑标签之间的关联性,有的不考虑标签的关联性。

最简单的不考虑关联性的算法将多标签中的每⼀个标签当成是单标签,对每⼀个标签实施常见的分类算法。

具体⽽⾔,在传统机器学习的模型中对每⼀类标签做⼆分类,可以使⽤SVM、DT、Naïve Bayes、DT、Xgboost等算法;在深度学习中,对每⼀类训练⼀个⽂本分类模型(如:textCNN、textRNN等)。

考虑多标签的相关性时候可以将上⼀个输出的标签当成是下⼀个标签分类器的输⼊。

在传统机器学习模型中可以使⽤分类器链,在这种情况下,第⼀个分类器只在输⼊数据上进⾏训练,然后每个分类器都在输⼊空间和链上的所有之前的分类器上进⾏训练。

让我们试着通过⼀个例⼦来理解这个问题。

在下⾯给出的数据集⾥,我们将X作为输⼊空间,⽽Y作为标签。

在分类器链中,这个问题将被转换成4个不同的标签问题,就像下⾯所⽰。

黄⾊部分是输⼊空间,⽩⾊部分代表⽬标变量。

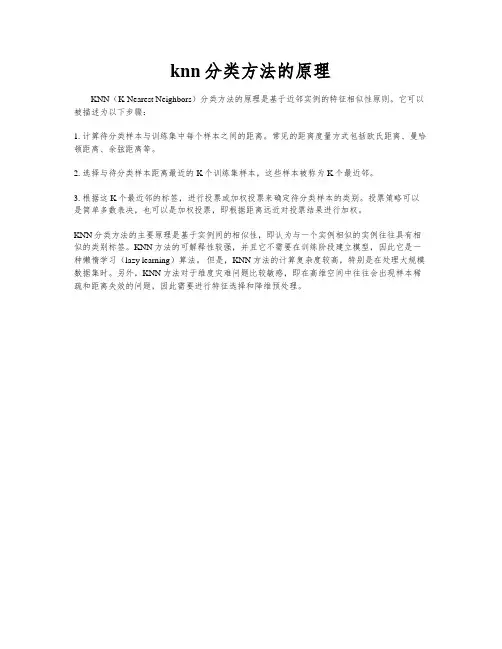

在深度学习中,于输出层加上⼀个时序模型,将每⼀时刻输⼊的数据序列中加⼊上⼀时刻输出的结果值。

knn分类方法的原理

KNN(K-Nearest Neighbors)分类方法的原理是基于近邻实例的特征相似性原则。

它可以被描述为以下步骤:

1. 计算待分类样本与训练集中每个样本之间的距离。

常见的距离度量方式包括欧氏距离、曼哈顿距离、余弦距离等。

2. 选择与待分类样本距离最近的K个训练集样本,这些样本被称为K个最近邻。

3. 根据这K个最近邻的标签,进行投票或加权投票来确定待分类样本的类别。

投票策略可以是简单多数表决,也可以是加权投票,即根据距离远近对投票结果进行加权。

KNN分类方法的主要原理是基于实例间的相似性,即认为与一个实例相似的实例往往具有相似的类别标签。

KNN方法的可解释性较强,并且它不需要在训练阶段建立模型,因此它是一种懒惰学习(lazy learning)算法。

但是,KNN方法的计算复杂度较高,特别是在处理大规模数据集时。

另外,KNN方法对于维度灾难问题比较敏感,即在高维空间中往往会出现样本稀疏和距离失效的问题,因此需要进行特征选择和降维预处理。

基于K近邻的分类算法研究沈阳航空航天大学Shenyang Aerospace University算法分析题目:基于K-近邻分类算法的研究院系计算机学院专业计算机技术姓名学号指导教师2015年 1 月摘要数据挖掘是机器学习领域内广泛研究的知识领域,是将人工智能技术和数据库技术紧密结合,让计算机帮助人们从庞大的数据中智能地、自动地提取出有价值的知识模式,以满足人们不同应用的需要。

K 近邻算法(KNN)是基于统计的分类方法,是数据挖掘分类算法中比较常用的一种方法。

该算法具有直观、无需先验统计知识、无师学习等特点,目前已经成为数据挖掘技术的理论和应用研究方法之一。

本文主要研究了K 近邻分类算法。

首先简要地介绍了数据挖掘中的各种分类算法,详细地阐述了K 近邻算法的基本原理和应用领域,其次指出了K 近邻算法的计算速度慢、分类准确度不高的原因,提出了两种新的改进方法。

针对K 近邻算法的计算量大的缺陷,构建了聚类算法与K 近邻算法相结合的一种方法。

将聚类中的K -均值和分类中的K 近邻算法有机结合。

有效地提高了分类算法的速度。

针对分类准确度的问题,提出了一种新的距离权重设定方法。

传统的KNN 算法一般采用欧式距离公式度量两样本间的距离。

由于在实际样本数据集合中每一个属性对样本的贡献作用是不尽相同的,通常采用加权欧式距离公式。

本文提出一种新的计算权重的方法。

实验表明,本文提出的算法有效地提高了分类准确度。

最后,在总结全文的基础上,指出了有待进一步研究的方向。

关键词:K 近邻,聚类算法,权重,复杂度,准确度ABSTRACTData mining is a widely field of machine learning, and it integrates the artificial intelligence technology and database technology. It helps people extract valuable knowledge from a large data intelligently and automatically to meet different people applications. KNN is a used method in data mining based on Statistic. The algorithm has become one of the ways in data mining theory and application because of intuitive, without priori statistical knowledge, and no study features.The main works of this thesis is k nearest neighbor classification algorithm. First, it introduces mainly classification algorithms of data mining and descripts theoretical base and application. This paper points out the reasons of slow and low accuracy and proposes two improved ways.In order to overcome the disadvantages of traditional KNN, this paper use two algorithms of classification and clustering to propose an improved KNN classification algorithm. Experiments show that this algorithm can speed up when it has a few effects in accuracy.According to the problem of classification accuracy, the paper proposes a new calculation of weight. KNN the traditional method generally used Continental distance formula measure the distance between the two samples. As the actual sample data collection in every attribute of a sample of the contribution is not the same, often using the weighted Continental distance formula. This paper presents a calculation of weight,that is weighted based on the characteristics of KNN algorithm. According tothis Experiments on artificial datasets show that this algorithm can improve the accuracy of classification.Last, the paper indicates the direction of research in future based on the full-text.Keywords: K Nearest Neighbor, Clustering Algorithm, Feature Weighted, Complex Degree, Classification Accuracy.前言K最近邻(k-Nearest neighbor,KNN)分类算法,是一个理论上比较成熟的方法,也是最简单的机器学习算法之一。

深度学习中的多标签分类算法随着人工智能技术的发展,深度学习已经成为智能系统的核心组成部分。

在实际应用中,我们通常需要对实例进行多个标签的分类。

例如,在图片中同时识别出不同的动物、物体和场景。

这就需要应用到深度学习中的多标签分类算法。

一、什么是多标签分类多标签分类是指一个实例可以被分为多个标签,每个标签分别代表着它所属的类别。

它通常应用于文本分类、图像分类、音频分类、视频分类等领域。

以图像分类为例,一个物体可能同时属于多个类别,如一张狗的图片可能被分类为“动物”、“宠物”、“狗”等多个类别。

在传统的图像分类方法中,通常只考虑一个标签,而多标签分类则可以为它们赋予多个标签。

二、多标签分类的应用多标签分类在实际应用中非常广泛。

例如,在社交媒体平台上,我们可以使用多标签分类算法来标记用户的兴趣和行为。

在医学图像诊断中,我们可以使用多标签分类来辅助医生进行病理鉴定和诊断。

在商品推荐中,我们可以使用多标签分类来为用户推荐更相关的商品。

三、在深度学习中,多标签分类的主要算法包括卷积神经网络(CNN)、循环神经网络(RNN)和注意力机制等。

在CNN中,我们可以使用多通道卷积来实现多标签分类。

例如,在图像分类领域,我们可以通过某种方法将多个标签融合成一个标签向量,然后利用多通道卷积实现多标签分类。

在RNN中,我们可以使用门控循环单元(GRU)和长短时记忆网络(LSTM)等方法来实现多标签分类。

这种方法可以有效地利用序列中的上下文信息。

在注意力机制中,我们可以使用注意力加权的方法来获得特征的重要性,并更好地实现多标签分类。

例如,在图像分类中,我们可以利用注意力机制来进一步挖掘图像中的内容信息,从而更好地识别多个标签。

四、多标签分类的评价指标在多标签分类中,我们通常使用以下指标来评价模型:1.准确率(Accuracy):分类正确的样本数与总样本数之比。

2.精确率(Precision):分类为正的样本中真正是正的样本数与分类为正的样本数之比。

多标签分类问题的解决方法多标签分类问题是机器学习和自然语言处理中常见的挑战之一。

在多标签分类问题中,每个样本可以被分配多个标签,与传统的单标签分类问题不同。

解决多标签分类问题需要使用特定的算法和技术来处理数据,从而准确地预测多个标签。

在本文中,我们将探讨几种常用的方法来解决多标签分类问题。

这些方法包括二进制方法、递归方法、问题转化方法和集成方法。

首先,我们来介绍二进制方法。

在这种方法中,将多标签分类问题转化为多个独立的二进制分类问题。

对于每个标签,训练一个二进制分类器来预测该标签的存在与否。

这种方法的优点是简单易懂,易于理解和实现。

然而,它忽略了标签之间的相关性,可能导致预测结果不够准确。

接下来,我们讨论递归方法。

递归方法是基于决策树的算法,通过递归地划分样本空间来预测多个标签。

该方法考虑了标签之间的相互关系,并通过递归地划分样本子集来预测每个标签。

递归方法的优点是能够准确地预测相关性较强的标签。

然而,该方法在处理大规模数据集时可能效率较低。

另一种常见的方法是问题转化方法。

在这种方法中,将多标签分类问题转化为其他类型的问题,例如多类分类或回归问题。

然后使用单标签分类或回归方法来解决转化后的问题。

问题转化方法的优点是可以使用各种现有的分类或回归算法来解决多标签分类问题。

然而,这种方法可能忽略了标签之间的相关性,导致预测结果不准确。

最后,我们介绍集成方法。

集成方法将多个独立的分类器组合起来,通过投票或权重相结合的方式来预测多个标签。

这种方法的优点是能够利用不同分类器之间的互补性,提高分类性能。

集成方法可以使用各种集成学习算法,例如随机森林、梯度提升树等。

然而,集成方法可能需要更多的计算资源和训练时间。

除了以上提到的方法,还有其他一些变种方法可以解决多标签分类问题,例如基于图的方法、深度学习方法等。

这些方法在不同的场景下可能具有更好的性能和效果。

选择合适的方法取决于数据集的特征、分类任务的复杂性和可用的计算资源等因素。

k近邻算法的应用实例k近邻算法是一种常用的机器学习算法,其主要用于分类和回归问题。

在分类问题中,k近邻算法基于已知类别的样本集合,对新样本进行分类。

在回归问题中,k近邻算法基于已知数值型的样本集合,对新样本进行数值预测。

以下是k近邻算法的应用实例:1. 手写数字识别:k近邻算法可以用于识别手写数字。

训练数据集包含许多手写数字的图像和对应的类别标签,测试数据集包含未知的手写数字图像,需要对其进行分类。

使用k近邻算法,可以将测试数据集中的每个图像与训练数据集中的所有图像进行比较,并找到最近的k个邻居。

然后,根据这k个邻居的类别标签,预测测试数据集中图像的类别。

2. 电商推荐系统:k近邻算法可以用于电商推荐系统,预测用户可能感兴趣的商品。

该算法基于用户历史购买数据和商品描述数据,将用户与最相似的一组其他用户进行比较,找到最近的k个邻居。

然后,通过分析邻居们的购买历史,预测用户可能感兴趣的商品。

3. 医学诊断:k近邻算法可以用于医学诊断,例如预测患者是否患有某种疾病。

训练数据集包含已知患病和健康的患者的数据,测试数据集是需要进行预测的患者。

通过将测试患者的数据与训练数据集中的所有患者进行比较,可以找到最近的k个邻居。

然后,通过分析邻居们的症状和疾病历史,预测测试患者是否患有某种疾病。

4. 金融风险评估:k近邻算法可以用于金融风险评估,例如预测借款人是否会按时还款。

训练数据集包含已知借款人的还款历史和其他信息,测试数据集是需要进行预测的借款人。

通过将测试借款人的数据与训练数据集中的所有借款人进行比较,可以找到最近的k个邻居。

然后,通过分析邻居们的还款历史和其他信息,预测测试借款人是否会按时还款。

总之,k近邻算法在许多实际应用中都发挥着重要作用,可以用于分类、回归和推荐等问题。

kneighborsclassifier 函数是Python中常用的机器学习算法之一,它用于解决分类问题,属于监督学习算法的一种。

本文将对kneighborsclassifier 函数的定义、使用方法、参数说明以及实际案例进行详细介绍,帮助读者全面了解和掌握这一重要的机器学习工具。

一、kneighborsclassifier 函数的定义kneighborsclassifier 函数是用于K近邻分类算法的工具,它基于实例的学习(instance-based learning),是一种非参数方法,不假定数据的分布情况。

K近邻算法的核心思想是通过测量不同特征之间的距离来对数据进行分类,对于一个待分类的样本,根据与其距离最近的K个已知分类样本的类别来确定其所属类别。

这种算法对数据的分布没有假设,适用于各种类型的数据,因此在实际应用中被广泛使用。

二、kneighborsclassifier 函数的使用方法kneighborsclassifier 函数属于Python中的scikit-learn库(sklearn),其使用方法非常简单。

首先需要导入sklearn库:```pythonfrom sklearn.neighbors import KNeighborsClassifier```然后创建一个KNeighborsClassifier对象,并设定K值(即确定最近的K个邻居):```pythonknn = KNeighborsClassifier(n_neighbors=3)```接下来,使用fit方法对模型进行训练,将训练集的特征数据和对应的分类标签作为参数传入:```pythonknn.fit(X_train, y_train)```可以使用predict方法对新的数据进行分类预测:```pythony_pred = knn.predict(X_test)```三、kneighborsclassifier 函数的参数说明在创建KNeighborsClassifier对象时,可以根据实际情况传入不同的参数进行个性化设置,常用的参数包括:1. n_neighbors:K值,即确定最近的K个邻居。

基于邻域的算法基于邻域的算法是一种常用的数据挖掘和机器学习方法,它主要是基于某个样本的邻居来推断该样本的特征或标签。

在实际应用中,基于邻域的算法被广泛应用于分类、聚类、推荐系统等领域。

基于邻域的算法有很多种,其中最常见的包括k最近邻算法、均值漂移算法和DBSCAN算法等。

下面将分别介绍这几种算法的原理和应用。

1. k最近邻算法(k-Nearest Neighbor,简称kNN)是最简单、最常用的基于邻域的算法之一。

其基本原理是通过计算待分类样本与训练集中各个样本之间的距离,找出距离最近的k个邻居,然后根据这k个邻居的标签来预测待分类样本的标签。

kNN算法适用于多分类和二分类问题,且对样本的分布情况没有太高要求。

2. 均值漂移算法(Mean Shift)是一种基于邻域密度的密度估计方法。

其原理是通过计算样本点周围邻域内点的密度分布情况,将样本点向密度高的方向移动,直到达到局部最大密度。

均值漂移算法的应用比较广泛,包括图像分割、无监督聚类等。

3. DBSCAN算法(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法,可以自动发现具有各种形状的聚类,并能够将孤立点(噪声)排除在外。

该算法的核心是通过计算样本点周围邻域内的密度,并通过设置一定的密度阈值和最小样本数来划分聚类。

DBSCAN算法广泛应用于图像分割、异常检测等领域。

基于邻域的算法有以下几个特点:1. 算法简单易于实现:基于邻域的算法通常基于简单的原理,易于理解和实现,不需要太多的数学基础。

2. 高效处理大规模数据:由于基于邻域的算法主要关注于局部信息,而不需要全局计算,因此适用于处理大规模数据。

3. 对数据分布要求较低:基于邻域的算法对数据的分布情况没有太高要求,可以处理各种形状和密度的数据。

在实际应用中,基于邻域的算法被广泛应用于各个领域。

例如,在推荐系统中,可以利用基于邻域的算法来为用户推荐相似的商品或用户;在文本分类中,可以利用kNN算法来根据文本的内容将其分类至相应的类别;在图像处理中,可以利用均值漂移算法来实现图像分割等。

k-近邻算法的运用场景

K-近邻算法是一种基于实例的学习算法,它主要用于分类和回归问题。

以下是一些K-近邻算法的应用场景:

1.分类问题:K-近邻算法是一种非常常用的分类算法,它可以用于多种分类问

题,例如垃圾邮件识别、图像分类、文本分类等。

2.回归问题:除了分类问题之外,K-近邻算法也可以用于回归问题,例如预测

房价、股票价格等。

3.异常检测:K-近邻算法也可以用于异常检测,例如检测信用卡欺诈、医疗诊

断中的异常病例等。

4.聚类分析:K-近邻算法也可以用于聚类分析,例如市场细分、社交网络分析

等。

5.推荐系统:K-近邻算法可以用于推荐系统,例如电影推荐、商品推荐等。

总之,K-近邻算法是一种非常通用的机器学习算法,它可以应用于多种场景中,包括分类、回归、异常检测、聚类分析和推荐系统等。

【机器学习】k-近邻算法以及算法实例时间 2015-01-26 14:31:00 博客园-原创精华区原文/jtianwen2014/p/4249003.html主题算法数据挖掘机器学习中常常要用到分类算法,在诸多的分类算法中有一种算法名为k-近邻算法,也称为kNN算法。

一、kNN算法的工作原理二、适用情况三、算法实例及讲解---1.收集数据---2.准备数据---3.设计算法分析数据---4.测试算法一、kNN算法的工作原理官方解释:存在一个样本数据集,也称作训练样本集,并且样本中每个数据都存在标签,即我们知道样本集中每一数据与所属分类的对应关系,输入没有标签的新数据后,将新数据的每个特征与样本集中的数据对应的特征进行比较,然后算法提取样本集中特征最相似的数据(最近邻)的分类标签。

一般来说,我们只选择样本集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不大于20的整数,最后,选择k个最相似的数据中出现次数最多的分类,作为新数据的分类。

我的理解:k-近邻算法就是根据“新数据的分类取决于它的邻居”进行的,比如邻居中大多数都是退伍军人,那么这个人也极有可能是退伍军人。

而算法的目的就是先找出它的邻居,然后分析这几位邻居大多数的分类,极有可能就是它本省的分类。

二、适用情况优点:精度高,对异常数据不敏感(你的类别是由邻居中的大多数决定的,一个异常邻居并不能影响太大),无数据输入假定;缺点:计算发杂度高(需要计算新的数据点与样本集中每个数据的“距离”,以判断是否是前k个邻居),空间复杂度高(巨大的矩阵);适用数据范围:数值型(目标变量可以从无限的数值集合中取值)和标称型(目标变量只有在有限目标集中取值)。

三、算法实例及讲解例子中的案例摘《机器学习实战》一书中的,代码例子是用python编写的(需要matplotlib和numpy库),不过重在算法,只要算法明白了,用其他语言都是可以写出来的:海伦一直使用在线约会网站寻找合适自己的约会对象。