LINUX下多路径(详细)

- 格式:docx

- 大小:930.04 KB

- 文档页数:10

linux多路径multipath 参数在Linux系统中,多路径是一种常见的冗余技术,用于提高系统的可靠性和稳定性。

Multipath则是Linux中实现多路径的一种机制,它能够自动选择最合适的路径来传输数据,从而提高了系统的性能和可靠性。

在本篇文章中,我们将介绍Linux多路径Multipath的参数。

一、Multipath工作原理Multipath是一种自动选择最佳路径来传输数据的机制,它使用多个路径来连接不同的存储设备或网络资源。

当系统需要访问存储设备上的数据时,Multipath会根据各个路径的性能和可靠性等因素,自动选择最合适的路径来传输数据。

这种机制提高了系统的性能和可靠性,因为即使某个路径出现故障,系统仍然可以使用其他路径来访问数据。

二、Multipath参数配置在Linux系统中,可以通过配置Multipath的参数来优化系统的性能和可靠性。

以下是一些常见的Multipath参数及其说明:1. `dm.multipath`:该参数用于启用或禁用Multipath机制。

将其设置为`1`以启用Multipath,设置为`0`以禁用。

2. `dm.scan`:该参数用于指定应搜索哪些设备以启用Multipath。

常见的值包括`all`(搜索所有设备)和`loop`(仅搜索loop设备)。

3. `dm.service_timeout`:该参数用于设置Multipath服务的超时时间。

默认值为60秒。

4. `dm.scan_tmo`:该参数用于设置扫描设备的超时时间。

默认值为3秒。

5. `multipath.scan_interval`:该参数用于设置Multipath自动扫描设备的间隔时间。

默认值为1秒。

6. `multipath.default_timeout`:该参数用于设置默认的块设备超时时间。

7. `multipath.find_tune`:该参数用于指定是否应该自动调整设备组的性能设置。

linux 文件路径写法

Linux文件路径分为两种:绝对路径和相对路径。

1. 绝对路径:从根目录(/)开始到目标文件或目录的完整路径。

例如:/usr/share/doc。

2. 相对路径:基于当前目录的路径。

例如,从当前目录到上级目录的路径表示为“..”,到子目录的路径表示为“./子目录名”。

在Linux中,还可以使用以下方法表示路径:

-根目录:使用“/”表示,例如:/home/user/documents

-当前目录:使用“.”表示,例如:./documents

-上级目录:使用“..”表示,例如:../documents

-当前目录下的文件或目录:直接使用文件或目录名,例如:documents

总结一下,Linux文件路径的写法主要包括以下几种:

-绝对路径:/根目录/目录名/文件名

-相对路径:./子目录名/文件名、../上级目录名/文件名、当前目录名

/文件名

在实际使用中,可以根据需要选择使用绝对路径或相对路径。

需要注意的是,路径中的空格和特殊字符需要正确处理,以避免出现错误。

linux sdk常用路径Linux SDK是开发者在Linux操作系统上进行软件开发时所使用的软件开发工具包,其中包含了一些常用的路径。

本文将介绍一些常用的Linux SDK路径,并简要说明其作用。

1. /usr/include该路径下存放了系统标准库的头文件,开发者可以在自己的代码中使用这些头文件提供的函数和数据结构。

这些头文件定义了许多常用的函数和类型,使开发者可以方便地进行编程。

2. /usr/lib这个路径下存放了系统的共享库文件,开发者在编译和链接程序时,可以使用这些共享库提供的函数和数据结构。

共享库是一种可以被多个程序共享使用的代码库,它可以减小程序的体积,提高代码的复用性。

3. /usr/bin该路径下存放了系统的可执行文件,开发者可以在终端中直接运行这些可执行文件,或者在自己的程序中调用这些可执行文件。

这些可执行文件包括系统提供的一些常用命令,如ls、cp等,以及一些开发者常用的工具,如gcc、gdb等。

4. /usr/local/include这个路径下存放了用户自定义库的头文件,开发者可以将自己编写的库的头文件放在这个路径下,以供其他程序使用。

这样做可以方便其他开发者在编写程序时使用你的库。

5. /usr/local/lib该路径下存放了用户自定义库的共享库文件,开发者可以将自己编写的库的共享库文件放在这个路径下,以供其他程序链接和使用。

这样做可以方便其他开发者在编译和链接程序时使用你的库。

6. /usr/local/bin这个路径下存放了用户自定义的可执行文件,开发者可以将自己编写的可执行文件放在这个路径下,以供自己和其他用户直接运行。

这样做可以方便其他用户使用你的程序。

7. /opt该路径下存放了一些第三方软件的安装目录,开发者可以将一些不属于系统标准库的库文件和可执行文件放在这个路径下,以供自己和其他用户使用。

这些软件通常是一些额外的工具或库,不属于系统的默认安装内容。

RHEL系统带有iSCSI initiator软件,下面描述如何配置iSCSI Initiator实现对ISCSI卷的访问1.Linux iscsi 介绍(这一条介绍了linux iscsi的基本原理和相关命令,具体配置时可略过)在Linux内核中提供了iscsi驱动,iSCSI 驱动(driver)使主机拥有了通过IP网络访问存储的能力,驱动在主机(Initiator)和服务端(Target)间使用iSCSI协议在TCP/IP 网上传输SCSI请求和响应,在构建上,iSCSI驱动与TCP/IP栈、网络驱动和网络接口卡(NIC)结合,其等同于SCSI或光纤通道卡适配器驱动对主机总线卡(HBA)的作用。

驱动采用采用模块的方式,具体模块包括iscsi_tcp, libiscsi, libiscsi_tcp。

Initiator守护进程介绍:/etc/iscsi/iscsid.conf --initiator配置文件/sbin/iscsiadm --initiator管理工具open-iscsi包括两个守护进程iscsid和iscsi,其中iscsid是主进程,iscsi进程则主要负责根据配置,在系统启动时进行发起端(Initiator)到服务端(target)的登录,建立发起端与服务端的会话,使主机在启动后即可使用通过iSCSI提供服务的存储设备。

iscsid 进程实现iSCSI协议的控制路径以及相关管理功能。

例如守护进程(指iscsid)可配置为在系统启动时基于持久化的iSCSI数据库内容,自动重新开始发现(discovery)目标设备。

Initiator配置介绍(前提是已经安装iSCSI initiator)1> iSCSI initiator 名称设置initiator名称用来唯一标识一个iSCSI Initiator端。

保存此名称的配置文件为 /etc/iscsi/initiatorname.iscsi,命名规则可采用iqn-type格式,利用 iscsi-iname命令可产出一个名称,将此名称输入到initiatorname.iscsi配置文件即可。

Red Hat Enterprise Linux 7DM 多路径Configuring and managing Device Mapper MultipathLast Updated: 2023-03-25Red Hat Enterprise Linux 7 DM 多路径Configuring and managing Device Mapper Multipath Steven LevineRed Hat Customer Content Services******************. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .目录第 1 章 设备映射器多路径1.1. NEW AND CHANGED FEATURES 1.2. OVERVIEW OF DM MULTIPATH 1.3. 存储阵列支持1.4. DM MULTIPATH COMPONENTS1.5. DM MULTIPATH SETUP OVERVIEW 第 2 章 多路径设备2.1. 多路径设备识别器2.2. 在群集中保持多路径设备名称一致2.3. 多路径设备属性2.4. 逻辑卷中的多路径设备第 3 章 SETTING UP DM MULTIPATH 3.1. SETTING UP DM MULTIPATH 3.2. 在生成多路径设备时忽略逻辑磁盘3.3. CONFIGURING STORAGE DEVICES 3.4. SETTING UP MULTIPATHING IN THE INITRAMFS FILE SYSTEM 第 4 章 THE DM MULTIPATH CONFIGURATION FILE 4.1. 配置文件总览4.2. 配置文件黑名单4.3. 配置文件默认设置4.4. 多路径设备配置属性4.5. 配置文件设备4.6. ISCSI AND DM MULTIPATH OVERRIDES 第 5 章 DM MULTIPATH ADMINISTRATION AND TROUBLESHOOTING5.1. AUTOMATIC CONFIGURATION FILE GENERATION WITH MULTIPATH HELPER 5.2. RESIZING AN ONLINE MULTIPATH DEVICE 5.3. MOVING ROOT FILE SYSTEMS FROM A SINGLE PATH DEVICE TO A MULTIPATH DEVICE 5.4. MOVING SWAP FILE SYSTEMS FROM A SINGLE PATH DEVICE TO A MULTIPATH DEVICE 5.5. THE MULTIPATH DAEMON 5.6. ISSUES WITH QUEUE_IF_NO_PATH FEATURE 5.7. MULTIPATH COMMAND OUTPUT 5.8. MULTIPATH QUERIES WITH MULTIPATH COMMAND 5.9. MULTIPATH COMMAND OPTIONS 5.10. 使用 DMSETUP 命令确定设备映射器条目5.11. THE MULTIPATHD COMMANDS 5.12. TROUBLESHOOTING WITH THE MULTIPATHD INTERACTIVE CONSOLE 5.13. CLEANING UP MULTIPATH FILES ON PACKAGE REMOVAL 附录 A. 修订记录索引335778999101012121314151616172031364345454545474747484949505051525354目录1DM 多路径2第 1 章设备映射器多路径3DM 多路径4第 1 章设备映射器多路径5DM 多路径6第 1 章设备映射器多路径在这个配置中,可将 I/O分布到那四条路径中。

multipath-tools 原理multipath-tools是一个用于Linux系统的多路径软件,它可以将多个路径绑定在一起,形成一个逻辑上的设备,从而提高系统的可靠性和性能。

其原理如下:1. 多路径设备的定义在Linux系统中,每个磁盘设备都有一个唯一的标识符,称为WWN(World Wide Name)。

多路径设备是由多个WWN相同的磁盘设备组成的,这些设备可以是不同的物理路径,也可以是同一路径上的不同端口。

在多路径设备中,只有一个设备是活动的,其他设备处于备用状态。

2. 多路径设备的管理multipath-tools通过将多个路径绑定在一起,形成一个逻辑上的设备,从而提高系统的可靠性和性能。

在多路径设备中,只有一个设备是活动的,其他设备处于备用状态。

当活动设备发生故障时,备用设备会自动接管工作,从而保证系统的连续性。

3. 多路径设备的配置在Linux系统中,多路径设备的配置通常需要在multipath.conf文件中进行。

该文件包含了多路径设备的配置信息,包括设备的WWN、路径的优先级、设备的属性等。

在配置文件中,还可以定义多个路径组,每个路径组包含多个路径,用于提高系统的可靠性和性能。

4. 多路径设备的使用在使用多路径设备时,需要先将其格式化为文件系统,然后挂载到系统中。

在挂载时,可以使用/dev/mapper/路径来代替实际的设备路径,这样可以避免在多路径设备发生故障时,系统无法访问数据的情况。

总结:multipath-tools是一个用于Linux系统的多路径软件,可以将多个路径绑定在一起,形成一个逻辑上的设备,从而提高系统的可靠性和性能。

其原理包括多路径设备的定义、管理、配置和使用。

在Linux系统中,多路径(Multipath)是一种提高存储系统可靠性和性能的技术,通常用于连接主机和存储设备的复杂存储网络中。

多路径技术允许多条路径同时连接主机和存储设备,提高系统的冗余性和负载均衡性。

以下是一些与Linux 多路径相关的概念和操作:1. 多路径概念:1. 路径(Path):-指连接主机和存储设备之间的物理通道。

一个存储设备可以有多个路径。

2. 多路径设备(Multipath Device):-将多个路径组合在一起,形成一个逻辑上的多路径设备。

这个设备会在主机上被当作一个单一的设备来使用,但它会通过多个路径连接到存储设备。

3. 多路径I/O(Multipath I/O):-主机使用多个路径同时进行I/O 操作,以提高性能和可靠性。

2. 多路径软件:1. Device Mapper(DM):-Linux 中使用Device Mapper 实现多路径支持。

multipathd是Device Mapper 的用户空间管理工具,用于检测和管理多路径设备。

2. Multipath Configuration Files:- /etc/multipath.conf是Multipath 的配置文件,可以定义多路径设备的行为、超时设置、路径选择策略等。

3. 操作和命令:1. 安装Multipath 工具:-使用包管理工具安装Multipath 工具,如在基于Debian/Ubuntu 的系统中可以使用apt-get,在基于Red Hat/CentOS 的系统中可以使用yum。

# Debian/Ubuntusudo apt-get install multipath-tools# Red Hat/CentOSsudo yum install device-mapper-multipath2. 配置Multipath:-编辑/etc/multipath.conf文件,配置多路径设备的行为和参数。

LINUX下多路径(multi-path)介绍及使用一、什么是多路径普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。

而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。

也就是说,主机到存储可以有多条路径可以选择。

主机到存储之间的IO由多条路径可以选择。

每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。

多路径软件就是为了解决上面的问题应运而生的。

多路径的主要功能就是和存储设备一起配合实现如下功能:1.故障的切换和恢复2.IO流量的负载均衡3.磁盘的虚拟化由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。

并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。

比如EMC公司基于linux下的多路径软件,就需要单独的购买license。

好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

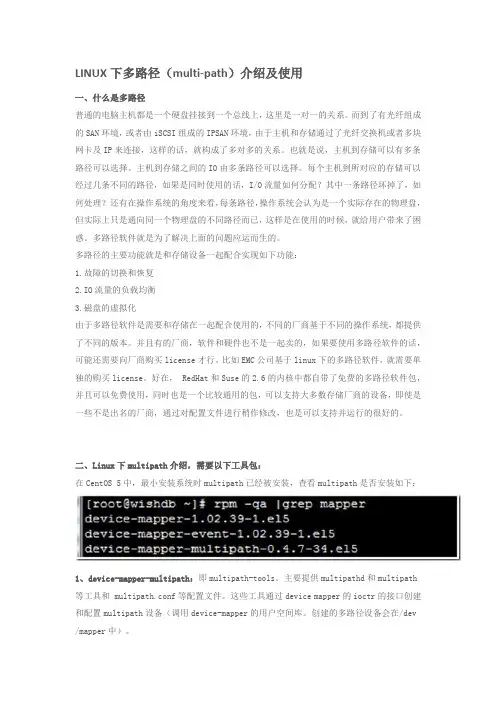

二、Linux下multipath介绍,需要以下工具包:在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:1、device-mapper-multipath:即multipath-tools。

主要提供multipathd和multipath 等工具和 multipath.conf等配置文件。

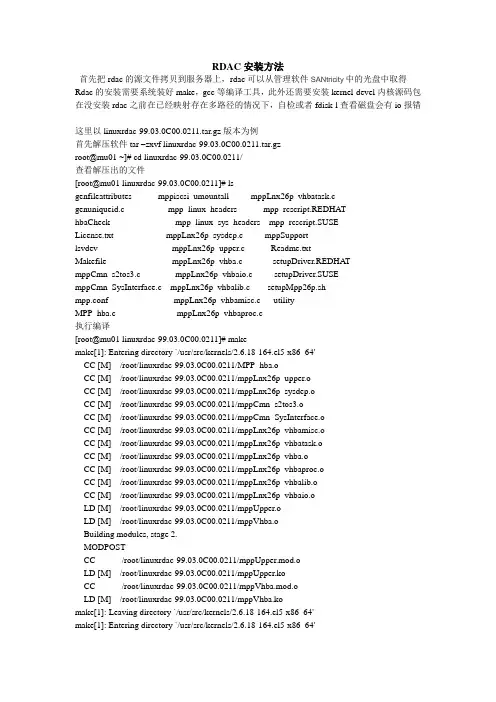

RDAC安装方法首先把rdac的源文件拷贝到服务器上,rdac可以从管理软件SANtricity中的光盘中取得Rdac的安装需要系统装好make,gcc等编译工具,此外还需要安装kernel-devel内核源码包在没安装rdac之前在已经映射存在多路径的情况下,自检或者fdisk-l查看磁盘会有io报错这里以linuxrdac-99.03.0C00.0211.tar.gz版本为例首先解压软件tar –zxvf linuxrdac-99.03.0C00.0211.tar.gzroot@mu01 ~]# cd linuxrdac-99.03.0C00.0211/查看解压出的文件[root@mu01 linuxrdac-99.03.0C00.0211]# lsgenfileattributes mppiscsi_umountall mppLnx26p_vhbatask.cgenuniqueid.c mpp_linux_headers mpp_rcscript.REDHAThbaCheck mpp_linux_sys_headers mpp_rcscript.SUSELicense.txt mppLnx26p_sysdep.c mppSupportlsvdev mppLnx26p_upper.c Readme.txtMakefile mppLnx26p_vhba.c setupDriver.REDHA TmppCmn_s2tos3.c mppLnx26p_vhbaio.c setupDriver.SUSEmppCmn_SysInterface.c mppLnx26p_vhbalib.c setupMpp26p.shmpp.conf mppLnx26p_vhbamisc.c utilityMPP_hba.c mppLnx26p_vhbaproc.c执行编译[root@mu01 linuxrdac-99.03.0C00.0211]# makemake[1]: Entering directory `/usr/src/kernels/2.6.18-164.el5-x86_64'CC [M] /root/linuxrdac-99.03.0C00.0211/MPP_hba.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_upper.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_sysdep.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppCmn_s2tos3.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppCmn_SysInterface.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhbamisc.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhbatask.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhba.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhbaproc.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhbalib.oCC [M] /root/linuxrdac-99.03.0C00.0211/mppLnx26p_vhbaio.oLD [M] /root/linuxrdac-99.03.0C00.0211/mppUpper.oLD [M] /root/linuxrdac-99.03.0C00.0211/mppVhba.oBuilding modules, stage 2.MODPOSTCC /root/linuxrdac-99.03.0C00.0211/mppUpper.mod.oLD [M] /root/linuxrdac-99.03.0C00.0211/mppUpper.koCC /root/linuxrdac-99.03.0C00.0211/mppVhba.mod.oLD [M] /root/linuxrdac-99.03.0C00.0211/mppVhba.komake[1]: Leaving directory `/usr/src/kernels/2.6.18-164.el5-x86_64'make[1]: Entering directory `/usr/src/kernels/2.6.18-164.el5-x86_64'Building modules, stage 2.MODPOSTmake[1]: Leaving directory `/usr/src/kernels/2.6.18-164.el5-x86_64'gcc -g -I/root/linuxrdac-99.03.0C00.0211 -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_headers/ -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_sys_headers/ -c ./utility/mppUtil.c -o mppUtil.o /bin/bash ./genfileattributes bldgcc -g -I/root/linuxrdac-99.03.0C00.0211 -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_headers/ -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_sys_headers/ -c ./utility/mppUtil26p_sysdep.c -o mppUtilSysdep.ogcc mppUtil.o mppUtilSysdep.o -o mppUtilgcc -o genuniqueid genuniqueid.c执行安装,执行安装完毕后会被/boot目录下生成mpp开头的initrd内核映像文件[root@mu01 linuxrdac-99.03.0C00.0211]# make installmake[1]: Entering directory `/usr/src/kernels/2.6.18-164.el5-x86_64'Building modules, stage 2.MODPOSTmake[1]: Leaving directory `/usr/src/kernels/2.6.18-164.el5-x86_64'make[1]: Entering directory `/usr/src/kernels/2.6.18-164.el5-x86_64'Building modules, stage 2.MODPOSTmake[1]: Leaving directory `/usr/src/kernels/2.6.18-164.el5-x86_64'/bin/bash ./genfileattributes bldgcc -g -I/root/linuxrdac-99.03.0C00.0211 -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_headers/ -I/root/linuxrdac-99.03.0C00.0211/mpp_linux_sys_headers/ -c ./utility/mppUtil26p_sysdep.c -o mppUtilSysdep.ogcc mppUtil.o mppUtilSysdep.o -o mppUtilChecking Host Adapter Configuration...iSCSI software initiator found. Do you want MPP to manage an iSCSI storage array?Do you want to continue (yes or no) ? yesPlease wait while we modify the system configuration files.Your kernel version is 2.6.18-164.el5Preparing to install MPP driver against this kernel version...Generating module dependencies...Creating new MPP initrd image...红色为生成的mpp 内核映像[root@mu01 ~]# cd /boot[root@mu01 boot]# lsconfig-2.6.18-164.el5 initrd-2.6.18-164.el5_old.img mpp-2.6.18-164.el5xen.img vmlinuz-2.6.18-164.el5config-2.6.18-164.el5xen initrd-2.6.18-164.el5xen.img symvers-2.6.18-164.el5.gz vmlinuz-2.6.18-164.el5xengrub initrd-2.6.18-164.el5xen_old.img symvers-2.6.18-164.el5xen.gz xen.gz-2.6.18-164.el5initrd-2.6.18-164.el5.img lost+foundSystem.map-2.6.18-164.el5 xen-syms-2.6.18-164.el5initrd-2.6.18-164.el5kdump.img memtest86+-1.65 System.map-2.6.18-164.el5xen接下来需要把grub的把内核指向新生成的mpp内核注意:linux系统可能存在多个内核,在哪个内核下编译的rdac生成的mpp映像对应的此内核例如下面的例子系统是在Red Hat Enterprise Linux Server (2.6.18-164.el5xen)内核下编译的那么把需要修改Red Hat Enterprise Linux Server (2.6.18-164.el5xen)内核的initrd指向新生成的mpp内核,假如想Red Hat Enterprise Linux Server (2.6.18-164.el5)内核下mpio软件生效需要进系统时选择进此内核然后然后在此内核下编译指向相应的mpp映像更改前[root@mu01 grub]# cat grub.conf# grub.conf generated by anaconda## Note that you do not have to rerun grub after making changes to this file# NOTICE: You have a /boot partition. This means that# all kernel and initrd paths are relative to /boot/, eg.# root (hd0,0)# kernel /vmlinuz-version ro root=/dev/rootvg/lv0# initrd /initrd-version.img#boot=/dev/sdadefault=1timeout=5splashimage=(hd0,0)/grub/splash.xpm.gzhiddenmenutitle Red Hat Enterprise Linux Server (2.6.18-164.el5xen)root (hd0,0)kernel /xen.gz-2.6.18-164.el5module /vmlinuz-2.6.18-164.el5xen ro root=/dev/rootvg/lv0 rhgb quietmodule /initrd-2.6.18-164.el5xen.imgtitle Red Hat Enterprise Linux Server (2.6.18-164.el5)root (hd0,0)kernel /vmlinuz-2.6.18-164.el5 ro root=/dev/rootvg/lv0 rhgb quietinitrd /initrd-2.6.18-164.el5.img更改后[root@mu01 grub]# cat grub.conf# grub.conf generated by anaconda## Note that you do not have to rerun grub after making changes to this file# NOTICE: You have a /boot partition. This means that# all kernel and initrd paths are relative to /boot/, eg.# root (hd0,0)# kernel /vmlinuz-version ro root=/dev/rootvg/lv0# initrd /initrd-version.img#boot=/dev/sdadefault=0timeout=5splashimage=(hd0,0)/grub/splash.xpm.gzhiddenmenutitle Red Hat Enterprise Linux Server (2.6.18-164.el5xen)root (hd0,0)kernel /xen.gz-2.6.18-164.el5module /vmlinuz-2.6.18-164.el5xen ro root=/dev/rootvg/lv0 rhgb quietmodule / mpp-2.6.18-164.el5xen.imgtitle Red Hat Enterprise Linux Server (2.6.18-164.el5)root (hd0,0)kernel /vmlinuz-2.6.18-164.el5 ro root=/dev/rootvg/lv0 rhgb quietinitrd /initrd-2.6.18-164.el5.img查看多路径方法在radc make完毕后会生成mppUtil工具可以./mppUtil –g 0可以显示路径状态[root@mu01 linuxrdac-99.03.0C00.0211]# ./mppUtil -g 0Hostname = mu01Domainname = (none)Time = GMT 08/18/2010 11:58:53MPP Information:----------------ModuleName: AS1000G3 SingleController: N VirtualTargetID: 0x000 ScanTriggered: N ObjectCount: 0x000 A VTEnabled: N WWN: 60080e50001828f6000000004c60bd43 RestoreCfg: N ModuleHandle: none Page2CSubPage: Y FirmwareVersion: 7.60.34.xxScanTaskState: 0x00000000LBPolicy: LeastQueueDepthController 'A' Status:-----------------------ControllerHandle: none ControllerPresent: Y UTMLunExists: Y (007) Failed: N NumberOfPaths: 1 FailoverInProg: NServiceMode: NPath #1---------DirectoryVertex: present Present: Y PathState: OPTIMALPathId: 77020000 (hostId: 2, channelId: 0, targetId: 0)Controller 'B' Status:-----------------------ControllerHandle: none ControllerPresent: Y UTMLunExists: Y (007) Failed: N NumberOfPaths: 1 FailoverInProg: NServiceMode: NPath #1---------DirectoryVertex: present Present: Y PathState: OPTIMALPathId: 77010000 (hostId: 1, channelId: 0, targetId: 0)Lun Information---------------Lun #0 - WWN: 60080e5000181d8c000005e94c6a1995----------------LunObject: present CurrentOwningPath: A RemoveEligible: N BootOwningPath: A NotConfigured: N PreferredPath: A DevState: OPTIMAL ReportedPresent: YReportedMissing: NNeedsReservationCheck: NTASBitSet: YNotReady: NBusy: NQuiescent: NController 'A' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Controller 'B' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Lun #1 - WWN: 60080e50001828f6000005b64c6a1a08----------------LunObject: present CurrentOwningPath: B RemoveEligible: N BootOwningPath: B NotConfigured: N PreferredPath: B DevState: OPTIMAL ReportedPresent: YReportedMissing: NNeedsReservationCheck: NTASBitSet: NNotReady: NBusy: NQuiescent: NController 'A' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Controller 'B' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Lun #2 - WWN: 60080e5000181d8c000005ed4c6af8c9----------------LunObject: present CurrentOwningPath: A RemoveEligible: N BootOwningPath: A NotConfigured: N PreferredPath: A DevState: OPTIMAL ReportedPresent: YReportedMissing: NNeedsReservationCheck: NTASBitSet: NNotReady: NBusy: NQuiescent: NController 'A' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Controller 'B' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Lun #3 - WWN: 60080e50001828f6000005b84c6af904----------------LunObject: present CurrentOwningPath: B RemoveEligible: N BootOwningPath: B NotConfigured: N PreferredPath: B DevState: OPTIMAL ReportedPresent: YReportedMissing: NNeedsReservationCheck: NTASBitSet: NNotReady: NBusy: NQuiescent: NController 'A' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Controller 'B' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Lun #7 - WWN: 60080e50001828f6000004bc4c60bf47----------------LunObject: none CurrentOwningPath: A RemoveEligible: N BootOwningPath: A NotConfigured: N PreferredPath: A DevState: OPTIMAL ReportedPresent: YReportedMissing: NNeedsReservationCheck: NTASBitSet: NNotReady: NBusy: NQuiescent: NController 'A' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: present UTMLunDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0Controller 'B' Path--------------------NumLunObjects: 1 RoundRobinIndex: 0 Path #1: LunPathDevice: present UTMLunDevice: presentDevState: OPTIMALRemoveState: 0x0 StartState: 0x1 PowerState: 0x0此外还有个简单的查看路径方法通过/proc/mpp/或者/proc/scsi/mpp查看因为不同的机型可能查看的文件不太一样不再说明可以根据机型在此目录下查看测试方法格式化存储然后挂载进入存储目录写一个50G的文件然后拔掉一个hba卡的光纤线测试,假如此lun正好是通过此hba卡访问的那么lun会进行控制器切换,切换会有一定的时间一般几十秒,在切换期间ls查看此目录的文件切换时间内会没有任何反应想hang死一样,切换完毕后就正常,切换完毕后插上此hba卡的线拔下另一个hba卡的线测试dd if=/dev/zero of=test bs=10M count=5000。

普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。

而到了有光纤组成的SAN环境,由于主机和存储通过了光纤交换机连接,这样的话,就构成了多对多的关系。

也就是说,主机到存储可以有多条路径可以选择。

主机到存储之间的IO由多条路径可以选择,如下图:根据上图所示,每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。

多路径软件就是为了解决上面的问题应运而生的。

多路径的主要功能就是和存储设备一起配合实现如下功能:1.故障的切换和恢复2.IO流量的负载均衡3.磁盘的虚拟化由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。

并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license 才行。

比如EMC公司基于linux下的多路径软件,就需要单独的购买license。

好在,RedHat和Suse 的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

---Linux 内置HBA 驱动程序和内置多路径计划(HP)从Red Hat RHEL 5.2 和Novell SLES 10 SP2 开始的惠普支持的客户选项选项一:惠普提供的Emulex HBA 驱动程序和Multipulse 故障转移,或者惠普提供的Emulex HBA 驱动程序和内置Device Mapper Multipathing选项二:惠普提供的QLogic HBA 驱动程序和QLogic 故障转移,或者惠普提供的单一路径模式QLogic HBA 驱动程序和内置Device Mapper Multipathing选项三:内置HBA 驱动程序和内置Device Mapper Multipathing。

Linux安装device-mapper多路径文档-推荐下载Linux多路径安装步骤一、在Linux AS4 Update 5上安装多路径软件如果AS4采用默认安装到话,需要手动安装多路径软件。

步骤如下:1)在第四张AS4安装光盘上找到device-mapper-multipath-0.4.5-21.RHEL4.i386文件,运行下面的命令进行安装:rpm –ivh device-mapper-multipath-0.4.5-21.RHEL4.i3862)安装完成后在/etc目录下可以看到multipath.conf的文件,编辑该文件,并添加以下的内容:defaults {udev_dir/devpolling_interval10selector"round-robin 0"path_grouping_policy failovergetuid_callout"/sbin/scsi_id -g -u -s /block/%n"prio_callout"/bin/true"path_checker turrr_min_io100rr_weight uniformfailback immediateno_path_retry12user_friendly_names yes}blacklist {devnode"^(ram|raw|loop|fd|md|dm-|sr|scd|st)[0-9]*"devnode "^hd[a-z][[0-9]*]"devnode"^cciss!c[0-9]d[0-9]*}device {vendor"IFT "product"*"path_grouping_policy group_by_priogetuid_callout"/sbin/scsi_id -g -u -s /block/%n"path_checker turpath_selector"round-robin 0"rr_weight uniformfailback immediatehardware_handler"0"no_path_retry12rr_min_io100}注意:Vendor项到IFT后面有五个空格3)reboot,重启服务器4)运行multipath –ll命令,如果看到类似以下的内容说明已经多路径已经绑定成功。

在linux下安装HP多路软件步骤(Device Mapper Multipath Enablement Kit for HP StorageWorks Disk Arrays)各位兄弟,因为本人早就开始接触到HP EVA4400的存储,但是一直都是在windows或者VMware下解决多路径的问题。

今天刚好在Redhat Enterprise Linux 5.5解决,顺便也写成文档,免得自己老了,记不了。

这里要感谢一下广军,感谢他对我的信任和支持。

以下是客户的环境:服务器:4台HP DL580G7服务器OS:Redhat Enterprise Linux 5.5存储:EVA4400步骤一、确认信息1、确认HBA卡驱动是否正常,系统是否能识别到。

注意:有部份博科的HBA卡是不能直连的,只能通过光纤交换机才能连接的。

可以使用lspci命令查看。

(别的牌子没有测试过还不知道)。

2、确认HBA卡的驱动是否加载到内核里面,可以使用lsmod命令查看。

3、确保系统已经安装已下的rpm包:可以使用rpm –qa|grep device* 查看是否安装For RHEL 4 Update 7:∙device-mapper-1.02.25-2.el4 or later∙device-mapper-multipath-0.4.5-31.el4 or later∙For RHEL 4 Update 8:∙device-mapper-1.02.28-2.el4 or later∙device-mapper-multipath-0.4.5-35.el4 or later∙For RHEL 5 Update 2:∙device-mapper-1.02.24-1.el5 or later∙device-mapper-multipath-0.4.7-17.el5 or later∙For RHEL 5 Update 3:∙device-mapper-1.02.28-2.el5 or later∙device-mapper-multipath-0.4.7-23.el5 or later∙For RHEL 5 Update 4:∙device-mapper-multipath-0.4.7-30.el5 or later∙device-mapper-1.02.32-1.el5 or later∙For RHEL 5 Update 5:∙device-mapper-multipath-0.4.7-34.el5 or later∙device-mapper-1.02.39-1.el5 or later∙For SLES 10 SP2:∙device-mapper-1.02.13-6.14 or later∙device-mapper-devel-1.02.13-6.14 or later∙multipath-tools-0.4.7-34.43 or later∙For SLES 10 SP3:∙device-mapper-1.02.13-6.14 or later∙device-mapper-devel-1.02.13-6.14 or later∙multipath-tools-0.4.7-34.50.10 or later∙For SLES 11:∙device-mapper-1.02.27-8.6 or later∙multipath-tools-0.4.8-40.4.1 or later步骤二、安装HPDM Multipath Enablement在HP的官网上有很多版本,可以根据自己需要下载(/bizsupport/TechSupport/SoftwareIndex.jsp?lang=en&cc=us&pro dNameId=3559652&prodTypeId=18964&prodSeriesId=3559651&swLang=13&taskId=135&swEnv OID=4004)下载完成后,进入文件目标,例如:/tmp# cd /tmp# tar -zxvf HPDMmultipath-<version>.tar.gz# cd HPDMmultipath-<version># ./INSTALL这样HPDM Multipath Enablement就安装完成了。

Linux下MPIO一、什么是多路径普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。

而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。

也就是说,主机到存储可以有多条路径可以选择。

主机到存储之间的IO 由多条路径可以选择。

每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。

多路径软件就是为了解决上面的问题应运而生的。

多路径的主要功能就是和存储设备一起配合实现如下功能:1.故障的切换和恢复2.IO流量的负载均衡3.磁盘的虚拟化由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。

并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。

比如EMC公司基于linux下的多路径软件,就需要单独的购买license。

好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

二、Linux下multipath介绍,需要以下工具包:在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:1、device-mapper-multipath:即multipath-tools。

主要提供multipathd和multipath等工具和 multipath.conf等配置文件。

这些工具通过device mapper 的ioctr的接口创建和配置multipath设备(调用device-mapper的用户空间库。

1、查看/dev/mapper下的设备,其中mpathn是多路径映射的设备2、对mpathn进行分区,使用parted进行分区[root@localhost mapper]# cd[root@localhost ~]# parted /dev/mapper/mpath13GNU Parted 1.8.1Using /dev/mapper/mpath13Welcome to GNU Parted! Type 'help' to view a list of commands.(parted) helpcheck NUMBER do a simple check on the file systemcp [FROM-DEVICE] FROM-NUMBER TO-NUMBER copy file system to another partition help [COMMAND] prints general help, or help on COMMAND mklabel,mktable LABEL-TYPE create a new disklabel (partition table)mkfs NUMBER FS-TYPE make a FS-TYPE file system on partititon NUMBERmkpart PART-TYPE [FS-TYPE] START END make a partitionmkpartfs PART-TYPE FS-TYPE START END make a partition with a file systemmove NUMBER START END move partition NUMBERname NUMBER NAME name partition NUMBER as NAMEprint [free|NUMBER|all] display the partition table, a partition,or all devicesquit exit programrescue START END rescue a lost partition near START and ENDresize NUMBER START END resize partition NUMBER and its file systemrm NUMBER delete partition NUMBERselect DEVICE choose the device to editset NUMBER FLAG STATE change the FLAG on partition NUMBER toggle [NUMBER [FLAG]] toggle the state of FLAG on partition NUMBERunitUNIT set the default unit to UNITversion displays the current version of GNU Parted and copyright information(parted) mkpartPartition type?primary/extended? pFile system type? [ext2]? ext3Start? 1End? 1(parted) mkpartPartition type?primary/extended? pFile system type? [ext2]? ext3Start? 1End? 3000(parted) printModel: Linux device-mapper (dm)Disk /dev/mapper/mpath13: 322GBSector size (logical/physical): 512B/512BPartition Table: msdosNumber Start End Size Type File system Flags1 0.51kB 1000kB1000kB primary2 1000kB 3000MB 2999MB primary(parted) mkpartPartition type?primary/extended? pFile system type? [ext2]? ext3Start? 1End? 102400Warning: You requested a partition from 1000kB to 102GB.The closest location we can manage is 3002MB to 102GB. Is this still acceptable to you?Yes/No?Yes/No?yes(parted) namePartition number? 1Error: msdos disk labels do not support partition names.Partition name? 3Error: msdos disk labels do not support partition names.(parted) printModel: Linux device-mapper (dm)Disk /dev/mapper/mpath13: 322GBSector size (logical/physical): 512B/512BPartition Table: msdosNumber Start End Size Type File system Flags1 0.51kB 1000kB1000kB primary2 1000kB 3000MB 2999MB primary3 3002MB 102GB 99.4GB primary(parted) quitInformation: Don't forget to update /etc/fstab, if necessary.[root@localhost ~]# fdisk -lDisk /dev/sda: 291.9 GB, 291999055872 bytes255 heads, 63 sectors/track, 35500 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 13 104391 83 Linux/dev/sda2 14 35500 285049327+ 8e Linux LVMDisk /dev/sdb: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDisk /dev/sdb doesn't contain a valid partition tableDisk /dev/sdc: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDisk /dev/sdc doesn't contain a valid partition tableDisk /dev/dm-2: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/dm-2p1 1 1 976+ 83 Linux Partition 1 does not end on cylinder boundary./dev/dm-2p2 1 365 2928711 83 Linux Partition 2 does not end on cylinder boundary./dev/dm-2p3 366 12449 97064730 83 LinuxDisk /dev/dm-3: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id SystemDisk /dev/sdd: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDisk /dev/sdd doesn't contain a valid partition tableDisk /dev/sde: 322.1 GB, 322122547200 bytes255 heads, 63 sectors/track, 39162 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDisk /dev/sde doesn't contain a valid partition table[root@localhost ~]# cd /dev/mapper[root@localhost mapper]# lscontrol mpath13p1mpath13p3 VolGroup01-LogVol00mpath13mpath13p2 mpath14 VolGroup01-LogVol01[root@localhost mapper]# mkfs.ext3 /dev/mapper/mpath13p3mke2fs 1.39 (29-May-2006)Filesystem label=OS type: LinuxBlock size=4096 (log=2)Fragment size=4096 (log=2)12140544 inodes, 24266182 blocks1213309 blocks (5.00%) reserved for the super userFirst data block=0Maximum filesystem blocks=4294967296741 block groups32768 blocks per group, 32768 fragments per group16384 inodes per groupSuperblock backups stored on blocks:32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,4096000, 7962624, 11239424, 20480000, 23887872Writing inode tables: doneCreating journal (32768 blocks): doneWriting superblocks and filesystem accounting information:doneThis filesystem will be automatically checked every 24 mounts or180 days, whichever comes first. Use tune2fs -c or -i to override.[root@localhost mapper]#[root@localhost mapper]# cd[root@localhost ~]# lsa iometer-2006_07_27.linux.i386-binanaconda-ks.cfg iometer-2006_07_27.linux.i386-bin.tgzinstall.log iscsi-initiator-utils-6.2.0.871-0.16.el5.x86_64.rpminstall.log.syslog[root@localhost ~]# mount /dev/mapper/mpath13p3 a**将mpath13p3挂载到目录a下[root@localhost ~]# lsa iometer-2006_07_27.linux.i386-binanaconda-ks.cfg iometer-2006_07_27.linux.i386-bin.tgzinstall.log iscsi-initiator-utils-6.2.0.871-0.16.el5.x86_64.rpminstall.log.syslog[root@localhost ~]# cd a[root@localhost a]# lslost+found下面对mpath13p3进行读写测试和链路切换测试路径冗余测试-linux1、使用dd进行读写测试2、查看实时IO状态,3、拔掉客户端一根网线,查看io变化。

LINUX下多路径(multi-path)介绍及使用2013-05-16 11:15:34| 分类:openfiler系统+fr|举报|字号订阅一、什么是多路径普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。

而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。

也就是说,主机到存储可以有多条路径可以选择。

主机到存储之间的IO由多条路径可以选择。

每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。

多路径软件就是为了解决上面的问题应运而生的。

多路径的主要功能就是和存储设备一起配合实现如下功能:1.故障的切换和恢复2.IO流量的负载均衡3.磁盘的虚拟化由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。

并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。

比如EMC公司基于linux下的多路径软件,就需要单独的购买license。

好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

二、Linux下multipath介绍,需要以下工具包:在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:1、device-mapper-multipath:即multipath-tools。

主要提供multipathd和multipath 等工具和 multipath.conf等配置文件。

这些工具通过device mapper的ioctr的接口创建和配置multipath设备(调用device-mapper的用户空间库。

创建的多路径设备会在/dev /mapper中)。

2、 device-mapper:主要包括两大部分:内核部分和用户部分。

内核部分主要由device mapper核心(dm.ko)和一些target driver(md-multipath.ko)。

核心完成设备的映射,而target根据映射关系和自身特点具体处理从mappered device 下来的i/o。

同时,在核心部分,提供了一个接口,用户通过ioctr可和内核部分通信,以指导内核驱动的行为,比如如何创建mappered device,这些divece的属性等。

linux device mapper 的用户空间部分主要包括device-mapper这个包。

其中包括dmsetup工具和一些帮助创建和配置mappered device的库。

这些库主要抽象,封装了与ioctr通信的接口,以便方便创建和配置mappered device。

multipath-tool的程序中就需要调用这些库。

3、dm-multipath.ko和dm.ko:dm.ko是device mapper驱动。

它是实现multipath的基础。

dm-multipath其实是dm的一个target驱动。

4、scsi_id:包含在udev程序包中,可以在multipath.conf中配置该程序来获取scsi 设备的序号。

通过序号,便可以判断多个路径对应了同一设备。

这个是多路径实现的关键。

scsi_id是通过sg驱动,向设备发送EVPD page80或page83 的inquery命令来查询scsi设备的标识。

但一些设备并不支持EVPD 的inquery命令,所以他们无法被用来生成multipath设备。

但可以改写scsi_id,为不能提供scsi设备标识的设备虚拟一个标识符,并输出到标准输出。

multipath程序在创建multipath设备时,会调用scsi_id,从其标准输出中获得该设备的scsi id。

在改写时,需要修改scsi_id程序的返回值为0。

因为在multipath程序中,会检查该直来确定scsi id是否已经成功得到。

三、multipath在CentOS 5中的基本配置过程:1、安装和加载多路径软件包# yum –y install device-mapper device-mapper-multipath# chkconfig –level 2345 multipathd on #设置成开机自启动multipathd# lsmod |grep dm_multipath #来检查安装是否正常如果模块没有加载成功请使用下列命初始化DM,或重启系统---Use the following commands to initialize and start DM for the first time: # modprobe dm-multipath# modprobe dm-round-robin# service multipathd start# multipath –v22、配置multipath:Multipath的配置文件是/etc/multipath.conf , 如需要multipath正常工作只需要如下配置即可:(如果需要更加详细的配置,请看本文后续的介绍)blacklist {devnode "^sda"}defaults {user_friendly_names yespath_grouping_policy multibusfailback immediateno_path_retry fail}# vi /etc/multipath.conf3、multipath基本操作命令# /etc/init.d/multipathd start #开启mulitipath服务# multipath -F #删除现有路径# multipath -v2 #格式化路径# multipath -ll #查看多路径如果配置正确的话就会在/dev/mapper/目录下多出mpath0、mpath1等之类设备。

用fdisk -l命令可以看到多路径软件创建的磁盘,如下图中的/dev/dm-[0-3]4、multipath磁盘的基本操作要对多路径软件生成的磁盘进行操作直接操作/dev/mapper/目录下的磁盘就行. 在对多路径软件生成的磁盘进行分区之前最好运行一下pvcreate命令:# pvcreate /dev/mapper/mpath0# fdisk /dev/mapper/mpath0用fdisk对多路径软件生成的磁盘进行分区保存时会有一个报错,此报错不用理会。

fdisk对多路径软件生成的磁盘进行分区之后,所生成的磁盘分区并没有马上添加到/dev/目录下,此时我们要重启IPSAN或者FCSAN的驱动,如果是用iscsi-initiator 来连接IPSAN的重启ISCSI服务就可以发现所生成的磁盘分区了# service iscsi restart# ls -l /dev/mapper/如上图中的mpath0p1和mpath1p1就是我们对multipath磁盘进行的分区# mkfs.ext3 /dev/mapper/mpath0p1 #对mpath1p1分区格式化成ext3文件系统# mount /dev/mapper/mpath0p1 /ipsan/ #挂载mpath1p1分区四、multipath的高有配置以上都是用multipath的默认配置来完成multipath的配置,比如映射设备的名称,multipath负载均衡的方法都是默认设置。

那有没有按照我们自己定义的方法来配置multipath呢,当可以。

1、multipath.conf文件的配置接下来的工作就是要编辑/etc/multipath.conf的配置文件multipath.conf主要包括blacklist、multipaths、devices三部份的配置blacklist配置blacklist {devnode "^sda"}Multipaths部分配置multipaths和devices两部份的配置。

multipaths {multipath {wwid **************** #此值multipath -v3可以看到alias iscsi-dm0 #映射后的别名,可以随便取path_grouping_policy multibus #路径组策略path_checker tur #决定路径状态的方法path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法}}Devices部分配置devices {device {vendor "iSCSI-Enterprise" #厂商名称product "Virtual disk" #产品型号path_grouping_policy multibus #默认的路径组策略getuid_callout "/sbin/scsi_id -g -u -s /block/%n" #获得唯一设备号使用的默认程序prio_callout "/sbin/acs_prio_alua %d" #获取有限级数值使用的默认程序path_checker readsector0 #决定路径状态的方法path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法failback immediate #故障恢复的模式no_path_retry queue #在disable queue之前系统尝试使用失效路径的次数的数值rr_min_io 100 #在当前的用户组中,在切换到另外一条路径之前的IO请求的数目}}如下是一个完整的配置文件blacklist {devnode "^sda"}defaults {user_friendly_names no}multipaths {multipath {wwid 14945540000000000a67854c6270b4359c66c272e2f356321alias iscsi-dm0path_grouping_policy multibuspath_checker turpath_selector "round-robin 0"}multipath {wwid 14945540000000000dcca2eda91d70b81edbcfce2357f99eealias iscsi-dm1path_grouping_policy multibuspath_checker turpath_selector "round-robin 0"}multipath {wwid 1494554000000000020f763489c165561101813333957ed96alias iscsi-dm2path_grouping_policy multibuspath_checker turpath_selector "round-robin 0"}multipath {wwid 14945540000000000919ca813020a195422ba3663e1f03cc3alias iscsi-dm3path_grouping_policy multibuspath_checker turpath_selector "round-robin 0"}}devices {device {vendor "iSCSI-Enterprise"product "Virtual disk"path_grouping_policy multibusgetuid_callout "/sbin/scsi_id -g -u -s /block/%n"path_checker readsector0path_selector "round-robin 0"}}获取wwid的方法:(1)默认情况下,将使用 /var/lib/multipath/bindings 内的配置设定具体每个多路径设备名,如果在/etc/multipath.conf中有设定各wwid 别名,别名会覆盖此设定。