Poisson Image Editing

- 格式:docx

- 大小:1.82 MB

- 文档页数:5

泊松融合matlab

泊松融合是一种常用的图像处理算法,可以将两张不同的图片合并成一张完整的图片。

这种算法在数码相机、电影特效以及计算机视觉领域都有很广泛的应用。

在matlab中,实现泊松融合可以使用Image Processing Toolbox中的函数。

泊松融合的基本思路是将两张图像进行“剪切”和“粘贴”操作,即将一张图像中的某些区域剪切出来,然后将其粘贴到另一张图像中。

为了使得两张图像的边缘能够自然地衔接,需要使用泊松方程进行修正,从而达到更好的融合效果。

在matlab中,可以使用如下代码实现泊松融合:

```matlab

% 读入两张图像

A = imread('image1.jpg');

B = imread('image2.jpg');

% 获取A图像中需要剪切的区域

mask = roipoly(A);

% 对A图像中的剪切区域进行泊松融合

blended_image = poissonBlend(B, A, mask);

% 显示融合后的图像

imshow(blended_image);

```

上述代码中,通过调用roipoly函数获取图像A中需要剪切的区

域,然后使用poissonBlend函数进行泊松融合操作,最终得到融合后的图像。

需要注意的是,将两张图像进行泊松融合时,需要保证两张图像的大小和分辨率相同。

除了使用matlab自带的函数实现泊松融合之外,还可以使用第三方工具包,如OpenCV、Python等进行实现。

无论使用哪种工具包,都需要对泊松融合的算法原理有一定的了解,才能够更好地实现该算法。

泊松融合原理和python代码泊松融合(Poisson blending)是一种图像处理技术,用于将源图像中的对象融合到目标图像中,以实现无缝的图像合成。

该技术通过泊松方程求解,在图像融合中起到关键作用。

泊松融合的基本原理是通过将源图像中的像素值通过泊松方程融合到目标图像中,从而在目标图像中生成一个新的像素值,以实现图像融合的效果。

其数学表示如下:∇²α=∂²α/∂x²+∂²α/∂y²=β其中,α表示源图像中的像素值,β表示目标图像中的边缘像素值。

这个方程可以简化为拉普拉斯方程∆α=β,其中∆表示拉普拉斯算子。

这个方程的意义是,对于源图像中的像素α,其梯度的变化应该与目标图像中的边缘像素β相匹配。

根据泊松方程求解的目标,可以得到融合后的像素值。

在求解过程中,需要考虑边界条件和约束条件。

边界条件通常是指融合图像的边界像素值应与目标图像一致,约束条件通常是指源图像中的一些区域或者像素需要完全复制到目标图像中,从而实现融合效果。

下面是一个使用Python实现泊松融合的代码示例:```pythonimport numpy as npfrom scipy.sparse import linalgdef poisson_blend(source, target, mask):#获取图像的宽度和高度height, width, _ = target.shape#创建拉普拉斯矩阵A和边界像素矩阵bA = np.zeros((height * width, height * width))b = np.zeros(height * width)#根据源图像和目标图像计算拉普拉斯矩阵A和边界像素矩阵bfor y in range(1, height - 1):for x in range(1, width - 1):#当前像素在图像中的索引idx = y * width + xif mask[y, x] == 1:#如果是掩膜内的像素,使用泊松方程并加上约束条件A[idx, idx] = 4A[idx, idx - 1] = -1A[idx, idx + 1] = -1A[idx, idx - width] = -1A[idx, idx + width] = -1b[idx] = 4 * source[y, x] - source[y, x - 1] - source[y, x + 1] - source[y - 1, x] - source[y + 1, x]else:#如果是边界像素,直接复制到目标图像中A[idx, idx] = 1b[idx] = target[y, x]#使用稀疏矩阵求解线性方程组x = linalg.spsolve(A, b)# 将求解出的像素值reshape为目标图像的形状blend = x.reshape((height, width, 3)) return blend#加载源图像、目标图像和掩膜图像source = np.array(Image.open('source.jpg')) target = np.array(Image.open('target.jpg')) mask = np.array(Image.open('mask.png'))#对源图像和目标图像进行泊松融合blend = poisson_blend(source, target, mask) #显示融合后的图像plt.imshow(blend)plt.show```这段代码使用了`numpy`库和`scipy.sparse`库实现了泊松融合的算法。

泊松融合原理与Python代码实现1. 前言泊松融合是一种图像处理技术,用于将源图像的内容无缝地融合到目标图像中。

它的基本原理是通过解决一个泊松方程,将源图像的梯度与目标图像的梯度相匹配,从而实现融合效果。

在本文中,我们将详细介绍泊松融合的基本原理,并使用Python编写代码来实现泊松融合。

2. 泊松方程首先,让我们来了解一下泊松方程。

泊松方程是一个偏微分方程,通常用于描述物理系统中的平衡状态。

在图像处理中,我们可以使用泊松方程来实现无缝融合。

泊松方程可以表示为:∇²f = g其中,∇²表示拉普拉斯算子(二阶导数),f表示未知函数,g表示已知函数。

在泊松融合中,我们希望通过求解这个方程来得到未知函数f。

3. 泊松融合原理泊松融合的基本原理是将源图像的梯度与目标图像的梯度相匹配。

通过匹配这些梯度,我们可以确保融合后的图像在边界处具有连续性。

具体来说,泊松融合的步骤如下:1.将源图像和目标图像进行对齐。

对齐可以使用特征点匹配或其他图像对齐算法来实现。

2.在目标图像上选择一个感兴趣区域(ROI),并在该区域内将源图像的内容融合进去。

3.计算源图像和目标图像的梯度。

我们可以使用Sobel算子等滤波器来计算梯度。

4.在ROI中,将泊松方程应用于目标图像的梯度和源图像的梯度之间的差异。

这相当于求解泊松方程中的未知函数f。

5.将求解得到的未知函数f与目标图像中ROI外的部分进行融合,得到最终的融合结果。

4. Python代码实现接下来,让我们使用Python编写代码来实现泊松融合。

首先,我们需要导入所需的库:import numpy as npimport cv2from scipy import sparsefrom scipy.sparse.linalg import spsolve然后,我们定义一个名为poisson_blend的函数来执行泊松融合:def poisson_blend(source, target, mask):# 获取源图像和目标图像的尺寸height, width, _ = source.shape# 将源图像和目标图像转换为灰度图像source_gray = cv2.cvtColor(source, cv2.COLOR_BGR2GRAY)target_gray = cv2.cvtColor(target, cv2.COLOR_BGR2GRAY)# 计算源图像和目标图像的梯度source_grad_x = cv2.Sobel(source_gray, cv2.CV_64F, 1, 0, ksize=3)source_grad_y = cv2.Sobel(source_gray, cv2.CV_64F, 0, 1, ksize=3)target_grad_x = cv2.Sobel(target_gray, cv2.CV_64F, 1, 0, ksize=3)target_grad_y = cv2.Sobel(target_gray, cv2.CV_64F, 0, 1, ksize=3)# 创建稀疏矩阵A和向量bA = sparse.lil_matrix((height * width, height * width))b = np.zeros((height * width,))# 填充矩阵A和向量bfor y in range(1,height-1):for x in range(1,width-1):if mask[y,x] == 255:index = y * width + xA[index,index] = -4A[index,index-1] = 1A[index,index+1] = 1A[index,index-width] = 1A[index,index+width] = 1b[index] = target_grad_x[y,x] - target_grad_x[y,x-1] + target_ grad_y[y,x] - target_grad_y[y-1,x]# 解泊松方程f = spsolve(A.tocsr(), b)# 将求解得到的未知函数f转换为图像f_image = np.uint8(np.clip(f.reshape(height, width), 0, 255))# 在目标图像中将ROI外的部分与源图像进行融合blended = target.copy()for y in range(height):for x in range(width):if mask[y,x] == 255:blended[y,x] = source[y,x]return blended最后,我们加载源图像、目标图像和蒙版,并调用poisson_blend函数来执行泊松融合:source = cv2.imread('source.jpg')target = cv2.imread('target.jpg')mask = cv2.imread('mask.jpg', cv2.IMREAD_GRAYSCALE)result = poisson_blend(source, target, mask)cv2.imwrite('result.jpg', result)5. 总结在本文中,我们详细介绍了泊松融合的基本原理,并使用Python编写了相应的代码实现。

泊松融合原理和python代码泊松融合是一种图像处理技术,可以将两幅图像进行平滑过渡,使其看起来自然无缝地融合在一起。

本文将介绍泊松融合的原理,并给出使用Python实现泊松融合的代码示例。

1. 泊松融合的原理2. 泊松融合的步骤3. 使用Python实现泊松融合的代码示例【1. 泊松融合的原理】泊松融合的原理是基于在两幅图像之间进行局部亮度和颜色平滑的假设。

具体来说,泊松融合可以看作是将源图像的颜色和边缘信息与目标图像的结构进行融合的过程。

【2. 泊松融合的步骤】泊松融合一般包括以下几个步骤:1) 输入源图像和目标图像。

2) 确定源图像在目标图像中的位置,以及需要融合的区域。

3) 对源图像和目标图像进行预处理,包括调整图像大小、灰度化等。

4) 使用梯度域重建技术计算源图像的梯度场。

5) 根据源图像的梯度向量和目标图像的结构特征进行优化,生成泊松方程。

6) 使用泊松方程进行图像融合。

7) 输出泊松融合后的图像。

【3. 使用Python实现泊松融合的代码示例】下面是一个使用Python实现泊松融合的简单示例代码:```pythonimport cv2import numpy as npdef poisson_blend(source, target, mask):# 将原图像和目标图像转换为浮点型source = source.astype(np.float32)target = target.astype(np.float32)# 将图像转换为灰度图gray_source = cv2.cvtColor(source, cv2.COLOR_BGR2GRAY) gray_target = cv2.cvtColor(target, cv2.COLOR_BGR2GRAY) # 计算源图像的梯度场gradient = placian(gray_source, cv2.CV_64F)# 将源图像的梯度场与目标图像的结构特征进行融合result = target.copy()result[mask] = source[mask] - gradientreturn result.astype(np.uint8)# 读取源图像、目标图像和融合区域的掩码source = cv2.imread("source.jpg")target = cv2.imread("target.jpg")mask = cv2.imread("mask.jpg", cv2.IMREAD_GRAYSCALE)# 进行泊松融合blended_image = poisson_blend(source, target, mask)# 显示融合结果cv2.imshow("Blended Image", blended_image)cv2.waitKey(0)cv2.destroyAllWindows()【4. 总结】泊松融合是一种常用的图像处理技术,可以实现图像的无缝融合。

量化图像的方法引言:在现代科技的飞速发展下,图像处理技术已成为一个重要的领域。

量化图像是其中的一个重要步骤,它将连续的图像转化为离散的数值表示,为后续的图像分析和处理提供了基础。

本文将介绍几种常用的图像量化方法,并从不同角度探讨它们的优缺点。

一、最近邻法(Nearest Neighbor)最近邻法是一种简单直观的图像量化方法。

其基本原理是将每个像素点的数值替换为最接近的离散化数值。

这种方法的优点是处理速度快,适用于实时性要求较高的场景。

然而,最近邻法的缺点是处理结果较粗糙,容易产生锯齿状的伪影。

二、误差扩散法(Error Diffusion)误差扩散法是一种常用的图像量化方法,其核心思想是将量化误差分散到周围的像素中,从而提高图像的质量。

最典型的误差扩散方法是Floyd-Steinberg算法,它通过逐像素地计算当前像素与离散化数值的差距,并将误差按照一定的权重传递给周围的像素。

这种方法能够有效减少锯齿状伪影,但在处理过程中会引入一定的噪声。

三、中位值切割法(Median Cut)中位值切割法是一种基于聚类分析的图像量化方法。

它通过对图像的像素进行聚类,并选择每个聚类中心的中位值作为离散化数值。

中位值切割法的优点是能够获得较好的色彩分布效果,适用于对图像的整体特征进行捕捉。

然而,该方法需要进行大量的像素遍历和聚类计算,处理速度较慢。

四、矢量量化法(Vector Quantization)矢量量化法是一种基于向量空间的图像量化方法,它将图像的像素组织为一组向量,并利用聚类分析将这些向量进行离散化表示。

与中位值切割法相比,矢量量化法将每个像素看作一个向量,能够更精确地描述图像的空间结构。

这种方法的缺点是需要消耗较大的计算资源,对硬件要求较高。

五、小波变换法(Wavelet Transform)小波变换法是一种基于信号处理的图像量化方法,它通过将图像分解为一组不同频率的小波基函数,并利用小波系数对图像进行离散化表示。

1. 拍摄图像拍摄出较高素质的原始图像能够从根本上保障最终制成图像的质量。

在拍摄二代证卡图像时应当特别注意以下一些方面:&S226; 根据拍摄环境设置合理的白平衡。

图像的偏色程度主要受白平衡影响。

良好的白平衡能够有效提升图像的色彩质量。

&S226; 设置合理的光照。

通常由于光照不合理带来的各种问题在后续的图像处理中很难得到有效解决,因此拍摄时的光照设置会非常重要。

&S226; 镜头应尽量聚焦于整个面部。

良好的聚焦能够保证图像中人像的清晰度。

由于聚焦带来的背景虚化则可以在后续的背景处理中解决。

&S226; 设置图像格式,具备足够的分辨率。

在拍摄的原始图像中人物脸部宽度应当大于221 象素。

在后续的图像处理过程中,如果通过图像放大来满足几何尺寸要求的话,会引起一定程度的图像模糊,应当尽量避免此类操作。

&S226; 设置拍摄背景,使图像中人物与背景间出现明显的边缘。

这会使后续的背景分割较为容易。

&S226; 把握拍摄对象的状况。

二代证卡图像对人物有表情自然、头部无偏转、双眼平视、不能穿制服、眼镜镜片透明等等各种要求。

应当引导拍摄对象,在满足各种要求的条件下,真实展现人物的良好风貌。

2. 几何内容处理二代证卡对图像的几何尺寸有明确和严格的要求。

下面逐步说明如何满足几何尺寸的要求。

(1) 检查人物头部是否偏转。

人物头部的各类旋转可以分解到如图2所示的三维空间里。

除 z 轴上的偏转能够通过图像旋转校正外,其它方向的偏转校正均无法保证结果的准确性。

此外,在 z 轴上的偏转校正会给图像造成一定程度的模糊。

因此在拍摄时应当尽量避免人物在 z 轴角度上的偏转,在其它轴角度上则不应当发生偏转。

(2) 缩放图像。

在原始的拍摄图像上,(a) 测量脸部宽度:脸部实际宽度=水平方向右侧脸部位置-水平方向左侧脸部位置(b) 用脸部标准宽度除以测量得到的脸部宽度,获得图像的缩放比例。

albumentations中的随机变换

albumentations 是一个用于图像增强的 Python 库,其中包含了多种随机变换的方法,比如:

- `Blur`:对图像进行均值平滑滤波。

- `VerticalFlip`:对图像进行垂直翻转。

- `HorizontalFlip`:对图像进行水平翻转。

- `Flip`:对图像进行水平和垂直翻转。

- `Normalize`:将像素值除以 255,减去每个通道的平均值并除以每个通道的标准差。

- `Transpose`:将图像的行和列进行互换。

- `RandomCrop`:随机从图像中裁剪一块区域。

- `RandomGamma`:对图像进行随机伽马变换。

- `RandomRotate90`:随机旋转图像90度。

- `Rotate`:随机旋转图像。

- `ShiftScaleRotate`:随机平移、缩放、旋转图像。

- `CenterCrop`:对图像进行中心裁剪。

- `OpticalDistortion`:对图像进行光学畸变。

- `GridDistortion`:对图像进行网格失真。

- `ElasticTransform`:对图像进行弹性变换。

上述方法中的 `p` 参数表示使用此转换的概率,默认值为0.5。

Algebraic operation 代数运算一种图像处理运算,包括两幅图像对应像素的和、差、积、商。

Aliasing 走样(混叠)当图像象素间距和图像细节相比太大时产生的一种人工痕迹。

Arc 弧(l)图的一部分(2)表示一段相连曲线的像素集合。

Binary image 二值图像只有两级灰度的数字图像(通常为0和1,黑和白)。

Blur 模糊由于散焦、低通滤波、摄像机运动等引起的图像清晰度的下降。

Border 边框一幅图像的首、未行或列。

Boundary chain code 边界链码定义一个物体边界的方向序列。

Boundary pixel 边界像素至少和一个背景象素相邻接的内部像素(比较:外部像素、内部像素)。

Boundary tracking边界跟踪一种图像分割技术,通过沿弧从一个像素顺序探索到下一个像素的方法将弧检测出来。

Brightness 亮度和图像一个点相关的值,表示从该点的物体发射或反射的光的量。

Change detection 变化检测通过相减等操作将两幅匹准图像的像素加以比较从而检测出其中物体差别的技术。

Class 类见模或类。

Closed curve 封闭曲线一条首尾接于一点的曲线。

Cluster 聚类,集群在空间(如在特征空间)中位置接近的点的集合。

Cluster analysis 聚类分析在空间中对聚类的检测、度量和描述。

Concave 凹的如果说某个物体是“凹的”是指至少存在两个物体内部的点,其连线不能完全包含在物体内部(反义词为凸的)。

Connected 连通的。

Contour encoding 轮廓编码对具有均匀灰度的区域,只将其边界进行编码的一种图像压缩技术。

Contrast 对比度物体平均亮度(或灰度)与其周围背景的差别程度。

Contrast stretch 对比度扩展一种线性的灰度变换。

Convex 凸的指连接物体内部任意两点的直线均落在物体内部。

Convolution 卷积一种将两个函数组合生成第三个函数的运算,卷积刻画了线性移不变系统的运算。

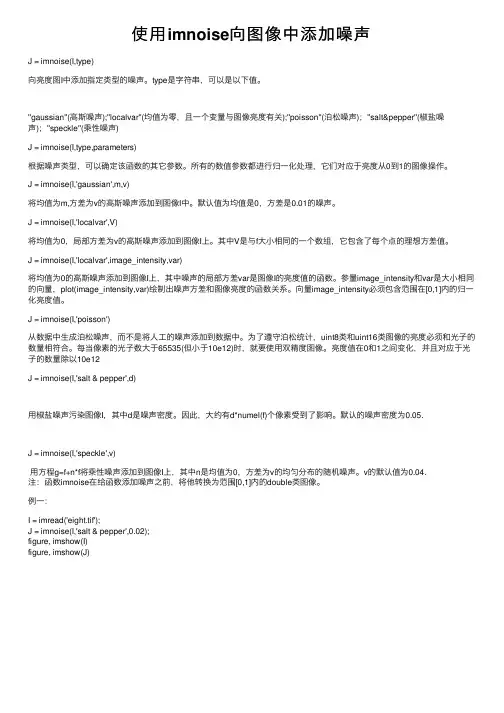

使⽤imnoise向图像中添加噪声J = imnoise(I,type)向亮度图I中添加指定类型的噪声。

type是字符串,可以是以下值。

''gaussian''(⾼斯噪声);''localvar''(均值为零,且⼀个变量与图像亮度有关);''poisson''(泊松噪声);''salt&pepper''(椒盐噪声);''speckle''(乘性噪声)J = imnoise(I,type,parameters)根据噪声类型,可以确定该函数的其它参数。

所有的数值参数都进⾏归⼀化处理,它们对应于亮度从0到1的图像操作。

J = imnoise(I,'gaussian',m,v)将均值为m,⽅差为v的⾼斯噪声添加到图像I中。

默认值为均值是0,⽅差是0.01的噪声。

J = imnoise(I,'localvar',V)将均值为0,局部⽅差为v的⾼斯噪声添加到图像I上。

其中V是与f⼤⼩相同的⼀个数组,它包含了每个点的理想⽅差值。

J = imnoise(I,'localvar',image_intensity,var)将均值为0的⾼斯噪声添加到图像I上,其中噪声的局部⽅差var是图像I的亮度值的函数。

参量image_intensity和var是⼤⼩相同的向量,plot(image_intensity,var)绘制出噪声⽅差和图像亮度的函数关系。

向量image_intensity必须包含范围在[0,1]内的归⼀化亮度值。

J = imnoise(I,'poisson')从数据中⽣成泊松噪声,⽽不是将⼈⼯的噪声添加到数据中。

为了遵守泊松统计,uint8类和uint16类图像的亮度必须和光⼦的数量相符合。

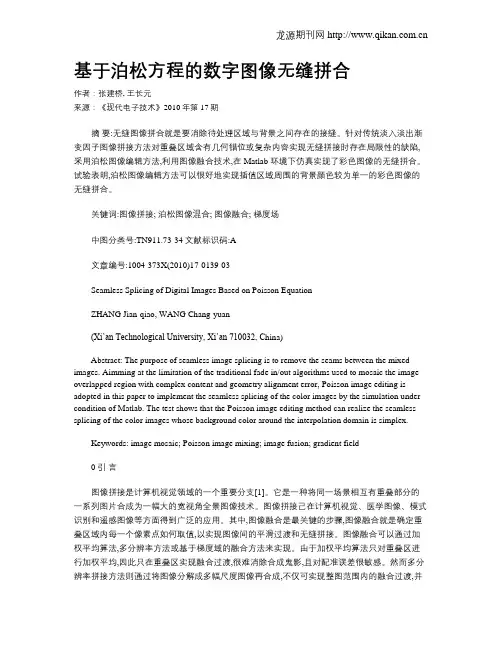

基于泊松方程的数字图像无缝拼合作者:张建桥, 王长元来源:《现代电子技术》2010年第17期摘要:无缝图像拼合就是要消除待处理区域与背景之间存在的接缝。

针对传统淡入淡出渐变因子图像拼接方法对重叠区域含有几何错位或复杂内容实现无缝拼接时存在局限性的缺陷,采用泊松图像编辑方法,利用图像融合技术,在Matlab 环境下仿真实现了彩色图像的无缝拼合。

试验表明,泊松图像编辑方法可以很好地实现插值区域周围的背景颜色较为单一的彩色图像的无缝拼合。

关键词:图像拼接; 泊松图像混合; 图像融合; 梯度场中图分类号:TN911.73-34文献标识码:A文章编号:1004-373X(2010)17-0139-03Seamless Splicing of Digital Images Based on Poisson EquationZHANG Jian-qiao, WANG Chang-yuan(Xi’an Technological University, Xi’an 710032, C hina)Abstract: The purpose of seamless image splicing is to remove the seams between the mixed images. Aimming at the limitation of the traditional fade in/out algorithms used to mosaic the image overlapped region with complex content and geometry alignment error, Poisson image editing is adopted in this paper to implement the seamless splicing of the color images by the simulation under condition of Matlab. The test shows that the Poisson image editing method can realize the seamless splicing of the color images whose background color around the interpolation domain is simplex.Keywords: image mosaic; Poisson image mixing; image fusion; gradient field0 引言图像拼接是计算机视觉领域的一个重要分支[1]。

【数字图像处理】图像平滑图像平滑从信号处理的⾓度看就是去除其中的⾼频信息,保留低频信息。

因此我们可以对图像实施低通滤波。

低通滤波可以去除图像中的噪⾳,模糊图像(噪⾳是图像中变化⽐较⼤的区域,也就是⾼频信息)。

⽽⾼通滤波能够提取图像的边缘(边缘也是⾼频信息集中的区域)。

根据滤波器的不同⼜可以分为均值滤波,⾼斯加权滤波,中值滤波,双边滤波。

均值滤波平均滤波是将⼀个m*n(m, n为奇数)⼤⼩的kernel放在图像上,中间像素的值⽤kernel覆盖区域的像素平均值替代。

平均滤波对⾼斯噪声的表现⽐较好,对椒盐噪声的表现⽐较差。

g(x,y) = \frac{1}{mn}\sum_{(x,y) \in S_{xy}} f(s,t)其中$S_{xy} 表⽰中⼼点在(x, y) ⼤⼩为m X n 滤波器窗⼝。

当滤波器模板的所有系数都相等时,也称为盒状滤波器。

BoxFilter , BoxFilter可以⽤来计算图像像素邻域的和。

cv2.boxFilter() normalize=False,此时不使⽤归⼀化卷积窗,当前计算像素值为邻域像素和。

加权均值滤波器不同于上⾯均值滤波器的所有像素系数都是相同的,加权的均值滤波器使⽤的模板系数,会根据像素和窗⼝中⼼的像素距离取不同的系数。

⽐如距离中⼼像素的距离越近,系数越⼤。

$$\frac{1}{16}\left [\begin{array}{ccc}1 &2 & 1 \\ 2 & 4 & 2 \\ 1 & 2 & 1\end{array}\right ]$$⼀般的作⽤于M*N⼤⼩的图像,窗⼝⼤⼩为m*n的加权平均滤波器计算公式为:g(x, y) = \frac{\sum_{s = -a}^a \sum_{t = -b}^b w(s, t) f(x+s, y+t)}{\sum_{s = -a}^a \sum_{t = -b}^b w(s, t)}⾼斯加权滤波器⾼斯函数是⼀种正态分布函数,⼀个⼆维⾼斯函数如下:hh(x, y) = \frac{1}{2\pi \sigma^2}e^{-\frac{x^2+y^2}{2\sigma^2}}\sigma为标准差,如果要得到⼀个⾼斯滤波器模板可以对⾼斯函数进⾏离散化,得到离散值作为模板系数。

imagefolder的用法与示例什么是imag efolder?`i ma ge fo ld er`是一个用于管理和组织图像文件的P yt ho n库。

它提供了简单且高效的方法,用于加载、预处理和可视化图像数据。

本文将介绍`im ag ef ol de r`的基本使用方法,并提供一些示例来帮助读者更好地理解如何有效地使用该库。

安装imagef older使用`i ma ge fo ld er`之前,我们需要先安装它。

你可以通过以下命令来安装`im ag ef ol de r`:p i pi ns ta ll im ag efo l de r加载图像数据集在使用`im ag ef ol de r`之前,我们需要准备好图像数据集。

可以将要使用的图像文件按类别分别放在不同的文件夹中,每个文件夹的名称即为对应的类别名称。

通过`i ma ge fo ld er`可以很方便地加载这些图像数据集。

以下是一个示例代码,展示了如何使用`im ag ef ol de r`加载数据集:f r om im ag ef ol de rim p or tI ma ge Fo ld er设置数据集路径d a ta_p at h='./d ata s et'创建ImageFolder对象d a ta se t=Im ag eF old e r(da ta_p at h)获取数据集中的类别数n u m_cl as se s=da tas e t.nu m_cl as se s打印类别数p r in t("数据集中的类别数:",nu m_cl as s es)数据预处理使用`i ma ge fo ld er`加载数据集后,我们可以对图像数据进行预处理。

`i ma ge fo ld er`提供了多种预处理方法,包括图像缩放、裁剪、旋转等操作。

以下是一个示例代码,展示了如何使用`i m ag ef ol de r`进行数据预处理:f r om im ag ef ol de rim p or tI ma ge Fo ld erf r om im ag ef ol de r.t r an sf or ms im po rtR e si ze,T oT en so r设置数据集路径d a ta_p at h='./d ata s et'创建ImageFolder对象,并指定预处理方法d a ta se t=Im ag eF old e r(da ta_p at h,tra n sf or m=[R es iz e(256),T oT e ns or()])加载数据集d a ta=d at as et.l oad_da ta()打印数据集中的第一张图片p r in t("第一张图片:",d at a[0])数据可视化`i ma ge fo ld er`还提供了简单且方便的方法来可视化加载的图像数据。

python实现泊松图像融合本⽂实例为⼤家分享了python实现泊松图像融合的具体代码,供⼤家参考,具体内容如下```from __future__ import divisionimport numpy as npimport scipy.fftpackimport scipy.ndimageimport cv2import matplotlib.pyplot as plt#sns.set(style="darkgrid")def DST(x):"""Converts Scipy's DST output to Matlab's DST (scaling)."""X = scipy.fftpack.dst(x,type=1,axis=0)return X/2.0def IDST(X):"""Inverse DST. Python -> Matlab"""n = X.shape[0]x = np.real(scipy.fftpack.idst(X,type=1,axis=0))return x/(n+1.0)def get_grads(im):"""return the x and y gradients."""[H,W] = im.shapeDx,Dy = np.zeros((H,W),'float32'), np.zeros((H,W),'float32')j,k = np.atleast_2d(np.arange(0,H-1)).T, np.arange(0,W-1)Dx[j,k] = im[j,k+1] - im[j,k]Dy[j,k] = im[j+1,k] - im[j,k]return Dx,Dydef get_laplacian(Dx,Dy):"""return the laplacian"""[H,W] = Dx.shapeDxx, Dyy = np.zeros((H,W)), np.zeros((H,W))j,k = np.atleast_2d(np.arange(0,H-1)).T, np.arange(0,W-1)Dxx[j,k+1] = Dx[j,k+1] - Dx[j,k]Dyy[j+1,k] = Dy[j+1,k] - Dy[j,k]return Dxx+Dyydef poisson_solve(gx,gy,bnd):# convert to double:gx = gx.astype('float32')gy = gy.astype('float32')bnd = bnd.astype('float32')H,W = bnd.shapeL = get_laplacian(gx,gy)# set the interior of the boundary-image to 0:bnd[1:-1,1:-1] = 0# get the boundary laplacian:L_bp = np.zeros_like(L)L_bp[1:-1,1:-1] = -4*bnd[1:-1,1:-1] \+ bnd[1:-1,2:] + bnd[1:-1,0:-2] \+ bnd[2:,1:-1] + bnd[0:-2,1:-1] # delta-xL = L - L_bpL = L[1:-1,1:-1]# compute the 2D DST:L_dst = DST(DST(L).T).T #first along columns, then along rows# normalize:[xx,yy] = np.meshgrid(np.arange(1,W-1),np.arange(1,H-1))D = (2*np.cos(np.pi*xx/(W-1))-2) + (2*np.cos(np.pi*yy/(H-1))-2)L_dst = L_dst/Dimg_interior = IDST(IDST(L_dst).T).T # inverse DST for rows and columnsimg = bnd.copy()img[1:-1,1:-1] = img_interiorreturn imgdef blit_images(im_top,im_back,scale_grad=1.0,mode='max'):"""combine images using poission editing.IM_TOP and IM_BACK should be of the same size."""assert np.all(im_top.shape==im_back.shape)im_top = im_top.copy().astype('float32')im_back = im_back.copy().astype('float32')im_res = np.zeros_like(im_top)# frac of gradients which come from source:for ch in xrange(im_top.shape[2]):ims = im_top[:,:,ch]imd = im_back[:,:,ch][gxs,gys] = get_grads(ims)[gxd,gyd] = get_grads(imd)gxs *= scale_gradgys *= scale_gradgxs_idx = gxs!=0gys_idx = gys!=0# mix the source and target gradients:if mode=='max':gx = gxs.copy()gxm = (np.abs(gxd))>np.abs(gxs)gx[gxm] = gxd[gxm]gy = gys.copy()gym = np.abs(gyd)>np.abs(gys)gy[gym] = gyd[gym]# get gradient mixture statistics:f_gx = np.sum((gx[gxs_idx]==gxs[gxs_idx]).flat) / (np.sum(gxs_idx.flat)+1e-6) f_gy = np.sum((gy[gys_idx]==gys[gys_idx]).flat) / (np.sum(gys_idx.flat)+1e-6) if min(f_gx, f_gy) <= 0.35:m = 'max'if scale_grad > 1:m = 'blend'return blit_images(im_top, im_back, scale_grad=1.5, mode=m)elif mode=='src':gx,gy = gxd.copy(), gyd.copy()gx[gxs_idx] = gxs[gxs_idx]gy[gys_idx] = gys[gys_idx]elif mode=='blend': # from recursive call:# just do an alpha blendgx = gxs+gxdgy = gys+gydim_res[:,:,ch] = np.clip(poisson_solve(gx,gy,imd),0,255)return im_res.astype('uint8')def contiguous_regions(mask):"""return a list of (ind0, ind1) such that mask[ind0:ind1].all() isTrue and we cover all such regions"""in_region = Noneboundaries = []for i, val in enumerate(mask):if in_region is None and val:in_region = ielif in_region is not None and not val:boundaries.append((in_region, i))in_region = Noneif in_region is not None:boundaries.append((in_region, i+1))return boundariesif __name__=='__main__':"""example usage:"""import seaborn as snsim_src = cv2.imread('../f01006.jpg').astype('float32')im_dst = cv2.imread('../f01006-5.jpg').astype('float32')mu = np.mean(np.reshape(im_src,[im_src.shape[0]*im_src.shape[1],3]),axis=0) # print musz = (1920,1080)im_src = cv2.resize(im_src,sz)im_dst = cv2.resize(im_dst,sz)im0 = im_dst[:,:,0] > 100im_dst[im0,:] = im_src[im0,:]im_dst[~im0,:] = 50im_dst = cv2.GaussianBlur(im_dst,(5,5),5)im_alpha = 0.8*im_dst + 0.2*im_src# plt.imshow(im_dst)# plt.show()im_res = blit_images(im_src,im_dst)import scipyscipy.misc.imsave('orig.png',im_src[:,:,::-1].astype('uint8'))scipy.misc.imsave('alpha.png',im_alpha[:,:,::-1].astype('uint8'))scipy.misc.imsave('poisson.png',im_res[:,:,::-1].astype('uint8'))im_actual_L = cv2.cvtColor(im_src.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] im_alpha_L = cv2.cvtColor(im_alpha.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] im_poisson_L = cv2.cvtColor(im_res.astype('uint8'),cv2.cv.CV_BGR2Lab)[:,:,0] # plt.imshow(im_alpha_L)# plt.show()for i in xrange(500,im_alpha_L.shape[1],5):l_actual = im_actual_L[i,:]#-im_actual_L[i,:-1]l_alpha = im_alpha_L[i,:]#-im_alpha_L[i,:-1]l_poisson = im_poisson_L[i,:]#-im_poisson_L[i,:-1]with sns.axes_style("darkgrid"):plt.subplot(2,1,2)#plt.plot(l_alpha,label='alpha')plt.plot(l_poisson,label='poisson')plt.hold(True)plt.plot(l_actual,label='actual')plt.legend()# find "text regions":is_txt = ~im0[i,:]t_loc = contiguous_regions(is_txt)ax = plt.gca()for b0,b1 in t_loc:ax.axvspan(b0, b1, facecolor='red', alpha=0.1)with sns.axes_style("white"):plt.subplot(2,1,1)plt.imshow(im_alpha[:,:,::-1].astype('uint8'))plt.hold(True)plt.plot([0,im_alpha_L.shape[0]-1],[i,i],'r')plt.axis('image')plt.show()plt.subplot(1,3,1)plt.imshow(im_src[:,:,::-1].astype('uint8'))plt.subplot(1,3,2)plt.imshow(im_alpha[:,:,::-1].astype('uint8'))plt.subplot(1,3,3)plt.imshow(im_res[:,:,::-1]) #cv2 reads in BGRplt.show()以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

利用全局方法进行泊松前景提取曹春红;王庆敏【期刊名称】《计算机科学与探索》【年(卷),期】2016(010)005【摘要】图像前景提取是运用图像处理算法快速准确地提取出图像中人们感兴趣的目标。

图像前景提取的精度直接影响了对目标图像的后续处理。

为了提高图像前景提取的精度,提出了一个新的利用全局方法进行Poisson前景提取的算法。

为了能够更快更好地得到最优采样点,提出了扩散、搜索的方法,并对该方法的有效性和精确性进行了分析。

扩散方法是通过在较小的邻域内计算各采样点的代价寻找代价最小的采样点,它能够得到邻近区域的最优解;搜索方法是通过一定的规则跳跃式地寻找最优采样点,它能够加快寻找最优采样点的速度。

实验表明,基于全局的Poisson前景提取算法会得到更精确的前景提取结果。

%The image foreground extraction is using image processing algorithms to quickly and accurately extract the target image that people are interested in. The precision of image foreground extraction directly affects the subsequent processing of target image. In order to improve the accuracy of image foreground extraction, this paper proposes a new Poisson matting algorithm using global method. In order to improve the speed, this paper uses a diffusion-search method, and analyzes the effectiveness and accuracy of the algorithm. Diffusion method is to find the least cost sampling points by calculating the cost of each sampling point in a small neighborhood, it can obtain the optimal solution adjacent areas;Searchmethod is to find the optimal sampling point by certain rules, it can acceler-ate the speed to find the optimal sampling point. Finally, the experiment proves that Poisson extraction algorithm based on global foreground will get more accurate results for foreground extraction.【总页数】11页(P688-698)【作者】曹春红;王庆敏【作者单位】东北大学信息科学与工程学院,沈阳 110819; 东北大学医学影像计算教育部重点实验室,沈阳110819; 南京大学计算机软件新技术国家重点实验室,南京 210023;东北大学信息科学与工程学院,沈阳 110819; 东北大学医学影像计算教育部重点实验室,沈阳110819; 南京大学计算机软件新技术国家重点实验室,南京 210023【正文语种】中文【中图分类】TP391【相关文献】1.利用泊松阻抗进行油气检测 [J], 解吉高;刘志斌;张益明;何峰;王志红;牛聪2.利用Poisson方法实现图像前景提取 [J], 王庆敏;赵亮3.利用地震波出射角确定介质泊松系数的方法[J], А.,АГ;闵祥仪4.利用地震波出射角确定介质泊松系数的方法 [J], 闵祥仪;冯德益5.利用非稳态泊松模型对云南地区地震危险性进行概率预测 [J], 钱晓东; 彭关灵;贺素歌因版权原因,仅展示原文概要,查看原文内容请购买。

pr蒙版原理什么是pr蒙版在图像处理和计算机视觉领域,蒙版是指在特定区域内给图像施加特定效果或操作的一种技术。

pr蒙版(Poisson Reconstruction Mask)是一种基于泊松重建算法的蒙版技术。

pr蒙版的原理pr蒙版的原理是将待修改的图像和参考图像之间的差异映射到蒙版上,通过将蒙版应用于待修改的图像,可以实现图像的重建或修复。

pr蒙版的实现基于泊松重建算法,该算法主要包括以下几个步骤:1. 创建蒙版首先,需要创建一个与待修改的图像相同大小的蒙版图像。

蒙版图像中的每个像素表示相应位置是否需要进行修改,通常使用二进制表示,1表示需要修改,0表示不需要修改。

2. 计算梯度场接下来,计算待修改图像和参考图像之间的梯度场。

梯度场表示图像在不同位置上的颜色变化程度,可以用来指导图像修复时的颜色填充。

3. 重建图像将待修改图像和参考图像之间的差异以及梯度场信息应用于蒙版上,通过最小化重建误差来实现图像的重建。

重建误差通常使用泊松方程来度量,即要求重建图像的梯度场与参考图像的梯度场在蒙版区域内保持一致。

4. 解决边界问题在应用蒙版时,需要处理边界问题,以避免修复后的图像与周围内容不连续。

为了解决这个问题,可以通过在边界区域附加约束条件,如固定像素值或限制梯度值来实现。

pr蒙版的应用pr蒙版在图像修复、图像特效等方面有广泛的应用。

以下是一些常见的应用场景:图像修复pr蒙版可以用于修复图像中的缺陷、刮痕或污渍等问题。

通过创建蒙版并应用泊松重建算法,可以将参考图像中的相应区域填充到待修复区域,从而实现图像的修复。

图像合成pr蒙版可以用于实现图像合成,将不同图像中的内容进行拼接。

通过创建蒙版,并将不同图像的内容叠加在一起,可以实现将多个图像合成为一个完整的图像。

图像特效pr蒙版可以用于实现各种图像特效,如模糊、风格转换等。

通过在蒙版上定义特定区域,并将特效应用于蒙版区域,可以实现对图像局部区域的特殊处理。

基于泊松模型的极大似然保边恢复算法的研究的开题报告一、选题背景和研究意义图像保边恢复是计算机视觉领域中一个重要的研究内容,其目的是在保留图像边缘结构的前提下修补缺失、损坏的图像区域。

这在现实中具有重要的应用价值,在医学影像处理、文物保护、数字图像处理等领域中均有广泛的应用。

随着数字图像技术的不断发展和应用的不断深入,图像保边恢复算法的研究得到了广泛关注。

保边恢复算法的核心问题在于如何保留图像边缘信息,避免图像恢复后出现瑕疵和失真等情况。

传统的保边恢复算法基本上是基于局部信息的方法,这种方法通常是根据缺失区域周围像素的灰度值信息来推测缺失区域的灰度值,但是这种局部信息往往不足以准确地推测出缺失区域的灰度值信息。

而且,这种方法会造成图像边缘结构的信息丢失,导致图像恢复效果不佳。

因此,如何将图像全局信息有效地整合进来,来提升保边恢复算法的效果,成为了当前保边恢复算法的研究热点。

泊松模型是常用的图像处理模型之一,它是一种数学上的偏微分方程,可以描述一个自然界中的二维物理现象和过程,例如图像亮度和色彩在时间和空间上的变化。

基于泊松模型的图像保边恢复算法可以通过拟合图像的全局信息来准确地恢复缺失的图像区域,并保留图像边缘结构的信息。

同时,该方法还可以应用于多种图像修补任务中。

因此,开展基于泊松模型的极大似然保边恢复算法的研究,具有重要的理论和应用价值。

二、研究内容和技术路线本研究的主要研究内容是基于泊松模型的极大似然保边恢复算法,其基本思想是在全局信息的约束下,通过最大化生成的观测数据的概率,来恢复缺失的图像区域。

具体来说,我们将研究以下几个方面:1. 泊松模型的基本原理和应用场景,以及在图像保边恢复算法中的作用;2. 极大似然估计在泊松模型中的基本原理和实现方法;3. 以灰度图像为例,设计并实现基于泊松模型的极大似然保边恢复算法,并评估算法的性能;4. 进一步改进算法的性能,优化保边恢复效果。

技术路线如下:1. 研究泊松模型的基本原理和应用场景,了解泊松模型在图像处理中的作用;2. 研究极大似然估计在泊松模型中的基本原理和实现方法;3. 设计并实现基于泊松模型的极大似然保边恢复算法,测试算法的性能;4. 在实验的基础上,进一步优化算法性能,设计改进策略,实现算法的优化。

最优化大作业

Poisson图像编辑

实验背景

图像合成是图像处理的一个基本问题,其通过将源图像中一个物体或者一个区域嵌入到目标图像生成一个新的图像。

在对图像进行合成的过程中,为了使合成后的图像更自然,合成边界应当保持无缝。

但如果原图像和目标图像有着明显不同的纹理特征,则直接合成后的图像会存在明显的边界。

针对此问题,Prez等[1]提出了一种利用构造Poisson方程求解像素最优值的方法,在保留了源图像梯度信息的同时,可以很好的融合源图像与目标图像的背景。

该方法根据用户指定的边界条件求解一个Poisson方程,实现了梯度域上的连续,从而达到边界处的无缝融合。

实验原理

Poisson图像编辑的主要思想是,根据原图像的梯度信息以及目标图像的边界信息,利用插值的方法重新构建出和成区域内的图像像素。

为表述方便,在图1中标出了各个字母所代表

的区域。

其中,g代表了原图像中被合成的部分,V是g的梯度场,S是合并后的图像,Ω是合并后目标图像中被覆盖的区域,∂Ω是其边界。

设合并后图像在Ω内的像素值由f表示,在Ω外的像素值由*f表示。

图1各区域代表字母示意

注意到图像合并的要求是使合并后的图像看上去尽量的平滑,没有明显的边界。

所以,Ω内的梯度值应当尽可能的小。

因此,f的值可以由(1)得出

2

*

min ..f

f

s t f

f Ω

∂Ω

∂Ω

∇=⎰⎰

(1)

根据Euler-Lagrange 公式,f 最小值应该满足(2)式

*

..f s t f

f ∂Ω

∂Ω

∆==

(2)

其中∆代表Laplacian 算子。

然而,(2)式所求得的解中并没有包含源图像的相关信息。

为使合并后的图像中Ω内的图像尽量接近于g ,可以利用g 的梯度场V 作为求解(1)式时的引导场,即将(1)式改写为如下形式

2

*min ..f

f V s t f

f

Ω

∂Ω

∂Ω

∇-=⎰⎰ (3)

其最优解应满足如(4)的Poisson 方程:

*

..f divV

s t f

f ∂Ω

∂Ω

∆==

(4)

对于一副图像,其像素点的值并不是连续函数,而是离散的数值。

因此,需要建立(4)式的离散形式。

对于S 中的每一个像素点p ,定义p N 代表图像中p 4临域点的集合,定义

,p q <>代表p 与p N 内一点q 的点对。

那么Ω的边界∂Ω可以由(5)式表示

{\:0}p p S N ∂Ω=∈Ω⋂Ω≠

(5)

这样,可以改写(3)为:

,0

*

min

()

..,p q pq f p q p p

f f v s t f f p Ω

<>⋂Ω≠--=∈∂Ω

∑

(6)

同样,根据最优性条件,最优解满足(7)式:

*p p p

p p q q pq

q N q N q N N f f f v

∈⋂Ω

∈⋂∂Ω

∈-

=

+

∑

∑

∑ (7)

这是一个线性方程,解之即可得出Ω内的像素值。

如果像素较多时,系数矩阵规模较大,

求解时可以采用迭代的方法。

Gauss-Seidel 迭代是一种简单易行的迭代法,应此被选作求解(7)式的算法。

实验步骤

本次实验编写了用于Poisson图像合并的Matlab代码,主要功能包括读取源文件及目标文件,交互选择源图像区域,选择合并位置,迭代求解等。

在编写完代码后,具体的操作步骤为:

(1)运行PoissonEditing.m文件;

(2)交互选取源图像,如下图所示选取完成后,双击确认;

(3)确定合并区域;

(4)计算结果并显示。

实验结果

图2显示了直接合并与Poisson编辑结果的不同。

从两张图片的对比来看,Poisson编辑很好的消融了图像合并时的边缘,使得合并后的图像更加自然。

但是,由于Poisson方法的边界条件由目标图像确定,建立最优模型时仅考虑原图像的梯度信息,应此也就失去了部分原图像的颜色信息,这也是图2融合后船颜色偏蓝的原因

图2直接合并与Poisson合并对比

此外,由于图像像素较多,迭代时间较长,由图2的第一幅图得到第二副图像需要1383.879334秒,这也是需要改进的地方。

[1]Pérez, Patrick, Michel Gangnet, and Andrew Blake."Poisson image editing."ACM Transactions on Graphics (TOG) 22.3 (2003): 313-318.。