神经网络作业20092676吴戈林电子0901班

- 格式:docx

- 大小:337.88 KB

- 文档页数:12

神经网络文献综述吴一凡(西南交通大学峨眉校区,四川 峨眉 614202)摘 要:本文着重介绍了神经网络的发展、优点及其应用、发展动向,文中着重论述了神经网络目前的几个研究热点,对神经网络有一个全面系统的概括。

关键词:神经网络 模糊控制 遗传算法 专家系统 小波分析Abstract :Development,merits and application of neural network are introduced in this paper. Then,the trends are presented.And its several main research directs.This paper can give you a comprehensive and systematic exposition of the neural network.Keywords :Neural network Fuzzy control Genetic algorithm Expert system Wavelet analysis0 绪论神经网络最早的研究是20世纪40年代心理学家Mcculloch 和数学家Pitts 合作提出的,他们提出的MP 模型拉开了神经网络研究的序幕,其结构如图1所示。

图1 人工神经元示意图图1中,n I I I ,,,21 表示其他n 个神经元的突触输出,n W W W ,,,21 为其他n个神经元的突触连接,其值可正可负,分别表示兴奋性突触和抑制性突触。

∑θ为阀值,神经元的输出()θf 称为变换函数,一般采用的形式有线性函数、阶跃函数、Sigmoid 函数及双曲正切函数等。

神经网络的发展大致经三个阶段:1947~1969年为初期。

在这期间科学家们提出了许多神经元模型和学习规则,如MP模型、HEBB学习规则和感知器等;1970~1986年为过渡期。

这个期间神经网络研究经过了一个低潮,继续发展。

《神经网络电子教案》PPT课件一、教案简介1. 课程背景:介绍神经网络的基本概念、发展历程和应用领域。

2. 教学目标:使学生了解神经网络的基本原理,掌握神经网络的主要模型和应用。

3. 适用对象:计算机科学、、机器学习等领域的学生。

二、教学内容1. 神经网络的基本概念:神经元、连接、权重、激活函数等。

2. 神经网络的发展历程:生物神经网络、人工神经网络、深度学习等。

3. 神经网络的主要模型:前馈神经网络、卷积神经网络、递归神经网络等。

4. 神经网络的应用领域:图像识别、自然语言处理、推荐系统等。

三、教学方法1. 讲授:讲解神经网络的基本概念、发展历程和主要模型。

2. 案例分析:分析神经网络在图像识别、自然语言处理等领域的应用案例。

3. 互动讨论:引导学生提问、解答疑问,增强课堂活跃度。

4. 练习题:布置课后练习题,巩固所学知识。

四、教学资源1. PPT课件:展示神经网络的基本概念、发展历程、主要模型和应用案例。

2. 参考教材:推荐国内外优秀教材,供学生课后自学。

3. 网络资源:介绍相关领域的在线课程、论文、博客等资源。

五、教学评价1. 课后作业:评估学生对神经网络知识的掌握程度。

2. 课堂互动:评价学生在课堂上的参与程度和提问质量。

3. 小组项目:鼓励学生团队合作,解决实际问题。

4. 期末考试:全面测试学生对神经网络知识的掌握情况。

教案编辑专员:日期:2024六、教学安排1. 课时:共计32课时,每课时45分钟。

2. 授课方式:课堂讲授、案例分析、互动讨论相结合。

3. 课程进度安排:课时1-4:神经网络的基本概念及发展历程课时5-8:前馈神经网络的原理及应用课时9-12:卷积神经网络的原理及应用课时13-16:递归神经网络的原理及应用课时17-20:神经网络在各领域的应用案例分析课时21-24:课后练习及小组项目讨论课时25-28:课堂互动、提问与解答课时29-32:期末考试复习及考试七、教学注意事项1. 确保学生具备一定的数学基础,如线性代数、微积分等。

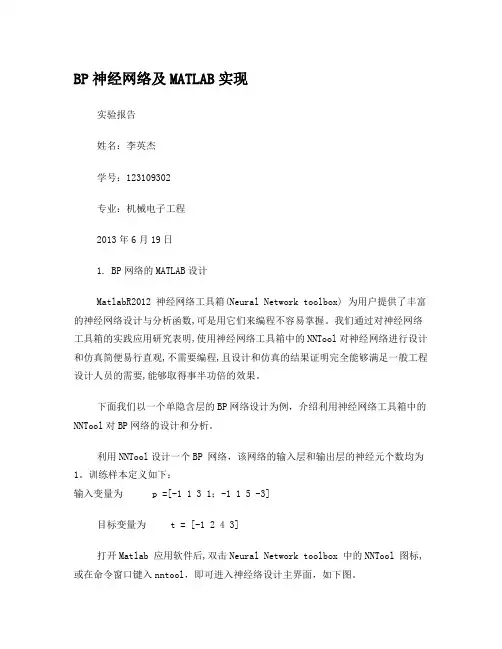

BP神经网络及MATLAB实现实验报告姓名:李英杰学号:123109302专业:机械电子工程2013年6月19日1. BP网络的MATLAB设计MatlabR2012 神经网络工具箱(Neural Network toolbox) 为用户提供了丰富的神经网络设计与分析函数,可是用它们来编程不容易掌握。

我们通过对神经网络工具箱的实践应用研究表明,使用神经网络工具箱中的NNTool对神经网络进行设计和仿真简便易行直观,不需要编程,且设计和仿真的结果证明完全能够满足一般工程设计人员的需要,能够取得事半功倍的效果。

下面我们以一个单隐含层的BP网络设计为例,介绍利用神经网络工具箱中的NNTool对BP网络的设计和分析。

利用NNTool设计一个BP 网络,该网络的输入层和输出层的神经元个数均为1。

训练样本定义如下:输入变量为p =[-1 1 3 1;-1 1 5 -3]目标变量为 t = [-1 2 4 3]打开Matlab 应用软件后,双击Neural Network toolbox 中的NNTool 图标,或在命令窗口键入nntool,即可进入神经络设计主界面,如下图。

图1 NNTool 设计主界面1.训练样本数据的导入点击New按钮,在弹出窗口选择Date选项卡,按如图2,3所示创建输入变量和目标变量。

图2 创建新的输入变量图3 创建新的目标变量2.神经网络的创建点击主界面中点击New按钮,在弹出窗口选择Newwork选项卡,并在对话框中可对网络的名称、类型、结构和训练函数等进行设置,如图4 所示。

图4创建神经元网络界面在上面窗口中对该网络命名为:tracylee;网络类型为:Feed-forward backprop,即前馈BP神经网络;Input ranges :点击Get From Input下拉框选择样本输入变量p加入输入向量;Training function:在下拉列表中选择TRAINGDM训练函数;采用动量梯度下降算法训练 BP 网络。

实验十二: 神经网络及其在数据拟合中的应用(设计性实验)一、实验目的1.了解神经网络的基本知识。

2.学会用matlab神经网络工具箱进行数据拟合。

3.通过实例学习matlab神经网络工具箱的应用。

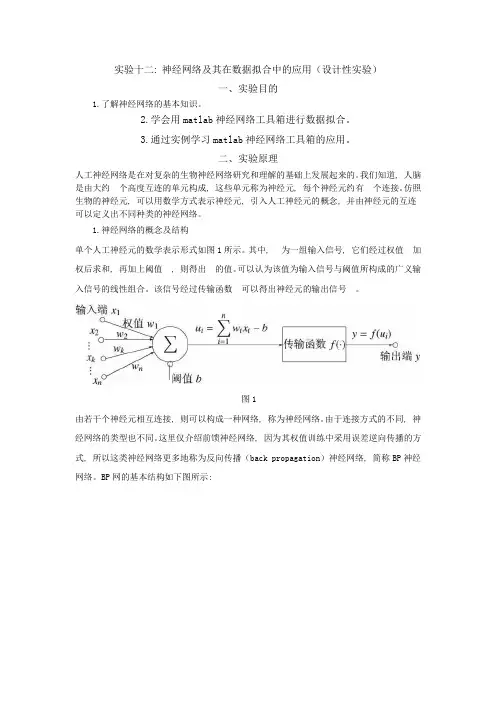

二、实验原理人工神经网络是在对复杂的生物神经网络研究和理解的基础上发展起来的。

我们知道, 人脑是由大约个高度互连的单元构成, 这些单元称为神经元, 每个神经元约有个连接。

仿照生物的神经元, 可以用数学方式表示神经元, 引入人工神经元的概念, 并由神经元的互连可以定义出不同种类的神经网络。

1.神经网络的概念及结构单个人工神经元的数学表示形式如图1所示。

其中, 为一组输入信号, 它们经过权值加权后求和, 再加上阈值, 则得出的值。

可以认为该值为输入信号与阈值所构成的广义输入信号的线性组合。

该信号经过传输函数可以得出神经元的输出信号。

图1由若干个神经元相互连接, 则可以构成一种网络, 称为神经网络。

由于连接方式的不同, 神经网络的类型也不同。

这里仅介绍前馈神经网络, 因为其权值训练中采用误差逆向传播的方式, 所以这类神经网络更多地称为反向传播(back propagation)神经网络, 简称BP神经网络。

BP网的基本结构如下图所示:MATLAB的神经网络工具箱提供了现成的函数和神经网络类, 可以使用newff()函数来建立一个前馈的BP神经网络模型。

newff()的具体调用格式如下:net=newff(x,y,[h1,h2,…,hk],{f1,f2,…,fk})其中, x为输入向量, y为输出(目标)向量。

[h1,h2,…,hk]是一个行向量, 用以存储神经网络各层的节点数, 该向量的大小等于神经网络隐层的层数。

{f1,f2,…,fk}为一个元胞数组, 由若干个字符串构成, 每个字符串对应于该层的传输函数类型。

当这些参数设定好后, 就建立了一个神经网络数据对象net, 它的一些重要属性在下表给出。

2.神经网络的训练和泛化若建立了神经网络模型net, 则可以调用train()函数对神经网络参数进行训练。

神经网络大作业题目神经网络模型的对比与分析学院学号学生姓名神经网络的网络拓扑结构大体有前向型、反馈型、自组织竞争型和随机型网络等拓扑结构(出发点不同网络结构的分法也不一样)。

前向型的人工神经网络有学习、分类等功能,反馈型的人工神经网络有联想记忆、优化计算等功能,自组织竞争型的人工神经网络有聚类、搜索、自组织、自学习等功能。

截至目前,我们主要学习了四种网络模型,即:感知机、有监督的Hebb网络、ADLINE (Widrow-Hoff)模型和反向传播模型(BP)都隶属于前向网络。

下面,我就各个网络模型的学习规则以及异同谈一些体会。

1.感知机学习规则:1943年,Warren McCulloch和Walter Pitts最早提出了一种人工神经元模型,把神经元输入信号的加权和与其阈值相比较以确定神经元的输出。

如果加权和小于阈值,则该神经元的输出值为0;如果加权和大于阈值,则该神经元的输出值为1。

但由于没有找到训练这一网络的方法,因此必须设计这些神经元网络的参数以实现特定的功能。

上世纪50年代,Frank Rosenblatt等研究人员提出了一种感知机的神经网络,引入了用于训练神经网络解决模式识别问题的学习规则,并证明了只要求解问题的权值存在,那么其学习规则通常会收敛到正确的权值上。

但是,感知机网络却存在一定的局限性,其只能解决模式识别中的线性可分问题。

正是由于这种局限性,一度导致神经网络的研究工作陷入低潮。

我们知道,对于1-3维输入单层神经元的模式识别问题,可以通过图解法解决。

其基本程序为:1、画出判定边界,该判定边界实现了区域划分的目的;2、求解权值矩阵,权值矩阵求解的关键是判定边界总是和权值矩阵相正交,对于同一模式识别问题,判定边界的不同会造成权值矩阵的不同。

这一不同,在与当前模式精确匹配时不会产生错误的输出,而在其他模式的判别中可能引起较大的误差(下面将举例说明)。

3、求解偏值,偏值b的求解,可以在求解权值矩阵的基础上,将判定边界上任意一点的坐标带入方程WT*P+b=0得到,如果我们划定的判定边界通过坐标原点,那么此时的b值可以设定为0。

《神经网络实用教程》实验一人工神经网络概论一、实验目的1、了解生物神经网络的组成及功能;2、熟悉人工神经网络的历史发展过程;3、熟悉人工神经网络的组成、工作原理和分类;4、了解人工神经网络的应用环境。

二、实验内容1、在网络上查找生物神经网络的组成及功能的相关资料。

2、在网络上查找人工神经网络的发展过程及发展趋势。

3、列出人工神经网络的种类,每一种人工神经网络给出一个实际的应用例子。

4、浏览神经网络学习网站(1)网站(2)书籍教程神经网络入门教程:神经网络参考书籍:.php?type=blog&itemid=23三、思考与实验总结1、人工神经网络存在哪些缺点?如何解决?2、在什么情况下使用神经网络?《神经网络实用教程》实验二 MATLAB快速入门一、实验目的1、掌握MATLAB工具的安装方法;2、掌握神经网络设计中常用的MATLAB操作技能;3、熟悉神经网络设计中常用MATLAB的绘图功能与使用技巧;4、初步了解MATLAB的程序设计方法。

二、实验内容:1、在MATLAB中求解下列式子计算所得到的结果:(109*891+235-0.5)/16+1822、给定矩阵A = [11 32 23 4; 5 16 7 8; 9 10 25 12],设B = A(2,1:3);在MATLAB中求解下列矩阵运算后的结果:C = [A B']D = [A; 4 3 2 1]C(:, 2) = [ ]C([1 3], :) = [ ]3、使用MATLAB中的条件语句和循环语句,编程实现下面的功能:从1累加到20,即:1+2+3+4+…+20,当累加和超过30时,跳出FOR 循环,在命令窗口中输出此时的累加次数和累加值。

4、神经网络常用的激活函数有S型、对数S型、线性型和硬限幅等,在MATLAB 中有tansig()、logsig()、purelin()和hardlim()四个函数对应,请使用MATLAB 编程,按下画所示图形,画出四个激活函数的图形。

《神经网络电子教案》课件一、引言1. 教学目标:使学生了解神经网络的基本概念、发展历程和应用领域。

2. 教学方法:采用讲授、案例分析、互动讨论等方式进行教学。

3. 教学时长:40分钟4. 教学准备:课件、案例资料、互动讨论问题二、神经网络的基本概念1. 神经元:神经网络的基本单元,包括输入层、隐藏层和输出层。

2. 前馈神经网络:信息从输入层经过隐藏层传递到输出层的神经网络。

3. 反馈神经网络:信息在神经网络中进行循环传递的神经网络。

4. 激活函数:用于判断神经元是否兴奋的函数,如Sigmoid、ReLU等。

5. 损失函数:用于评估神经网络预测结果与实际结果之间差异的函数,如均方误差、交叉熵等。

三、神经网络的发展历程1. 人工神经网络的起源:生物神经网络的研究启示。

2. 人工神经网络的发展:从感知机、多层前馈神经网络到深度学习。

3. 重要人物和成果:霍普菲尔德、反向传播算法、卷积神经网络等。

4. 我国在神经网络领域的发展:华为、阿里巴巴等企业的技术创新。

四、神经网络的应用领域1. 计算机视觉:图像识别、目标检测、人脸识别等。

2. 自然语言处理:机器翻译、文本分类、情感分析等。

3. 语音识别:语音信号处理、说话人识别等。

4. 推荐系统:基于用户行为和神经网络的推荐算法。

5. 智能控制:无人驾驶、控制等。

五、神经网络的训练与优化1. 训练过程:数据预处理、模型构建、参数调整等。

2. 优化算法:梯度下降、随机梯度下降、Adam等。

3. 模型调参:学习率、批量大小、正则化等。

4. 防止过拟合:正则化、Dropout、数据增强等。

5. 模型评估:准确率、召回率、F1值等指标。

六、前馈神经网络的架构与功能1. 单层神经网络与多层神经网络:理解不同层数的神经网络如何处理复杂问题。

2. 全连接神经网络:每一个输入都与隐藏层的每一个神经元相连接。

3. 卷积神经网络(CNN):适用于处理具有网格结构的数据,如图像和视频。

目录摘要 (1)Abstract (1)1绪论 (2)1.1人工神经网络概述 (2)1.2人工神经网络的基本模型 (3)1.3人工神经网络的特点 (5)1.4人工神经网络的分类 (5)2神经网络发展 (6)2.1早期阶段 (6)2.2过渡阶段 (6)2.3复兴时期 (7)2.4发展时期 (7)3神经网络基本原理 (9)3.1人工神经网络的工作机理 (9)3.2人工神经网络的互连方式 (9)4其他神经网络 (12)4.1回归神经网络(RNN) (12)4.2卷积神经网络(CNN) (12)4.3模糊神经网络 (13)5深度学习的发展与应用 (15)5.1深度学习在语音识别中的应用 (15)5.2深度学习在语言处理中的应用 (16)总结 (17)参考文献 (18)摘要神经控制是一种新型的控制系统,其在动态模拟、建模和控制方面应用广泛。

人工神经网络是人工智能的重要分支,具有自适应、自组织和自学习的特点。

回顾了人工神经网络理论的发展历史,并介绍了其在信息、医学、经济、控制等领域的应用及研究现状。

随着人们对人工神经网络不断地探索和研究,并将其与一些传统方法相结合,将推动人工智能的发展,在以后的生产生活中发挥更大的作用。

关键词:人工神经网络;应用;现状;发展AbstractNeural control is a new type of control system in the dynamic simulation, modeling and control applications. As an important branch of artificial intelligence,artificial neural network own the characteristics of self-adaption,self-organization and self-learning. Review the development history of artificial neural network theory and its application and research status in the field of information,medicine,economic,control and others are introduced. As continuous exploring and researching the combination of artificial neural network and some traditional methods will promote the development of artificial intelligence and play a bigger role in the production and living later.Key words: Artificial Neural Network;application;current situation;prospect1绪论1.1人工神经网络概述人工神经网络是对生理学上真实人脑生物神经元网络的结构、功能、以及若干基本特性的某种理论抽象、简化和模拟,它实际上是一种复杂的信息处理系统,是由大量神经元通过极其丰富和完善的联接而构成的自适应非线性动态系统。

神经网络原理及其应用——基于BP 人工神经网络的图像分割器学校:东北大学班级:电子信息工程0901班姓名:吴戈林学号:20092676指导老师:王斐时间:2012年12月目录人工神经网络 (3)一、特点与优势 (3)二、人工神经网络的主要研究方向 (4)三、人工神经网络的应用分析 (4)四、人工神经网络在图像分割中的应用 (6)1.问题概述 (7)2.基于BP 人工神经网络的图像分割器 (8)2.1神经网络结构的确定 (8)2. 2 神经网络结构的改进 (9)2. 3 BP 神经网络的图像分割基本训练 (9)2. 4 BP 神经网络的针对性训练 (10)3.网络应用 (10)4.结论 (11)五、课程收获与感想 (11)六、参考文献 (12)人工神经网络人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connectionist Model),是对人脑或自然神经网络(Natural Neural Network)若干基本特性的抽象和模拟。

人工神经网络以对大脑的生理研究成果为基础的,其目的在于模拟大脑的某些机理与机制,实现某个方面的功能。

国际著名的神经网络研究专家,第一家神经计算机公司的创立者与领导人Hecht Nielsen给人工神经网络下的定义就是:“人工神经网络是由人工建立的以有向图为拓扑结构的动态系统,它通过对连续或断续的输入作状态相应而进行信息处理。

”这一定义是恰当的。

人工神经网络的研究,可以追溯到1957年Rosenblatt提出的感知器模型(Perceptron) 。

它几乎与人工智能——AI(Artificial Intelligence)同时起步,但30余年来却并未取得人工智能那样巨大的成功,中间经历了一段长时间的萧条。

直到80年代,获得了关于人工神经网络切实可行的算法,以及以Von Neumann体系为依托的传统算法在知识处理方面日益显露出其力不从心后,人们才重新对人工神经网络发生了兴趣,导致神经网络的复兴。

目前在神经网络研究方法上已形成多个流派,最富有成果的研究工作包括:多层网络BP算法,Hopfield网络模型,自适应共振理论,自组织特征映射理论等。

人工神经网络是在现代神经科学的基础上提出来的。

它虽然反映了人脑功能的基本特征,但远不是自然神经网络的逼真描写,而只是它的某种简化抽象和模拟。

一、特点与优势人工神经网络的以下几个突出的优点使它近年来引起人们的极大关注:(1)可以充分逼近任意复杂的非线性关系;(2)所有定量或定性的信息都等势分布贮存于网络内的各神经元,故有很强的鲁棒性和容错性;(3)采用并行分布处理方法,使得快速进行大量运算成为可能;(4)可学习和自适应不知道或不确定的系统;(5)能够同时处理定量、定性知识。

人工神经网络的优越性,主要表现在三个方面:第一,具有自学习功能。

例如实现图像识别时,只在先把许多不同的图像样板和对应的应识别的结果输入人工神经网络,网络就会通过自学习功能,慢慢学会识别类似的图像。

自学习功能对于预测有特别重要的意义。

预期未来的人工神经网络计算机将为人类提供经济预测、市场预测、效益预测,其应用前途是很远大的。

第二,具有联想存储功能。

用人工神经网络的反馈网络就可以实现这种联想。

第三,具有高速寻找优化解的能力。

寻找一个复杂问题的优化解,往往需要很大的计算量,利用一个针对某问题而设计的反馈型人工神经网络,发挥计算机的高速运算能力,可能很快找到优化解。

二、人工神经网络的主要研究方向神经网络的研究可以分为理论研究和应用研究两大方面。

理论研究可分为以下两类:1).利用神经生理与认知科学研究人类思维以及智能机理。

2).利用神经基础理论的研究成果,用数理方法探索功能更加完善、性能更加优越的神经网络模型,深入研究网络算法和性能,如:稳定性、收敛性、容错性、鲁棒性等;开发新的网络数理理论,如:神经网络动力学、非线性神经场等。

应用研究可分为以下两类:1).神经网络的软件模拟和硬件实现的研究。

2).神经网络在各个领域中应用的研究。

这些领域主要包括:模式识别、信号处理、知识工程、专家系统、优化组合、机器人控制等。

随着神经网络理论本身以及相关理论、相关技术的不断发展,神经网络的应用定将更加深入。

三、人工神经网络的应用分析神经网络近来越来越受到人们的关注,因为它为解决大复杂度问题提供了一种相对来说比较有效的简单方法。

神经网络可以很容易的解决具有上百个参数的问题(当然实际生物体中存在的神经网络要比我们这里所说的程序模拟的神经网络要复杂的多)。

神经网络常用于两类问题:分类和回归。

在结构上,可以把一个神经网络划分为输入层、输出层和隐含层(见图1)。

输入层的每个节点对应一个个的预测变量。

输出层的节点对应目标变量,可有多个。

在输入层和输出层之间是隐含层(对神经网络使用者来说不可见),隐含层的层数和每层节点的个数决定了神经网络的复杂度。

图1一个神经元网络除了输入层的节点,神经网络的每个节点都与很多它前面的节点(称为此节点的输入节点)连接在一起,每个连接对应一个权重Wxy,此节点的值就是通过它所有输入节点的值与对应连接权重乘积的和作为一个函数的输入而得到,我们把这个函数称为活动函数或挤压函数。

如图2中节点4输出到节点6的值可通过如下计算得到:W14*节点1的值+W24*节点2的值神经网络的每个节点都可表示成预测变量(节点1,2)的值或值的组合(节点3-6)。

注意节点6的值已经不再是节点1、2的线性组合,因为数据在隐含层中传递时使用了活动函数。

实际上如果没有活动函数的话,神经元网络就等价于一个线性回归函数,如果此活动函数是某种特定的非线性函数,那神经网络又等价于逻辑回归。

调整节点间连接的权重就是在建立(也称训练)神经网络时要做的工作。

最早的也是最基本的权重调整方法是错误回馈法,现在较新的有变化坡度法、类牛顿法、Levenberg-Marquardt法、和遗传算法等。

无论采用那种训练方法,都需要有一些参数来控制训练的过程,如防止训练过度和控制训练的速度。

图2带权重Wxy的神经元网络决定神经网络拓扑结构(或体系结构)的是隐含层及其所含节点的个数,以及节点之间的连接方式。

要从头开始设计一个神经网络,必须要决定隐含层和节点的数目,活动函数的形式,以及对权重做那些限制等,当然如果采用成熟软件工具的话,他会帮你决定这些事情。

在诸多类型的神经网络中,最常用的是前向传播式神经网络,也就是我们前面图示中所描绘的那种。

我们下面详细讨论一下,为讨论方便假定只含有一层隐含节点。

可以认为错误回馈式训练法是变化坡度法的简化,其过程如下:前向传播:数据从输入到输出的过程是一个从前向后的传播过程,后一节点的值通过它前面相连的节点传过来,然后把值按照各个连接权重的大小加权输入活动函数再得到新的值,进一步传播到下一个节点。

回馈:当节点的输出值与我们预期的值不同,也就是发生错误时,神经网络就要“学习”(从错误中学习)。

我们可以把节点间连接的权重看成后一节点对前一节点的“信任”程度(他自己向下一节点的输出更容易受他前面哪个节点输入的影响)。

学习的方法是采用惩罚的方法,过程如下:如果一节点输出发生错误,那么他看他的错误是受哪个(些)输入节点的影响而造成的,是不是他最信任的节点(权重最高的节点)陷害了他(使他出错),如果是则要降低对他的信任值(降低权重),惩罚他们,同时升高那些做出正确建议节点的信任值。

对那些收到惩罚的节点来说,他也需要用同样的方法来进一步惩罚它前面的节点。

就这样把惩罚一步步向前传播直到输入节点为止。

对训练集中的每一条记录都要重复这个步骤,用前向传播得到输出值,如果发生错误,则用回馈法进行学习。

当把训练集中的每一条记录都运行过一遍之后,我们称完成一个训练周期。

要完成神经网络的训练可能需要很多个训练周期,经常是几百个。

训练完成之后得到的神经网络就是在通过训练集发现的模型,描述了训练集中响应变量受预测变量影响的变化规律。

由于神经网络隐含层中的可变参数太多,如果训练时间足够长的话,神经网络很可能把训练集的所有细节信息都“记”下来,而不是建立一个忽略细节只具有规律性的模型,我们称这种情况为训练过度。

显然这种“模型”对训练集会有很高的准确率,而一旦离开训练集应用到其他数据,很可能准确度急剧下降。

为了防止这种训练过度的情况,我们必须知道在什么时候要停止训练。

在有些软件实现中会在训练的同时用一个测试集来计算神经网络在此测试集上的正确率,一旦这个正确率不再升高甚至开始下降时,那么就认为现在神经网络已经达到做好的状态了可以停止训练。

图3中的曲线可以帮我们理解为什么利用测试集能防止训练过度的出现。

在图中可以看到训练集和测试集的错误率在一开始都随着训练周期的增加不断降低,而测试集的错误率在达到一个谷底后反而开始上升,我们认为这个开始上升的时刻就是应该停止训练的时刻。

神经元网络和统计方法在本质上有很多差别。

神经网络的参数可以比统计方法多很多。

由于参数如此之多,参数通过各种各样的组合方式来影响输出结果,以至于很难对一个神经网络表示的模型做出直观的解释。

实际上神经网络也正是当作“黑盒”来用的,不用去管“盒子”里面是什么,只管用就行了。

在大部分情况下,这种限制条件是可以接受的。

比如银行可能需要一个笔迹识别软件,但他没必要知道为什么这些线条组合在一起就是一个人的签名,而另外一个相似的则不是。

在很多复杂度很高的问题如化学试验、机器人、金融市场的模拟、和语言图像的识别,等领域神经网络都取得了很好的效果。

神经网络的另一个优点是很容易在并行计算机上实现,可以把他的节点分配到不同的CPU上并行计算。

在使用神经网络时有几点需要注意:第一,神经网络很难解释,目前还没有能对神经网络做出显而易见解释的方法学。

第二,神经网络会学习过度,在训练神经网络时一定要恰当的使用一些能严格衡量神经网络的方法,如前面提到的测试集方法和交叉验证法等。

这主要是由于神经网络太灵活、可变参数太多,如果给足够的时间,他几乎可以“记住”任何事情。

第三,除非问题非常简单,训练一个神经网络可能需要相当可观的时间才能完成。

当然,一旦神经网络建立好了,在用它做预测时运行时还是很快得。

第四,建立神经网络需要做的数据准备工作量很大。

一个很有误导性的神话就是不管用什么数据神经网络都能很好的工作并做出准确的预测。

这是不确切的,要想得到准确度高的模型必须认真的进行数据清洗、整理、转换、选择等工作,对任何数据挖掘技术都是这样,神经网络尤其注重这一点。

比如神经网络要求所有的输入变量都必须是0-1(或-1 -- +1)之间的实数,因此像“地区”之类文本数据必须先做必要的处理之后才能用作神经网络的输入。