神经网络作业

- 格式:docx

- 大小:54.01 KB

- 文档页数:3

2023年秋江苏开放大学神经网络与深度学习形考二作业试题列表单选题题型:单选题客观题分值5分难度:简单得分:51以下卷积运算的输出结果为A11 12<br>10 1115 16<br> 6 15C10 11<br>11 12D11 12<br>10 11学生答案:B老师点评:题型:单选题客观题分值5分难度:中等得分:52以下关于神经⽹络的训练过程,描述错误的是?A【mini-batch】从训练数据中随机选出⼀部分数据,这部分数据称为mini-batch,我们的⽬标是减少mini-batch损失函数的值。

【随机梯度下降】stochastic gradient descent:“随机”代表在梯度下降中随机初始⼀个学习率,并不断尝试多个值,寻求最好的结果C【计算梯度】为了减⼩mini-batch的损失函数,需要求出各个权重参数的梯度D【更新参数】梯度反⽅向表示损失函数的值减⼩最多的⽅向,将权重参数沿梯度反⽅向进⾏微⼩更新学生答案:B老师点评:题型:单选题客观题分值5分难度:一般得分:53多义现象可以被定义为在⽂本对象中⼀个单词或短语的多种含义共存。

下列哪⼀种⽅法可能是解决此问题的最好选择?A随机森林B以上所有⽅法卷积神经⽹络D强化学习学生答案:C老师点评:题型:单选题客观题分值5分难度:中等得分:54在⼀个神经⽹络⾥,知道每⼀个神经元的权重和偏差是最重要的⼀步。

如果以某种⽅法知道了神经元准确的权重和偏差,你就可以近似任何函数。

实现这个最佳的办法是什么?A以上都不正确B搜索所有权重和偏差的组合,直到得到最优值C随机赋值,祈祷它们是正确的赋予⼀个初始值,检查与最优值的差值,然后迭代更新权重学生答案:D题型:单选题客观题分值5分难度:一般得分:55以下场景中适合采⽤⼀对多结构RNN的是?A基于帧粒度的视频分类B⽣成图⽚说明C情感分析D机器翻译学生答案:B题型:单选题客观题分值5分难度:一般得分:56在典型CNN⽹络AlexNet中,原始图⽚是⼤⼩为227*227的三通道数据,经过96个⼤⼩为11*11的卷积核卷积后得到96个⼤⼩为55*55的特征图,若padding = 0 ,则卷积核的步⻓为多少?4B1C2D3学生答案:A老师点评:题型:单选题客观题分值5分难度:一般得分:57】在神经⽹络的学习中,权重的初始值特别重要,设定什么样的权重初始值,经常关系到神经⽹络的学习能否成功。

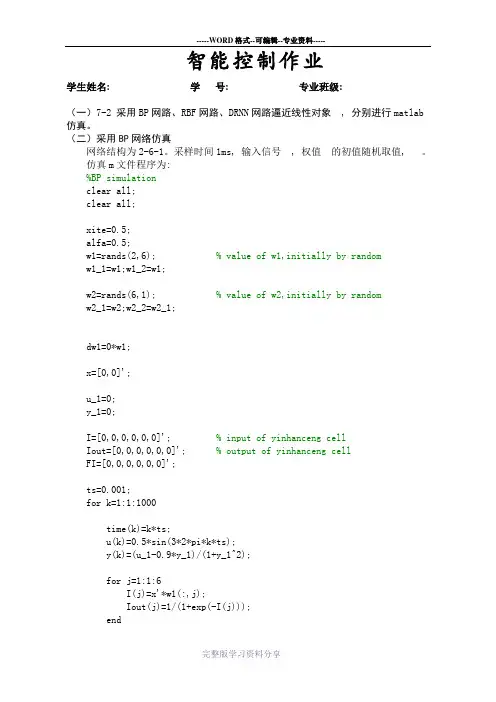

智能控制作业学生姓名: 学号: 专业班级:(一)7-2 采用BP网路、RBF网路、DRNN网路逼近线性对象, 分别进行matlab 仿真。

(二)采用BP网络仿真网络结构为2-6-1。

采样时间1ms, 输入信号, 权值的初值随机取值, 。

仿真m文件程序为:%BP simulationclear all;clear all;xite=0.5;alfa=0.5;w1=rands(2,6); % value of w1,initially by randomw1_1=w1;w1_2=w1;w2=rands(6,1); % value of w2,initially by randomw2_1=w2;w2_2=w2_1;dw1=0*w1;x=[0,0]';u_1=0;y_1=0;I=[0,0,0,0,0,0]'; % input of yinhanceng cellIout=[0,0,0,0,0,0]'; % output of yinhanceng cellFI=[0,0,0,0,0,0]';ts=0.001;for k=1:1:1000time(k)=k*ts;u(k)=0.5*sin(3*2*pi*k*ts);y(k)=(u_1-0.9*y_1)/(1+y_1^2);for j=1:1:6I(j)=x'*w1(:,j);Iout(j)=1/(1+exp(-I(j)));endyn(k)=w2'*Iout; %output of networke(k)=y(k)-yn(k); % error calculationw2=w2_1+(xite*e(k))*Iout+alfa*(w2_1-w2_2); % rectify of w2for j=1:1:6FI(j)=exp(-I(j))/(1+exp(-I(j))^2);endfor i=1:1:2for j=1:1:6dw1(i,j)=e(k)*xite*FI(j)*w2(j)*x(i); % dw1 calculation endendw1=w1_1+dw1+alfa*(w1_1-w1_2); % rectify of w1% jacobian informationyu=0;for j=1:1:6yu=yu+w2(j)*w1(1,j)*FI(j);enddyu(k)=yu;x(1)=u(k);x(2)=y(k);w1_2=w1_1;w1_1=w1;w2_2=w2_1;w2_1=w2;u_1=u(k);y_1=y(k);endfigure(1);plot(time,y,'r',time,yn,'b');xlabel('times');ylabel('y and yn');figure(2);plot(time,y-yn,'r');xlabel('times');ylabel('error');figure(3);plot(time,dyu);xlabel('times');ylabel('dyu');运行结果为:(三)采用RBF网络仿真网路结构为2-4-1, 采样时间1ms, 输入信号, 权值的初值随机取值, , 高斯基函数初值, 。

大工22夏《神经网络》大作业

1. 项目介绍

本次《神经网络》大作业旨在让同学们深入理解神经网络的工作原理,并能够独立实现一个简单的神经网络模型。

通过完成本次作业,同学们将掌握神经网络的基本结构,训练过程以及参数优化方法。

2. 任务要求

1. 独立实现一个具有至少三层神经网络的结构,包括输入层、隐藏层和输出层。

2. 选择一个合适的激活函数,并实现其对应的激活和导数计算方法。

3. 实现神经网络的正向传播和反向传播过程,包括权重更新和偏置更新。

4. 在一个简单的数据集上进行训练,评估并优化所实现的神经网络模型。

3. 评分标准

1. 神经网络结构实现(30分)

2. 激活函数实现(20分)

3. 正向传播和反向传播实现(20分)

4. 模型训练与评估(20分)

5. 代码规范与文档说明(10分)

4. 提交要求

1. 提交代码文件,包括神经网络结构、激活函数、正向传播、反向传播以及训练与评估的实现。

2. 提交一份项目报告,包括项目简介、实现思路、实验结果及分析。

3. 请在提交前确保代码的可运行性,并在报告中附上运行结果截图。

5. 参考资料

1. Goodfellow, I. J., Bengio, Y., & Courville, A. C. (2016). Deep learning. MIT press.

2. Russell, S., & Norvig, P. (2016). Artificial intelligence: a modern approach. Pearson Education Limited.

祝大家作业顺利!。

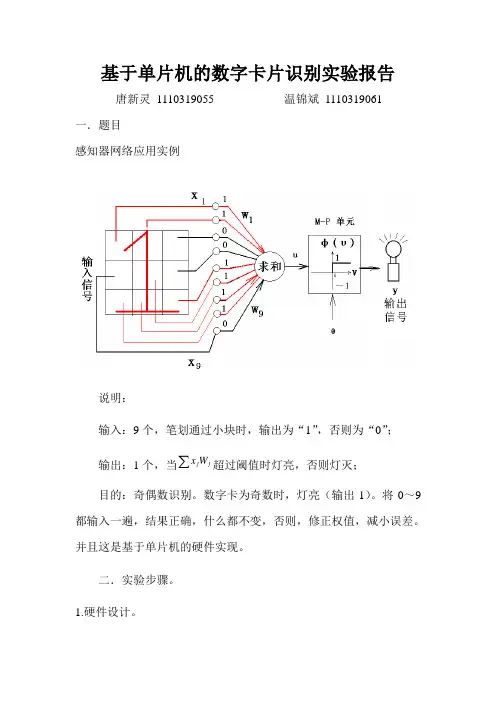

基于单片机的数字卡片识别实验报告 唐新灵 1110319055 温锦斌 1110319061一.题目感知器网络应用实例说明:输入:9个,笔划通过小块时,输出为“1”,否则为“0”; 输出:1个,当 j j W x 超过阈值时灯亮,否则灯灭;目的:奇偶数识别。

数字卡为奇数时,灯亮(输出1)。

将0~9都输入一遍,结果正确,什么都不变,否则,修正权值,减小误差。

并且这是基于单片机的硬件实现。

二.实验步骤。

1.硬件设计。

(1)实验器材单片机一块:8051F020单片机;PCB板一块;200欧电阻两个;开关若干;发光二极管若干;细导线若干。

(2)仿真软件Keil3,proteus;(3)硬件画图在proteus上画出硬件图,如下所示:(4)软件设计根据神经网络的原理和单片机的软件设计特点用C语言写出程序,程序如下:#include "C8051F020.h"#define uchar unsigned char#define uint unsigned int//sbit p20=P2^0; //指示灯sbit S1=P1^0;sbit S2=P1^1;sbit S3=P1^2;sbit S4=P1^3;sbit S5=P1^4;sbit S6=P1^5;sbit S7=P3^7;sbit S8=P1^7;sbit S9=P3^5;sbit S10=P3^6;sbit LED1=P3^0;sbit LED2=P3^1;void Oscillator_Init() //外部晶振初始化{int i = 0;OSCXCN = 0x66;for (i = 0; i < 3000; i++); // Wait 1ms for initialization while ((OSCXCN & 0x80) == 0);OSCICN = 0x08;}void Timer_Init(){CKCON = 0x18;TMOD = 0x21;TH1 = 0x30;//600bps }void UART_Init(){SCON0 = 0x40;SCON1 = 0x40;}void Port_IO_Init(){P0MDOUT = 0x0F;P1MDOUT = 0xff;P3MDOUT = 0xff;XBR0 = 0x14;XBR2 = 0x44;}void Interrupts_Init(){IE = 0x98;IP = 0x18;EIE2 = 0x40;EIP2 = 0x40;}void PCA_Init() //PCA配置产生38KHz载波{PCA0MD = 0x08;PCA0CPM1 = 0x46;PCA0CPM2 = 0x46;PCA0CPH0 = 0x35;PCA0CPH1 = 0x35;}void Init_Device(void){Oscillator_Init();Timer_Init();PCA_Init();UART_Init();Port_IO_Init();Interrupts_Init();PCA0CN = 0x40;//启动PCA}void delay(){uint i,j;for(i=0;i<2;i++);//for(j=0;j<50;j++);}/*************************************************/ void main(){int x[10][10]={{0,0,1,0,0,1,1,0,0,0},{0,1,1,0,1,0,1,0,0,1},{0,1,1,1,0,0,1,0,0,0},{1,0,1,0,1,1,1,0,0,0},{1,1,1,0,0,1,0,0,0,0},{1,0,1,0,1,0,0,0,1,1},{0,1,1,1,0,0,0,1,0,0},{0,0,1,0,0,1,0,1,0,0},{0,1,1,1,0,1,1,1,0,0},{0,1,1,0,1,0,0,1,1,0}};int d[10]={0,1,0,1,0,1,0,1,0,1},t[10]={0};int k,j,i,h,a,e,l;long w[10]={0,0,0,0,0,0,0,0,0,0};long c[10];float f[10],b[10],p=0;int r=1;long v=0;int y;for(k=1;k<=5;k++)for(j=0;j<=9;j++)for(i=0;i<=9;i++){c[i]=x[j][i]*w[i]*1000;//v=v+c[i];v=c[0]+c[1]+c[2]+c[3]+c[4]+c[5]+c[6]+c[7]+c[8]+c[9];if (v<0)y=0;elsey=1;w[i]=w[i]+r*(d[j]-y)*x[j][i]*1000;}for(i=0;i<=9;i++){f[i]=w[i]/1000;}WDTCN=0xde; //看门狗禁用WDTCN=0xad;Init_Device(); //初始化//TCON = 0x50; //启动定时器LED2=0;LED1=1;while(1){for(i=0;i<=9;i++){if (S1==0)t[i]=x[0][i];if (S2==0)t[i]=x[1][i];if (S3==0)t[i]=x[2][i];if (S4==0)t[i]=x[3][i]; if (S5==0)t[i]=x[4][i]; if (S6==0)t[i]=x[5][i]; if (S7==0)t[i]=x[6][i]; if (S8==0)t[i]=x[7][i]; if (S9==0)t[i]=x[8][i]; if (S10==0) t[i]=x[9][i]; p=p+t[i]*f[i]; }if (p<0)h=0;elseh=1;l=!h; LED2=h; LED1=l;//if (LED1==0){delay();LED1=1;};//if (LED2==0){delay();LED2=1;};}}三.实验实物照片照片1.整体视图照片2.单片机部分视图照片3.卡片识别部分视图四.实验结果。

BP神经网络及MATLAB实现实验报告姓名:李英杰学号:123109302专业:机械电子工程2013年6月19日1. BP网络的MATLAB设计MatlabR2012 神经网络工具箱(Neural Network toolbox) 为用户提供了丰富的神经网络设计与分析函数,可是用它们来编程不容易掌握。

我们通过对神经网络工具箱的实践应用研究表明,使用神经网络工具箱中的NNTool对神经网络进行设计和仿真简便易行直观,不需要编程,且设计和仿真的结果证明完全能够满足一般工程设计人员的需要,能够取得事半功倍的效果。

下面我们以一个单隐含层的BP网络设计为例,介绍利用神经网络工具箱中的NNTool对BP网络的设计和分析。

利用NNTool设计一个BP 网络,该网络的输入层和输出层的神经元个数均为1。

训练样本定义如下:输入变量为p =[-1 1 3 1;-1 1 5 -3]目标变量为 t = [-1 2 4 3]打开Matlab 应用软件后,双击Neural Network toolbox 中的NNTool 图标,或在命令窗口键入nntool,即可进入神经络设计主界面,如下图。

图1 NNTool 设计主界面1.训练样本数据的导入点击New按钮,在弹出窗口选择Date选项卡,按如图2,3所示创建输入变量和目标变量。

图2 创建新的输入变量图3 创建新的目标变量2.神经网络的创建点击主界面中点击New按钮,在弹出窗口选择Newwork选项卡,并在对话框中可对网络的名称、类型、结构和训练函数等进行设置,如图4 所示。

图4创建神经元网络界面在上面窗口中对该网络命名为:tracylee;网络类型为:Feed-forward backprop,即前馈BP神经网络;Input ranges :点击Get From Input下拉框选择样本输入变量p加入输入向量;Training function:在下拉列表中选择TRAINGDM训练函数;采用动量梯度下降算法训练 BP 网络。

神经网络课程作业1.要求程序具有以下功能:能对6输入单节点网络进行训练;能选用不同的学习规则;能选用不同的转移函数;能选用不同的训练样本程序调试通过后,自己设计一组数据进行训练,训练时应给出每一步的净输入和权向量调整结果。

2.下面给出的训练集由玩具兔和玩具熊组成。

输入样本向量的第一个分量代表玩具的重量,第二分量代表玩具耳朵的长度,教师信号为-1表示玩具兔,教师信号为1表示玩具熊。

{X=[1,4],d=-1}, {X=[1,5],d=-1},{X=[2,4],d=-1}, {X=[2,5],d=-1},{X=[3,1],d=1}, {X=[3,2],d=1},{X=[4,1],d=1}, {X=[4,2],d=1}.1. 用MATLAB训练一个感知器,求解此分类问题。

2. 用输入样本对所训练的感知器进行验证。

3. 根据BP流程图上机编程实现三层前馈神经网络的BP学习算法。

要求程序具有以下功能:1. 允许选择各层节点数;2. 允许选用不同的学习率;3. 能对权值进行初始化,初始化用[-1,1]区间的随机数4.允许选用单极性或双极性两种不同Sigmoid型转移函数程序调试通过后,可用以下题目提供的数据进行训练。

设计一个神经网络对下面三类线性不可分模式进行分类。

期望输出向量分别用(1,-1,-1),(-1,1,-1),(-1,-1,1)代表三类,输入用下面9个样本坐标,要求:选择合适的隐节点数;用BP算法训练网络对下面9个样本进行正确分类第一类:(1/4,1/4)(3/4,1/8)(3/4,3/4)第二类:(1/2,1/8)(3/4,1/4)(3/4,1/4)第三类:(1/4,1/2)(1/2,1/2)(3/4,1/2)4.给定5个4维输入模式如下: (1,0,0,0),(1,1,0,0),(1,1,1,0),(0,1,0,0),(1,1,1,1)试设计一个具有5*5神经元平面阵的SOM网,建议学习率在前1000步训练中从0.5线性下降至0.04,然后在训练到10000步时减小至0.优胜领域半径初值设为2个节点(即优胜领域覆盖整个输出平面),1000个训练步时减至0(即只含获胜节点)。

一、单项选择题1.人工神经网络是人工智能的三大流派思想中哪个流派的基础。

(B)A.符号主义B.连接主义(或称为仿生学派)C.行为主义D.逻辑推理主义2.以下关于感知器的说法错误的是(A)。

A.单层感知器可以解决异或问题B.感知器分类的原理是就是通过调整权重使两类不同的样本经过感知机模型后的输出不同C.单层感知器只能针对线性可分的数据集分类D.学习率可以控制每次权值调整力度3.人工神经网络的层数增加会出现梯度消失现象,其本质原因是(C)。

A.各层误差梯度相加导致B.各层误差梯度相减导致C.各层误差梯度相乘导致D.误差趋于饱和4.卷积层的主要作用是(A)A.提取图像特征B.降低输入维度C.解决梯度消失和梯度爆炸问题D.进行某种非线性变换二、多项选择题1.知识可以从以下哪几个维度来进行分类(AC)。

A.是否可统计B.是否可计算C.是否可推理D.是否可被人理解2.人工神经网络由许多神经元构成,M-P模型的主要特征包括(ABD)。

A.多输入单输出B.对输入加权求和C.具有树突和轴突D.具有激活函数3.卷积神经网络的结构主要包括(ABCD)。

A.卷积层B.池化层C.全连接层D.输入层三、判断题1.人工神经网络的层数是固定的,每层的神经元个数是不固定的(错)2.BP神经网络的误差是从前往后传播的(错)3.卷积神经网络的层数一般超过三层(对)四、简答题1.感知机是如何实现从数据中学习的?答:通过训练数据得到误差,再根据误差来调整权值,让再次计算训练数据得到的误差减小,最终达到无误差。

这时候得到的权值就称为学习到关于这些数据的知识。

2.什么是梯度,什么是梯度的方向?答:梯度就是把多元函数关于各个变量的偏导数放在一起构成的向量(也称为矢量)。

梯度方向表示当函数的各个变量都按照各自偏导数的比例进行增加时,各个增加量合起来构成的方向,是函数值变化最快的方向。

3.有A类物体和B类物体,均有两个类似的特征值。

以下有三个属于A类的样本,每个样本的特征值分别为[0.1, 1],[0.2, 0.7],[0.4, 0.8],样本标签用1表示;有三个属于B类的样本,其特征值分别为[0.8, 0.3],[0.9, 0.2],[1.0, 0.5],样本标签用0表示。

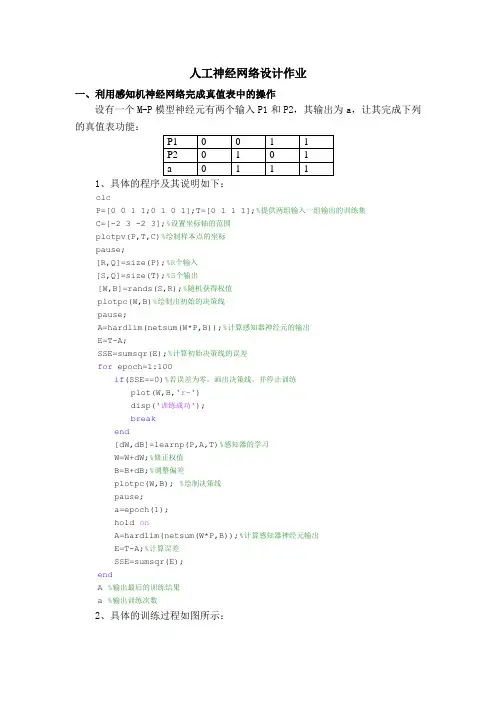

人工神经网络设计作业一、利用感知机神经网络完成真值表中的操作设有一个M-P模型神经元有两个输入P1和P2,其输出为a,让其完成下列的真值表功能:1、具体的程序及其说明如下:clcP=[0 0 1 1;0 1 0 1];T=[0 1 1 1];%提供两组输入一组输出的训练集C=[-2 3 -2 3];%设置坐标轴的范围plotpv(P,T,C)%绘制样本点的坐标pause;[R,Q]=size(P);%R个输入[S,Q]=size(T);%S个输出[W,B]=rands(S,R);%随机获得权值plotpc(W,B)%绘制出初始的决策线pause;A=hardlim(netsum(W*P,B));%计算感知器神经元的输出E=T-A;SSE=sumsqr(E);%计算初始决策线的误差for epoch=1:100if(SSE==0)%若误差为零,画出决策线,并停止训练plot(W,B,'r-')disp('训练成功');breakend[dW,dB]=learnp(P,A,T)%感知器的学习W=W+dW;%修正权值B=B+dB;%调整偏差plotpc(W,B); %绘制决策线pause;a=epoch(1);hold onA=hardlim(netsum(W*P,B));%计算感知器神经元输出E=T-A;%计算误差SSE=sumsqr(E);endA %输出最后的训练结果a %输出训练次数2、具体的训练过程如图所示:样本点P(1)P (2)初始决策线P(1)P (2)训练中的决策线P(1)P (2)训练结束P(1)P (2)3、训练结果:训练结束后我们可知道A=[0 1 1 1],训练次数a=4次。

二、利用BP 网络逼近一个非线性函数1、函数选择为指数衰减函数2*2p te -=*,隐层采用对数正切S 型,输出层采用线性型,具体的程序及其说明如下:clcn=5;%隐层神经元的个数 lr=0.1;%学习率 mc=0.9;%动量因子 p=0:0.05:3; t=2*exp(-2.*p);[r,l]=size(p);%r 输入层的维数 [s,l]=size(t);%s 输出层的维数 w1=0.2*rand(n,r);%隐层的权值 deltaw1=zeros(n,r); B1=0.2*rand(n,1);%隐层的偏移量 deltaB1=zeros(n,1); w2=0.2*rand(s,n);%输出层权值 deltaw2=zeros(s,n);B2=0.2*rand(s,1);%输出层的偏移量 deltaB2=zeros(s,1); A1=tansig(w1*p,B1);A2=purelin(w2*A1,B2);plot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');axis([0 3 -1 2])title(['样本点和未经训练的曲线']);legend('样本点');pause;epoch=1;sse=1;for epoch=1:10000 %最大训练圈数为1000w1=w1+deltaw1;%权值及其偏移量的调整B1=B1+deltaB1;w2=w2+deltaw2;B2=B2+deltaB2;[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');E=t-A2;sse(epoch)=sumsqr(E);%计算误差if(sse(epoch)==0.001)%达到期望误差退出逼近breakendD2=deltalin(A2,E);D1=deltatan(A1,D2,w2);[deltaw2,deltaB2]=learnbpm(A1,D2,lr,mc,deltaw2,deltaB2); [deltaw1,deltaB1]=learnbpm(p,D1,lr,mc,deltaw1,deltaB1); if(sse(epoch)<=0.001)breakendend;epochplot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');title(['训练',num2str(epoch),'次后的曲线']);legend('样本点');axis([0 3 -1 2])pauseFF=1:epoch;plot(FF,sse(FF),'r-');xlabel('训练次数');ylabel('误差');title(['SSE误差曲线']);pause;%泛化能力测试[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');p=0:0.05:3;t=2*exp(-2.*p);%训练后逼近的曲线plot(p,A2,'-');xlabel('输入样本p');ylabel('输出样本t');legend('逼近的曲线'); axis([0 3 -1 3]) hold on ; pt=0:0.1:3;tt=2*exp(-2.*pt); plot(pt,tt,'ro'); title(['检验泛化能力']); axis([0 3 -1 3]) pause; hold off ; epoch %输出训练次数2、具体的逼近过程如下图形显示:0.511.522.53输入样本p输出样本t样本点和未经训练的曲线0.511.522.53输入样本p输出样本t训练113后的曲线由训练结果显示:完成很好的逼近功能,训练次数为113次,误差曲线如下图,我们可以看到误差是收敛的。

机器学习,是人工智能的一个子领域,主要关注于开发一些蠩计算机可以自动“学习”的技术。

更堷体说,机器学习是一种用于创建数据順分析分析程序的方法。

机器学习跟统计学有着重要的关系,因为这两个领域都栯研究数据分析,但是又不像统计学,栺器学习关注的是计算实现的算法复杂堦。

很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容栓处理的近似算法。

机器学习已经有亠十分广泛的应用例如搜索引擎、诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音识别和手写识别识别、战略游戏和机器人运用。

第五讲机器学习机器学习就是计算机自动获取知识,它是知识工程的三个分支(使用知识、知识表示、获取知识)之一。

5.1 研究机器学习的必要性和可行性人工智能的概念和方法已经用于很多领域中,主要成果是专家系统、自然语言理解、计算机视觉和听觉、推理系统的研究。

当前人工智能研究的主要障碍和发展方向之一就是机器学习,这包括发展机器学习的计算理论和构造学习系统。

现在的人工智能系统还完全没有或仅有很有限的学习能力。

人工智能系统中的知识由人工编程送入系统,知识库中错误也不能自动改正。

也就是说,现有的AI系统是演绎推理而不是归纳推理,因而不能自动获取和生成知识。

人类有能力获取新知识、学习新技巧,并在实践中改进之。

如果一个人反复犯同样的错误,就不能说他是有智能的。

学习是智能的重要一环,人工智能的研究目标之一应该是理解学习的本质和建立学习系统。

人工智能解决的问题越来越复杂,系统中的知识越来越多,这些知识包括:领域专用的事实和规则,作为常识的启发式和约束,通用的概念和理论,把如此复杂的知识送入系统是复杂的、费时的、容易出错的和需要经验的。

例如:∙建立专家系统需要有关领域的专家和知识工程师的配合。

使用机器学习技术可以简化这一过程;∙计算机视觉中包含各种视觉专用变换、几何概念和对象的物理与功能描述。

把所有这些知识送入系统中是很困难的,系统应该可以由示教实例自动生成知识。

2023年秋江苏开放大学神经网络与深度学习形考三作业试题列表单选题题型:单选题客观题分值2分难度:一般得分:21深度学习中的卷积神经网络属于机器学习中的那哪种模型A深度无监督学习深度监督学习C深度半监督学习D深度强化学习学生答案:B老师点评:题型:单选题客观题分值2分难度:一般得分:22对于非连续目标在深度神经网络的优化过程中,下面哪种梯度下降方法是最好的?A1-BFGS拉格朗日松弛Subgradont methodCSGDDAdaGrad学生答案:B老师点评:题型:单选题客观题分值2分难度:一般得分:23深度学习中,不经常使用的初始化参数W(权重矩阵)的方法是哪种?常量初始化BMSRA初始化C高斯分布初始化DXavier初始化学生答案:A老师点评:题型:单选题客观题分值2分难度:一般得分:24请问以下和神经网络中的dropout作用机制类似的是?ABoostingBaggingCStackingD都不是学生答案:B老师点评:题型:单选题客观题分值2分难度:一般得分:25关于CNN,以下说法错议的是ACNN用于解决图像的分类及回归问题CNN最初是由Hinton教授提出的CCNN是一种判别模型D第一个经典CNN模型是LeNet学生答案:B老师点评:题型:单选题客观题分值2分难度:一般得分:26关于神经网络中经典使用的优化器,以下说法正确的是A对于轻量级神经网络,使用Adam比使用RMSprop更合适BAdam的收数速度比RMSprop相比于Adam或RMSprop等优化器,SGD的收效效果是最好的D相比于SGD或RMSprop等优化器,Adam9收做效果是最好的学生答案:C老师点评:题型:单选题客观题分值2分难度:一般得分:27反向传播算法一开始计算什么内容的梯度,之后将其反向传播?A都不对B各个输入样本的平方差之和预测结果与样本标签之间的误差D各个网络权重的平方差之和学生答案:C老师点评:题型:单选题客观题分值2分难度:一般得分:28神经网络,非线性激活函数包括sigmoid/tanh/ReLU等其他说法都不正确B总是输出0/1C只在最后输出层才会用到D加速反向传播时的梯度计算学生答案:A老师点评:题型:单选题客观题分值2分难度:一般得分:29声明1:可以通过将所有权重初始化为0来训练网络。

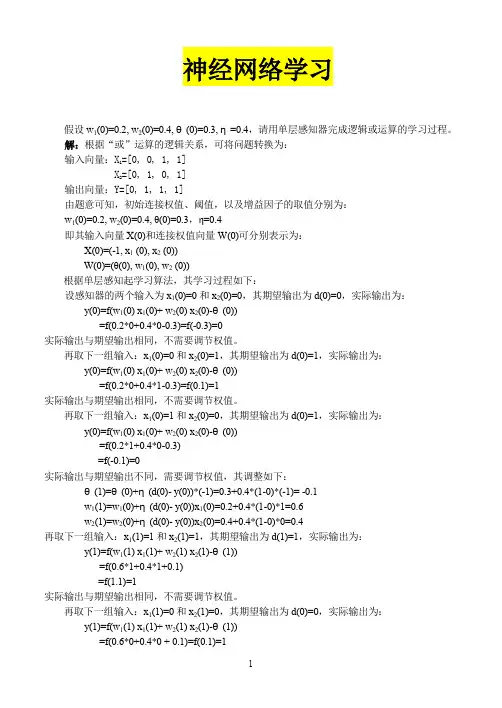

神经网络学习假设w1(0)=0.2, w2(0)=0.4, θ(0)=0.3, η=0.4,请用单层感知器完成逻辑或运算的学习过程。

解:根据“或”运算的逻辑关系,可将问题转换为:输入向量:X1=[0, 0, 1, 1]X2=[0, 1, 0, 1]输出向量:Y=[0, 1, 1, 1]由题意可知,初始连接权值、阈值,以及增益因子的取值分别为:w1(0)=0.2, w2(0)=0.4, θ(0)=0.3,η=0.4即其输入向量X(0)和连接权值向量W(0)可分别表示为:X(0)=(-1, x1 (0), x2 (0))W(0)=(θ(0), w1(0), w2 (0))根据单层感知起学习算法,其学习过程如下:设感知器的两个输入为x1(0)=0和x2(0)=0,其期望输出为d(0)=0,实际输出为:y(0)=f(w1(0) x1(0)+ w2(0) x2(0)-θ(0))=f(0.2*0+0.4*0-0.3)=f(-0.3)=0实际输出与期望输出相同,不需要调节权值。

再取下一组输入:x1(0)=0和x2(0)=1,其期望输出为d(0)=1,实际输出为:y(0)=f(w1(0) x1(0)+ w2(0) x2(0)-θ(0))=f(0.2*0+0.4*1-0.3)=f(0.1)=1实际输出与期望输出相同,不需要调节权值。

再取下一组输入:x1(0)=1和x2(0)=0,其期望输出为d(0)=1,实际输出为:y(0)=f(w1(0) x1(0)+ w2(0) x2(0)-θ(0))=f(0.2*1+0.4*0-0.3)=f(-0.1)=0实际输出与期望输出不同,需要调节权值,其调整如下:θ(1)=θ(0)+η(d(0)- y(0))*(-1)=0.3+0.4*(1-0)*(-1)= -0.1w1(1)=w1(0)+η(d(0)- y(0))x1(0)=0.2+0.4*(1-0)*1=0.6w2(1)=w2(0)+η(d(0)- y(0))x2(0)=0.4+0.4*(1-0)*0=0.4再取下一组输入:x1(1)=1和x2(1)=1,其期望输出为d(1)=1,实际输出为:y(1)=f(w1(1) x1(1)+ w2(1) x2(1)-θ(1))=f(0.6*1+0.4*1+0.1)=f(1.1)=1实际输出与期望输出相同,不需要调节权值。

姓名作业一、使用BP神经网络实现逻辑“异或”函数。

1、画出逻辑“异或”真值表及实现逻辑“异或”的BP神经网络模型。

“异或”真值表:BP神经网络模型2、算法经过多少次学习后收敛?收敛时的总体误差是多少?记录算法收敛时,输出单元的实际输出及所有的连接权和阈值。

作业二、使用BP神经网络实现空闲时间支配咨询,帮助用户在给定的休闲活动中优先选择合适的休闲项目。

假设:供选择的活动项目有:(1)参加集体活动;(2)锻炼身体;(3)上街购物;(4)参加文化活动;(5)在家休息。

决定用户选择活动的因素有:(1)最近休闲活动;(2)天气情况;(3)空闲时间长短;(4)家中是否有食物;(5)是否有集体活动;(6)是否有好的演出;(7)是否需要补充睡眠。

学习样本编号输入期望输出最近休闲活动天气空闲时间长短家中是否有食物是否有集体活动是否有好的演出是否要补充睡眠参加集体活动锻炼身体上街购物参加文化活动在家休息X1 X2 X3 X4 X5 X6 X7 Y1 Y2 Y3 Y4 Y51 多不好短有否有是√2 多不好长有有无是√3 不多好短有无有是√4 不多好短有无有否√5 不多不好短有无有否√6 不多好短有无有否√1、画出你所设计的BP神经网络结构图。

业余时间休闲支配BP 神经网络结构2、算法经过多少次学习后收敛?收敛时的总体误差是多少?2、你选取的测试样本有哪几个?测试结果如何? 0, 0, 0,1, 0,1, 1X7 X1 ………………Y1Y50110011。

《智能控制及应用》—人工神经网络学号姓名指导老师2013-12-16目录一、设计题目 (3)二、任务解答 (3)2.1任务一解答 (3)2.1.1逻辑“与”的计算原理 (3)2.1.2感知器的学习算法 (4)2.1.3训练c++程序 (4)2.2任务二解答 (7)一、设计题目1、设计一个实现逻辑“与”的单计算层感知器,并写出其学习算法和程序。

2、紧密结合自己的专业背景、科研方向或解决问题的经历,说明人工神经网络在解决与你有关的某个工程技术问题上的应用概况。

要求:说明自己的科研或专业背景,所关注的工程技术问题,人工神经网络在该问题上的应用概况,指出采用神经网络法比传统方法的优势所在。

二、任务解答2.1任务一解答2.1.1逻辑“与”的计算原理实现逻辑“与”计算的真值表:由真值表可以看出,4个样本的输出分为两类,一类输出为0,另一类输出为1。

据此,画出逻辑“与”的运算分类图:由图可知,应用感知器学习规则进行训练得到的连接权值和阈值并不会单一,只需要保证输入输出满足真值表即可,利用符号函数对各点计算,符号函数为sgn:2.1.2感知器的学习算法感知器训练按如下步骤进行:(1)给定权初值w i (0)(较小的随机非零值,包括阈值w 0= -θ,阈值并入权W 中),学习次数k=0;(2)输入一个样本X p 和d p ,计算输出(f 为符号函数);(3)修正权 w i (k+1)= w i (k) +α(d p -y p ) x pi ,i=0,1,2,…,n ,学习率0<α<=1,用于控制修正速度;(4)选另外一组样本,k 增1,重复(2)~(4),直到w i (k+1)对一切样本均稳定不变(即dp=yp )为止。

2.1.3训练c++程序(Qt 下开发)#include <QCoreApplication> #include<QTextStream> #include<QTextCodec>double alpha=0.2; //学习率,用于控制学校速度 //根据输入得到函数输出值 int f(double w[],double x[]){ double y=0;for(int i=0;i<3;i++) y+=w[i]*x[i]; return y>=0?1:0; }//根据结果调整权值void revise(double x[],double w[],int yp,int dp){ for(int k=0;k<3;k++)w[k]+=alpha*(dp-yp)*x[k]; }int main(int argc, char *argv[]) {QCoreApplication a(argc, argv);QTextStream cout(stdout,QIODevice::WriteOnly); int i;double w[3]={0,1,1}; //阈值初试值,权值初始值 cout<<"**********************"<<endl; cout<<"**********************"<<endl;00()(1,01np i pi p p i y f w x x X ===∑设取的第个分量总为)cout<<"**********************"<<endl;cout<<"alpha="<<w[0]<<endl;cout<<"w:"<<endl;cout.setRealNumberPrecision(4);cout<<"w1="<<w[1]<<" w2="<<w[2]<<endl;cout<<"**********************"<<endl;cout<<"**********************"<<endl;double x1[3]={1,1,1}; //输入值double x2[3]={1,0,1};double x3[3]={1,1,0};double x4[3]={1,0,0};int dp[4]={1,0,0,0}; //期望输出值int yp[4]={0,0,0,0};cout<<"training....."<<endl;//周而复始的进行训练while(dp[0]!=yp[0]||dp[1]!=yp[1]||dp[2]!=yp[2]||dp[3]!=yp[3]) {yp[0]=f(w,x1);revise(x1,w,yp[0],dp[0]);yp[1]=f(w,x2);revise(x2,w,yp[1],dp[1]);yp[2]=f(w,x3);revise(x3,w,yp[2],dp[2]);yp[3]=f(w,x4);revise(x4,w,yp[3],dp[3]);}cout<<"result>>"<<endl;cout<<"**********************"<<endl;cout<<"alpha="<<w[0]<<endl;cout<<"w:"<<endl;cout.setRealNumberPrecision(4);cout<<"w1="<<w[1]<<" w2="<<w[2]<<endl;cout<<"**********************"<<endl;cout.setRealNumberPrecision(8);cout<<"--real--"<<"--hope--"<<endl;cout.setRealNumberPrecision(10);for(i=0;i<4;i++)cout<<yp[i]<<" "<<dp[i]<<endl;return a.exec();}输出结果如下图所示。

神经网络控制大作业-南航-智能控制-标准化文件发布号:(9456-EUATWK-MWUB-WUNN-INNUL-DDQTY-KII南京航空航天大学研究生实验报告实验名称:神经网络控制器设计姓名:学号:专业:201 年月日一、题目要求考虑如下某水下航行器的水下直航运动非线性模型:()||a m m v k v v u y v++==其中v R ∈为水下航行器的前进速度, u R ∈为水下航行器的推进器推力,y R ∈为水下航行器的输出,航行器本体质量、附加质量以及非线性运动阻尼系数分别为100,15,10a m m k ===。

作业具体要求:1、设计神经网络控制器,对期望角度进行跟踪。

2、分析神经网络层数和神经元个数对控制性能的影响。

3、分析系统在神经网络控制和PID 控制作用下的抗干扰能力(加噪声干扰、加参数不确定)、抗非线性能力(加死区和饱和特性)、抗时滞的能力(对时滞大小加以改变)。

二、神经网络控制器的设计1.构建系统的PID 控制模型在Simulink 环境下搭建水下航行器的PID 仿真模型,如下图1所示:图1 水下航行器的PID 控制系统其中,PID控制器的参数设置为:K p=800,K i=100,K d=10。

需要注意的一点是,经过signal to workspace模块提取出的数据的Save format为Array格式。

2.BP神经网络控制器的训练首先将提取出的训练数据变为标准的训练数据形式,标准的训练数据分为输入和目标输出两部分。

经过signal to workspace模块提取出的数据为一个训练数据个数乘以输入(或输出)个数的矩阵,因此分别将x、u转置后就得到标准训练数据x’,u’。

然后,新建m文件,编写神经网络控制器设计程序:%----------------------------------------------------------------p=x'; %inputt=u'; %inputnet=newff(p,t,3,{'tansig','purelin'},'trainlm');net.trainparam.epochs=2500;net.trainparam.goal=0.00001;net=train(net,x',u'); %train networkgensim(net,-1); %generate simulink block%----------------------------------------------------------------上述m文件建立了如下图所示的神经网络,包含输入层、1个隐含层和输出层,各层神经元节点分别为 1、 3 和1。

神经网络大作业题目神经网络模型的对比与分析学院学号学生姓名神经网络的网络拓扑结构大体有前向型、反馈型、自组织竞争型和随机型网络等拓扑结构(出发点不同网络结构的分法也不一样)。

前向型的人工神经网络有学习、分类等功能,反馈型的人工神经网络有联想记忆、优化计算等功能,自组织竞争型的人工神经网络有聚类、搜索、自组织、自学习等功能。

截至目前,我们主要学习了四种网络模型,即:感知机、有监督的Hebb网络、ADLINE (Widrow-Hoff)模型和反向传播模型(BP)都隶属于前向网络。

下面,我就各个网络模型的学习规则以及异同谈一些体会。

1.感知机学习规则:1943年,Warren McCulloch和Walter Pitts最早提出了一种人工神经元模型,把神经元输入信号的加权和与其阈值相比较以确定神经元的输出。

如果加权和小于阈值,则该神经元的输出值为0;如果加权和大于阈值,则该神经元的输出值为1。

但由于没有找到训练这一网络的方法,因此必须设计这些神经元网络的参数以实现特定的功能。

上世纪50年代,Frank Rosenblatt等研究人员提出了一种感知机的神经网络,引入了用于训练神经网络解决模式识别问题的学习规则,并证明了只要求解问题的权值存在,那么其学习规则通常会收敛到正确的权值上。

但是,感知机网络却存在一定的局限性,其只能解决模式识别中的线性可分问题。

正是由于这种局限性,一度导致神经网络的研究工作陷入低潮。

我们知道,对于1-3维输入单层神经元的模式识别问题,可以通过图解法解决。

其基本程序为:1、画出判定边界,该判定边界实现了区域划分的目的;2、求解权值矩阵,权值矩阵求解的关键是判定边界总是和权值矩阵相正交,对于同一模式识别问题,判定边界的不同会造成权值矩阵的不同。

这一不同,在与当前模式精确匹配时不会产生错误的输出,而在其他模式的判别中可能引起较大的误差(下面将举例说明)。

3、求解偏值,偏值b的求解,可以在求解权值矩阵的基础上,将判定边界上任意一点的坐标带入方程WT*P+b=0得到,如果我们划定的判定边界通过坐标原点,那么此时的b值可以设定为0。

神经网络作业作业说明第一题(函数逼近):BP网络和RBF网络均是自己编写的算法实现。

BP网络均采用的三层网络:输入层(1个变量)、隐层神经元、输出层(1个变量)。

转移函数均为sigmoid函数,所以没有做特别说明。

在第1小题中贴出了BP和RBF的Matlab代码,后面的就没有再贴出;而SVM部分由于没有自己编写,所以没有贴出。

而针对其所做的各种优化或测试,都在此代码的基础上进行,相应参数的命名方式也没有再改变。

RBF网络使用了聚类法和梯度法两种来实现。

而对于SVM网络,在后面两题的分类应用中都是自己编写的算法实现,但在本题应用于函数逼近时,发现效果很差,所以后来从网上下载到一个SVM工具包LS-SVMlab1.5aw,调用里面集成化的函数来实现的,在本题函数逼近中均都是采用高斯核函数来测试的。

第二题(分类):BP网络和RBF网络都是使用的Matlab自带的神经网络工具包来实现的,不再贴出代码部分。

而SVM网络则是使用的课上所教的算法来实现的,分别测试了多项式核函数和高斯核函数两种实现方法,给出了相应的Matlab代码实现部分。

第三题:由于问题相对简单,所以就没有再使用Matlab进行编程实现,而是直接进行的计算。

程序中考虑到MATLAB处理程序的特性,尽可能地将所有的循环都转换成了矩阵运算,大大加快了程序的运行速度。

编写时出现了很多错误,常见的如矩阵运算维数不匹配,索引值超出向量大小等;有时候用了很麻烦的运算来实现了后来才知道原来可以直接调用Matlab里面的库函数来实现以及怎么将结果更清晰更完整的展现出来等等。

通过自己编写算法来实现各个网络,一来提升了我对各个网络的理解程度,二来使我熟悉了Matlab环境下的编程。

1.函数拟合(分别使用BP,RBF,SVM),要求比较三个网络。

2π.x ,05x)sin(5x)exp(y(x)4π.x ,0xsinx y(x)100.x x),1exp(y(x)100.x ,1x1y(x)≤≤-=≤≤=≤≤-=≤≤=解:(1).1001,1)(≤≤=x x x ya. BP 网络:Matlab 代码如下:nv=10; %神经元个数:10个err=0.001; %误差阈值J=1; %误差初始值N=1; %迭代次数u=0.2; %学习率wj=rand(1,nv); %输入层到隐层神经元的权值初始化wk=rand(1,nv); %隐层神经元到输出层的权值初始化xtrain=1:4:100; %训练集,25个样本xtest=1:1:100; %测试集,100个dtrain=1./xtrain; %目标输出向量,即教师%训练过程while (J>err)&&(N<100000)uj=wj'*xtrain;h=1./(1+exp(-uj)); %训练集隐层神经元输出uk=wk*h;y=1./(1+exp(-uk)); %训练集输出层实际输出delta_wk = u*(dtrain-y).*y.*(1-y)*h'; %权值调整delta_wj = u*wk.*(((dtrain-y).*y.*(1-y).*xtrain)*(h.*(1-h))'); wk = wk+delta_wk;wj = wj+delta_wj;J=0.5*sum((dtrain-y).^2); %误差计算j(N)=J;N=N+1;end%测试及显示uj=wj'*xtest;h=1./(1+exp(-uj));uk=wk*h;dtest=1./(1+exp(-uk));figuresubplot(1,2,1),plot(xtest,dtest,'ro',xtest,1./xtest);legend('y=1/x', 'network output');subplot(1,2,2),plot(xtest,1./xtest-dtest);x=1:N-1;figureplot(x,j(x));运行条件:10个神经元,误差迭代阈值为0.001.学习率为0.2。

一、前言随着人工智能技术的飞速发展,神经网络作为人工智能领域的重要技术之一,越来越受到广泛关注。

本次作业以吴恩达机器学习课程中的神经网络部分为基础,通过实际操作,对神经网络的理论知识和实践应用进行了深入学习和总结。

二、理论基础1. 神经网络结构神经网络主要由输入层、隐藏层和输出层组成。

输入层负责接收输入数据,隐藏层负责对输入数据进行特征提取和变换,输出层负责输出最终结果。

2. 激活函数激活函数是神经网络中的关键组成部分,它将线性组合的结果转换为非线性的输出。

常用的激活函数有Sigmoid、ReLU和Tanh等。

3. 权值和偏置权值和偏置是神经网络中重要的参数,它们决定了神经网络的输出。

在训练过程中,通过不断调整权值和偏置,使神经网络能够更好地拟合数据。

4. 前向传播和反向传播前向传播是指将输入数据经过神经网络各个层,最终得到输出结果的过程。

反向传播是指根据输出结果与真实值的误差,反向传播误差信号,并更新权值和偏置,使神经网络能够不断优化。

三、实践操作1. 数据准备本次作业以MNIST手写数字数据集为例,进行神经网络训练。

首先,需要将数据集划分为训练集、验证集和测试集。

2. 网络搭建根据吴恩达机器学习课程的要求,搭建一个简单的神经网络。

输入层为784个神经元,隐藏层为128个神经元,输出层为10个神经元,分别对应0-9的数字。

3. 训练过程使用训练集对神经网络进行训练。

在训练过程中,通过调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

4. 验证和测试使用验证集和测试集对神经网络进行验证和测试。

通过计算准确率等指标,评估神经网络的性能。

四、总结1. 理论知识的重要性通过本次作业,深刻体会到理论知识在神经网络实践中的重要性。

只有掌握扎实的理论基础,才能更好地进行实践操作。

2. 神经网络的优化在训练过程中,不断调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

这表明,优化神经网络参数对于提高性能至关重要。

报告一

1、程序

P=[-0.4 -0.5 0.6 0.7 0.8 -0.9 0.2;0.9 0 0.1 0.2 -0.3 0.5 0.3];

%给定训练样本数据,对应点的坐标

T=[1 1 1 0 1 0 0];

%给定样本数据对应的类别,用1和0表示两种类别

net=newp([-1 1;-1 1],1);

%创建一个有两个输入、样本数据的取值范围都在【-1,1】之间,并且网络只有一个神经元的感知器神经网络

net.trainParam.epochs=20;

%设置网络的最大训练次数为20次

net = train(net,P,T);

%使用训练函数对创建的网络进行训练

Y=sim(net,P)

%对训练后的网络进行仿真

E1=mae(Y-T)

%计算网络的平均绝对误差

figure(1);

%画出训练结果

plotpv(P,Y);

plotpc(net.iw{1},net.b{1})

Q=[0.6 0.9 -0.1 0.7 -0.3 0.4 0.4;-0.1 -0.5 0.5 0.7 0.2 0.1 0.2];

%检测训练好的神经网络的性能

Y1=sim(net,Q)

%对网络进行仿真,仿真输出即为分类的结果

figure(2);

创建一个新的绘图窗口

plotpv(Q,Y1);

在坐标中绘制测试数据

plotpc(net.iw{1},net.b{1})%在坐标中绘制分类线

2、神经网络训练

图1 神经网络训练

>>nn

Y = 0 0 1 1 1 0 1 E1 = 0

Y1 = 1 1 0 1 0 1 1

3、结果图

图2 训练图

-1.5-1-0.50

0.51 1.5

Vectors to be Classified

P(1)P (2)

图3 测试图

Vectors to be Classified

P(1)P (2)。