云计算Mapreduce简介

- 格式:ppt

- 大小:239.50 KB

- 文档页数:14

运用实例简述mapreduce原理MapReduce是一种编程模型和模型化的方法,用于大规模数据集(如分布式文件系统)的并行处理。

它通常用于处理和转换大数据集,以进行数据挖掘、机器学习、数据库等领域的应用。

MapReduce原理的核心思想是将一个复杂的问题拆解成多个小问题,然后将小问题分配给多个处理器(可以是多个计算机或处理器),最后将处理结果汇总并生成最终结果。

这个过程主要包括两个阶段:Map阶段和Reduce阶段。

1.Map阶段:Map阶段的任务是将输入数据集分解为多个小的数据块,并对每个数据块进行处理,生成中间结果。

这个过程通常是一个用户定义的函数,它接受输入数据块并产生一组键-值对。

这些键-值对随后被合并并发送到Reduce阶段。

举个例子,假设我们要对一个大规模的文本文件进行词频统计。

Map阶段会将文本文件分解为单词,并对每个单词生成一个键值对(键为单词,值为该单词在文本中出现的次数)。

2.Reduce阶段:Reduce阶段的任务是将Map阶段产生的中间结果进行汇总,并执行用户定义的Reduce函数,对汇总后的键值对进行处理并生成最终结果。

Reduce函数通常也是用户自定义的函数,它接受一组键值对并产生一个输出结果。

同样以词频统计为例,Reduce阶段会对所有相同的单词进行计数,并将结果输出为一个新的文本文件,其中包含每个单词及其对应的频数。

MapReduce原理的优势在于它能够充分利用多台计算机或处理器的计算资源,实现大规模数据的并行处理。

同时,MapReduce还提供了简单易用的编程接口,使得用户可以轻松地处理大规模数据集。

在实际应用中,MapReduce已被广泛应用于各种领域,如数据挖掘、机器学习、数据库等。

通过MapReduce,我们可以轻松地处理和分析大规模数据集,从而获得更有价值的信息和知识。

需要注意的是,MapReduce原理并不是适用于所有类型的大规模数据处理任务。

对于一些特定的任务,可能需要使用其他类型的并行处理模型和方法。

MapReduce数据处理原理1. 概述MapReduce是一种用于大规模数据处理的编程模型,由Google首先提出并应用于分布式计算中。

它通过将大规模数据集划分为小的子集,并在多个计算节点上同时进行处理,从而实现高效的数据处理。

MapReduce的核心思想是将复杂的数据处理任务分解成简单的、可并行执行的任务。

2. 基本原理MapReduce模型基于两个基本操作:Map和Reduce。

下面将详细介绍这两个操作以及它们在数据处理中的作用。

2.1 Map操作Map操作是将输入数据集中的每个元素进行转换,并生成一个键值对集合作为输出。

具体来说,Map操作接受一个键值对作为输入,经过转换后输出一个新的键值对。

在Map操作中,用户需要自定义一个Map函数,该函数接受输入键值对作为参数,并根据具体需求进行转换操作。

在词频统计任务中,用户可以定义一个Map函数来将输入文本切分成单词,并为每个单词生成一个键值对(单词,1)。

2.2 Reduce操作Reduce操作是将经过Map操作后生成的键值对集合按照键进行分组,并对每个组进行聚合计算。

具体来说,Reduce操作接受一个键和与该键相关联的一组值作为输入,经过聚合计算后输出一个新的键值对。

在Reduce操作中,用户需要自定义一个Reduce函数,该函数接受输入键和与之相关联的值集合作为参数,并根据具体需求进行聚合计算。

在词频统计任务中,用户可以定义一个Reduce函数来对每个单词出现的次数进行累加。

2.3 数据流MapReduce模型通过Map和Reduce操作将数据流划分为三个阶段:输入阶段、中间阶段和输出阶段。

在输入阶段,原始数据集被划分成多个小的数据块,并分配给不同的计算节点进行处理。

每个计算节点上的Map操作并行处理自己分配到的数据块,并生成中间结果。

在中间阶段,所有计算节点上生成的中间结果被按照键进行分组,相同键的结果被发送到同一个Reduce操作所在的计算节点。

mapreduce的工作原理

MapReduce 是一种在大型数据集上分布式运行计算的编程模型和算法。

其工作原理主要分为两个步骤:Map 和Reduce。

1. Map 阶段:

Map 阶段是指将输入数据分成若干个小数据块,然后对每个数据块分别应用一个Map 函数,将数据块转换成一个键值对列表。

这个键值对列表中的键是某种描述符,值是包含着这个描述符的数据。

这个Map 函数可以并行运行,也就是可以在不同计算节点上同时运行。

2. Reduce 阶段:

Reduce 阶段是指将Map 阶段产生的若干键值对列表按照键进行排序,并将相同键的值进行聚合。

Reduce 函数通常与Map 函数位于不同的计算节点上,并且对每个不同的键值对列表,Reduce 函数只会在一个节点上执行。

Reduce 函数对键值对进行聚合,并生成一个输出键值对列表,其中输出键的数量通常比输入键的数量少。

整个MapReduce 过程的主要思想是将整个数据集的处理过程拆分成多个小的子过程,并在分布式计算节点中进行并行处理,最后将所有子过程的结果合并

成最终的输出结果。

这样就可以有效地处理大量数据,缩短计算时间和提高计算效率。

Map、Reduce是什么Python中的map和reduce如果我们把MapReduce拆开看,就是两个单词map和reduce。

在本书中,map翻译为“映射”,reduce翻译为“归约”。

这两个单词在有的编程语言中属于内置的两个函数。

我们以Python语言举例,该语言中map、reduce属于内置函数。

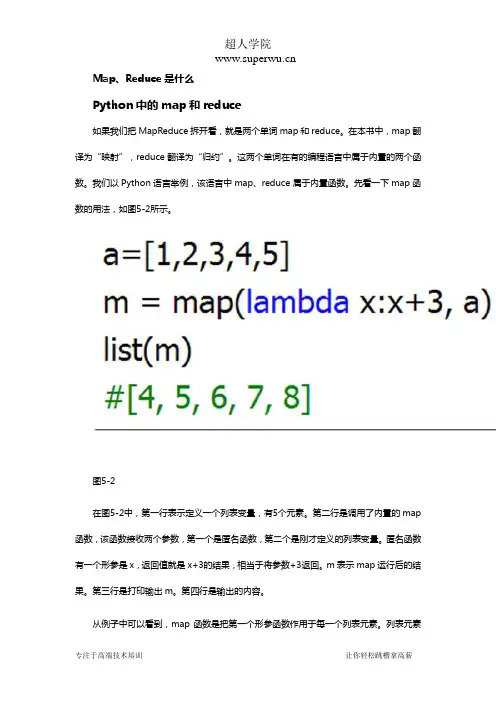

先看一下map函数的用法,如图5-2所示。

图5-2在图5-2中,第一行表示定义一个列表变量,有5个元素。

第二行是调用了内置的map 函数,该函数接收两个参数,第一个是匿名函数,第二个是刚才定义的列表变量。

匿名函数有一个形参是x,返回值就是x+3的结果,相当于将参数+3返回。

m表示map运行后的结果。

第三行是打印输出m。

第四行是输出的内容。

从例子中可以看到,map函数是把第一个形参函数作用于每一个列表元素。

列表元素有5个,那么匿名函数就会被调用5次,每次调用把元素作为匿名函数的形参传入,最终结果是还是含有5个元素的列表。

下面再看一下reduce函数,如图5-3所示。

图5-3在图5-3中,第一句是加载函数所在的包,类似于java中的import语句。

第二句是定义一个含有5个元素的列表变量。

第三句是调用reduce函数。

这个函数与map函数类似,也是接收两个参数,第一个参数是定义的匿名函数,第二个参数是刚才定义的列表变量。

匿名函数有两个形参x和y,返回值就是x+y运算的结果,s表示运算后的结果。

第四行语句表示打印输出s。

第五行是输出的结果。

从例子中可以看出,匿名函数的形参有两个,分别是x和y,取值来自于第二个形参a 中的每个元素。

通过匿名函数对a中的元素进行聚合,把5个元素通过加法运算聚合成一个结果。

这就是reduce函数。

注意:以上是函数式语言Python的语法,允许函数作为函数的形参,这在java中是不允许的。

读者对此不必过分关心,只需要知道map、reduce函数在其他语言中也是存在的,并不是Hadoop的专利。

MapReduce(分布式计算框架)MapReduce是⼀种计算模型,⽤于处理⼤数据量的计算,其计算过程可以分为两个阶段(实质上是三个阶段),即Map和Reduce.图2-3-1:MapReduce执⾏步骤其中Map将输⼊的原始数据集转化为Key-Value(键-值对),拆分给不同节点并⾏进⾏指定的计算操作(例如排序、聚集),形成中间结果,这个计算操作的过程称为Map shuffle;Reduce则并⾏地对⽣成的中间结果中相同的Key的所有Value进⾏规约合并汇总处理后,输出新的Key-Value得到最终结果,这个处理相同Key的过程称为Reduce shuffle. 可以看出,在Map和Reduce中间,其实还有⼀个过程,就是对Map的输出进⾏整理并交给Reduce,这个过程就是shuffle. Map和Reduce操作需要我们⾃⼰定义相应的Map类和Reduce类,⽽shuffle则是系统⾃动帮我们实现的。

简单点理解,可以将Map看作是拆分数据集给不同的节点进⾏并⾏计算操作,将Reduce看作是整合每个节点的计算结果以汇总出最终结果(即Map负责分的计算,Reduce负责合的计算)。

图2-3-2:MapReduce⼯作原理1. JobTracker和TaskTrackerMapReduce由两种主要的后台程序运⾏:JobTracker和TaskTracker.(1) JobTrackerJobTracker是master节点,⼀个集群中只有⼀个,负责管理所有作业、任务/作业的监控及错误处理等,并将任务分解成⼀系列任务,分派给TaskTracker.(2) TaskTrackerTaskTracker是slave节点,负责运⾏Map Task和Reduce Task,并通过周期性的⼼跳与JobTracker交互,通知JobTracker其当前的健康状态,每⼀次⼼跳包含了可⽤的Map和Reduce任务数⽬、占⽤的数⽬以及运⾏中的任务详细信息。

mapreduce的介绍及工作流程MapReduce是一种用于大规模数据处理的编程模型和计算框架。

它可以有效地处理大规模数据集,提供了分布式计算的能力,以及自动化的数据分片、任务调度和容错机制。

本文将介绍MapReduce的基本概念、工作流程以及其在大数据处理中的应用。

一、MapReduce的基本概念MapReduce的基本概念分为两个部分:Map和Reduce。

Map用于对输入数据进行初步处理,将输入数据分解成若干个<key, value>对。

Reduce则对Map的输出进行聚合操作,生成最终的结果。

MapReduce的输入数据通常是一个大型数据集,可以是文件、数据库中的表或者其他形式的数据源。

输入数据被划分为若干个数据块,每个数据块由一个Map任务处理。

Map任务将输入数据块转化为若干个中间结果,每个中间结果都是一个<key, value>对。

Reduce任务负责对Map任务的输出进行进一步处理,将具有相同key的中间结果进行聚合操作,生成最终的结果。

Reduce任务的输出结果通常是一个<key, value>对的集合。

二、MapReduce的工作流程MapReduce的工作流程可以简单概括为以下几个步骤:输入数据的划分、Map任务的执行、中间结果的合并与排序、Reduce任务的执行、最终结果的输出。

1. 输入数据的划分:输入数据被划分成若干个数据块,在分布式环境下,每个数据块都会被分配到不同的节点上进行处理。

数据块的大小通常由系统自动设置,以保证每个Map任务的负载均衡。

2. Map任务的执行:每个Map任务独立地处理一个数据块,将输入数据转化为若干个中间结果。

Map任务可以并行执行,每个任务都在独立的节点上运行。

Map任务的输出中间结果被存储在本地磁盘上。

3. 中间结果的合并与排序:Map任务输出的中间结果需要在Reduce任务执行之前进行合并和排序。

mapreduce例题摘要:1.MapReduce 简介2.MapReduce 的组成3.MapReduce 的工作原理4.WordCount 案例介绍5.MapReduce 的优缺点正文:一、MapReduce 简介MapReduce 是一种编程模型,用于大规模数据处理。

它最初由Google 开发,后来被Apache Hadoop 项目采用。

MapReduce 模型将数据处理分为两个阶段:Map 阶段和Reduce 阶段。

这个模型通过将数据切分为多个块,然后在这些块上并行处理,最后将结果进行汇总,从而实现高效的数据处理。

二、MapReduce 的组成MapReduce 由两个主要组件组成:Map 和Reduce。

1.Map:Map 阶段负责对输入数据进行切分和处理。

在Map 阶段,数据被切分成多个块,每个块由一个Mapper 处理。

Mapper 对每个块内的数据进行处理,将处理后的数据输出到一个中间结果文件中。

2.Reduce:Reduce 阶段负责对Map 阶段产生的中间结果进行汇总和处理。

在Reduce 阶段,所有Map 阶段产生的中间结果文件会被传输到Reduce 任务所在的节点。

Reduce 任务会对这些中间结果文件进行处理,将处理后的结果输出到一个最终结果文件中。

三、MapReduce 的工作原理MapReduce 的工作原理可以概括为以下几个步骤:1.分割输入数据:将输入数据切分成多个块,以便在多个节点上并行处理。

2.Map 处理:在每个节点上,使用Mapper 对输入数据块进行处理,并输出一个中间结果文件。

3.数据传输:将Map 阶段产生的中间结果文件传输到Reduce 任务所在的节点。

4.Reduce 处理:在Reduce 任务所在的节点上,使用Reduce 函数对所有中间结果文件进行处理,并输出一个最终结果文件。

5.结果返回:将最终结果文件返回给用户。

四、WordCount 案例介绍WordCount 是MapReduce 的一个经典案例,用于统计文本中单词出现的次数。

MapReduce名词解释

MapReduce是一种用于并行处理大规模数据的编程模型和算法。

它采用了分布式计算的思想,将数据分成若干个小块,然后分配给不同的计算节点进行处理。

MapReduce包括两个主要阶段:Map(映射)和Reduce(归约)。

在Map阶段,输入的数据会被拆分成一个个的键值对,并由多个Map任务并行处理。

每个Map任务会对输入的键值对进行处理,并生成中间结果。

在Reduce阶段,相同键的中间结果会被分组到同一个Reduce任务,并按照一定的规则进行处理和合并。

最终,Reduce任务会输出最终结果。

例如,统计一篇文档中每个单词的出现次数,就可以使用MapReduce来实现。

MapReduce的优点包括:

•可扩展性强:能够处理大规模数据集,并充分利用分布式计算的优势。

•容错性好:蜗牛节点的存在,即使有计算节点发生故障,整个任务也不会失败。

•简化并行计算:开发者只需要关注数据的映射和归约逻辑,而不用担心细节。

MapReduce的应用场景包括:

•大规模数据处理和分析

•搜索引擎索引构建

•推荐系统

•日志分析

•图计算等。

mapreduce的基本功能MapReduce是一种分布式的计算模型,它可以帮助处理海量数据,并在分布式环境下实现高效的数据处理。

MapReduce提供了一种简单而有效的模式,它将输入数据划分成多个块,并将每个块传递给Map函数进行处理。

Map函数将数据转换为键值对,并将处理结果传递给Reduce函数进行聚合。

MapReduce最终可以将所有处理结果合并为一个输出结果。

MapReduce主要有三个基本功能:数据划分、Map函数处理和Reduce函数聚合。

首先是数据划分,MapReduce将输入数据划分成多个块,每个块都可以在不同的处理器上独立进行处理。

划分数据的过程可以通过数据分片来实现。

数据分片是指将输入数据按照指定的大小进行分块,每个数据块都有自己的处理器进行处理。

分片后的数据可以分发给不同的处理节点,并发地处理数据,提高计算效率。

其次是Map函数处理,Map函数是MapReduce的核心功能之一,它将输入数据转换为键值对,并对每个键值对进行处理。

Map函数的输入可以是任何格式的数据,例如文本、图像、音频等。

Map函数接收输入数据并将其转换为键值对的形式,这个过程称为“映射”。

映射后的每个键值对都会成为Reduce函数的输入,并传递给Reduce函数进行聚合。

最后是Reduce函数聚合,Reduce函数是MapReduce的另一个核心功能。

它接收Map函数转换后的键值对,并将相同键的值进行聚合。

Reduce函数的主要任务是将相同键的值进行合并,从而生成一个新的键值对列表。

Reduce函数可以对键值对进行各种聚合操作,包括计算平均值、求和、计数等。

最终,Reduce函数会将聚合后的结果输出到一个文件中。

总的来说,MapReduce的基本功能是实现大规模数据处理和并行计算,它通过数据划分、Map函数处理和Reduce函数聚合来实现。

MapReduce可以支持多种数据处理和统计操作,可以部署在分布式计算环境中,可以支持数据的高效处理和优化。

mapreduce工作原理

MapReduce是一种分布式计算模型,用于处理大规模的数据集。

它的工作原理可以简单概括为两个过程:Map过程和Reduce过程。

在Map过程中,输入数据集被分割成多个小块,并由多个

Map任务并行处理。

每个Map任务都会对输入数据集中的每

个元素执行相同的操作,并生成中间键值对。

这些中间键值对会被存储在内存中的缓冲区内。

接下来是Shuffle过程,该过程负责将Map任务生成的中间键

值对按照键的值进行排序和分区,并将同一个键的中间键值对传递给同一个Reduce任务进行处理。

Shuffle过程可以确保相

同键的中间键值对被发送到同一个Reduce任务。

在Reduce过程中,每个Reduce任务并行处理一组中间键值对。

Reduce任务会将它们从存储在内存中的缓冲区中取出,并按

照键的值进行合并和计算。

最终的计算结果会被写入一个输出文件中。

整个MapReduce过程中,数据的读取、处理和写入都是在分

布式计算集群中进行的,可以充分利用集群中的多台计算机资源来加速处理过程。

MapReduce模型的并行处理能力和可靠

性使得它成为处理大规模数据集的一种理想选择。

mapreduce的具体工作流程一、前言MapReduce是一种分布式计算模型,用于处理大规模数据集。

它将计算任务分成两个阶段:Map阶段和Reduce阶段,并将这些阶段分配给多台计算机进行并行处理。

本文将详细介绍MapReduce的具体工作流程。

二、MapReduce的概念1. Map阶段在Map阶段,数据被分成若干个小块,每个小块由一个Map任务处理。

Map任务将输入数据转换为键值对,并输出中间结果。

2. Reduce阶段在Reduce阶段,中间结果被聚合并排序,然后由多个Reduce任务进行最终的计算。

每个Reduce任务接收到一个或多个键值对列表,并输出最终结果。

3. 分布式环境下的MapReduce在分布式环境下,一个MapReduce作业通常由一个Master节点和多个Worker节点组成。

Master节点负责调度作业并管理Worker节点,而Worker节点负责执行具体的计算任务。

三、MapReduce的工作流程1. 输入数据切片在开始执行作业之前,输入数据会被切片成若干个小块。

每个小块通常大小为64MB-128MB左右。

2. Map任务执行每个Worker节点会启动若干个Mapper线程来处理输入数据切片。

每个Mapper线程负责读取一个输入数据切片,并将其转换为键值对。

Mapper线程会将中间结果写入本地磁盘。

3. 中间结果的合并和排序在Map阶段结束后,所有的中间结果会被合并到一起,并按照键进行排序。

这个过程通常由Master节点来完成。

4. Reduce任务执行在Reduce阶段,每个Worker节点会启动若干个Reducer线程来处理中间结果。

每个Reducer线程负责读取一个或多个中间结果文件,并将它们聚合成最终的输出结果。

Reducer线程会将最终结果写入本地磁盘。

5. 最终输出在Reduce阶段结束后,所有的最终结果会被合并到一起,并输出到指定的目录下。

这个过程通常由Master节点来完成。

MapReduce数据处理原理一、概述在大数据时代,数据处理变得越来越重要。

MapReduce是一种经典的数据处理模型,它以其高效、可扩展和容错等特点被广泛应用于分布式数据处理。

本文将详细介绍MapReduce的原理,包括其基本概念、流程、组成部分以及实现方式等。

二、MapReduce基本概念MapReduce是一种将大规模数据集并行处理的编程模型。

它由两个阶段组成,即Map阶段和Reduce阶段。

在Map阶段中,原始数据被切分成若干个小数据块,然后通过Map函数进行处理;在Reduce阶段中,Map阶段的输出被分类整理并传递给Reduce函数进行进一步处理。

下面我们将详细介绍MapReduce的基本概念。

2.1 Map函数Map函数是MapReduce的核心部分之一。

它接收一个输入键值对,将其转换为若干个中间键值对。

通常情况下,Map函数的输入是一行文本,输出是零个或多个中间结果。

2.2 Reduce函数Reduce函数是MapReduce的另一个核心部分。

它接收同一个键的多个值,并将它们聚合为一个或多个结果。

Reduce函数的输入是一个键和与该键相关的一个或多个值,输出是最终的结果。

2.3 MapReduce过程MapReduce过程由Map阶段和Reduce阶段组成。

首先,在Map阶段中,原始数据被切分成若干个小数据块,每个小数据块由一个Map任务处理。

然后,Map任务对每个小数据块分别执行Map函数,生成中间键值对。

接着,在Reduce阶段中,中间结果被分类整理,并根据键进行排序。

每个键及其相关的值被传递给一个或多个Reduce任务,Reduce任务通过Reduce函数将多个值聚合为一个或多个结果。

三、MapReduce过程详解3.1 数据划分在MapReduce过程中,原始数据被划分成若干个小数据块,每个小数据块由一个Map任务处理。

数据划分的目的是将原始数据分解成多个小块,使得每个Map任务可以并行处理自己的数据。

mapreduce的工作原理

MapReduce是一种用于处理大规模数据集的编程模型和算法。

它的基本工作原理可以简单地概括为两个阶段:Map阶段和Reduce阶段。

在Map阶段中,大规模的数据集被分割成许多小块,并由多

个Map任务并行处理。

每个Map任务接收一个数据块作为输入,并将其转换成一系列键值对。

这些键值对可以是任意类型,但通常是以某种方式与问题相关联的。

在Reduce阶段中,通过对Map阶段输出的键值对进行合并和

归约,将结果从多个Map任务中提取出来并汇总。

Reduce任

务接收具有相同键的键值对集合,并将它们合并成一个更小的集合,最终生成一个或多个最终结果。

为了实现高效的并行处理,Map和Reduce任务通常在集群中

的多台计算机上执行。

这种分布式处理的方式可以大大加快处理速度,同时也使系统具有较高的容错性,因为一台计算机的故障并不会导致整个任务的失败。

除了Map和Reduce阶段,MapReduce模型还包括一些其他的

组件,如输入输出处理、任务调度和数据分配等。

这些组件相互配合,确保整个处理过程的顺利进行。

总的来说,MapReduce通过将大规模数据集的处理任务拆分

成多个可并行执行的小任务,并通过合并和归约的方式提取和

汇总结果,实现了分布式计算的高效处理。

这种工作原理使得MapReduce成为处理大数据问题的一种强大工具。

MapReduce技术详解1.什么是MapReduce?MapReduce 是由Google公司的Jeffrey Dean 和 Sanjay Ghemawat 开发的一个针对大规模群组中的海量数据处理的分布式编程模型。

MapReduce实现了两个功能。

Map把一个函数应用于集合中的所有成员,然后返回一个基于这个处理的结果集。

而Reduce是把从两个或更多个Map中,通过多个线程,进程或者独立系统并行执行处理的结果集进行分类和归纳。

Map() 和 Reduce() 两个函数可能会并行运行,即使不是在同一的系统的同一时刻。

Google 用MapReduce来索引每个抓取过来的Web页面。

它取代了2004开始试探的最初索引算法,它已经证明在处理大量和非结构化数据集时更有效。

用不同程序设计语言实现了多个MapReduce,包括 Java, C++, Python, Perl, Ruby和C, 其它语言。

在某些范例里,如Lisp或者Python, Map() 和Reduce()已经集成到语言自身的结构里面。

通常,这些函数可能会如下定义:List2 map(Functor1, List1);Object reduce(Functor2, List2);Map()函数把大数据集进行分解操作到两个或更多的小“桶”。

而一个“桶”则是包含松散定义的逻辑记录或者文本行的集合。

每个线程,处理器或者系统在独立的“桶”上执行Map()函数,去计算基于每个逻辑记录处理的一系列中间值。

合并的结果值就会如同是单个Map()函数在单个“桶”上完全一致。

Map()函数的通常形式是:map(function, list) {foreach element in list {v = function(element)intermediateResult.add(v)}} // mapReduce()函数把从内存,磁盘或者网络介质提取过来的一个或多个中间结果列表,对列表中的每个元素逐一执行一个函数。

MapReduce 是一种用于处理大规模数据的并行计算框架。

它的工作机制主要包括分布式计算、数据划分、映射函数和归约函数等关键步骤。

下面将详细介绍 MapReduce 的工作机制。

一、分布式计算1. MapReduce 使用分布式计算来处理大规模数据。

它将数据划分成多个块,并在不同的计算节点上并行处理这些数据块。

2. 分布式计算可以充分利用集裙中的计算资源,加快数据处理速度,并提高系统的容错能力。

3. 分布式计算还可以有效地处理数据的并行化计算,提高计算效率。

二、数据划分1. 在 MapReduce 中,数据会被划分成多个输入对。

2. 每个输入对包括一个键和一个值。

键用来唯一标识数据,值则是数据的实际内容。

3. 数据划分可以根据键来实现,这样相同键的数据会被划分到同一个计算节点上进行处理。

三、映射函数1. 映射函数是 MapReduce 中的一个重要环节。

它负责将数据划分成多个键值对,并为每个键值对生成一个中间键值对。

2. 映射函数会对每个数据块进行处理,并输出多个中间键值对。

这些中间键值对由键和相应的值组成。

3. 映射函数的输出将作为归约函数的输入,用于后续的数据处理。

四、归约函数1. 归约函数是 MapReduce 中的另一个重要环节。

它负责对映射函数的输出进行处理,并生成最终的结果。

2. 归约函数会根据键将中间键值对进行聚合,然后对每个键值对执行归约操作。

3. 归约函数的输出就是最终的处理结果,可以将结果保存到文件系统中。

五、MapReduce 的工作流程1. 当一个 MapReduce 任务被提交时,首先会将输入数据划分成多个数据块,然后将这些数据块分配到不同的计算节点上。

2. 每个节点上都会运行映射函数来处理数据块,并生成中间键值对。

然后这些中间键值对会被发送到不同的节点上进行归约操作。

3. 各个节点上的归约函数会对中间键值对进行聚合,生成最终的处理结果。

通过以上介绍,可以看出 MapReduce 的工作机制主要包括分布式计算、数据划分、映射函数和归约函数等关键步骤。