信息论期末复习

- 格式:doc

- 大小:31.50 KB

- 文档页数:1

信息论复习题1、求基本高斯信源的差熵。

(10分)2、一个随机变量x 的概率密度函数为kx x p =)(,V x 20≤≤。

试求该信源的相对熵。

3、黑白气象传真图的消息只有黑色和白色两种,即信源{}黑,白=X ,设黑色的出现概率为3.0(=黑)P ,白色的出现概率为7.0(=白)P 。

(1)假设图上黑白消息出现前后没有关联,求熵)(X H 。

(2)假设消息前后有关联,其依赖关系为9.0/(=白)白P ,1.0/(=白)黑P ,2.0/(=黑)白P ,8.0/(=黑)黑P ,求此平稳离散信源的熵)(2X H 。

(3)分别求上述两种信源的剩余度,比较)(X H 和)(2X H 的大小。

4、给出求一般离散信道的信道容量的计算步骤并用拉格朗日乘子法加以证明。

5、给出离散无记忆信源的信息率失真函数的参量表述并用拉格朗日乘子法加以证明。

6、若信道的输入和输出分别是N 长序列X 和Y ,且信道是无记忆的,则∑=≤Nk k k Y X I Y X I 1),();(,这里k X 和k Y 分别是序列X 和Y 中第k 位随机变量;并且证明当且仅当信源也是无记忆信源时等号成立。

7、有一并联高斯加性信道,各子信道的噪声均值为0,方差为2i σ:21σ=0.1,22σ=0.2,23σ=0.3,24σ=0.4,25σ=0.5,26σ=0.6,27σ=0.7,28σ=0.8,29σ=0.9,210σ=1.0(W )。

输入信号X 是10个相互统计独立、均值为0、方差为i P 的高斯变量,且满足:)(1101W P i i=∑=。

求各子信道的信号功率分配方案。

8、给定语音信号样值x的概率密度函数为x e x p λλ-=21)(,∞<<∞-x ,求)(X H c ,并比较)(X H c 与具有同样方差的正态变量的连续熵的大小。

9、某二元信源=5.05.010)(x p X ,其失真矩阵定义为??=00a a D ,求该信源的max D ,min D 和该信源的信息率失真函数)(D R 。

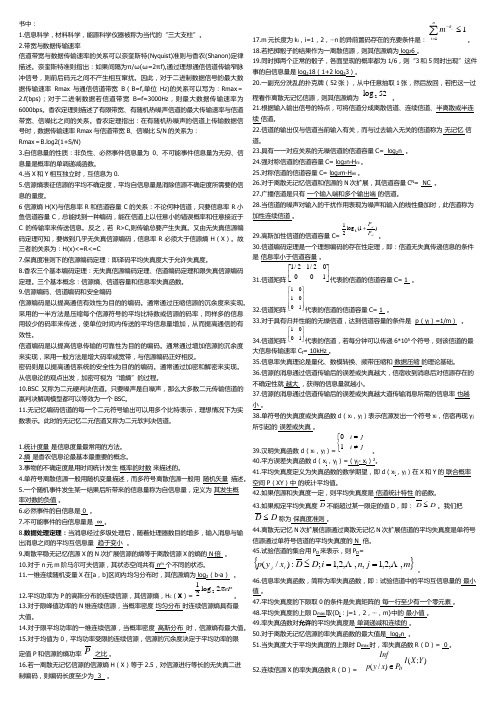

判断30名词解释4*5计算3道20分第一章1、自信息和互信息P6 公式2、信道P9 概念第二章1、离散平稳信源P18概念2、离散无记忆信源P19概念3、时齐马尔可夫信源P20概念4、自信息P22概念5、信息熵P25概念6、信息熵的基本性质P281)对称性2)确定性3)非负性4)扩展性5)可加性6)强可加性7)递增性8)极值性9)上凸性7、联合熵条件熵P42公式P43例题8、马尔克夫信源P54公式P55例题9、信源剩余度P5810、熵的相对率信源剩余度P5811、课后作业:2、4、13、21、22第三章1、有记忆信道P73概念2、二元对称信道BSC P743、前向概率、后向概率、先验概率、后验概率P764、条件熵信道疑义度、平均互信息P775、平均互信息、联合熵、信道疑义度、噪声熵计算公式P786、损失熵噪声熵 P797、平均互信息的特性P821)非负性2)极值性3)交互性4)凸状性8、信息传输率R P869、无噪无损信道P87概念10、有噪无损信道P88概念11、对称离散信道 P89概念12、对称离散信道的信道容量P90公式张亚威2012/06/20张亚威2012/06/2116、 数据处理定理 P113定理 17、 信道剩余度 P118公式 18、 课后作业:1、 3、 9第五章1、 编码:实质上是对信源的原始符号按一定的数学规则进行的一种变换。

2、 等长码 P172概念3、 等长信源编码定理 P1784、 编码效率 P1805、 克拉夫特不等式 P1846、 香农第一定理 P1917、 码的剩余度 P194第六章1、 最大后验概率准则 最小错误概率准则 P2002、 最大似然译码准则 P2013、 费诺不等式 P2024、 信息传输率(码率) P2055、 香农第二定理 P2156、 课后习题 3、第八章1、 霍夫曼码 最佳码 P2732、 费诺码 P2793、 课后习题 11、第八章1、 编码原则 译码原则 P3072、 定理9.1 P3133、 分组码的码率 P314公式4、 课后习题 3、一、 填空题1、 在现代通信系统中,信源编码主要用于解决信息传输中的 有效性 ,信道编码主要用于解决信息传输中的 可靠性 ,加密编码主要用于解决信息传输中的 安全性 。

第二章离散信源及其信息测度❝ 2.4, 2.5, 2.7, 2.8, 2.10, 2.13, 2.15, 2.17, 2.22, 2.23, 2.24第三章离散信道及其信道容量❝ 3.1(H(X|Y) 平均互信息),3.2(多符号码字互信息), 3.7(有相关H(XZ) ),3.10(准对称信道容量), 3.11(一般信道容量), 3.14(证明马氏链), 3.16(串接信道互信息)❝ 3.3 (对称信道HX H(X|Y) I(X;Y))3.9(画信道矩阵,强对称求信道容量,最佳输入概率)❝第四章无失真信源编码定理❝ 5.1(自信息I(X)大数定理),5.2(编码方式), 5.3, 5.5(信道容量每秒信息量),5.10(平均码长编码效率)结果:Log2 0.9 = -0.152003 结果:Log2 0.8 = -0.321928 结果:Log2 0.7 = -0.514573 结果:Log2 0.6 = -0.736966 结果:Log2 0.5 = -1结果:Log2 0.4 = -1.321928 结果:Log2 0.3 = -1.736966 结果:Log2 0.2 = -2.321928 结果:Log2 0.1 = -3.321928)(i x I =相互独立H(XY)=HX+HY=P(X1X2)log(1/p(x1|x2))一阶马尔科夫信源)y /x (I )x (I )y /x (p 1log )x (p 1log )m ,,2,1j ;n ,,2,1i ()x (p )y /x (p log )y ;x (I j i i j i 2i 2i j i 2j i -=-=⋯=⋯==互信息量 获得y 求关于x 的信息◦观察者站在输入端)/()()/(1log )(1log );(22i j j i j j i j x y I y I x y p y p x y I -=-=先验不确定度:)()(1log )(2'j ij i y p x p y x I =后验不确定度:)(1log )(2''j i j i y x p y x I =通信后的互信息量,等于前后不确定度的差)()()()()()(1log )()(1log );('''22j i j i j i j i j i j i j i y x I y I x I y x I y x I y x p y p x p y x I -+=-=-=平均互信息量定义:互信息量 I (x i ;y j ) 在联合概率空间P (XY ) 中的统计平均值(简称平均互信息/平均交互信息量/交互熵)∑∑∑∑======n i mj i j i j i n i m j j i j i x p y x p y x p y x I y x p Y X I 11211)()/(log )();()();(观察者站在输出端 )/()()/(1log )()(1log )()()/(log )();(112112112Y X H X H y x p y x p x p y x p x p y x p y x p Y X I n i mj j i j i ni m j i j i ni mj i j i j i -=-==∑∑∑∑∑∑======❝ H (X /Y ) —信道疑义度/损失熵。

书中:1.信息科学,材料科学,能源科学仪器被称为当代的“三大支柱”。

2.带宽与数据传输速率信道带宽与数据传输速率的关系可以奈奎斯特(Nyquist)准则与香农(Shanon)定律描述。

奈奎斯特准则指出:如果间隔为π/ω(ω=2πf),通过理想通信信道传输窄脉冲信号,则前后码元之间不产生相互窜扰。

因此,对于二进制数据信号的最大数据传输速率Rmax 与通信信道带宽B (B=f,单位Hz)的关系可以写为:Rmax =2.f(bps);对于二进制数据若信道带宽B=f=3000Hz ,则最大数据传输速率为6000bps 。

香农定理则描述了有限带宽、有随机热噪声信道的最大传输速率与信道带宽、信噪比之间的关系。

香农定理指出:在有随机热噪声的信道上传输数据信号时,数据传输速率Rmax 与信道带宽B 、信噪比S/N 的关系为: Rmax =B.log2(1+S/N)3.自信息量的性质:非负性、必然事件信息量为0、不可能事件信息量为无穷、信息量是概率的单调递减函数。

4.当X 和Y 相互独立时,互信息为0.5.信源熵表征信源的平均不确定度,平均自信息量是消除信源不确定度所需要的信息的量度。

6信源熵H(X)与信息率R 和信道容量C 的关系:不论何种信道,只要信息率R 小鱼信道容量C ,总能找到一种编码,能在信道上以任意小的错误概率和任意接近于C 的传输率来传送信息。

反之,若R>C,则传输总要产生失真。

又由无失真信源编码定理可知,要做到几乎无失真信源编码,信息率R 必须大于信源熵H (X )。

故三者的关系为:H(x)<=R<=C7.保真度准则下的信源编码定理:即译码平均失真度大于允许失真度。

8.香农三个基本编码定理:无失真信源编码定理、信道编码定理和限失真信源编码定理。

三个基本概念:信源熵、信道容量和信息率失真函数。

9.信源编码、信道编码和安全编码信源编码是以提高通信有效性为目的的编码。

通常通过压缩信源的沉余度来实现。

信息论复习知识点本页仅作为文档封面,使用时可以删除This document is for reference only-rar21year.March1、平均自信息为表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

3、最大熵值为。

4、通信系统模型如下:5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。

6、只要,当N足够长时,一定存在一种无失真编码。

7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。

8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

按照信息的地位,可以把信息分成客观信息和主观信息。

人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

信息的可度量性是建立信息论的基础。

统计度量是信息度量最常用的方法。

熵是香农信息论最基本最重要的概念。

事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有 比特、奈特和哈特 。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是 ∞ 。

15、两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。

信息论复习题期末答案1. 信息论的创始人是谁?答案:信息论的创始人是克劳德·香农。

2. 信息熵的概念是什么?答案:信息熵是衡量信息量的一个指标,它描述了信息的不确定性或随机性。

在信息论中,熵越高,信息的不确定性越大。

3. 请简述信源编码定理。

答案:信源编码定理指出,对于一个具有确定概率分布的离散无记忆信源,存在一种编码方式,使得信源的平均编码长度接近信源熵的值,且当信源长度趋于无穷大时,编码长度与信源熵之间的差距趋于零。

4. 什么是信道容量?答案:信道容量是指在特定的通信信道中,能够以任意小的错误概率传输信息的最大速率。

它是信道的最大信息传输率,通常用比特每秒(bps)来表示。

5. 香农公式是如何定义信道容量的?答案:香农公式定义信道容量为信道输入和输出之间的互信息量的最大值,可以表示为C = B log2(1 + S/N),其中C是信道容量,B是信道带宽,S是信号功率,N是噪声功率。

6. 差错控制编码的目的是什么?答案:差错控制编码的目的是为了检测和纠正在数据传输过程中可能发生的错误,以提高数据传输的可靠性。

7. 什么是线性码?答案:线性码是一种特殊的编码方式,其中任意两个合法编码的线性组合仍然是一个合法编码。

线性码通常可以用生成矩阵和校验矩阵来表示。

8. 卷积码和块码有什么区别?答案:卷积码和块码都是差错控制编码的类型,但它们的主要区别在于编码的结构和处理方式。

卷积码是连续的,其编码过程是按时间序列进行的,而块码是离散的,其编码过程是针对数据块进行的。

9. 什么是信道编码定理?答案:信道编码定理指出,对于任何给定的信道和任何小于信道容量的错误概率,都存在一种编码方式,可以使得错误概率趋近于零。

10. 请解释什么是信道编码的译码算法。

答案:信道编码的译码算法是一种用于从接收到的编码信号中恢复原始信息的方法。

常见的译码算法包括维特比算法、最大似然译码和最小均方误差译码等。

这些算法旨在最小化译码错误的概率。

1、一个事件发生的概率和它提供的信息量有什么关系?

2、离散信源的概率如何分布,熵达到最大?

3、联合自信息量和条件自信息量也满足非负性吗?

4、信源熵12(,,...)q H p p p 是概率分布12,,...q p p p 的什么函数?

5、要做到几乎无失真信源编码,信息率必须满足什么条件?

6、加权熵的定义是什么?写出公式。

7、如何计算自信息量?自信息量的单位是唯一的吗?主要有哪几个单位?

8、联合自信息量()()()i j i j I x y I x I y =+在什么条件下成立?

9、掌握联合熵,条件熵和信源熵之间的关系。

10、什么是对无损信道?它有什么特点?

11、什么是对称信道?什么是准对称信道?

12、什么是信道容量?

13、要使离散对称信道的输出等概分布,输入分布应如何?

14、什么是信息率失真函数?自变量的范围如何确定?信息率的范围如何确定?

15、什么是平均失真度?给出平均失真度的定义。

16、什么是二元无记忆信源的扩展信源。

17、什么是信源编码?什么是信道编码?

18、设二元信源为120.40.6a a ⎧⎫⎨⎬⎩⎭,相应的失真矩阵为00αα⎡⎤⎢⎥⎣⎦

,则最小失真度和最大失真度分别为多少?

19、信息价值率的定义是什么?

20、R(D)~D 曲线与信源概率分布有关吗?信源如何分布时R(D)最大?

21、怎么判断一组码字是否为唯一可译码?

22、在哈夫曼编码过程中,对缩减信源符号按概率由大到小的顺序重新排列时,应使合并后的新符号尽可能排在什么位置可使合并后的新符号重复编码次数减少,使短码得到充分利用。

课后习题(务必要看)

2.3 2.4 2.12

3.2 3.3 3.12

4.3 4.4 4.11

5.1 5.2 5.3。