淘宝分布式服务框架

- 格式:pdf

- 大小:1.89 MB

- 文档页数:34

目录摘要 (I)1.引言 (1)1.1课题的来源、目的、意义 (1)2.系统分析 (3)2.1 业务流程 (3)2.2 系统功能分析 (7)3.系统设计 (10)3.1 数据库设计 (10)EBusiness是一个典型的电子商务系统,针对它将要实现的业务功能,数据库中具有以下的模块: (10)4.总结与展望 (15)致谢 (16)参考文献 (17)淘宝网上购物系统的开发与设计摘要随着计算机技术在各行各业日益广泛和深入的应用,网络的概念早已深入人心。

网络在各行各业的发展战略中占据了重要的位置,成为商家不可分割的部分。

商品的宣传已不只局限于电视与报纸,网络已成为商家展示自己的另一个舞台。

商家建立网站,将商家各方面的宣传与服务展现于网络中,通过网络便可实现如网上购物、信息查寻等功能,这样一个基于浏览器/服务器(B/S)模式的B2C的网上购物系统就形成了。

本论文研究了这种基于B/S模式的B2C的网上购物系统的开发。

其开发主要包括后台数据库的建立、后台管理以及前台页面的Web设计。

系统使用Microsoft 公司以C#为核心语言的开发工具,利用微软提供的IIS 5.0建立运行环境,再结合SQL Server 2000建立数据连接关系。

利用其提供的各种组件,在短时间内建立数据库,对数据库进行分析与建立页面,不断改进,直到功能基本实现的可行系统。

论文还对WEB分析、设计、开发、测试和发布这个工作流程进行了详细的论述,从中着重介绍了网上购物系统要实现的功能、业务流程、系统流程、前台数据流图、后台数据流图、E-R图、数据库设计、功能模块设计、实现和测试等一系列开发流程。

最后,对设计中所遇到的难题进行重点介绍、分析和说明解决的办法,同时对商场实现后所运行的结果进行定性分析并得出结论。

关键词:技术,数据库,网上购物系统,Web设计1.引言1.1课题的来源、目的、意义1.1.1本课题的来源近年来,随着Internet的迅速崛起,互联网已日益成为收集提供信息的最佳渠道并逐步进入传统的流通领域。

当当网的系统功能:1.客户服务系统当当网建立了功能强大的客户服务中心。

当当网以网上购物为主要的经营手段,用户与商家最为直接交流莫过于电话,因此,建立一个完善的客户服务中心是用户必须的。

当当网呼叫中心系统在保证话务质量的同时具有相当的规模,并随着业务的不断增大,还可以平滑的升级;所采用的呼叫中心系统完全摆脱了传统呼叫中心系统的羁绊,建立了一套基于IP的分布式呼叫中心平台,同时,可以实现高质量的话务统计。

2.智能比价系统当当网开发了智能比价系统系统。

通过此系统,当当网每天都实时对各电子商务网站的同类商品的价格进行对比。

如果对方同类商品价格低于当当网商品价格,此系统将自动调低当当网同类商品的价格。

3.相关搜索系统当当网购物系统根据客户的购物习惯自动向他们推荐相关商品。

如今当当网客户的搜索范围不仅包括当当网近百万自营商品,还把当当数千家店中店的各类商品一搜到底4.物流配送系统当当网在这180个城市拥有物流合作伙伴。

这些合作伙伴可能只是一家只有数十人的小快递公司,服务范围可能仅仅是它所在的城市。

但当当网成功的将这些物流合作伙伴整合成一个覆盖全国的物流网络,向180个城市提供送货上门和货到付款服务,并且覆盖的城市还在增加。

当当网在北京、上海、广州3个城市设立了仓储中心。

当一笔订单产生时,当当网将判断从那个仓库调货最优,然后订单被发送到用户所在的城市,该城市的快递公司收到货后立即送货上门。

当当网对于这些快速公司怎么搭配发送包裹一向不作要求,唯一的要求就是在特定的时间内将货物送到。

5.支付系统当当网其主要的支付方式有:a.货到付款:快递公司把商品送至指定地点时,由收货人当时交付货款和运费。

b.银行汇款:用户可以通过银行汇款、转帐的方式汇款至当当网。

c.邮局汇款:全国邮政服务范围所能覆盖的国内省、市、自治区、直辖市的客户均可以选择此方式支付。

d.信用卡支付:用户使用几种指定的信用卡付款。

当当网还设立了专门的论坛。

HSF新人用户手册一江,更新时间:2010-9-91.HSF介绍 (2)2.安装和使用HSF (3)1.下载和安装HSF (3)2.进行HSF服务开发 (6)3.查询和调用HSF服务 (13)3.HSF相关开发工具 (16)1.Eclipse Jetty插件 (16)2.Hsf.unit (21)3.Hsf-Standalone (23)4.HSF工作原理 (24)1.JBoss中的HSF部署模型 (24)2.Tomcat中的HSF部署模型 (25)3.HSF发布服务 (25)4.HSF订阅及调用服务 (26)5.HSF服务配置详解 (28)1.HSFSpringProviderBean (28)2.HSFSpringConsumerBean (30)1.HSF介绍HSF全称为High-Speed Service Framework,旨在为淘宝应用提供一个分布式的服务框架,HSF从分布式应用层面以及统一的发布/调用方式层面为大家提供支持,从而可以很容易的开发分布式的应用以及提供或使用公用功能模块,而不用考虑分布式领域中的各种细节技术,例如远程通讯、性能损耗、调用的透明化、同步/异步调用方式的实现等等问题。

更详细的HSF介绍信息请访问:淘宝百科HSF页面,常用链接入口:/。

图1-1.HSF常用链接入口2.安装和使用HSF1.下载和安装HSF第一步:从HSF主页访问HSF软件下载中心,下载JBoss4.2.2和HSF1.4.8压缩包。

如下图所示:图2-1.HSF下载中心第二步:解压jboss-4.2.2.GA.zip包到任意目录,如D:\。

这时JBoss应该位于D:\jboss-4.2.2.GA目录;解压taobao-hsf.tgz到%JBOSS_HOME%\server\default\deploy 目录。

至此,JBoss和HSF安装完成。

JBoss服务器目录结构如图2-2所示。

图2-2.JBoss和HSF安装后目录结构第三步:执行%JBOSS_HOME%\bin\run.bat启动JBoss,这时访问http://localhost/将能够看到JBoss服务器默认首页,如图2-3所示。

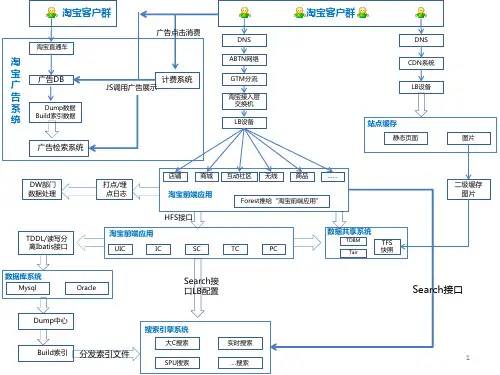

淘宝技术框架分析报告淘宝作为国首屈一指的大型电子商务,每天承载近30亿PV的点击量,拥有近50PB的海量数据,那么淘宝是如确保其的高可用的呢?本文将对淘宝在构建大型过程中所使用到的技术框架做一个总结,并结合银行现有技术框架进展比照分析。

另外,本文还会针对金融互联网以及公司未来技术开展向给出个人看法。

淘宝技术分析CDN技术及多数据中心策略国的网络由于运营商不同〔分为电信、联通、移动〕,造成不同运营商网络之间的互访存在性能问题。

为了解决这个问题,淘宝在全国各地建立了上百个CDN节点,当用户访问淘宝时,浏览器首先会访问DNS效劳器,通过DNS解析域名,根据用户的IP将访问分配到不同的入口。

如果客户的IP属于电信运营商,那么就会被分配到同样是电信的CDN节点,并且保证访问的〔这里主要指JS、CSS、图片等静态资源〕CDN节点是离用户最近的。

这样就将巨大的访问量分散到全国各地。

另外,面对如此巨大的业务请求,任一个单独的数据中心都是无法承受的,所以淘宝在全国各主要城市都建立了数据中心,这些数据中心不但保证了容灾,而且各个数据中心都在提供效劳。

不管是CDN技术还是多个数据中心,都涉及到复杂的数据同步,淘宝很好的解决了这个问题。

银行现在正在筹建两地三中心,但主要目的是为了容灾,数据中心的利用率差,而淘宝的多个数据中心利用率为100%。

LVS技术淘宝的负载均衡系统采用了LVS技术,该技术目前由淘宝的章文嵩博士负责。

该技术可以提供良好的可伸缩性、可靠性以及可管理型。

只是这种负载均衡系统的构建是在Linux操作系统上,其他操作系统不行,并且需要重新编译Linux操作系统核,对系统核的了解要求很高,是一种软负载均衡技术。

而银行那么通过F5来实现负载均衡,这是一种硬负载均衡技术。

Session框架Session对于Web应用是至关重要的,主要是用来保存用户的状态信息。

但是在集群环境下需要解决Session共享的问题。

目前解决这个问题通常有三种式,第一个是通过负载均衡设备实现会话保持,第二个是采用Session复制,第三个那么是采用集中式缓存。

概述淘宝是中国最大的电商网站之一,每天有数以亿计的用户访问淘宝平台。

在高并发的访问环境下,如何保证淘宝的稳定性和可用性是一个重要的挑战。

本文将介绍淘宝高并发解决方案,包括架构设计、缓存优化、数据库优化以及负载均衡。

架构设计淘宝采用了分布式架构来应对高并发的访问压力。

整个系统被划分为多个服务模块,每个模块独立运行,并通过消息队列进行通信。

这种架构设计可以有效地提高系统的可伸缩性和可扩展性。

缓存优化为了减轻数据库的压力,淘宝采用了大量的缓存来加速数据访问。

其中,最核心的缓存技术是利用Redis来缓存热点数据。

通过将频繁访问的数据放入Redis缓存中,可以大大提高系统的响应速度和吞吐量。

淘宝还利用CDN(内容分发网络)来缓存静态资源,例如商品图片、CSS文件和JavaScript文件。

CDN可以将这些静态资源缓存在全球各地的节点上,用户可以就近访问这些缓存节点,从而提高访问速度。

数据库优化淘宝使用了分布式数据库来处理海量的数据。

数据库采用主从复制的方式,将读写操作分散到多个数据库节点上,从而提高数据库的并发处理能力。

为了减少数据库查询的负载,淘宝采用了数据库分库分表的技术。

将数据按照一定的规则分散到多个数据库和表中,从而均衡数据库的负载,并且降低了单个数据库的数据量和并发访问量。

此外,淘宝还采用了数据库的读写分离技术。

将读操作和写操作分别路由到不同的数据库节点上,从而提高数据库的读写性能。

负载均衡淘宝使用了负载均衡技术来分发用户的请求,以实现高并发的访问。

主要的负载均衡技术包括DNS负载均衡和反向代理负载均衡。

DNS负载均衡将用户的请求解析到多个服务器的IP地址上,从而使得用户的请求被均衡地分发到不同的服务器上。

反向代理负载均衡则是通过将用户的请求发送到多个反向代理服务器上,由反向代理服务器再将请求分发给后端的多个应用服务器。

这样可以均衡地分担用户的请求压力,提高系统的并发处理能力。

总结淘宝面临着海量用户的高并发访问压力,为了保证系统的稳定性和可用性,需要在架构设计、缓存优化、数据库优化和负载均衡等方面进行优化。

淘宝运行知识点总结作为中国最大的电子商务平台之一,淘宝的运行涉及到许多方面的知识点。

在这篇文章中,我们将从技术、运营、市场和管理等多个方面来总结淘宝的运行知识点。

技术知识点1. 服务器构架淘宝作为一个庞大的电子商务平台,其服务器构架必须具备高性能、高可用和高扩展性。

淘宝采用分布式服务器架构,通过负载均衡和分布式缓存来处理大规模的访问请求。

2. 数据库管理淘宝的数据库系统包括关系型数据库和非关系型数据库,用于存储用户数据、商品信息、交易记录等。

数据库管理涉及到数据的备份恢复、性能优化、数据安全等方面。

3. 网络安全作为一个电子商务平台,淘宝面临着各种网络安全威胁,包括DDoS攻击、SQL注入、跨站脚本攻击等。

网络安全团队必须采取一系列措施来保护平台的安全。

4. 大数据处理淘宝拥有庞大的用户群体和海量的交易数据,因此需要采用大数据技术来进行数据分析、用户画像、推荐系统等方面的处理。

运营知识点1. 商品运营淘宝的商品运营包括平台运营、销量提升、品牌推广等方面。

运营团队需要了解市场趋势,制定商品推广策略,优化商品搜索排名等。

2. 用户运营用户运营是淘宝的核心工作之一,包括用户注册、用户活跃度、用户留存等方面。

用户运营团队通过数据分析和用户画像来提升用户体验,增加用户粘性。

3. 营销推广淘宝的营销推广包括广告投放、活动策划、社交媒体营销等方面。

运营团队需要了解不同渠道的用户行为特点,制定相应的营销策略。

市场知识点1. 竞争分析淘宝面临着激烈的市场竞争,竞争分析是市场团队的重要工作之一。

团队需要了解竞争对手的产品、价格、营销策略等,并及时调整自身策略。

2. 消费者行为消费者行为分析是市场团队的重要工作内容,包括用户购买行为、用户偏好、用户消费习惯等方面。

团队需要通过数据分析来了解消费者行为,从而制定相应的市场策略。

管理知识点1. 团队管理淘宝拥有庞大的团队,团队管理是管理团队的重要工作内容。

管理团队需要制定有效的团队管理制度,调动团队的积极性,提升团队的执行力。

淘宝技术架构演进之路1. 概述本⽂以淘宝作为例⼦,介绍从⼀百个到千万级并发情况下服务端的架构的演进过程,同时列举出每个演进阶段会遇到的相关技术,让⼤家对架构的演进有⼀个整体的认知,⽂章最后汇总了⼀些架构设计的原则。

特别说明:本⽂以淘宝为例仅仅是为了便于说明演进过程可能遇到的问题,并⾮是淘宝真正的技术演进路径2. 基本概念在介绍架构之前,为了避免部分读者对架构设计中的⼀些概念不了解,下⾯对⼏个最基础的概念进⾏介绍:分布式系统中的多个模块在不同服务器上部署,即可称为分布式系统,如Tomcat和数据库分别部署在不同的服务器上,或两个相同功能的Tomcat分别部署在不同服务器上⾼可⽤系统中部分节点失效时,其他节点能够接替它继续提供服务,则可认为系统具有⾼可⽤性集群⼀个特定领域的软件部署在多台服务器上并作为⼀个整体提供⼀类服务,这个整体称为集群。

如Zookeeper中的Master和Slave分别部署在多台服务器上,共同组成⼀个整体提供集中配置服务。

在常见的集群中,客户端往往能够连接任意⼀个节点获得服务,并且当集群中⼀个节点掉线时,其他节点往往能够⾃动的接替它继续提供服务,这时候说明集群具有⾼可⽤性负载均衡请求发送到系统时,通过某些⽅式把请求均匀分发到多个节点上,使系统中每个节点能够均匀的处理请求负载,则可认为系统是负载均衡的正向代理和反向代理系统内部要访问外部⽹络时,统⼀通过⼀个代理服务器把请求转发出去,在外部⽹络看来就是代理服务器发起的访问,此时代理服务器实现的是正向代理;当外部请求进⼊系统时,代理服务器把该请求转发到系统中的某台服务器上,对外部请求来说,与之交互的只有代理服务器,此时代理服务器实现的是反向代理。

简单来说,正向代理是代理服务器代替系统内部来访问外部⽹络的过程,反向代理是外部请求访问系统时通过代理服务器转发到内部服务器的过程。

3. 架构演进3.1 单机架构以淘宝作为例⼦。

在⽹站最初时,应⽤数量与⽤户数都较少,可以把Tomcat和数据库部署在同⼀台服务器上。

电子商务网站(淘宝网)的系统架构解析淘宝网,是一个在线商品数量突破一亿,日均成交额超过两亿元人民币,注册用户接近八千万的大型电子商务网站,是亚洲最大的购物网站。

那么对于淘宝网这样大规模的一个网站,我猜想大家一定会非常关心整个网站都采用了什么样的技术、产品和架构,也会很想了解在淘宝网中是否采用了开源的软件或者是完全采用的商业软件。

那么下面我就简单的介绍一下淘宝网中应用的开源软件。

对于规模稍大的网站来说,其IT必然是一个服务器集群来提供网站服务,数据库也必然要和应用服务分开,有单独的数据库服务器。

对于像淘宝网这样规模的网站而言,就是应用也分成很多组。

那么下面,我就从应用服务器操作系统、应用服务器软件、Web Server、数据库、开发框架等几个方面来介绍一下淘宝网中开源软件的应用。

操作系统我们首先就从应用服务器的操作系统说起。

一个应用服务器,从软件的角度来说他的最底层首先是操作系统。

要先选择操作系统,然后才是操作系统基础上的应用软件。

在淘宝网,我们的应用服务器上采用的是Linux操作系统。

Linux操作系统从1991年第一次正式被公布到现在已¾¬走过了十七个年头,在PC Server上有广泛的应用。

硬件上我们选择PC Server而不是小型机,那么Server的操作系统供我们选择的一般也就是Linux,FreeBSD,windows2000 Server或者Windows Server2003。

如果不准备采用微软的一系列产品构建应用,并且有能力维护Linux或者FreeBSD,再加上成本的考虑,那么还是应该在Linux和FreeBSD之间进行选择。

可以说,现在Linux和FreeBSD这两个系统难分伯仲,很难说哪个一定比另外一个要优秀很多、能够全面的超越对手,应该是各有所长。

那么在选择的时候有一个因素就是企业的技术人员对于哪种系统更加的熟悉,这个熟悉一方面是系统管理方面,另外一方面是对于内核的熟悉,对内核的熟悉对于性能调优和对操作系统进行定制剪裁会有很大的帮助。