第二章:信息论的基本概念

- 格式:ppt

- 大小:877.00 KB

- 文档页数:59

计算机科学中的信息论与编码信息论与编码是计算机科学中的重要理论,它们对于信息的传输、存储和处理起着至关重要的作用。

信息论主要研究信息的度量和传输的可靠性,而编码则是将信息以有效的方式表示和传递的技术手段。

本文将介绍信息论和编码在计算机科学中的应用,并探讨其对现代计算机技术的影响。

一、信息论的基本概念信息论是由香农在1948年提出的一门学科。

它通过熵和信息量的概念,量化了信息的度量和传输的质量。

熵是信息理论中的关键概念,用来表示一个随机变量的不确定性和信息量的平均值。

计算机系统中的信息可用二进制表示,因此信息的度量单位是比特(bit)。

二、信息论的应用1. 数据压缩信息论的一个重要应用是数据压缩。

利用信息论的原理,可以设计出高效的压缩算法,将大量的数据压缩成较小的文件。

常见的数据压缩算法有哈夫曼编码、LZ编码等。

这些算法通过统计字符或者字符组合出现的频率,将频率高的字符用较短的编码表示,从而实现数据的有损或无损压缩。

2. 信道编码信道编码是信息论的另一个重要应用领域。

在数据传输过程中,由于信道噪声等原因,数据容易出现误码。

为了提高传输的可靠性,可以使用信道编码技术。

常见的信道编码方案有纠错码和调制码,它们可以通过增加冗余信息或者改变信号的特性,提高传输系统的容错能力。

三、编码的基本原理编码是将信息转换成特定的符号或者编码字,以便能够有效地表示和传输。

在计算机科学中,常见的编码方式有ASCII码、Unicode和UTF-8等。

ASCII码是一种最早的字符编码方式,它将每个字符映射为一个7位的二进制数。

Unicode是一种全球通用的字符编码标准,它使用16位或32位的二进制数表示字符。

UTF-8则是Unicode的一种变体,它采用可变长度的编码方式,可以表示任意字符。

四、编码的应用1. 信息存储编码在信息存储中起着关键作用。

计算机系统中的文件和数据都需要以某种方式进行编码才能存储和读取。

不同的数据类型使用不同的编码方式,例如图片可以使用JPEG、PNG等图像编码格式,音频可以使用MP3、AAC等音频编码格式。

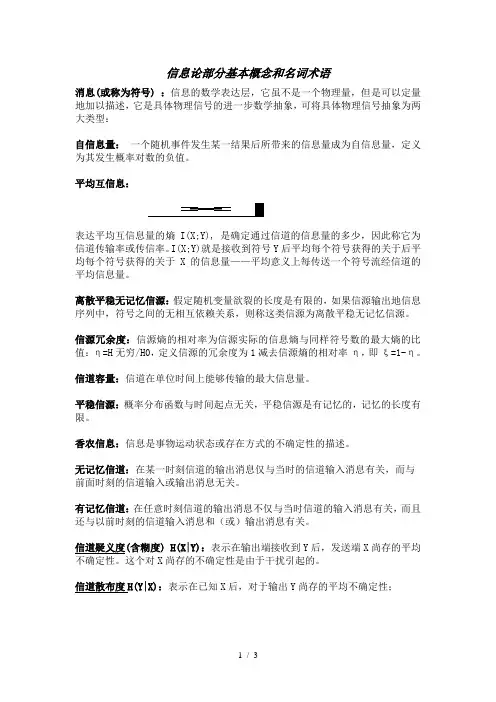

信息论部分基本概念和名词术语消息(或称为符号):信息的数学表达层,它虽不是一个物理量,但是可以定量地加以描述,它是具体物理信号的进一步数学抽象,可将具体物理信号抽象为两大类型:自信息量:一个随机事件发生某一结果后所带来的信息量成为自信息量,定义为其发生概率对数的负值。

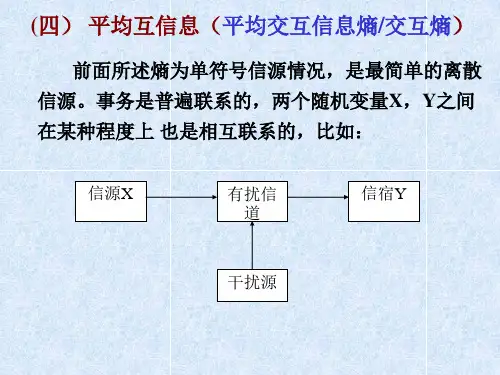

平均互信息:表达平均互信息量的熵I(X;Y), 是确定通过信道的信息量的多少,因此称它为信道传输率或传信率。

I(X;Y)就是接收到符号Y后平均每个符号获得的关于后平均每个符号获得的关于X的信息量——平均意义上每传送一个符号流经信道的平均信息量。

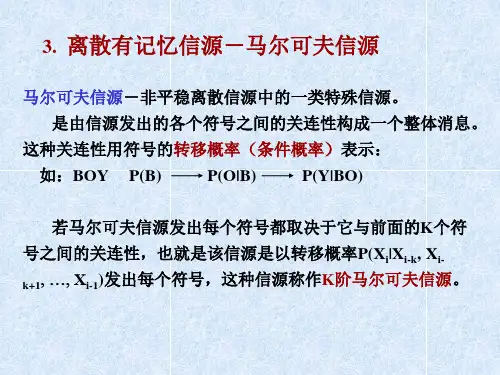

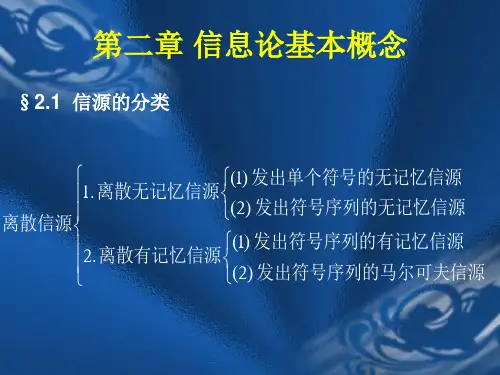

离散平稳无记忆信源:假定随机变量欲裂的长度是有限的,如果信源输出地信息序列中,符号之间的无相互依赖关系,则称这类信源为离散平稳无记忆信源。

信源冗余度:信源熵的相对率为信源实际的信息熵与同样符号数的最大熵的比值:η=H无穷/H0,定义信源的冗余度为1减去信源熵的相对率η,即ξ=1-η。

信道容量:信道在单位时间上能够传输的最大信息量。

平稳信源:概率分布函数与时间起点无关,平稳信源是有记忆的,记忆的长度有限。

香农信息:信息是事物运动状态或存在方式的不确定性的描述。

无记忆信道:在某一时刻信道的输出消息仅与当时的信道输入消息有关,而与前面时刻的信道输入或输出消息无关。

有记忆信道:在任意时刻信道的输出消息不仅与当时信道的输入消息有关,而且还与以前时刻的信道输入消息和(或)输出消息有关。

信道疑义度(含糊度) H(X|Y):表示在输出端接收到Y后,发送端X尚存的平均不确定性。

这个对X尚存的不确定性是由于干扰引起的。

信道散布度H(Y|X):表示在已知X后,对于输出Y尚存的平均不确定性;平均失真度:定义平均失真度为失真函数的数学期望,及d(xi,yi)在X和Y 得联合概率空间P(XY)中的统计平均值:D=E[D(xi,yi)] ,起是在平均的意义上,从总体上对整个系统失真情况的描述。

失真函数d(xi,yj):是人为规定的,给出规定时应该考虑解决问题的需要以及失真可能引起的损失、风险和主观上感觉的差别等因素。

信息论与概率的联系信息论是一门研究信息传输和处理的学科,而概率论是一门研究随机现象的学科。

尽管两者看似不同,但实际上它们之间存在着密切的联系。

本文将探讨信息论与概率的联系,并阐述它们在现实生活中的应用。

一、信息论的基本概念信息论是由克劳德·香农于1948年提出的,它主要研究信息的度量和传输。

信息的度量通常使用信息熵来衡量,信息熵越大,信息的不确定性就越高。

信息熵的计算公式为:H(X) = -ΣP(x)log2P(x)其中,H(X)表示随机变量X的信息熵,P(x)表示随机变量X取值为x的概率。

二、概率论的基本概念概率论是研究随机现象的规律性的数学理论。

它通过概率的定义和性质,研究随机事件的发生规律和概率分布。

概率的计算通常使用频率概率和古典概率等方法。

三、信息论与概率的联系信息论与概率论之间存在着紧密的联系。

首先,信息熵可以看作是概率分布的度量,它反映了随机变量的不确定性。

信息熵越大,表示随机变量的不确定性越高,即信息量越大。

而概率分布越均匀,信息熵越大。

其次,信息论中的条件熵和互信息等概念与概率论中的条件概率和联合概率有着密切的关系。

条件熵表示在已知某一事件发生的条件下,另一事件的不确定性。

互信息表示两个事件之间的相关性,它可以通过条件熵和边际熵的差值来计算。

这些概念在概率论中有着重要的应用,可以用来描述随机事件之间的关联程度。

最后,信息论中的编码理论和信道容量等概念也与概率论有着密切的联系。

编码理论研究如何将信息进行编码和解码,以便在传输过程中减少误差和提高传输效率。

而信道容量则表示在给定信道条件下,能够传输的最大信息量。

这些概念都涉及到概率分布和概率计算,因此与概率论有着紧密的联系。

四、信息论与概率的应用信息论与概率论的联系在现实生活中有着广泛的应用。

首先,在通信领域中,信息论的概念和方法被广泛应用于数据压缩、信道编码和纠错编码等方面。

通过对信息的压缩和编码,可以提高数据传输的效率和可靠性。

《信息论》课程介绍摘要:一、课程背景二、课程目标三、课程内容1.信息论基本概念2.信息熵与信息量3.信道容量与信源编码4.信道编码与解码5.信息论在实际应用中的发展四、课程学习方法与要求正文:《信息论》课程是一门理论性较强的课程,主要研究信息传输、信息处理、信号检测等领域的基本理论。

通过本课程的学习,学生将掌握信息论的基本概念、基本原理和计算方法,了解信息论在实际应用中的发展,提高解决实际问题的能力。

一、课程背景信息论是20 世纪40 年代由香农(Claude Shannon)创立的,它是一门研究信息、通信、计算等领域的理论基础。

信息论不仅关注信息的量度,还关注信息传输的效率和可靠性等问题。

随着信息技术的迅速发展,信息论已成为现代通信技术、数据压缩、信号处理等领域的理论基石。

二、课程目标通过本课程的学习,学生将能够:1.理解信息论的基本概念、基本原理和计算方法;2.掌握信息熵、信息量、信道容量等基本概念,并会进行计算;3.了解信源编码、信道编码和解码的基本原理和方法;4.熟悉信息论在实际应用中的发展,提高解决实际问题的能力。

三、课程内容本课程主要包括以下内容:1.信息论基本概念:包括信息、熵、信息量、信道容量等基本概念,以及它们之间的关系。

2.信息熵与信息量:详细介绍信息熵的定义、性质和计算方法,以及信息量的概念和计算方法。

3.信道容量与信源编码:介绍信道容量的定义、性质和计算方法,以及信源编码的基本原理和方法。

4.信道编码与解码:介绍信道编码的基本原理和方法,以及解码的原理和过程。

5.信息论在实际应用中的发展:介绍信息论在通信技术、数据压缩、信号处理等领域的应用和发展。

四、课程学习方法与要求1.认真阅读教材,掌握课程的基本概念、基本原理和计算方法;2.积极参与课堂讨论,提高解决实际问题的能力;3.完成课后习题,巩固所学知识;4.结合实际应用,加深对课程内容的理解。

信息论原理

信息论是一种研究信息传输和处理的数学理论。

它由克劳德·香农于20世纪40年代提出,被广泛应用于通信、计算机科学和统计学等领域。

信息论的核心概念是信息熵。

熵是表示随机变量不确定性的度量,也可以理解为平均信息的度量。

信息熵越大,表示平均信息越多,不确定性也越大。

通过信息熵的定义,我们可以得到一个重要的定理——香农编码定理。

该定理指出,对于一个离散无记忆信源,它的信息熵可以通过最优编码方式达到最小。

最优编码方式即一种编码方法,能够使得编码的平均长度达到信息熵的下界。

这意味着,我们可以使用更短的编码来传输信息,从而提高信息传输的效率。

除了信息熵和编码定理,信息论还引入了其他重要的概念。

其中之一是互信息,用来度量两个随机变量之间的相关性。

互信息越大,表示两个变量之间的相关性越强,反之亦然。

信息熵和互信息等概念在数据压缩、信道编码和错误纠正码等通信领域的研究中得到了广泛应用。

通过理解和运用信息论的原理,人们可以设计出更高效、可靠的通信系统,提高信息传输的质量和效率。

总之,信息论是研究信息传输和处理的数学理论,通过信息熵

和互信息等概念,可以对信息的不确定性和相关性进行度量,从而提高通信和数据处理的效率和可靠性。

信息论与编码第二版答案第一章:信息论基础1.问题:信息论的基本概念是什么?答案:信息论是一种数学理论,研究的是信息的表示、传输和处理。

它的基本概念包括:信息、信息的熵和信息的编码。

2.问题:什么是信息熵?答案:信息熵是信息的度量单位,表示信息的不确定度。

它的计算公式为H(X) = -ΣP(x) * log2(P(x)),其中P(x)表示事件x发生的概率。

3.问题:信息熵有什么特性?答案:信息熵具有以下特性:•信息熵的值越大,表示信息的不确定度越高;•信息熵的值越小,表示信息的不确定度越低;•信息熵的最小值为0,表示信息是确定的。

4.问题:信息熵与概率分布有什么关系?答案:信息熵与概率分布之间存在着直接的关系。

当概率分布均匀时,信息熵达到最大值;而当概率分布不均匀时,信息熵会减小。

第二章:数据压缩1.问题:数据压缩的目的是什么?答案:数据压缩的目的是通过消除冗余和重复信息,使数据占用更少的存储空间或传输更快。

2.问题:数据压缩的两种基本方法是什么?答案:数据压缩可以通过无损压缩和有损压缩两种方法来实现。

无损压缩是指压缩后的数据可以完全还原为原始数据;而有损压缩则是指压缩后的数据不完全还原为原始数据。

3.问题:信息压缩的度量单位是什么?答案:信息压缩的度量单位是比特(bit),表示信息的数量。

4.问题:哪些方法可以用于数据压缩?答案:数据压缩可以通过以下方法来实现:•无结构压缩方法:如霍夫曼编码、算术编码等;•有结构压缩方法:如词典编码、RLE编码等;•字典方法:如LZW、LZ77等。

第三章:信道容量1.问题:什么是信道容量?答案:信道容量是指在给定信噪比的条件下,信道传输的最大数据速率。

2.问题:信道容量的计算公式是什么?答案:信道容量的计算公式为C = W * log2(1 + S/N),其中C表示信道容量,W表示信道带宽,S表示信号的平均功率,N表示噪声的平均功率。

3.问题:信道容量与信噪比有什么关系?答案:信道容量与信噪比成正比,信噪比越高,信道容量越大;反之,信噪比越低,信道容量越小。

信息论在通信中的应用信息论是研究信息传输和处理的科学,在通信领域有着广泛的应用。

本文将探讨信息论在通信中的应用,并介绍其中的一些重要概念和技术。

一、信息论的基本概念1.1 信息熵信息熵是信息论的基本概念之一,用来衡量信息的平均不确定性。

在通信中,发送方通过编码将消息转化为信号进行传输,接收方通过解码还原原始消息。

信息熵可以帮助我们理解信道的传输能力和编码的效率。

1.2 信道容量信道容量是指在给定信噪比条件下,信道能够传输的最大信息速率。

通信系统的设计就是要使得信道传输的信息速率能够尽可能接近信道容量。

通过对信道容量的分析和计算,可以优化通信系统的性能。

1.3 香农定理香农定理是信息论的核心定理之一,它给出了在给定信噪比条件下,信道容量的理论上界。

根据香农定理,我们可以评估通信系统的性能,并设计出更优化的通信方案。

二、信息论在编码中的应用2.1 奇偶校验码奇偶校验码是一种简单的编码方式,通过在原始数据中添加奇偶位来检测和纠正传输中的错误。

这种编码方式基于信息论的原理,可以帮助我们提高数据的可靠性。

2.2 哈夫曼编码哈夫曼编码是一种无损压缩编码方式,它根据每个符号出现的概率来设计一种最优编码方式,从而减少传输数据的带宽。

哈夫曼编码是一种基于信息论的编码方法,被广泛应用于通信和数据存储系统中。

2.3 循环冗余检测码循环冗余检测码是一种用于检测数据传输中是否发生错误的编码方式。

它基于信息论的原理,通过添加冗余位进行校验,可以有效地检测和纠正传输中的错误。

三、信息论在调制中的应用3.1 调制方式选择在通信系统中,选择合适的调制方式可以提高信号的传输效率和可靠性。

信息论提供了一种理论模型,可以评估不同调制方式的性能,并帮助我们选择最优的调制方式。

3.2 码间干扰码间干扰是指在多载波调制系统中,由于不同载波之间的频谱交叠而引起的干扰现象。

信息论可以用来分析和设计抗码间干扰的调制方案,从而提高系统的性能。

3.3 多天线技术多天线技术是一种通过增加天线数量来提高通信系统性能的方法。

《信息论与编码技术》实验教案第一章:绪论1.1 课程背景介绍信息论与编码技术的起源、发展及应用领域,强调其在现代通信技术中的重要性。

1.2 实验目的使学生了解信息论与编码技术的基本概念,掌握信息论的基本计算方法,培养学生对信息编码的实际操作能力。

1.3 实验要求学生需预习相关理论课程,了解信息论的基本原理,掌握编码技术的基本概念。

第二章:信息论基本概念与计算2.1 信息量计算利用公式计算信息的熵、条件熵、联合熵等,通过实例使学生了解信息量的计算方法。

2.2 信道编码介绍常用的信道编码技术,如Hamming 码、奇偶校验码等,通过实际例子使学生了解编码的原理及应用。

2.3 误码率计算介绍误码率的定义及计算方法,使学生能够评估编码技术的性能。

第三章:数字基带传输3.1 数字基带信号介绍数字基带信号的分类、特点,使学生了解不同基带信号的传输特性。

3.2 基带传输系统分析基带传输系统的组成,了解系统中的主要噪声及影响因素。

3.3 基带传输仿真利用软件对数字基带传输系统进行仿真,使学生了解实际传输过程中的信号波形及误码情况。

第四章:信号检测与解码4.1 信号检测原理介绍信号检测的基本原理,如最大后验概率检测、最小距离检测等。

4.2 解码方法介绍解码的基本方法,如硬判决解码、软判决解码等,使学生了解不同解码方法的优缺点。

4.3 解码仿真利用软件对信号进行解码,分析不同解码方法对系统性能的影响。

第五章:实验总结与分析5.1 实验报告5.2 课程讨论组织学生进行课程讨论,分享实验心得,提高学生对信息论与编码技术的理解和应用能力。

5.3 课后作业布置课后作业,巩固实验内容,提高学生的实际操作能力。

第六章:实验一:信息熵的计算6.1 实验目的理解信息熵的概念,学习如何计算信息熵。

6.2 实验原理介绍信息熵的数学表达式和计算方法。

6.3 实验步骤1. 设置一组数据。

2. 计算信息熵。

3. 分析结果。

6.4 实验注意事项确保数据的准确性和计算的正确性。