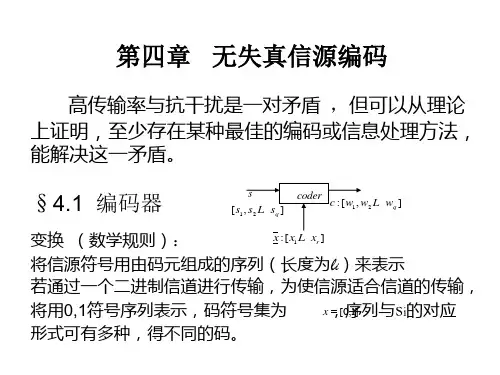

第四章 无失真信源编码

- 格式:ppt

- 大小:1.91 MB

- 文档页数:96

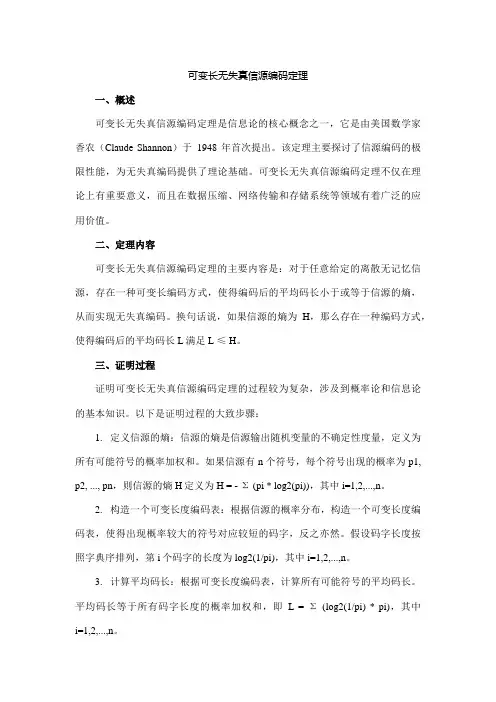

可变长无失真信源编码定理一、概述可变长无失真信源编码定理是信息论的核心概念之一,它是由美国数学家香农(Claude Shannon)于1948年首次提出。

该定理主要探讨了信源编码的极限性能,为无失真编码提供了理论基础。

可变长无失真信源编码定理不仅在理论上有重要意义,而且在数据压缩、网络传输和存储系统等领域有着广泛的应用价值。

二、定理内容可变长无失真信源编码定理的主要内容是:对于任意给定的离散无记忆信源,存在一种可变长编码方式,使得编码后的平均码长小于或等于信源的熵,从而实现无失真编码。

换句话说,如果信源的熵为H,那么存在一种编码方式,使得编码后的平均码长L满足L ≤ H。

三、证明过程证明可变长无失真信源编码定理的过程较为复杂,涉及到概率论和信息论的基本知识。

以下是证明过程的大致步骤:1.定义信源的熵:信源的熵是信源输出随机变量的不确定性度量,定义为所有可能符号的概率加权和。

如果信源有n个符号,每个符号出现的概率为p1, p2, ..., pn,则信源的熵H定义为H = - Σ (pi * log2(pi)),其中i=1,2,...,n。

2.构造一个可变长度编码表:根据信源的概率分布,构造一个可变长度编码表,使得出现概率较大的符号对应较短的码字,反之亦然。

假设码字长度按照字典序排列,第i个码字的长度为log2(1/pi),其中i=1,2,...,n。

3.计算平均码长:根据可变长度编码表,计算所有可能符号的平均码长。

平均码长等于所有码字长度的概率加权和,即L = Σ(log2(1/pi) * pi),其中i=1,2,...,n。

4.证明平均码长小于或等于信源熵:利用不等式性质和概率分布的性质,推导出平均码长L满足L ≤H。

关键在于利用概率分布的不均匀性,通过调整码字长度来最小化平均码长。

5.构造一个解码函数:为了实现无失真解码,需要构造一个解码函数,使得每个码字能够唯一地还原为原始符号。

解码函数可以采用查表法或类似算法实现。

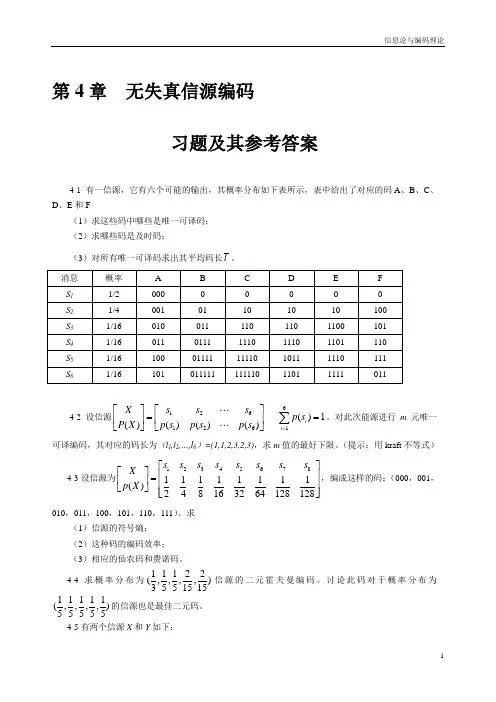

信息论与编码理论-第4章无失真信源编码-习题解答-20071202信息论与编码理论第4章无失真信源编码习题及其参考答案4-1 有一信源,它有六个可能的输出,其概率分布如下表所示,表中给出了对应的码A、B、C、D、E和F(1)求这些码中哪些是唯一可译码;(2)求哪些码是及时码;(3)对所有唯一可译码求出其平均码长。

?X??s14-2 设信源????p(s)P(X)???1s6?p(s2)?p(s6)???s2?p(s)?1。

对此次能源进行m元唯一ii?16可译编码,其对应的码长为(l1,l2,…,l6)=(1,1,2,3,2,3),求m值的最好下限。

(提示:用kraft不等式)?s?X??14-3设信源为??1??p(X)???2?(1)信源的符号熵;(2)这种码的编码效率;s214s3s411816s5132s6s7s8?,编成这样的码:(000,001,111???64128128?010,011,100,101,110,111)。

求(3)相应的仙农码和费诺码。

4-4求概率分布为(,11122信)源的二元霍夫曼编码。

讨论此码对于概率分布为355151511111(,,,,)的信源也是最佳二元码。

555554-5有两个信源X和Y如下:1信息论与编码理论s2s3s4s5s6s7??X??s1??p(X)??0.200.190.180.170.150.100.01?????s2s3s4s5s6s7s8s9??Y??s1??p(Y)??0.490.140.140.070.070.040.020.02 0.01?????(1)用二元霍夫曼编码、仙农编码以及费诺编码对信源X和Y进行编码,并计算其平均码长和编码效率;(2)从X,Y两种不同信源来比较三种编码方法的优缺点。

4-6设二元霍夫曼码为(00,01,10,11)和(0,10,110,111),求出可以编得这样霍夫曼码的信源的所有概率分布。

4-7设信源为?码。

第4章无失真信源编码习题及其参考答案4-1 有一信源,它有六个可能的输出,其概率分布如下表所示,表中给出了对应的码A、B、C、D、E和F(1)求这些码中哪些是唯一可译码;(2)求哪些码是及时码;(3)对所有唯一可译码求出其平均码长l。

4-2 设信源61261126()1()()()()iis s sXp sp s p s p sP X=⎡⎤⎡⎤==⎢⎥⎢⎥⎣⎦⎣⎦∑。

对此次能源进行m元唯一可译编码,其对应的码长为(l1,l2,…,l6)=(1,1,2,3,2,3),求m值的最好下限。

(提示:用kraft不等式)4-3设信源为1234567811111111()248163264128128s s s s s s s sXp X⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦⎢⎥⎣⎦,编成这样的码:(000,001,010,011,100,101,110,111)。

求(1)信源的符号熵;(2)这种码的编码效率;(3)相应的仙农码和费诺码。

4-4求概率分布为11122(,,,,)3551515信源的二元霍夫曼编码。

讨论此码对于概率分布为11111(,,,,)55555的信源也是最佳二元码。

4-5有两个信源X和Y如下:121234567()0.200.190.180.170.150.100.01X s s s s s s s p X ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦123456789()0.490.140.140.070.070.040.020.020.01Y s s s s s s s s s p Y ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦(1)用二元霍夫曼编码、仙农编码以及费诺编码对信源X 和Y 进行编码,并计算其平均码长和编码效率;(2)从X ,Y 两种不同信源来比较三种编码方法的优缺点。

4-6设二元霍夫曼码为(00,01,10,11)和(0,10,110,111),求出可以编得这样 霍夫曼码的信源的所有概率分布。

4-7设信源为12345678()0.40.20.10.10.050.050.050.05X s s s s s s s s p X ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦,求其三元霍夫曼编码。

4。

1 某集源按P (0)=3/4,P(1)=1/4的概率产生统计独立的二元序列.(1) 试求N 0,使当N>N 0时有: P {|I(a i )/N -H(S )| ≥0.05}≤0.01其中H (S)是信源的熵。

(2)试求当N= N 0时典型序列集G εN 中含有的信源序列个数.解:(1) H(S)= —∑Pi ㏒Pi= -3/4㏒(3/4)—1/4㏒(1/4) =0.811 比特/符号根据契比雪夫不等式,对于任意ε>0,当N >N0时,P {∣I(αi)/N – H(S )∣≥ε}≤D[I(Si )]/N ε2现有ε=0.05,欲证原式,只要 D [I(Si )]/N ε2≤0。

01根据信源,D [I (Si)]=∑P (Si )[㏒P(Si)]2– H 2(S)=3/4(㏒3/4)2+1/4(㏒1/4)2—(0。

811)2=0。

471∴N0= D[I(Si)]/0。

01ε2=0.471/0。

01×(0.05)2=18840(2) 序列G εN 是所有N 长的ε典型序列集合,(1-δ)2N [H (S )—ε]≤‖G εN ‖≤2N[H (S )-ε]0.99×214342。

5≤‖G εN ‖≤216226。

54。

2 设无记忆二元信源,其概率为P1=0.005, P0=0。

995.信源输出N =100的二元序列.在长为N =100的信源序列中只对含有3个或小于3个“1”的各信源序列构成一一对应的一组等长码。

(1)求码字所需的最小长度。

(2)计算式(4.27a )中的ε。

(3)考虑没有给予编码的信源序列出现的概率,该等长码引起的错误概率PE 是多少?若从契比雪夫不等式(4。

22)考虑,PE 应是多少?试加以比较。

解:(1)无记忆二元信源()⎢⎣⎡⎥⎦⎤=⎢⎣⎡⎥⎦⎤005.0995.01,0i s P S N=100的扩展信源()()()()()⎢⎢⎢⎣⎡⎥⎥⎦⎤⨯⨯=====⎢⎢⎣⎡⎥⎦⎤--N N N N NN N N i N N N P S 005.0,005.0995.0005.0995.0,995.0111,1011010001121221,,,,,- ααααα 现只对含有3个或小于3个“1”的各信源序列构成一一对应的一组二元等长码。