世纪对弈——AlphaGo围棋胜利的深度透视_图文.ppt

- 格式:ppt

- 大小:952.07 KB

- 文档页数:23

围棋人机大战的启示本月最吸引眼球的事件之一,是AlphaGo与李世乭的五番棋大战。

最终,人工智慧完胜人类顶尖棋手。

这次对弈无论是结局还是过程,都让人感到震撼。

赛前外界的猜测比较分化。

懂技术的坚决看好机器,会下棋的一般都认为李世乭将横扫对手。

我围棋水平很业余,但好歹会下,所以也看好人类。

但是,我的看法在第一盘就被完全逆转。

AlphaGo所表现出的深谋远虑,决不是人类可以企及的。

即便不懂技术也不会下棋的人,只要耐心看完第一盘的直播,再综合一些信息,也会得出同样的结论。

在第一盘中,白(AlphaGo)在第80手吃掉黑掉中上两子,网上讲解的职业棋手都说这一手是臭棋,认为电脑的大局观不行。

确实,白棋似乎有更重要的地方可以走。

白右边大龙还没活,左上角的空可能被黑掏掉,左下星位在黑棋右测厚势面前显得非常单薄。

李世乭在81手正是攻击这颗白子,看起来气势如虹。

此时,观棋的绝大部分职业选手和业余菜鸟都认为黑棋优势明显。

有位高手甚至说,李世乭下好了可以赢20目。

但接下的走势完全出乎意料。

白棋先在左下活出一块,然后打入黑棋右侧空地,占住右下角后,又先手吃掉了右上三子,再点住左上的三三位置。

局面一下变成李世乭要大败了。

而在这一过程中,讲棋的职业选手还在评论机器哪手下得有问题,到很晚才发现“优势局面”已经被逆转。

而AlphaGo团队的负责人赛后透露,机器在第一盘始终认为自己处于领先地位。

也就是说,它不认为自己是逆转取胜,人类以为的优势局面在它眼里根本不存在。

不懂棋的人也可以看出,AlphaGo的计算能力与人类不在一个层面上。

据介绍,对手每走一步,AlphaGo都会找出可能的应手并推演到终局,瞬间形成几百万种局面,然后选择胜率最高的那个。

这种计算能力,人类先天没有,后天怎么努力也练不出来。

所以在第一盘结束后,我就认为李世乭要悲剧了。

李世乭是顶尖的人类高手,有如那吕温侯:头戴三叉束发紫金冠,体挂西川红绵百花袍,身披兽面吞头连环铠,腰系勒甲玲珑狮蛮带,看上去八面威风,不可一世。

围棋基础入门中国古代有四大才艺“琴棋书画”。

其中的“棋”就是围棋,是我国的国粹之一。

围棋不仅是一门科学,还是一门艺术,它可以最大限度地开发智力,启迪思维,锻炼头脑,陶冶情操。

在围棋的对弈中,包含着形象思维、逻辑思维的创作。

它能增强机械记忆和理解记忆,也能提高人们的计算本领。

所以古往今来,围棋的魅力长久不衰。

虽然说围棋是一种智力游戏,想要学会却并不困难,只要懂得一些规则就可以在棋盘上对弈了。

但是想要懂得围棋的乐趣,就不仅是规则那么简单了。

本篇介绍的是初级围棋知识,学会本篇将会达到业余15级左右的水平,可以下一些简单的对局。

认识围棋认识围棋围棋起源于中国古代。

推测起源时间为大约公元前6世纪。

传说尧的儿子丹朱顽劣,尧发明围棋以教育丹朱,陶冶其性情。

围棋的最早可靠记载见于春秋时期的《左传》。

战国时期的弈秋是见于史籍的第一位棋手。

南北朝时候,棋盘定型为现在的19道棋盘,并且出现了评定棋手水平的围棋九品制。

围棋逐渐成为中国古代知识阶层修身养性的一项必修课目,为“琴棋书画”四艺之一。

唐代出现了棋待诏官职。

著名棋手王积薪作“围棋十诀”在现代围棋中依旧适用。

清朝初年,出现了中国古代围棋的发展一个高峰期。

大批著名棋手涌现,留下大量名局棋谱,如黄龙士与徐星友的“血泪篇”,施襄夏与范西屏的“当湖十局”。

同时,围棋理论的研究亦达到一个高峰,代表作有徐星友的《兼山堂弈谱》和施襄夏的《弈理指归》等。

但随后,中国围棋渐渐衰微,围棋发展的中心也转移到日本。

围棋在公元7世纪传入日本,很快就流行于宫廷和贵族之中。

战国末期,丰臣秀吉设立“棋所”,德川幕府时代,出现了在天皇或将军面前对弈的“御城棋”,日本围棋逐渐兴盛,出现了本因坊,安井,井上,林等围棋世家。

其中坊门尤其人才辈出,先后出现了道策、丈和、秀和、秀策、秀甫、秀荣等杰出棋士。

日本围棋由于废除了中国古代围棋的座子制(古代中国围棋是放四个座子,就是两黑两白放在对角星的位置上,双方在这个基础上开始布局),布局理论得以极大发展。

alphago使用的主要算法

AlphaGo是一种强大的人工智能系统,企图击败世界上最强大的人类围棋棋手。

它使用了一种叫做“深度强化学习”的复杂机器学习算法,它利用包括计算机视觉、自然语言处理和游戏决策逻辑在内的众多组件,在一定的范围内,能够像人类一样进行推理,识别游戏的正确策略,从而使用最佳位置移动棋子使得获胜的可能性更大。

AlphaGo使用的主要算法包括卷积神经网络(CNN)、递归神经网络(RNN)以及单步迁移算法等。

其中,卷积神经网络(CNN)是一种由多个层次组成的网络结构,用于识别图像中特定的模式,而递归神经网络(RNN)则是一种神经网络,可用于模拟大脑的记忆和更深层

次的学习过程,它的示例可以帮助AlphaGo识别不同的棋局,以及分析每一步棋的正确策略,从而帮助它赢取比赛。

此外,AlphaGo还使用单步迁移算法,让它根据局面分析出当前最有可能赢得游戏的移动,以及移动最有可能带来胜利的情况。

这些算法在AlphaGo中共同起作用,使它能够为每一步棋做出深思熟虑的判断,并做出正确的决定。

CNN让 AlphaGo够识别图像中的模式,而RNN让它能够模拟人类大脑的学习过程,从而识别棋局的正确策略。

最后,单步迁移算法则可以帮助AlphaGo做出有利的决策,从而推动其一步步击败世界上的人类强棋手。

总的来说,AlphaGo的机器学习算法可以说是一个复杂而有效的系统,通过使用卷积神经网络(CNN)、递归神经网络(RNN)以及单

步迁移算法,AlphaGo能够模拟人类大脑进行推理和抉择,最终帮助

它赢取比赛。

这种算法的使用,也让人们能够更好地理解机器学习,从而推动更多人工智能技术的发展。

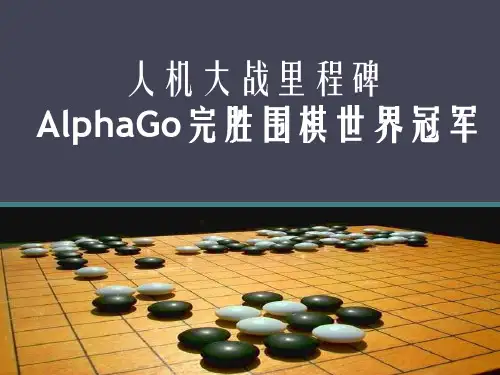

AlphaGo打开新世界早在2016年1月28日,《自然》杂志发表论文,并以封面故事展示了由谷歌旗下人工智能公司DeepMind研发的计算机围棋程序“AlphaGo”,这项程序在此前一项竞赛中以5比0的成绩战胜了欧洲围棋冠军樊麾,2016年3月又以4比1的成绩战胜了世界围棋冠军李世石。

这是有史以来第一次,计算机程序在不让子的情况下,在围棋游戏中击败人类专业高手,而这原本被认为是人工智能在10年后才能达到的成就。

“AlphaGo以无数的棋谱数据为基础‘深度学习’,不断完善,又通过自我模拟对局提高实力。

此外,我们有针对性地进行了很多测试。

所以短短几个月AlphaGO的棋力就能得到显著的提高。

”DeepMind公司的CEO兼谷歌副总裁戴密斯·哈萨比斯(Demis Hassabis)在接受采访时表示。

人工智能最难破解的游戏20多年来,人工智能在大众棋类领域同人类的较量一直存在。

从上世纪90年代中期战胜全世界跳棋顶尖高手的“Chinook”程序,到战胜国际象棋大师卡斯帕罗夫的“深蓝”,通过一代代的更新发展,在这类以智力博弈著称的游戏中,人工智能打败人类,创下纪录。

然而,一直以来,围棋却是个例外。

在这次AlphaGo取得突破性胜利之前,计算机围棋程序虽屡次向人类高手发出挑战,但其博弈水平远远低于人类。

在同职业高段位顶尖棋手的较量中往往只能在“让子”的情况下才能打个平手或是略胜一筹。

2013年日本电脑围棋“Crazy Stone”让四子打败了围棋九段高手石田芳夫,2015年11月韩国专家林宰范研发的“DolBaram”程序在让四子的情况下击败了前超一流棋手赵治勋九段。

出现这种情况的原因就在于围棋特别复杂。

国际象棋平均一回合有35种可能的下法,围棋却高达250种可能。

而且每个走法之后还有另外250种走法。

以此类推。

这意味着,即使最大的超级计算机也难以预测出每个可能下法的结果。

因为围棋招法的变化太多了。