曙光集群用户使用手册

- 格式:doc

- 大小:430.50 KB

- 文档页数:20

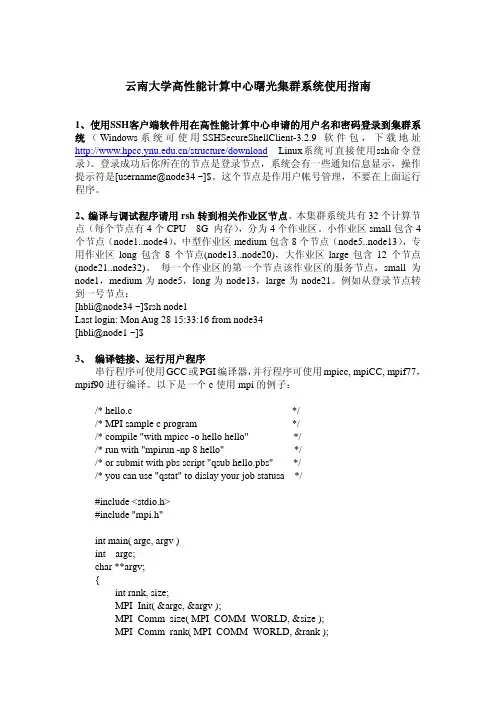

云南大学高性能计算中心曙光集群系统使用指南1、使用SSH客户端软件用在高性能计算中心申请的用户名和密码登录到集群系统(Windows系统可使用SSHSecureShellClient-3.2.9软件包,下载地址/structure/download Linux系统可直接使用ssh命令登录)。

登录成功后你所在的节点是登录节点,系统会有一些通知信息显示,操作提示符是[username@node34 ~]$。

这个节点是作用户帐号管理,不要在上面运行程序。

2、编译与调试程序请用rsh转到相关作业区节点。

本集群系统共有32个计算节点(每个节点有4个CPU 8G 内存),分为4个作业区。

小作业区small包含4个节点(node1..node4),中型作业区medium包含8个节点(node5..node13),专用作业区long包含8个节点(node13..node20),大作业区large包含12个节点(node21..node32)。

每一个作业区的第一个节点该作业区的服务节点,small为node1,medium为node5,long为node13,large为node21。

例如从登录节点转到一号节点:[hbli@node34 ~]$rsh node1Last login: Mon Aug 28 15:33:16 from node34[hbli@node1 ~]$3、编译链接、运行用户程序串行程序可使用GCC或PGI编译器,并行程序可使用mpicc, mpiCC, mpif77,mpif90进行编译。

以下是一个c使用mpi的例子:/* hello.c *//* MPI sample c program *//* compile "with mpicc -o hello hello" *//* run with "mpirun -np 8 hello" *//* or submit with pbs script "qsub hello.pbs" *//* you can use "qstat" to dislay your job statusa */#include <stdio.h>#include "mpi.h"int main( argc, argv )int argc;char **argv;{int rank, size;MPI_Init( &argc, &argv );MPI_Comm_size( MPI_COMM_WORLD, &size );MPI_Comm_rank( MPI_COMM_WORLD, &rank );printf( "Hello world from process %d of %d\n", rank, size );MPI_Finalize();return 0;}可以用如下命令对上面的程序进行编译:$ [hbli@node1 sample]mpicc –o hello hello.c生成可运行的文件hello,用ls –l 命令可以看到生成的可执行文件:$ [hbli@node1 sample]ls –l-rwxrwxr-x 1 hbli hbli 507375 Oct 10 10:39 hello-rw-r--r-- 1 hbli hbli 532 Jun 20 08:01 hello.c这样就可运行hello 这个程序了。

HPC软件环境自动部署工具Clussoft使用手册解决方案中心李斌2012.081.1 Clussoft介绍HPC集群软件环境部署是一项复杂而繁琐的工作。

HPC集群的基础软件众多,各领域的应用软件更是纷繁复杂,软件之间存在复杂的依赖关系,绝大部分软件需要从源代码编译,还需要针对不同的硬件平台或网络环境进行不同的配置和优化,安装部署出错的概率很高,对实施人员的技术经验要求较高。

另外,HPC集群软件如果采用手动安装的方式,工作量巨大,重复劳动很多,效率低下,而且容易出现人为失误。

Clussoft是曙光开发的HPC集群软件环境自动部署工具,提供包括编译器、常用函数库、并行库、GPGPU开发环境、HPC benchmark工具集、以及HPC各领域的常用开源或非商业应用软件的自动安装部署。

Clussoft将各个软件的编译安装都自动化和模块化,自动解决软件依赖关系、自动针对软硬件平台选择优化配置,可以大大减轻集群实施人员的工作量,提高集群部署效率,另外,也实现了HPC软件实施的标准化,提高HPC软件部署的质量。

Clussoft广泛适用于不同规模的HPC集群的部署实施,也可用于HPC云平台的软件快速自动部署。

1.2 Clussoft的组成模块Clussoft采用模块化设计,根据HPC软件类型,分为单独的若干个安装包,各安装包的名称和功能如下:clussoft-base——基础安装包,提供编译器、函数库、并行库等基础软件的安装clussoft-benchmark——HPC benchmark工具集clussoft-md——分子动力学、Monte Carlo等应用软件clussoft-qchem——计算化学、物理、材料类HPC应用软件clussoft-bio——生命科学领域的HPC应用软件clussoft-mets——气象、海洋领域的HPC应用软件clussoft-gpu——GPGPU开发环境及应用软件1.3 Clussoft的兼容性1.3.1 处理器架构Clussoft广泛支持基于Intel或AMD的x86_64处理器。

Clusconf-1.5.1用户手册曙光信息产业股份有限公司解决方案中心马少杰2013年3月目录第1章高性能集群三要素 (3)第2章clusconf功能介绍 (3)2.1 集群配置功能 (3)2.2 集群管理功能 (3)2.3 IPMI配置及管理功能 (4)第3章使用前要求 (4)第4章安装和配置 (4)4.1 安装clusconf (4)4.2 配置/etc/hosts文件 (4)4.3 配置nfs.cfg 文件 (6)4.4 配置ipmi.cfg文件 (7)第5章Clusconf使用帮助 (8)5.1 clusconf 使用选项 (8)5.2 配置操作(setting Operation) (10)5.3 管理操作(Managing Operation) (11)5.4 IPMI相关操作(IPMI Operation) (12)第6章环境变量说明: (14)第1章高性能集群三要素对于一个高性能集群,至少需要满足三个要求:1 全网全通,实现rsh或ssh的无密码访问2 统一的用户信息,可以通过同步用户信息来实现或配置NIS来实现。

3 统一的文件印象,可以通过nfs(或并行文件系统)来实现。

第2章clusconf功能介绍clusconf为一个设置集群并行环境的程序,能够完成Linux系统下的整个集群的配置、管理。

默认为根据/etc/hosts 表来认定集群中所有的节点,可以通过选项-p prefix和-n number 来自己定义集群中的节点包含功能:2.1 集群配置功能1.为某个用户设置ssh 无密码访问(--set-ssh|-ss)2.为所有用户设置rsh 无密码访问(--set-rsh|-sr)3.按照集群规范设置服务(--set-service|-sv)4.设置整个集群的nfs服务(--set-nfs|-sf)5.按照预定的流程一键配置集群(--set-all|-sa)2.2 集群管理功能1.测试全网是否完全通过(--test-net|-tn)2.显示集群信息(--sys-info|-si)3.显示整个集群的cpu负载(负载大于5%的进程) (--disp-cpu|-dc)4.同步整个集群的用户(--sync-user|-yu)5.添加一个用户到整个集群(--useradd|--adduser|-au|-ua username)6.删除一个用户到整个集群(--deluser|--uerdel|-du|-ud username)7.同步整个集群的时间(--sync-time|-yt)8.同步整个集群的某个文件(--sync-file|-yf file|files|path|paths)9.在整个集群上执行相同的命令(--sync-do|-yd command)2.3 IPMI配置及管理功能1.配置ipmi IP地址(--set-ipmi|-si)2.显示ipmi的IP地址及显示电源状态(--ipmi-info|-ii)3.IPMI远程开机(--ipmi-poweron|-in)4.IPMI 远程关机(--ipmi-poweroff|-if)5.IPMI 远程智能开机,可根据集群的角色自动规划开机顺序(--ipmi-ipoweron|-iin)6.IPMI 远程智能关机,可根据集群的角色自动规划开机顺序(--ipmi-ipoweroff|-iif)第3章使用前要求1 整个集群中所有节点操作系统安装好。

曙光天阔 A440 服务器用 手册 阔 0-G 服 用户手使用前,请仔 使 仔细阅读本说 说明书并妥善 善保管,以备 备将来使用声明本手册的用途在于帮助您正确地使用曙光服务器产品(以下称“本产品”), 在安装和第一次使用本产品前,请您务必先仔细阅读随机配送的所有资料, 特别是本手册中所提及的注意事项。

这会有助于您更好和安全地使用本产品。

请妥善保管本手册,以便日后参阅。

本手册的描述并不代表对本产品规格和软、硬件配置的任何说明。

有关本产 品的实际规格和配置,请查阅相关协议、装箱单、产品规格配置描述文件, 或向产品的销售商咨询。

如您不正确地或未按本手册的指示和要求安装、使用或保管本产品,或让非 曙光授权的技术人员修理、变更本产品,曙光将不对由此导致的损害承担任 何责任。

本手册中所提供照片、图形、图表和插图,仅用于解释和说明目的,可能与 实际产品有些差别,另外,产品实际规格和配置可能会根据需要不时变更, 因此与本手册内容有所不同。

请以实际产品为准。

本手册中所提及的非曙光网站信息,是为了方便起见而提供,此类网站中的 信息不是曙光产品资料的一部分,也不是曙光服务的一部分,曙光对这些网 站及信息的准确性和可用性不做任何保证。

使用此类网站带来的风险将由您 自行承担。

本手册不用于表明曙光对其产品和服务做了任何保证,无论是明示的还是默 示的,包括(但不限于)本手册中推荐使用产品的适用性、安全性、适销性和 适合某特定用途的保证。

对本产品及相关服务的保证和保修承诺,应按可适 用的协议或产品标准保修服务条款和条件执行。

在法律法规的最大允许范围 内,曙光对于您的使用或不能使用本产品而发生的任何损害(包括,但不限于 直接或间接的个人损害、商业利润的损失、业务中断、商业信息的遗失或任 何其他损失),不负任何赔偿责任。

对于您在本产品之外使用本产品随机提供的软件,或在本产品上使用非随机 软件或经曙光认证推荐使用的专用软件之外的其他软件,曙光对其可靠性不 做任何保证。

曙光MPI用户手册(TC1700 & TC4000L)曙光信息产业有限公司2003-9目录MPI的使用 (1)1.MPI简介 (1)2.MPI的程序设计 (1)2.1 MPI的基本功能 (1)2.2 MPI的几个重要元素 (2)2.3 消息 (2)2.4 point-to-point通信 (3)2.5 集群通信 (5)3. MPI应用程序的编译 (6)3.1 环境设置 (6)3.2 make (6)3.3 mpif77和mpicc (7)4. MPI应用程序的运行 (8)5. 常见问题分析 (8)附录MPI函数简表 (9)MPI的使用1.MPI简介MPI(M essage P assing I nterface)是消息传递接口的标准,当前通用的是MPI1.2规范。

不久前制定的MPI2.0规范除支持消息传递外,还支持MPI的I/O规范和进程管理规范。

MPI正成为并行程序设计事实上的工业标准。

MPICH含三层结构,最上层是MPI的API,基本是点到点通信和点到点通信基础上构造的集群通信(Collective Communication);中间层是ADI层(Abstract Device Interface),其中device可以简单地理解为某一种底层通信库,ADI就是对各种不同的底层通信库的不同接口的统一标准;最下层是具体的底层通信库,例如工作站机群上的p4通信库。

MPICH在不同平台上的实现都是根据不同的device(即平台或底层通信)实现不同的ADI 接口,这种实现机制的好处有:将与device有关和无关的代码分开,减小实现难度;利于MPI的不断升级;提高MPI的性能。

2.MPI的程序设计2.1 MPI的基本功能MPI1.2标准中没有对如何产生多个MPI进程作标准性规定,而把这一工作交给了具体的实现。

但是它有如下众所周知的假设:静态加载,即所有进程在加载完以后就全部确定,直至整个程序结束才终止,在程序正常运行期间没有进程的创建和结束。

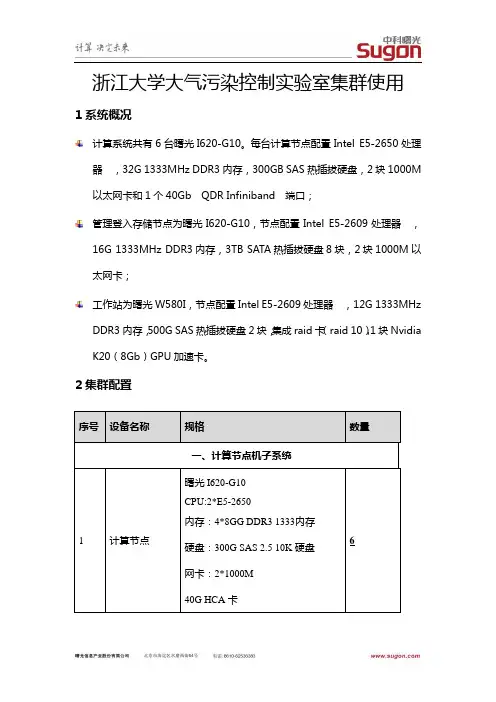

浙江大学大气污染控制实验室集群使用1系统概况计算系统共有6台曙光I620-G10。

每台计算节点配置Intel E5-2650处理管理登入存储节点为曙光I620-G10,节点配置Intel E5-2609处理器,16G工作站为曙光W580I,节点配置Intel E5-2609处理器,12G 1333MHz2集群配置3 节点配置及IP4. 账号管理该集群中有两个用户组,即apclab与visitor组,本实验组人员归apclab组管理,外来游客归visitor组管理。

(1)创建用户(apclab组)[root@node1 home]# clusconf -au test1REMOTE_SH using ssh/scpOperation is done in following hosts:node1 node2 node3 node4 node5 node6 node7node3: ssh: connect to host node3 port 22: No route to hostpdsh@node1: node3: ssh exited with exit code 255Now add user: test1 on the Whole cluster5.. 4.. 3.. 2.. 1..Input the Home directory for user:test1[/public/home/test1]: /public/home/apclab /test1Input the Group Name for user:test1[users]: apclabInput the uid for user:test1[504]:Changing password for user test1.New password:Retype new password:passwd: all authentication tokens updated successfully.Now Synchronize user and group on the Whole cluster5.. 4.. 3.. 2.. 1..========node1=================node2=================node3=================node4=================node5=================node6=================node7=========adduser test1 on the whole cluster successfully!初始密码:apclab;123(2)创建用户(visitor组)[root@node1 home]# clusconf -au guest1REMOTE_SH using ssh/scpOperation is done in following hosts:node1 node2 node3 node4 node5 node6 node7node3: ssh: connect to host node3 port 22: No route to hostpdsh@node1: node3: ssh exited with exit code 255Now add user: guest1 on the Whole cluster5.. 4.. 3.. 2.. 1..Input the Home directory for user:guest1[/public/home/guest1]: /public/home/visitor/guest1 Input the Group Name for user:guest1[users]: visitorInput the uid for user:guest1[505]:Changing password for user guest1.New password:BAD PASSWORD: it does not contain enough DIFFERENT charactersBAD PASSWORD: is a palindromeRetype new password:passwd: all authentication tokens updated successfully.Now Synchronize user and group on the Whole cluster5.. 4.. 3.. 2.. 1..========node1=================node2=================node3=================node4=================node5=================node6=================node7=========adduser guest1 on the whole cluster successfully!初始密码:111111(3)删除用户[root@node1 home]# clusconf -du test2REMOTE_SH using ssh/scpOperation is done in following hosts:node1 node2 node3 node4 node5 node6 node7node3: ssh: connect to host node3 port 22: No route to hostpdsh@node1: node3: ssh exited with exit code 255Now del user: test2 on the Whole cluster5.. 4.. 3.. 2.. 1../public/home/test2Do you want to delete Home path: /public/home/test2 for test2(n/y)[n]: y(删去家目录,节省空间)Now Synchronize user and group on the Whole cluster5.. 4.. 3.. 2.. 1..========node1=================node2=================node3=================node4=================node5=================node6=================node7=========deluser test2 on the whole cluster successfully!(4)apclab组的共享目录(/public/home/apclab/test1)/public/home/apclab/test1,目前所设置的权限为只读,设置方法:[root@node1 apclab]# chmod 750 /public/home/apclab/test1 -R如果设置的权限为可读可写,设置方法:[root@node1 apclab]# chmod 770 /public/home/apclab/test1 –R5.存储使用管理目前分别有两个存储资源,即/dev/sdb,/dev/sdc分别挂在/public,/data; /public目录通过NFS方式映射给node2~7节点使用;/data通过NFS方式映射给com-gpu节点使用。

I240-G20用户手册DAWNING INFORMATION INDUSTRY CO.,LTD.声明本手册的用途在于帮助您正确地使用曙光公司服务器产品(以下称“本产品”),在安装和第一次使用本产品前,请您务必先仔细阅读随机配送的所有资料,特别是本手册中所提及的注意事项。

这会有助于您更好和安全地使用本产品。

请妥善保管本手册,以便日后参阅。

本手册的描述并不代表对本产品规格和软硬件配置的任何说明。

有关本产品的实际规格和配置,请查阅相关协议、装箱单、产品规格配置描述文件,或向产品的销售商咨询。

如您不正确地或未按本手册的指示和要求安装、使用或保管本产品,或让非曙光公司授权的技术人员修理、变更本产品,曙光公司将不对由此导致的损害承担任何责任。

本手册中所提供照片、图形、图表和插图,仅用于解释和说明目的,可能与实际产品有些差别,另外,产品实际规格和配置可能会根据需要不时变更,因此与本手册内容有所不同。

请以实际产品为准。

本手册中所提及的非曙光公司网站信息,是为了方便起见而提供,此类网站中的信息不是曙光公司产品资料的一部分,也不是曙光公司服务的一部分,曙光公司对这些网站及信息的准确性和可用性不做任何保证。

使用此类网站带来的风险将由您自行承担。

本手册不用于表明曙光公司对其产品和服务做了任何保证,无论是明示的还是默示的,包括(但不限于)本手册中推荐使用产品的适用性、安全性、适销性和适合某特定用途的保证。

对本产品及相关服务的保证和保修承诺,应按可适用的协议或产品标准保修服务条款和条件执行。

在法律法规的最大允许范围内,曙光公司对于您的使用或不能使用本产品而发生的任何损害(包括,但不限于直接或间接的个人损害、商业利润的损失、业务中断、商业信息的遗失或任何其他损失),不负任何赔偿责任。

对于您在本产品之外使用本产品随机提供的软件,或在本产品上使用非随机软件或经曙光公司认证推荐使用的专用软件之外的其他软件,曙光公司对其可靠性不做任何保证。

曙光集群系统(Pluto)简明用户手册(第2版)1.系统介绍曙光集群系统(命名为Pluto)共有172个计算节点(140个刀片节点,16个MIC节点,16个GPU节点),5个登录节点。

集群系统所有登录节点和计算节点的操作系统均为64位Redhat7.2。

系统采用Intel Omni-Path高速计算网络,曙光Parastor200全局并行存储系统。

全系统峰值性能为211.2Tflop/s。

计算节点的硬件配置如下:●所有刀片计算节点、MIC计算节点、GPU计算节点均配置2颗Intel E5-2680 v3处理器,每个处理器12核,每节点共24核;64 GB DDR4 ECC 2133MHz内存。

●每台MIC计算节点配置1块Intel Xeon Phi 5110P加速卡(1.011TFlops)。

●每台GPU计算节点配置1块NVIDIA TESLA K80 GPGPU加速卡(2.911TFlops)。

2.系统登录及文件传输2.1.系统登录首先使用Xshell、SecureCRT等软件登录到前端机(IP:218.249.35.43)。

登陆进前端机后,再用命令ssh 帐号@pluto登录到新曙光(pluto)系统。

2.2.文件拷贝用scp命令在前端机与新曙光(pluto)之间完成文件拷贝,新老曙光系统间的文件拷贝同样用scp命令。

3.程序编译运行环境集群系统部署的编译器既包含Linux操作系统自带的GNU c/c++/fortran(版本4.8.5)编译器,也提供了Intel/MPI多个版本的c/c++/fortran的编译器,以及支持NVIDIA GPU 程序编译的CUDA toolkit。

此外,集群系统还部署了Mvapich2/OpenMPI/IntelMPI等多个版本的MPI 库,可以支持OpenMP和MPI两种并行方式。

3.1.环境变量设置方法用户可以采用下面的方法来快速设置环境变量:方法一、运行脚本文件加载环境变量。

曙光IPMI系统管理平台用户使用指南(总10页)曙光I P M I系统管理平台用户使用指南(总10页)-CAL-FENGHAI.-(YICAI)-Company One1-CAL-本页仅作为文档封面,使用请直接删除用户使用指南目录概述........................................................................................................................... 错误!未指定书签。

智能平台管理接口(IPMI)................................................................... 错误!未指定书签。

基板管理控制器(BMC)....................................................................... 错误!未指定书签。

IPMI的相关配置 ...................................................................................................... 错误!未指定书签。

获取/配置IP地址等信息........................................................................ 错误!未指定书签。

1.在BIOS下进行配置 ........................................................................ 错误!未指定书签。

2.用DOS工具进行获取/配置 ........................................................... 错误!未指定书签。

1. 登录和文件传输登录方式为ssh,与telnet功能类似,推荐的登录工具为putty或者Secure Shell (/html/download/ser/20070917/35112.html,绿色版无需安装)在地址栏输入本集群的登录地址(node1对应的局域网IP),点击“打开”,就会出现登录窗口,输入用户名、密码即可。

文件传输为sftp,与传统ftp类似,但其协议更安全可靠,推荐工具为filezilla。

(https:///p/filezilla/download?filename=FileZilla_3.3.2_win32.zip,绿色版无需安装)输入登录地址222.222.21.29,输入用户名和密码,端口填22(本软件支持ftp,端口为21),点击快速连接,即可使用,操作办法与常用ftp工具类似。

2. 图形窗口支持Linux推荐使用vnc。

vnc可以将用户的操作状态保持在服务器端,即使断开连接也不会影响到正在进行的操作、计算等。

登录到linux服务器中,在命令行运行vncserver。

第一次运行时需要输入VNC登陆用的密码:根据提示输入新的vnc密码。

此密码与用户登录密码无关,将在登录vnc时需要。

此处提示的node1:2即为vnc成功打开的端口。

运行vncclient,输入登录服务器地址和端口号,点确定,输入前面设置的密码,即进入了图形窗口。

注意:1、在第一次启动了vncserver之后,vnc的连接一直可用,全部图形窗口保持在Linux 服务器上。

因此,只在每次服务器重新启动后运行一次vncserver即可,由于用户较多,请勿启动多个。

2、如果需要使用node2的图形界面,可执行ssh -X node2。

3. 作业提交3.1. Fluent3.1.1. 图形方式运行首先通过VNC登陆到图形界面,如果没有Terminal的话在桌面点击左键选择Xterm,输入以下命令即可运行:此处myhosts为用户指定的host文件,内容如下所示:node1node1node1node1node2node2node2node2-t8即指定8个核心参与计算,分别为node1上的4个核心和node2上的4个核心。

在图形界面下导入cas和data文件,修改和设置边界条件等并计算(和在windows下操作单机版Fluent相同,略):注:通过VNC使用图形界面方式运行fluent时,无需保持PC机与服务器的连接,只要vncserver没有重新启动,即可随时连接到原有的窗口。

3.1.2. 命令行方式运行建立script1文件:script1内容如下:(注:其中fl5m1.cas为cas文件名,根据实际进行修改;solve/iterate 25 表示迭代25步,也可根据需要修改步数。

)用命令行进行fluent计算:此处myhosts为用户指定的host文件,内容如下所示:node1node1node1node1node2node2node2node2-t8即指定8个核心参与计算,分别为node1上的4个核心和node2上的4个核心。

3.1.3. 作业调度方式运行注:PBS只持Fluent命令行运行方式的作业提交1.编译脚本script1,内容如下(与上面脚本运行方式相同):file/rcd fl5m1.cas.gzsolve/iterate 25/file/wcd fl5m1_final.datparallel/timer/usageexityes2.编辑pbs脚本fluent.pbs,内容如下:#!/bin/bash#PBS -N job1-8cpu#PBS -l nodes=1:ppn=8#PBS -j oeINPUTFILE=script1OUTPUTFILE=script1.logcd $PBS_O_WORKDIR## pib.dapl indicate using ib protocal and the udapl way. t8 indicates using# 8 processors#NP=`cat $PBS_NODEFILE | wc -l`datefluent 3d -t$NP -cnf=$PBS_NODEFILE -g -i $INPUT >& $OUTPUTdateexit 0提交作业:qsub fluent.pbs用qstat -a和pbsnodes -a以及top命令查看作业是否正常排队运行。

注:红色字体部分需要根据实际情况改动,黑色字体为固定格式的内容。

3.1.4. 获取计算结果1.如果用图形界面的方式运行fluent,可以在菜单中选择选择保存dat文件到当前工作目录或其他某个目录下,然后用ftp软件将dat文件下载到终端pc机上,即可进行后处理。

2.如果用命令行的方式运行fluent,dat文件自动保存到当前目录,文件名由script1文件的内容决定(例如“file/wcd fl5m1_final.dat”则表示dat文件为fl5m1_final.dat),用软件将dat文件下载到终端pc机上,即可进行后处理。

3.2. Ansys作业3.2.1. 图形方式运行通过vnc登录以后,运行launcher121,即可进入ansys界面,选择相关的模块点击run 即可。

3.2.2. 命令行方式运行在命令行方式下,不能进行交互的图形操作,所有的命令需要通过命令流来实现。

假设写好的命令流文件为input.inp,运行方式如下:单节点:ansys121 -np 16 -i input.inp >& output.log &多节点运行:ansys121 -dis -machines node1:16:node2:16 -i input.inp >& output.log &3.2.3. 作业调度方式运行编写一个pbs脚本ansys.pbs如下所示:#PBS -j oe###################what you just need and could edit are between the two lines#######################PBS -N my_ansys_test#PBS -l nodes=1:ppn=16INPUTFILE=wing.inpOUTPUTFILE=wing.log###############################################theend##############################################cd $PBS_O_WORKDIRnp=1for NODE in `cat $PBS_NODEFILE`; dohost=$NODEif [ ! -z $lasthost ]; thenif [ $host = $lasthost ]; thennp=`expr $np + 1`elseif [ -z $mList ]; thenmList=$lasthost:$npelsemList=$mList:$lasthost:$npnp=1fifilasthost=$hostdoneif [ -z $mList ]; thenmList=$lasthost:$npelsemList=$mList:$lasthost:$npfiansys121 -dis -machines $mList -i $INPUTFILE -o $OUTPUTFILE写完以后提交方式与fluent相同,qsub ansys.pbs即可。

3.3. CFX作业3.3.1. 图形方式运行在图形窗口中运行cfx5即可。

3.3.2. 命令行方式运行CFX支持PVM和MPI两种方式的并行,通常MPI的性能更好一些,建议采用。

同时还有Local和Distributed两种运行模式,单机上建议采用Local模式,而跨节点时只能采用Distributed模式。

cfx5solve命令可直接进入求解模式。

cfx5solve -def Benchmark.def -par-dist 'node1*8'在本机上用8个核心并行cfx5solve -def Benchmark.def -par-dist 'node1*8,node2*8'采用2个节点各8个核心进行分布式并行计算3.3.3. 作业调度方式运行[test@node34 cfxbm]$ cat pbs_cfx.ib#!/bin/bash#PBS -N CFX_8cpu#PBS -l nodes=1:ppn=8INPUTFILE=Benchmark.defOUTPUTFILE=Benchmark.log############################################################## ########## You don't need to modify the lines below ######################################################################## PeHostfile2MachineFile(){cat $1 | while read line; do# echo $linehost=`echo $line`# add here code to map regular hostnames into ATM hostnamesif [ -z $mList ]; thenmList=$host"*1"elsemList=$mList,$host"*1"fiecho $mListdone}CFX_PBS_NODEFILE="/tmp/cfx_`whoami`_$PBS_JOBID"PeHostfile2MachineFile $PBS_NODEFILE | sed "s#bnode#node#g" >$CFX_PBS_NODEFILENPROCS=`wc -l $PBS_NODEFILE`cd $PBS_O_WORKDIRcfx5solve -def $INPUTFILE -par-dist `tail -n1 $CFX_PBS_NODEFILE`写完脚本就可以按如下方式提交作业:[test@node34 cfxbm]$ qsub cfx.pbs3.4. ABAQUS作业3.4.1. 图形方式运行在图形窗口中运行abaqus cae即可。