信息论讲义(2讲)

- 格式:pdf

- 大小:564.40 KB

- 文档页数:88

《信息论》研究生课程讲义2-5 平均互信息量的特性平均交互信息量IX,Y在统计平均的意义上,描述了信源、信道、信宿组成的通信系统的信息传输特性。

这一节将进一步讨论IX,Y的数学特性,重点介绍其特性的结论和其物理意义。

2-5-1 IX,Y的非负性当x为大于0的实数时,底大于1的对数logx是x的严格上凸函数,可以证明若fx为上凸函数,则有:f∑pixi≥∑pifxi,如fxlogx,则有:log∑pixi≥∑pilogxi根据这个关系,考虑平均互信息量,IX,Y ∑∑pxi,yjlog[pxi,yj/pxipyj]则:-IX,Y ∑∑pxi,yjlog[pxipyj/pxi,yj]≤log∑∑pxi,yj[pxipyj/pxi,yj]log∑pxi ∑pyj0所以有:IX,Y ≥0只有当PX,YPXPY,即对于所有的i1,2,…n, j1,2,…m。

都有:pxi,yjpxipyj,才有:IX,Y0互信息量可能出现负值,但平均互信息量不可能出现负值。

接收者收到一个Y的符号,总能从中获取道关于信源X的信息量,只有当XY相互独立时,平均互信息量才为0。

由IX,YHX-HX/Y,可知,在信息传输过程中,后验熵不可能大于先验熵,这种特性称为后熵不增加原理。

当XY相互独立时,pxi,yjpxipyj可得:HX,YHX+HY当XY相互独立时,pyj/xipyj可得:HY/XHY当XY相互独立时,pxi/yjpxi可得:HX/YHX由互信息量的定义可知:IX,YHX+HY-HX,YHX-HX/YHY-HY/X02-5-2 平均互信息量的交互性由于pxi,yjpyj,xi则:IX,YIY,X交互性表明在Y中含有关于X的信息,IX,Y;在X中含有关于Y的信息,IY,X;而且两者相等。

实际上IX,Y和IY,X只是观察者的立足点不同,对信道的输入X 和输出Y的总体测度的两种表达形式。

两个园相交的部分为平均互信息量,可见,平均互信息量的大小体现了X和Y 的相关程度。

![信息论基础课件2[1][1].1.1- 2](https://uimg.taocdn.com/5d523fd3360cba1aa811da2f.webp)

第一章绪论主要内容:(1)信息论的形成和发展;(2)信息论研究的分类和信息的基本概念;(3)一般通信系统模型;(4)目前信息论的主要研究成果。

重点:信息的基本概念。

难点:消息、信号、信息的区别和联系。

说明:本堂课作为整本书的开篇,要交待清楚课程开设的目的,研究的内容,对学习的要求;在讲解过程中要注意结合一些具体的应用实例,避免空洞地叙述,以此激发同学的学习兴趣,适当地加入课堂提问,加强同学的学习主动性。

课时分配:2个课时。

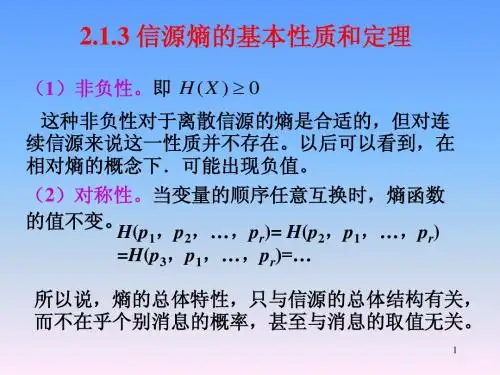

板书及讲解要点:“信息”这个词相信大家不陌生,几乎每时每划都会接触到。

不仅在通信、电子行业,其他各个行业也都十分重视信息,所谓进入了“信息时代”。

信息不是静止的,它会产生也会消亡,人们需要获取它,并完成它的传输、交换、处理、检测、识别、存储、显示等功能。

研究这方面的科学就是信息科学,信息论是信息科学的主要理论基础之一。

它研究信息的基本理论(Information theory),主要研究可能性和存在性问题,为具体实现提供理论依据。

与之对应的是信息技术(Information Technology),主要研究如何实现、怎样实现的问题。

它不仅是现代信息科学大厦的一块重要基石,而且还广泛地渗透到生物学、医学、管理学、经济学等其他各个领域,对社会科学和自然科学的发展都有着深远的影响。

1.1 信息论的形成和发展信息论理论基础的建立,一般来说开始于香农(C.E.shannon)研究通信系统时所发表的论文。

随着研究的保深入与发展,信息论具有了较为宽广的内容。

信息在早些时期的定义是由奈奎斯持(Nyquist,H.)和哈特莱(Hartley,L.V.R.)在20世纪20年代提出来的。

1924年奈奎斯特解释了信号带宽和信息速率之间的关系;1928年哈特莱最早研究了通信系统传输信息的能力,给出了信息度量方法;1936年阿姆斯特朗(Armstrong)提出了增大带宽可以使抗干扰能力加强。

这些工作都给香农很大的影响,他在1941—1944年对通信和密码进行深入研究,用概率论的方法研究通信系统,揭示了通信系统传递的对象就是信息,并对信息给以科学的定量描述,提出了信息嫡的概念。

第二章信源与信息熵主要内容:(1)信源的描述与分类;(2)离散信源熵和互信息;(3)离散序列信源的熵;(4)连续信源的熵和互信息;(5)冗余度。

重点:离散/连续信源熵和互信息。

难点:离散序列有记忆信源熵。

说明:本章内容主要针对信源,但是很多基本概念却是整个信息论的基础,所以安排了较多课时。

由于求熵涉及一些概率论的基础知识,考虑到大四的同学可能对这部分知识已经遗忘,故适当复习部分概率论知识。

较难的 2.1.2节马尔可夫信源部分放置在本章最后讲,便于同学理解。

本章概念和定理较多,比较抽象,课堂教学时考虑多讲述一些例题,通过例题来巩固概念和消化定理。

作业:2.1—2.7,2.10,2.12。

课时分配:10课时。

板书及讲解要点:在信息论中,信源是发出消息的源,信源输出以符号形式出现的具体消息。

如果符号是确定的而且预先是知道的,那么该消息就无信息而言。

只有当符号的出现是随机的,预先无法确定,一旦出现某个符合就给观察者提供了信息。

因此应该用随机变量或随机矢量来表示信源,运用概率论和随机过程的理论来研究信息,这就是香农信息论的基本点。

2.1 信源的描述与分类在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。

信源:产生随机变量、随机序列和随机过程的源。

信源的基本特性:具有随机不确定性。

信源的分类连续信源:话音、图像——随机过程离散信源:输出在时间和幅度上都是离散分布的消息。

1213消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。

发出单个符号的无记忆信源离散无记忆信源: 发出符号序列的无记忆信源离散信源离散有记忆信源: 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源概率论基础:无条件概率,条件概率和联合概率的性质和关系: (1) 非负性0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, (2) 完备性111111()1,()1,(/)1,(/)1,()1nmnijiji j i mm nji i j j j i p x p y p x y p yx p x y ===========∑∑∑∑∑∑11()(),()()n mijjijii j p x y p y p x y p x ====∑∑(3) 联合概率()()(/)()(/)()()()(/)()(/)()i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,,(4) 贝叶斯公式11()()(/)(/)()()i j i j i j j i nmijiji j p x y p x y p x y p y x p x y p x y ====∑∑,2.1.1 无记忆信源:例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。

信息论第2讲北京航空航天大学201教研室陈杰buaa201gcss@ PWD:buaaf6152第一章小结1.信息论:经典信息论工程信息论广义信息论2.信息的概念:通俗信息概念广义信息概念概率信息概念3.信息:抽象概念,研究对象,含于消息消息:比较具体,非物理量,信息的载荷者信号:最具体,表示消息的物理量,可测量、可显示、可描述,消息的载荷者4.通信系统的模型:第一章小结(续)通信系统干扰源窃听者模型32.5 连续随机变量的互信息和相对熵2.5.1 连续随机变量的互信息⎯定义⎯熵的性质2.5.2 连续随机变量的相对熵⎯连续随机变量的自信息量⎯相对熵、联合熵、条件熵⎯性质45•连续随机变量的互信息连续随机变量集XY ,事件x , p (x ) ≥0和事件y , p (y ) ≥0之间的互信息定义为00()() lim log ()()x y p x y p y x y p x xp y y Δ→Δ→ΔΔ=ΔΔ00()(;)lim log ()def x y p x y x I x y p x xΔ→Δ→Δ=Δ() log ()()p xy p x p y =6•连续随机变量的平均互信息连续随机变量集合X 和Y 之间的平均互信息量(Mutual Information)定义为()(;)()log ()()def p xy I X Y p xy dxdy p x p y ∞−∞=∫∫7•连续随机变量的平均互信息的性质(1)非负性当且仅当连续随机变量X 和Y 统计独立时等号成立。

(2)对称性(;)0I X Y ≥(;)(;)I X Y I Y X =8•连续随机变量令随机变量X 的取值区间是(a ,b ),a <b ,把它分成n 段,等间隔,那么X 处于第i 个小区间的概率为事件x i <x i +Δ的自信息量为b a n −Δ=()i i p p x Δ=⋅Δlog log[()]i i p p x −Δ=−⋅Δ9•连续r.vX 的平均自信息量为•当n →∞,Δi →0时,定义绝对熵()()log[()]i i iH X p x p x Δ=−⋅Δ⋅⋅Δ∑()H X Δ→∞0()log H X Δ=-()[log ()]()[log ]i i i i ip x p x p x =−⋅⋅Δ−⋅Δ⋅Δ∑∑10•连续随机变量的相对熵(Differential Entropy)称为连续随机变量的相对熵,或微分熵,简称为熵。

()()log ()C H X p x p x dx ∞−∞=−∫11•连续r.v.的联合熵(Joint Entropy)•连续r.v.的条件熵(Conditional Entropy)()()log ()C H XY p xy p xy dxdy∞−∞=−∫∫(|)()log (|)C H X Y p xy p x y dxdy∞−∞=−∫∫•性质(1)(2)(3)()()()C C CH XY H X H Y X=+()()()C C CH XY H Y H X Y=+(;)(;)()(|)()(|)C CC CI X Y I Y XH X H X YH Y H Y X==−=−(|)()(|)()C CC CH X Y H XH Y X H Y≤≤1213例2.10连续随机变量X ,其概率密度函数(1) 试求信源X 的熵H c (X );(2) 试求Y = X + A (A > 0)的熵H c (Y);(3) 试求Y = 2X 的熵H c (Y )。

⎩⎨⎧≤≤=其他0)(2a x bxx p14解:(1)2()()log ()()log c R RH X f x f x dx f x bx dx=−=−∫∫2log ()()log RRb f x dx f x x dx=−⋅−∫∫2log 2log Rb b x xdx=−−∫332 log log9ba ab e =−−33(),()133X X bx baF x F a ===∵32()log log 3c aH X b bite∴=−−⋅15解:(2)00, x a y A a ≤≤⇒≤−≤∵()()Y F y P Y y =≤2()()()f y F y b y A ′∴==−2()log ()R f y b y A dy=−−∫()()log ()c RH Y f y f y dy =−∫332log log 9ba ab bite=−− A y a A∴≤≤+2log 2()log()()Rb b y A y A d y A =−−−−−∫3()13Y ba F a A ⇒+==32log log 3ab bite=−−⋅23()3y A A b bx dx y A −==−∫()P X A y =+≤()P X y A =≤−16解:(3)002yx a a ≤≤⇒≤≤∵()()Y F y P Y y =≤2()()8b f y F y y′∴==2()log8Rb f y y dy=−∫()()log ()c RH Y f y f y dy =−∫333292log log 93ba a bab bite −=−−+02y a∴≤≤2log ()()log 8R R b f y dy f y y dy=−⋅−∫∫3(2)13Y ba F a ⇒==32()log log 1 3c aH Y b bite∴=−−⋅+2320 24yb bx dx y ==∫(2)P X y =≤()2yP X =≤17第二章小结⎯信息的描述1.自信息量:简单事件联合事件2.条件自信息量:3.互信息量:4.条件互信息量:()()log defi i I x p x =−()()log defi j i j I x y p x y =−()()|log |defi j i j I x y p x y =−(|)log()defi j i p x y p x =(|)(;|)log(|)i j k i j k i k p x y z I x y z p x z =I (x i ;y j )11log log()(|)i i j p x p x y =−自信息量条件信息量(;)(;)i j k i j I x y z I x y =−18第二章小结⎯信息的度量1.信息熵:2.条件熵:3.联合熵:4.平均互信息量:()1()log ()qdefi i i H X p x p x ==−∑(,)()()defi j i j XYH X Y p x y I x y =∑(;)()(;)defj j YI X Y p y I X y =∑()()()defi j j i XYH Y X p x y I y x =∑()log()def i j j i XYp x y y x =−∑()log ()def i j i j XYp x y p x y =−∑ ()(;)defi j i j XYp x y I x y =∑19⎯信息的度量1.信息熵数学性质•对称性:H (p 1, p 2, …p q )= H (p 2, p 1,…p q )•非负性: H (p 1, p 2, …p q ) ≥0•扩展性: •可加性•极值性:•确定性:•上凸性: H (X )是(p 1, p 2, …p q )的上凸函数112120lim (,,,,)(,,,)q q q q H p p p H p p p εεε+→−= 12(,,,)log n H p p p n≤ (1,0)(1,0,0)(1,0,0,0)(1,0,,0)0H H H H =====20⎯信息的度量1.平均互信息量的性质:•非负性•互易性(对称性)•极值性•凸函数性(;)0I X Y ≥(;)()(;)()I X Y H X I X Y H Y ≤≤(;)(;)I X Y I Y X =21⎯信息的度量各种熵的关系:•联合熵与信息熵、条件熵的关系•共熵与信息熵的关系•条件熵与通信熵的关系(,)()()H X Y H X H Y X =+()()H Y H X Y =+(,)()()H X Y H X HY ≤+()()()()HY X HY H XY H X ≤≤22⎯信息的度量(;)()()()()I X Y H X H X Y H Y H Y X =−=−(;)()()(,)I X Y H X H Y H X Y =+−平均互信息和各类熵的关系23第二章小结⎯连续型随机变量的熵1.平均互信息:(Mutual Information)2.平均自信息量:绝对熵:相对熵:3.联合熵:(Joint Entropy)4. 条件熵:(Conditional Entropy)()(;)()log ()()defp xy I X Y p xy dxdyp x p y ∞−∞=∫∫()()log ()C H X p x p x dx∞−∞=−∫()()log ()C H XY p xy p xy dxdy∞−∞=−∫∫0()()()C H X H X H X Δ=+0()log H X Δ=-(|)()log (|)C H X Y p xy p x y dxdy ∞−∞=−∫∫24第三章离散信源•内容提要3.1 信源的数学模型及其分类3.2 离散无记忆信源3.3 离散无记忆信源的扩展信源3.4 离散平稳信源3.5 马尔可夫信源3.6 信源的相关性和剩余度253.1 信源的数学模型及其分类•3.1.1 信源及其数学模型•3.1.2 信源的分类⎯无记忆信源⎯有记忆信源26信源信源是信息的发源地,其输出称作消息。

信源的数学模型用概率场描述其中即信源的概率空间是完备的。

1212()()()n n x x x X p x p x p x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦1()0 1,2,,()1i qii p x i q p x =≥==∑271.离散信源信源输出是离散的消息符号,用离散随机变量描述。

最简单的离散信源可用一维离散随机变量来描述的,其数学模型为其中且通常q 为有限正整数,也可为可数无穷大.1212()()()q q a a a X p a p a p a P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦()() 1,2,,i i p a P X a i q===...()0 1,2,,i p a i q ≥= (1)()1qi i p a ==∑282. 连续信源信源输出为连续信号形式,可用连续随机变量来描述。

最简单的连续信源可用一维连续随机变量来描述,其数学模型为其中p (x )为连续随机变量的概率密度函数,(a,b ) 为X 的存在域,且(,)()X a b P p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦()0,()1bap x p x dx ≥=∫293.1.2 信源分类随机变量X⎧⎨⎩连续信源离散信源随机序列X ⎧⎨⎩平稳信源非平稳信源⎧⎨⎩离散平稳信源连续平稳信源⎧⎨⎩离散无记忆信源的N 次扩展信源有限记忆信源随机过程X (t )采样定理特例马尔可夫信源1212()()()n n x x x X p x p x p x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦ 1()0 , 1,2,,()1i q i i p x i q p x =≥==∑ (,)()X a b P p x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦()0,()1ba p x p x dx ≥=∫301. 定义设信源X 输出符号集X=(x 1 ,x 2 , …,x q ),q 为信源发出的消息符号个数,每个符号发生的概率为p (x i )。