信息论讲义_第十二讲

- 格式:pdf

- 大小:1.15 MB

- 文档页数:64

第68篇信息论(1)—《信息论》的创始人申农作者:中国医药信息学会北京分会后现代理论医学专业委员会主任委员杨鸿智一概括介绍克劳德?艾尔伍?申农是美国数学家,美国全国科学院院士。

信息论的创始人。

1916年 4月30日生于美国密歇根州盖洛德城。

1936年在密歇根大学毕业获理学士学位,1940年在麻省理工学院获理学硕士和哲学博士学位。

1941~1956年间任贝尔电话实验研究所数学研究员。

1956年到麻省理工学院任教,先后担任客座教授、教授,1958年后为终身教授。

1957~1958年间还担任过斯坦福行为科学高级研究中心的研究员。

1956年当选为美国全国科学院院士。

他是美国无线电工程师学会和美国数学会的高级会员。

曾获电气和电子工程师学会(IEEE)的诺布尔奖,美国无线电工程师学会的利布曼奖,富兰克林学会的巴兰坦奖章(1955),美国全国研究协会奖(1956)和哈维奖。

香农在1948年发表《通信的数学理论》,1949年发表《噪声中的通信》。

这两篇著名论文奠定了信息论的基础。

1949年发表《保密系统的通信理论》,使他成为密码学的先驱。

他在1956年与J.麦卡锡合编的著名论文集《自动机研究》是自动机理论方面的重要文献。

他的博士论文《关于类的古典布尔代数方法在电工开关系统研究中的应用》,是数字控制系统和计算机科学的先驱工作。

克劳德?艾尔伍?申农是创造了信息时代的巨人之一。

约翰?冯诺伊曼和阿伦?图灵等人发明了计算机,让信息处理成为可能,而克劳德?申农则提出了现代的信息概念。

如果高科技行业仿照拉什摩尔山雕筑四大伟人的头像的话,克劳德?申农定会出现在其中。

完整的信息论科学肇始于申农1948年发表的一份论文,时年32岁的申农是贝尔实验室的一名研究员。

文中,他说明了怎样定义并准确量化一度还很模糊的信息概念,指出了各种信息媒介之间必然的联系:文字、电话信号、无线电波、影像等等通讯交流方式,都能够编码为一种二进制的通用语言——比特,这也是“比特”(bit)一词第一次出现在文字上。

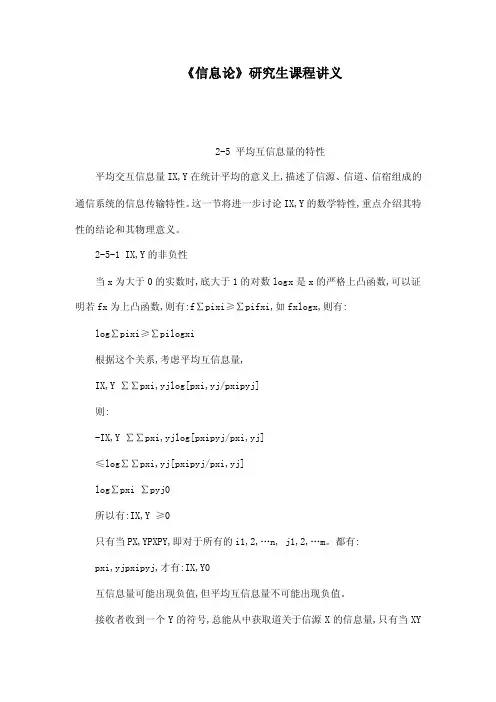

《信息论》研究生课程讲义2-5 平均互信息量的特性平均交互信息量IX,Y在统计平均的意义上,描述了信源、信道、信宿组成的通信系统的信息传输特性。

这一节将进一步讨论IX,Y的数学特性,重点介绍其特性的结论和其物理意义。

2-5-1 IX,Y的非负性当x为大于0的实数时,底大于1的对数logx是x的严格上凸函数,可以证明若fx为上凸函数,则有:f∑pixi≥∑pifxi,如fxlogx,则有:log∑pixi≥∑pilogxi根据这个关系,考虑平均互信息量,IX,Y ∑∑pxi,yjlog[pxi,yj/pxipyj]则:-IX,Y ∑∑pxi,yjlog[pxipyj/pxi,yj]≤log∑∑pxi,yj[pxipyj/pxi,yj]log∑pxi ∑pyj0所以有:IX,Y ≥0只有当PX,YPXPY,即对于所有的i1,2,…n, j1,2,…m。

都有:pxi,yjpxipyj,才有:IX,Y0互信息量可能出现负值,但平均互信息量不可能出现负值。

接收者收到一个Y的符号,总能从中获取道关于信源X的信息量,只有当XY相互独立时,平均互信息量才为0。

由IX,YHX-HX/Y,可知,在信息传输过程中,后验熵不可能大于先验熵,这种特性称为后熵不增加原理。

当XY相互独立时,pxi,yjpxipyj可得:HX,YHX+HY当XY相互独立时,pyj/xipyj可得:HY/XHY当XY相互独立时,pxi/yjpxi可得:HX/YHX由互信息量的定义可知:IX,YHX+HY-HX,YHX-HX/YHY-HY/X02-5-2 平均互信息量的交互性由于pxi,yjpyj,xi则:IX,YIY,X交互性表明在Y中含有关于X的信息,IX,Y;在X中含有关于Y的信息,IY,X;而且两者相等。

实际上IX,Y和IY,X只是观察者的立足点不同,对信道的输入X 和输出Y的总体测度的两种表达形式。

两个园相交的部分为平均互信息量,可见,平均互信息量的大小体现了X和Y 的相关程度。

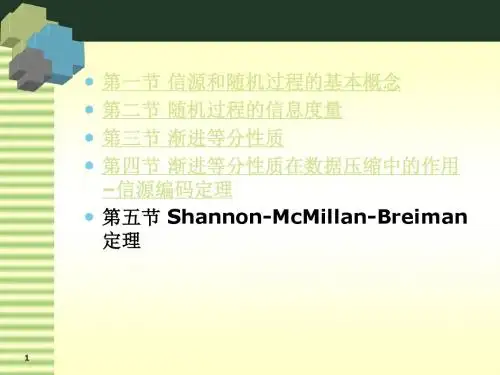

第一章绪论主要内容:(1)信息论的形成和发展;(2)信息论研究的分类和信息的基本概念;(3)一般通信系统模型;(4)目前信息论的主要研究成果。

重点:信息的基本概念。

难点:消息、信号、信息的区别和联系。

说明:本堂课作为整本书的开篇,要交待清楚课程开设的目的,研究的内容,对学习的要求;在讲解过程中要注意结合一些具体的应用实例,避免空洞地叙述,以此激发同学的学习兴趣,适当地加入课堂提问,加强同学的学习主动性。

课时分配:2个课时。

板书及讲解要点:“信息”这个词相信大家不陌生,几乎每时每划都会接触到。

不仅在通信、电子行业,其他各个行业也都十分重视信息,所谓进入了“信息时代”。

信息不是静止的,它会产生也会消亡,人们需要获取它,并完成它的传输、交换、处理、检测、识别、存储、显示等功能。

研究这方面的科学就是信息科学,信息论是信息科学的主要理论基础之一。

它研究信息的基本理论(Information theory),主要研究可能性和存在性问题,为具体实现提供理论依据。

与之对应的是信息技术(Information Technology),主要研究如何实现、怎样实现的问题。

它不仅是现代信息科学大厦的一块重要基石,而且还广泛地渗透到生物学、医学、管理学、经济学等其他各个领域,对社会科学和自然科学的发展都有着深远的影响。

1.1 信息论的形成和发展信息论理论基础的建立,一般来说开始于香农(C.E.shannon)研究通信系统时所发表的论文。

随着研究的保深入与发展,信息论具有了较为宽广的内容。

信息在早些时期的定义是由奈奎斯持(Nyquist,H.)和哈特莱(Hartley,L.V.R.)在20世纪20年代提出来的。

1924年奈奎斯特解释了信号带宽和信息速率之间的关系;1928年哈特莱最早研究了通信系统传输信息的能力,给出了信息度量方法;1936年阿姆斯特朗(Armstrong)提出了增大带宽可以使抗干扰能力加强。

这些工作都给香农很大的影响,他在1941—1944年对通信和密码进行深入研究,用概率论的方法研究通信系统,揭示了通信系统传递的对象就是信息,并对信息给以科学的定量描述,提出了信息嫡的概念。

信息理论基础(第十二讲)授课教师:于泽电子信息工程学院201教研室2¾目的是为了优化通信系统,就是使通信指标达到最佳¾通信系统的性能指标主要包括:有效性可靠性安全性经济性¾按不同的编码目的,编码分为三类:信源编码信道编码安全编码/密码为什么要进行编码3信源编码由于信源符号之间存在分布不均匀和相关性,使得信源存在冗余度,信源编码的主要任务就是减少冗余,提高编码效率。

具体说,就是针对信源输出符号序列的统计特性,寻找一定的方法把信源输出符号序列变换为最短的码字序列。

4信道编码–是以提高信息传输的可靠性可靠性为目的的编码。

–通常通过增加信源的冗余度来实现。

采用的方法与信源编码正好相反。

密码–是以提高通信系统的安全性为目的的编码。

–通常通过加密和解密来实现。

从信息论的观点出发“加密”可视为增熵的过程,“解密”可视为减熵的过程。

信道编码和密码5信源编码的基本途径是什么?信源编码的基本途径有两个:¾一是使序列中的各个符号尽可能地互相独立,即解除相关性------方法包括预测编码和变换编码;¾二是使编码中各个符号出现的概率尽可能地相等,即概率均匀化------方法主要是统计编码。

6信源编码的基础是什么?信源编码的基础是:两个编码定理,即无失真编码定理和限失真编码定理。

7内容提要5.1 编码器5.2 分组码5.3 定长编码5.4 变长编码5.5 变长编码方法—香农(Shannon)编码—霍夫曼(Huffman)编码—费诺(Fano)编码•研究信源编码时,将信道编码和译码看成是信道的一部分,而突出信源编码;•研究信道编码时,将信源编码和译码看成是信源和信宿的一部分,而突出信道编码。

895.1 编码器无失真信源编码将信源产生的全部信息无损地送给信宿,这种信源编码称无失真信源编码。

105.1 编码器(续)数学模型:编码器X Y 12(,,,)q X x x x ="12(,,,)q S s s s ="12(,,,)q C W W W ="S CX信源符号集代码组码符号集输入:信源符号集S =(s 1,s 2, …s q ),由q 个符号组成码符号集X =(x 1,x 2…x r ),由r 个符号组成11数学模型:编码器XY12(,,,)q X x x x ="12(,,,)q S s s s ="12(,,,)q C W W W ="SCX信源符号集代码组码符号集输出:代码组C =(w 1, w 2,…w q ),由q 个码字组成其中,称为码字,l i 称为码字长度)...(21i l i i i ix x x w =12数学模型:编码器XY12(,,,)q X x x x ="12(,,,)q S s s s ="12(,,,)q C W W W ="SCX信源符号集代码组码符号集编码器的作用:将信源符号集S 中的符号s i ,i=1,2…,q →变换成由码符号集X 中的码元x j ,j=1,2…,r组成的长度为l i 的一一对应的码字码字的集合称为代码组C 。

第二章信源与信息熵主要内容:(1)信源的描述与分类;(2)离散信源熵和互信息;(3)离散序列信源的熵;(4)连续信源的熵和互信息;(5)冗余度。

重点:离散/连续信源熵和互信息。

难点:离散序列有记忆信源熵。

说明:本章内容主要针对信源,但是很多基本概念却是整个信息论的基础,所以安排了较多课时。

由于求熵涉及一些概率论的基础知识,考虑到大四的同学可能对这部分知识已经遗忘,故适当复习部分概率论知识。

较难的 2.1.2节马尔可夫信源部分放置在本章最后讲,便于同学理解。

本章概念和定理较多,比较抽象,课堂教学时考虑多讲述一些例题,通过例题来巩固概念和消化定理。

作业:2.1—2.7,2.10,2.12。

课时分配:10课时。

板书及讲解要点:在信息论中,信源是发出消息的源,信源输出以符号形式出现的具体消息。

如果符号是确定的而且预先是知道的,那么该消息就无信息而言。

只有当符号的出现是随机的,预先无法确定,一旦出现某个符合就给观察者提供了信息。

因此应该用随机变量或随机矢量来表示信源,运用概率论和随机过程的理论来研究信息,这就是香农信息论的基本点。

2.1 信源的描述与分类在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。

信源:产生随机变量、随机序列和随机过程的源。

信源的基本特性:具有随机不确定性。

信源的分类连续信源:话音、图像——随机过程离散信源:输出在时间和幅度上都是离散分布的消息。

1213消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。

发出单个符号的无记忆信源离散无记忆信源: 发出符号序列的无记忆信源离散信源离散有记忆信源: 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源概率论基础:无条件概率,条件概率和联合概率的性质和关系: (1) 非负性0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, (2) 完备性111111()1,()1,(/)1,(/)1,()1nmnijiji j i mm nji i j j j i p x p y p x y p yx p x y ===========∑∑∑∑∑∑11()(),()()n mijjijii j p x y p y p x y p x ====∑∑(3) 联合概率()()(/)()(/)()()()(/)()(/)()i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,,(4) 贝叶斯公式11()()(/)(/)()()i j i j i j j i nmijiji j p x y p x y p x y p y x p x y p x y ====∑∑,2.1.1 无记忆信源:例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。