加权最小二乘法(WLS)

- 格式:pdf

- 大小:90.25 KB

- 文档页数:2

加权最小二乘法(Weighted Least Squares, WLS)是一种经典的拟合方法,用于处理数据中的噪声和异常值。

在拟合多项式的过程中,加权最小二乘法能够更好地适应不同的数据权重,从而得到更准确、更可靠的拟合结果。

结合Matlab强大的数学计算和可视化工具,我们可以更方便、更高效地实现加权最小二乘法拟合多项式。

一、加权最小二乘法的基本原理1. 加权最小二乘法的概念在拟合多项式过程中,常常会遇到数据噪声较大或者部分数据异常值较大的情况。

此时,普通的最小二乘法可能无法有效地拟合数据,因此需要引入加权最小二乘法。

加权最小二乘法通过为每个数据点赋予不同的权重,对异常值和噪声进行更有效的处理。

2. 加权最小二乘法的数学原理加权最小二乘法的数学原理主要是在最小化误差的基础上,引入权重矩阵来调整不同数据点的重要性。

通过优化残差的加权和,可以得到适应不同权重的拟合结果。

二、Matlab中的加权最小二乘法1. Matlab工具Matlab提供了丰富的数学计算和拟合工具,通过内置的polyfit函数和curve fitting工具箱,可以方便地实现加权最小二乘法拟合多项式。

Matlab还提供了丰富的可视化工具,可以直观展示加权最小二乘法的拟合效果。

2. 加权最小二乘法的实现在Matlab中,可以通过指定权重向量来调用polyfit函数,实现加权最小二乘法拟合多项式。

利用Matlab内置的拟合评估工具,可以对拟合效果进行全面评估和优化。

三、实例分析以实际数据为例,我们可以在Matlab环境下进行加权最小二乘法的拟合多项式实例分析。

通过构建数据模型、指定权重、调用polyfit函数并结合可视化工具,可以全面了解加权最小二乘法在拟合多项式中的应用效果。

四、个人观点和总结在实际工程和科学研究中,加权最小二乘法拟合多项式是一种非常有效和重要的数据处理方法。

结合Matlab强大的数学计算和可视化工具,可以更方便、更高效地实现加权最小二乘法拟合多项式。

一般情况下,对于模型Y X若存在:E( ) 02Cov( , ) E( ) u WW 1W 2W(4.2.2)(4.2.3)W n则原模型存在 异方差性。

设即随机误差项的方差与解释变量1 .f (X 2i ) ¥|.f (X 2i )1.f(X 2i )X 2ikXki.f(X 2i ).f (X 2i ) Uii1,2,,nSi)U i )-^E(U i 2) f (X 2i )(4・即同方差性。

于是可以用普通最小二乘法估计其参数, 得到关于参数0, 1 >的无偏的、有效的估计量。

这就是加权最小二乘法,在这里权就是 .f(X 2i )加权最小二乘法(WLS)如果模型被检验证明存在异方差性, 则需要发展新的方法估计模型, 最常用的方法是加权最小二乘法。

加权最小二乘法是对原模型加权, 使之变成一个新的不存在异方差性的模型, 然后采用普通最小二乘法估计其参数。

下面先看一个例子。

原模型:yi0 1X1i2X2i,k X kiUi 1,2, ,n如果在检验过程中已经知道:D(U i ) E(U i 2)i 2f (X>i ) J,i 1,2, ,nX 2之间存在相关性,模型存在异方差。

那么可以用... f(X 2)去除原模型,使之变成如下形式的新模型:在该模型中,存在W DD TW iW nD 1YD 1X(4.2.4)Cov(N , N )E(*T)E(D 1T)D1:WD 1T1u 2DD Du2I于是,可以用普通最小二乘法估计模型T *1. ?WLS(X X ) 1X Y1E(iT(4.2.4),得到参数估计量为:* T *用D 1左乘(422)两边,得到一个新的模型:* X该模型具有同方差性。

因为T 1T1 1 T 1T 1(X TD 1D 1X) 1X TD 1D "T 1 1 T 1(425)(X W X) X W Y这就是原模型(2.6.2)的加权最小二乘估计量,是无偏的、有效的估计量。

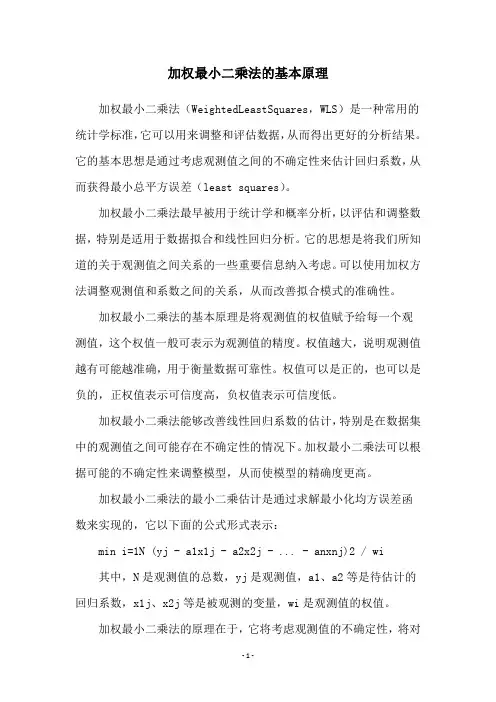

加权最小二乘法的基本原理加权最小二乘法(WeightedLeastSquares,WLS)是一种常用的统计学标准,它可以用来调整和评估数据,从而得出更好的分析结果。

它的基本思想是通过考虑观测值之间的不确定性来估计回归系数,从而获得最小总平方误差(least squares)。

加权最小二乘法最早被用于统计学和概率分析,以评估和调整数据,特别是适用于数据拟合和线性回归分析。

它的思想是将我们所知道的关于观测值之间关系的一些重要信息纳入考虑。

可以使用加权方法调整观测值和系数之间的关系,从而改善拟合模式的准确性。

加权最小二乘法的基本原理是将观测值的权值赋予给每一个观测值,这个权值一般可表示为观测值的精度。

权值越大,说明观测值越有可能越准确,用于衡量数据可靠性。

权值可以是正的,也可以是负的,正权值表示可信度高,负权值表示可信度低。

加权最小二乘法能够改善线性回归系数的估计,特别是在数据集中的观测值之间可能存在不确定性的情况下。

加权最小二乘法可以根据可能的不确定性来调整模型,从而使模型的精确度更高。

加权最小二乘法的最小二乘估计是通过求解最小化均方误差函数来实现的,它以下面的公式形式表示:min i=1N (yj - a1x1j - a2x2j - ... - anxnj)2 / wi 其中,N是观测值的总数,yj是观测值,a1、a2等是待估计的回归系数,x1j、x2j等是被观测的变量,wi是观测值的权值。

加权最小二乘法的原理在于,它将考虑观测值的不确定性,将对观测值更有可信度的权重赋予给观测值,从而改善回归系数的估计。

当数据存在某些影响因素时,加权最小二乘法可以更有效地消除其影响,从而使得拟合数据更加准确。

另外,加权最小二乘法还可以用于数据分析,可以用来估计参数和拟合模型,从而对数据集中的数据进行有效分析。

加权最小二乘法可以减少拟合模型的噪声,并且可以更好地拟合回归曲线,从而获得更好的拟合效果。

综上所述,加权最小二乘法是一种有效的统计方法,可以用来改善线性回归系数的估计,特别是在数据集中的观测值之间存在不确定性的情况下。

简述用加权最小二乘法消除多元线性回归中异方差性的思

想与方法

加权最小二乘(WeightedLeastSquares,WLS)是一种常用的回归分析方法,它是多元线性回归分析中最常使用的拟合方法之一。

最小二乘法的基本思想是求解最小化残差平方和的情况下的最佳参数

估计值。

这种方法的优点在于可以有效地消除多元线性回归中存在的异方差性。

多元线性回归分析是一种统计分析方法,用于研究一个或多个自变量与一个或多个因变量之间的关系。

它是通过确定自变量与因变量之间的线性关系,以拟合出最佳拟合线,从而预测未知的因变量的值,并分析自变量对因变量的影响程度。

然而,多元线性回归模型存在一个严重的问题:异方差性。

异方差性是指观测值之间方差的不均一,也就是指当观测值(X)越大,估计值的变化会变得越大,从而影响估计结果的准确性。

加权最小二乘法可以有效消除多元线性回归中异方差性问题。

把普通最小二乘法中残差平方和的目标函数,改为残差平方和乘以对应观测值权重因子的形式,即把均方差误差改为比例型误差,这样误差异方差就可以得到抑制,其结果就更加准确了。

- 1 -。

计量经济学gls和wls方法

计量经济学中的GLS和WLS是两种重要的回归分析方法,用于处理模型中的异方差性和序列相关性问题。

广义最小二乘法(GLS)通过对原始模型的变换,解释了误差方差的已知结构(异方差性)、误差中的序列相关形式或同时解释二者的估计量。

它通过一个线性变换来处理异方差性和序列相关性。

在GLS中,被解释变量、解释变量和干扰项都进行相同的线性变换,使得新的干扰项满足球形假设,从而使得高斯马尔可夫定理重新成立,即对参数的估计重新变为最佳线性无偏估计。

加权最小二乘法(WLS)是GLS的一个特例,用于处理异方差性。

在WLS 中,每个残差的平方都用一个等于误差的(估计的)方差的倒数作为权数,从而对异方差性进行调整。

当误差的方差矩阵V(X)为对角矩阵时,WLS成立。

WLS的线性变换也是一个对角矩阵,使得最小化新的残差和过程相当于最小化加权后的旧的残差和过程。

以上内容仅供参考,如需更多信息,建议查阅计量经济学相关的专业书籍或咨询该领域的专家。

加权最小二乘法求线性方程组加权最小二乘法:1、什么是加权最小二乘法?加权最小二乘法,简称WLS,是一种优化统计分析方法,用于拟合模型到多元数据集中的真实观测值。

加权最小二乘法在非线性回归中得到广泛应用,是一种能够有效地拟合不同测量误差的有效方法。

它以计算误差的最小平方和作为最小化的目标,以权重矩阵来衡量不同变量的影响,可以有效地适应噪声和其他不可控干扰。

2、加权最小二乘法的优点(1)它可以让用户提供不同变量的不同权重,以反映不同变量的不同程度的重要性。

(2)加权最小二乘法可以有效地拟合数据,对噪声和其他不可控干扰具有良好的鲁棒性。

(3)最小二乘法具有出色的数学优势,可以有效降低计算的复杂度并减少计算量。

(4)由于具有较低的复杂度,它可以比其他算法更快地完成优化计算任务。

3、加权最小二乘法的应用(1)加权最小二乘法被广泛用于拟合多元数据和统计模型。

它可以用于多元回归,用于做回归分析,并计算推断和预测模型。

(2)加权最小二乘法也经常用于有关气象、水质分析和生物学领域的研究中。

例如,它可以用于分析多个变量对气候变化的影响,也可以用于研究物种变化。

(3)加权最小二乘法还可以用于解决计算机视觉领域中的复杂问题,例如分析图像和处理图像。

它可以帮助人们更好地理解和识别图像数据以及物体的动作和特征。

(4)加权最小二乘法在分类和聚类数据分析中也经常被应用,它可以用来探索解释变量和响应变量之间的关系。

因此,它可以帮助数据分析人员找到更多的细节。

4、加权最小二乘法的缺点(1)加权最小二乘法会假设观测值的权重是正确的,这可能会导致模型的偏差。

(2)加权最小二乘法可能会忽略一些重要的信息,这可能会影响模型的精度和可靠性。

(3)加权最小二乘法可能无法有效地处理过大的数据集,因为它可能会产生过多的计算量。

(4)加权最小二乘法求解过程比较困难,即使在线性情况下也需要计算更复杂的表达式。

加权最小二乘法例题详解加权最小二乘法 (WLS) 是一种常见的线性回归模型调整方法,用于解决异方差问题。

在 WLS 中,我们利用加权残差平方和 (SSR) 作为损失函数,通过最小化该函数来寻找最优的回归系数。

具体来说,我们可以用以下公式表示 WLS:$$hat{mathbf{b}} = argmin_{mathbf{b}}frac{1}{n}sum_{i=1}^{n}left(mathbf{y}_{i}-mathbf{X}_{i}math bf{b}ight)^{2}+lambdamathbf{b}^{T}mathbf{Wb}$$其中,$mathbf{y}$是观测值,$mathbf{X}$是特征矩阵,$mathbf{b}$是回归系数向量,$lambda$是平衡系数,$mathbf{W}$是权重矩阵,它确定了每个特征对回归系数的影响程度。

为了求解上述最小二乘问题,我们可以使用矩阵分解的方法,将权重矩阵$mathbf{W}$分解为$mathbf{W}=mathbf{P}mathbf{Q}^{T}$,其中$mathbf{P}$和$mathbf{Q}$是对角矩阵,且$mathbf{P}$的对角线上的元素是特征矩阵$mathbf{X}$的权重,$mathbf{Q}$的对角线上的元素是观测值$mathbf{y}$的权重。

因此,我们可以将 WLS 公式改写为:$$hat{mathbf{b}} = argmin_{mathbf{b}}frac{1}{n}sum_{i=1}^{n}left(mathbf{y}_{i}-mathbf{X}_{i}math bf{b}ight)^{2}+lambdamathbf{b}^{T}mathbf{P}mathbf{Q}^{T}mathbf{b }$$此时,我们可以使用矩阵分解的方法求解最优的回归系数向量$hat{mathbf{b}}$。

具体来说,我们可以将$mathbf{P}mathbf{Q}^{T}$分解为$mathbf{P}=mathbf{D}-mathbf{N}$,其中$mathbf{D}$是对角矩阵,$mathbf{N}$是非对角矩阵,$mathbf{N}$的元素是$mathbf{X}$的特征值,$mathbf{D}$的元素是$mathbf{X}$的特征值对应的对角线上的元素。

加权最小二乘法

加权最小二乘法(weighted least squares, WLS)是一种线性回归的方法,用于处理具有不同观测误差方差的数据。

在普通最小二乘法(ordinary least squares, OLS)中,假设所有的观测误差方差是相等的。

但在实际应用中,有一

些变量可能有更大的观测误差,或者某些观测点可能有更

大的误差。

WLS通过对不同观测点赋予不同的权重来解决

这个问题,权重的大小与观测误差的方差成反比。

加权最小二乘法的目标是最小化加权残差的平方和,即最

小化:

\\[S = \\sum_{i=1}^{n} w_i(y_i - f(x_i))^2\\]

其中,$n$为观测点数量,$w_i$为第$i$个观测点的权重,$y_i$为第$i$个观测点的观测值,$f(x_i)$为模型对第$i$个观测点的预测值。

为了最小化$S$,可以通过求解加权最小二乘问题的正规方程来获得参数的估计值,即求解:

\\[(X^TWX)\\hat{\\beta} = X^TWy\\]

其中,$X$为设计矩阵,包含自变量的观测值,

$\\hat{\\beta}$为参数的估计值,$W$为权重矩阵,对角线上的元素为权重值,其他元素为零。

通过求解正规方程,可以获得参数的估计值

$\\hat{\\beta}$,进而用于预测新的观测值或进行模型的推断分析。

需要注意的是,加权最小二乘法的权重选择需要根据具体的实际情况来确定,通常可以通过观察观测数据的方差不均匀性、残差分析等方法来确定权重值。

wls加权最小二乘法步骤哎呀,今天咱们来聊聊“加权最小二乘法”,也就是WLS(Weighted Least Squares)。

这个名字听起来高大上,其实它就像一位默默无闻的英雄,平时不显山不露水,但一旦需要,立刻登场救场。

就拿我们平常的线性回归来说吧,大家都知道线性回归就是通过找到一条直线,把数据点尽量贴合。

但数据点就像个调皮的小孩,乖乖的、不乖的都有,咋办呢?这时候,WLS就像是给每个孩子贴上了标签——有的乖,有的不乖,给他们不同的“权重”。

这样,乖孩子多加几分,不乖的就稍微降低一点影响,咱们就能更精准地找到那条理想的线了。

具体步骤是啥呢?你得把你的数据搞清楚。

想象一下,你在准备一场盛大的聚会,得知道有多少人参加,大家的喜好是什么。

搞定数据后,得看看哪些点的噪音大,哪些点比较靠谱。

这个时候,你就需要算出每个点的“权重”了。

权重就是告诉你,哪个数据点在这个模型里更重要。

通常,这些权重是通过对数据的方差来估算的。

噢,说到这里,有个关键的事,计算权重的时候,得特别小心,别让那些“出格”的数据点影响了大局,真是麻烦得很呢。

你得把这些权重放进去,进行最小二乘估计。

换句话说,就是通过最小化误差平方和的方式,找到最佳拟合线。

这个过程就像是找一条最舒服的路,确保不会被路边的坑坑洼洼给绊倒。

得注意,计算过程中用到的那些公式,看起来可能有点复杂,但别怕,慢慢来,一步步解读就能搞定。

再说说结果吧,WLS的结果往往比普通的线性回归更靠谱。

就像你找了个好厨师,菜做得可香了。

你可以通过一些诊断图表来验证模型的效果,看看线的斜率、截距,数据的分布,确保它们都在预期的范围内。

要是发现什么不对劲,赶紧调整调整。

就像聚会一样,发现食物不够了,就赶紧再叫外卖,别让客人失望。

WLS就像是聚会中的调酒师,确保每一种口味都能得到充分体现,不至于让某一种味道抢了风头。

通过合理的加权,咱们能更好地理解数据,做出明智的决策。

而这就是WLS的魅力所在了!简单易懂,又能应对复杂情况,谁不想拥有这样一招呢?希望今天的分享能让你对WLS有点儿了解。

简述用加权最小二乘法消除多元线性回归中异方差性的思想与方法加权最小二乘法(weightedleast-squares,WLS)是一种常用的用于拟合多元线性回归模型的优化方法。

它是通过引入权重来缓解回归模型中异方差性(heteroscedasticity)问题,提高多元线性回归模型的准确性。

本文将重点介绍加权最小二乘法消除多元线性回归中异方差性的思想与方法。

一、WLS原理概述加权最小二乘法是指在估计多元线性回归时,采用最小二乘法(Ordinary Least Squares,OLS)的原理,但是使用不同的权重来拟合回归模型。

WLS的原理是,在估计系数时,先将数据根据权重进行标准化,然后再使用最小二乘法估计模型参数。

WLS最大的优势是可以缓解数据中异方差性(heteroscedasticity)问题,从而提高模型实用性。

二、WLS在多元线性回归中的应用1、在处理异方差性的多元线性回归问题时,WLS可以缓解数据的异方差性,从而提高统计模型的有效性和准确性;2、WLS可以应用于所有的多元线性回归问题,比如逻辑回归,线性判别分析等;3、WLS可以使用不同的权重,以提高模型的准确性,并降低参数估计的偏差;4、WLS可以使用偏最小二乘方法(Partial Least Squares,PLS)来提升多元线性回归模型的准确性。

三、WLS消除异方差性的实现方式1、采用灰色系统建模,使用灰色关联度来消除异方差;2、采用基于赤池信息准则(Akaike Information Criterion,AIC)的向量自回归(Vector Autoregressive,VAR)方法来消除异方差;3、采用改进的最小二乘算法(Improved Least Squares,ILS)方法来消除异方差;4、采用多重约束技术(Multiple Constraints,MC)方法来消除异方差;5、采用改进的加权最小二乘算法(Improved Weighted Least Squares,IWLS)方法来消除异方差;6、采用线性模型的总体方差结构方法(Total Variance Structure Model,TVSM)来消除异方差。

加权最小二乘法(WLS) 是一种统计学方法,它用于解决带有误差的线性回归问题。

它的基本思想是在最小二乘法的基础上,通过给每个样本点赋予不同的权重,来解决样本点的误差不同的问题。

基本思想就是,通过给不同的样本点赋予不同的权重,来解决样本点的误差不同的问题。

在WLS中,每个观测值都有一个相应的权重。

权重是与观测值相关的标量值,可以用来衡量观测值的置信度或相对重要性。

权重越大,观测值对结果的影响就越大。

大残差的定义是指比较大的样本误差。

在WLS中,我们通过减小大残差对结果的影响来提高结果的精确度。

简述用加权最小二乘法消除多元线性回归中异方差性的思想与方法多元线性回归是统计学中一种重要的简单线性回归模型,它可以用来研究两个或多个变量之间的关系。

然而,在多元线性回归中容易出现异方差性,这会影响回归结果的准确性。

为了解决多元线性回归中异方差性的问题,研究者提出了一种新的模型加权最小二乘法(WLS),其中权重由变量自身的方差决定。

1.加权最小二乘法(WLS)原理WLS是一种基于最小二乘法改进的新方法,它可以用来消除多元线性回归中的异方差性。

其基本原理是,在估计回归参数时利用各个观测数据的权重,以更好的拟合多元回归曲线。

其中,权重的定义如下:假设观测数据共有n组,那么第i组观测数据的权重可以定义为w_i = 1/sigma_i^2,其中sigma_i^2第i组观测数据的方差,即变量之间有异方差性。

2.权最小二乘法(WLS)的优点(1)WLS可以解决多元线性回归中异方差性的问题。

异方差性经常会影响多元线性回归模型的准确性,而WLS则可以通过调整变量之间的权重来消除异方差性。

(2)WLS也可以用来消除多元线性回归中的过度拟合问题。

WLS 的权重可以用来控制拟合曲线,从而改善模型的准确性。

(3)WLS还可以改善多元线性回归模型的稳健性。

WLS可以通过调整权重来降低一个变量对模型结果的影响,从而增加模型的稳健性。

3.权最小二乘法(WLS)的应用WLS在实际工作中得到了广泛的应用,其中最常见的是用于减少多元线性回归中异方差性的影响。

例如,在金融分析中,可以利用WLS来消除股票价格波动对投资收益的影响。

此外,WLS也可以用来消除多元线性回归中的过度拟合问题,从而提高模型的准确度。

综上所述,用加权最小二乘法消除多元线性回归中异方差性是一种有效且有效的做法,它可以改善模型的稳健性和准确度,也可以有效地减少多元线性回归中对异方差性的影响。

标题:OLS、FGLS和WLS异方差公式推导与比较一、概述在统计学和计量经济学中,对OLS(普通最小二乘法)、FGLS(广义最小二乘法)和WLS(加权最小二乘法)等方法的研究与应用日益广泛。

这三种方法在处理数据时,都考虑了异方差(heteroskedasticity)的问题,并针对此问题提出了相应的公式。

本文将梳理和比较这三种方法的异方差公式推导过程,旨在深入探讨这一核心问题,使读者对其背后的原理和应用有更深入的理解。

二、异方差的概念在回归分析中,当观测数据的误差方差并非恒定时,则存在异方差问题。

简而言之,异方差即指一种情况,即数据的误差项的方差不是恒定的,其方差随着自变量或其他因素的变化而变化。

异方差可能导致OLS估计量不再是最优的,因此需要采取相应的方法进行修正。

接下来,我们将分别对OLS、FGLS和WLS方法进行异方差公式的推导和比较。

三、OLS方法的异方差公式推导我们来推导OLS方法的异方差公式。

假设我们有一个简单的线性回归模型:\[ Y_i = \beta_0 + \beta_1X_i + \varepsilon_i \],其中\[ \varepsilon_i \]为误差项。

如果我们假设误差项\[ \varepsilon_i \]的方差\[ \sigma^2 \]与自变量\[ X_i \]的取值无关,即\[ Var(\varepsilon_i) = \sigma^2 \],则OLS估计量是无偏的和最优的。

然而,当存在异方差时,OLS估计量不再是最有效的。

针对异方差问题,我们需要对误差项\[ \varepsilon_i \]进行修正。

通过对残差项进行加权,引入权重矩阵\[ \Omega \],即可得到加权最小二乘法(WLS)。

具体地,WLS方法利用\[ \Omega \]对残差项\[ e_i \]进行加权,使得\[ \sum_{i=1}^{n} \Omega_i e_i^2 \]最小。

这样,针对异方差问题,我们可以使用WLS方法进行估计。

一种改进的加权最小二乘无网格法加权最小二乘方法(WLS)是一种优化问题,用于解决非线性最小二乘问题。

它通过引入一组权重,对观测误差进行加权,从而得到更准确的估计结果。

传统的WLS方法通常基于网格搜索,需要先确定权重的初始值。

这种方法的计算复杂度很高,效率较低。

为了改进该方法,我们提出了一种新的加权最小二乘无网格法。

以下将详细介绍该方法的原理、优势和应用。

该方法的优势在于,它不需要事先确定权重的初始值,能够自动寻找最优的权重。

具体实现过程如下:1. 初始化权重:将权重初始化为单位矩阵,即每个观测值的权重都设为1。

2. 迭代计算:使用当前权重,通过最小二乘方法计算估计结果。

3. 计算残差:计算每个观测值的残差,即观测值与估计结果的差。

4. 更新权重:根据残差的大小更新权重。

较小的残差对应较高的权重,较大的残差对应较低的权重。

这可以通过将残差归一化后与当前权重相乘得到。

5. 判断收敛条件:判断当前的估计结果与前一次的估计结果之间的差异是否小于预设的阈值。

如果是,则停止迭代;否则,回到步骤2继续迭代。

这种无网格的方法通过自适应调整权重,能够有效减小观测误差,提高估计结果的准确性。

而且,由于不再需要网格搜索,计算复杂度大大降低,计算速度更快。

该方法在一些实际应用中已经验证了其有效性。

在机器学习中,该方法可以用于参数估计,从而提高模型的拟合能力。

在图像处理中,该方法可以用于图像恢复,从而减小噪声的影响。

在物理实验中,该方法可以用于数据处理,从而提高测量结果的精度。

我们提出的一种改进的加权最小二乘无网格法能够自动寻找最优的权重并提高估计结果的准确性。

该方法具有计算复杂度低、计算速度快的优势,并在一些实际应用中取得了良好的效果。

加权最小二乘法(W L S) -CAL-FENGHAI-(2020YEAR-YICAI)_JINGBIAN加权最小二乘法(WLS)如果模型被检验证明存在异方差性,则需要发展新的方法估计模型,最常用的方法是加权最小二乘法。

加权最小二乘法是对原模型加权,使之变成一个新的不存在异方差性的模型,然后采用普通最小二乘法估计其参数。

下面先看一个例子。

原模型:+++=i i i x x y 22110βββ,i ki k u x ++βn i ,,2,1 =如果在检验过程中已经知道: 2222)()()(u i i i i x f u E u D σσ=== ,n i ,,2,1 =即随机误差项的方差与解释变量2x 之间存在相关性,模型存在异方差。

那么可以用)(2x f 去除原模型,使之变成如下形式的新模型:+++=i i i i i i i x x f x x f x f y x f 222121202)(1)(1)(1)(1βββi i ki i k u x f x x f )(1)(122++βn i ,,2,1 =在该模型中,存在 222222)()(1))(1())(1(u i ii i i i u E x f u x f E u x f D σ=== (4.2.1)即同方差性。

于是可以用普通最小二乘法估计其参数,得到关于参数βββ01,,, k 的无偏的、有效的估计量。

这就是加权最小二乘法,在这里权就是)(12i x f 。

一般情况下,对于模型Y X =+B N (4.2.2) 若存在:W2)(),(0)(uE Cov E σ=N 'N =N N =NW =⎡⎣⎢⎢⎢⎢⎤⎦⎥⎥⎥⎥w w w n 12(4.2.3) 则原模型存在异方差性。

设T DD W =⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=n w w w D21, ⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=----112111n w w w D用D 1-左乘(4.2.2)两边,得到一个新的模型:D Y D X D ---=+111B N (4.2.4) 即Y X ***=+B N该模型具有同方差性。

加权最小二乘法(WLS)

如果模型被检验证明存在异方差性,则需要发展新的方法估计模型,最常用的方法是加权最小二乘法。

加权最小二乘法是对原模型加权,使之变成一个新的不存在异方差性的模型,然后采用普通最小二乘法估计其参数。

下面先看一个例子。

原模型:,

如果在检验过程中已经知道:

,

即随机误差项的方差与解释变量之间存在相关性,模型存在异方差。

那么可以用去除原模型,使之变成如下形式的新模型:

在该模型中,存在

(4.2.1)

即同方差性。

于是可以用普通最小二乘法估计其参数,得到关于参数的无偏的、有效的估计量。

这就是加权最小二乘法,在这里权就是。

一般情况下,对于模型

(4.2.2)若存在:

(4.2.3)

则原模型存在异方差性。

设

,

用左乘(4.2.2)两边,得到一个新的模型:

(4.2.4)

即

该模型具有同方差性。

因为

于是,可以用普通最小二乘法估计模型(4.2.4),得到参数估计量为: (4.2.5)

这就是原模型(2.6.2)的加权最小二乘估计量,是无偏的、有效的估计

量。

如何得到权矩阵W?仍然是对原模型首先采用普通最小二乘法,得到随机误差项的近似估计量,以此构成权矩阵的估计量,即

(4.2.6)

当我们应用计量经济学软件包时,只要选择加权最小二乘法,将上述权矩阵输入,估计过程即告完成。

这样,就引出了人们通常采用的经验方法,即并不对原模型进行异方差性检验,而是直接选择加权最小二乘法,尤其是采用截面数据作样本时。

如果确实存在异方差性,则被有效地消除了;如果不存在异方差性,则加权最小二乘法等价于普通最小二乘法。

在利用Eviews计量经济学软件时,加权最小二乘法具体步骤是:

1 选择普通最小二乘法估计原模型,得到随机误差项的近似估计

量;

⑵ 建立的数据序列;

⑶ 选择加权最小二乘法,以

序列作为权,进行估计得到参数估计量。

实际上是以乘原模型的两边,得到一个新模型,采用普通最小二乘法估计新模型。

(步骤见PPT文件)。