基于听感知特征的语种识别

- 格式:pdf

- 大小:326.67 KB

- 文档页数:4

基于深度学习的语音识别技术研究随着人工智能技术的发展,语音识别技术也日渐成熟。

从最初的基于模板匹配的语音识别到后来的基于统计学习的语音识别,再到今天的基于深度学习的语音识别,语音识别技术已经不再是未来科技,而是已经进入了我们的日常生活。

一、基于深度学习的语音识别技术深度学习技术是人工智能领域的热门技术之一,因其在图像识别、语音识别、自然语言处理等领域的卓越表现而备受关注。

深度学习算法通过模拟人脑的神经元网络实现对输入数据的多层抽象表示和处理。

而在语音识别任务中,深度学习算法可以通过对音频信号的建模和自适应模型训练来有效降低语音识别的误识别率。

目前基于深度学习的语音识别技术主要包括深度神经网络(Deep Neural Networks, DNNs)、卷积神经网络(Convolutional Neural Networks, CNNs)、长短时记忆网络(Long Short-Term Memory, LSTM)等多种模型。

其中,DNNs是基于前馈神经网络实现的语音识别模型,通过多个隐层抽象输入特征,将输入的音频信号映射到语音单元上,通过输出层的激活函数可以得到对音频信号的识别结果。

CNNs则是通过卷积层和池化层实现特征的提取和降维,然后再使用全连接层实现的识别。

而LSTM则是基于循环神经网络实现的模型,对于长序列信号的记忆、建模和识别效果尤为出色。

二、深度学习技术的优点相对于传统语音识别算法,深度学习技术具有以下优点:1. 非线性特征提取: 传统语音信号的特征提取通常采用Mel频率倒谱系数(Mel-frequency cepstral coefficients, MFCCs)等算法,而深度学习技术可以通过多层的非线性变换实现更为复杂的特征提取。

2. 优秀的分类性能: 深度学习算法可以通过大规模数据训练和模型自适应调整,从而获得优秀的分类性能,尤其对于噪声干扰、口音变化等情况的适应能力更强。

3. 高效的训练方法: 深度学习算法可以使用反向传播算法实现模型训练,而且可以结合GPU等并行计算技术加速训练完成。

1语言辨识的基本概念自动语言辨识(又称语种识别),是计算机分析处理一个语音片段以判别其所属语种的技术。

随着当前全球合作的增长,各种余元之间的通信要求增加,这就对自动语言识别提出新的挑战,在机械能够懂得语言含义之前,必须辨别使用了哪种语言。

自动语言辨识的任务在于快速准确的辨识出所使用的语言,目前它已经成为通信和信息领域一个新的学科增长点。

自动语言辨识技术的学术特点在于它横跨技术的融合。

对它的研究,不仅需要掌握信息理论和技术,而且需要具有多种信息处理的手段和方法。

众所周知,语音中包含着多种信息,从语音中提取不同的信息进行处理也就形成了不同语言处理方法。

从内容上分,语音中包含着所属语言种类的信息、说话内容的语义信息和说话人个体特征,因此从识别的角度来说,我们可以利用从语音中提取的这些信息进行识别,语音信息的识别可以分为语音识别、语言辨识和说话人识别。

语音识别中要提取出包含在语音信号中的字词意思和言语内容,说话人识别则是从语音信号中获取说话人的身份,语言辨识是从语音信号中提取出包含的语言的种类(或方言的种类)。

与语音识别和说话人识别不同的是,语言辨识利用的是语音信号中的语言学信息,而不考虑语音信号中的字词意思,不考虑说话人的个性。

语种识别在信息检索和军事领域都有很重要的应用,包括自动转换服务多语言信息补偿等。

在信息服务方面, 很多信息查询中可提供多语言服务, 但一开始必须用多种语言提示用户选择用户语言。

语种辨识系统必须预先区分用户的语言种类, 以提供不同语言种类的服务。

这类典型服务的例子包括旅游信息、应急服务、以及购物和银行、股票交易。

例如 AT&T 向处理 911 紧急呼救的社会机构和警察局推出语言热线服务。

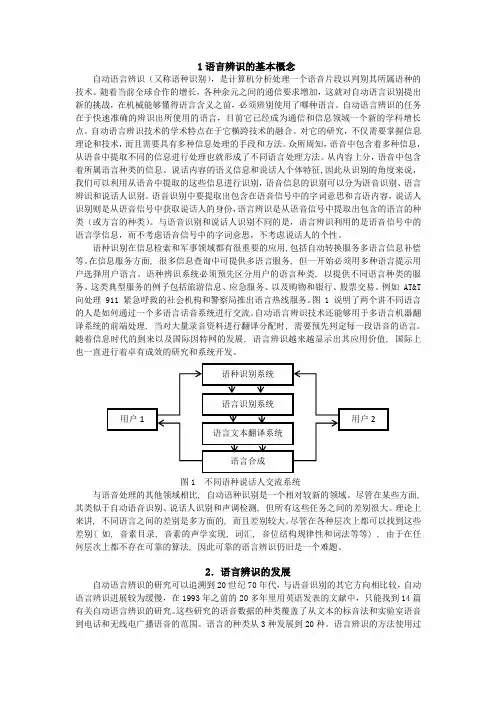

图 1 说明了两个讲不同语言的人是如何通过一个多语言话音系统进行交流。

自动语言辨识技术还能够用于多语言机器翻译系统的前端处理, 当对大量录音资料进行翻译分配时, 需要预先判定每一段语音的语言。

声纹鉴定技术基本知识介绍作者:金恬文章来源:本站原创点击数:5 更新时间:2010-11-1声纹鉴定技术基本知识介绍科技的进步不断推动着刑侦技术的发展,声纹鉴定是目前发展较为迅速的一个领域,涉及语音、语言、生理、心理、信号处理、统计等多个学科。

在生物认证领域,唯有机器自动声纹鉴定的性能在某些条件下与人类相当,甚至超过人类。

为使大家对声纹鉴定有所了解,现将相关的概念、应用、发展及现状等作简单介绍。

一、声纹鉴定的概念(一)声纹鉴定的定义声纹鉴定,也称为说话人识别,是一项根据语音中反映说话人发音和言语的特征,识别说话人身份的技术。

语音中既包含说话人先天的发音差异,又包含后天的言语习惯。

声纹鉴定的核心是通过预先录入的语音样本,提取这些独一无二的特征并保存在数据库中,应用时将检材的特征与数据库中的进行匹配,从而确定说话人的身份。

(二)声纹鉴定的特点与其他生物认证如指纹、掌纹、虹膜等一样,声纹也有不会遗失、无须记忆和使用方便等特点。

首先,以声音作为识别特征,因其非接触性和自然性,用户容易接受,也易于采集。

其次,所用的设备成本不高。

对输入设备如麦克风等没有特别要求;特征提取、模型匹配只需普通计算机即可完成。

再次,对于远程应用和移动互联环境的身份验证,声音恐怕是最方便快捷的生物特征。

(三)声纹鉴定的分类声纹鉴定任务根据鉴定方式的不同,可以分为三类:说话人辨认,是指从给定样本集中把检材所属的说话人区分出来;说话人确认,是针对单个用户的样本,判断检材是否属于所声称的用户;说话人探测跟踪,是指对一段包含多个说话人的语音,正确标注和提取特定说话人的语音。

对说话人辨认可进一步分为闭集辨认和开集辨认两种:闭集辨认,是指所测试的说话人肯定是在数据库中出现过的;开集辨认,指的是所测试的说话人还有可能是数据库中没有出现过的,难度大于闭集辨认。

此外,声纹鉴定任务从对语音的要求上可以分为与文本无关的和与文本有关的两种:与文本无关的,是指语音样本不要求特定的语种和内容,即样本与检材之间并不要求一致;与文本有关的,是指语音样本由用户按照给定的文本朗读得到,样本应与检材相一致。

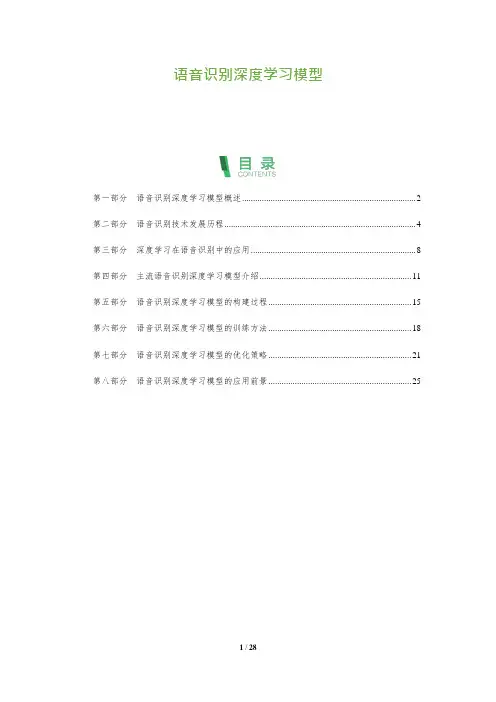

语音识别深度学习模型第一部分语音识别深度学习模型概述 (2)第二部分语音识别技术发展历程 (4)第三部分深度学习在语音识别中的应用 (8)第四部分主流语音识别深度学习模型介绍 (11)第五部分语音识别深度学习模型的构建过程 (15)第六部分语音识别深度学习模型的训练方法 (18)第七部分语音识别深度学习模型的优化策略 (21)第八部分语音识别深度学习模型的应用前景 (25)第一部分语音识别深度学习模型概述语音识别深度学习模型概述随着人工智能技术的不断发展,深度学习已经成为了语音识别领域的研究热点。

深度学习模型在语音识别任务中取得了显著的性能提升,为实际应用提供了强大的支持。

本文将对语音识别深度学习模型进行概述,包括其基本原理、关键技术和应用领域。

一、基本原理深度学习是一种模拟人脑神经网络结构的机器学习方法,通过多层次的神经网络对数据进行自动学习和抽象表示。

在语音识别任务中,深度学习模型通常采用深度神经网络(DNN)结构,包括多个隐藏层和一个输出层。

输入层接收原始语音信号的特征向量,通过隐藏层的非线性变换和逐层抽象表示,最终在输出层得到识别结果。

二、关键技术1.卷积神经网络(CNN)卷积神经网络是一种特殊的深度学习模型,广泛应用于图像识别和语音识别任务。

在语音识别中,CNN 可以有效地提取局部特征,减少参数量,提高模型的泛化能力。

常见的 CNN 结构有多层感知机(MLP)、长短期记忆网络(LSTM)和门控循环单元(GRU)。

2.长短时记忆网络(LSTM)长短时记忆网络是一种具有长短时记忆能力的循环神经网络(RNN),可以有效地处理序列数据。

在语音识别中,LSTM 可以捕捉语音信号的时序信息,提高模型的识别性能。

为了进一步提高 LSTM 的性能,研究者提出了多种改进方法,如双向 LSTM、门控 LSTM 和注意力机制等。

3.注意力机制注意力机制是一种模拟人类注意力分配机制的方法,可以帮助模型在处理序列数据时关注重要的部分。

40、下面那些是行排式二维条码()。

(A、B、C) A、PDF417 B、CODE49 C、CODE16K二、多选题(每题2分,共20题)21、物联网跟人的神经网络相似,通过各种信息传感设备,把物品与互联网连接起来,进行信息交换和通讯,下面哪些是物联网的信息传感设备:(ABCD)A、射频识别(RFID)芯片,B、红外感应器C、全球定位系统,D、激光扫描器22、出租车智能调度系统主要有哪三部分构成?(BCD)A、导航系统,B、车载平台,C、手机平台,D、指挥系统23、移动通信网络的主要应用(AC)A、移动电话,B、无线耳机,C、车载网络,D、无线鼠标24、能实现节电节能量的方式是( ABCD)。

P196A、休眠机制,B、拒绝通信,C、停止采集数据,D、关闭计算模块25、基于四大技术的物联网支柱产业群包括( ABCD)。

A、RFID从业人员,B、传感网从业人员C、M2M人群,D、工业信息化人群26、下列技术中,哪些项属于智能物流的支撑技术?( ABC)P275A、物联网信息感知技术,B、网络技术C、人工智能、数据仓库和数据挖掘技术,D、秘密技术27、物联网系统中,信息表现为(ABCD)。

P127A、多样性,B、数据量的巨大性C、数据关系的复杂性,D、数据处理所要求的实时性、准确性和可靠性28、云计算平台的特点(ABCD)。

A、虚拟化,B、基于互联网,C、大型的集中计算,D、按需使用29、ZigBee网络拓扑类型包括(ABD)。

A、星型,B、网状,C、环形,D、树形30、 3C是指的是( ACD)。

A、omputer,B、ontrol,C、mmunication,D、onsumer31、在传感器节点定位技术中,下列哪些项是使用全球定位系统技术定位的缺点?(ABC )A、只适合于视距通信的场合,B、通常能耗高、体积大且成本较高C、需要固定基础设施,D、实用性不好,抗干扰能力弱32、RFID系统解决方案的基本特征:(ABCD)P141A、机密性,B、完整性,C、可用性,D、真实性33、下列说法错误的是?(ACD)P196A、边缘节点消耗的能量最大,B、处于中间的节点消耗的能量最大C、能量消耗都一样,D、靠近基站的节点消耗的能量最大34、语音识别主要包含的功能(ABCD) P79A、声纹识别,B、内容识别,C、语种识别,D、语音标准识别35、传感器朝什么方向发展?(AB)A、微型化,B、智能化,C、网络化,D、大型化36、物联网数据管理系统结构主要有(ABCD)A、集中式结构,B、半分布式结构,C、分布式结构,D、层次式结构37、应用支撑平台层用于支撑跨行业、跨应用、跨系统之间的信息协同、共享、互通的功能,主要包括(BCD)。

失匹配负波(MMN)对听觉中枢言语识别功能的评估刘浩强;赵立东【摘要】言语识别功能往往受到各种神经因素或脑部疾病等的影响,事件相关电位ERP是与特定事件在时间上具有锁相性的脑反应,是分析大脑感知和听觉辨别信息的窗口,反应了认知过程中大脑神经电生理活动改变.目前已提取出的成分有慢反应P1-N1-P2、N2b-P3b及N400等.其中MMN是一种内源性事件相关电位ERP 成分,反应大脑对信息的自动加工过程,以无需患者主动参与,在无意识的情况下被测定的特点越来越广泛被应用于临床.失匹配负波(MMN)已被用作研究涉及听觉识别等领域中的工具.对于许多疾病,与对照组相比,MMN幅度基本都会显示减弱和(或)潜伏期延长.这个发现,虽然MMN不能作为任何特定疾病的特异性指标,但MMN 可能有助于理解涉及中枢听觉言语障碍的一些疾病的识别因素,并且可以作为预知这些疾病风险的潜在指标.%Speech recognition functions are often affected by various neurological factors,brain diseases and oth-er conditions.Event-related potential(ERP)is a brain response with phase-locked time specific events.It is a window for studying cerebral cognition and auditory information recognition,reflecting changes in electrophysiological activi-ties of the brain during cognitive processes.At present,components such as slow reaction P1-N1-P2,Mismatch Negativ-ity(MMN),N2b-P3b and N400 can be extracted from ERP.MMN is an endogenous ERP component that reflects the brain's automatic processing of information,with the fact that it does not require the patient to take the initiative to par-ticipate,can be measured in an unconscious situation and is gaining increasingly wide use in the clinic.MMN has been used as tools for studying obstacles in areassuch as auditory recognition.In many diseases conditions,compared with the normal control,MMN displays substantially reduced amplitudes and/or delayed latencies.While this general finding suggests that MMN cannot be used as a specific indicator of any particular disease,it may still help understand telltale signs of certain diseases involving central auditory speech disorders and may serve as a potential indicator of the risk of these diseases.【期刊名称】《中华耳科学杂志》【年(卷),期】2018(016)002【总页数】7页(P227-233)【关键词】失匹配负波;言语识别;听觉中枢【作者】刘浩强;赵立东【作者单位】中国人民解放军总医院耳鼻咽喉头颈外科,耳鼻咽喉科研究所,聋病教育部重点实验室,聋病防治北京市重点实验室北京100853 ;浙江中医药大学杭州310000;中国人民解放军总医院耳鼻咽喉头颈外科,耳鼻咽喉科研究所,聋病教育部重点实验室,聋病防治北京市重点实验室北京100853【正文语种】中文【中图分类】R764听觉是在有听力的前提下大脑对声音的识别能力。

音乐信息检索技术:音乐与人工智能的融合李伟;高智辉【摘要】音乐科技是一个典型的交叉学科领域,分为艺术部分和科技部分.近年来兴起的音乐信息检索技术(MIR)是音乐科技领域的重要组成部分.MIR领域包含数十个研究课题,可按照与各音乐要素的密切程度分为核心层和应用层.当前的MIR技术发展仍然面临诸多困难,但随着艺术与科技的不断融合,必将迎来其发展的辉煌时期.【期刊名称】《艺术探索》【年(卷),期】2018(032)005【总页数】5页(P112-116)【关键词】人工智能;音乐信息检索技术;音乐科技【作者】李伟;高智辉【作者单位】复旦大学计算机科学技术学院,上海201203;复旦大学信息科学与工程学院,上海200433【正文语种】中文【中图分类】J61一、音乐科技概况早在20世纪50年代,计算机刚刚产生,美国的一位化学博士就开始尝试运用计算机处理音乐。

随后几十年,欧美各国相继建立了多个大型音乐科技研究机构,如1975年建立的美国斯坦福大学的音乐及声学计算机研究中心(Center forComputer Research in Music and Acoustics,CCRMA)、1977 年建立的法国巴黎的声学与音乐研究与协调研究所(Institute for Research and Coordination Acoustic/Music,IRCAM)、1994年建立的西班牙巴塞罗那庞培法布拉(UPF)大学的音乐科技研究组(Music Technology Group,MTG)、2001年建立的英国伦敦女王大学数字音乐研究中心(Centrefor Digital Music,C4DM)等。

此外,在亚洲的日本、中国台湾等国家和地区也有多个该领域的公司(如雅马哈)和科研院所。

欧洲由于其浓厚的人文和艺术气息成了音乐科技的世界中心。

图1 音乐科技各领域关系图音乐科技是一个典型的交叉学科领域,分为艺术部分和科技部分。

基于GMM区分性别的汉语方言识别系统王侠;顾明亮;高原;马勇【摘要】提出一种基于GMM的区分不同性别的汉语方言识别系统,系统提取语音的RASTA - PLP特征,在方言电话语音库上进行仿真实验,结果表明在GMM模型阶数为32时,系统的识别率可达到98.66%.同时还将RASTA -PLP特征与SDC特征对比,结果表明系统识别率最高可提高6.05%,且RASTA - PLP特征在性别分类方面优于SDC.【期刊名称】《电声技术》【年(卷),期】2011(035)012【总页数】4页(P39-41,46)【关键词】方言识别;RASTA - PLP;GMM;SDC【作者】王侠;顾明亮;高原;马勇【作者单位】徐州师范大学物理与电子工程学院,江苏徐州221116;徐州师范大学物理与电子工程学院;徐州师范大学语言科学学院,江苏徐州221116;徐州师范大学语言科学学院,江苏徐州221116;徐州师范大学物理与电子工程学院,江苏徐州221116【正文语种】中文【中图分类】TN912.31 引言方言和性别是语音的两个重要信息。

自动方言、性别识别是一项通过分析一段语音来判断说话人性别以及所属方言的技术。

随着全球经济一体化,不同地区的人员往来日益增多,跨地区(尤其是经济发达地区与不发达地区间)的刑事案件呈多发趋势。

利用截获的罪犯语音信息来判断案犯的性别及其所属的方言区对于协助破解案件具有十分重要的价值。

该技术可广泛应用于刑事案件的侦破。

另外,该技术也可用于人机交互,对不同性别不同方言的人采用不同的应答方式,增加人机交互的舒适度。

目前已有学者分别从事语言识别[1-2]和性别识别[3-4]方面的研究,并取得了较好的结果,但是只有较少的文献进行联合性别和方言识别的研究[5]。

提出一种区分不同性别的汉语方言识别方法,提取电话语音信号的RASTA-PLP[6]特征,建立不同性别方言的GMM模型,利用贝叶斯分类器对每个测试音段进行似然打分,进而判断音段所属的性别和方言类别该方法可以同时识别出一段语音所包含的性别和方言信息。

基于Transformer的语音识别技术研究第一章:引言1.1 研究背景语音识别是一项重要的研究领域,随着人工智能的迅猛发展,语音识别技术逐渐成为科技创新的热点。

传统的语音识别技术主要基于隐马尔可夫模型(Hidden Markov Model,HMM)和循环神经网络(Recurrent Neural Network,RNN)等模型,但这些模型在长距离依赖建模和并行计算方面存在一定的问题。

为了解决这些问题,基于Transformer的语音识别技术应运而生。

1.2 研究意义基于Transformer的语音识别技术具有较好的长距离依赖建模能力和较好的并行计算性能,可以提高语音识别的准确性和效率。

在语音识别技术的应用场景中,如语音交互、语音助手等,基于Transformer的语音识别技术能够提供更好的用户体验和更高的应用效果。

1.3 研究内容本文旨在研究基于Transformer的语音识别技术,具体包括以下内容:(1)基于Transformer的语音特征提取方法;(2)基于Transformer的语音识别模型设计;(3)基于Transformer的语音识别实验与分析;(4)对比传统语音识别技术与基于Transformer的语音识别技术的优劣势。

第二章:基于Transformer的语音特征提取方法2.1 传统语音特征提取方法回顾传统的语音特征提取方法包括梅尔频率倒谱系数(Mel Frequency Cepstral Coefficient,MFCC)和线性预测编码(Linear Predictive Coding,LPC)等。

这些方法在一定程度上可以提取到语音的重要特征,但在处理长时序语音数据时存在一定的局限性。

2.2 基于Transformer的语音特征提取方法基于Transformer的语音特征提取方法主要利用Self-Attention机制来提取语音特征。

通过对输入语音序列进行自注意力计算,可以获得序列中不同帧之间的关联性,并提取到更全面、更准确的语音特征。

1语言辨识的基本概念自动语言辨识(又称语种识别),是计算机分析处理一个语音片段以判别其所属语种的技术。

随着当前全球合作的增长,各种余元之间的通信要求增加,这就对自动语言识别提出新的挑战,在机械能够懂得语言含义之前,必须辨别使用了哪种语言。

自动语言辨识的任务在于快速准确的辨识出所使用的语言,目前它已经成为通信和信息领域一个新的学科增长点。

自动语言辨识技术的学术特点在于它横跨技术的融合。

对它的研究,不仅需要掌握信息理论和技术,而且需要具有多种信息处理的手段和方法。

众所周知,语音中包含着多种信息,从语音中提取不同的信息进行处理也就形成了不同语言处理方法。

从内容上分,语音中包含着所属语言种类的信息、说话内容的语义信息和说话人个体特征,因此从识别的角度来说,我们可以利用从语音中提取的这些信息进行识别,语音信息的识别可以分为语音识别、语言辨识和说话人识别。

语音识别中要提取出包含在语音信号中的字词意思和言语内容,说话人识别则是从语音信号中获取说话人的身份,语言辨识是从语音信号中提取出包含的语言的种类(或方言的种类)。

与语音识别和说话人识别不同的是,语言辨识利用的是语音信号中的语言学信息,而不考虑语音信号中的字词意思,不考虑说话人的个性。

语种识别在信息检索和军事领域都有很重要的应用,包括自动转换服务多语言信息补偿等。

在信息服务方面, 很多信息查询中可提供多语言服务, 但一开始必须用多种语言提示用户选择用户语言。

语种辨识系统必须预先区分用户的语言种类, 以提供不同语言种类的服务。

这类典型服务的例子包括旅游信息、应急服务、以及购物和银行、股票交易。

例如AT&T 向处理911 紧急呼救的社会机构和警察局推出语言热线服务。

图1 说明了两个讲不同语言的人是如何通过一个多语言话音系统进行交流。

自动语言辨识技术还能够用于多语言机器翻译系统的前端处理, 当对大量录音资料进行翻译分配时, 需要预先判定每一段语音的语言。

随着信息时代的到来以及国际因特网的发展, 语言辨识越来越显示出其应用价值, 国际上也一直进行着卓有成效的研究和系统开发。

ASV名词解释1. 任务背景ASV(Automatic Speaker Verification)是一种自动说话人验证技术,通过分析说话人的声音特征,判断其是否为预先注册的目标说话人。

ASV技术在语音识别、语音安全等领域有着广泛的应用。

2. ASV的定义ASV是Automatic Speaker Verification的缩写,中文名为自动说话人验证。

它是一种利用计算机技术对说话人进行验证的方法。

ASV通过分析说话人的声音特征,比对其与预先注册的目标说话人的声音特征是否匹配,从而判断说话人的身份是否合法。

3. ASV的原理ASV的原理基于声纹识别技术。

声纹是指每个人独特的声音特征,就像指纹一样可以用来识别个体。

ASV通过提取说话人的声音特征,建立声纹模型和目标说话人的声纹模型进行比对,从而判断说话人的身份。

ASV的过程主要包括以下几个步骤:3.1 特征提取在ASV中,常用的特征提取方法是MFCC(Mel Frequency Cepstral Coefficient)算法。

MFCC算法通过对语音信号进行预处理、傅里叶变换和倒谱分析,提取出与人耳听觉感知相关的声音特征。

3.2 声纹建模在ASV中,声纹建模是指根据特征提取得到的声音特征,建立说话人的声纹模型。

常用的声纹建模方法有高斯混合模型(GMM)和深度神经网络(DNN)等。

3.3 声纹比对在ASV中,声纹比对是指将待验证的说话人的声音特征与预先注册的目标说话人的声纹模型进行比对。

常用的声纹比对方法有高斯混合模型(GMM)和支持向量机(SVM)等。

3.4 决策在ASV中,决策是指根据声纹比对的结果,判断说话人的身份是否合法。

通常使用阈值判决方法,设定一个阈值,当声纹比对的相似度超过该阈值时,判定为目标说话人,否则判定为非法说话人。

4. ASV的应用ASV技术在语音识别、语音安全等领域有着广泛的应用。

4.1 语音识别ASV技术可以用于语音识别中的说话人识别任务。

语音识别技术综述一、引言语音识别技术是指通过计算机技术将人类的语音转化为计算机可识别的文本或命令的过程。

随着人工智能技术的不断发展,语音识别技术在各个领域得到了广泛应用,如智能家居、智能客服、语音助手等。

本文将对语音识别技术进行综述。

二、语音识别技术分类1.基于模板匹配的语音识别技术该方法是通过预先录制一系列标准的语音样本,然后将输入的语音与这些样本进行匹配,从而获得相应的文本或命令。

但是该方法需要大量存储空间和计算资源,并且对说话人的声音和环境噪声敏感。

2.基于统计模型的语音识别技术该方法是通过使用概率模型来描述声学特征与文本之间的关系,从而实现语音识别。

该方法包括隐马尔可夫模型(HMM)、条件随机场(CRF)等。

这些模型需要大量训练数据,并且对说话人和环境噪声有一定容忍度。

3.基于深度学习的语音识别技术该方法是通过使用深度神经网络(DNN)、卷积神经网络(CNN)和循环神经网络(RNN)等深度学习模型来实现语音识别。

该方法具有良好的鲁棒性和准确性,但需要大量训练数据和计算资源。

三、语音识别技术关键技术1.特征提取特征提取是将语音信号转换为计算机可处理的数字信号的过程。

常用的特征包括梅尔频率倒谱系数(MFCC)、线性预测编码(LPC)等。

2.声学模型声学模型是描述声学特征与文本之间关系的数学模型。

常用的声学模型包括隐马尔可夫模型(HMM)、条件随机场(CRF)等。

3.语言模型语言模型是描述文本序列出现概率的数学模型。

常用的语言模型包括n元语法、递归神经网络语言模型(RNNLM)等。

4.解码器解码器是将声学特征转化为文本序列的过程。

常用的解码器包括维特比算法、束搜索算法等。

四、语音识别技术应用领域1.智能家居语音识别技术可以实现智能家居的控制,如通过语音控制灯光、空调等。

2.智能客服语音识别技术可以实现智能客服的自助服务,如通过语音识别用户的问题并给出相应的答案。

3.语音助手语音识别技术可以实现语音助手的功能,如通过语音控制手机进行打电话、发短信等操作。

1语言辨识的基本概念自动语言辨识(又称语种识别),是计算机分析处理一个语音片段以判别其所属语种的技术。

随着当前全球合作的增长,各种余元之间的通信要求增加,这就对自动语言识别提出新的挑战,在机械能够懂得语言含义之前,必须辨别使用了哪种语言。

自动语言辨识的任务在于快速准确的辨识出所使用的语言,目前它已经成为通信和信息领域一个新的学科增长点。

自动语言辨识技术的学术特点在于它横跨技术的融合。

对它的研究,不仅需要掌握信息理论和技术,而且需要具有多种信息处理的手段和方法。

众所周知,语音中包含着多种信息,从语音中提取不同的信息进行处理也就形成了不同语言处理方法。

从内容上分,语音中包含着所属语言种类的信息、说话内容的语义信息和说话人个体特征,因此从识别的角度来说,我们可以利用从语音中提取的这些信息进行识别,语音信息的识别可以分为语音识别、语言辨识和说话人识别。

语音识别中要提取出包含在语音信号中的字词意思和言语内容,说话人识别则是从语音信号中获取说话人的身份,语言辨识是从语音信号中提取出包含的语言的种类(或方言的种类)。

与语音识别和说话人识别不同的是,语言辨识利用的是语音信号中的语言学信息,而不考虑语音信号中的字词意思,不考虑说话人的个性。

语种识别在信息检索和军事领域都有很重要的应用,包括自动转换服务多语言信息补偿等。

在信息服务方面, 很多信息查询中可提供多语言服务, 但一开始必须用多种语言提示用户选择用户语言。

语种辨识系统必须预先区分用户的语言种类, 以提供不同语言种类的服务。

这类典型服务的例子包括旅游信息、应急服务、以及购物和银行、股票交易。

例如 AT&T 向处理 911 紧急呼救的社会机构和警察局推出语言热线服务。

图 1 说明了两个讲不同语言的人是如何通过一个多语言话音系统进行交流。

自动语言辨识技术还能够用于多语言机器翻译系统的前端处理, 当对大量录音资料进行翻译分配时, 需要预先判定每一段语音的语言。

语音识别技术研究综述语音识别技术是指通过人的口述,自动将其转化为机器可理解的文本或命令。

这是一项广泛应用于社会生产、生活和娱乐等方面的技术。

为了实现这个目标,研究者们需要从声音的性质、声学模型、语言模型等各个方面来研究其理论基础,并结合计算机技术的发展,形成了不同的语音识别技术算法体系和工程应用系统。

本文将对语音识别技术的研究进行综述。

1. 语音识别技术的发展历程语音识别技术最早可以追溯到1952年,由贝尔实验室的研究人员Samuel Jay和Alexander Gorin等人提出了最初的语音识别理论。

其后,虽然研究者们积极尝试,但由于计算机技术和语音信号处理技术的发展不足,实验效果难以令人满意。

20世纪80年代,研究者们开始在计算机技术和语音信号处理技术方面取得了突破性进展,尤其是基于隐马尔可夫模型(HMM)的语音识别算法和相关算法的应用推广,获得了较好的效果。

此后,随着自然语言处理技术和神经网络技术的发展,语音识别技术也在不断推进。

2. 语音识别技术的原理语音识别技术的基本原理是将人说话的声音转化为数字信号后,通过特征提取、分类和模式识别等过程进行语音识别。

其中,要解决的最主要问题是声学模型、语言模型和搜索算法。

声学模型通过转化人口述的声音信号为文本,主要将其声学特征表示为动态时间规整(DTW)或声学模型,然后对其进行静态或动态金句特征提取。

语言模型则将对文本语言的理解建立在语言词汇和语法上,以及一个人定义的语音和语调上。

研究者们还需要进行搜索算法的改进,以提高语音识别系统的精确性。

最常用的搜索算法是动态规划(DP),它可以在所有可能的匹配序列中寻找最佳匹配序列,并根据语言模型进行过滤。

3. 语音识别技术的应用领域随着语音识别技术的不断发展,越来越多的领域开始应用这一技术,包括语音娱乐、智能家居、电子商务、医疗服务和金融行业等。

以下是其中一些应用领域:(1)语音娱乐:现在很多娱乐应用都能够通过语音控制,比如说智能音箱、语音助手等平台,这些应用可以为用户提供更加智能、便捷、集成化的操作体验。

ISSN 100020054CN 1122223 N 清华大学学报(自然科学版)J T singhua U niv (Sci &Tech ),2009年第49卷第1期2009,V o l .49,N o .120 4078281基于听感知特征的语种识别张卫强, 刘 加(清华大学电子工程系,北京100084)收稿日期:2007212204基金项目:国家自然科学基金资助项目(60572083);国家“八六三”高技术项目(2006AA 010101,2007AA 04Z 223)作者简介:张卫强(1979—),男(汉),河北,博士研究生。

通讯联系人:刘加,教授,E 2m ail :liuj @m ail.tsinghua .edu .cn 摘 要:为了在语种识别时充分利用人的听感知特性提高识别性能,提出了一种基于听感知模型的特征。

听感知特征采用Gamm atone 滤波器组代替常用的三角滤波器组计算语音信号各子带能量;根据等效矩形带宽模型,确定各滤波器的中心频率与带宽;使用反置等响度曲线模拟人耳对信号不同频率成分的主观响度感受。

在基本听感知特征的基础上,还提出了一、二阶差分特征和偏移差分特征用于语种识别。

对比实验表明,该文所提的听感知特征性能均优于目前普遍使用的M el 频率倒谱系数(M FCC )特征及其衍生特征。

关键词:语音信号处理;语种识别;听感知特征中图分类号:TN 912.3文献标识码:A文章编号:100020054(2009)0120078204Language iden tif ica tion ba sed onaud itory fea turesZHANG W e iq ia ng ,L I U J ia(D epart men t of Electron ic Engi neer i ng ,Tsi nghua Un iversity ,Be ij i ng 100084,Ch i na )Abstract :A n audito ry 2based feature extracti on algo rithm w as developed to i m p rove the recogniti on perfo rm ance of language identificati on algo rithm s using hum an audito ry characteristics .T he sub 2band energies of the extracted audito ry features w ere calculated using a Gamm atone filter bank instead of the commonly used triangle filter bank.T he center frequencies and bandw idth s w ere then determ ined acco rding to the equivalent rectangular bandw idth (ERB )model .T he subjective hum an loudness percep ti on fo r different frequency components w as si m ulated by an inverse equal loudness curve .T he first 2and second 2o rder delta cep strum and the sh ifted delta cep strum w ere derived based on these audito ry features .T ests show that the features outperfo r m the w idely used M el 2frequency cep strum coefficient (M FCC )counterparts .Key words :speechsignal p rocessing;languageidentificati on;audito ry feature语种识别是语音识别的一个分支,它是指从一段语音信号中自动识别出其语种类型。

近年来随着全球化的趋势不断增长,语种识别的重要性也逐渐显现出来。

语种识别可以用于跨语种语音识别系统、语音翻译机、呼叫中心、语音文档检索等系统中[1-2]。

在另外一些关系到国家安全等方面的应用中,语种识别也起着重要的作用。

目前语种识别与语音识别类似,使用最为普遍的特征是M el 频率倒谱系数(M el 2frequency cep strum coefficien t ,M FCC )及其衍生特征,另外还有线性预测倒谱系数(linear p redicti on cep strum ,L PCC )和感知线性预测(p ercep tual linear p redicti on ,PL P )等[2-3]。

其中L PCC 是根据人的发声机理提出的,而M FCC 和PL P 已经部分考虑了人的听感知特性。

在过去的几十年中,人们还提出了其他一些基于听感知的特征[4-6]。

这些特征表现出较强的抗噪能力,实验表明在特定条件下其性能优于传统的特征。

但是其应用还主要局限在数码串识别、说话人识别等领域。

本文仿照M FCC 提出一种用于语种识别的听感知特征。

在听感知模型的基础上给出了听感知特征及其衍生特征的提取方法,通过对比实验验证了其性能。

1 听感知模型1.1 等效矩形带宽在人的听感知系统中,耳蜗可以将声音信号转换为神经发放信号[7]。

当声音传入耳蜗时,声音的机械运动会引起耳蜗内流体压强的变化,从而引起行波沿基底膜传播。

不同频率的信号将会引起基底膜的不同位置产生最大的响应。

这就相当于基底膜上有一组滤波器,各滤波器有不同的中心频率和等效矩形带宽。

实验表明,滤波器的等效矩形带宽(ERB )与中心频率f c 的关系为[8]ERB (f c )=f c Q +B 0,(1)其中:Q 为渐进品质因子,B 0为最小带宽。

本文参照文[8]取Q =9.26449,B 0=24.7H z 。

假设一共有N 个滤波器,覆盖从整个f l 到f u 的频率范围,且各滤波器在频域上按一定的比例重叠,则根据式(1)可以推出,第n 个滤波器的中心频率为[9]f c (n )=-QB 0+(f l +QB 0)exp n -1N ln f u +QB 0f l +QB 0,(2)可以看到f c (n )+QB 0随n 呈指数增长。

1.2 Gamma tone 滤波器组Gamm atone 滤波器最早由A ertsen 和Johannes m a 提出[10],后来用来模拟人耳的听感知特性。

中心频率为f c 的q 阶Gamm atone 滤波器可以表示为g (t )=a tq -1e -2Πbtco s (2Πf c t +Υ)u (t ).(3)其中:u (t )为阶跃函数;a 为归一化因子;Υ为相位项;b 为带宽相关的参数,它与ERB 之间的关系为b =1.019ERB (fc ),(4)这里取q =4,Υ=0。

根据式(2)和式(4),如果取f l =20H z ,f u =4kH z ,N =32,则对于第16个滤波器,即n =16,可以得到f c =669.1851H z ,b=98.7729H z 。

此时,Gamm atone 滤波器的时域响应如图1所示。

对于n =4,8,…,32,各滤波器的频率响应如图2所示。

图1 第16个Gamma tone 滤波器的时域响应图2 Gammatone 滤波器组的频率响应1.3 等响度曲线根据听感知声学,人对声音响度的主观感受不但取决于声压级,还与声音的频率有关,也就是说人耳对不同频率声音的响应是不平坦的[7]。

经过大量的统计,对于每一个固定的响度,可以得到一条声压级与频率的曲线,这样的曲线称为等响度曲线。

将等响度曲线反置,就正好描述了人耳的频率响应。

图3给出了一条平均反置的等响度曲线。

图3 反置的等响度曲线2 基于听感知的语种识别特征2.1 基本特征仿照M FCC 特征的提取方法[3],并结合上节提到的人耳听感知特性,不难得到图4所示的听感知特征提取流程。

首先语音信号经过分帧加汉明窗后进行快速傅立叶变换(FFT ),在频域上先进行反置等响度加权,用来模拟人耳的频率响应。

然后经过Gamm atone 滤波器组,得到子带能量,然后取对数,最后经过离散余弦变换(DCT )去相关即可得到听感知特征。

图4 听感知特征提取流程97张卫强,等: 基于听感知特征的语种识别 与M FCC不同的是,本文所提的听感知特征用Gamm atone滤波器组代替了三角滤波器组,并且用反置等响度曲线进行了加权。

由于它考虑了人耳的听感知特性,并且是一种倒谱系数,所以称它为听感知倒谱系数(audito ry cep strum coefficien t, A CC)。

另外,在特征提取前,语音还进行了预加重处理,滤波器转移函数为H P(z)=1-0.975z-1.(5)在特征提取后,还进行了RA STA(relative sp ectra)滤波来抑制信道噪声,滤波器转移函数为[11]H R(z)=0.12+z-1-z-3-2z-41-0.98z-1.(6)2.2 衍生特征2.2.1 差分特征实验表明,在基本特征的基础上拼接差分特征,可以有效地提高语音识别系统的性能[12]。

常用的差分特征有一阶差分(也称为delta)和二阶差分(也称为accelerati on)。

假设第t帧的基本特征为{cj(t), j=0,1,…,N-1},则其一阶差分特征为[12]∆j(t)=∑Dd=1d[c j(t+d)-c j(t-d)]∑Dd=1d2,j=1,2,…,N-1.(7)其中D为差分窗的大小,一般取值为2。

同理,由一阶差分∆j (t)按式进行计算即可得到二阶差分Αj(t)。

将基本特征与其一阶和二阶差分拼接,即可得到一个新的特征矢量,{cj(t),j=0,1,…,N-1;∆j(t),j=0,1,…,N-1;Αj(t),j=0,1,…,N-1}。

本文将其A CC及其一二阶差分表示为A CC2D2A,对应的M FCC及其一二阶差分表示为M FCC2 D2A。

2.2.2 偏移差分倒谱特征在语种识别中,时序信息是一个非常主要的特征,基于这一点,学者们提出了偏移差分倒谱(sh ifted delta cep strum,SDC)特征[13]。

SDC特征实际上是由k块一阶差分特征拼接而成的,可表示为s(i N+j)(t)=c j(t+iP+d)-c j(t+iP-d), j=1,2,…,N-1;i=0,1,…,k-1.(8)其中:d为计算一阶差分特征时的帧数差,k为块数,P为各块之间的偏移帧数。