基于BP神经网络的曲线拟合

- 格式:pdf

- 大小:304.87 KB

- 文档页数:8

基于BP神经网络的函数拟合算法研究摘要:BP神经网络是一种常用的机器学习算法,被广泛用于函数拟合问题中。

该算法通过反向传播的方式不断调整权重和偏差,从而最小化输出误差。

本文将研究基于BP神经网络的函数拟合算法,包括网络结构的设计、激活函数的选择、权重调节和网络训练等方面,通过实验验证算法的性能。

1.引言函数拟合是数学建模中的基本问题之一、传统的函数拟合方法通常基于数学模型,需要明确的函数表达式和参数。

然而,在实际应用中,往往难以找到精确的函数表达式,这时基于BP神经网络的函数拟合算法就可以派上用场。

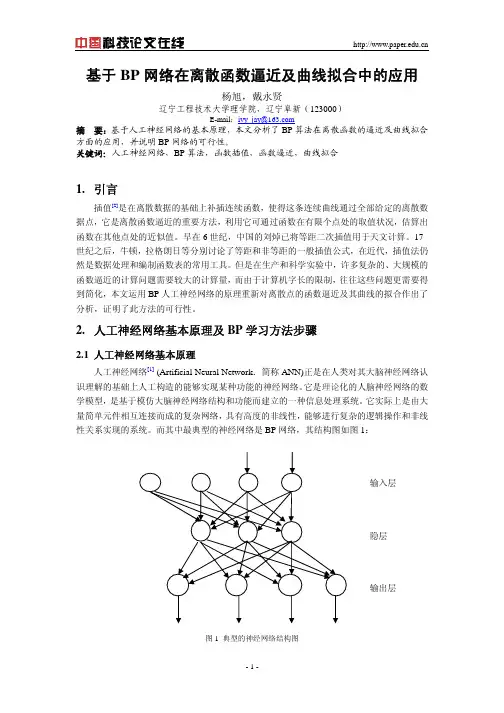

2.BP神经网络介绍BP神经网络是一种前向反馈的多层神经网络,包括输入层、隐藏层和输出层。

输入层接受外部输入,并将其传递给隐藏层,隐藏层再将信息传递给输出层。

每个神经元都有一个权重和偏差,通过调整这些参数来使网络输出接近期望输出。

训练BP神经网络的关键是反向传播算法,通过计算输出误差的梯度来调整权重和偏差。

3.网络结构设计网络结构设计是BP神经网络函数拟合算法的关键。

一般来说,网络的层数和每层的神经元数量需要根据具体问题进行调整。

过多的神经元和层数可能会导致过拟合问题,而过少可能会导致拟合能力不足。

一个经验法则是将隐藏层的神经元数量设置为输入层和输出层神经元数量之和的二分之一4.激活函数选择激活函数在BP神经网络中起到了非常重要的作用,它决定了神经元的输出。

常用的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

Sigmoid函数可以将输出限制在0和1之间,适用于需要进行二分类的问题;ReLU函数在输入大于0时输出等于输入,小于0时输出为0,适用于解决稀疏性问题;Tanh函数将输入限制在-1和1之间,适用于需要进行多分类的问题。

根据具体问题的不同,选择适当的激活函数可以提高网络的性能。

5.权重调节和网络训练BP神经网络的权重调节和网络训练是通过反向传播算法实现的。

反向传播算法首先计算输出层的误差,然后将误差沿着网络反向传播,通过链式规则计算隐藏层和输入层的误差。

基于神经网络的曲线拟合技术研究曲线拟合是计算机图形学、计算机视觉、自然语言处理等领域中的一项重要技术。

它将给定的离散数据拟合成一个连续的函数。

曲线拟合技术在实际应用中非常广泛。

比如,在计算机辅助设计中,它可以用来拟合工件的形状,实现三维造型;在机器视觉中,它可以用来识别和跟踪目标;在自然语言处理中,它可以用来提取语言模型等。

本文将介绍一种基于神经网络的曲线拟合技术。

一、神经网络神经网络是一种模仿人类神经网络的学习算法。

在神经网络中,每个神经元与其他神经元相连形成大量节点。

当刺激信号通过神经元时,节点将进行加权,并将输出传递给其他神经元。

根据不同的神经网络模型,神经元之间的连接权重可以用来表示不同的影响程度。

神经网络模型主要由输入层、输出层和隐藏层组成。

输入层接收输入数据并将其传递到网络的隐藏层。

隐藏层处理数据,其中包括激活函数、偏差和加权值。

输出层将摘要结果返回给用户或下一个处理步骤。

二、曲线拟合曲线拟合的目标是找到一种函数$f(x)$,它可以恰当地逼近一组给定的数据点$(x_i, y_i)$,并且可以在处理新数据时进行插值或外推。

传统的曲线拟合方法,例如多项式拟合、指数拟合和幂拟合,通常具有一定的局限性。

这些方法可能会导致过度拟合,而过度拟合对未知数据的预测效果非常不好。

基于神经网络的曲线拟合技术可以解决传统曲线拟合方法面临的挑战。

这种方法使用具有反向传播算法的神经网络进行训练,将给定的数据点转换成模型的参数。

然后,网络将生成新的数据点,以适应未来未知数据的预测需求。

这种方法的优点在于它可以调整线性组合的权重,因此可以灵活地适应不同的形状和趋势。

同时,神经网络也有自适应的特性,使其可以自动进行学习和调整。

三、神经网络曲线拟合技术的应用神经网络曲线拟合技术在实际应用中具有广泛的应用。

具体应用场景包括:1. 图像处理神经网络曲线拟合技术可以用于图像分析和处理。

将曲线拟合用于细节提取、轮廓识别和图像分割等操作中,能够获得更准确的结果和更好的鲁棒性。

基于BP 神经网络的非线性函数拟合摘要:本文建立BP 神经网络对一个多输入多输出系统的二元非线性函数进行拟合,仿真实验表明:在样本数据充足且不含噪声的情况下,训练的精度越高,逼近的效果越好;数据不充足且不含噪声时,训练精度的高低在一定范围内对于网络性能没有决定性的影响,网络性能主要取决于初始化;不管训练数据是否充足,若含有噪声,训练精度过高会使网络泛化能力降低。

0引言作为当前应用最为广泛的一种人工神经网络,BP网络在函数逼近、模式识别、数据压缩、智能控制等领域有着非常广泛的应用。

BP网络由大量简单处理单元广泛互联而成,是一种对非线性函数进行权值训练的多层映射网络,结构简单,工作状态稳定,具有优良的非线性映射能力,理论上它能够以任意精度逼近任意非线性函数。

BP神经网络通过学习能够存储大量输入输出样本中蕴含的映射关系,只需提供足够的样本模式对BP网络进行训练,而无需事先了解数学方程。

本文采用BP神经网络解决下列函数拟合问题。

函数逼近:设计一个神经网络拟合下列多输入多输出函数:y1=2+ x1 RP1.5-1.5sin(3 x2); y 2 = x 2 sin( x 1 )+ x 1 cos( x 2 ); 1< x1, x2<5 产生200 个数据,其中100 个用来训练网络,另外100 个用于网络模型的测试。

1 BP 神经网络结构和算法一个典型的3层BP神经网络结构如图1所示,包括输入层、隐含层和输出层。

各层神经元之间无反馈连接,各层内神经元之间无任何连接。

其中隐含层的状态影响输入输出之间的关系,及通过改变隐含层的权系数,就可以改变整个多层神经网络的性能。

BP神经网络的学习过程由正向传播和反向传播组成。

在正向传播中,输入的样本从输入层经过隐含层之后,传向输出层,在逐层处理的过程中,每一层神经元的状态只对下一层神经元的状态产生影响。

在输出层把现行输出和期望输出进行比较,如果现行输出不等于期望输出,则进入反向传播过程。

神经网络实验报告基于BP网络的曲线拟合学院:控制学院*名:***学号: ********2015年6月一、实验目的⑴掌握BP神经网络的权值修改规则⑵利用BP网络修改权值对y=sin(x)曲线实现拟合二、实验要求人工神经网络是近年来发展起来的模拟人脑生物过程的人工智能技术,具有自学习、自组织、自适应和很强的非线性映射能力。

在人工神经网络的实际应用中,常采用BP神经网络或它的变化形式,BP神经网络是一种多层神经网络,因采用BP算法而得名,主要应用于模式识别和分类、函数逼近、数据压缩等领域。

BP网络是一种多层前馈神经网络,由输入层、隐层和输出层组成。

层与层之间采用全互连方式,同一层之间不存在相互连接,隐层可以有一个或多个。

BP算法的学习过程由前向计算过程和误差反向传播过程组成,在前向计算过程中,输入信息从输入层经隐层逐层计算,并传向输出层,每层神经元的状态只影响下一层神经元的状态。

如输出层不能得到期望的输出,则转入误差反向传播过程,误差信号沿原来的连接通路返回,通过修改各层的神经元的权值,使得网络系统误差最小,最终实现网络的实际输出与各自所对应的期望输出逼近。

三、实验内容3.1 训练数据导入要对BP网络进行训练,必须准备训练样本。

对样本数据的获取,可以通过用元素列表直接输入、创建数据文件,从数据文件中读取等方式,具体采用哪种方法,取决于数据的多少,数据文件的格式等。

本文采用直接输入100个样本数据的方式,同时采用归一化处理,可以加快网络的训练速度。

将输入x和输出y都变为-1到1之间的数据,归一化后的训练样本如下图:3.2 网络初始化根据系统输入输出序列,确定网络输入层节点数为1,隐含层节点数H 为20,输出层节点数为1。

初始化输入层、隐含层和输出层神经元之间的连接权值ij w ,jk v ,初始化隐含层阈值0t ,输出层阈值1t ,给定学习速率0a ,1a 和u ,给定算法迭代次数inum 和最大可接受误差error ,同时给定神经元激励函数sigmoid 。

BP 神经网络与多项式拟合曲线摘要 首先介绍了曲线拟合的原理及其在曲线拟合中的应用。

接着讨论了BP 神经网络的原理,研究了非线性拟合的在MATLAB 中仿真过程 通过比较可以看出利用神经网络进行非线性拟合具有拟合速度快、拟合精度高的特点。

关键词:曲线拟合;BP 神经网络;MATLAB0 引言在实际工程应用和科学实践中,为了描述不同变量之间的关系,需要根据一组测定的数据去求得自变量x 和因变量y 的一个函数关系)(x f y =,使其在某种准则下最佳地接近已知数据。

曲线拟合是用连续曲线近似地刻画或比拟平面上离散点组所表示坐标之间的函数关系的一种数据处理方法。

从一组实验数据(i i y x ,) 中寻求自变量x 和因变量y 之间的函数关系)(x f y =来反映x 和y 之间的依赖关系,即在一定意义下最佳地逼近已知数据。

应用曲线拟合的方法揭示数据之间内在规律具有重要的理论和现实意义。

1 多项式曲线拟合 1.1 曲线拟合原理最小二乘法原理:对给定的数据点(i i y x ,)(N i ,...,2,1=),在取定的函数类φ中,求函数φ∈)(x f ,使误差i i y x f -)((N i ,...,1,0=)的平方和最小,即[]∑=-Ni iiy x f 02)(取到最小值。

从几何意义上讲,就是寻求与给定点(i i y x ,)(N i ,...,2,1=)的距离平方和为最小的曲线)(x f y =。

函数)(x f 称为拟合函数或最小二乘解,求拟合函数)(x f 的方法称为曲线拟合的最小二乘法。

拟合函数和标志数据点之间的垂直距离是该点的误差。

对该数据点垂直距离求平方,并把平方距离全加起来,拟合曲线应是使误差平方和尽可能小的曲线,即是最佳拟合。

1.2 最小二乘法曲线拟合对非线性函数)+=,进行曲线拟合。

xy-16ex p(22x1.2.1 拟合过程选取拟合区间为-5:0.1:5.用10阶、30阶不同阶数对函数进行拟合,绘制出拟合曲线图,比对拟合效果差异。

基于BP网络的曲线拟合法的线图处理

杨小安

【期刊名称】《现代制造工程》

【年(卷),期】2003(000)008

【摘要】通过实例验证BP神经网络对解析曲线及非解析曲线都非常有效,供开发面向对象的参数化CAD系统时参考.

【总页数】2页(P33-34)

【作者】杨小安

【作者单位】西宁市长安大学322信箱,710064

【正文语种】中文

【中图分类】TH132.413

【相关文献】

1.应用BP神经网络实现基于等高线图像的CFD地形网格 [J], 甘勇;刘新新;郑远攀

2.基于流水线图像处理结构的多层模板相关神经元网络 [J], 安向京;常文森

3.BP神经网络在机械零件曲线图处理中的应用 [J], 宗望远;王巧华;朱松德

4.基于神经网络的线图数据处理模型 [J], 陈东

5.基于改进粒子群算法优化BP神经网络的废水处理软测量模型 [J], 何丹;林来鹏;李小勇;牛国强;易晓辉;黄明智

因版权原因,仅展示原文概要,查看原文内容请购买。

基于BP神经网络的函数拟合摘要:随着科学技术的飞速发展,人工神经网络也迅速发展,它更是智能领域中的重要组成部分,现在它已经被广泛的应用到了数据处理、模式识别、机器控制、专家系统等多个领域之中,并且在预测领域得到了更深入的发展。

BP神经网络是人工智能网络中的一个典型算法,而且它本身具有很强的非线性映射能力,解决一些非线性问题更是它最突出的一环。

BP神经网络不止这-个优点,它的网络拓扑结构简单,而且具有较高的误差精度,并且它易于用编权实现,而它还具有很强的可操作性,等等。

因此,BP神经网络的应用更加广泛,成为智能领域中的最重要的算法之一。

本文就BP神经网络的基本原理进行论述,并且利用BP神经网络进行二元函数拟合,对相关数据误差进行分析,并讨论如何在拟合过程中选择合适的激励函数,以使得拟合函数逼近真实函数,最后,对函数拟合的相关知识进行总结。

关键词:模式识别;BP神经网络;函数拟合;激励函数第一章绪论1.1 人工神经网络研究意义人工神经网络[1]是为了进行信息处理而建立的一种数学模型,它之所以被称为神经网络是因为这一数学模型所应用的结构是一种类似大脑神经突触的联接结构。

在很多领域,例如工程界、学术界等,通常称其为类神经网络,在更多的时候他们也简称其为“神经网络”。

神经网络这一数学模型是由数据庞大的“神经”节点进行互联形成的一个结构,它也是一种运算模型。

在这个模型中的每一个神经元节点都代表了一种特定的输出函数我们把这个特定的函数称作激励函数(activation function)[2],有时也称之为转换函数。

每两个人工神经元节点之间的连接都会对通过的信息进行加权处理,对于这种加权处现,我们称它们为连接权系数或直接称它为权重(weight),这一操作间接的模拟了神经网络的记忆功能。

网络的输出并不是固定不变的,它会根据网络的连接权系数、连接方式以及激励函数的不同而发生变化。

它的理念是受到了一定的启发而形成的,生物的动作、思想是在生物(人或其他动物)神经网络的运作下产生的,这也为人工神经网络的产生提供了支持。

基于BP神经网络的非线性函数拟合——技术报告技术报告:基于BP神经网络的非线性函数拟合1.引言非线性函数拟合是机器学习领域的重要研究内容之一,其在模式识别、图像处理、金融预测等领域有着广泛的应用。

传统的机器学习方法或者回归方法往往无法很好地拟合非线性函数,而BP神经网络作为一种强大的学习工具,可以有效地解决非线性函数拟合问题。

本报告主要介绍了基于BP神经网络的非线性函数拟合方法及其应用。

2.BP神经网络介绍BP神经网络是一种多层前馈神经网络,在模式识别和函数逼近中有着广泛的应用。

BP神经网络由输入层、隐层和输出层组成,其中输入层负责接收输入数据,隐层负责进行学习和特征提取,输出层负责输出结果。

BP神经网络通过正向传播和反向误差传播算法来进行训练,以提高网络的拟合能力。

3.非线性函数拟合方法在进行非线性函数拟合时,首先需要确定输入特征和输出结果。

然后将拟合问题转化为一个监督学习问题,将已知的样本数据输入BP神经网络进行训练。

具体步骤如下:(1)准备数据:收集与非线性函数相关的样本数据,并进行预处理,如归一化处理。

(2)设计网络结构:确定BP神经网络的输入层神经元个数、隐层神经元个数和输出层神经元个数。

(3)初始化网络参数:随机初始化BP神经网络的连权和阈值。

(4)正向传播:输入样本数据,通过正向传播计算网络的输出结果。

(5)反向传播:根据计算得到的输出结果,使用反向传播算法来更新网络的权值和阈值,以减小预测结果与实际结果之间的误差。

(6)训练网络:重复进行正向传播和反向传播,以提高网络的拟合能力,直到达到训练终止条件。

(7)测试网络:使用测试数据来评估已经训练好的BP神经网络的拟合能力。

4.实验结果与分析我们在实验中使用了多组非线性函数数据进行拟合,包括正弦函数、指数函数等。

通过对比实验结果和原始函数的对比图,我们可以发现BP 神经网络在非线性函数的拟合方面有着较好的效果。

拟合结果和原始函数之间的误差较小,拟合曲线能够较好地覆盖样本点。

基于BP神经网络的弗兰克-赫兹实验曲线拟合

王蕴杰

【期刊名称】《大学物理实验》

【年(卷),期】2013(026)006

【摘要】BP神经网络通过调整连接权重便可按预定精确度逼近非线性函数,利用这一特点可对非线性函数关系进行拟合.利用BP神经网络对弗兰克-赫兹实验数据进行处理,结果显示该方法处理结果精度高,拟合效果好.

【总页数】2页(P95-96)

【作者】王蕴杰

【作者单位】青海师范大学,青海西宁810008

【正文语种】中文

【中图分类】O4-39

【相关文献】

1.基于MATLAB的弗兰克-赫兹实验数据处理 [J], 张容

2.基于NI myDAQ数据采集器的弗兰克-赫兹实验系统 [J], 廖德驹;沈韩;崔新图;冯饶慧;方奕忠;林志森

3.基于MATLAB编程的弗兰克-赫兹实验数据处理方法探讨 [J], 李立; 张皓晶; 张雄

4.基于支持向量机的弗兰克-赫兹实验曲线拟合 [J], 周祉煜;孟倩

5.弗兰克-赫兹实验的BP神经网络处理方法设计 [J], 赵建飞;王蕴杰

因版权原因,仅展示原文概要,查看原文内容请购买。

闲来无事,利用神经网络进行曲线拟合目的:拟合正弦曲线;数据源:正弦曲线+扰动,来自y=sin(x)+n;测试数据:来自y=sin(x);神经网络:BP神经网络,nntool工具箱;网络:1×10×1;即单隐含层,且隐含层有10个节点;MATLAB代码:%%%本例使用神经网络模拟曲线拟合%%clcclear%%x=linspace(-2*pi,2*pi,100);%生成输入数据y=sin(x);%求出输入数据对应的目标值n=0.1*rand(1,length(x));%对目标值加入干扰y=y+n;%求出实际目标值%%[xx,ps]=mapminmax(x);%对x进行归一化Data_input=xx;%网络训练输入Data_target=y;%网络训练输入对应的目标值Data_test=linspace(-5,5,20);%网络测试数据Data_t=mapminmax('apply',Data_test,ps);%网络测试数据归一化Data_true=sin(Data_test);%网络测试数据对应的目标值%%%打开nntool,利用输入输出数据训练网络,网络命名为network%%Data_y=sim(network,Data_t);%利用训练好的网络求出测试数据对应的实际输出值%%figure(1)e=Data_true-Data_y;plot(e)%绘制误差曲线xlabel('X轴');ylabel('Y轴');legend('误差')%%figure(2)plot(Data_test,network1_outputs,'*',x,y)xlabel('X轴');ylabel('Y轴');legend('预测值','实际值','location','NorthEast')下面具体说明nntool工具箱的使用:命令行输入nntool:打开工具箱界面:单击Import,导入训练数据,并选择对应的训练类型,如图所示:新建网络,命名为network,采用BP神经网络,即误差反向算法,选择Input data和Target data,其他选项默认,点击Create创建BP神经网络,如下图所示:点击View,可以预览网络结构,如下图所示:返回主界面,选中新建的network,然后点击Open打开,选择Train,再次选择Inputs和Targets,开始训练网络,点击Tarin netwrk训练过程和结果如下图所示:为了便于在M文件中使用新建的network,可以将其导出到工作空间,点击Export:工作空间中出现network,如下图所示:接下来可以使用sim函数求网络对测试数据的输出,并绘制误差曲线:结果:可以看出,拟合效果很好。

神经网络实验报告

基于BP网络的曲线拟合

学院:控制学院

姓名:李嘉頔

学号:09423021

2015年6月

一、实验目的

⑴掌握BP神经网络的权值修改规则

⑵利用BP网络修改权值对y=sin(x)曲线实现拟合

二、实验要求

人工神经网络是近年来发展起来的模拟人脑生物过程的人工智能技术,具有自学习、自组织、自适应和很强的非线性映射能力。

在人工神经网络的实际应用中,常采用BP神经网络或它的变化形式,BP神经网络是一种多层神经网络,因采用BP算法而得名,主要应用于模式识别和分类、函数逼近、数据压缩等领域。

BP网络是一种多层前馈神经网络,由输入层、隐层和输出层组成。

层与层之间采用全互连方式,同一层之间不存在相互连接,隐层可以有一个或多个。

BP算法的学习过程由前向计算过程和误差反向传播过程组成,在前向计算过程中,输入信息从输入层经隐层逐层计算,并传向输出层,每层神经元的状态只影响下一层神经元的状态。

如输出层不能得到期望的输出,则转入误差反向传播过程,误差信号沿原来的连接通路返回,通过修改各层的神经元的权值,使得网络系统误差最小,最终实现网络的实际输出与各自所对应的期望输出逼近。

三、实验内容

3.1训练数据导入

要对BP网络进行训练,必须准备训练样本。

对样本数据的获取,可以通过用元素列表直接输入、创建数据文件,从数据文件中读取等方式,具体采用哪种方法,取决于数据的多少,数据文件的格式等。

本文采用直接输入100个样本数据的方式,同时采用归一化处理,可以加快网络的训练速度。

将输入x和输出y都变为-1到1之间的数据,归一化后的训练样本如下图:

3.2网络初始化

根据系统输入输出序列,确定网络输入层节点数为1,隐含层节点数H 为20,输出层节点数为1。

初始化输入层、隐含层和输出层神经元之间的连接权值ij w ,

jk v ,初始化隐含层阈值0t ,输出层阈值1t ,给定学习速率0a ,1a 和u ,给定算法

迭代次数inum 和最大可接受误差error ,同时给定神经元激励函数sigmoid 。

3.3前向输出计算

根据输入变量x ,输入层和隐含层间连接权值ij w 和隐含层阈值0t ,计算隐含层输出P :

)

)((∑=-⋅=n

i j i ij j t x w u f P 10l

j ,...,,21=其中n 为输入层节点数,本实验中取1;l 为隐含层节点数,本实验中取20;f 为隐含层激励函数,该函数可设置为多种形式,本实验中所选函数为:

x

e x

f -+=

11

)(根据隐含层输出P ,隐含层和输出层间连接权值jk v 和输出层阈值1t ,计算BP 神经网络预测输出k Q :

∑=-=l

j k

jk j k t v P Q 11m

k ,...,,21=其中m 为输出层节点数,本实验中取1。

3.4权值修正

根据网络预测输入Q 和期望输出y ,计算网络预测误差e :

k

k k Q y e -=BP 神经网络采用梯度修正法作为权值和阈值的学习算法,从网络预测误差的负梯度方向修正权值和阈值。

在本实验采用的sigmoid 激励函数下,隐含层和输出层间连接权值和输出层阈值更新公式为:

k

j jk jk e P a u v v 1*+=m k l j ,...,,;,...,,2121==k

k k e u t t *+=11m

k ,...,,21=输入层和隐含层间连接权值和输出层阈值更新公式为:

∑=*-+=m

k k

jk i j j ij ij e v u x P P a w w 101)(l

j n i ,...,,;,...,,2121==∑=*-+=m

k k

jk j j j j e v u P P a t t 1

0001)(l

j ,...,,21=

通过是否达到迭代次数或者错误率是否在可接受范围内来判断算法迭代是否结束,若没有结束,则继续迭代。

四、实验步骤和结果

3.1数据输入和归一化

%function[x,y,y1,Error]=BPnet(t)

%清空环境变量

clc;

clear;

num=1;%要拟合的曲线试举例

for i=0.01*pi:0.02*pi:2*pi%训练样本

x(num)=i;%输入数据

y(num)=sin(x(num));%期望输出

num=num+1;

end

num1=size(x,2);

max_x=max(x);%训练样本归一化

max_y=max(y);

min_x=min(x);

min_y=min(y);

%最大最小法(归一化)

for i=1:num1

x(i)=2*((x(i)-min_x)/(max_x-min_x))-1;

y(i)=2*((y(i)-min_y)/(max_y-min_y))-1;

end

3.2网络结构初始化

H=20;%隐含层神经元个数

w=2*rand(1,H)-1;%初始化隐层权值

v=2*rand(1,H)-1;%初始化输出层权值

t0=2*rand(1,H)-1;%隐层阈值

t1=2*rand(1,1)-1;%输出层阈值

a0=0.4;a1=0.3;u=1;%步长

error=0.0001;err=error;%可接受误差

inum=1;

y1=zeros(1,100);

3.3BP神经网络训练

while inum<=20&err>=error

ii=randperm(length(x));

y2=y(ii);

x2=x(ii);%打乱样本顺序

err=0;

for m=1:100

d=y2(m);%给定输出

for i=1:H

p(i)=w(i)*x2(m)+t0(i);

P(i)=logsig(p(i).*u);

end

q1=0;

for j=1:H

q(j)=P(j)*v(j);

q1=q1+q(j);

end

q2=q1+t1;%输出

%if m<=100

Q=q2;%Q=tanh(q2.*u);%输出层输出

%Q=2*logsig(q2.*u)-1;%输出层也可用sigmoid做激励函数

%else

%Q=-logsig(q2.*u);

%end

y1(m)=Q;

e=[(d-Q).^2]/2;%误差平方函数

err=err+e;

c1=(d-Q)*u;

%c1=2*(d-Q)*Q*(1-Q)*u;

for n=1:H

d1(n)=c1*P(n);

v1(n)=v(n)+a1*d1(n);

end

t1=t1+a1*c1;%对输出层的每一个权值修正

for r=1:H

d0(r)=c1*v(r)*(1-P(r))*x2(m)*P(r);

w1(r)=w(r)+a0*d0(r);

t0(r)=t0(r)+a0*c1*v(r)*(1-P(r))*P(r);%对隐层的每一个权值修正end

w=w1;

v=v1;

end

err=err/100;

erro(inum)=err;

inum=inum+1;

end

3.4BP神经网络预测

num=1;

for i=0.02*pi:0.02*pi:2*pi%预测样本

z(num)=i;

z1(num)=i;

num=num+1;

end

num1=size(z,2);

max_z=max(z);%预测样本归一化

min_z=min(z);

%最大最小法(归一化)

for i=1:num1

z(i)=2*((z(i)-min_z)/(max_z-min_z))-1; end

for m=1:100

for i=1:H

p(i)=w(i)*z(m)+t0(i);

P(i)=logsig(p(i).*u);%隐含层输出end

q1=0;

for j=1:H

q(j)=P(j)*v(j);

q1=q1+q(j);

end

q2=q1+t1;

Q=q2;%输出层输出

y2(m)=Q;

end

figure;plot(z,sin(z1),'b');%期望输出

hold on;

plot(z,y2,'r*');%预测输出

3.5BP神经网络预测结果

迭代20次后的预测结果如下图:

50次后的预测结果如下图:

迭代

迭代200次后的预测结果如下图:

通过上面四个图可以看出,随着迭代次数的增加,预测误差是逐渐减小的,在开始的迭代中,误差减小较快,最后经过规定次数的迭代,基本上能将函数y=sin(x)拟合出来。

虽然BP神经网络具有较高的拟合能力,但是预测结果仍然存在一定的误差,基本的BP神经网络对于一些复杂系统的预测能力会比较差,其拟合能力存在局限性。