win7+eclipse+hadoop开发环境搭建

- 格式:doc

- 大小:162.00 KB

- 文档页数:8

基于Eclipse的Hadoop应用开发环境的配置/s/blog_537770820100byho.html基于Eclipse的Hadoop应用开发环境的配置配置好了Hadoop运行环境,下一步就要配置,开发环境了。

实际上开发环境很好配置,网上很多的帖子,都指向了IBM提供的Hadoop开发工具,这个工具很好用。

大家打开这个网址,很容易就能Step by step搞定,/tech/mapreducetools。

但是细心的读者不难发现,这个工具似乎是个绝版,到现在似乎还是停留在2007年3月23日呢,而且其支持的Eclipse也是3.3的,Hadoop更是0.17的。

很多人在forum上还抱怨,安装上这个工具后,报出错误:Refresh DFS Children has encountered a problem:Refreshing DFS node failed: 1。

呵呵,这个问题我也遇到了,我也很郁闷。

我心里也在骂IBM这帮官僚如此不思进取。

这两天我在装载Hadoop Core的Examples测试,由于想要多了解些Hadoop,于是就打开了Hadoop的每个子目录,在打开/hadoop-0.19.0 /contrib/意外发现了eclipse-plugin,心里不禁窃喜,不知道是不是IBM的这个工具的升级版移到这里还是其他什么原因,工具不是在这里吗?只不过与以前不同,是个jar包!我把hadoop-0.19.0-eclipse-plugin.jar,拷贝到eclipse-SDK- 3.4-win32\eclipse\plugins下面,启动eclipse,居然真的安装成功了,真的是该工具的升级版,也没有了那个错误!真的是很意外!界面是这样滴,选择Window->Open Perspective,可见到一个窗口,里面有一个小象图标:Map/Reduce,点击它,会打开一个新的Perspective。

配置hadoop配置hadoop-eclipse开发环境由于hadoop-eclipse-1.2.1插件需要自行编译,所以为了图省事而从网上直接下载了这个jar包,所以如果有需要可以从点击并下载资源。

下载这个jar包后,将它放置在eclipse/plugins目录下,并重启eclipse即可。

如果你需要自己编译该插件,请参考文献。

配置hadoop-1.2.1与eclipse链接信息如果没有意外,在你的eclipse的右上角应该出现了一只蓝色的大象logo,请点击那只大象。

之后,在正下方的区域将会多出一项Map/Reduce Locations的选项卡,点击该选项卡,并右键新建New Hadoop Location。

这时应该会弹出一个对话框,需要你填写这些内容:•Location name•Map/Reduce Master•DFS Master•User nameLocation name指的是当前创建的链接名字,可以任意指定;Map/Reduce Master指的是执行MR的主机地址,并且需要给定hdfs协议的通讯地址;DFS Master指的是Distribution File System 的主机地址,并且需要给定hdfs协议的通讯地址;User name指定的是链接至Hadoop的用户名。

参考上一篇文章的设计,hadoop-1.2.1集群搭建,这里的配置信息将沿用上一篇文章的设定。

因此,我们的设置情况如下数之后确认,这样便在eclipse左边出现了HDFS的文件结构。

但是现在你只能查看,而不能添加修改文件。

因此你还需要手工登录到HDFS上,并使用命令修改权限。

在完成这些步骤后,需要配置最后的开发环境了。

配置开发环境如果是在Windows上模拟远程开发,那么你需要将hadoop-1.2.1.tar.gz解压一份,我们将解压后得到的hadoop-1.2.1放置在documents里之后,打开 eclipse -> Preferences -> Hadoop Map/Reduce,将解压后的路径添加在hadoop installation directory 中,并点击apply使设置生效。

hadoop Map/Reduce开发实例1) Eclipse插件配置与程序开发在windows下开发Map/Readuce程序,首先要在windows安装cygwin,目的是让hadoop在执行过程中可以用到linux下的一些shell命令,sygwin则给window装了一个linux外壳。

配置eclipse及运行程序具体步骤如下:1. 安装cygwin步骤略过(网上安装步骤很多,因为不是此篇文章重点,不再赘述)但值得注意的在安装过程中一定要安装以下部分(1). net下的openssh和openssl,base下的sed,devel下的subversion(2). 设置环境变量path,需要设置 Cygwin 的bin 目录,具体是否需要设置 Cygwin 的usr\bin 目录还不是很确定,但本人设置了提示:cygwin安装完成后会有cygwin ssd服务在windows服务中,可以启动也可以不启动。

2. 下载并安装hadoop,(本人使用hadoop0.20.2版本)下载:/dyn/closer.cgi/hadoop/core/安装:即将hadoop-0.20.2.tar.gz解压即可2. 下载并安装hadoop eclipse插件(1)下载插件:https:///jira/browse/MAPREDUCE-1280(注意:此hadoop-eclipse-plugin-0.20.3-SNAPSHOT.jar插件支持eclipse3.4+,hadoop0.20.2目录 hadoop-0.20.2\contrib\eclipse-plugin中的插件只支持到eclipse3.3版本,版本不支持的话,导致插件不能正常使用。

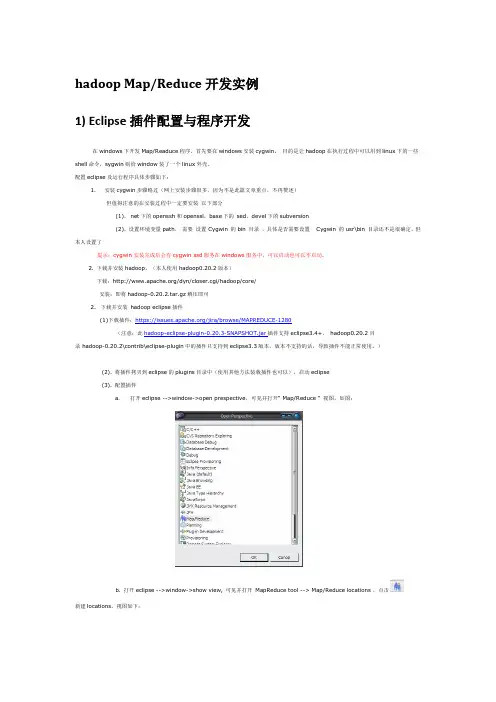

)(2). 将插件拷贝到eclipse的plugins目录中(使用其他方法装载插件也可以),启动eclipse(3). 配置插件a.打开eclipse -->window->open prespective,可见并打开“ Map/Reduce ” 视图,如图:b. 打开eclipse -->window->show view, 可见并打开MapReduce tool --> Map/Reduce locations ,点击新建locations,视图如下:General选项卡各个参数说明:Location name:本地视图的location名称,自己自定义一个名称即可Map/Reduce Master组内host和port: 为Map/Reduce Master的地址与端口号,此地址端口与hadoop服务器安装配置过程中conf/mapred-site.xml文件中mapred.job.tracker节点值一致。

准备工作:Window版hadoop下载地址:/apache/hadoop/common/hadoop-1.2.1/hadoop-1.2.1-bin.tar.gz下载Eclipse hadoop的插件地址:hadoop-eclipse-plugin-1.2.1.jarLinux Hadoop下载地址:/apache/hadoop/common/hadoop-1.2.1/hadoop-1.2.1.tar.gz在linux服务器上创建用户名为hadoop的用户:[root@localhost ~]# useradd hadoop设置密码:[root@localhost ~]# passwd hadoop添加hadoop用户使用vim、vi等命令的权限:[root@localhost ~]# vim /etc/sudoersroot ALL=(ALL) ALLhadoop ALL=(ALL) ALL此处保存是可能需要使用:wq!强制保存。

以下文档如无特殊说明均使用hadoop账户进行操作1.Hadoop单机部署1.下载hadoop-1.2.1.tar.gz文件。

2.运行命令tar zxvf hadoop-1.2.1.tar.gz将hadoop解压到自己喜欢的目录下(我的解压在/usr/local/目录下)3.编辑hadoop-1.2.1目录下的conf/hadoop-env.sh文件,将其中的JA V A_HOME配置为自己的jdk目录(如我的为:JA V A_HOME=/usr/local/jdk1.7.0_60)4.到此出Hadoop单机部署基本完成。

5.单机模式的操作方法默认情况下,Hadoop被配置成以非分布式模式运行的一个独立Java进程。

这对调试非常有帮助。

下面的实例将已解压的 conf 目录拷贝作为输入,查找并显示匹配给定正则表达式的条目。

输出写入到指定的output目录。

[hadoop@localhost hadoop-1.2.1]$ mkdir input[hadoop@localhost hadoop-1.2.1]$ cp conf/*.xml input[hadoop@localhost hadoop-1.2.1]$ bin/hadoop jar hadoop-examples-1.2.1.jargrep input output 'dfs[a-z.]+' $ cat output/*注:语法不理解没关系看下面进一步说明显示结果 1 dfsadmin2.Hadoop伪分布式模式部署1.下载hadoop-1.2.1.tar.gz文件。

Cygwin的安装1.先在/install.html上下载安装文件打开后双击setup.exe安装。

如下图:2. 直接点击下一步后如下图:图中有三个选项,意思一看就懂啊。

这里直选择下一步3.直接点击下一步后如下图:这里是要选择安装路径,设置在哪里都可以。

没有特殊要求。

4. 设置好路径后下一步进入下图:这是设置Cygwin安装文件的目录。

先安装的exe只是个引导它需要自己下载安装文件。

设置这个目录就是存储这些文件的。

5.设置好后下一步进入下图:这里是你网络的链接方式,第一个是直接链接,第二个是使用IE代理,第三个使用你指定的HTTP/FTP代理。

你要根据你自己的情况选择。

通常选第一个如不好使则查看你的联网是否使用了代理用了就选下面两个中的一个。

6.设置好后下一步进入下图:选择其中一个url用作下载的站点。

我选第一就行挺快的。

你的不行可以试试别的。

也可以在下面的User URL中添加url写完地址一点Add就加入到上面的url列表中了。

然后选择你自己加入的url即可。

如果自己加入可以尝试一下这个url:/pub/。

然后点击下一步进行安装文件的下载,需要点时间。

如果点击下一步后出现这个错误Internal Error: gcrypt library error 60 illegal tag。

就是上一步网络选择的问题或者选择的url不能下载。

自己可以尝试改动一下。

正常下载的话也可能出现一个警告窗口如下图:点击确定即可。

随即会进入下图。

7. 来到此图就要开始进行一些配置了。

选择一下要安装的包。

如下图:首先:选择其中的Base Default,通常这里的包都已经选择上了。

你要确保sed已选择上,这样你可以在eclipse中使用hadoop了。

如下图这样即可:其次:选择Devel Default,将其中的subversion选中第一个即可。

如下图:最后:选择Net default包,将其中的openssh及openssl选上。

Windows 7安装Eclipse 搭建C/C++开发环境分类:C++技术2011-11-06 17:04 508人阅读评论(0) 收藏举报Windows 7安装Eclipse 搭建C/C++开发环境(2011-07-28 11:27:48)操作系统:Windows 7 SP1软件:JRE1. 安装JRE由于Eclipse本身是用Java开发而成,因此自然需要使用到JRE(Java Runtime Environment),如果先前已经安装过就可以不必安装了。

JRE下载地址:2. 安装Eclipse进入下载Eclipse Classic版本,下面是Eclipse Classic 的下载链接:解压至C:\Program Files,在桌面上创建的快捷方式。

3. 安装CDT进入下载跟Eclipse对应版本的CDT(C/C++ Development Tooling),下面是CDT 的下载链接:&url=&mirror_id=1093打开Eclipse,进入菜单Help,选择Install New Software…,点击右边Add按钮,在Add Repository对话框中点击右下角的Archive…,浏览到你之前下载保存路径,选中并双击,勾选所有CDT部件,然后点击Next>,继续Next>,选中“I accept the terms of the license agreement –Finish”,点击Finish开始安装CDT。

安装完CDT后重启Eclipse。

4. 安装MinGW进入projects/mingw/files/MinGW/下载最新的下载器MinGW-Get,这里使用,双击运行,选择安装路径,把MinGW安装C:\MinGW,选择“C++ Compiler”和“MSYS Basic System”两个组建,然后开始下载安装。

由于网络等原因,安装过程中会提示有两个文件下载不了,安装不完整:前者可以在sourceforge网站上找到,后者没有找到,但是都无法下载,后来动用百毒和股沟,再加上fg715p,终于在网上下到了这两个文件,把他们拷贝到以下路径:C:\MinGW\var\cache\mingw-get\packages然后重新运行,这样才安装完整。

Win7 Eclipse C++开发环境的搭建与配置1、下载与安装Eclipse下载的Eclipse只须解压在D:\Eclipse文件夹中即可,双击其中eclipse.exe即可使用,但前提是安装了JDK2、安装MinGWMinGW,即“Minimalist GNU for Windows”的缩写,是GNU编译器集和GNU Binutils的一个端口,用来开发本地微软应用程序。

注意:eclipse和MinGW一定要在同级目录下,否则eclipse无法找到MinGW。

比如说,eclipse安装在D:\Eclipse,则MinGW 5.1.6 安装在D:\MinGW文件夹中。

安装:(1)解压后,点击mingw文件夹内的MinGW-5.1.6.exe开始安装。

(2)在安装向导界面上点击next。

(3)点选“Download and Install”,点击next进入下一步。

(4)授权协议界面点击next进入下一步5)安装包选择界面,选取current,点next进入下一步。

(6)安装组件选择界面,选择你需要的组件,然后点next进入下一步。

各组件描述:(本电脑上安装了所有组件)g++ Compiler,C++编译器g77 Compiler,Fortran编译器Ada Compiler,Ada编译器Java Compiler,Java编译器Objective C Compiler,Objective C编译器mingw make,mingw的makefile 解释器(7)在安装目录选择界面,选择mingw的安装目录,默认目录是D:/MinGW,点next到下一步。

8)选择开始菜单文件夹界面,就是你想把程序的快捷方式放到开始菜单的“所有程序”的那个目录下。

点击“Install ”开始正式安装(9)安装程序将你选择的安装包解压到指定的目录中,稍等一会提示安装成功。

(10)点击Finish,结束安装。

环境变量的设置假定MinGW安装在D:/MinGW目录下。

hadoop环境搭建教学设计-回复如何搭建Hadoop环境。

第一步:准备工作在开始搭建Hadoop环境之前,我们需要准备一些基本的资源。

首先,你需要一台物理机或者虚拟机来安装Hadoop。

其次,你需要安装Java开发工具包(JDK),因为Hadoop是用Java开发的。

最后,你需要下载Hadoop的安装包,你可以从Hadoop的官方网站上获取安装包。

第二步:安装和配置JDK首先,你需要下载合适版本的JDK安装包,并且按照安装向导进行安装。

安装完成后,你需要设置JAVA_HOME环境变量。

在Windows系统中,你可以右键点击“计算机”,选择“属性”,然后点击“高级系统设置”,点击“环境变量”按钮,在“系统变量”下点击“新建”按钮,填写变量名为JAVA_HOME,变量值为JDK的安装路径。

在Linux系统中,你可以通过编辑.bashrc文件来添加JAVA_HOME环境变量。

第三步:安装Hadoop在完成JDK的安装和配置之后,你需要下载Hadoop的安装包。

你可以从Hadoop的官方网站上下载最新版本的安装包。

下载完成后,将安装包解压到一个合适的目录下。

第四步:配置Hadoop在安装Hadoop之前,你需要对Hadoop进行一些配置。

打开Hadoop 的安装目录,你会看到一个名为"etc"的文件夹。

打开这个文件夹,你会看到一些配置文件,包括hadoop-env.sh、core-site.xml等。

你需要根据自己的需求对这些配置文件进行修改。

首先,你需要编辑hadoop-env.sh文件。

这个文件定义了Hadoop的环境变量。

你需要设置JAVA_HOME环境变量,将其指向之前安装的JDK 的路径。

然后,你需要编辑core-site.xml文件。

这个文件定义了Hadoop的核心配置。

你需要设置一个唯一的标识符,这个标识符用来识别你的Hadoop 集群。

你还需要设置Hadoop的文件系统类型,这里我们可以使用HDFS。

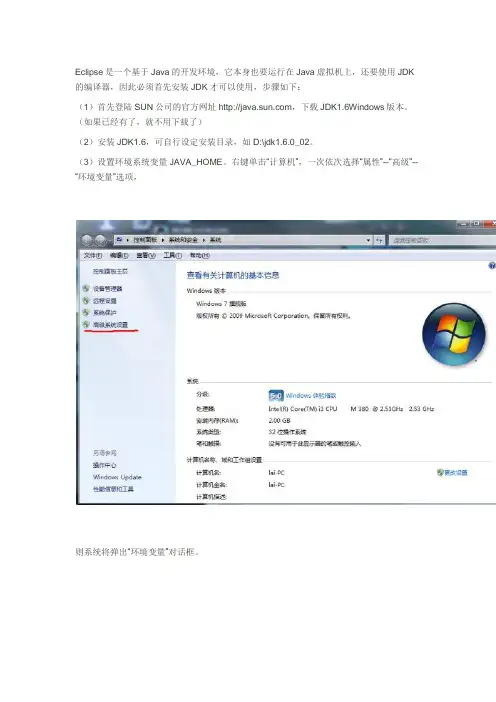

Eclipse是一个基于Java的开发环境,它本身也要运行在Java虚拟机上,还要使用JDK 的编译器,因此必须首先安装JDK才可以使用,步骤如下:(1)首先登陆SUN公司的官方网址,下载JDK1.6Windows版本。

(如果已经有了,就不用下载了)(2)安装JDK1.6,可自行设定安装目录,如D:\jdk1.6.0_02。

(3)设置环境系统变量JAVA_HOME。

右键单击“计算机”,一次依次选择“属性”--“高级”--“环境变量”选项,则系统将弹出“环境变量”对话框。

在“系统环境变量”部分中,单击“新建”按钮,弹出“新建系统变量”对话框,在“变量名”文本框中输入“JAVA_HOME”,(大小写都可以)在“变量值”文本框中输入JDK的安装路径,如:D:\jdk1.6.0_02,单击“确定”按钮即可完成配置。

(4)设置系统环境变量“CLASSPATH”。

操作步骤(3),但是在新建系统变量时,须在“变量名”中输入“CLASSPATH”,变量值中输入“.;D:\jdk1.6.0_02\lib\dt.jar;D:\jdk1.6.0_02\lib\tools.jar”,注意不要漏掉“.;”,单击“确定”按钮完成配置。

(5)编辑系统变量PATH。

在“环境变量”对话框中,选中"PATH"系统变量,单击“编辑”按钮,则会弹出“编辑系统变量的对话框”,在“变量值”的文本框的最后加入“D:\jdk1.6.0_02\bin”。

(6)至此,JDK已经安装配置完毕。

下面测试JDK是否配置正确(可以这样试试:1.“开始”->;“运行”,键入“cmd”,键入命令“javac”,出现以下画面,说明环境变量配置成功。

)。

但是,有时出现这个画面后,却并不能在命令行编译运行,(提示找不到文件),所以,为了测试一下能不能再命令行编译运行,将以下内容复制到记事本中,另存为“HelloJAVA.java”(不含引号),并保存到D盘的根目录下。

搭建Java开发环境1、配置JDK环境变量

分别按照JDK和JRE

计算机→属性→高级系统设置→高级→环境变量A.新建系统环境变量JA V A_HOME

B.编辑Path

;%JA V A_HOME%\bin;%JA V A_HOME%\jre\bin

(注意原来Path的变量值末尾有没有;号,如果没有,先输入;号再输入上面的代码)

C. 新建CLASSPATH

.;%JA V A_HOME%\lib;%JA V A_HOME%\lib\tools.jar

(注意最前面有一点)

环境变量的解析:

JAVA_HOME:jdk的安装路径

CLASSPATH:java加载类路径,只有类在classpath中java命令才能识别,在路径前加了个"."表示当前路径。

Path:系统在任何路径下都可以识别java,javac命令。

2、配置TOMCAT环境变量

TOMCAT路径

A.新建CATALINA_HOME

B.编辑Path

;%CATALINA_HOME%\bin

验证TOMCAT配置成功:

1.启动Tomcat服务器

在cmd命令窗口下输入startup回车,运行如下图所示

2、1测试Tomcat服务器是否安装成功

在浏览器中输入http://localhost:8080或http://127.0.0.1:8080 安装成功将如下图所示

3、myeclipse tomcat配置

4、Maven配置环境变量。

基于Eclipse的Hadoop应用开发环境配置我的开发环境:操作系统fedora 14 一个namenode 两个datanodeHadoop版本:hadoop-0.20.205.0Eclipse版本:eclipse-SDK-3.7.1-linux-gtk.tar.gz第一步:先启动hadoop守护进程第二步:在eclipse上安装hadoop插件1.复制 hadoop安装目录/contrib/eclipse-plugin/hadoop-eclipse-plugin-0.20.205.0.jar 到eclipse安装目录/plugins/ 下。

2.重启eclipse,配置hadoop installation directory。

如果安装插件成功,打开Window-->Preferens,你会发现Hadoop Map/Reduce 选项,在这个选项里你需要配置Hadoop installation directory。

配置完成后退出。

3.配置Map/Reduce Locations。

在Window-->Show View中打开Map/Reduce Locations。

在Map/Reduce Locations中新建一个Hadoop Location。

在这个View中,右键-->New Hadoop Location。

在弹出的对话框中你需要配置Location name,如Hadoop,还有Map/Reduce Master和DFS Master。

这里面的Host、Port分别为你在mapred-site.xml、core-site.xml中配置的地址及端口。

如:Map/Reduce Master192.168.1.1019001DFS Master192.168.1.1019000配置完后退出。

点击DFS Locations-->Hadoop如果能显示文件夹(2)说明配置正确,如果显示"拒绝连接",请检查你的配置。

Windows7部署Android开发环境傻瓜式教程(Eclipse+

准备文件:

1 下载Android SDK

code.google/android/download.html

WIN7 的安装方法与XP 的安装方式完全相同。

2 下载JDK6

java.sun/javase/downloads/index.jsp

3 下载Eclipse3.4.1

eclipse/downloads/

对于Eclipse 来说,直接解压之后就可以使用。

4 下载Eclipse 的Android ADT 插件

许多教程在这一步都是通过Eclipse 自身的update 功能进行下载:

启动Eclipse,选择【Help】【Soft Updates】【Find and Install】

选择Available Software 标签页,点击【Add Site】按键。

添加update 站点:https://dl-ssl.google/android/eclipse/

这时窗口中新增了https://dl-ssl.google/android/eclipse/项,选中该项,点击【Install】按键即可下载。

注:许多国内的网友都无法完成这样的升级,通常是进行到一半就没有任何

反映了(其他插件,例如pydev 也是这样)。

没关系,我们直接到Android 官网去下载这个ADT 插件:

code.google/android/adt_download.html

下载完成后解压,将features 和plugins 目录中的文件拷贝到Eclipse 的对应目录中就可以了。

Hadoop-2.6.0环境下配置Eclipse开发环境:1.下载(eclipse-standard-kepler-SR1-linux-gtk.tar),假设解压到/home/u/eclipse在/etc/profile中设置ant路径:export ECLIPSE_HOME=/home/u/eclipseexport PATH=.:$ECLIPSE _HOME:$PATH2.下载ant安装包(apache-ant-1.9.2-bin.tar.gz),假设解压到/home/u/apache-ant-1.9.2目录,在/etc/profile中设置ant路径:export ANT_HOME=/home/u/ apache-ant-1.9.2export PATH=.:$ANT_HOME/bin:$PATH3.下载maven安装包(apache-maven-3.2.1-bin.tar.gz),假设解压到/home/u/apache-maven-3.2.1目录,在在/etc/profile中设置maven路径:export MAVEN_HOME=/home/u/ apache-maven-3.2.1export PATH=.:$MAVEN_HOMEE/bin:$PATH4.复制hadoop2.6-eclipse-plugin.zip解压到/home/u,cd /home/u/hadoop2.6-eclipse-plugin/src/contrib/eclipse-pluginantjar -Dversion=2.6.0 -Dhadoop.version=2.6.0 -Declipse.home=/home/u/eclipse -Dhadoop.home=/home/u/Hadoop-2.6.0编译成功后我们可以在以下目录获得hadoop-eclipse-plugin-2.6.0.jar插件。

${hadoop2x-eclipse-plugin}/build/contrib/eclipse-plugin/hadoop-eclipse-plugin-2.6.0.jar5.将hadoop-eclipse-plugin-2.6.0.jar拷贝至/home/u/eclipse/plugins下,重启eclipse.可在Preference里看到Hadoop Map/Reduce插件生效。

Eclipse 开发环境搭建用法eclipse真的有年头了,信任java程序员没有不知道它的,最近在给团队中新来的应届生做指导,特地讲解了一下Eclipse开发环境的搭建过程,一是协助他们尽快的认识IDE的用法,二也是保证团队开发环境的全都性(顺便说一下,这点在灵敏开发团队中尤为重要,便利学问传扬,提升团队迅速响应能力)。

的过程中想起了自己当年初涉java时的情景,不免感慨万千啊。

正所谓工欲善其事必先利其器,话不多说,抓紧搭吧。

本文主要介绍在windows下搭建eclipse环境的过程,主要包括jdk的安装与配置、toat的安装与配置、eclipse 的安装与配置以及eclipse常用插件的安装。

一。

jdk安装与配置jdk7于3月份刚刚发布,目前eclipse的最新版本中还没有提供对jdk7的编译支持,所以我们只下载jdk6。

下载地址:/jdk6/挑选适合平台的安装文件,windows32下目前最新版本为:jdk-6u25-ea-bin-b03-windows-i586-27_feb_2011.e默认安装即可,安装完成后要配置环境变量。

比如,我的安装名目为:C:Program FilesJavajdk1.6。

环境变量配置如下:XP系统下,右击我的电脑 --挑选属性 --挑选高级 --点击环境变量在系统变量(S) 中新建:JAVA_HOME:C:Program FilesJavajdk1.6新建:CLASS_PATH:.;%JAVA_HOME%lib编辑:PATH:在最前面加上%JAVA_HOME%bin; 创建环境变量后,打开cmd,输入 java -version 验证是否安装胜利。

Java代码 C:WindowsSystem32 java-version java version \"1.6.0_13\" Java(TM) SE Run Environment (build 1.6.0_13-b03) Java HotSpot(TM)Client VM (build 11.3-b02, mix mode, sharing) 二。

关于在eclipse中配置hadoop插件的文档一、下载hadoop下载hadoop开发包,并解压到一个文件中。

(或将hadoop文件直接从服务器上复制到本地电脑上)。

二、导入hadoop插件开发包1.在左侧项目窗口中,点击右键,选择“import”,弹出导入提示窗口。

2.在提示窗口中选择“Existing Projects into Workspace”,点击“next”。

3.默认选择“Select root directory”,点击“Browse”按钮,选择导入项目存在的根目录,(选择文件路径为:hadoop1.2.1\hadoop\src\contrib\eclipse-plugin),在“Projects”中选择“MapReduceTools”项目,并选中“Copy projects into workspace”选项,最后点击“Finish”按钮。

三、配制导入的项目1.删除错误Jar包,并添加正确jar包在左侧选择“MapReduceTools”项目,点击右键,选择“Properties”选项。

在弹出的“属性”对话框中选择“Java Build Path”,右侧选择“Libraries”标签。

删除错误Jar包,点击“AddExternal JARs...”按钮,在弹出的对话框中选择相对应的hadoop-XXX根目录下“hadoop-core-xxx.jar”。

点击“OK”,完成此次操作。

2.导入新的jar包在项目中新建“lib”的文件夹。

选择下图中的8个jar包将其复制到此“lib”中。

全选这些jar包,点击右键,选择“Build Path”-->“Add to Build Path”,将这些jar包编译通过。

3.操作“plugin.xml”文件双击项目最下方的“plugin.xml”文件,选择“Runtime”模式。

将图中的jar删除,并点击“Add...”按钮,添加新的jar包。

实验-hadoop开发环境部署hadoop-0.20.2⾃带了eclipse插件,⽐如1.0.0和2.2.0就没有1.windows下1)把插件hadoop-0.20.2-eclipse-plugin.jar复制到eclipse⽬录下的plugins⽬录中;2)启动eclipse;3) windown->preferences->Hadoop Map/Reduce4)打开Map/Reduce视图window->show view->Map/Reduce Location5)配置hadoop右键选择New Hadoop location(名字随意、第⼀个是MR的地址和端⼝,第⼆个是HDFS的地址和端⼝,要配的和配置⽂件中的⼀样,特别注意User name⼀定要填Namenode的⽤户名,之前因为没注意,⼀直报错)然后运⾏集群,即可链接如果链接不上<1>.namenode的防⽕墙关掉(root⽤户);<2>.关掉HDFS的⽤户检查6)能查看HDFS上的⽂件说明HDFS链接成功了,再测试⼀下MR<1>.新建⼀个hadoop⼯程<2>.⾃⼰写个代码或者直接贴上wordcount的代码<3>.运⾏。

设置输⼊输出参数这时出现问题:windows中chmod这个命令,解决办法:安装cygwin,然后把它的安装⽬录bin⽬录设置到环境变量Path中就可以了2.Linux下(这个要更简单点)1)安装eclipse(省略)2)安装hadoop插件、Map/Reduce Locations、Hadoop installation Directoy等这个不需要配置Linux环境和不⽤关⼼⽤户问题。

3)测试wordcount也同上。

其中有个问题我没懂得就是在配置运⾏参数的时候不能直接⽤/input/ /output/,必须⽤hdfs://192.168.126.129:9000/in这样的全称我看到别⼈的⽂档中可以,不知道是我哪⼉设置有问题还是他们在忽悠⼈。

Win7+eclipse+Ubuntu14虚拟机环境下搭建hadoop1.2.1单机模式的开发环境

1.虚拟机下安装ubuntu14操作系统。

**注:(我安装ubuntu的时候的用户名是zjp一下涉及到的所有的zjp都需要换成自己的用名)

2.Ctrl+Alt+t 快捷键可以打开终端。

3.激活root用户sudo passwd root

4.联网的情况下,可以用apt-get install samba命令下载以及安装samba服务器。

这个主要是为了window向ubuntu中上传jdk以及hadoop的安装文件。

(如果apt-get命令无法使用,先用apt-get update安装这个命令。

如果主机联网了,但是ubuntn没有连上网,那么将虚拟机的网络适配器改为NA T模式,并且启动任务管理器。

打开服务,查看VMware NAT service 和WMware DPCH service是否启动,如果没有启动那么就启动这两个服务。

如果还不能联网那就在虚拟机的菜单栏中选择编辑->虚拟网络编辑器,恢复默认设置。

重启一下电脑,如果还是不行,那就没办法了,自求多福!)

5.联网的情况下安装ssh协议apt-get install ssh

6.在/home/zjp 目录下创建两个文件夹1.share用于存放共享文件 2.mysoftware用于存放需要安装的软件

7.配置samba共享su root 切换至root用户gedit /etc/samba/smb.conf 编辑samba 的配置文件在文件的最后添加

[share]

comment=sharedir

path=/home/zjp/share

read only=no

browseable=yes

guest ok=no

7.关闭防火墙ufw disable

8重启samba服务器service samba restart

9创建samba用户smbpasswd -a samba用户名eg:smbpasswd -a zkpk

10ifconfig查看ubuntu的ip地址。

例如ip是192.168.30.128

11打开我的电脑,在地址栏中输入\\192.168.30.128不出意外的话会让你登录,就用创建的samba登录就可以了。

然后把下载好的linux版本的jdk和hadoop的安装文件拷贝进去。

12.再把传到share目录下面的两个文件拷贝到mysoftware中去。

这些准备工作都做好了,就可以安装jdk以及hadoop了

一.先安装jdk

1.在mysoftware目录下用tar -zxvf jdk-7u55-linux-x64.gz命令解压以及安装jdk。

2.配置环境变量

gedit /etc/profile 然后在文件的最末尾添加如下内容:

JA V A_HOME=/home/xkl/mysof/jdk1.7.0_60

export PA TH=$PATH:$JA V A_HOME/bin

OK注销一下Ubuntu然后在终端中输入java -version如果可以看见jdk的版本,说明jdk 安装成功。

二.安装hadoop

1.利用图形界面进入mysoftware->hadoop-1.

2.1->conf目录,然后修改一些配置文件

修改hadoop-env.sh

右键hadoop-env.sh open with gedit 编辑hadoop-env.sh

将export JA V A_HOME=****** 这一行的注释去掉,然后写上自己的jdk的安装目录(/home/zjp/mysoftware/jdk1.7.0_55)

保存一下

修改core-site.xml文件

在configuration标签中加入两个属性:ip地址换成你自己的ip地址即可

<property>

<name>hadoop.tmp.dir</name>

<value>/home/zjp/hadoop/hadooptmp</value>

</property>

<property>

<name></name>

<value>hdfs://192.168.30.128:9000</value>

</property>

修改hdfs-site.xml

同样的方法:在configuration标签中加入一个个属性:

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

修改mapred-site.xml

同样的方法:在configuration标签中加入一个个属性:

<property>

<name>mapred.job.tracker</name>

<value>192.168.30.128:9001</value>

</property>

这几项配置代表什么意思可以自己查一下。

2.将hadoop的bin加入环境变量。

这个的意思就跟装jdk的时候添加环境变量是一个意思,就是让系统能够认识hadoop命令.

gedit /etc/profile 然后在文件的最末尾添加如下内容:

export HADOOP_INSTALL=/home/zjp/mysoftware/hadoop-1.2.1

export PATH=$PATH:$HADOOP_INSTALL/bin

重启一下ubuntu打开终端输入hadoop version如果能看见hadoop的版本,说明hadoop的基

本的配置就成功了。

3.切换到mysoftware 目录下,查看一下hadoop-1.2.1的所有者和所属的组是不是你的hadoop 用户,如果不是的话就用chown -R zjp:zjp hadoop-1.2.1修改一下。

否则在以非root用户启动hadoop的时候,会提示没有权限的错误。

4.格式化hdfs

**不要用root用户格式化。

要切换成hadoop用户。

执行命令hadoop namenode -format。

执行完此操作以后在/home/zjp目录下会有一个hadoop 的文件夹。

5.实现linux的ssh无密码验证配置。

这主要是为了启动hadoop的时候不用输入密码.

1.输入ssh-keygen -t rsa 然后一路点enter键,(什么也不用输入)然后进入/home/zkpk/.ssh

将id_rsa.pub 拷贝到authorized_keys文件命令: cp id_rsa.pub authorized_keys

重启一下ssh服务命令:service ssh restart

然后输入ssh localhost或者你的ip地址或者主机名.如果可以登录成功,那就配置成功了

6.测试hadoop启动

进入hadoop的安装目录的bin目录 ./start-all.sh启动hadoop启动过程中如果没有任何异常信息,并且启动完成后用ps -e命令查看一下进程,如果可以看见5个java进程,则说明hadoop成功启动,然后可以运行pi 和wordcount这两个测试程序,如果可以得出正确结果则说明hadoop安装成功.

三.在eclipse中集成hadoop的开发环境

1.再利用samba共享将配置成功的hadoop安装目录传到window系统中

2.将hadoop-eclipse-plugin-1.2.1.jar加入至eclipse中的plugins文件夹中,然后启动eclipse

在菜单栏中选择window->preferences

选择Hadoop Map/Reduce在右侧有一个窗口,在这里面选择你的hadoop在windows中的安装目录。

然后点击window->show view->other

然后在eclipse的控制台的位置出现一个小窗口选项

在下面的空白处右键,选择new hadooplocation

Location name可以随便添,就是一个标识而已,host就添你的ubuntu的ip地址

然后两个端口就按照图添就可以。

填完以后重启一下eclipse然后

在小象这里右键一下,选择edit hadoop location

如果是按照我推荐的方式安装,那就把.dir和其他的一些选项中的zjp换成自己的ubuntu的登录名就可以了

这两项也是一样

这个换成1因为是单机模式所以备份就一个就可以

其实就几个需要改,别的都是自动生成好的。

这些都弄完以后。

在eclipse中就会出现hadoop的文件系统,要稍等一会才能加载完成.

这样就算搭建完成了。