视频目标跟踪与分割汇报总结共28页文档

- 格式:ppt

- 大小:3.78 MB

- 文档页数:28

视频检测和运动目标跟踪方法总结目前常用的视频检测方法可分为如下几类:光流法,时域差分法,背景消减法,边缘检测法,运动矢量检测法[2]。

一、光流法光流法[1]是一种以灰度梯度基本不变或亮度恒定的约束假设为基础对运动目标进行检测的有效方法。

光流是指图像中灰度模式运动的速度,它是景物中可见的三维速度矢量在成像平面上的投影,表示了景物表面点在图像中位置的瞬时变化,一般情况下,可以认为光流和运动场没有太大区别,因此就可以根据图像运动来估计相对运动。

优点:光流不仅携带了运动目标的运动信息,而且还携带了有关景物三维结构的丰富信息,它能够检测独立运动的对象,不需要预先知道场景的任何信息,并且能够适用于静止背景和运动背景两种环境。

缺点:当目标与背景图像的对比度太小,或图像存在噪音时,单纯地从图像灰度强度出发来探测目标的光流场方法将会导致很高的虚警率。

且计算复杂耗时,需要特殊的硬件支持。

二、时域差分法时域差分法分为帧差法和改进的三帧双差分法。

1.帧差法帧差法[8]是在图像序列中的相邻帧采用基于像素点的时间差分, 然后阈值化来提取出运动区域。

视频流的场景具有连续性,在环境亮度变化不大的情况下,图像中若没有物体运动,帧差值会很小;反之若有物体运动则会引起显著的差值。

优点:时域相邻帧差法算法简单,易于实现,对背景或者光线的缓慢变化不太敏感,具有较强的适应性,能够快速有效地从背景中检测出运动目标。

缺点:它不能完全提取运动目标所有相关像素点,在运动实体内部不容易产生空洞现象。

而且在运动方向上被拉伸,包含了当前帧中由于运动引起的背景显露部分,这样提取的目标信息并不准确。

2.三帧双差分法三帧双差分法与相邻帧差法基本思想类似,但检测运动目标的判决条件上有所不同。

三帧双差分较两帧差分提取的运动目标位置更为准确。

三、背景消减法背景消减法[4]是将当前帧与背景帧相减,用阈值T判断得到当前时刻图像中偏离背景模型值较大的点,若差值大于T则认为是前景点(目标);反之,认为是背景点,从而完整的分割出目标物体。

本次实验是一种基于MATLAB的简易的从视频播放的帧图像中找出目标图像,并进行视频跟踪的实现方法。

通过对图像进行阈值处理(图像分割),再对分割后的图像求取形心,以对目标图像进行定位,并最后找到各幅帧图像的目标位置的方法,从而实现对95帧视频图像的实时跟踪。

图片存于帧图片文件夹!程序算法为Untitled6.m文件!基于MATLAB的图像跟踪算法2.1 95帧视频图像的读取由于视频是由95帧图像通过连续播放从而达到视频的效果的,所以要达到视频放映的效果,应首先对95帧图像序列进行顺序读取。

95帧图像存储在MATLAB的默认路径中,文件名为00000xxx.bmp。

要达到读取它们的目的,需要使用循环算法。

算法由一个名为read_seqim(i)的函数实现,以下是函数的源程序:function I=read_seqim(i)if nargin==0i=1;min=00000001;endname=num2str(i);if i<=9min=strcat('0000000',name,'.bmp');elseif i<=99min=strcat('000000',name,'.bmp');elsemin=strcat('00000',name,'.bmp');endI=imread(min);其中i为读取图像的序号,通过以上的函数可以很方便的实现对95帧图像中任意一帧的读取,从而为后面的处理提供方便。

2.2 图像的阈值处理(图像分割)阈值(Threshold),也叫门限。

阈值化(Thresholding),即按给定阈值进行图像的二值化处理。

阈值分割法可分为以下几种:☐简单阈值分割法;☐多阈值分割法;☐最大类间方差法;☐最佳阈值法。

许多情况,图像是由具有不同灰度级的几类区域组成。

如文字与纸张、地物与云层(航空照片)等,阈值分割是利用同一区域的具有某种共同灰度特性进行分割。

视频目标跟踪算法研究视频目标跟踪算法研究一、引言随着计算机视觉技术的快速发展,视频目标跟踪算法为机器学习和人工智能领域提供了重要的基础。

视频目标跟踪算法可用于实时监控、自动驾驶、智能安防等诸多应用领域,大大提升了智能系统的性能和功能。

本文旨在探讨视频目标跟踪算法的研究现状、方法和挑战。

二、视频目标跟踪算法概述视频目标跟踪是指在给定视频序列中,根据第一帧或者人为指定的初始目标位置,通过计算机视觉和机器学习技术,实现对目标在整个视频序列中的位置和状态的准确定位和追踪。

视频目标跟踪算法主要分为基于特征的方法和基于深度学习的方法两大类。

1. 基于特征的方法基于特征的方法利用目标在图像中的某些显著特征,如颜色、形状、纹理等进行目标跟踪。

这类方法的优点是计算简单,速度快,但对于目标外观的变化和光照条件的变化较为敏感。

常见的基于特征的方法有均值漂移算法、卡尔曼滤波算法等。

2. 基于深度学习的方法基于深度学习的方法利用深度神经网络对目标进行特征提取和表示,并通过监督或无监督学习的方式实现目标跟踪。

这类方法在处理目标外观变化和光照条件变化方面更具鲁棒性,但也需要大量的训练数据和计算资源支持。

常见的基于深度学习的方法有卷积神经网络(CNN)、循环神经网络(RNN)等。

三、视频目标跟踪算法研究现状目前,视频目标跟踪算法研究主要集中在以下几个方面:1. 多目标跟踪多目标跟踪是指同时追踪视频中多个目标。

由于多目标之间存在相互遮挡、相似外观等问题,多目标跟踪是一个比较复杂的问题。

研究者们通过引入关联滤波器、目标分割等技术,提出了一系列针对多目标跟踪的算法,取得了一定的进展。

2. 长时目标跟踪长时目标跟踪是指目标在视频中间断出现和消失的情况下的跟踪。

由于目标的外观和姿态在间断期间可能发生很大变化,长时目标跟踪是一个更加困难的问题。

目前,研究者们通过引入复杂的神经网络结构和目标模型更新机制,成功研发了一些针对长时目标跟踪的算法。

视频目标跟踪技术的研究及应用随着科技的不断发展,视频目标跟踪技术已经被广泛应用于安防、智能交通、医疗等领域。

本篇文章将从技术原理、优缺点分析、应用场景以及未来发展等方面进行探讨。

一、技术原理首先,我们需要了解视频目标跟踪技术的基础知识。

视频目标跟踪技术是指通过计算机视觉等技术手段,对视频中的特定目标进行跟踪、定位和识别的过程。

技术实现的一般思路是首先在视频帧中通过目标检测算法检测出待跟踪的目标,然后通过跟踪算法对目标进行追踪。

其中,跟踪算法又分为基于特征和基于深度学习的两种方式。

基于特征的目标跟踪算法常用的是判别式跟踪算法,该算法利用目标的特征对目标进行跟踪,如颜色、纹理、形状等。

常见的包括KCF、TLD、MOSSE等算法。

这些算法快速、高效,能够在实时处理视频时满足实施要求,但对于目标的遮挡、快速移动等场景表现不够理想。

而基于深度学习的目标跟踪算法是近年来的新兴技术,相较于基于特征的算法具有更好的对抗目标姿态变化、光照变化、背景干扰等方面的鲁棒性。

例如,Siamese网络、SiamRPN等算法拥有高效的推理速度及较好的识别性能。

相比基于特征的算法,基于深度学习的算法所需要的计算能力和硬件设备要求比较高,因此它们常常采用GPU进行加速。

二、优缺点分析目标跟踪技术在应用中的优缺点也是需要我们考虑的。

优点:1.实时性:目标跟踪技术能够实现实时处理,能够在毫秒级别内完成对目标的跟踪,满足实时性的需求。

2.鲁棒性:基于深度学习的目标跟踪算法具有很强的鲁棒性,适用于复杂的环境中,能够应对光照变化和背景混杂等复杂问题。

3.可扩展性:针对不同场景的跟踪需求,目标跟踪技术应用灵活多样,可根据需求进行定制。

缺点:1.精度:针对一些目标需要进行精确定位的场景,目标跟踪技术的精度相对于检测技术仍有提升空间。

2.计算量:基于深度学习的目标跟踪算法所需要的计算量相较于基于特征的算法更高,因此需要较高的计算资源。

3.可靠性:在目标跟踪过程中,一些干扰项如背景混杂等因素会影响目标跟踪的可靠性,因此需要综合考虑处理复杂环境的能力。

视频监控目标的跟踪与识别研究共3篇视频监控目标的跟踪与识别研究1随着现代社会的不断进步和发展,各种技术手段不断涌现并得到广泛的应用。

其中,视频监控技术作为一种日益普及的安全监控手段,已经在各个领域得到了广泛的应用,如公共安全、交通监控、金融安全等。

视频监控技术有助于提高社会安全水平和防控能力,因此,也越来越受到重视。

视频监控系统中,追踪和识别是最基本的功能之一。

通过追踪和识别,视频监控系统可以实现对目标的跟踪和监测,并能给安全防范和管理带来更多的便利和效益。

而实现目标的跟踪和识别,在现实场景中面临着很多挑战和难点。

此外,随着技术的不断更新和升级,视频监控系统的效果也是越来越突出。

目标跟踪是视频监控系统的核心功能之一,在保证监控效果的同时,也是关键技术之一。

目标跟踪的关键是提取目标物体的特征信息,并对目标的位置和运动状态进行准确的判断和预测。

在实现目标跟踪的过程中,需要克服物体变形、光照变化、目标遮挡等因素的干扰。

针对这些因素,可以引入多种算法和技术手段进行处理和优化,从而实现目标的高效跟踪和检测。

目标识别是视频监控系统中另外一个重要的技术方向。

目标识别的主要目的是通过对目标物体的颜色、形状、纹理等特征信息的判别,实现对目标物体的自动识别和分类。

采用目标识别技术可以帮助视频监控系统更快、更精准地检测并定位到目标物体,同时还能够降低误检率和漏检率。

在实现目标识别的过程中,可以利用计算机图像识别以及机器学习等技术手段,实现目标物体识别和分类。

视频监控目标的跟踪与识别研究是一个涉及多个学科领域的复杂问题,需要从多个角度进行分析和研究。

面对复杂的现实环境和监控场景,视频监控目标的跟踪和识别技术需要不断的进步和优化才能更好地发挥效果,及时发现目标的异常行为,保障监控的有效性。

除了技术手段的提高,还需要加强对视频监控系统安全性的建设与提升,不断提升监测控制的精准性和敏感度,更好地为社会的安全与发展做出贡献总之,视频监控目标的跟踪与识别技术是保障社会安全的重要手段之一。

视频目标分割总结视频目标分割分类最近听了阿里巴巴王文冠老师“基于深度学习技术的视频分割”的讲座(可能需要报名比赛才能观看),我感到受益匪浅,学习到了许多关于视频目标分割(VOS)的知识,在这里进行整理总结。

关于视频目标分割的分类,有的综述文章分为无监督VOS,半监督VOS,交互式VOS,弱监督VOS等,这里将视频目标分割任务分类成无监督VOS,半监督VOS,交互式VOS,背景移除或运动物体分割,视频语义分割/实例分割。

1.无监督VOS:在测试阶段,不要求任何用户输入,通常是自动分割视频中最关键,最显著的目标。

2.半监督VOS:在测试阶段,用户提供第一帧或者关键帧的目标掩膜(mask),然后分割剩下帧中的目标。

3.交互式VOS:在测试阶段,依靠用户的迭代交互来分割感兴趣的对象,目的是获取高精度的分割结果,需要大量的人力参与。

4.背景移除或运动目标提取:通常假定摄像机静止或运动缓慢,然后自动分割出运动的前景目标。

5.视频语义分割/实例分割:是图像语义分割/实例分割的拓展,不仅要求分割出视频中感兴趣目标,还要根据语义或者实例关系区分不同目标。

值得注意的是,无监督VOS和半监督VOS的区分并不是根据监督学习和无监督学习的分类方式区分,这两者都可以利用有标签的视频数据进行训练,区分是根据测试阶段的用户参与方式来进行的,并且这两者关注的都是分割前景和背景,并不关注分割目标的类别信息。

此外,单独把背景移除提出来,应该是想强调这里指的是基于深度学习的背景移除方法。

这篇博客简单介绍各个方向的传统方法,着重介绍基于深度学习的视频目标分割。

解决思路总结关于解决思路,这里主要讨论的是无监督VOS,半监督VOS和视频实例分割的基本方法。

随着时间的推移,出现了更多优秀的工作。

RANet结合了基于传播和基于匹配的思路,利用孪生网络encoder结构获取第一帧的模板特征和当前帧特征,通过Correlation操作获取相似性特征图,根据第一帧前景和背景,经过RAM模块筛选前景和背景特征,再与预测的前一帧mask合并,通过decoder结构获取最终分割mask。

视频制作年中总结与计划今年已经过去了一半时间,回首半年的视频制作工作,我感到有许多值得总结和反思的地方。

同时,我也要制定下半年的计划,以保证工作的进展和提高。

首先,我要总结下半年的工作中取得的成绩和进展。

这半年,我参与了多个视频制作项目,并承担了不同的角色和责任。

通过与项目组成员的密切合作和共同努力,我们成功完成了所有项目的制作任务,并且取得了令人满意的效果。

我学会了如何优化视频内容,如何在预算和时间的限制下达成最好的效果,以及如何与团队成员协作,共同完成项目。

这些经验将对我今后的工作产生积极的影响。

其次,我要反思一些不足之处和需要改进的地方。

在项目过程中,我发现自己在沟通和协调团队方面还有待提高。

有时候由于表达不清或者协调不足,导致项目进展缓慢或者出现不必要的问题。

我也发现自己的技术能力还有不足之处,需要持续学习和提高。

在使用一些高级制作软件和设备时,我有时候会遇到一些困难,需要加强学习和实践。

针对以上问题,我制定了下半年的计划。

首先,我会加强沟通和协调能力的培养。

我将积极主动地与团队成员进行沟通,了解他们的需求和意见,并及时解决问题。

我还将参加一些相关的培训和讲座,学习如何更好地沟通和协调项目。

其次,我会加强技术能力的提升。

我将积极参与一些技术培训和课程,学习最新的制作技术和软件知识。

同时,我还会加强实践,通过自己的实际操作来提高技术能力。

此外,我还计划在下半年尝试一些新的创意和风格。

作为一个视频制作人,我需要不断创新和突破,为观众呈现更多元化和独特的作品。

我会积极参与团队的讨论和策划,提出一些新颖的创意,并尝试将它们应用到实际制作中。

总的来说,下半年我将继续努力,不断提高自己的技术能力和工作素质。

通过更好地沟通和协调团队,不断学习和实践,以及尝试新的创意和风格,我相信我能够取得更大的进步和成就。

希望通过我的努力,能够为公司和团队带来更多的价值和贡献。

视频目标跟踪算法与实现目标跟踪是计算机视觉领域中的重要任务之一。

它可以用于监控、智能交通、虚拟现实等众多领域。

在视频目标跟踪中,我们的目标是根据输入视频序列找出感兴趣的目标,然后在不同帧之间追踪目标的位置。

为了实现视频目标跟踪,我们需要采用适当的算法。

目前,常用的视频目标跟踪算法可以分为两大类:基于特征的跟踪算法和深度学习算法。

基于特征的跟踪算法主要依靠图像特征来进行目标跟踪。

其中,常见的算法包括:1. 光流法:光流法利用相邻帧之间的像素亮度差异来估计目标的运动。

通过对光流向量的计算和分析,可以推断出目标的位置和速度。

然而,光流法容易受到光照变化和纹理丰富度等因素的影响,导致跟踪结果不准确。

2. 直方图匹配法:直方图匹配法利用目标区域的颜色直方图进行跟踪。

它通过计算帧间颜色直方图的相似度来判断目标的位置。

直方图匹配法简单易懂,但对目标的颜色分布要求较高,不适用于复杂场景。

3. 卡尔曼滤波器:卡尔曼滤波器是一种用于状态估计的优化算法,可以对目标的位置和速度进行预测和修正。

它可以利用先验知识和测量结果来逐步调整估计值。

卡尔曼滤波器具有较好的鲁棒性和实时性,但对目标运动模型的假设较为严格。

与基于特征的算法相比,深度学习算法能够更准确地捕捉目标的特征,从而实现更精确的目标跟踪。

深度学习算法通常采用卷积神经网络(Convolutional Neural Network,CNN)来提取特征,并使用适当的分类器或回归器来预测目标的位置。

常见的深度学习算法包括:1. 基于卷积神经网络的目标跟踪:利用卷积神经网络对输入帧进行特征提取,然后通过分类器或回归器来预测目标的位置。

这种方法能够较好地捕捉目标的纹理和形状特征,实现精确的目标跟踪。

2. 循环神经网络(Recurrent Neural Network,RNN):循环神经网络可以对目标的时序信息进行建模,从而实现更准确的目标跟踪。

它通过学习帧间的时序关系来预测目标的位置。

视频目标跟踪综述作者:张丰,冯平来源:《计算机时代》2022年第01期摘要:研究近年来主流的目标跟踪算法。

通过文献阅读和归纳对比,分析了使用生成式模型和判别式模型的目标跟踪算法。

结果显示,对于存在复杂干扰因素的场景,采用第二类模型的目标跟踪算法的跟踪效果更好。

文章为视频跟踪领域的研究者们提供了一个关于目标跟踪算法的客观分析。

关键词:目标跟踪; 深度学习; 相关滤波; 计算机视觉中图分类号:TP399 文献标识码:A 文章编号:1006-8228(2022)01-32-04Overview on video target trackingZhang Feng, Feng Ping(Guizhou University of Finance and Economics, Guiyang, Guizhou 550025, China)Abstract: This paper focuses on the mainstream target tracking algorithms in recent years, and analyzes the target tracking algorithms using generative and discriminative models through literature reading and inductive comparison. The results show that for the scenes with complex interference factors, the target tracking algorithms using the second kind of model have better tracking effect. This paper provides an objective analysis of target tracking algorithms for researchers in the field of video tracking.Key words: target tracking; deep learning; correlation filtering; computer vision0 引言根据人们对感知觉的研究发现,人们通过视觉、听觉、味觉、嗅觉和肤觉来接受外部的刺激,其中视觉是人们获取外部刺激的最主要途径,约占80%。

⎩ 视频目标检测与跟踪算法综述1、引言运动目标的检测与跟踪是机器视觉领域的核心课题之一,目前被广泛应用在视频编码、智能交通、监控、图像检测等众多领域中。

本文针对视频监控图像的运动目标检测与跟踪方法,分析了近些年来国内外的研究工作及最新进展。

2、视频监控图像的运动目标检测方法运动目标检测的目的是把运动目标从背景图像中分割出来。

运动目标的有效分割对于目标分类、跟踪和行为理解等后期处理非常重要。

目前运动目标检测算法的难点主要体现在背景的复杂性和目标的复杂性两方面。

背景的复杂性主要体现在背景中一些噪声对目标的干扰,目标的复杂性主要体现在目标的运动性、突变性以及所提取目标的非单一性等等。

所有这些特点使得运动目标的检测成为一项相当困难的事情。

目前常用的运动目标检测算法主要有光流法、帧差法、背景相减法,其中背景减除法是目前最常用的方法。

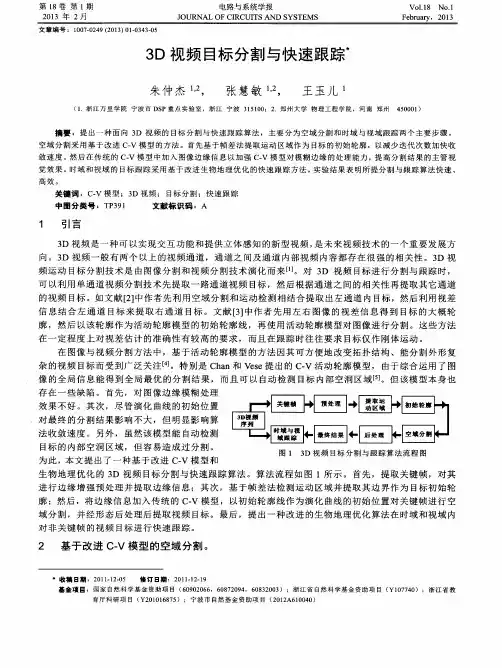

2.1 帧差法帧差法主要是利用视频序列中连续两帧间的变化来检测静态场景下的运动目标,假设 f k (x , y ) 和 f (k +1) (x , y ) 分别为图像序列中的第 k 帧和第 k+1 帧中象素点 (x ,y)的象素值,则这两帧图像的差值图像就如公式 2-1 所示:Diff k +1 = f k (x , y ) - f (k +1) (x , y )(2-1)2-1 式中差值不为 0 的图像区域代表了由运动目标的运动所经过的区域(背景象素值不变),又因为相邻视频帧间时间间隔很小,目标位置变化也很小,所以运动目标的运动所经过的区域也就代表了当前帧中运动目标所在的区域。

利用此原理便可以提取出目标。

下图给出了帧差法的基本流程:1、首先利用 2-1 式得到 第 k 帧和第 k+1 帧的差值图像 Diff k +1 ;2、对所得到的差值图像 Diff k +1 二值化(如式子 2-2 示)得到 Qk+1;3、为消除微小噪声的干扰,使得到的运动目标更准确,对Q k +1 进行必要的滤波和去噪处理,后处理结果为M k +1 。