基于内容的项目视频关键帧识别技术研究

- 格式:pdf

- 大小:836.58 KB

- 文档页数:8

基于深度学习的视频内容分析与关键帧提取视频内容分析是指通过运用深度学习技术对视频进行分析和理解,从而提取出视频中的关键帧。

深度学习是一种机器学习方法,通过构建多层神经网络模型来模拟人类大脑处理信息的方式。

它可以自动学习和提取特征,以实现对复杂任务的解决。

在视频内容分析中,关键帧提取是一个重要的步骤。

关键帧是指在视频中具有重要信息或变化的帧画面,可以代表视频内容的特征。

通过提取关键帧,可以有效地压缩视频数据,并减少对存储和传输资源的需求。

此外,关键帧提取还在视频搜索、视频摘要和视频内容分析等领域具有广泛的应用。

深度学习在视频内容分析中发挥了重要作用。

首先,深度学习可以通过训练模型来学习和提取视频中的特征,包括颜色、纹理、形状等。

通过大量的视频数据和深度神经网络的训练,可以得到更准确和鲁棒的特征表示。

其次,深度学习可以建立复杂的模型来理解视频的语义信息。

通过深度卷积神经网络和循环神经网络的结合,可以对视频进行时间和空间上的建模,进一步提高关键帧提取的准确性和效果。

在深度学习方法中,常用的模型包括卷积神经网络(CNN)和循环神经网络(RNN)。

卷积神经网络主要用于提取视频帧的空间特征,通过多层卷积层和池化层,可以逐渐减少特征图的尺寸,并提取出有代表性的特征。

而循环神经网络则主要用于处理序列数据,如视频帧的时间顺序。

通过循环隐藏层的记忆性,RNN可以捕捉视频中的时间相关性,从而更好地理解视频的语义信息。

在基于深度学习的视频内容分析中,通常的步骤包括数据预处理、特征提取和关键帧提取。

首先,需要对视频数据进行预处理,例如解码、采样和标准化。

然后,通过卷积神经网络提取视频帧的空间特征,同时利用循环神经网络建立视频帧之间的时间关系。

最后,通过设计适当的评估指标,可以筛选出关键帧,并得到最终的结果。

当前,基于深度学习的视频内容分析与关键帧提取已经取得了许多重要进展。

例如,通过引入注意力机制和生成对抗网络,可以进一步提高关键帧提取的效果。

基于深度学习的视频关键帧提取算法研究摘要:随着互联网和数字媒体的快速发展,视频数据的数量和规模不断增长。

视频关键帧提取算法在视频内容分析、视频检索和视频摘要等领域具有重要应用价值。

本文研究了基于深度学习的视频关键帧提取算法,探讨了其原理、方法和实现过程,并对其应用前景进行了展望。

1.引言随着移动互联网和社交媒体的普及,人们对视频数据的需求越来越高。

然而,海量的视频数据使得人们在观看和搜索视频时面临着困难。

视频关键帧提取算法能够从视频序列中自动选择表达视频内容的关键帧,以便于用户快速浏览和搜索视频,提升用户体验。

2.相关工作2.1 传统方法传统的视频关键帧提取算法主要基于图像处理和机器学习技术。

这些方法通常使用手工设计的特征提取器和分类器来进行关键帧的选择,但往往面临着通用性差、效率低和提取效果不佳的问题。

2.2 基于深度学习的方法近年来,深度学习技术在计算机视觉领域取得了显著的成果。

基于深度学习的视频关键帧提取算法通过利用深度神经网络自动学习视频特征表示,能够提高提取效果和适应性。

3.基于深度学习的视频关键帧提取算法3.1 数据预处理在深度学习算法中,数据预处理是一个重要的环节。

对于视频关键帧提取,首先需要将视频转化为图像序列,并进行大小归一化和图像增强等处理。

3.2 特征表示学习通过卷积神经网络(Convolutional Neural Network,CNN)等深度学习模型,提取视频图像序列的特征表示。

深度学习模型能够自动学习到更具有判别性的特征,从而提高关键帧提取的准确性。

3.3 关键帧选择在学习到的特征表示基础上,利用聚类、分类或回归方法进行关键帧的选择。

聚类方法通常将相似的特征聚集到一起,从而选取代表性帧作为关键帧。

分类方法则通过训练一个分类器来判断每一帧是否为关键帧。

回归方法则是通过回归模型预测每一帧的关键帧得分,从而选取得分最高的帧作为关键帧。

4.实验与评估通过实验比较基于深度学习的视频关键帧提取算法与传统方法的效果差异。

基于内容的视频检索与关键技术简述作者:马晨晨周政龙门来源:《新学术论丛》2013年第04期1.引言随着多媒体技术的发展和信息高速公路的出现,数字视频的存储和传输技术都取得了重大的进展。

如何能在海量的视频中找到需要的资料,是视频检索要解决的问题。

传统的视频检索只能通过快进和快退等顺序的方法人工查找,因而是一件非常繁琐耗时的工作,这显然已无法满足多媒体数据库的要求。

用户往往希望只要给出例子或特征描述,系统就能自动地找到所需的视频片断点,即实现基于内容的视频检索。

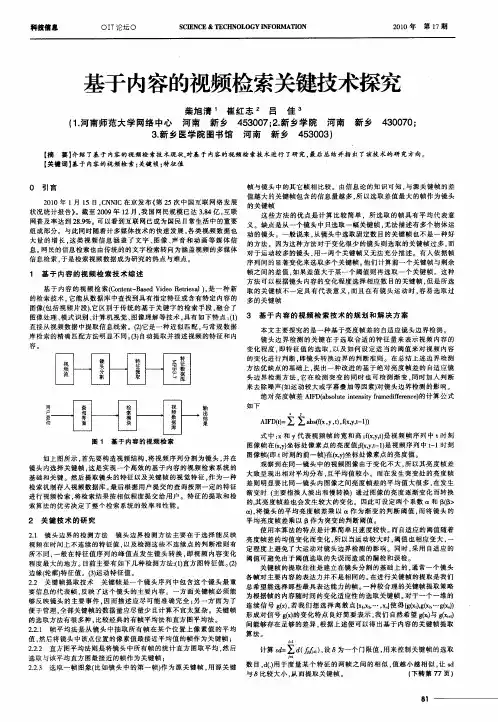

2.基于内容的视频检索基于内容的视频检索(Content Based Video Retrieval, CBVR)指根据视频的内容及上下文关系,对大规模视频数据库中的视频数据进行检索。

主要特点:直接从视频数据中提取信息线索,它是一种近似匹配,在没人工参与的情况下自动提取并描述视频的特征和内容。

它融合了图像理解、模式识别、计算机视觉等技术。

基于内容的视频检索的过程是先将视频流通过镜头边界检测分割为镜头,并在镜头内选关键帧,再提取镜头的运动特征和关键帧中的视觉特征,作为一种检索机制存入视频数据库,最后根据用户提交的查询按一定特征进行视频检索,将检索结果按相似性程度交给用户,用户可优化查询结果,系统会依用户意见灵活优化检索结果。

特征的提取和检索算法的优劣决定了系统的效率和性能。

3.关键技术视频包含着丰富的内容。

一般对视频采用分层的表达方式表示视频。

一个视频可以表示为场景、镜头、帧几个层次。

帧是视频最基本组成单元,镜头边界检测是视频层次化的基础。

3.1镜头边界检测实现基于内容的视频检索首先要将视频数据自动地分割为镜头,称为镜头边界检测或场景转换检测。

镜头的切换有突变和渐变,突变表现为在相邻两帧之间发生的突变性的镜头转换。

(1)基于像素的镜头检测方法利用视频两帧对应像素之差的绝对值之和作为帧间差,当大于某个阈值m时,则认为有镜头的切换。

缺点是对噪声和物体运动敏感,易造成误识别。

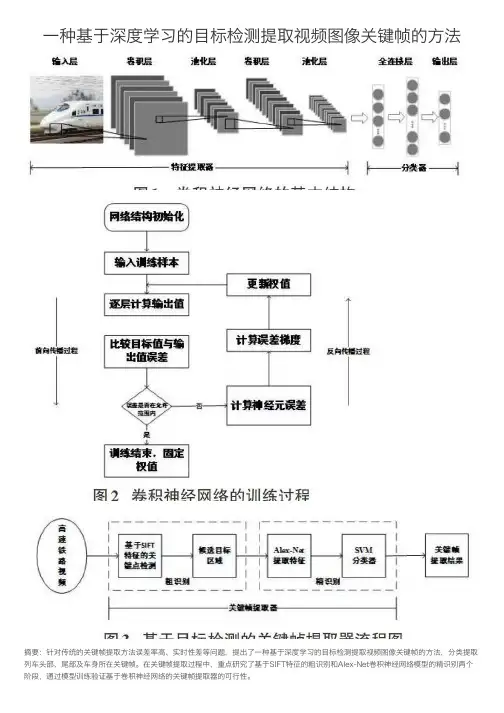

⼀种基于深度学习的⽬标检测提取视频图像关键帧的⽅法摘要:针对传统的关键帧提取⽅法误差率⾼、实时性差等问题,提出了⼀种基于深度学习的⽬标检测提取视频图像关键帧的⽅法,分类提取列车头部、尾部及车⾝所在关键帧。

在关键帧提取过程中,重点研究了基于SIFT特征的粗识别和Alex-Net卷积神经⽹络模型的精识别两个阶段,通过模型训练验证基于卷积神经⽹络的关键帧提取器的可⾏性。

关键词:卷积神经⽹络(CNN);关键帧;⽬标检测中图分类号:TP391 ⽂献标识码:A ⽂章编号:1009-3044(2018)36-0201-031 概述随着我国铁路的不断发展,铁路在运⾏过程中的安全性问题⽇益凸显,视频监控在铁路交通安全中起着⾄关重要的作⽤。

通过摄像头监控、互联⽹的传播,监控画⾯实时显⽰,铁路部门可以利⽤视频中的有效图像信息,对视频流进⾏处理,从⽽有效地保证铁路系统的正常运营。

因此,如何快速有效地提取铁路视频图像中的关键帧信息,是本⽂研究的重点。

考虑到视频中相邻帧的重复率⼀般⽐较⾼,关键帧的提取可以减少帧数,进⽽提升图像特征点检测和匹配效率,同时也为图像拼接提供⼀个组织框架。

针对这项关键技术,得到了研究者们的⼴泛关注,并取得了⼀定研究成果。

⽂献[1]从相邻帧间的颜⾊或纹理信息变化程度出发,提出了基于视频内容的⽅法。

⽂献[2]通过计算当前帧与类⼼之间特征值的距离,将视频中所有帧进⾏聚类分析,得到基于视频聚类的分析⽅法。

⽂献[3]提出基于运动特征分析的算法,其基本原理是利⽤光流分析,将视频中运动量最⼩的⼀帧作为关键帧。

上述的三类传统算法主要基于图像整体信息的变化来选定关键帧,容易造成关键帧选取错误、计算量⼤、实时性差等问题。

因此,本⽂在此基础上使⽤⼀种基于深度学习的⽬标检测⽅法,通过建⽴卷积神经⽹络(Convolutional Neural Network,CNN)模型,分类提取视频中列车头部、尾部及车⾝所在关键帧,使得基于深度学习的⽬标检测在关键帧提取的应⽤中成为可能。

基于神经网络的视频关键帧提取算法研究随着音视频技术的快速发展,视频的应用范围越来越广泛。

然而,在大量的视频数据中,如何快速、准确地找到需要的信息是一个非常具有挑战性的问题。

关键帧提取算法是视频检索和压缩领域中的重要技术之一。

对于一段视频,关键帧提取算法可以将其中最代表性和重要性最强的帧作为关键帧进行提取,从而实现视频的快速浏览和检索。

传统的关键帧提取算法通常基于图像处理技术,常用的方法包括基于帧间差异和基于图像特征的方法。

然而,这些方法存在一定的局限性,如对于内容复杂、动态变化较大的视频,关键帧提取的准确性不高。

针对这个问题,近年来,基于神经网络的视频关键帧提取算法逐渐被引入并被广泛研究。

基于神经网络的视频关键帧提取算法,在使用深度学习模型对视频进行处理的基础上,结合了图像处理技术。

首先通过卷积神经网络对视频中的每一帧进行特征提取,然后将特征向量输入到分类模型中进行分类,得到每一帧是否为关键帧的概率。

最终,根据概率阈值筛选出关键帧。

在具体实现时,有不同的方法和结构。

比如,可以采用卷积神经网络和循环神经网络相结合的结构,对于不同长度的视频片段,使用循环神经网络进行特征提取和对时间序列的建模。

也可以使用类似于图像分类网络的结构,直接对每一帧进行分类。

此外,还可以采用多模态数据融合的方法,融合视频图像和音频数据进行关键帧提取。

基于神经网络的视频关键帧提取算法相对于传统方法的优势在于其自适应性和泛化能力更强。

神经网络可以从大量的数据中学习到视频的内在特征,结合分类模型可以更加准确地判断每一帧是否为关键帧。

此外,该算法还可以在不同任务之间进行迁移学习,提高模型的效果。

然而,基于神经网络的视频关键帧提取算法也存在一些问题。

首先,需要大量的数据进行训练,才能得到较好的效果。

其次,对于某些特定的场景和低质量视频,算法的准确性依然存在局限性。

另外,由于神经网络模型的复杂性,算法的计算量较大,需要强大的计算资源进行支撑。

2020年第4期信息与电脑China Computer & Communication算法语言内容的视频检索中关键帧提取算法分析丁锐鑫1 陈元睿2(1.国网河南省电力公司三门峡供电公司,河南 三门峡 472000;2.沈阳农业大学,辽宁 沈阳 110866)摘 要:视频信息检索主要由镜头检测、关键帧提取、镜头聚类、视觉特征提取、视觉特征匹配、界面显示和人机交互等多个环节组成,而关键帧提取则是其中的重要环节之一。

由于当前视频检索中的关键帧提取存在关键帧难以把控、关键帧代表性不足等一系列的问题,因此笔者对基于内容分析的关键帧提取算法进行了分析,并通过运用这种关键帧提取方法对过选取多冗余帧展开了探讨,希望能够为解决关键帧提取的相关问题提供借鉴。

关键词:视频检索;关键帧;镜头提取中图分类号:G354.4 文献标识码:A 文章编号:1003-9767(2020)04-050-02Analysis of Key Frame Extraction Algorithm in Video Retrieval of ContentDing Ruixin 1, Chen Yuanrui 2(1. Sanmenxia Power Supply Company of State Grid Henan Electric Power Company, Sanmenxia Henan 472000, China; 2. Shenyang Agricultural University, Shenyang Liaoning 110866, China)Abstract: Video information retrieval mainly consists of shot detection, key frame extraction, shot clustering, visual featureextraction, visual feature matching, interface display and human-computer interaction, and key frame extraction is one of the important links. Because the key frame extraction in current video retrieval has a series of problems, such as difficult to control the key frame, lack of representativeness of key frame and so on, so the author analyzes the key frame extraction algorithm based on content analysis, and discusses the excessive redundant frame selection by using this key frame extraction method, hoping to providereference for solving the related problems of key frame extraction.Key words: video retrieval; key frames; lens extraction0 引言在信息技术持续发展、互联网高度普及的今天,视频信息检索技术作为检索实现视频信息内容的关键技术,在日常生活中发挥着重要的作用,而在对层次化视频进行检索的过程中,则需要提取组成视频的帧,才能够实现对视频信息内容的准确识别与提取。

视频内容分析与关键帧提取算法研究随着互联网的高速发展,视频成为了人们生活中必不可少的媒体之一。

在大量的视频数据中,如何高效地提取出关键信息,成为了研究的重要课题之一。

视频内容分析与关键帧提取算法的研究,正是为了解决这一问题而展开的。

一、视频内容分析视频内容分析是指通过对视频中的图像和音频进行解析,从而获取视频的各种特征和信息。

通过视频内容分析,我们可以实现视频检索、视频摘要、视频分类等应用。

1. 视频特征提取视频特征提取是视频内容分析的基础工作。

常用的视频特征包括颜色特征、纹理特征、形状特征、运动特征等。

其中,颜色特征可以通过提取关键帧的颜色直方图来得到,纹理特征可以通过提取关键帧的纹理特征描述符来得到,形状特征可以通过提取目标物体的轮廓信息来得到,运动特征可以通过分析关键帧之间的光流变化来得到。

2. 视频目标检测视频目标检测是视频内容分析的一个重要应用领域。

目标检测的目的是在视频中自动识别出特定的目标物体。

常用的目标检测方法包括基于帧间差分的运动目标检测、基于光流的运动目标检测、基于深度学习的物体检测等。

3. 视频关键帧提取关键帧是视频中具有代表性和信息丰富程度高的帧,提取关键帧可以减少视频数据量,提高视频处理的效率,并且方便快速浏览和检索。

关键帧提取一般基于图像质量评价和关键帧选取策略。

图像质量评价可以通过计算图像的清晰度、对比度、亮度等指标来进行,关键帧选取策略可以采用基于颜色分布、运动特征、局部相似性等方法。

二、关键帧提取算法研究关键帧提取算法的目标是从视频序列中自动选择具有代表性和信息变化较大的图像帧。

关键帧提取算法的研究旨在提高关键帧的准确性和有效性。

1. 基于图像质量评价的关键帧提取算法图像质量评价是判断图像的视觉质量的重要指标。

基于图像质量评价的关键帧提取算法通过计算帧间差异、帧内相似性等指标来评估每个帧的质量,从而选取出具有代表性的关键帧。

常用的图像质量评价方法包括均方差(MSE)、结构相似性指数(SSIM)、峰值信噪比(PSNR)等。

基于深度学习的视频内容分析与视频推荐研究随着互联网的快速发展,视频内容已成为人们获取信息和娱乐的重要途径。

然而,面对海量的视频资源,用户如何快速准确地找到自己感兴趣的内容,成为了一个亟待解决的问题。

基于深度学习的视频内容分析与视频推荐研究,就是为了解决这一问题而展开的研究。

首先,基于深度学习的视频内容分析是该领域的核心任务之一。

传统的视频内容分析主要依靠人工提取特征和规则来识别视频的内容,这种方法通常需要耗费大量时间和精力,并且很难适应不同类型和风格的视频。

而深度学习通过构建深层神经网络,可以从大量的训练数据中进行自动学习,从而实现对视频内容的高效分析和识别。

利用深度学习技术进行视频内容分析,可以实现多领域的应用。

例如,面对大规模的视频监控系统,可以利用深度学习算法对视频中的行人、车辆等目标进行实时检测和跟踪;对于视频编辑,可以通过深度学习提取视频中的关键帧,自动进行剪辑和合成;在视频内容审核方面,深度学习可以帮助识别和过滤含有违法、低俗或不适宜的内容。

这些应用都可以极大地提高视频处理的效率和准确度。

其次,基于深度学习的视频推荐研究是另一个重要的研究方向。

视频推荐是指根据用户的兴趣和偏好,向其推荐具有高度相关性和个性化的视频内容。

传统的推荐系统主要基于用户行为和内容特征进行推荐,但这些方法往往只考虑了用户历史行为,忽视了视频内容的语义和情感信息。

而基于深度学习的视频推荐研究可以通过对视频内容进行深度学习和分析,从而更好地理解用户的兴趣和喜好,实现更加准确和个性化的推荐。

在基于深度学习的视频推荐研究中,一种常见的方法是基于协同过滤的深度学习推荐算法。

该算法通过分析用户行为和视频内容之间的关系,学习到用户和视频之间的隐含特征表示。

通过将用户和视频的特征表示映射到共享的低维空间中,可以计算用户和视频之间的相似度,并向用户推荐与其兴趣最相关的视频内容。

此外,还可以通过引入注意力机制和序列建模等技术,提高推荐结果的准确度和多样性。

Software Engineering and Applications 软件工程与应用, 2016, 5(2), 114-121Published Online April 2016 in Hans. /journal/sea/10.12677/sea.2016.52013Video Key Frame Recognition TechnologyResearch Based on the ContentQian Liu, Gui’e Luo, Xianru Liu*Central South University, Changsha HunanReceived: Mar. 17th, 2016; accepted: Apr. 2nd, 2016; published: Apr. 5th, 2016Copyright © 2016 by authors and Hans Publishers Inc.This work is licensed under the Creative Commons Attribution International License (CC BY)./licenses/by/4.0/AbstractThe key frame extraction is vital for automatic segmentation of video; the standard of extracted key frame directly affects the final result. Based on the analysis and research about project video, the paper proposes template matching, histogram comparison, the key frame detection and key frame recognition algorithm, and for the recognition accuracy and recognition rate of template matching and histogram comparison, the paper also does the comparison. In the recognition, the key frames adopted a new character segmentation algorithm. Finally, the paper summarizes the advantages of this method and good results have been achieved.KeywordsKey Frame, Template Matching, Character Segmentation基于内容的项目视频关键帧识别技术研究刘倩,罗桂娥,刘献如*中南大学,湖南长沙收稿日期:2016年3月17日;录用日期:2016年4月2日;发布日期:2016年4月5日摘要关键帧的提取对于视频的自动切分至关重要,提取的好坏直接影响最终的结果,本文通过对项目视频的*通讯作者。

刘倩等分析研究,提出了模板匹配,直方图比较,关键帧检测与关键帧识别的算法,并比较了模板匹配与直方图对比的识别准确率和识别速率,其中在关键帧识别中,采用了新的字符分割的算法。

最后,总结了本文方法的优越性,并且取得了很好的效果。

关键词关键帧,模板匹配,字符分割1. 引言随着计算机技术、多媒体技术[1]和网络技术的不断发展,图像和视频资源[2]日益丰富,从这些海量图像、视频中获取感兴趣[3]的信息已经成为当前多媒体信息技术研究的热点。

为加快国家科技管理信息系统建设,各类计划等实现全流程在线信息化管理[4];实现全过程痕迹管理,做到“可申诉、可查询、可追溯”[5]。

在研究、借鉴网易视频、百度网盘、微软skydrive等大数据[6]、大文件视频等管理模式基础上,结合国家科技信息管理的新要求以及信息中心自身建设的特点和要求,科技部提出了对各类视频数据进行有效管理的要求,具体要求实现对相关视频文件按需求进行切分、标注、归档、查询和服务等功能。

目前,这一项工作主要由工作人员通过利用相关软件手动拖动视频进行观察、估计、切分等工作,这不仅效率低下且造成人力资源的浪费。

针对此问题,本项目拟设计并开发一个基于内容的视频切分系统[7],该系统可根据需求能对一种或多路高清视频进行自动解码、识别关键帧、切分等多项功能。

在目前的条件下本文针对特定的视频类型来设计特定的、既简单又实用的视频提取算法,下面本文就介绍一种针对项目视频的识别关键帧而设计的一种关键帧提取算法。

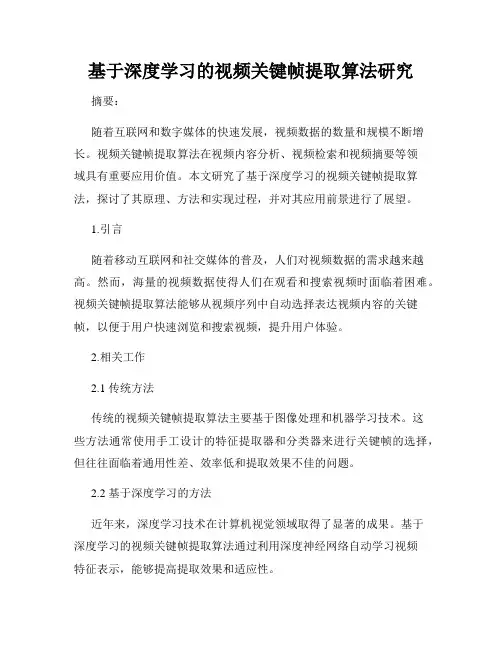

通过反复观察此项目视频之后,发现在视频中,如果出现时间表的文字时,一定在视频帧的右上角,这些视频帧最大限度地反映了报告人作报告所用的时间,具有极强的代表性,正是我们要提取的关键帧. 因此,在对项目视频进行分析和对项目视频的关键帧进行提取时,考虑到了时间表信息的利用。

为了对关键帧进行识别,主要分为两个步骤,分别是关键帧检测和关键帧识别,本文分别对这两个内容进行了描述。

2. 关键帧检测关键帧提取[8]的方法有很多种,目前比较典型的有基于镜头的方法,帧平均法和直方图平均法[9],基于运动的分析法方法[10],基于聚类的方法[11]。

其中基于镜头的方法主要是将镜头检测中得到的镜头中的首帧(或尾帧)作为镜头关键帧。

帧平均法是从镜头中取所有帧在某个位置上像素值的平均值,然后将镜头中该点位置的像素值最接近平均值的帧作为关键帧;直方图平均法则是将镜头中所有帧的统计直方图取平均,然后选择与该平均直方图最接近的帧作为关键帧。

基于运动的分析法方法通过光流分析来计算镜头中的运动量,在运动量局部最小值处选取关键帧,它反映了视频数据的静止。

基于聚类的方法[12]可以通过对视频帧进行聚类来选取关键帧。

算法主要分为三个步骤,首先是特征提取阶段,这里的特征主要是帧间直方图的差别,第一阶段提取的特征作为第二阶段的输入进行聚类,第三阶段即是关键帧的选取。

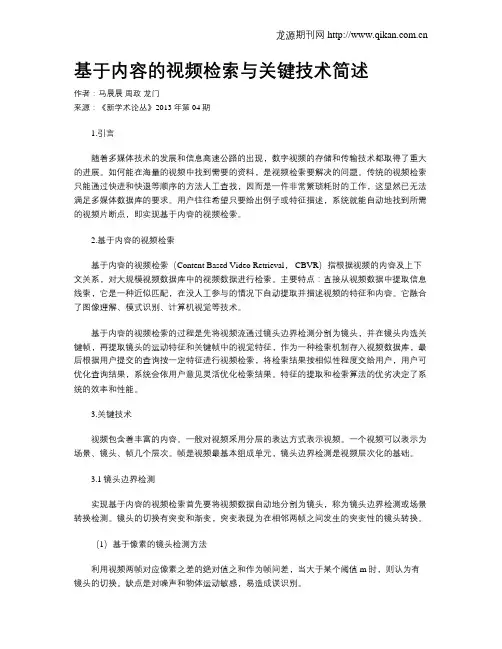

本文采用模板匹配和直方图比较两种方法,通过对项目视频进行大量的分析发现,不包含时间表帧和包含时间表帧的区别的最为行之有效的方法就是提取时间表本身的特征,包含时间表的帧和不包含时间表的帧空间结构模型是固定的,如图1所示为视频帧的空间结构模型。

2.1. 模板匹配法由于本项目需要实现大量视频的自动切分,各类视频数据量非常多,实现视频的自动切分不仅识刘倩 等Figure 1. The spatial structure model of video frames 图1. 视频帧的空间结构模型别的准确率要高,而且识别的时间也必须提高。

因此本文采用了改进的模板匹配[13]方法不仅能够提高识别的准确率,而且也提高了识别的效率。

模板匹配方法是通过在输入图像上滑动图像块对实际的图像块和输入图像进行匹配,算法的检测速度比较快,可以对视频流进行实时检测,通过多次分析统计项目视频中的时间表,逐步对算法进行改进,并利用改进后的算法对项目视频中固定区域(位于屏幕右上方十二分之一范围内)的图片进行了检测,下面对优化后的基于帧图像序列模板提取的模板匹配方法做简要介绍。

根据图1所示空间结构可知,时间表出现的位置是一定的,因此要设定一个局部区域来进行检测,为了提高检测的准确性,局部区域的选择要满足两个条件:1) 位置要准,所选的区域一定是时间表可能出现的区域;2) 范围不能大,否则直接导致检测的时间会延长,而且准确率也会下降。

基于上述条件,选择了图1空间结构图所示的“局部A ”区域。

图中所示的“局部A ”区域相对帧于整帧图像的尺寸如式(2-1)所示:w a W h b H =∗=∗, (2-1)其中,H ——整帧图像的高度;W ——整帧图像的宽度;h ——局部区域的高度;w ——局部区域的宽度;a ,b ——尺寸系数。

对于不同项目视频,尺寸系数略有差异,可以根据具体情况来调整尺寸系数的大小。

对于本文中所采用的项目视频,本文用a = 0.25,b = 1/3。

得到了视频中的区域,算法开始用模板匹配的方法进行检测,多次分析视频数据,提取时间表本身作为固定的模板对项目视频进行检测。

具体实现过程为:首先,读取视频,在视频帧序列中选取一幅有时间帧的图像,根据上述区域分割的方法提取出时间表,作为模板匹配方法的模板,然后连续读入视频序列,对视频序列中所有帧进行固定区域检测,将提取出的模板与视频序列中所有的帧进行模板匹配,检测视频帧中是否包含时间表帧,最后,将检测的结果进行输出并将包含时间表的帧提取出来。

时间表的具体提取流程图如图2所示。

2.2. 直方图比较法直方图[14]中的数值都是统计而来,描述了该图像中关于颜色的数量特征,可以反映图像颜色的统计分布和基本色调。

本文采用了直方图比较的方法实现两幅图像的对比。

要比较两个直方图(H1和H2),首先必须要选择一个衡量直方图相似度的对比标准()12,d H H 。

Opencv 中提供了函数cvCompareHist()用于刘倩 等Figure 2. The extraction of schedule steps 图2. 时间表的提取步骤c) 相交(CV_COMP_INTERSECT),如式(2-4)所示。

()()()()interection 1212,min ,id H H H iH i =∑ (2-4)d) Bhattacharyya 距离(CV_COMP_BHATTACHARYYA),如式(2-5)所示。

通过大量的实验可以验证,使用Bhattacharyya 方法的效果最好。

对Bhattacharyya 方法的直方图匹配,低分数表示好匹配,而高分数表示坏的匹配。

完全匹配是0,完全不匹配是1。

本文所采用的直方图具体步骤如下。

1) 计算视频中提取到的模板图片的直方图hist1。

2) 读取视频帧,截取帧上与模板图片相同大小的位置,并计算其直方图。

3) 采用Bhattacharyya 直方图比较的方法比较每一帧图片与模板图片的直方图相似性。

4) 统计结果设定出阈值T ,通过对所有项目视频做大量的实验分析,可以将本项目视频的阈值T 设定为0.6,将直方图比较结果与阈值T 进行对比,若小于T ,则包含时间表,否则,此视频帧不包含时间表。

2.3.实验结果对比通过上述两种方法,为了验证算法的准确性与高效性,本文选取了多个项目中的视频作为实验对象,其中包括多人做ppt 时的报告视频。

采用识别的准确率与识别效率作为评判标准,模板匹配具体结果如表1所示,直方图比较具体结果如表2所示。