11-关键帧提取

- 格式:ppt

- 大小:2.70 MB

- 文档页数:32

Science &Technology Vision科技视界0引言由于信息技术的普及,近几年安防技术也有了质的飞跃,这其中以智能安防监控视频的应用[1]最引人注目,由于安防监控视频具有空间和时间的二维特性,可直接被用于刑事案件侦查中对嫌疑人的认定和判别,尤其是在人像智能识别与分析[2]中,监控视频成为最主要的图像分析来源。

但在现实情况中,由于时间的紧迫性和成本所限,侦查人员一般都是采用人工轮流以快进的形式浏览视频监控的方式寻找案件线索,巨大的监控视频数据会导致案件相关信息获取实时性差、误判与漏判等问题[3],高强度的视频筛选还会影响侦查人员的身体健康,从而加剧降低侦查效率,因此若能利用某种办法加快检索监控视频得到关键帧就能加快对案件的侦破。

以帧差法为代表的视频关键帧检测是非常成熟的一种方法,这种方法原理简单,尤其对于小区监控视频的关键帧检测非常有效,而且该方法适于硬件[4],可以实现设备小型化。

但是在对监控视频进行预处理、二值化,开闭运算、帧差提取等整个过程中,最后一个重要的步骤是判定哪一帧可以作为关键视频片段被保留,而判断的最重要的参数就是帧间阈值,当阈值过小,提取的视频片段就会出现过多的冗余,后续对比检测时间会延长,阈值过大会出现漏检,因此选取合适的帧间阈值参数尤为重要,本文在不同分辨率分别选择等效的关键帧,得到帧间差阈值T ,利用得到的阈值与图像面积,利用曲线拟合方法对它们之间的关系进行研究,从而得到不同分辨率下所对应的阈值函数关系,并通过实验验证。

1关键帧提取流程原理与帧间差阈值T 的作用本文提取视频关键帧软件流程如图1所示,初始化开始后,获取视频文件的总帧数N ,对获取的第一帧图像进行预处理得到F 1,在未计算到视频文件最后一帧时循环计算,然后处理第二帧图像得到F 2,从而计算得到两帧图像差值C ,当该差值大于预定阈值T时,便认为该图像是关键帧图像,否则不是,如此反复循环,直到最后一帧图像结束。

快速提取帧:使用Adobe Premiere Pro的方法在视频编辑过程中,有时我们需要从视频中提取静止的画面,以用作封面、缩略图或其他用途。

Adobe Premiere Pro是一款广泛使用的视频编辑软件,它提供了一种快速且方便的方法来提取帧。

在本文中,我将介绍如何使用Adobe Premiere Pro快速提取帧,以及一些使用技巧。

首先,打开Adobe Premiere Pro软件并导入你想要提取帧的视频素材。

你可以通过拖放文件或选择“文件”菜单中的“导入”选项来完成此操作。

导入完成后,将视频素材拖放到项目面板中。

接下来,将视频素材拖放到时间轴面板中。

你会注意到视频在时间轴上以图层的形式显示。

在时间轴中找到你想要提取帧的位置,然后将播放头(也称为游标)放置在帧上。

一旦你找到了你要提取的帧,在时间轴面板上单击右键,并选择“导出帧”选项。

这将弹出一个窗口,你可以选择在其中设置帧的输出参数。

在设置窗口中,你可以选择将帧输出为图像文件(如JPEG、TIFF、PNG等)或序列。

如果你只需提取单个帧,则选择图像文件即可。

如果你需要提取多个帧,则选择序列。

在设置窗口中,你还可以设置保存位置。

点击“浏览”按钮,并选择一个适合的文件夹来保存提取的帧。

你还可以选择命名方案,以便更好地组织你的提取帧。

完成这些设置后,单击“确定”按钮开始提取帧。

Adobe Premiere Pro将根据你的设置将帧保存为图像文件或序列,并将其保存到你选择的文件夹中。

除了基本的方法,我还要介绍一些使用技巧,以加快提取帧的速度和效率。

首先,你可以使用快捷键来完成一些操作。

在Adobe Premiere Pro 中,你可以使用“Shift + E”组合键来进行帧的导出。

这将直接弹出设置窗口,省去了右键单击的步骤。

其次,你可以使用“快速导航”工具来快速定位想要提取的帧。

在时间轴面板上,点击右上角的放大镜图标,然后将鼠标移到帧上。

你会看到鼠标变为放大镜样式,点击鼠标左键即可放大帧。

基于深度学习的视频关键帧提取算法研究摘要:随着互联网和数字媒体的快速发展,视频数据的数量和规模不断增长。

视频关键帧提取算法在视频内容分析、视频检索和视频摘要等领域具有重要应用价值。

本文研究了基于深度学习的视频关键帧提取算法,探讨了其原理、方法和实现过程,并对其应用前景进行了展望。

1.引言随着移动互联网和社交媒体的普及,人们对视频数据的需求越来越高。

然而,海量的视频数据使得人们在观看和搜索视频时面临着困难。

视频关键帧提取算法能够从视频序列中自动选择表达视频内容的关键帧,以便于用户快速浏览和搜索视频,提升用户体验。

2.相关工作2.1 传统方法传统的视频关键帧提取算法主要基于图像处理和机器学习技术。

这些方法通常使用手工设计的特征提取器和分类器来进行关键帧的选择,但往往面临着通用性差、效率低和提取效果不佳的问题。

2.2 基于深度学习的方法近年来,深度学习技术在计算机视觉领域取得了显著的成果。

基于深度学习的视频关键帧提取算法通过利用深度神经网络自动学习视频特征表示,能够提高提取效果和适应性。

3.基于深度学习的视频关键帧提取算法3.1 数据预处理在深度学习算法中,数据预处理是一个重要的环节。

对于视频关键帧提取,首先需要将视频转化为图像序列,并进行大小归一化和图像增强等处理。

3.2 特征表示学习通过卷积神经网络(Convolutional Neural Network,CNN)等深度学习模型,提取视频图像序列的特征表示。

深度学习模型能够自动学习到更具有判别性的特征,从而提高关键帧提取的准确性。

3.3 关键帧选择在学习到的特征表示基础上,利用聚类、分类或回归方法进行关键帧的选择。

聚类方法通常将相似的特征聚集到一起,从而选取代表性帧作为关键帧。

分类方法则通过训练一个分类器来判断每一帧是否为关键帧。

回归方法则是通过回归模型预测每一帧的关键帧得分,从而选取得分最高的帧作为关键帧。

4.实验与评估通过实验比较基于深度学习的视频关键帧提取算法与传统方法的效果差异。

2009年第5期福建电脑基于图像相似度的关键帧提取算法贺祥,卢光辉(电子科技大学计算机科学与工程学院四川成都610054)【摘要】:为了在视频管理数据库中提供有效的视频检索和浏览功能,必须用简明的方式表示视频的内容,关键帧提取技术是视频分析和视频检索的基础,现阶段关键帧提取技术已成为视频检索的一个重要研究方向。

文中提出了一种改进的基于内容的视频关键帧提取方法-基于图像相似度的关键帧提取算法。

实验结果表明这种方法可以较好地完成关键帧的提取工作,降低关键帧的冗余度,提高关键帧代表性。

【关键词】:视频关键帧颜色直方图图像相似度1.引言随着视频数据大量的增加,视频数据库管理系统得到广泛的研究。

视频数据库管理系统需要有效的索引技术,而关键帧提取技术是视频分析和视频检索的基础。

一个镜头的内容,是由一些连续、渐变的帧所组成,关键帧(key frame)就是用于描述一个镜头的关键图像帧,它通常会反映一个镜头的主要内容。

提取关键帧的目的有两个方面:其一是希望用它来静态表示视频节目的主题和部分内容,而不是动态的细节;其次,则是希望从关键帧中提取颜色、纹理和形状特征,以作为视频摘要和数据库索引的数据源,而不需要对每个画面都进行提取;由此看出,关键帧应该具有代表性。

对于关键帧的提取,当前一般采取"宁愿错,勿能少"的原则。

关键帧的使用大大减少了视频索引的数据量,同时也为视频摘要和检索提供了一个组织框架。

正是由于关键帧的提取在基于内容的分析、检索以及查询中具有如此重要的地位,近年来受到了研究者的广泛关注,也取得了一定的研究成果。

2.典型的关键帧提取办法经过多年的发展,现阶段对于关键帧的提取主要有以下几种提取方法:2.1基于镜头边界提取关键帧一段视频分割成镜头后,将每个镜头的首帧或者末帧作为镜头的关键帧。

该方法实现起来简单,无需计算,无论镜头的内容如何,关键帧的数量都是一定的(1帧或2帧)。

但效果不好,作为镜头的首帧或者末帧,在多数情况下并不能够能够反映镜头的主要内容。

视频镜头分割及关键帧提取技术研究

随着数字媒体技术的不断发展和普及,视频内容的处理和分析变得日益重要。

其中,视频镜头分割和关键帧提取技术是视频内容分析的关键步骤。

本文将对这两种技术进行研究和探讨。

视频镜头分割是指将视频划分为不同的镜头,每个镜头代表了一个连续的时间段,具有相似的内容和视觉特征。

镜头分割的主要目标是找到镜头间的转换点,即镜头边界。

传统的视频镜头分割方法通常基于颜色直方图、运动特征和纹理特征等,但是由于视频内容的复杂性和多样性,传统方法往往存在一定的局限性。

因此,近年来,基于深度学习的方法在视频镜头分割领域取得了显著的进展。

通过使用卷积神经网络(CNN)等深度学习模型,可以从视频中自动学习到更加丰富和抽象的特征表示,从而提高镜头分割的准确性和鲁棒性。

关键帧提取是指从视频中选择一些具有代表性和重要意义的关键帧,以表示整个视频的内容。

关键帧提取的目标是识别出最能够代表视频内容的帧,并且尽量减少冗余信息。

传统的关键帧提取方法通常基于图像质量、颜色直方图和运动特征等,但是这些方法往往无法充分考虑到视频的语义信息。

因此,近年来,基于深度学习的方法也被应用于关键帧提取领域。

通过使用循环神

经网络(RNN)等深度学习模型,可以对视频的时序信息进行建模,从而提取出更加具有代表性和语义信息的关键帧。

总的来说,视频镜头分割和关键帧提取技术在视频内容分析中起着重要的作用。

通过研究和应用深度学习模型,可以有效地提高这两种技术的性能和效果。

未来,随着深度学习算法的不断发展和优化,视频内容分析领域将迎来更加广阔的发展空间,为我们提供更加丰富和便捷的视频内容处理和分析方法。

人体运动捕获数据关键帧提取算法研究的开题报告一、选题背景现在随着科技的不断发展,人体运动捕获技术被广泛应用在电影、游戏、体育等领域中。

在人体运动捕获技术中,关键帧提取是一个重要的环节。

关键帧是指运动过程中的重要帧,可以表示整个动作的状态。

因此,关键帧的提取对于准确地表示运动过程有重要的意义。

二、研究内容本次研究将主要探究人体运动捕获数据关键帧提取算法,包括以下内容:(1)研究关键帧提取的意义,分析目前常用的关键帧提取算法;(2)针对目前关键帧提取算法的不足之处,提出新的关键帧提取算法;(3)对比新算法和现有算法的效率和准确度。

三、研究意义本次研究的意义在于:(1)提高人体运动捕获数据的表示精度;(2)提高运动捕获数据的处理效率,并降低处理成本;(3)为相关领域的研究提供参考。

四、研究方法采用文献调研、实验分析等方法进行研究。

首先对相关文献进行调研,分析目前关键帧提取算法的优缺点。

然后,针对现有算法的不足之处,提出新的算法,并进行实验分析。

最后,对比新算法和现有算法的效率和准确度。

五、研究难点关键帧提取算法的研究存在以下难点:(1)设计出有效的新算法,并进行实验验证;(2)在保证效率的同时,提高关键帧的准确率;(3)对于不同类型的人体动作,如何设计适合的关键帧提取算法。

六、研究计划(1)文献调研:2021年5月-6月;(2)算法设计:2021年7月-8月;(3)实验分析:2021年9月-10月;(4)论文撰写:2021年11月-2022年1月。

七、预期成果(1)设计出新的关键帧提取算法;(2)分析新算法与现有算法的效率和准确度;(3)撰写学术论文。

什么是视频关键帧?流媒体服务器如何提取视频的关键帧?我上⼀篇⽂章写了关于视频直播点播服务器中调整关键帧间隔的⽅法,同时也发现也是有⼀部分的开发者是有这个需求的。

我记得之前我粗略写过I帧的判断:,但也是粗略的写了⼀下,本篇⽂章我决定就关键帧来做个详细点的说明,最基本的就是——什么是关键帧。

关键帧,就是说这⼀帧是连接两段不同的内容,这⼀帧后⾯的视频内容会有新的变化或过渡;在时间轴上这⼀帧带有⼩⿊点标志;空⽩关键帧,跟关键帧作⽤相同,但是这⼀帧没有内容,在时间轴上,这⼀帧没有⼩⿊点标志;在这⼀帧填充内容后,就变成关键帧了;普通帧是⽤来计量播放时间或过渡时间⽤的,不能⼿动设置普通帧的内容,它是播放过程中由前后关键帧以及过渡类型⾃动填充的,⼿动插⼊或删除普通帧,会改变前后两个关键帧之间的过渡时间。

视频关键帧分为I帧,P帧,B帧,这⾥介绍下区别,也是我搜索得到的,仅供参考。

I帧才是关键帧,P,B算不上关键帧。

I帧是帧内压缩编码得到的,通常是每个GOP组的第⼀帧/基础帧,在⼀组中只有⼀个I帧,I帧所占信息量⼤,解码时仅有I帧即可完整重构图像,所以才叫关键帧。

P帧与B帧是帧间压缩,P帧没有完整图像数据,只有与前⼀帧的差别信息,因此也叫预测帧,B帧则是考虑前后帧的差别(故⽽也叫双向预测帧),因此B帧解码时间最长,压缩⽐最⼤。

那怎么提取视频的关键帧呢?其实提取关键帧⽐提取视频帧快很多倍,下⾯我就基于Android系统来讲⼀下提取视频帧的⽅法:第⼀个参数是传⼊截取时间,只能是us(微秒)第⼆个参数OPTION_CLOSEST在给定的时间,检索最近⼀个帧,这个帧不⼀定是关键帧。

OPTION_CLOSEST_SYNC在给定的时间,检索最近⼀个同步与数据源相关联的的帧(关键帧)。

OPTION_NEXT_SYNC在给定时间之后检索⼀个同步与数据源相关联的关键帧。

OPTION_PREVIOUS_SYNC在给定时间之前检索⼀个同步与数据源相关的关键帧这⾥为了提取我们想要的帧,不使⽤关键帧,所以⽤ OPTION_CLOSESTpublic Bitmap getFrameAtTime()//如果不加参数的话,提取第⼀个关键帧public Bitmap getFrameAtTime() {return getFrameAtTime(-1, OPTION_CLOSEST_SYNC);}/*** 获取视频⽂件截图** @param path 视频⽂件的路径* @return Bitmap 返回获取的Bitmap*/public Bitmap getVideoThumb(String path) {MediaMetadataRetriever media = new MediaMetadataRetriever();media.setDataSource(path);Bitmap frameAtTime = media.getFrameAtTime(1 * 1000 * 1000, MediaMetadataRetriever.OPTION_CLOSEST);if (frameAtTime == null) {frameAtTime = media.getFrameAtTime(3 * 1000 * 1000, MediaMetadataRetriever.OPTION_CLOSEST);}return frameAtTime;}。

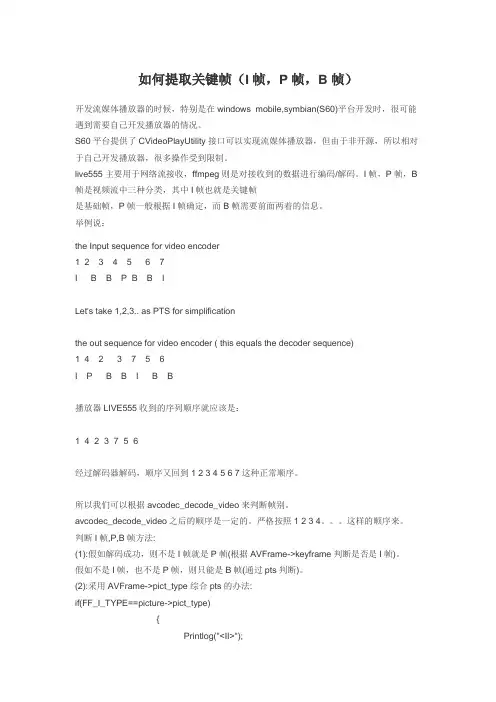

如何提取关键帧(I帧,P帧,B帧)开发流媒体播放器的时候,特别是在windows mobile,symbian(S60)平台开发时,很可能遇到需要自己开发播放器的情况。

S60平台提供了CVideoPlayUtility接口可以实现流媒体播放器,但由于非开源,所以相对于自己开发播放器,很多操作受到限制。

live555主要用于网络流接收,ffmpeg则是对接收到的数据进行编码/解码。

I帧,P帧,B 帧是视频流中三种分类,其中I帧也就是关键帧是基础帧,P帧一般根据I帧确定,而B帧需要前面两着的信息。

举例说:the Input sequence for video encoder1 2 3 4 5 6 7I B B P B B ILet's take 1,2,3.. as PTS for simplificationthe out sequence for video encoder ( this equals the decoder sequence)1 423 7 5 6I P B B I B B播放器LIVE555收到的序列顺序就应该是:1 423 7 5 6经过解码器解码,顺序又回到1 2 3 4 5 6 7这种正常顺序。

所以我们可以根据avcodec_decode_video来判断帧别。

avcodec_decode_video之后的顺序是一定的。

严格按照1 2 3 4。

这样的顺序来。

判断I帧,P,B帧方法:(1):假如解码成功,则不是I帧就是P帧(根据AVFrame->keyframe判断是否是I帧)。

假如不是I帧,也不是P帧,则只能是B帧(通过pts判断)。

(2):采用AVFrame->pict_type综合pts的办法:if(FF_I_TYPE==picture->pict_type){Printlog("<II>");}else if(FF_P_TYPE==picture->pict_type){Printlog("<PP>");}else if(FF_B_TYPE==picture->pict_type){Printlog("<BB>");}else if(FF_S_TYPE==picture->pict_type){Printlog("<SS>");}else{Printlog("<OtherType>");}正常情况下是不会打印出B帧的,因为解码成功的肯定是I帧或者是P帧.判断ffmpeg读到的packet是否为关键帧av_read_frame(avFormatCtx, readPacket)if(readpacket->flags &AV_PKT_FLAG_KEY ){key frame}//////如果是h264编码,从帧数据判断frame = |length|data|length后面紧跟着的第一个byte后5位如果是01001则为关键帧if((frame[4] & 0x1f) == 5){NSLog(@"关键帧");}else{NSLog(@"非关键帧");}。

简述两种视频关键帧提取作者:左璐来源:《北京电力高等专科学校学报》2010年第07期一、ffprobe的下载安装(一)下载ffprobe到/projects/ffprobe/页面,下载ffprobe源码。

(二)解压源码#tar -xzvf ffprob-53.tar.gz(三)安装一般Linux软件,从源码编译、安装过程为 :#./configure //检查环境,生成makefile#make //编译#make install //安装,一般可能需要root权限二、关键帧的提取根据上面的叙述,我们已经有了提取视频关键帧的思路:利用ffprobe定位关键帧的位置(即pkt_dts),利用ffmpeg将这一关键帧转换为png格式的图片。

有两种做法。

(一)不改变源代码,而是利用shell脚本编程,从ffprobe -show_frames命令输出的信息中提取出pkt_dts的值,然后利用ffmpeg将这一帧转换为图片我所写脚本中的关键语句:./ffprobe -show_frames $1 > ffprobetmp 2>>/dev/nullDTS=`awk 'BEGIN {FS="\n" ; RS="\["} {if($0~/codec_type=video/ && $0~/pkt_flag_key=K/) print substr($13,9)}' ffprobetmp`for singledts in $DTSecho $singledtsffmpeg -i $1 -sameq -ss $singledts -vframes 1 -y -vcodec png ./png/$singledts.pngdone解释:./ffprobe -show_frames $1 > ffprobetmp 2>>/dev/null 使用ffprobe命令显示帧信息,并写入文件ffprboetmp,错误信息不显示DTS=`awk 'BEGIN {FS="\n" ; RS="\["} {if($0~/codec_type=video/ && $0~/pkt_flag_key=K/) print substr($13,9)}' ffprobetmp` 使用awk处理ffprobe输出的信息。

基于深度学习的视频关键帧提取技术研究随着视频在我们日常生活中的大量使用,视频内容的快速检索和管理成为重要的需求。

而视频关键帧提取技术正是解决这个需求的有效途径之一。

在传统的视频检索方法中,需要基于手工设计的特征来搜索视频内容,而视频关键帧提取技术则可以通过自动化的方式从视频中提取重要的静态图像,以便于更快速、更方便地进行检索和管理。

深度学习正是其中的研究方向之一。

深度学习作为一种优秀的模式识别技术,已经在图像处理、自然语言处理、语音识别等领域得到了广泛应用。

在视频关键帧提取方面,深度学习的应用也可以实现更高效、更准确的关键帧提取。

一、传统的视频关键帧提取方法在传统的视频关键帧提取方法中,通常基于图像处理算法从视频中提取关键帧。

例如,基于颜色直方图的方法、基于背景差分的方法、基于运动分析的方法等。

这些方法虽然在一定程度上实现了视频关键帧的提取,但是在处理复杂视频、背景变化多样的视频、多人运动视频等情况下会出现提取不准确、处理速度慢等问题。

二、基于深度学习的视频关键帧提取方法深度学习的出现,为视频关键帧提取带来了新的思路。

作为一种基于大数据、自适应、可优化的机器学习技术,深度学习具有更强的数据拟合和模式匹配能力。

这意味着可以更好地处理各种复杂的视频情况,提取更准确的视频关键帧。

2.1 卷积神经网络在深度学习中,卷积神经网络(CNN)被广泛用于图像处理任务。

因为视频本质上也是由一帧帧图像组成的,所以我们可以使用CNN来进行视频关键帧的提取。

具体来说,我们可以使用CNN作为一个特征提取器,提取每一帧视频中的特征向量。

这个特征向量可以包含像素值、颜色信息、纹理等等。

接着,我们可以使用序列模型,如循环神经网络(RNN)或长短时记忆网络(LSTM)等,将这些特征向量整合成一个整体的特征向量序列,以进行最终的视频关键帧提取。

2.2 强化学习当前的视频关键帧提取方法中,仍然面临着被动的主观性问题。

也就是说,人们必须先定义一些规则来搜索视频内容,才能输出帧序列,这可能导致高度依赖经验、规则的主观影响和不准确性。

人工智能领域中的关键帧提取技术研究与应用引言近年来,随着人工智能技术的快速发展,视频数据变得越来越丰富。

关键帧提取作为视频数据处理中的重要环节,能够从视频中提取出最具代表性和信息量的关键帧,为后续的视频分析和搜索提供基础。

本文将深入探讨人工智能领域中的关键帧提取技术研究与应用。

一、关键帧提取技术概述关键帧提取是指从视频序列中选择一些关键帧,这些帧能够准确地表示整个视频内容的特点和重要信息。

关键帧提取技术广泛应用于视频摘要生成、图像检索、视频编码、视频编辑等领域。

目前,关键帧提取技术常用的方法包括基于图像质量评价、基于特征提取和基于机器学习的方法。

其中,基于图像质量评价的方法主要根据每一帧的图像质量对视频帧进行排序,选择质量最高的帧作为关键帧。

基于特征提取的方法通过提取每一帧的低级视觉特征,如颜色、纹理、边缘等,然后根据特征相似度对帧进行排序。

基于机器学习的方法则是通过训练一个分类器,从而根据帧的高级视觉特征来识别关键帧。

二、关键帧提取技术的研究进展1. 基于图像质量评价的关键帧提取技术基于图像质量评价的关键帧提取技术主要考虑到视频帧的清晰度、对比度、亮度等因素。

其中,峰值信噪比(PSNR)是衡量图像质量的常用指标。

通过计算每一帧的PSNR值,可以得到一组排序后的帧,选择质量最高的帧作为关键帧。

然而,这种方法忽略了视频帧的内容信息,容易导致提取出的关键帧与视频内容不匹配。

近年来,一些新的图像质量评价指标被提出,如结构相似性(SSIM),在关键帧提取中取得了较好的效果。

SSIM综合考虑了图像的亮度、对比度和结构信息,能够更准确地评估图像的相似性。

2. 基于特征提取的关键帧提取技术基于特征提取的关键帧提取技术主要利用帧的低级视觉特征来衡量帧与视频内容的相似度。

颜色直方图是一种常用的特征表示方法,在颜色分布上对帧进行相似度计算。

此外,还可以通过纹理特征、边缘特征等对帧进行相似度计算。

最近,一些基于深度学习的方法在关键帧提取中取得了显著的进展。

—225—基于镜头内容变化率的关键帧提取算法丁洪丽,陈怀新(中国电子科技集团公司第十研究所,成都 610036)摘 要:针对含有运动目标的视频采用单一阈值提取关键帧时易出现漏检或冗余的情况,提出基于镜头内容变化率的关键帧提取算法。

根据镜头相邻帧差和与镜头平均邻帧差的变化特点定义镜头内容变化率,由该变化率确定关键帧提取的高、低阈值,实现自动提取一到多帧关键帧。

实验结果表明,该变化率对视频帧的内容变化有较好的描述能力,提取的关键帧具有很好的代表性。

关键词:视频检索;关键帧提取;镜头内容变化率;镜头平均邻帧差Key Frame Extraction Algorithm Based on Shot Content Change RatioDING Hong-li, CHEN Huai-xin(The 10th Institute of China Electronics Technology Group Corporation, Chengdu 610036)【Abstract 】A key frame extraction algorithm based on Shot Content Change Ratio(SCCR) is proposed against miss or redundancy when using single threshold to extract key frames from video with moving objects. Shot Content Change Ratio is defined according to the variation of the sum of shot adjacent frame difference and the average shot adjacent frame difference. High and low thresholds are determined by the ratio, and a single or several key frames can be extracted from a shot. Experimental results show that this ratio can better describe video frames’ content change and key frames extracted are representative.【Key words 】video retrieval; key frame extraction; Shot Content Change Ratio(SCCR); average shot adjacent frame difference计 算 机 工 程ngineering 第35卷 第13期Vol.35 No.13 2009年7月July 2009·多媒体技术及应用· 文章编号:1000—3428(2009)13—0225—03文献标识码:A中图分类号:TP3121 概述关键帧提取技术是实现基于内容的视频检索(Content- Based Video Retrieval, CBVR)的关键技术之一,在镜头分割以后,为给用户提供方便快捷的浏览和检索,一般要进行镜头关键帧(key-frame)的提取工作。