02第二章 并行程序设计基础(并行计算基础)

- 格式:ppt

- 大小:273.00 KB

- 文档页数:32

MPI并行程序设计实例教程教学设计1. 简介MPI (Message Passing Interface) 是一种进程间通信的标准,可用于实现并行计算。

MPI 是一个库,通过对 MPI 中的函数调用,可实现在共享内存和分布式内存计算机中实现并行计算的任务分割和进程通信。

在实际应用中,MPI 会被和多线程一样用于实现算法的并行化,从而提高计算效率和运行速度。

2. 教学目标通过这个实例教程,我们会:1.了解 MPI 并行程序设计的基本概念和原理2.学会使用 MPI 的基本函数和指令3.学会通过实例演示的方式,掌握常见的 MPI 算法和技术4.实现一个简单的 MPI 并行程序,对其进行测试和优化,提高程序的执行效率3. 教学计划本教程共计 5 个部分,每个部分涵盖不同的内容。

每个部分的内容和学习目标如下:第一部分:MPI 基础概念和原理本部分的目标是让学生了解 MPI 的概念、原理和应用场景。

通过课堂讲授、案例分析和问题解答等方式,使学生领悟 MPI 的并行计算模型和通信方式。

第二部分:MPI 基本函数和指令本部分的目标是让学生掌握 MPI 中的基本函数和指令,理解其使用方法和调用方式。

通过讲解 MPI_Init、MPI_Comm_size、MPI_Comm_rank 等函数和指令,让学生能够熟练使用 MPI 构建并行程序。

第三部分:MPI 并行算法实例本部分的目标是让学生通过具体实例学习 MPI 并行算法设计的方法和技巧。

通过案例分析的方式,让学生了解 MPI 算法设计的核心思想、主要步骤和注意事项。

同时,本部分还会介绍一些常见的 MPI 库和工具,如 MPIBLAST 和 OpenMPI。

第四部分:MPI 程序设计和优化本部分的目标是让学生实践 MPI 代码的编写、调试和优化过程。

通过一个综合实例,让学生学习 MPI 并行程序的设计、实现和测试。

同时,本部分还会讲授MPI 排序算法和负载平衡算法的具体实现方法。

并行计算综述姓名:尹航学号:S131020012 专业:计算机科学与技术摘要:本文对并行计算的基本概念和基本理论进行了分析和研究。

主要内容有:并行计算提出的背景,目前国内外的研究现状,并行计算概念和并行计算机类型,并行计算的性能评价,并行计算模型,并行编程环境与并行编程语言。

关键词:并行计算;性能评价;并行计算模型;并行编程1. 前言网络并行计算是近几年国际上并行计算新出现的一个重要研究方向,也是热门课题。

网络并行计算就是利用互联网上的计算机资源实现其它问题的计算,这种并行计算环境的显著优点是投资少、见效快、灵活性强等。

由于科学计算的要求,越来越多的用户希望能具有并行计算的环境,但除了少数计算机大户(石油、天气预报等)外,很多用户由于工业资金的不足而不能使用并行计算机。

一旦实现并行计算,就可以通过网络实现超级计算。

这样,就不必要购买昂贵的并行计算机。

目前,国内一般的应用单位都具有局域网或广域网的结点,基本上具备网络计算的硬件环境。

其次,网络并行计算的系统软件PVM是当前国际上公认的一种消息传递标准软件系统。

有了该软件系统,可以在不具备并行机的情况下进行并行计算。

该软件是美国国家基金资助的开放软件,没有版权问题。

可以从国际互联网上获得其源代码及其相应的辅助工具程序。

这无疑给人们对计算大问题带来了良好的机遇。

这种计算环境特别适合我国国情。

近几年国内一些高校和科研院所投入了一些力量来进行并行计算软件的应用理论和方法的研究,并取得了可喜的成绩。

到目前为止,网络并行计算已经在勘探地球物理、机械制造、计算数学、石油资源、数字模拟等许多应用领域开展研究。

这将在计算机的应用的各应用领域科学开创一个崭新的环境。

2. 并行计算简介[1]2.1并行计算与科学计算并行计算(Parallel Computing),简单地讲,就是在并行计算机上所作的计算,它和常说的高性能计算(High Performance Computing)、超级计算(Super Computing)是同义词,因为任何高性能计算和超级计算都离不开并行技术。

292学苑论衡一、概述并行计算是高性能计算的代表,是一个国家经济和科技实力的综合体现,也是促进经济、科技发展,社会进步和国防安全的重要工具,是世界各国竞相争夺的战略制高点。

受半导体发热效应的影响,单处理器上的运算速度已经达到极限。

2003年以后,“多核”的并行计算架构逐步成为人类追求更高计算性能的重要途径,并在行业中迅速普及。

并行计算一直应用于航天、国防、气象、能源等国家级重大科研项目,成为“贵族产品”。

随着微电子技术的发展,使用微处理器构建并行计算系统的成本不断下降。

同时,互联网和物联网的发展使高性能计算在“大众市场”的需求日益迫切,Hadoop 的诞生让并行计算“大众化”成为现实,并催生了云计算和大数据。

产业的迅速发展刺激着人才需求的变化,并行计算人才需求开始由研究生向本科生延伸。

总之,无论是计算性能发展的要求,还是产业发展的需求,都给计算机人才的培养带来了重大的影响。

具体的影响是什么?本科教育如何应对?文章就这些问题做了进一步的探讨。

二、并行计算综述(一)并行计算的定义并行计算(Parallel Computing)是一种相对于串行的计算模式,是指使用多种计算资源并行性地解决问题的过程。

狭义上的并行计算尤指同时使用多种计算资源解决计算问题的过程,它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分由一个独立的处理机来并行处理。

(二)并行计算的层次架构时间重叠、资源重复和资源共享是并行计算的三种实现技术。

可以在处理单元、CPU、板载和主机等级别上重复资源构建并行架构。

(1)处理单元级并行即以处理单元(PU)为资源重复单位在CPU 内部实现并行计算。

比如阵列处理机、向量处理机和图形处理器(GPU)。

(2)CPU 级并行以CPU 为资源重复单位建立并行架构,即多处理机系统。

比如共享存储模式的对称多处理机(SMP 系统)和分布式存储模式的大规模并行处理机(MPP)系统。

并行程序设计导论并行程序设计是计算机科学领域中的一个重要分支,它涉及到如何利用多个处理器或者核心同时执行任务以提高程序的执行效率。

这种设计方法在现代计算中变得越来越重要,因为随着硬件的发展,多核处理器已经成为标准配置。

以下是并行程序设计的导论内容。

并行程序设计的概念并行程序设计是指在多个处理器上同时执行程序的不同部分,以实现更快的计算速度。

它基于并行计算的概念,即多个计算任务可以同时进行。

并行程序设计的目标是充分利用现代硬件的多核特性,通过并行化来提升程序的性能。

并行计算的分类并行计算可以分为多种类型,主要包括:1. 数据并行:当相同的操作需要在大量数据上执行时,可以将其分配给多个处理器同时进行。

2. 任务并行:当程序可以被分解为多个独立的任务时,每个任务可以分配给不同的处理器执行。

3. 混合并行:结合数据并行和任务并行的方法,以实现更高效的并行计算。

并行程序设计的挑战尽管并行程序设计可以显著提高性能,但它也带来了一些挑战:1. 复杂性:并行程序设计通常比串行程序设计更复杂,需要考虑数据的分配、同步和通信等问题。

2. 调试难度:并行程序的调试比串行程序更困难,因为需要跟踪多个线程或进程的执行。

3. 可扩展性:设计并行程序时,需要考虑其在不同规模的硬件上的可扩展性。

4. 性能瓶颈:并行程序可能会遇到性能瓶颈,如内存带宽限制、处理器间通信延迟等。

并行程序设计的方法1. 多线程编程:使用线程库(如POSIX线程或Java线程)来创建和管理线程,实现任务的并行执行。

2. 消息传递接口(MPI):一种用于分布式内存并行计算机的标准通信协议,允许不同节点上的进程进行通信。

3. 共享内存编程:在共享内存架构中,多个处理器可以访问同一块内存区域,通过同步机制来协调对共享数据的访问。

4. 向量处理:利用向量处理器或GPU进行大规模数据的并行处理。

并行算法的设计原则1. 分解:将问题分解为可以并行处理的子问题。

2. 独立性:确保子问题之间的执行尽可能独立,以减少同步需求。

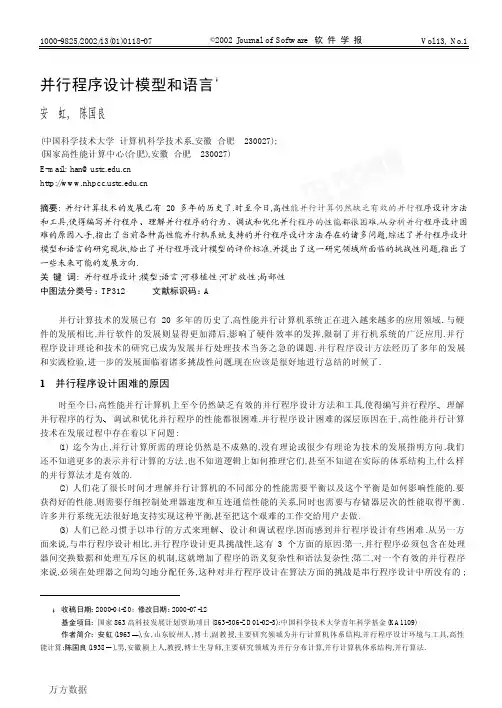

Vol.13, No.1©2002 Journal of Software 软 件 学 报1000-9825/2002/13(01)0118-07并行程序设计模型和语言á安 虹, 陈国良(中国科学技术大学 计算机科学技术系,安徽 合肥 230027);(国家高性能计算中心(合肥),安徽 合肥 230027)E-mail:han@摘要:并行计算技术的发展已有20多年的历史了.时至今日,高性能并行计算仍然缺乏有效的并行程序设计方法和工具,使得编写并行程序调试和优化并行程序的性能都很困难.从分析并行程序设计困难的原因入手,指出了当前各种高性能并行机系统支持的并行程序设计方法存在的诸多问题,综述了并行程序设计模型和语言的研究现状,给出了并行程序设计模型的评价标准,并提出了这一研究领域所面临的挑战性问题,指出了一些未来可能的发展方向.关 键 词:并行程序设计;模型;语言;可移植性;可扩放性;局部性中图法分类号:TP312 文献标识码: A并行计算技术的发展已有20多年的历史了,高性能并行计算机系统正在进入越来越多的应用领域.与硬件的发展相比,并行软件的发展则显得更加滞后,影响了硬件效率的发挥,限制了并行机系统的广泛应用.并行程序设计理论和技术的研究已成为发展并行处理技术当务之急的课题.并行程序设计方法经历了多年的发展和实践检验,进一步的发展面临着诸多挑战性问题,现在应该是很好地进行总结的时候了.1 并行程序设计困难的原因时至今日,高性能并行计算机上至今仍然缺乏有效的并行程序设计方法和工具,使得编写并行程序调试和优化并行程序的性能都很困难.并行程序设计困难的深层原因在于,高性能并行计算技术在发展过程中存在着以下问题:(1) 迄今为止,并行计算所需的理论仍然是不成熟的,没有理论或很少有理论为技术的发展指明方向.我们还不知道更多的表示并行计算的方法,也不知道逻辑上如何推理它们,甚至不知道在实际的体系结构上,什么样的并行算法才是有效的.(2) 人们花了很长时间才理解并行计算机的不同部分的性能需要平衡以及这个平衡是如何影响性能的.要获得好的性能,则需要仔细控制处理器速度和互连通信性能的关系,同时也需要与存储器层次的性能取得平衡.许多并行系统无法很好地支持实现这种平衡,甚至把这个艰难的工作交给用户去做.(3) 人们已经习惯于以串行的方式来理解),女,山东胶州人,博士,副教授,主要研究领域为并行计算机体系结构,并行程序设计环境与工具,高性安虹等:并行程序设计模型和语言119第三,数据也必须在处理器间进行划分,以保持数据的局部性,因为移动数据是要开销的.(4) 与串行程序设计相比,并行程序设计中存在的可移植性问题更加严重.由于至今还没有哪个并行体系结构家族是独立于技术变化的,当需要将一个软件系统从一个并行平台移植到另一个上时,则可能意味着要完全重建这个软件.许多用户至今还未能从高性能并行计算中得到实际的好处,就是因为重写代码的难度太大.并行软件用户期望在他们所使用的并行计算平台上能获得平滑的过渡,这样可以平滑地重新设计和重建软件.(5) 长期以来,并行系统的设计目标只面向市场较小的科学和工程计算,而忽视了大的工业和商用市场,使得并行机十分昂贵,增加了制造商和用户的投资风险,减小了用户使用并行机的热情,从而势必造成其上的软件技术发展缓慢.并行程序设计环境和工具从来都缺少较长的生长期,无法通过不断的版本更新,形成与现今的PC机或工作站一样好用的环境和工具.2 研究现状并行程序设计模型是硬件和软件之间的桥梁,是并行计算的低层实现与高层抽象的界面.为了帮助程序员解决并行程序设计面临的挑战性问题,并行程序设计模型和语言的研究者们已经研究了许多种不同的模型和语言,但迄今为止,还没有哪一种模型是通用的和完美的.2.1 模型研究的硬件结构抽象观点尽管模型的建立应独立于具体的硬件结构,但现有的大多数并行程序设计模型和语言的产生与发展还是深受并行硬件系统结构发展的影响,尤其在并行系统发展的早期.在20世纪80年代后期有两个相互竞争的硬件方法:SIMD(single instruction multiple data)和MIMD (multiple instruction multiple data),最后是MIMD占了上风.硬件也可区分为共享存储和分布存储机器.近年来,共享存储和分布存储的概念本质上已趋于合一.现今大规模并行一般使用多个计算节点和分布存储来实现,每个计算节点内部采用共享存储.一些商家试图在分布存储的机器上提供一个单一的存储映像,使并行机看上去更像一台大的工作站.目前,分布共享存储程序设计只是在处理器数较少的情况下获得了成功,随着处理器数量的增加很少能获得成功.其原因主要不在硬件方面,而在于编译器不能识别和利用数据的局部性.例如,Cray T3E 的通信模式已经做得开销很低了,但显式的消息传递依然是使用多个处理器时最有效的方式.因此,我们认为分布共享存储程序设计可能并非并行计算的圣杯,尽管它是当前许多研究者所追寻的目标.究竟采用哪种方法才是正确的,可能取决于可得到的硬件以及想要得到什么量级的并行.模型和语言代表了用户与并行体系结构之间的中介,应该保障有更多的应用领域能简单而有效地使用并行计算.从体系结构中抽象出来的模型和语言的可用性对并行软件的开发过程有着很重要的影响,也对并行计算系统能否获得广泛应用产生重要影响.第2.2~2.4节主要从这一角度来讨论模型和语言的发展现状.2.2 共享存储的模型和语言共享存储的程序设计模型大多是由PVP(parallel vector processor)和SMP(symmetric multiprocessor)平台提供,共享存储的程序大多是在特定的多处理器平台上用平台专用的语言写成.在这种模型上,数据处在单一地址空间,分为共享和私有两种,数据通信通过共享存储来完成.平台独立的共享存储并行程序设计的标准模型有X3H5[1]¿âÀý³ÌºÍ»·¾³±äÁ¿ÎªUNIX和Wondows NT平台提供共享存储的应用程序接口.支持共享存储并行的标准Fortran语言有PCF(parallel computing forum)[4].它是在Fortran 77里加入并行结构,使程序员能对并行性进行控制,但需要程序员关注进程同步和数据共享问题.商用共享存储语言的例子有SGI P ower C[5].它在串行C语言的基础上扩展了编译制导(compiler directives)和库函数,用于支持共享变量的并行程序设计.SGI对Fortran也提供了类似的扩展结构.120Journal of Software软件学报 2002,13(1)2.3 消息传递的模型和语言分布存储结构的出现带来了两大焦点问题:局部性要求和并行程序设计的复杂性.一种解决局部性的方法是使用显式描述并行的方法,对应于采用消息传递库的消息传递模型和采用说明语句的数据并行模型.在消息传递模型中,一个并行应用由一组进程组成,每个进程的代码是本地的,只能访问私有数据,进程之间通过传递消息实现数据共享和进程同步.消息传递的优点是用户可以对并行性的开发模块化的并行程序.其他的消息传递软件系统还有P4,Vertex,PARMACS,Zipcode,UNIFY和PICL等.在当前所有的消息传递软件中,最重要SMP工作站和PC组成的机群系统,并已经在Windows NT和Windows 95这样的非Unix平台上实现,提供了对C语言银河和曙光上都实现了对MPI和PVM的支持[12].2.4 数据并行的模型和语言数据并行模型的目的是要在分布存储的机器上实现在全局名空间进行并行程序设计,以屏蔽显式的通信问题.它是一种细粒度的并行.数据并行语言用单线程控制配合用户定义的数据和计算在处理器上的分布注释,使用户能够有效地将一些低层细节留给编译器和运行时系统去实现,用户所要做的全部工作就是给出有关并行的指示(parallel directives),说明哪段程序要并行执行.与消息传递模型相比,数据并行程序设计能在一定程度上减轻程序员的负担,但是完全依赖于程序员能否确定一个好的数据分布.最早允许用户控制数据布局(the layout of data)的语言是为SIMD机器ILLIAC IV开发的语言IVTRAN[13].在MIMD环境下第一个引入分配声明(distribution declarations)的语言是Kali[14].Kali编译器[15]是第一个集成静态和运行时通信策略的编译器.Thinking Machines联合COMPASS公司在Connection Machine上的Fortran-8x的子集中引入了静态布局说明(static layout directives)以及数组对准(alignment of arrays)说明[16].Fortran D[17]采用了稍有不同的指示数据分布的方法,即所谓“分解(decompositions)”的方法.它通过先将数据数组对准虚拟数组的方法来指示数据分布,然后用类似于CM-Fortran中的方法,对不同维使用相对权重分配到一个隐式的处理器集合中.该语言允许根据简单规则的分布和不规则的分布来扩展一组对准.Vienna Fortran[18]是上述Fortran 语言中第一个提供了完整的定义映射结构的语言,它主要基于Kali模型.允许数组与数组的对准,因此能够将数组显式地分布到一个处理器阵列上.Thinking Machines公司为它的Connection Machine CM-2和CM-5开发了几个有影响的数据并行语言,像C*,C M F ortran和*Lisp.一些其他的项目也对促进数据并行及其编译技术的开发有所贡献,其中包括很多商业上的努力[19].最重要的数据并行语言是Fortran 90[20]和HPF(high performance Fortran)[19,21].HPF是Fortran 90的扩充.它们都与现有的Fortran语言标准兼容.随着体系结构的发展和科学计算程序设计越来越复杂,该语言的局限性变得越来越明显.对HPF的批评主要有3个方面:认为HPF是一个太低层的语言,通过改进语言编译技术和体系结构,完全可以避开HPF风格的语言所要求安虹等:并行程序设计模型和语言121应用的需要.2.5 模型研究的其他观点以模型的抽象性作为分类的依据,并行程序设计模型还可以分为显式(抽象层次低)和隐式(抽象层次高)两种类型.D.B.Skillicorn和D.Talia从模型的抽象性角度对各种引入了重要思想的并行程序设计模型和语言进行了评价,阐述了它们的发展历史和相互关系,着力描述了各种模型的关键特性[22].我们还可区分基于并行计算理论的模型(如PRAM[23],BSP[24]和LogP[25]模型)基于程序构造的模型(如CSP[28]和Linda[29]模型),也可以根据模型的可表达性和可扩放性来对模型进行分类.限于文章的篇幅,在此不一一讨论.总的说来,尽管有关并行程序模型和语言的研究异彩纷呈,但根据厂家支持和用户人数的规则,当前在实际应用中两种最成功的并行程序设计模型是显式的消息传递标准MPI和共享存储的标准OpenMP.在这两者当中,只有MPI的成功是名副其实的.OpenMP比较新,还需要时间的考验.3 并行程序设计模型的评价标准通过对大量现有的各种并行程序设计模型和语言的分析,可以总结出一个好的并行程序设计模型所应具备的性质.我们可以将这些性质作为模型的评价标准,用于比较各种模型的主要性能和指导新模型的设计.这些性质包括:(1) 尽可能抽象和简单,易于学习与理解.大规模并行程序设计通常是非常复杂的,常常要产生大量并行执行的进程(或线程),并要求能可靠地控制它们的执行,提供进程之间交互的手段.为了减少算法或程序设计人员的负担,模型应能通过一定的抽象,将尽可能多的指示程序并行执行的程序结构由转换机制(如编译器和运行时系统)来插入,而不应由程序员手工去做.这就意味着模型应该尽可能隐藏以下编程细节:线程到处理器的映射;线程间的同步,从而为用户提供一种简洁的描述程序并行的手段,使得模型易于学习和理解,否则,软件开发者就不会愿意使用它.(2) 体系结构独立.由于处理器和互连网络技术发展迅速,计算机系统结构只有较短的生命周期.并行计算的用户必须准备好可能每隔5年甚至更短的时间就要更换他们所用的并行机,并且新的并行计算机不可能与被更换掉的完全一样.如果想普及并行计算,就必须将并行软件从并行计算机底层的更新变化中隔离出来.模型应能够描述在不同体系结构的并行机上实现的并行算法或程序.模型越抽象,其体系结构的独立性越强,算法和软件的可移植性也就越强.(3) 能提供一套完整的软件开发方法.迄今为止已有的大量并行软件都是数值的或用于科学计算的,对它们的开发都没有优先考虑开发方法.这有两方面的原因:由于科学计算类的应用大多属于研究性质,而不是生产性的,因此很少强调这类软件发展的长期性,因为许多程序只打算短期使用.随着生产性并行应用的增加,比起串行程序设计,完整的并行软件开发方法似乎是更为基本的问题.我们需要经过长期的工作来建立正确的并行软件构造方法.模型的研究必须充分地考虑这一点.(4) 能够保障性能.模型应该能在各种并行系统结构上保障性能.现在我们已经完全明白,通信性能是对系统结构的基本限制.系统性能降低的原因通常是由于通信拥塞.只有支持限制通信频度的模型,或者是作了足够的限制来实现程序和数据局部性的模型,才能在所设计的并行计算机上保证好的性能.(5) 可测量程序的成本.程序的成本主要包括程序的执行时间,其次是处理器的利用率和软件开发的成本.在并行程序开发中对并行程序作小的改变和对目标计算机的选择都会影响程序的成本.一个程序在模型中的性能与其在实现中的性能之间应该存在等价关系.成本测量还要与模块性配合好.现代软件几乎都是在不同的时间里以分块的方式开发出来的,这意味着要能给每个开发小组限定一个资源预算.如果每个小组都能满足分配给他们的个别成本,就可以实现总的成本目标.这就意味着成本测量必须是可合成的,总的成本易于由其部分122Journal of Software软件学报 2002,13(1)在上述并行程序设计模型的评价准则之间不可避免地存在着一定的相互对立和矛盾.如,高层抽象提高了模型的通用性和简洁性,但同时失去了模型应具有的精确性;低层抽象虽然保证了模型的精确性,但却限制了模型的通用性,并增加了描述并行的复杂性.为了缓和这种矛盾,目前对模型的设计和使用大多是在这些性质之间进行了某种权衡.4 未来的挑战和发展趋势在过去10年里,并行计算的应用领域发生了两方面的变化:一方面是由市场较小的科学和工程计算转向市场巨大的商业和工业应用;另一方面是并行计算应用的规模和复杂性大大增加,呈现出高性能代码可移植软件包多学科并行程序框架(中间层)和代码(低层)三个设计层次,在每个层次上分别研究新的或集成现有的成功的设计方法.(2) 可视化的并行软件构造方法.在高层进行并行程序设计时,应该特别强调可视化的设计方法[31].用可视编程语言开发并行软件,设计者可以把头脑中的概念模型先用一张图“画”出来,这张图就是可视的并行程序.可视并行程序由系统提供的变换程序自动或半自动地翻译成在具体的并行机上可并行的执行代码,用户主要关心系统的概念模型,不必一开始就陷入复杂的并行语言的编程细节之中.我们正在研究以可视化的标准建模语言UML(unified modeling language)[32]为框架,建立面向对象的可视化并行软件开发方法.(3) 面向对象的并行程序设计语言.传统的并行程序设计方法主要基于功能分解,存在着功能抽象较为困难调试和复用,并发的面向对象程序设计语言正在成为新的研究热点[33].近年来,计算科学界也开始倾向于采用更先进的面向对象方法,而不再是抱着Fortran语言不放[34].从短期来看,让计算科学界学习新的面向对象语言和方法似乎很费时间,但从长远来看,这将有利于从根本上产生更好的并行软件,提高并行软件的生产效率.(4) 并行程序动态行为分析理论.由于并发同步和不确定的特性,使得并行程序的正确性验证和性能效率的判断非常困难.并行程序的正确性调试并行和分布系统[35],是一个值得重视的研究方向.(5) 异质环境下的并行计算问题.我们注意到,中间件技术CORBA[36]和跨平台的面向对象语言Java[37]已经解决了传统的硬件安虹等:并行程序设计模型和语言123于在模型层解决并行程序设计所面临的一系列问题.目前,在中国科学技术大学计算机科学技术系和国家高性能计算中心(合肥)正在进行的并行程序设计模型环境和工具的研究[38,39]正是沿着这个方向进行的.References:[1] American National Standards Institute. ANSI Technical Committee X3H5. Parallel Processing Model for High-Level ProgrammingLanguages, 1993.[2] IEEE. POSIX P1003.4a: Threads Extension for Portable Operating Systems. Piscataway, NJ: IEEE Press, 1994.[3] OpenMP Standards Board. OpenMP: a Proposed Industry Standard API for Shared Memory Programming. 1997. http://www./openmp/mp-documents/paper/paper.Html.[4] Parallel Computing Forum. PCF: parallel Fortran extensions. Fortran Forum, 1991,10(3):1.[5] Silicon Graphics, IRIS Power C User’s Guide, Silicon Graphics Computer Systems, Mountain View, CA, 1989.[6] Tucker, L.W., Mainwaring, a. CMMD: active messages on the CM-5. Parallel Computing, 1994,20(4):481~496.[7] Kolawa, A. Parasoft: a comprehensive approach to parallel and distributed computing. In: IEEE Computer Society, ed. Proceedingsof the Workshop on Cluster Computing. Los Alamitos, CA: IEEE Press, 1992.[8] Pierce, P., Regnier, G. The paragon implementation of the NX message passing interface. In: IEEE Computer Society, ed.Proceedings of the Scalable High-Performance Computing Conference. Los Alamitos, CA: IEEE Press, 1994, 184~190.[9] Foster, I., Chandy, K.M. Fortran M: a language for modular parallel programming. Journal of Parallel and Distributed Computing,1995,26(1):24~35.[10] CORPORATE the MPI Forum. MPI: a message passing interface. In: ACM, ed. Proceedings of the conference onSupercomputing’93. New York: ACM, 1993. 878~883.[11] PVM Home Page at UTK. /pvm.[12] Chen, Guo-liang. Parallel Computing: Architecture Programming. Beijing: Higher Education Press, 1999 (in Chinese).[13] Millstein, P.E. Control structures in ILLIAC IV Fortran. Communications of the ACM, 1973, 16(10):621~627.[14] Mehrotra, P., Rosendale, J.V. Programming distributed memory architectures using Kali. In: Nicolar, A., Gelernter, D., Gross, T., etal., eds. Advances in Languages and Compilers for Parallel Processing. Pitman: MIT Press, 1991. 364~384.[15] Koelbel, C., Mehrotra, P. Compiling global name-space parallel loops for distributed execution. IEEE Transactions on ParallelDistributed System, 1991,2(4):440~451.[16] Albert, E., Knobe, K., Lukas, J.D., et al. Compiling Fortran-8×array features for the connection machine computer system. In:Proceedings of the Symposium on Parallel Programing: Experience with Applications, Languages, and Systems (PPEALS). New Haven, CT, 1988. 42~56.[17] Fox, G., Hiranandani, S., Kennedy, K., Koelbel, C., et al. Fortran D language specification. Technical Report, TR90079, Houston:Department of Computer Science, Rice University, 1991.[18] Chapman, B., Mehrotra, P., Zima, H. Programming in Vienna Fortran. Scientific Programming, 1992,1(1):1~35.[19] Mehrotra, P., Rosendale, J.V., Zima, H. High performance Fortran: history, status and future. Parallel Computing, 1998,24(3-4):325~354.[20] Adams, J., Brainerd, W., Martin, J., et al. The Fortran 95 Handbook. Menlo Park, CA: MIT Press, 1997.[21] High performance FORTRAN language specification. 1993. ftp://.[22] Skillicorn, D.B., Talia, D. Models and languages for parallel computation. ACM Computing Surveys, 1998,30(2):123~169.[23] Fortune, S., Wyllie, J. Parallelism in random access machines. In: ACM, ed. Proceedings of the 10th ACM Symposium on Theoryof Computing. New York: ACM Press, 1978. 114~118.[24] Valiant, L. G. A bridging model for parallel computation. Communications of the ACM, 1990,33(8):103~111.[25] Culler, D., Karp, R., Patterson, D., et al. LogP: towards a realistic model of parallel computation. In: Proceedings of the 4th ACMSIGPLAN Symposium on Principles and Practices of Parallel Programming (PPoPP’93). San Diego, CA: ACM Press, 1993. 1~12.[26] Banatre, J.P., Metayer, D.L. Introduction to gamma. In: Banatre, J.P., LeMetayer, D., eds. Research Directions in High-LevelParallel Programming Languages. LNCS574, Springer-Verlag, 1991. 197~202.[27] Bickford, M. Composable specifications for synchronous systems using UNITY. In: Proceedings of the International Symposium onAdvanced Research in Asynchronous Circuits and Systems. 1994. 216~227.[28] Hoare, C.A.R. Communicating Sequential Processes, International Series in Computer Science. Englewood Cliffs, NJ: Prentice-Hall, Inc., 1985.[29] Carriero, N., Gelernter, D. Application experience with Linda. In: ACM, ed. Proceedings of the ACM/SIGPLAN Symposium on124Journal of Software软件学报 2002,13(1)[30] Womble, D.E., Dosanjh, S.S., Hendrickson, B., et al. Massively parallel computing: a Sandia perspective. Parallel Computing,1999,25(13-14):1853~1876.[31] Beguelin, A., Nutt, G. Visual parallel programming and determinancy: a language specification, an analysis technique, and aprogramming tool. Journal of Parallel and Distributed Computing, 1994,22(2):235~250.[32] Booch, G. UML in action. Communications of the ACM, 1999,42(10):26~28.[33] Yang, Da-jun, Zhang, Ming, Lü, Jian. The study of concurrent object oriented programming language. Computer Research andDevelopment, 1998,35(9):769~775 (in Chinese).[34] Gosling, J. Extensions to Java for numerical computation. In: ACM, ed. Proceedings of the ACM 1998 Workshop on Java for High-Performance Network Computing. 1998. /conferences/java98.[35] Lin, Chuang. Stochastic Petri Net and System Performance Evaluation. Beijing: Tsinghua University Press, 2000 (in Chinese).[36] Zhan, Yong-zhao, Xie, li, Sun, Zhong-xiu. The strategies of implementation of distributed application systems by using CORBA.Computer Science, 1999,26(4):13~16 (in Chinese).[37] Arnold, K., Gosling, J. The Java Programming Language. Reading, MA: Addison-Wesley, 1996.[38] An, Hong, Li, Hong, Wu, Ming, et al. A Java/CORBA based universal framework for super server user-end integrated environments.In: Chen, Jian, Lü, Jian, Meyer, B., eds. Proceedings of the 31st International Conference on Technology of Object Oriented Languages and Systems (TOOLS’ 31). Los Alamitos, CA: IEEE Computer Society Press, 1999. 336~341.[39] Wang, Feng, Zheng, Qi-long, An, Hong, et al. A parallel and distributed debugger implemented with Java. In: Chen, Jian, Lü, Jian,Meyer, B., eds. Proceedings of the 31th International Conference on Technology of Object Oriented Languages and Systems (TOOLS’31). Los Alamitos, CA: IEEE Computer Society Press, 1999. 342~346.附中文参考文献:[12]陈国良.并行计算结构编程.北京:高等教育出版社,1999.[33]杨大军,张鸣,吕建.并发面向对象程序设计语言研究与进展.计算机研究与发展,1998,35(9):769~775.[35]林闯.随机Petri网和系统性能评价.北京:清华大学出版社,2000.[36]詹永照,谢立,孙钟秀.使用CORBA实现各种分布式应用系统的策略.计算机科学,1999,26(4):13~16.Parallel Programming Models and LanguagesáAN Hong, CHEN Guo-liang(Department of Computer Science and Technology, University of Science and Technology of China, Hefei 230027, China);(National High Performance Computing Center at Hefei, Hefei 230027, China)E-mail: han@Abstract:Parallel computing is about 20 years old. Till now, there is a lack of effective parallel programming methods and tools in high performance computing as a result that it is very difficulty to parallel programming, understanding behaviors of parallel program, debugging parallel codes and optimizing performance. In this paper, the reasons why so difficulty parallel programming is are analyzed, while the issues about parallel programming methods existing in recent high performance parallel machines are addressed, the current status of parallel programming models and languages are surveyed, the view of the criteria is offered to evaluate parallel programming models, the challenge problems in this area are brought forward, and some future research directions are pointed out.Key words:parallel programming; models; languages; portability; scalability; localityáReceived April 20, 2000; accepted July 12, 2000Supported by the National High Technology Development 863 Program of China under Grant No.863-306-ZD01-02-3; the Youth。

并行处理技术摘要:并行处理计算机是计算机设计的未来。

当代面临着的重大科学技术问题要依赖于计算技术协助解决,一方面要作大型计算以得到更精确的解,另一方面要作计算机模拟,以便进一步了解所探讨问题的结构与运动规律。

这两个方面都离不开并行处理技术。

虽然许多人都认识到并行处理技术的重要性,但并行处理技术的发展道路并不平坦。

从70年代到90年代中期,中间几起几落,究其原因,就是并行计算技术仍然遇到若干困难,使其无法推广应用。

这其中既有软件方面的(并行程序设计)问题,也有硬件方面(并行处理机)的原因。

本文主要从并行程序设计和并行处理机两方面对并行处理技术进行了简要的介绍。

关键词:并行处理技术、并行处理机、并行程序引言人类对计算能力的需求是永无止境的,而在各种类型的计算系统中,超级计算机的性能最高。

90年代以来,超级计算机在工业、商业和设计等民用领域的重要性越来越明显了。

因此,超级计算机的发展,不仅会深刻地改变产品和材料的设计方法,改变研究和实验的方式,而且将逐步影响人们的生活方式。

超级计算机已经成为体现一个国家经济和国防力量的重要标志。

20多年来,超级计算机的工作频率只提高了将近10倍,而峰值速度却提高了1万倍。

这说明,主要的性能改善来自结构的进步,尤其是来自各种形式的并行处理技术。

但是,超级计算机的用户们关心的并不是系统在理论上的最高速度,而是实际解题所需要的时间和程序设计及移植的工作量。

并行处理是提高计算机系统性能的重要途径。

目前几乎所有的高性能计算机系统,都或多或少地采用了并行处理技术。

本文将就并行处理技术做简要的介绍。

何为并行并行性主要是指同时性或并发性,并行处理是指对一种相对于串行处理的处理方式,它着重开发计算过程中存在的并发事件。

并行性通常划分为作业级、任务级、例行程序或子程序级、循环和迭代级以及语句和指令级。

作业级的层次高,并行处理粒度粗。

粗粒度开并行性开发主要采用MIMD方式,而细粒度并行性开发则主要采用SIMD方式。

计算机程序设计并⾏计算概念及定义全⾯详解⽬录1 摘要2 概述2.1 什么是并⾏计算?2.2 为什么要并⾏计算?2.3 谁都在使⽤并⾏计算?科学界和⼯程界:⼯业界和商业界:全球应⽤:3 概念和术语3.1 冯诺依曼体系结构3.2 弗林的经典分类3.3 ⼀些常见的并⾏计算术语3.4 并⾏程序的缺陷和代价复杂性:可移植性:资源需求:可扩展性:4 并⾏计算机的内存架构4.1 共享内存统⼀内存存取(Uniform Memory Access):⾮统⼀内存存取(Non-Uniform Memory Access):4.2 分布式内存4.3 混合分布式-共享内存5. 并⾏计算模型5.1 概述在分布式内存架构上的共享内存模型在共享内存架构上的分布式内存模型5.2 共享内存模型(⽆线程)5.3 线程模型5.4 分布式内存/消息传递模型5.5 数据并⾏模型5.6 混合模型5.7 单程序多数据模型(SPMD)和多程序多数据模型(MPMD)单程序多数据模型(Single Program Multiple Data (SPMD)):多程序多数据模型(Multiple Program Multiple Data (MPMD)):6 并⾏程序设计6.1 ⾃动 vs. ⼿动并⾏化完全⾃动:程序员指令:6.2 理解问题和程序识别程序的关键点 (hotspots):识别程序中的瓶颈 (bottlenecks):6.3 分割 (Partitioning)6.4 通讯 (Communications)通讯开销:延迟 vs. 带宽:通讯可见性:同步 vs. 异步通讯:通讯的范围:通讯的效率:开销和复杂性:6.5 同步 (Synchronization)同步的类型:6.6 数据依赖性 (Data Dependencies)6.7 负载均衡 (Load Balancing)6.8 粒度 (Granularity)计算通讯⽐ (computation / Communication Ratio):细粒度并⾏化 (Fine-grain Parallelism):粗粒度并⾏化 (Coarse-grain Parallelism):6.9 输⼊输出 (I/O)6.10 调试 (Debugging)6.11 性能分析和调优 (Performance Analysis and Tuning)7 并⾏⽰例7.1 数组处理7.2 圆周率计算7.3 简单热⽅程7.4 ⼀维波动⽅程8 参考⽂献和更多信息(本⼈刚刚完成这篇长⽂章的翻译,尚未认真校对。

并行程序设计第一章1.摩尔定律是什么?从1986年到2002年,微处理器的性能以平均每年50%的速度不断提升。

但从2002年开始,单处理器的性能提升速度降低到每年大约20%,这个差异是巨大的:如果以每年50%的速度提升,在10年里微处理器的性能会提升60倍,而以20%的速度,10年里只能提升6倍2.任务并行和数据并行是什么?任务并行是将待解决问题所需要执行的各个任务分配到各个核上执行。

而数据并行是指将待解决问题所需要处理的数据分配给各个核,每个核在分配到的数据集上执行大致相似的操作。

3.并发、并行、分布式的区别?A)并发计算(解释错误)B)并行计算中,一个程序通过多个任务紧密协作来解决某个问题C)在分布式计算中,一个程序需要与其他程序协作来解决某个问题第二章1.冯·诺依曼结构是什么以及他的瓶颈冯·诺依曼结构包括、中央处理单元(CPU)处理器或核,以及主存和cpu之间的互连结构。

主存和cpu之间的分离称为冯·诺依曼瓶颈2.对冯·诺依曼模型的改进方法有几种分别是什么?有三种改进措施,分别为:缓存、虚拟储存器(或虚拟内存)和低层次并行3.cpu向cache写数据时因cache中的值与主存中的值不同或者不一致的问题,有什么方法解决?有两种方法解决这个不一致问题,在写直达cache中,当cpu向cache写数据时,高速缓存行会立即写入主存中。

在写回cache中,数据不是立即更新到主存中,而是将发生数据更新的高速缓存行标记成脏。

当发生高速缓存行替换时,标记为脏的高速缓存行被写入主存中。

4.Cache映射问题(了解)直接映射(directmapping)将一个主存块存储到唯一的一个Cache行。

全相联映射(fullyassociative mapping)可以将一个主存块存储到任意一个Cache行。

n路组相联映射(setassociative mapping)可以将一个主存块存储到唯一的一个Cache组中任意一个行。