哈希快速图像匹配算法研究

- 格式:pdf

- 大小:2.95 MB

- 文档页数:4

基于hausdorff距离和遗传算法的物体匹配方法

1. 前言

物体匹配是计算机视觉中一个重要飞研究课题,其目的是检测给定输入图像中可视物体的位置及其形状。

为了更有效地解决这个问题,许多相关理论及其应用不断地发展。

近年来,基于Hausdorff距离和遗传算法(GA)的物体匹配方法由于它的高效性,易于实现并拥有较高的精度,而受到了人们的广泛关注和应用。

2. 方法

(1)Hausdorff距离。

Hausdorff距离是一种比较两个不同特征之间形状相似性的方法,它测量了两个样本物体之间最大的距离,它衡量了一个物体距离另一个物体最远的点对最近点之间的距离,这种距离表征了两个物体的形状相似性。

(2)遗传算法(GA)。

GA是一个基于特定问题的搜索和求解方法,它可以根据特定的问题来生成适合的解决方数,通过迭代的优化方法来确定最优的解决方案。

GA的优势在于可以快速计算出最优结果,同时保证了较高的精度。

3. 结论

在虚拟视觉技术中,Hausdorff距离是一种计算机视觉中重要的研究课题,它可以实现高效和准确的物体匹配任务,可以改善传统的物体匹配方法的效率和准确性。

并且基于Hausdorff距离的物体匹配方法中结合遗传算法可以达到更快的收敛精度。

因此,基于Hausdorff距离和遗传算法的物体匹配方法可能会成为未来计算机视觉技术中更有效的物体进行识别和定位的重要工具。

使用计算机视觉技术进行图像配对的步骤详解图像配对是计算机视觉技术的一种重要应用,在许多领域都有广泛的应用,例如图像检索、人脸识别和物体识别等。

本文将详细介绍使用计算机视觉技术进行图像配对的步骤,并解释每个步骤的具体操作。

第一步:数据收集和预处理在开始图像配对之前,我们首先需要收集一组相关的图像数据,并进行预处理。

数据收集可以通过网络爬虫、图像数据库或合作伙伴机构等方式获取。

预处理通常包括图像尺寸调整、图像去噪和图像增强等操作,以便提高后续处理的准确性和效果。

第二步:特征提取特征提取是图像配对的关键步骤,它用于将图像数据转化为可供计算机进行处理和比较的特征向量。

常用的特征提取方法包括传统的人工设计特征和基于深度学习的卷积神经网络(CNN)特征。

传统的人工设计特征通常包括色彩特征、纹理特征和形状特征等。

色彩特征可以使用直方图统计图像的颜色分布情况,而纹理特征可以使用局部二值模式(LBP)或小波变换等方法描述图像的纹理信息。

形状特征可以使用边缘检测算法提取图像中物体的轮廓信息。

基于深度学习的特征提取方法中,卷积神经网络(CNN)已被证明对于图像配对任务具有优异的性能。

通常,我们可以使用预训练的CNN模型(例如VGG、ResNet或Inception等)提取图像的高层特征向量,并将其作为后续配对算法的输入。

第三步:特征匹配在提取了图像的特征向量后,接下来需要进行特征匹配。

特征匹配是指找到两幅图像之间对应的特征点或特征向量,以及计算它们之间的相似度或距离。

常用的特征匹配方法包括暴力匹配(Brute-Force Matching)和基于近似最近邻(Approximate Nearest Neighbor)的方法。

暴力匹配方法直接计算两幅图像中所有特征点或特征向量之间的相似度或距离,并选择最相似的进行配对。

这种方法的优点是简单直接,但计算复杂度较高,对大规模数据集不适用。

基于近似最近邻的方法则利用数据结构(如kd树、LSH等)或近似算法(如局部敏感哈希)来加速特征匹配过程,从而降低计算复杂度。

基于内容的图像检索方法研究的开题报告一、选题背景及研究意义现今互联网上产生了大量的图片数据,如何更快地准确地检索图像的内容成为了一个重要的研究领域。

基于内容的图像检索方法是一种基于图像内容的相似性匹配,从而实现在大规模的图像数据库中快速定位特定图像的方法。

在互联网时代,越来越多的信息以图像的方式存在。

如何快速、准确地从海量图像库中检索到需要的图像,就成为了当前图像检索领域面临的一大难题。

基于内容的图像检索技术具有操作简单、高效快速、精度高、结果准确等优点,已经被广泛用于许多领域,如医学图像识别、面部识别、车牌识别等。

然而,由于图像内容复杂多样,基于内容的图像检索技术还存在一定的局限性和挑战,如提高检索的准确性和普适性,增强图像数据的拟合能力。

二、研究内容本文旨在对基于内容的图像检索方法进行探索和研究。

主要研究内容包括以下方面:1. 基于特征提取的图像检索方法研究:通过对图像特征进行提取和描述,来实现图像相似度匹配,包括传统的色彩、纹理、形状等特征提取方法和基于深度学习的特征提取方法,并对其特点和应用进行比较和分析。

2. 基于感知哈希的图像检索方法研究:通过感知哈希算法,将图像特征向量量化为二进制编码,实现图像相似度计算,在保证检索精度的同时,降低图像检索的时间复杂度。

3. 基于深度学习的图像检索方法研究:深度学习是当前图像处理领域最热门的技术之一。

通过卷积神经网络提取特征,构建图像特征空间,实现图像相似度匹配,并研究深度学习技术在基于内容的图像检索中的应用方面。

三、研究方法本文采用文献研究和实验研究相结合的方法,通过调研已有的基于内容的图像检索方法,分析其优缺点和适用范围,并结合具体应用场景,选取适合的图像特征提取算法和图像相似度计算方法。

同时,利用公开的图像数据集构建实验平台,评估不同图像检索算法的性能和检索效果,并对实验结果进行分析和讨论。

四、预期成果1. 完成基于内容的图像检索方法的探索和研究,深入分析各种算法的特点和适用范围,并对其进行比较和优化。

第42卷 第4期 JOURNAL OF XIDIAN UNIVERSITY V ol.42 No.4 ______________________________收稿日期: 网络出版时间: 基金项目:国家自然科学基金资助项目(61170161,61303171,61271406)作者简介:马艳萍(1975-), 女, 博士研究生, E-mail :myp74920@网络出版地址: doi :10.3969/j.issn.1001-2400.2015.04.026数据依赖的多索引哈希算法马艳萍2,1,姬光荣1,邹海林2,谢洪涛3(1. 中国海洋大学信息科学与工程学院,山东 青岛 266100;2.鲁东大学信息与电气工程学院,山东 烟台 2640253.中国科学院信息工程研究所 信息内容安全技术国家工程实验室,北京,100093)摘要:多索引哈希是目前使用最广泛的针对二进制码的索引算法. 由于多索引哈希基于数据集中的二进制码呈均匀分布这一假设,不能有效处理非均匀分布的数据集. 针对这一问题,提出数据依赖的多索引哈希算法. 首先把二进制码划分为多个连续不重合的子串,并通过计算二进制码每位之间的相关性为每一个子串学习得到自适应投影向量. 在为每个子串建立哈希表时,使用投影向量对子串进行投影从而得到哈希表中的下标. 采用自适应投影的方法可以使得哈希表中的元素接近于均匀分布,进而提升查询速度. 此外,提出一个基于熵的分布度量方法,以评价哈希表中数据元素的分布情况. 在大规模数据集上的实验表明,与多索引哈希算法相比数据依赖的多索引哈希算法可以使查询速度提升36.9%–87.4%.关键词:最近邻查询;二进制码;索引;多索引哈希中图分类号:TP183 文献标识码:A 文章编号:1001-2400(2015)04-0177-07Data-oriented multi-index HashingMA Y anping 1,2, JI Guangrong 1, ZOU Hailin 2, XIE Hongtao 3(1School of Information Science and Engineering, Ocean University of China, Qingdao, 2661002Scholol of Information and Electrical Engineering, Ludong University, Y antai, 2640253Institute of Information Engineering, Chinese Academy of Sciences, Beijing, 100093)Abstract: Multi-index hashing (MIH) is the state-of-the-art method for indexing binary codes. However, MIH isbased on the dataset codes uniform distribution assumption, and will lose efficiency in dealing with non-uniformlydistributed codes. In this paper, we propose a data-oriented multi-index hashing method. W e first compute thecorrelations between bits and learn adaptive projection vector for each binary substring. Then, instead of usingsubstrings as direct indices into hash tables, we project them with corresponding projection vectors to generate newindices. With adaptive projection, the indices in each hash table are near uniformly distributed. Besides, we putforward an entropy based measurement to evaluate the distribution of data items in each hash table. Experimentsbe improved by 36.9%–87.4%.Key Words: nearest neighbor search; binary codes; indexing; multi-index Hashing在大规模的数据集中进行最近邻查询是图像检索[1][14]、计算机视觉[2][15]、目标检测[3]等领域的一个基础工作. 由于二进制码特征计算快速、节省存储空间、特征之间的匹配操作仅需要几个机器指令就能完成,目前越来越多的研究采用二进制码特征来描述视觉内容[4][5][6]. 在一个具有百万规模的二进制码数据集中查找一个查询的最近邻可以在不到一秒的时间内完成[7].虽然二进制码之间的海明距离可以快速计算,但是线性查询只能处理小规模的数据集. 因为计算机处2014-11-05 16:16/kcms/doi/10.3969/j.issn.1001-2400.2015.04.026.html理器的计算能力有限而数据集的规模是无限的,随着数据集的增长(数以百亿)线性查询将变得很慢. 为了提高大规模数据环境下二进制码的最近邻查询性能,Salakhutdinov等人提出了二进制哈希方法[4][8]. 该方法在建索引时,直接使用二进制码作为哈希表的下标(存储地址). 在查询时,通过不断增加查询半径即可返回与查询相似的最近邻. 但是随着查询半径的增加,该方法需要比对的待检测数据呈指数级的增长. 当二进制码的位数大于32维时,即使采用一个很小的查询半径二进制哈希在理论上需要比对的数据规模可能比整个数据集的容量还要大[7]. 在这种情况下,二进制哈希比线性查询的速度还要慢. 针对这一问题,W eiss 等人提出了多索引哈希算法[8]. 多索引哈希算法在建立索引时将二进制码划分为多个连续不重合的子串,并为每个子串建立一个哈希表. 在查询时,按照同样的方式把待查询二进制码划分为多个子串,然后在相应的哈希表中进行查找以返回候选结果. 最后,根据候选结果和查询之间的海明距离对候选结果排序从而得到最近邻. 对每一个子串,其所需的查询半径与整个二进制码相比大大减小. 因此,多索引哈希算法极大地降低了需要比对的待检测数据量,从而提高查找最近邻的速度. 由于多索引哈希算法基于数据集中的二进制码呈均匀分布这一假设[7],不能有效处理非均匀分布的数据集. 在多媒体检索中,数据集的分布往往都是非均匀的[1], 因此多索引哈希算法在处理这些数据集时,查询速度受到一定的影响和限制[7][11].针对多索引哈希算法不能有效应对非均匀分布的数据集这一问题,作者提出数据依赖的多索引哈希算法,算法框架图如图1所示. 首先把二进制码划分为多个连续不重合的子串. 然后构建一个训练数据集并计算二进制码每位之间的相关性,为每一个子串学习得到自适应投影向量. 在为每个子串建立哈希表时,使用投影向量对子串进行投影从而得到哈希表中的下标. 采用自适应投影的方法可以使得哈希表中的元素接近于均匀分布,进而提升查询速度. 此外,作者还提出一个基于熵的分布度量方法,以评价哈希表中数据元素的分布情况. 在大规模数据集上的实验表明,与多索引哈希算法相比数据依赖的多索引哈希算法可以使查询速度提升36.9%–87.4%.图1 数据依赖的多索引哈希算法示意图.1算法描述本节首先简要介绍多索引哈希算法[7],然后详细描述数据依赖的多索引哈希算法. 除此以外,作者还提出了一个基于熵[1]的数据分布度量方法.1.1多索引哈希算法虽然计算二进制码之间的海明距离只需要几个异或操作,但是线性查找不能有效地应对大规模的数据集. 因此,Norouzi结合二进制码和哈希表提出了二进制哈希方法[4][7][8]. 二进制哈希把海明空间下的最近邻查询问题转化为R近邻问题:第4期 马艳萍等:数据依赖的多索引哈希算法 179 , 1,2,...,,i i H q p r i N p D −≤=∈ , (1)其中q 是查询向量,D 是数据集,N 是数据集中元素的个数,H •代表海明距离. 通过不断增加查询半径r ,二进制哈希算法可以返回查询向量q 的R 近邻. 为了提高查询速度,二进制哈希算法建立一个哈希表,并直接使用二进制码作为数据元素在哈希表中的下标. 这样,R 近邻问题就可以通过不断增加查询半径r 得到解决. 此时,需要比对的待检测数据量为:0ri l i num C ==∑, (2)其中l 是二进制码的维度. 当二进制码的维数很长时,即使采用一个很小的查询半径r ,二进制哈希在理论上需要比对的数据规模可能比整个数据集的容量还要大[7]. 比如当l=256, r =5,1010num ≈. 而在很多应用中,二进制码的长度都大于256维并且查询半径一般都大于10,以满足检索精度的需求[6]. 在这种情况下,二进制哈希比线性查找还要慢.针对上述问题,Norouzi 提出多索引哈希算法[7]. 该算法在建立索引时将长度为 l 维的二进制码划分为m 个连续不重合的子串,每个子串的长度为l ⎡⎤⎢⎥或者l m ⎢⎥⎣⎦;然后为每个子串建立一个哈希表. 在查询时,按照同样的方式把待查询二进制码划分为 m 个子串,然后在相应的哈希表中进行查找以返回候选结果. 最后根据候选结果和查询之间的海明距离对候选结果排序并得到最近邻. 多索引哈希算法[7]的理论基础是:当两个二进制码 q 和 p 有r 位不相同时,那么至少它们的一个子串最多有r m ⎢⎥⎣⎦位不同:1 .. k kH k m s t q p r m ∃≤≤−≤⎢⎥⎣⎦, (3)其中k q 是q 的第k 个子串. 通过这种方式,多索引哈希算法可以极大地降低了需要比对的待检测数据量. 比如当l=256, r =5 , m=2, 需要比对的数据量为21280*i i m C =∑=16,512, 远远小于1010. 因此多索引哈希算法在索引长二进制码时具有明显的优势. 但是多索引哈希算法基于数据集中的二进制码呈均匀分布这一假设[7],不能有效处理非均匀分布的数据集. 在多媒体检索中,数据集的分布往往都是非均匀的[1][11]. 因此多索引哈希算法具有两个缺点:z 如果待检测区间分布的数据元素比较密集,那么在对候选结果计算距离并排序时需要很多额外的时间开销,从而增加计算量.z 如果待检测区间分布的数据元素比较稀疏,那么候选结果太少. 为了保证足够多的候选结果,不得不增加查询半径r , 这样增加了索引查询时间.1.2 多索引哈希算法通过1.1节的分析可以看出,多索引哈希算法的时间性能依赖于数据集的分布. 为了得到最优的时间性能,需要使哈希表中元素下标的分布尽可能呈均匀分布. 因此,作者在多索引哈希算法的基础上提出数据依赖的多索引哈希算法,算法框架如图1所示. 通过构建一个训练数据集并计算二进制码每位之间的相关性,为每一个子串学习得到自适应投影向量. 在为每个子串建立哈希表时,使用投影向量对子串进行投影从而得到哈希表中的下标. 采用自适应投影的方法可以使得哈希表中的元素下标接近于均匀分布,进而提升查询速度.数据集的非均匀分布是由于二进制码的各个位之间具有相关性造成的[7][11]. 主成分分析(PrincipalComponent Analysis ,PCA )[10] 是一种用来揭示复杂数据潜在的简单结构的数据分析技术. PCA 通过计算新的一组基对原有数据进行线性变换,变换后的数据尽量揭示原有数据之间的关系,且具有线性不相关性.PCA 的优点是简单有效且无参数设置,因此在计算机视觉领域应用广泛. 基于这一理论基础,作者采用PCA 来生成投影向量,以得到分布均匀的投影数据. 从而在尽量保留原始数据近邻关系的前提下,将索引均衡化. 数据依赖的多索引哈希算法执行步骤如下:a. 构建一个训练数据集1[,,,]i n T x x x ="用于PCA 训练. i x 是一个l 维二进制码,用一个列向量表示.为了算法的普适性,训练集和用于建立索引的基准数据集没有重合.b. 计算训练集T 的均值向量μ和协方差矩阵S :西安电子科技大学学报(自然科学版) 第42卷 180 11n i i x n μ==∑,,1()()n T i j i j S x x μμ==−−∑. (4) c. 对于每一个子串,获取其对应的协方差矩阵'S .'S 是S 的一个子矩阵. 然后对矩阵'S 进行特征值分解,得到对应最大特征值的特征向量V .向量V 即为该子串的自适应投影向量.d. 在建立索引和查询时,使用投影向量对子串进行投影从而得到哈希表中的下标. 假设某一子串为1[,,...,]i d p p p p =,那么新的下标值为:1**2dd i i i i indice p V −==∑ (5)由于投影向量包含数据集的分布信息,并去除数据之间的相关性,生成的哈希表中元素下标接近于均匀分布,从而提升查询速度.1.3 数据分布度量在信息论中,熵是对不确定性的测量. 信息熵越高,能传输的信息越多,信息熵越低,意味着传输的信息越少. 为了度量哈希表中数据元素的分布情况,作者提出一个基于熵的分布度量函数. 对于一个哈希表h , 假设数据集的大小为N , 哈希表h 有num_b 个哈希桶,第i 个哈希桶有()n i 个数据元素. 那么把某一个二进制串分配到第i 个哈希桶的概率估算为()()p i n i N =. 哈希表h 的分布熵定义为:_1()(()*log(()))num bi E h p i p i ==−∑. (6)直观上,如果哈希表的分布熵值比较大,那么其中的数据元素更接近于均匀分布. 通过这一度量公式,可以近似地量化和对比哈希表中数据元素的分布情况.2 实 验本节通过大量实验验证本文算法的有效性. 在实验的第1 部分, 首先介绍实验所用的数据集和评测方法;第2部分分析训练集的大小对算法性能的影响;第3部分验证算法的有效性和扩展性.2.1 实验数据集和评测方法实验在著名的ANN_SIFT1B 数据集[12]上开展. 该数据集的元素是128维的SIFT 描述子[13], 其中包含910的基准数据集用于建立索引,810的训练集和410的查询集. 实验数据集的具体描述如表1所述.表1 实验数据集描述数据集大小 基准数据集910 训练集810 查询集 410由于SIFT 描述子是浮点型的向量,作者采用文献[7]提供的开源代码得到原始数据集对应的二进制码数据集,每个二进制码为128维. 在实验中,首先由训练集计算二进制码各位的相关性并学习投影向量. 在性能对比时,训练集和基准数据集没有重合,以保证算法的普适性.为了验证本文提出的数据依赖的多索引哈希算法(Data-Oriented Multi-Index Hashing ,DOMIH )的性能,本文与多索引哈希算法(Multi-Index Hashing ,MIH )[7]和数据驱动的多索引哈希算法(Data Driven Multi-Index Hashing ,DDMIH) [11]进行实验对比. 数据驱动的多索引哈希算法把二进制码划分为多个不连续且不重合的子串,以去除数据的相关性.实验的硬件环境如下:Intel Xeon E5-2620*2(2.00 GHz, 7.2GT/s, 15M cache, 6cores),64G 内存, 上述三个算法都在相同的软硬件环境下运行. 由于这三个算法都返回查询的精确最近邻,因此它们具有相同的精度[11]. 所以在性能对比中,本文主要比较它们的平均查询时间和扩展性.第4期 马艳萍等:数据依赖的多索引哈希算法 1812.2 训练集大小对算法的影响由于本文构建训练集计算二进制码各位的相关性并学习自适应投影向量,那么训练集的大小对算法的性能有一定的影响. 直观上地,训练集越大得到的投影向量越能反应二进制码各位的相关性,算法的性能越好;训练集越小则算法的性能较差. 但是训练集越大计算协方差矩阵的时间就越长,即使这些操作是离线完成不影响在线查询时间. 表2 展示了随着训练集大小的变化本文算法的@1000recall NN 值.@1000recall NN 值度量索引算法返回的前1000个候选结果中正确结果的个数,即召回率. @1000recall NN定义如下:_1000_1000@1000_1000DOMIH NN Linear NN recall NN Linear NN∩= , (7) 其中_1000DOMIH NN 是本文算法返回的前1000个候选结果,即没有根据与查询之间的海明距离对候选结果排序;_1000Linear NN 是线性查找算法返回的前1000个结果,即精确的1000近邻. 对于每个查询,本文计算它的@1000recall NN 值,然后对所有查询求均值.表2 训练集大小对算法性能的影响,基准数据集为910.训练集大小310410510610 710810@1000recall NN 0.4470.5240.5720.623 0.6260.627通过表2 可以看出当训练集中元素个数从310增加到810时,本文算法的@1000recall NN 值不断提升. 当训练集从310增加到610时,@1000recall NN 值的增加幅度很大;当训练集从610增加到810时,@1000recall NN 值的增加幅度很小;即当训练集的大小为610时,@1000recall NN 值趋于稳定. 综合考虑算法精度和时间性能,本文把训练集的大小设置为610.2.3 算法有效性和扩展性验证为了验证本文算法的有效性,本文首先根据公式(6)对比DOMIH 、MIH 和DDMIH 中各个哈希表的数据分布情况;然后对比随着基准数据集和返回结果数量的增加,这三个算法对单查询的平均响应时间. 由于基准数据集的大小为910,那么每个二进制串的长度为9102log 32≈错误!未找到引用源。

基于Sobel算⼦的快速图像匹配检索⽅法

基于Sobel算⼦的快速图像匹配检索⽅法

顾珺恺;谢静

【期刊名称】《电脑编程技巧与维护》

【年(卷),期】2010(000)002

【摘要】给出⼀种较⽬前多数检索⽅法更为⾼效,快速的图像匹配检索⽅法.本算法⾸先利⽤Sobel算⼦对原始图像的边缘信息进⾏处理,然后对图像进⾏⼆值化处理,对所得的图像矩基于边缘进⾏分块实体提取,再将实体与⽬标图像矩进⾏⽐对处理,通过阀值的设置来判断图像的匹配程度,进⽽达到图像检索的⽬的.

【总页数】2页(106-107)

【关键词】图像检索;边缘提取;匹配

【作者】顾珺恺;谢静

【作者单位】南京晓庄学院⾏知学院,南京,211171;南京晓庄学院⾏知学院,南京,211171

【正⽂语种】中⽂

【中图分类】

【相关⽂献】

1.⼀种基于改进 SIFT 算法的图像匹配检索⽅法 [J], 陈守辉; 沙晶晶; 李振

2.基于SIFT算⼦的改进图像匹配算法 [J], 张凯杰; 徐伯庆

3.基于投影特征的图像匹配的快速算法 [J], 李永利; 桂志国; 杨民; 杨巧宁

4.改进SURF特征的维吾尔⽂复杂⽂档图像匹配检索[J], 阿丽亚·巴吐尔; 努尔毕亚·亚地卡尔; 吾尔尼沙·买买提; 阿⼒⽊江·艾沙;库尔班·吾布⼒

5.基于SIFT特征的哈希快速检索与图像匹配 [J], 张闯; 杨咸兆; 徐齐全; 陈苏。

图像识别算法的原理和应用1. 简介图像识别算法是一种通过计算机对图像进行分析和判断的技术。

它涉及到数学、统计学和人工智能等多个领域的知识。

本文将介绍图像识别算法的原理和在不同领域的应用。

2. 原理图像识别算法的原理主要包括特征提取、模式匹配和分类器训练等步骤。

2.1 特征提取特征提取是图像识别算法的第一步,它通过对图像进行分析,提取出能够表征图像特征的信息。

常用的特征包括颜色、纹理、形状和边缘等。

特征提取可以使用传统的图像处理技术,如边缘检测、滤波和灰度变换等。

2.2 模式匹配模式匹配是图像识别算法的关键步骤,它通过将提取到的特征与预先定义的模式进行匹配,确定图像中是否存在目标物体。

常用的模式匹配算法包括相关性匹配、哈希算法和模板匹配等。

2.3 分类器训练分类器训练是图像识别算法的最后一步,它通过对已知图像进行学习,构建一个用于分类的模型。

常用的分类器包括支持向量机、人工神经网络和决策树等。

分类器的选择和训练过程会影响图像识别算法的性能和准确率。

3. 应用领域图像识别算法在许多领域都有广泛的应用。

以下是几个常见的应用领域:3.1 人脸识别人脸识别是图像识别算法在人脸图像中的应用,它可以用于身份验证、安全管理和监控等方面。

人脸识别算法通过提取人脸的特征点、纹理和形状等信息,来确定一个人的身份。

3.2 目标检测目标检测是图像识别算法在检测特定目标物体方面的应用。

它可以用于自动驾驶、智能监控和物体识别等场景。

目标检测算法通过识别图像中的目标物体并标记出来,从而实现对目标的定位和跟踪。

3.3 图像分类图像分类是图像识别算法在对图像进行分类方面的应用。

它可以用于图像搜索、智能图像分析和情感识别等领域。

图像分类算法通过将图像与训练好的分类器进行比对,将图像归类到预定义的类别中。

3.4 文字识别文字识别是图像识别算法在提取图像中的文字信息方面的应用。

它可以用于扫描文档、车牌识别和手写识别等场景。

文字识别算法通过提取图像中的文字特征,并将其转化为可编辑的文本信息。

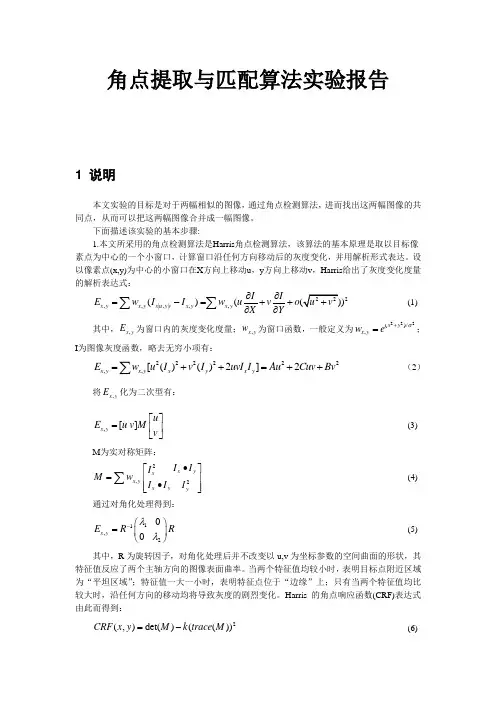

角点提取与匹配算法实验报告1 说明本文实验的目标是对于两幅相似的图像,通过角点检测算法,进而找出这两幅图像的共同点,从而可以把这两幅图像合并成一幅图像。

下面描述该实验的基本步骤:1.本文所采用的角点检测算法是Harris 角点检测算法,该算法的基本原理是取以目标像素点为中心的一个小窗口,计算窗口沿任何方向移动后的灰度变化,并用解析形式表达。

设以像素点(x,y)为中心的小窗口在X 方向上移动u ,y 方向上移动v ,Harris 给出了灰度变化度量的解析表达式:2,,|,|,,()(x y x y x u y v x y x y I I E w I I w uv o X Y∂∂=-=++∂∂∑∑ (1) 其中,,x y E 为窗口内的灰度变化度量;,x y w 为窗口函数,一般定义为222()/,x y x y w e σ+=;I 为图像灰度函数,略去无穷小项有:222222,,[()()2]2x y x y x y x y E w u I v I uvI I Au Cuv Bv =++=++∑(2)将,x y E 化为二次型有:,[]x yu E u v M v ⎡⎤=⎢⎥⎣⎦(3)M 为实对称矩阵:2,2x y x x y x y y I I I M w I I I •⎤⎡=⎥⎢•⎢⎥⎣⎦∑ (4)通过对角化处理得到:11,200x y E R R λλ-⎛⎫= ⎪⎝⎭(5)其中,R 为旋转因子,对角化处理后并不改变以u,v 为坐标参数的空间曲面的形状,其特征值反应了两个主轴方向的图像表面曲率。

当两个特征值均较小时,表明目标点附近区域为“平坦区域”;特征值一大一小时,表明特征点位于“边缘”上;只有当两个特征值均比较大时,沿任何方向的移动均将导致灰度的剧烈变化。

Harris 的角点响应函数(CRF)表达式由此而得到:2(,)det()(())CRF x y M k trace M =-(6)其中:det(M)表示矩阵M的行列式,trace(M)表示矩阵的迹。

特征点匹配算法概要特征点匹配是计算机视觉领域中的一项重要任务,其主要是为了在不同图像或视频帧中找到相互对应的特征点。

特征点是指在图像中明显可识别的局部区域,可以通过其在不同图像中的描述符来进行匹配。

在很多计算机视觉应用中,如图像拼接、目标跟踪、三维重建等,特征点匹配是必不可少的。

1.经典算法1.1尺度不变特征变换(SIFT)SIFT算法是一种基于局部特征的描述符,其通过尺度空间上的高斯差分函数检测图像中的关键点,并计算其旋转不变的特征向量。

SIFT算法具有尺度不变性和旋转不变性,可以在不同尺度和旋转角度下匹配特征点。

SIFT算法的主要流程包括尺度空间极值检测、关键点定位、方向分配和特征描述四个步骤。

1.2 加速稳健特征(Accelerated-robust features, SURF)SURF算法是对SIFT算法的改进,其通过积分图像和快速哈希技术实现了更快速的特征点检测和匹配。

SURF算法具有较好的尺度不变性和旋转不变性,并且可以在多尺度下进行特征点匹配。

1.3匹配追踪算法(OPTICALFLOW)匹配追踪是一类基于像素变化的特征点匹配算法,其通过计算图像中像素的运动向量来进行匹配。

典型的匹配追踪算法包括Lucas-Kanade光流算法和Horn-Schunck光流算法。

2.深度学习算法2.1 卷积神经网络(Convolutional Neural Network, CNN)卷积神经网络是一种深度学习算法,其通过卷积层、池化层和全连接层等结构来提取图像的特征。

在特征点匹配中,可以使用卷积神经网络来学习特征点的表示并进行匹配。

相比于传统算法,卷积神经网络可以自动学习图像的特征表示,具有更强的泛化能力。

2.2 微调网络(Fine-tuned network)微调网络是在预训练好的卷积神经网络模型上进行微调,以适应特定任务的需求。

在特征点匹配中,可以使用微调网络对图像进行特征提取,并使用其中一种距离度量方法(如欧氏距离、余弦相似度等)进行特征点的匹配。

csam测试原理CSAM(Content Scanning and Matching)测试原理指的是对互联网上的内容进行扫描和匹配的一种技术方法。

CSAM测试的目的是为了检测和阻止互联网上存在的儿童色情内容,以保护未成年人的权益和安全。

下面将详细介绍CSAM测试原理及其实现方式。

CSAM测试原理主要包括两个步骤:扫描和匹配。

首先,系统会对互联网上的内容进行扫描,这一过程类似于搜索引擎的爬虫机制,它会遍历互联网上的各个网页,并将其内容进行提取和分析。

扫描的内容包括文本、图像、视频等多种形式,其中最关键的是对图像和视频的处理。

在图像和视频的扫描过程中,系统会利用图像处理和分析算法,对每一帧图像进行特征提取和比对。

特征提取是指从图像中提取出具有代表性的特征,例如颜色、纹理、形状等。

而比对则是将提取出的特征与已知的儿童色情内容进行匹配,以确定是否存在潜在的违法内容。

对于图像和视频的匹配过程,系统通常采用哈希算法或深度学习技术。

哈希算法是一种将图像转化为唯一的数字指纹的方法,通过比对数字指纹来判断图像是否相似。

深度学习技术则利用神经网络对大量的儿童色情图像进行训练,从而提高匹配的准确性和效率。

除了图像和视频的扫描和匹配,CSAM测试还可以对文本内容进行分析。

系统会通过自然语言处理技术对文本进行关键词提取和语义分析,以确定是否存在儿童色情内容的线索。

关键词提取是指从文本中提取出具有特定意义的关键词,例如色情、儿童、禁止等。

而语义分析则是对关键词进行进一步的语境分析,以确定其是否与儿童色情内容相关联。

CSAM测试的实现方式可以是集中式或分布式的。

集中式的实现方式是指将扫描和匹配的任务集中在一个服务器端进行,通过云计算和大数据技术来实现高效的处理。

分布式的实现方式则是将任务分散到多个节点进行,每个节点负责一部分的内容扫描和匹配,通过分布式存储和计算来提高系统的可扩展性和性能。

需要注意的是,CSAM测试的目的是保护未成年人的权益和安全,因此在测试过程中需要遵守相关的法律法规和隐私保护的原则。

大规模图像检索中的特征提取与相似度匹配算法随着数字图像的广泛应用,如何高效地检索并匹配大规模图像数据成为了一个重要的问题。

在大规模图像检索中,特征提取和相似度匹配算法是两个关键的步骤。

特征提取主要是提取图像中的重要信息,将图像表示为多维向量;而相似度匹配则是根据特征向量进行图像之间的相似度计算。

本文将详细介绍大规模图像检索中的特征提取与相似度匹配算法。

一、特征提取算法特征提取算法旨在将图像中的信息转化为能够描述图像特征的向量。

常见的特征提取算法有SIFT、SURF、ORB等。

1. 尺度不变特征变换(SIFT)SIFT是一种广泛应用的特征提取算法,它通过局部不变性检测器在图像中寻找极值点,并基于这些极值点提取特征描述子。

SIFT具有尺度不变性和旋转不变性的特点,对于图像的旋转、平移、缩放、亮度变化等具有较好的鲁棒性。

2. 加速稳健特征(SURF)SURF是一种类似于SIFT的特征提取算法,它引入了一种快速测量算子,同时利用图像的积分图像来提高计算效率。

SURF算法具有较好的尺度不变性和旋转不变性,且相对于SIFT算法而言更快速。

3. 高效二进制描述符(ORB)ORB是一种基于FAST关键点检测器和BRIEF描述子的特征提取算法。

FAST关键点检测器能够快速地检测图像中的角点,而BRIEF描述子则通过比较像素对来生成二进制描述符。

ORB算法具有较高的计算速度和较好的鲁棒性。

二、相似度匹配算法相似度匹配算法用于计算特征向量之间的相似度以及找出与查询图像相似度最高的图像。

常见的相似度匹配算法有欧氏距离、余弦相似度、汉明距离等。

1. 欧氏距离欧氏距离是最常用的相似度度量方法之一,它的计算方式是计算两个向量之间的欧氏距离。

欧氏距离较小表示两个向量之间的相似度较高。

2. 余弦相似度余弦相似度是一种常用的向量相似度计算方法,它通过计算两个向量之间的夹角余弦值来评估它们之间的相似程度。

余弦相似度在图像检索中广泛应用,并且具有较好的性能。

图集去重最好的方法图集去重是指在一个图集中去掉重复的图片。

当我们在整理图片时,会发现有些图片可能会出现重复,占用不必要的存储空间。

图集去重的目的就是为了优化存储空间和提高效率。

下面我将介绍几种常见的图集去重方法。

1. 基于哈希算法的去重方法:这是一种常见的图集去重方法。

它的基本原理是通过计算图片的哈希值,将其作为图像的唯一标识。

当两个图片的哈希值相同时,它们被认为是相同的图片。

根据这个原理,我们可以遍历图集中的所有图片,计算其哈希值,并将其放入一个集合中。

如果集合中已经存在相同的哈希值,说明这是一张重复的图片,我们可以将其删除或标记。

这种方法的优点是效率高,速度快,适用于大规模的图集去重。

但是也存在缺点,就是可能会存在哈希冲突,即不同的图片计算出的哈希值相同,误判为重复图片的情况。

2. 基于相似度匹配的去重方法:这种方法的基本原理是通过比较图片之间的相似度来判断是否是重复图片。

常见的相似度匹配算法有均值哈希算法、感知哈希算法、结构相似度算法等。

通过计算图片之间的相似度,我们可以设置一个阈值,当两张图片的相似度超过阈值时,认为它们是重复图片。

这种方法的优点是精度较高,可以识别出相似度较高的图片,并进行去重。

但是也存在缺点,就是该方法计算量较大,需要遍历图集中的所有图片进行相似度计算。

3. 基于特征提取的去重方法:这种方法的基本原理是通过提取图片的特征来判断是否是重复图片。

常见的特征提取算法有局部二值模式(LBP)、灰度共生矩阵(GLCM)、尺度不变特征变换(SIFT)等。

我们可以通过将特征向量进行比较,来判断图片是否是重复图片。

这种方法的优点是可以提取出图片的特征信息,并进行比较判断,适用于不同风格和尺度的图片。

但是也存在缺点,就是特征提取的过程可能会存在一定的误差,造成误判或漏判。

以上是几种常见的图集去重方法。

选择何种方法取决于具体的应用场景和需求。

如果对于去重的准确性要求较高,可以采用基于相似度匹配或特征提取的方法;如果对准确性要求不是特别高,但对处理速度有要求,可以选择基于哈希算法的方法。

感知哈希算法感知哈希算法(PerceptualHashing,简称PHash)是一种用于检测非结构化数据(如图像、视频、音频)相似性的技术。

PHash具有抗硬件失真(如调整图像大小或者位深度,调整播放速度等)、抗加密、快速运算等优点,目前已经在多个领域应用。

PHash的原理是利用频谱特征来描述一个图像,然后用一定的数学方法计算出一个哈希码(Hash String),以此来表示这个图像的特征。

例如,如果一张图片的频谱特征有一定的变化,它的Hash String 也会发生变化。

因此,PHash可以用于判断两张图片的相似度,具体流程是:1.算图像的频谱特征,如傅里叶变换、低频滤波等;2.过某种数学方式,把频谱特征编码成一组字符串,也就是 Hash string;3.过比较两个图像的 Hash string计算它们的相似度。

由于PHash具有优秀的抗加密性,通过简单操作(如调整图像大小或者位深度,调整播放速度等)并不会改变图像本身的特征,因此,PHash可以用于发现抗加密图像。

例如,复制加密图像和原始图像的Hash String可能不一样,但它们之间的相似度还是可以计算出来的,因此,PHash可以用来发现受到加密影响的图片。

此外,PHash还可以应用在音频和视频中,其基本思路是在处理过程中,将音视频文件转换成图片,然后对图片应用PHash算法,最后计算出音视频文件之间的相似度。

总之,感知哈希算法是一种非常成熟且有效的技术,它可以用来检测非结构化数据的相似性,具有抗硬件失真、抗加密、快速运算等优点。

除此之外,在安全领域,PHash还可以用于发现受到加密影响的图片。

未来,随着算法的进一步研发与完善,PHash将会发挥更大的作用,为社会的信息安全做出更大的贡献。

如何应用计算机视觉技术进行图像检索和相似度匹配随着计算机技术和人工智能的发展,计算机视觉技术变得越来越成熟和普及。

其中,图像检索和相似度匹配是计算机视觉技术中的重要应用之一。

本文将介绍如何应用计算机视觉技术进行图像检索和相似度匹配。

首先,让我们了解一下图像检索的概念。

图像检索是指通过计算机视觉技术,根据用户给定的查询图像,从大规模的图像数据库中检索出与之相似的图像。

图像检索技术的应用非常广泛,比如商品搜索、人脸识别、文物鉴定等。

要实现图像检索,首先需要建立一个图像数据库。

这个数据库可以是存储在计算机中的图像文件集合,也可以是通过网络抓取的图像数据。

然后,需要对这些图像进行特征提取。

常用的特征包括颜色、纹理、形状等。

特征提取的目的是将图像转化为计算机能够理解和处理的数据形式。

接着,对于待查询的图像,也进行相同的特征提取操作。

通过比较查询图像和数据库中图像的特征,即可得到相似度评分。

最后,根据相似度评分对图像进行排序,返回与查询图像最相似的图像结果。

在相似度匹配中,可以采用多种方法来计算相似度评分。

最简单的方法是计算特征之间的欧氏距离或余弦相似度。

此外,还可以使用更复杂的算法,如支持向量机(SVM)、卷积神经网络(CNN)等。

这些算法不仅考虑了特征之间的距离,还能够学习到更高层次的图像特征表示,提高了匹配的准确性。

为了提高图像检索的效果,还可以通过以下几种方法进行优化。

首先,可以采用多尺度的特征提取方法,即在不同尺度下提取图像特征。

这样可以使得算法更加不受图像尺寸变化的影响,提高匹配的鲁棒性。

其次,可以引入语义信息,将图像特征和图像语义关联起来。

例如,可以使用深度学习算法学习到的图像表示,同时利用文本信息来提升匹配的准确性。

此外,对于大规模数据库的图像检索,还可以采用快速搜索算法,如局部敏感哈希(LSH)等。

除了图像检索,计算机视觉技术还可以应用于图像相似度匹配。

图像相似度匹配是指根据两张图像的相似度评分,判断它们是否表示同一对象或相似的对象。

一种图像局部特征快速匹配算法

张格森;陈东生;王怀野;陆振林

【期刊名称】《电子技术应用》

【年(卷),期】2015(41)11

【摘要】在图像处理和机器视觉领域,SIFT是目前被广泛应用的一种基于局部特征的图像匹配算法.针对SIFT算法匹配速度较慢和常常存在错误匹配对的问题,本文提出在匹配过程中采用角度相似性分析替代传统的欧式距离分析法,由此提高匹配速度,然后通过RANSAC一致性筛选删除错误匹配对,最后通过实验验证了新算法的有效性.新算法结构清晰,计算简便,易于硬件实现.

【总页数】4页(P124-127)

【作者】张格森;陈东生;王怀野;陆振林

【作者单位】北京航天微系统研究所,北京100094;中国航天时代电子公司博士后科研工作站,北京100094;北京航天微系统研究所,北京100094;北京航天微系统研究所,北京100094;中国航天时代电子公司博士后科研工作站,北京100094

【正文语种】中文

【中图分类】TP391.4

【相关文献】

1.一种高效的图像局部特征匹配算法 [J], 杨恒;王庆

2.一种基于遗传算法的快速景象匹配算法 [J], 李钊;李建军;董巍巍;韦关潮

3.一种新的结合遗传算法的快速变形模板匹配算法 [J], 金晟毅;王庆

4.一种利用遗传算法的快速匹配算法 [J], 侯格贤

5.一种基于图像局部特征的检测与匹配算法研究 [J], 冯谦

因版权原因,仅展示原文概要,查看原文内容请购买。

图像相似度计算范文图像相似度计算是指通过比较两幅图像的内容和结构,来判断它们之间的相似程度。

在计算机视觉和图像处理领域中,图像相似度计算广泛应用于图像检索、图像分类、图像匹配等任务中。

下面将介绍常见的图像相似度计算方法。

1.基于颜色直方图的相似度计算方法:颜色直方图是一种统计图像中各个颜色频次的方法,通过比较两幅图像的颜色直方图,可以得到它们之间的相似程度。

常见的方法有:直方图相似度(Histogram Similarity)、归一化直方图相似度(Normalized Histogram Similarity)等。

这些方法通常考虑了颜色的相对顺序和分层关系。

2.基于感知哈希的相似度计算方法:感知哈希是一种通过计算图像的哈希值来表示图像内容的方法。

在感知哈希方法中,首先将图像转换为灰度图像,然后计算图像的平均值,将每个像素与平均值进行比较,将大于平均值的像素设置为1,小于平均值的像素设置为0,最后将得到的序列转换为哈希值。

通过比较两幅图像的哈希值,可以得到它们之间的相似程度。

3.基于结构相似性的相似度计算方法:结构相似性是一种通过比较图像的亮度、对比度和结构来计算相似度的方法。

结构相似性算法首先通过高斯滤波对图像进行平滑处理,然后在每个像素点周围选择一个窗口,计算窗口内的亮度、对比度和结构相似性指数。

最后将所有像素点的相似性指数综合起来,得到图像的结构相似性。

结构相似性方法考虑了图像中的全局信息和局部信息,对图像中的改变具有一定的鲁棒性。

4.基于深度学习的相似度计算方法:近年来,随着深度学习的发展,在图像相似度计算中也得到了广泛应用。

深度学习方法通常通过训练一个神经网络来学习图像的表示,然后通过计算两幅图像在学习到的表示空间中的距离来计算它们的相似度。

常见的方法有:卷积神经网络(CNN)、循环神经网络(RNN)等。

深度学习方法在图像相似度计算中取得了很好的效果,能够对图像进行更加准确和细致的比较。

ORB特征点检测匹配算法ORB(Oriented FAST and Rotated BRIEF)是一种基于特征点的检测和描述算法,它结合了FAST角点检测器和BRIEF描述子生成器的优点,具有快速、高效和鲁棒性等优点。

ORB特征点检测匹配算法在计算机视觉领域得到了广泛应用,可以用于图像配准、物体识别、SLAM等各种应用场景中。

1.检测算法ORB特征点的检测算法主要由两个部分组成:FAST角点检测器和Harris角点响应检测器。

FAST角点检测器是一种高效的角点检测算法,可以用来寻找图像中的角点。

Harris角点响应检测器则是一种基于灰度梯度的角点检测算法,可以用来确定角点的强度和位置。

在ORB特征点检测算法中,首先使用FAST角点检测器对图像进行角点检测,然后在检测到的角点周围使用Harris角点响应检测器来确定最终的特征点位置。

通过这种组合方式,可以同时实现高效和鲁棒的角点检测,提高特征点检测的准确性和稳定性。

2.描述算法ORB特征点的描述算法主要由两个部分组成:BRIEF特征描述子生成器和ORB特征描述子。

BRIEF是一种二进制描述子生成算法,可以将每个特征点周围的像素值转换为一个二进制串。

ORB特征描述子是在BRIEF基础上进行改进的一种特征描述子,可以提高描述子的稳定性和鲁棒性。

在ORB特征点描述算法中,首先使用BRIEF特征描述子生成器对检测到的特征点进行二进制描述,然后通过ORB特征描述子将二进制描述子进行优化和加权,提高描述子的区分度和准确性。

通过这种方式,可以快速生成高质量的特征描述子,用于后续的特征匹配和识别过程。

3.匹配算法ORB特征点匹配算法主要通过计算两幅图像中的特征点之间的相似性来进行匹配。

在匹配过程中,通常采用汉明距离或欧氏距离等指标来度量特征点之间的相似性,找到最匹配的特征点对。

通过匹配算法,可以实现图像的配准、物体的识别和SLAM等应用。

总的来说,ORB特征点检测匹配算法是一种高效、鲁棒的特征点检测和描述算法,具有快速计算速度、高准确性和广泛应用等优点,适用于各种计算机视觉应用领域。

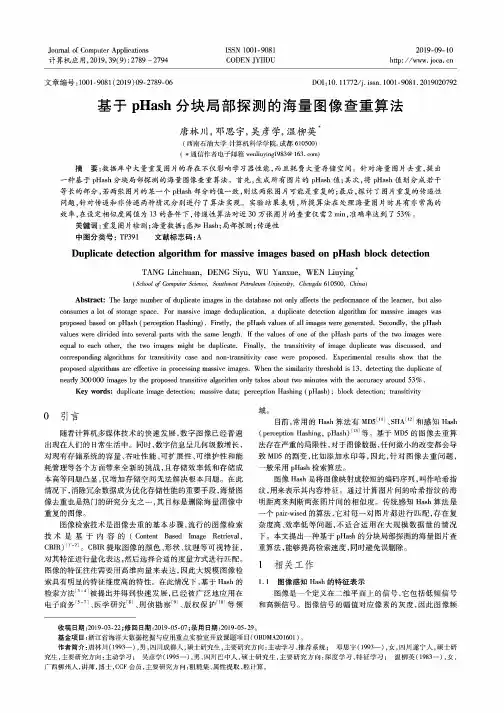

第19卷第3期重庆科技学院学报(自然科学版)2017年6月哈希快速图像匹配算法研究王拓于徐红刘志杰(贵州师范大学贵州省信息与计算科学重点实验室,贵阳550025)摘要:如何快速有效地在大量数据中将图片筛选匹配出来,是图像匹配技术研究的重点课题之一。

通过分析感知哈希算法及Smf 算法各自的优点,提出用感知哈希算法进行初步图片搜索,利用Smf 算法提取相似图片局部特征,从而更精准地确定最相似图片,增加图片匹配的鲁棒性。

实验结果表明,在对图片进行处理后,哈希快速图像匹配算法仍能快速地从本地图片库中将最相似图片搜索出来。

关键词:感知哈希算法;DCT 变换;Smf 算法;指纹数据 中图分类号:TP 391.41文献标识码:A近年来,随着计算机、手机等电子产品的不断发 展和普及,图片已成为我们记录生活的一种重要方 式。

据Facebook 官方公布,现在每天上传的图片数 量约20亿张,并且这个数字还在不断增加。

同时, 人们也不再仅仅局限于使用文字来搜索图片,“以 图搜图”在这种情况下应运而生。

目前应用“以图 搜图”的主要是互联网图像搜索引擎网站,例如 Google 、百度、搜狗、Picitup 、Bing 、TinEye 、Incogno 等。

大部分人的手机、电脑或其他存储设备里面也有成 千上万张图片,如何在自己的图片库里快速找出想 要查看的图片也是一个急需解决的问题。

因此,如 何将大量的图片进行数据处理与存储已成为大数据 时代面临和必须解决的一个重要难题[1]。

目前,对图片进行特征提取应用最多的还是在 Sift 算法基础上,先对图像进行特征提取,然后根据 提取特征对图像进行哈希编码,生成这个图像的 “指纹”特征。

Sift 算法的优点是对图像的旋转、变 换等都有很好的鲁棒性,缺点是复杂度比较高。

此次研究基于Sift 算法的改进算法---Surf 算法,并基于哈希编码规则来提升图片的搜索比对速度[3 _4]。

1算法描述1.1感知哈希算法哈希算法是一种将图片生成一组“指纹”数据文章编号:1673 -1980(2017)03 -0075 -04的方法。

在进行图片搜索比对时,首先对图片进行 特征信息提取,并生成一组二维数组即图片指纹。

通过对目标图像进行处理得到“指纹”后,将其与哈 希图像库中的图片直接进行“指纹”比对。

相对于 其他形式的特征值对比,二维数组有更高的时效性 优点。

感知哈希算法(perceptual hash algorithm ,简写 为pHash )。

其流程图见图1 〇图1感知哈希算法流程图pHash 对一幅图片的处理过程如下:(1) 缩小尺寸。

pHash 将图片缩小成7V * 7V 。

这样做的目的是简化了 DCT 的计算,去除各种图片尺寸和图片比例的差异,只保留结构、明暗等基本 信息。

一般情况下,的值设置为32。

(2)简化色彩。

将图片转化成灰度图像,进一 步简化计算量。

(3)计算平均灰度。

计算图片中所有像素的灰度平均值。

(4) 计算平均值。

如同均值哈希算法一样,计收稿日期=2016-11 -29基金项目:贵州省科学技术基金项目“基于Nutch 的单位内部网络智能搜索引擎研究”(黔科合J 字LKS [2009]17号);贵州省经济和信息化委员会资助项目“大规模点模型的并行化真实感实时渲染技术研究”(1158号);贵州省科技厅攻关 项目“海龙囤申报世界文化遗产关键性技术研究”(黔科合SY 字LKS [2014]3072号)作者简介:王拓(1991 一),男,贵州师范大学在读硕士研究生,研究方向为图形图像处理。

•75 •王拓,等:哈希快速图像匹配算法研究算DCT的均值。

(5)计算hash值。

这是最主要的一步,根据 DCT变换得到的32 * 32矩阵中,因为绝大部分信息包含在左上角8 *8的系数子矩阵中,并且为了简化 计算,在计算时只取其左上角8 * 8的系数子矩阵,然后将其设置成〇或1的64位的hash值,大于等 于DCT均值的设为“1”,小于DCT均值的设为“0”。

组合在一起,就构成了一个64位的整数,即为这张 图片的指纹。

本算法中,根据矩阵中8 * 8的系数子矩阵得出 二维离散余弦变换(DCT):G a,v= (-v)X■外%=0y =0M•為 0,4> < W时,0:(■!•〇 = 0:(«•)式中:g—w w图像像素点;G—W矩阵中阈矩阵;a—余弦系数矩阵。

对一张图片进行DCT变换后,便可将其像素信 息以矩阵形式输出。

若代表矩阵形式,式(1)可简化为:F(u,v)= Af(x,y)AI在利用PHaS h算法生成图片指纹后,就可比对 不同图片的指纹来确定出最相似图片。

首先要计算 出8 * 8矩阵中图片信息生成的64位中有多少位是 不一样的。

如果不相同的数据位数不超过5,就说 明两张图片很相似,如果超过10,说明它们是两张 不同的图片[5]。

感知哈希算法在处理大量图片时的时效性很 高,然而该算法针对的是图片的整体特征,不能对局 部特征进行提取和细致的识别,这就需要在局部特 征提取方面来加强算法的鲁棒性。

1.2 Surf算法1999年,David Lowe提出尺度不变特征变换(scale- invariant feature transform,简写为 Sift), Sift算法有以下特点:(1)尺度不变特征检测;(2)特征匹配和索引;(3)独特性好,信息量丰富;(4)高速性;(5)可扩展性。

利用Sift算法进行图片特征提取,可很好地避 免光照强度变化、目标遮挡及其他因素干扰对图片特征的影响。

但由于其计算复杂度较高,因此,研究 选取Surf算法代替Sift算法来提取图片特征[6]。

Surf算法是Sift算法的一个提升,其借鉴了 Sift 算法中简化近似的思想,将D〇H中的高斯二阶微分 方程模板进行了简化,使得模板对图像的滤波只需 要进行几个简单的加减法运算。

在对一幅图片进行特征提取时,Surf算法借助 积分图像原理,首先将目标图像通过高斯二阶微分 模板滤波,然后转化为对积分图像的加减运算。

因为图像由若干个像素点构成的,因此,若假设以左上 角为原点构建像素坐标系,对于图像中的任意一个 点(/,0,其值假设为以/j)表示为原图像左上角到 点(J'j)相应的对角线区域灰度值的总和,即为:r矣i,c矣j式中:jP(r,C)—图像中点(r,C)的灰度值。

接下来构建Hessian矩阵,并将提取的灰度信息 生成所有兴趣点,用于特征的提取。

其Hessian矩阵 如下:I f d2fdx2dxdyd'f I fdxdy dy1式中:/(、7)—图像函数。

为了找出当前关键位置点,要将图像/(X,y)经 过高斯滤波,对图像信息进行提取。

其HeSSian矩阵 为:H(x,cr)-L x x(x,(t) LX J(x,a)■Lxy(x,cr) Lyy(x,cr)图像信息在经过高斯滤波以后,假设i(X,0表 示在不同解析度下的一幅图像,可利用高斯核G(0 与图像函数/(x)在点x处的卷积来实现,其卷积计 算公式如下:L(x,t)= G(t)其中局斯核G⑴为:G⑴=赞dx式中:g(o—高斯函数;t—高斯方差。

为平衡准确值与近似值间的误差,引入权值。

权值随尺度变化,则w矩阵判别式可表示为:det(//appr0I) = DxxDyy -(0. 9D xy)2通过Hessian矩阵可以找出当前比周围其他更 亮或者更暗的关键位置点,也就是特征提取[7_8]。

• 76 •王拓,等:哈希快速图像匹配算法研究2哈希快速图像匹配算法设计哈希快速图像匹配算法是利用感知哈希算法复杂度低的优点,并结合Surf 算法对局部特征及噪声 的敏感性好等优点设计出的一种新算法,旨在提高 图片搜索速度的基础上,保证检索出的图片的鲁棒 性。

该算法步骤如下:(1) 归一化处理:首先将原始图像进行不同角 度的旋转以及不同比例缩放后,生成相同的8 * 8 尺寸。

(2) 对生成的图片进行DCT 变换,通过设定阈 值将矩阵生成64位的一维向量。

(3)根据生成的初步指纹,利用Hamming 距离方法,标记系列近相似图片,(4) 利用Smf 算法对标记的近相似图片进行特 征提取,利用Hamming 距离作为相似度度量,找出 最近似的图片[^11]。

3实验结果分析在对图像进行分析前,首先对图像的色彩进行 提取,找出色彩分布区域0图2为目标图像的颜色 分布图。

然后利用DCT 算法对图片进行整理,得出 感知哈希序列指纹。

图2目标图像的颜色分布图目标图像颜色直方图见图首先对图片进行 分析,得出其颜色分布区域,然后根据颜色分布进行DCT 变换,并根据图像信息设定阈值,通过对阈值 的比较生成8 * 8矩阵,并将其变换成一维64位数 组,并将指纹数据以文本格式存放在本地文件中Q 经过感知哈希算法处理后,便可通过第一次粗 筛选。

在此基础上,利用Surf 算法对筛选出的图像 信息进行二次比较,并利用特征点选取的方法进行 二次筛选。

利用Smf 算法对图片进行特征提取示意图见图4。

利用Surf 算法,右面被马赛克处理过的 图片也被找出特征相似点,从而在本地文件中找出最相似图片Q 局部特征点的提取示意图见图5。

尽 管图像被其他软件处理,该算法亦能通过排除干扰 找出最相似图片[12]。

24022020018016014012010080604020图3目标图像颜色直方图图4利用S u r f 算法对图片进行特征提取图5局部特征点提取示意图通过上述比较可知,此次研究中提出的感知哈希算法和Surf 结合算法的时效性与文献[11 ]中提出的算法不相上下,唯一不足的就是在利用Surf 算法时,由f 要提高算法的速度,从而需减少匹配点数 M 。

另外,本算法在利用双重定位方法的基础上,延续了尺度不变的特性,对于图像的翻转变换、明暗等 变化都有良好的抗噪声效果,并能够将其准确匹配搜索出。

4结语哈希快速图像匹配算法使用VS2013对图像进行处理编程,在对图像进行处理及编码指纹提取方 面有了很大的改进,提高了速度,并且摒弃了哈希算•77•王拓,等:哈希快速图像匹配算法研究法对局部不敏感等缺点,利用由粗到细的图像检索 方法,实现图片快速准确的匹配。

通过大量实验表 明,该算法比利用Sift算法速度更快,并且能够保证 图片的对比精度,快速准确地找到所需图片。

参考文献[1] YANG B,GU F,NIU X.Block Mean Value Based ImagePerceptual Hashing [C]//Proc of IEEE International Conference on IIH - A:IEEE,2006:167 -172.[2] XIANG S,KIM H J,HUANG J.Histogram- based ImageHashing Scheme Robust Against Geometric Deformations[C]//Proc of the 9th ACM Workshop on Multimedia andA:ACM,2007:121 -128.[3]孙锐,闫晓星,高隽.基于SIFT和PCA的图像感知哈希方法[J].电路与系统学报,2013,18(1) : 274 -278. [4]杜京义,胡益民,刘宇程.基于区域分块的SIFT图像匹配技术研究与实现[J].光电工程,2013,40(8) :52-58.[5] MONGA V,EVANS B L.Robust Perceptual Image Hashing Using Feature Point [C]//Proceedings of IEEE International Conference on Image Processing(ICIP).Singapore:IEEE,2004:677 -680.[6]赵璐璐,耿国华,李康,等.基于SURF和快速近似最近邻搜索的图像匹配算法[J].计算机应用研究,2013,30(3) : 921 -923.[7] BAY H,TUYTEPLAARS T,VAN G L.Speeded - up Robust Features(SURF) [J]. Computer Vision and ImageUnderstanding,2008,110(3 ) :346 -359.[8] ZAUNER C.Implementation and Benchmarking of Perceptual Image Hash Functions[D].Upper Austria:UpperAustria University, 2010.[9] MATTHEW B,DAVID L.Invariant Features from InterestPoint Groups[C].Cardiff:British Machine Vision Conference, 2002(23) :1 -10.[10] 王阿川,陈海涛.基于离散余弦变换的鲁棒感知图像哈希技术[J].中国安全科学学报,2009,19(4): 91-96.[11] 邱丽君,唐加山.一种快速的两步骤图像匹配新算法[J].计算机技术与发展,2015,25(8) : 67 -70.[12] ANGELIS A D,MOSCHITTA A,RUSSO F,et al.ImageQuality Assessment:An Overview and Some MetrologicalConsiderations[C]//International Workshop on AdvancedMethods for Uncertainty Estimation in Measurement.Trento:IEEE,2007 :47 -52.Fast Image Matching Algorithm Base on HashWANG Tuo YU Xuhong LIU Zhijie(Key Laboratory of Information and Computing Science of Guizhou Province,Guizhou Normal University, Guiyang 550025, China)Abstract; Nowadays, data and image update each minute. How to match the image quickly and effectively is the key issue in image matching technology and research. By analyzing the merits of the perceptual hash algorithm and Surf algorithm, this paper proposes a preliminary image search using the perceptual hash algorithm, and then uses Surf algorithm to extract the local characteristics of similar images to determine the most similar images more accurately and increase the robustness for image matching. Experimental results show, when the image is processed, the Hash Fast Image Matching algorithm can still quickly search the most similar images from the local gallery. Key words: perceptual Hash Algorithm ;DCT transform ;Surf Algorithm ;fingerprint Data• 78 •。