中文分词词典构造简述

- 格式:doc

- 大小:14.68 KB

- 文档页数:6

中文分词相关技术简介目前对汉语分词方法的研究主要有三个方面:基于规则的分词方法、基于统计的分词方法和基于理解的分词方法。

基于规则的分词方法基于规则的分词方法,这种方法又叫做机械分词方法,它是按照一定的策略将待分析的汉字串与一个"充分大的"机器词典中的词条进行匹配,若在词典中找到某个字符串,则匹配成功(识别出一个词)。

常用的方法:最小匹配算法(Minimum Matching),正向(逆向)最大匹配法(Maximum Matching),逐字匹配算法,神经网络法、联想一回溯法,基于N-最短路径分词算法,以及可以相互组合,例如,可以将正向最大匹配方法和逆向最大匹配方法结合起来构成双向匹配法等。

目前机械式分词占主流地位的是正向最大匹配法和逆向最大匹配法。

◆最小匹配算法在所有的分词算法中,最早研究的是最小匹配算法(Minimum Matching),该算法从待比较字符串左边开始比较,先取前两个字符组成的字段与词典中的词进行比较,如果词典中有该词,则分出此词,继续从第三个字符开始取两个字符组成的字段进行比较,如果没有匹配到,则取前3个字符串组成的字段进行比较,依次类推,直到取的字符串的长度等于预先设定的阈值,如果还没有匹配成功,则从待处理字串的第二个字符开始比较,如此循环。

例如,"如果还没有匹配成功",取出左边两个字组成的字段与词典进行比较,分出"如果";再从"还"开始,取"还没",字典中没有此词,继续取"还没有",依次取到字段"还没有匹配"(假设阈值为5),然后从"没"开始,取"没有",如此循环直到字符串末尾为止。

这种方法的优点是速度快,但是准确率却不是很高,比如待处理字符串为"中华人民共和国",此匹配算法分出的结果为:中华、人民、共和国,因此该方法基本上已经不被采用。

简述中文分词算法的种类和基本原理下载提示:该文档是本店铺精心编制而成的,希望大家下载后,能够帮助大家解决实际问题。

文档下载后可定制修改,请根据实际需要进行调整和使用,谢谢!本店铺为大家提供各种类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by this editor. I hope that after you download it, it can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you! In addition, this shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!探索中文分词算法的种类与基本原理1. 导言中文分词是自然语言处理中的基础任务之一,其目的是将连续的中文文本切分成有意义的词语单位。

中⽂分词算法综述 英⽂⽂本词与词之间以空格分隔,⽅便计算机识别,但是中⽂以字为单位,句⼦所有字连起来才能表达⼀个完整的意思。

如英⽂“I am writing a blog”,英⽂词与词之间有空格进⾏隔开,⽽对应的中⽂“我在写博客”,所有的词连在⼀起,计算机能很容易的识别“blog”是⼀个单词,⽽很难知道“博”、“客”是⼀个词,因此对中⽂⽂本序列进⾏切分的过程称为“分词”。

中⽂分词算法是⾃然语⾔处理的基础,常⽤于搜索引擎、⼴告、推荐、问答等系统中。

⼀、分词的算法 中⽂分词算法属于⾃然语⾔处理范畴,对于⼀句话,⼈类可以通过⾃⼰的经验知识知道哪些字组成⼀个词,哪些字⼜是独⽴的,但是如何让计算机理解这些信息并作出正确处理的过程叫做分词,中⽂分词算法分成三⼤类:⼀、基于词典的分词算法,⼆、基于机器学习的分词算法,三、基于神经⽹络的分词算法。

1、基于词典的分词算法 基于词典的分词算法⼜称为机械分词,它是按照⼀定的策略将待分词的⽂本切分成⼀个个⼩⽚段在已知的词典中进⾏查找,如果某字符串能在词典中找到,则匹配成功,这种分词思想简单、⾼效,在实际分词系统中很常⽤。

1.1 字符串匹配算法 字符串匹配算法按照其扫描⽅向的不同分成正向匹配和逆向匹配,按照其匹配长度的不同可以分成最⼤匹配和最⼩匹配。

由于中⽂“单字成词”的特点,很少利⽤到最⼩匹配来作为字符串匹配算法。

⼀般来说,正向匹配分词算法的准确度略低于逆向匹配算法,据统计单纯使⽤正向最⼤匹配算法的错误率为1/169,⽽单纯使⽤逆向最⼤匹配算法的错误率为1/245。

即使如此,单纯的字符串匹配算法也不能满⾜系统的要求,通常需要利⽤这种算法对⽂本进⾏粗分,在此基础上结合其他的⽅法⼀起使⽤,提⾼系统分词的准确率。

以逆向最⼤匹配为例,⾸先从待分词的⽂本中选取最后m(字典中词条的最⼤长度)个字,如果能在词典匹配到,则将匹配的词切分出来,并以未切分的⽂本中重新选取m个字进⾏匹配,如果没有在词典中匹配到,则去掉最后⼀个字,对m-1个字在字典中进⾏匹配,反复上述操作,直到选取的字组能在词典中匹配到为⽌,待匹配的所有字都在切分完成,就得到该⽂本的分词结果。

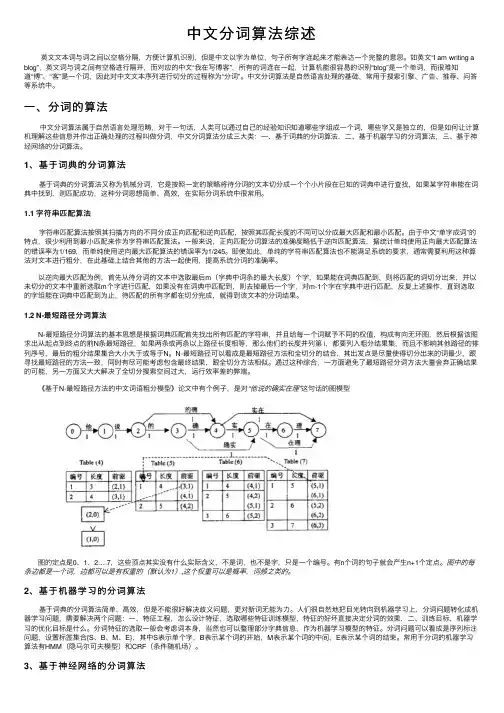

中文分词原理中文分词是指将一个汉字序列切分成一个个具有语言意义的词语的过程,是中文信息处理的基础工作之一。

在计算机领域中,中文分词是自然语言处理的重要环节,对于搜索引擎、信息检索、文本挖掘等应用具有重要意义。

本文将介绍中文分词的原理及相关内容。

首先,中文分词的原理是基于词语的语言学特征来进行切分。

中文词语之间并没有像英文那样的明显分隔符号,因此要进行中文分词就需要依靠词语的语言学特征来进行判断。

中文词语通常由一个或多个汉字组成,而且词语之间具有一定的语义关联,因此可以通过词语的语言学特征来进行切分。

其次,中文分词的原理还涉及到词语的频率统计和语境分析。

在进行中文分词时,需要利用大量的语料库来进行词语的频率统计,以确定词语的常见组合和概率。

同时,还需要进行语境分析,即根据词语在句子或文章中的上下文来确定词语的边界,以保证切分结果的准确性。

另外,中文分词的原理还包括了一些特定的算法和模型。

目前常用的中文分词算法包括基于词典的最大匹配法、逆向最大匹配法、双向最大匹配法等。

此外,还有基于统计模型的中文分词方法,如隐马尔可夫模型(HMM)、条件随机场(CRF)等。

这些算法和模型都是基于中文词语的语言学特征和频率统计来进行切分的。

总的来说,中文分词的原理是基于词语的语言学特征、频率统计和语境分析来进行切分的。

通过对词语的特征和语境进行分析,结合相应的算法和模型,可以实现对中文文本的准确切分。

中文分词的准确性对于中文信息处理具有重要意义,因此对于中文分词原理的深入理解和研究具有重要意义。

总结一下,中文分词原理是基于词语的语言学特征、频率统计和语境分析来进行切分的,通过相应的算法和模型实现对中文文本的准确切分。

中文分词对于中文信息处理具有重要意义,对其原理的深入理解和研究对于提高中文信息处理的效率和准确性具有重要意义。

中文分词的原理

中文分词是自然语言处理中的一个重要任务,其主要目的是将连续的中文文本划分成有意义的词语序列。

与英文不同,中文中的词语之间没有明显的间隔符号,因此,中文分词是一个相对复杂的问题。

中文分词的原理可以简单概括为基于词典的匹配和基于统计的方法。

基于词典的匹配是指通过一个词典来判断一个文本中的词语是否存在。

词典中包含了大量的中文词语,每个词语都有一个对应的词典项。

在分词过程中,系统会逐个扫描文本,并从词典中查找匹配项。

如果找到了匹配项,那么将这个词语划分出来;如果没有找到匹配项,那么就需要进行其他的处理方式。

基于词典的匹配方法可以保证分词的准确性,但是其覆盖范围有限,无法完全覆盖所有的词语。

基于统计的方法则是通过建立一个模型来预测一个文本中哪些位置可能是词语的分界点。

这个模型是通过大量的语料库训练得到的,其中包含了许多已经切好词的文本。

在分词过程中,系统会利用这个模型计算每个位置的分词概率,并选择概率最大的位置作为分界点。

基于统计的方法可以扩大分词的覆盖范围,但是可能会导致一些错误的切分结果。

在实际应用中,中文分词通常会将基于词典的匹配方法和基于统计的方法结合起来。

首先,通过基于词典的匹配方法,划分出词典中包含的词语;然后,利用基于统计的方法,对剩余的文本进行分词。

这种结合的方法可以兼顾准确性和覆盖范围,提高中文分词的效果。

总之,中文分词是中文自然语言处理中的重要任务。

它的原理包括基于词典的匹配和基于统计的方法。

通过合理地结合这两种方法,可以提高中文分词的准确性和覆盖范围,从而更好地满足人们对中文文本处理的需求。

中文词汇构成手册(完美梳理)中文词汇构成手册(完美梳理)引言中文词汇构成手册旨在为中文学习者提供一份全面的词汇构成指南,涵盖了中文词汇的构成规律和特点。

本手册内容丰富,结构清晰,通过系统地梳理和分析中文词汇的构成,帮助学习者更好地理解和掌握中文词汇的构成规律,提高中文运用能力。

中文词汇构成概述中文词汇主要由汉字组成,每个汉字都有其独特的读音、意义和书写形式。

中文词汇的构成主要通过以下几种方式:1. 单一汉字:即单个汉字独立构成的词汇,如“人”、“山”、“水”等。

2. 复合词汇:由两个或更多个汉字组合而成的词汇,如“学校”、“手机”、“电视”等。

3. 派生词汇:通过在词根前后加上前缀或后缀来构成的词汇,如“好”、“高兴”、“快乐”等。

4. 词组:由两个或更多个词汇组合而成,具有一定的意义,如“桌子”、“学校”、“电影”等。

汉字构成规律1. 拼音:汉字的读音由声母、韵母和声调组成。

声母表示汉字的初始音,韵母表示汉字的尾音,声调表示汉字的音高。

2. 部首:汉字的部首是汉字构成的重要部分,部首的存在有助于汉字的归类和记忆。

大部分汉字都包含一个或多个部首。

3. 笔画:汉字的笔画是构成汉字的基本元素,包括横、竖、撇、捺、折等。

汉字的笔画数不同,其形态和意义也有所区别。

4. 结构:汉字的结构是指汉字的书写顺序和布局。

常见的汉字结构有左右结构、上下结构、包围结构等。

词汇构成特点1. 语音特点:中文词汇的语音特点主要体现在声调和韵母上,不同的声调和韵母组合产生不同的意义。

2. 语法特点:中文词汇的语法特点主要体现在词汇的组合和变化上,如词组的构成、派生词汇的生成等。

3. 语义特点:中文词汇的语义特点主要体现在词汇的内涵和外延上,同一个汉字在不同的词汇中可能具有不同的意义。

4. 文化特点:中文词汇的文化特点主要体现在词汇的来源和寓意上,很多词汇都蕴含着丰富的文化内涵。

学习建议1. 掌握汉字的基本读音、书写和部首,为词汇学习打下基础。

词典分词法词典分词法,又称为机械分词法或基于词典的分词方法,是中文信息处理中的一种基本技术。

这种方法主要依赖于一部预先准备好的词典,通过一定的匹配规则将待处理的文本切分成独立的单词。

下面详细介绍词典分词法的主要内容和特点:1.词典准备:词典分词法的第一步是准备一部词典。

这部词典包含了大量预先定义好的词汇,每个词汇都作为一个独立的单元存储在词典中。

词典的质量对分词效果有着至关重要的影响,因此通常需要花费大量时间和精力来构建和维护词典。

2.匹配规则:在词典准备好之后,接下来需要定义一套匹配规则。

这些规则决定了如何将待处理的文本与词典中的词汇进行匹配。

常见的匹配规则包括正向最大匹配、逆向最大匹配、双向最大匹配以及最少切分等。

这些规则各有优缺点,需要根据具体的应用场景来选择合适的规则。

o正向最大匹配:从左向右扫描文本,每次尝试匹配最长的词汇。

如果词典中存在该词汇,则将其切分出来;否则,缩短一位继续匹配,直到找到词典中的词汇或只剩下一个字符为止。

o逆向最大匹配:与正向最大匹配相反,从右向左扫描文本进行匹配。

这种方法在某些场景下可能比正向最大匹配更准确。

o双向最大匹配:结合正向和逆向最大匹配的优点,同时进行两次扫描,然后选择切分结果中词数较少的那个作为最终的分词结果。

o最少切分:尽可能少地将文本切分成独立的词汇。

这种方法可能导致一些长词被错误地切分成多个短词。

3.分词过程:在定义了匹配规则之后,就可以开始进行分词了。

分词过程通常是一个迭代的过程,每次从文本中匹配出一个词汇并将其切分出来,然后继续处理剩余的文本,直到整个文本都被处理完毕。

4.优缺点:词典分词法的优点是实现简单、速度快、对于常见词汇的分词效果较好。

但是,它也存在一些明显的缺点,如对未登录词(词典中未包含的词汇)的处理能力有限、对歧义词的消解效果不理想等。

为了解决这些问题,通常需要结合其他分词方法或技术来提高分词的准确性。

5.应用场景:词典分词法广泛应用于中文信息处理领域,如文本编辑、搜索引擎、机器翻译、自然语言处理等。

中文分词词典构造简述在分词系统中常用的分词词典机制有:(1)基于整词二分;(2)基于TRIE索引树;(3)基于逐字二分.一、基于整词二分的分词词典机制这是一种广为使用的分词词典机制.其结构通常分为三级,前两级为索引,如图3.1听示。

图3.1 基于整词二分的分词词典机制1.首字散列表词首字散列函数根据汉字的国标区位码给出。

通过一次Hash运算即可直接定位汉字在首字散列表中的序号。

也就是将词首字的国标码与其在首字散列表中的序号相对应。

我国的GB2312-80标注规定汉语字符的交换码由两个ASCII 码构成:第一个是区码,取值从OxA1到OxF7,共87个区,第二个是位码,从OxA1到0xFE,共94位。

区码为OxA1到0xAE的存储全角符号,如标点、字母等。

GB2312-80汉字的编码空间是BOA1-FIFE,共有72 * 94 = 6768个码位,实有6763个汉字,其中一级汉字3755个,接着是5个空位,后面是3008个二级汉字。

设id是词首字在首字散列表中的序号,c1和c2是词首字的区码和位码,利用Hash方法求Id则有:Id = (c1–176) * 94 + (c2 - 161)(3-1)这种Hash方法实质上是一种一一映射。

首字散列表的一个单元包括两项内容:1) 入口项数(4字节):以该字为首字的词的个数。

2) 第一入口项指针(4字节):指向第一入口项在词索引表中的位置。

2.词索引表因为词的长度可变(实际系统中还包括附属于该词的各类信息),故以选择不定长存储为宜,此外必须实现对词的随机访问,这两条决定了必须建立词索引表。

词索引表的一个单元仅含一项内容:1) 词典正文指针(4字节):指向词在词典正文中的位置。

3.词典正文以词为单位的有序表,词典中的同一首字的词条按升序排列,通过词索引表和词典正文的配合,很容易实现指定词在词典正文中的整词二分快速查找。

在整词二分查询任意一个汉字串W[1…n], W[1]表示该字串首字,W[n]表示首字后面的n个汉字,查询的过程为:1) 根据首字散列表得到W[1]入口项指针和以它为首字的词在词索引表中所占的范围。

中文分词词典构造简述

在分词系统中常用的分词词典机制有:(1)基于整词二分;(2)基于TRIE索引树;(3)基于逐字二分.

一、基于整词二分的分词词典机制

这是一种广为使用的分词词典机制.其结构通常分为三级,前两级为索引,如图3.1听示。

图3.1 基于整词二分的分词词典机制

1.首字散列表

词首字散列函数根据汉字的国标区位码给出。

通过一次Hash运算即可直接定位汉字在首字散列表中的序号。

也就是将词首字的国标码与其在首字散列表中的序号相对应。

我国的GB2312-80标注规定汉语字符的交换码由两个ASCII 码构成:第一个是区码,取值从OxA1到OxF7,共87个区,第二个是位码,从OxA1到0xFE,共94位。

区码为OxA1到0xAE的存储全角符号,如标点、字母等。

GB2312-80汉字的编码空间是BOA1-FIFE,共有72 * 94 = 6768个码位,实有6763个汉字,其中一级汉字3755个,接着是5个空位,后面是3008个二级汉字。

设id是词首字在首字散列表中的序号,c1和c2是词首字的区码和位码,利用Hash方

法求Id则有:

Id = (c1–176) * 94 + (c2 - 161)

(3-1)

这种Hash方法实质上是一种一一映射。

首字散列表的一个单元包括两项内容:

1) 入口项数(4字节):以该字为首字的词的个数。

2) 第一入口项指针(4字节):指向第一入口项在词索引表中的位置。

2.词索引表

因为词的长度可变(实际系统中还包括附属于该词的各类信息),故以选择不定长存储为宜,此外必须实现对词的随机访问,这两条决定了必须建立词索引表。

词索引表的一个单元仅含一项内容:

1) 词典正文指针(4字节):指向词在词典正文中的位置。

3.词典正文

以词为单位的有序表,词典中的同一首字的词条按升序排列,通过词索引表和词典正文的配合,很容易实现指定词在词典正文中的整词二分快速查找。

在整词二分查询任意一个汉字串W[1…n], W[1]表示该字串

首字,W[n]表示首字后面的n个汉字,查询的过程为:

1) 根据首字散列表得到W[1]入口项指针和以它为首字的词

在词索引表中所占的范围。

2) 根据1)中得到的范围在词典正文中对汉字串W[n]进行

二分查找。

如果查询成功则W [l…n]为分词词典中的一个词. 整词二分法查询的基本原理很简单,但是每次查询都只能对汉字串W[l…n]是否为一个词进行判断,它不能从查询的中

间过程中发现汉字串W[1…n]中所有可能包括的词。

而且它查询的范围较大,总是在以W[1]为首字的所有词表范围内。

而我们在分词过程中,需要得到一个汉字串S中所有可能切分出的词,也就是说要找出S中所有以W[1]为首字的词,

如果用整词二分法来查询的话就需要进行多次的试探,即每改变一次待查字串W[1…n]的n值就要对词典进行一次查询,而且每次的查询过程都要在以W[1]为首字的所有词表范围内.因此整词二分法的查询效率不高.

二、基于TRIE索引树的分词词典机制

TRIE索引树是一种以树的多重链表形式表示的键树。

基于TRIE树的分词词典由两部分组成,如图3.2所示。

图3.2 基于TRIE索引树的分词词典机制

1.首字散列表

同基于整词二分的分词词典机制。

首字散列表的一个单元是所对应汉字的TRIE索引树的根结点.

2.TRIE索引树结点

TRIE索引树结点是以下述结构为单元的,按关键字排序的数组:

关键字(2字节):单一汉字。

子树大小(2字节):以从根结点到当前单元的关键字组成的子串为前缓的词的个数。

子树指针(4字节):子树大小非0时,指针指向子树,否则指向叶子。

在TRIE索引树上查询任意一个词W[1…n]的过程为:

1) 根据首字散列表得到W[1]TRIE索引树,沿相应指针移动至目标结点NODE,i = 2。

2) 在NODE的关键字域中对汉字W[i]进行二分查找。

如果与NODE的第j 个单元的关键字匹配成功则沿该单元的子树指针移至目标结点,并令该结点为新的NODE,i = i + 1,否则查找失败,退出此过程。

3) 重做2),直到NODE为叶子结点。

4) 如果到达叶于结点时i>n,则

查询成功,W [l…n]为分词词典中的一个词,否则查询失败。

与整词二分的分词词典机制形成鲜明对照的是:基于TRIE

索引树的分词词典机制每次仅仅只比较一个汉字,不需预知待查询词的长度,且在对汉字串S的一遍扫描过程中,就能得到所有可能切分的词。

这种由短词及长词的确定性工作方式避免了整词二分的分词词典机制不必要的多次试探性查询。

由于TRIE索引树已蕴含了词条信息,因此词典中不必再显式地罗列词条,可直接存储词的附属信息(叶子指针直接指向这些信息)。

TRIE索引树分词词典机制的主要缺点是其构造及维护比整

词二分复杂。

基于TRIE索引树的另外一种构造方式就是:所有字都采用Hash散列的方式。

其结构与图3.2 基本相同,不同的是其

入口项个数要么为0 要么就是整个汉字字库的大小。

这种方式在查询上有显著的效率提升,因为不需要执行二分查找,但是由于中文汉字数量巨大,同时也造成了大量空间的浪费。

三、基于逐字二分的分词词典机制

基于逐字二分的分词词典是针对整词二分和TRIE索引树的不足而设计的一种分词词典。

逐字二分分词词典与整词二分分词词典在数据结构上相同,因此其构造比TRIE索引树简

单。

从查询方式来看,逐字二分不再将整个词作为关键字进行比较,而是类似TRIE索引树的情形,每次仅仅比较单个的汉字。

因而其效果同TRIE索引树一样,不需预知待查询词的长度,且在对汉字串S的一遍扫描过程中,就能得到查询串中所有可能切分的词。

基于逐字二分分词词典,如图3.3所示。