最小二乘估计

- 格式:ppt

- 大小:2.74 MB

- 文档页数:46

简述参数最小二乘估计的基本原理

参数最小二乘估计是一种常用的统计方法,用于确定一组参数的最优值,以便最小化模型的预测误差。

该方法的基本原理是,在给定一组有限的观测数据下,通过拟合一个数学模型,估计模型中的参数值,使得模型的预测误差最小。

具体地说,参数最小二乘估计的基本原理是通过最小化残差平方和来确定参数的最优值。

这里的残差是指观测值与模型预测值之间的差异,平方和则是所有残差平方的总和。

通过最小化残差平方和,可以得到最优的参数值,使得预测误差最小。

参数最小二乘估计的优点是简单易懂、计算方便、可解释性好,并且在实际应用中广泛使用。

但是,该方法也存在一些限制,例如它要求模型中的误差服从正态分布,且假设模型的参数是固定的,而不是随机变量。

因此,在实际应用中需要对这些限制进行考虑,并结合实际情况选择合适的方法进行参数估计。

- 1 -。

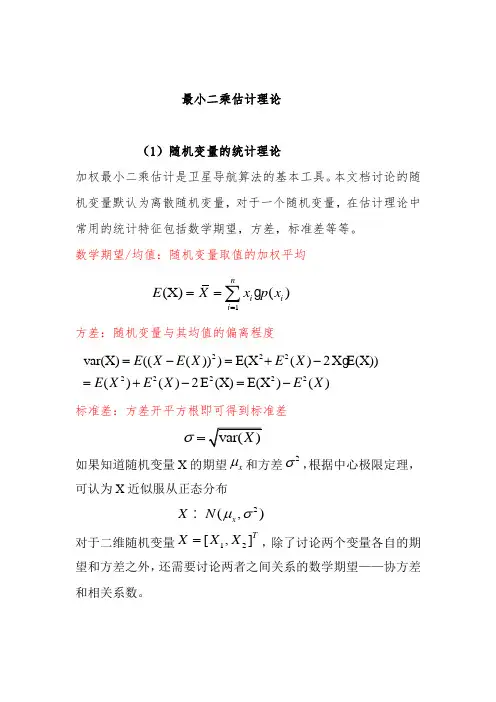

最小二乘估计理论(1)随机变量的统计理论加权最小二乘估计是卫星导航算法的基本工具。

本文档讨论的随机变量默认为离散随机变量,对于一个随机变量,在估计理论中常用的统计特征包括数学期望,方差,标准差等等。

数学期望/均值:随机变量取值的加权平均1(X)()ni i i E X x p x ===∑ 方差:随机变量与其均值的偏离程度22222222var(X)((()))E(X ()2X E(X))()()2E (X)E(X )()E X E X E X E X E X E X =-=+-=+-=-标准差:方差开平方根即可得到标准差σ=如果知道随机变量X 的期望x μ和方差2σ,根据中心极限定理,可认为X 近似服从正态分布2(,)x X N μσ对于二维随机变量12[,]T X X X =,除了讨论两个变量各自的期望和方差之外,还需要讨论两者之间关系的数学期望——协方差和相关系数。

1X 和2X 的协方差定义为12121122121221121212(X ,)((()(())E(X ()()()())E(X X )()()x x Cov X E X E X X E X X X E X X E X E X E X E X E X σ=--=--+=-=1X 和2X 相关系数定义为:121212x x x x x x σρσσ= 相关系数的取值范围为[-1,1]之间,其绝对值越小表明两随机变量的相关性越小。

则二维随机变量X 的均值和方差为:1122()()()()X E X E X E X E X ⎡⎤⎡⎤==⎢⎥⎢⎥⎣⎦⎣⎦11212211112222211112221122222,2,()((())(()))()E([()()])()((())),((()(())((()(()),((())),,T x x x x x x D X E X E X X E X X E X X E X X E X X E X E X E X E X E X X E X E X E X X E X E X E X σσσσ=---⎡⎤=--⎢⎥-⎣⎦⎡⎤---=⎢⎥---⎢⎥⎣⎦⎡⎤=⎢⎥⎢⎥⎣⎦同理对于多维随机变量123[,,......]T n X X X X X =同理有1122()()()()..()n n X E X X E X E X E X E X ⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥==⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦21111221121122222211((())(()))((())),((()(())...((()(())((()(()),((()))...((()(()).........((()(())...................T xx n n n n n n D E X E X X E X E X E X E X E X X E X E X E X X E X E X E X X E X E X E X E X E X X E X E X E X X E X =------------=-- 211..................................((()))E X E X ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥-⎣⎦1121122212,,2,,2,,,......,,...........,..............n n nn x x x x x x x x x x x x x σσσσσσσσ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦(实对称矩阵)现在讨论多维随机变量函数的期望和方差现在假设函数11220........n n Z k X k X k X k =++++ ,可令123[,,......]T n X X X X X =123[k ,k ,k ......k ]n K =则函数值Z 可表示为0Z K X k =+则随机变量Z 的期望和方差可表示为00()()()E Z E K X k K E X k =+=+((Z E(Z))(Z E(Z)))(K(X E(X))(K(X E(X)))((X E(X))(X E(X)))T zz T T T Txx D E E K E K K D K =--=--=--=已知随机变量的方差,可以求得随机变量函数的方差这个过程称为误差传播定律。

估计方法最小二乘法与极大似然估计估计方法是统计学中常用的一种工具,用于从样本数据中推断总体参数的值。

最小二乘法和极大似然估计是两种常见的估计方法,在不同的情境下被广泛应用。

本文将对这两种方法进行介绍,并比较它们的优缺点。

一、最小二乘法最小二乘法是一种常用的参数估计方法,它的核心思想是使观测数据与理论模型的预测值之间的残差平方和最小化。

通过最小化残差平方和,最小二乘法能够找到最优的参数估计值。

最小二乘法可用于线性回归、非线性回归以及参数估计等多个领域。

在线性回归问题中,最小二乘法可以用于拟合一个线性模型,使该模型与观测数据之间的残差平方和最小化。

具体地,假设我们有n个观测值(x,y),其中x为自变量,y为因变量。

线性回归的目标是找到最优的模型参数β0和β1,使得残差平方和最小化。

最小二乘法通过最小化残差平方和的方法来求解β0和β1的值。

除了线性回归问题,最小二乘法还可以用于非线性回归问题,其中模型可以是一些非线性函数。

通过将非线性模型转化为线性模型进行拟合,在最小二乘法的框架下,可以得到非线性模型的最优参数估计。

最小二乘法的优点在于易于理解和计算,具有较小的方差。

然而,最小二乘法也有一些缺点,比如对异常值非常敏感,并且对数据分布的假设要求较高。

二、极大似然估计极大似然估计是另一种常用的参数估计方法,它的核心思想是选择参数值,使得观测数据出现的概率最大化。

极大似然估计常用于统计模型的参数估计,可以用于概率分布参数的估计,以及对未知分布函数形式的参数估计。

假设我们有一组独立同分布的随机观测值x1, x2, ..., xn,我们希望通过这些观测值来对总体分布的参数进行估计。

极大似然估计的目标是选择最优的参数值,使得观测到这些数据的概率最大化。

以正态分布为例,假设我们观测到了一组随机变量x1, x2, ..., xn,我们希望通过这些观测值来估计正态分布的均值μ和方差σ^2。

使用极大似然估计,我们可以写出似然函数,然后通过最大化似然函数来求解最优的参数估计值。

最小二乘估计的基本假设1. 引言嘿,大家好!今天咱们来聊聊一个听上去有点复杂,但其实很有趣的话题——最小二乘估计。

可能你会想:“这是什么鬼?”其实,简单来说,它就是一种统计方法,帮助我们找到一条最能贴合数据的线。

想象一下,你在玩抛沙包,想找到一个最稳的投篮角度,最小二乘估计就能帮你找出最佳的“抛沙包”策略。

不过,嘿,要想玩得开心,得有几个基本的假设在前面,不然就像打麻将没带牌一样,别扭得很。

2. 最小二乘估计的基本假设2.1 线性关系首先,最重要的一点就是,咱们得假设变量之间是线性关系。

也就是说,如果你画个图,数据点大概会在一条直线上上下波动。

举个例子,如果你觉得每天吃的冰淇淋越多,心情就越好,这俩东西之间可能就有线性关系。

但如果你发现,吃冰淇淋过多反而心情糟糕,那就不符合咱们的假设了,可能还得调整一下“吃冰淇淋”的策略呢。

2.2 随机误差接下来,咱们得假设误差是随机的。

这就像你每次去外面吃饭,总有可能遇到服务慢、菜不好之类的意外情况,这些情况是不确定的,也不是你能控制的。

最小二乘估计要求这些误差是独立的、随机的,就像你的朋友突然告诉你今晚的电影没法看,这种意外不能影响你之前的计划。

要是误差有规律,比如总是偏高或偏低,那就会让估计的结果变得不靠谱,简直像开车不看路,肯定得出事故!3. 误差的正态分布3.1 正态分布再来,误差得服从正态分布。

这就像大多数人的身高,通常都是围绕着一个平均值分布的,高矮都有,但大部分人都在平均值附近。

正态分布的好处是,我们可以用一些简单的统计方法来进行推断。

要是数据点像个“波浪”一样,波动得不规则,那估计的效果就像一杯搅拌得太猛的奶昔,难以下咽。

3.2 同方差性最后,咱们还得考虑同方差性。

这听上去有点复杂,但其实就是要求误差的波动幅度在各个地方都差不多。

想象一下,如果你在做菜,调味料的味道在每一口都差不多,那大家都能接受。

可要是有的一口特别咸,有的特别淡,那就容易让人怀疑这菜是谁做的,肯定得有人埋怨“这是什么鬼东西?”所以,保持方差一致是很重要的,只有这样才能保证模型的可靠性。

最⼤似然估计(MLE )与最⼩⼆乘估计(LSE )的区别最⼤似然估计与最⼩⼆乘估计的区别标签(空格分隔): 概率论与数理统计最⼩⼆乘估计对于最⼩⼆乘估计来说,最合理的参数估计量应该使得模型能最好地拟合样本数据,也就是估计值与观测值之差的平⽅和最⼩。

设Q 表⽰平⽅误差,Y i 表⽰估计值,ˆY i 表⽰观测值,即Q =∑n i =1(Y i −ˆY i )2最⼤似然估计对于最⼤似然估计来说,最合理的参数估计量应该使得从模型中抽取该n 组样本的观测值的概率最⼤,也就是概率分布函数或者似然函数最⼤。

显然,最⼤似然估计需要已知这个概率分布函数,⼀般假设其满⾜正态分布函数的特性,在这种情况下,最⼤似然估计与最⼩⼆乘估计是等价的,也就是估计的结果是相同的。

最⼤似然估计原理:1. 当给定样本x 1,x 2,...,x n 时,定义似然函数为L (θ)=f (x 1,x 2,...,x n ;θ);2. L (θ)看做是θ的函数,最⼤似然估计就是⽤使L (θ)达到最⼤值的ˆθ去估计θ,这时称ˆθ为θ的最⼤似然估计;MLE 的步骤:1. 由总体分布导出样本的联合概率函数(或联合密度);2. 把样本联合概率函数的⾃变量看成是已知常数,⽽把θ看做是⾃变量,得到似然函数L (θ);3. 求似然函数的最⼤值(常常取对数,然后求驻点);4. ⽤样本值带⼊得到参数的最⼤似然估计。

例题设⼀个有偏的硬币,抛了100次,出现1次⼈头,99次字。

问⽤最⼤似然估计(ML )和最⼩均⽅误差(LSE )估计出现⼈头的概率哪个⼤?LSE设使⽤LSE 估计,出现⼈头的概率为θ, 则出现字的概率为1−θ。

已知观测量为:(观测到的)出现⼈头的概率为1100, (观测到的)出现字的概率为99100,则由最⼩⼆乘估计:Q (θ)=argmin θ∑1001(θ−ˆθ)2=argmin θ{(1100−θ)2+[99100−(1−θ)]2∗99}令∂Q (θ)∂θ=0,解得θ=1100;ML设使⽤ML 估计,所以x 服从伯努利分布,x ∼B (朝上,θ),则概率密度函数为:P (x |θ)=θ,if x ⼈头朝上1−θ,if x 字朝上则连续100次试验的似然函数为:P (x 1,x 2,..x 100|θ)=C 1100θ1∗(1−θ)99=100∗θ1∗(1−θ)99最⼤化似然函数,则θ⾄少为驻点,对似然函数取对数并求偏导:ln P (x 1,x 2,..x 100|θ)=ln100+ln θ+99ln(1−θ)对θ求偏导为0,得到:∂ln P (x 1,x 2,..x 100|θ)∂θ=1θ−991−θ=0, 解得θ=1100.{两者虽然得到的估计值是⼀样的,但是原理完全不同,要对他们的推导过程⾮常清楚。

简述参数最小二乘估计的基本原理

参数最小二乘估计是一种常见的回归分析方法,其基本原理是通过最小化残差平方和来估计模型中的所有参数。

具体地说,最小二乘估计的基本思想是,假设我们有一个线性模型y = β0 + β1x1 + β2x2 + … + βkxk + ε,其中,y表示因变量,x1、x2、…、xk表示自变量,β0、β1、β2、…、βk表示模型中的参数,ε表示误差项。

在最小二乘估计中,我们的目标是通过最小化残差平方和来确定模型中的参数,即使得∑(yi - β0 - β1x1i - β2x2i - … - βkxki)2最小。

为了实现最小二乘估计,我们通常使用矩阵代数的方法,将模型的参数估计值表示为(XX)-1Xy的形式,其中,X是自变量数据的矩阵,y是因变量数据的向量,而(XX)-1是矩阵(XX)的逆矩阵。

在实际应用中,最小二乘估计可以用于多种类型的回归分析,比如简单线性回归、多元线性回归、非线性回归等。

它的优点是简单易懂、计算方便,因此被广泛应用于统计学、经济学、工程学等领域。

- 1 -。

最小二乘估计的推导最小二乘估计是一种常用的参数估计方法,尤其在统计学和经济学领域得到广泛应用。

它的推导涉及到一些数学推理和统计原理,我将在本文中逐步解释和展示最小二乘估计的推导过程,并探讨其应用和优势。

1. 引言最小二乘估计是一种通过最小化观测值与预测值之间的差异来估计参数的方法。

它的基本思想是找到一组参数值,使得观测值与对应的预测值之间的平方差最小化。

这种方法在数据分析和回归分析中非常有用,因为它能够提供可靠的参数估计和预测模型。

2. 最小二乘估计的基本原理最小二乘估计的推导涉及到线性回归模型,即因变量Y与自变量X之间的线性关系。

假设我们有n个观测值,表示为(Xi,Yi),i=1,2,...,n。

我们的目标是找到一条直线Y=aX+b,使得所有观测值到这条直线的距离之和最小化。

距离的平方和可以表示为:S = Σ(Yi - (aXi + b))²我们的目标是最小化这个平方和。

为了找到最优的参数估计,我们需要找到使得S最小的a和b的值。

3. 最小化平方和我们可以通过对S求导,令导数等于零,来求解a和b的值。

具体地,我们分别对a和b求导,并令导数等于零:∂S/∂a = -2ΣXi(Yi - (aXi + b)) = 0∂S/∂b = -2Σ(Yi - (aXi + b)) = 0通过求解以上两个方程,我们可以得到最小二乘估计的闭合解:a = (ΣXiYi - n X̄Ȳ) / (ΣXi² - n X̄²)b = Ȳ - a X̄其中,X̄和Ȳ分别表示X和Y的均值,Σ表示求和符号。

4. 应用和优势最小二乘估计在实际应用中具有广泛的用途。

在经济学中,我们可以通过最小二乘估计来估计需求曲线和供给曲线的参数,从而预测市场的走势和变化。

在统计学中,最小二乘估计可以用于拟合数据并构建预测模型。

它是最经典的回归分析方法之一,可用于解释和预测变量之间的关系。

最小二乘估计具有一些优势。

最小二乘估计随着空间技术的发展,人类的活动开始进入了太空,对航天器(包括人造地球卫星、宇宙飞船、空间站和空间探测器等)的观测手段和轨道确定提出了很高的精度要求。

在计算技术高速发展的推动下,各种估计理论也因此引入到轨道估计方法中。

大约在1795年高斯在他那著名的星体运动轨道预报研究工作中提出了最小二乘法。

最小二乘法就成了估计理论的奠基石。

最小二乘估计不涉及观测数据的分布特性,它的原理不复杂,数学模型和计算方法也比较简单,编制程序不难,所以它颇受人们的重视,应用相当广泛。

对于严格的正态分布数据,最小二乘估值具有最优一致无偏且方差最小的特性。

实践证明,在没有粗差的情况下,大部分测量数据基本上符合正态分布。

这是最小二乘估计至今仍作为估计理论核心的基础。

最早的轨道确定就是利用最小二乘法,用全部观测数据确定某一历元时刻的轨道状态的“最佳”估值,即所谓的批处理算法定轨。

长期以来,在整个天体力学领域之中,各种天体的定轨问题,几乎都是采用这一方法。

卫星精密定轨的基本原理为:利用含有误差的观测资料和不精确的数学模型,通过建立观测量与卫星状态之间的数学关系,参数估计得到卫星状态及有关参数的最佳估值。

参数估计的基本问题就是对一个微分方程并不精确知道的动力学过程,用不精确的初始状态X0和带有误差的观测资料,求解其在某种意义下得卫星运动状态的“最佳”估值X。

常用的参数估计方法有两种,最小二乘法和卡尔曼滤波方法。

最小二乘法是在得到所有的观测数据之后,利用这些数据来估计初始时刻状态量的值,由于用到的观测数据多、计算方法具有统计特性,因此该方法精度高。

卡尔曼滤波在观测数据更新后,利用新的观测数据对状态量进行改进得到这一观测时刻的状态量,卡尔曼滤波适用于实时处理。

卫星精密定轨输运高精度的事后数据处理,通常采用最小二乘法进行参数估计。

记观测量的权阵为P。

利用加权最小二乘法计算总的观测方程方程y二Hx0•;,得x =(H T PH)JH T py卫星的参考状态为X; = X0 x0在精密定轨的过程中,由于状态方程和观测方程在线性化过程中会产生误差,上式的解算需要通过不断的迭代。

最小二乘法求解参数

最小二乘法来估计参数,就是使得实际值与估计值的差距的平方最小。

β可以被已知的未知数计算得到是无偏估计的值。

但是用最小二乘法可以得到最好的线性无偏估计量,因为变异比较小。

所以这种方法就是最稳定的最通用的方法。

如果只有一个β1,也就是只有y与x1,则使用两样本t检验和回归分析是一样的。

因为两样本t检验就可以计算β的置信区间,因此也可以在该回归方程中。

另一种估计参数方法是最大似然函数,用此法估计参数值是一样的,但是仅对于y是连续值情况。

采用最小二乘估计式可以得到简单线性回归模型参数的估计量。

但是估计量参数与总体真实参数的接近程度如何。

在工程物理、化学工程、生物医学、统计学、经济学、信号处理、自动化、测绘学等领域中,许多问题都可归结为求解矩阵方程Ax=b 的问题。

通过计算机仿真说明了在模型中所有变量均具有不可忽略的误差时,全最小二乘法得到的参数估计更接近。

除了线性均方估计外,最小二乘估计是另一种不需要任何先验知识的参数估计方法,最小二乘估计不需要先验统计特性,适用范围更广。

、、。

第1篇一、引言最小二乘法(Least Squares Method)是统计学中一种常用的参数估计方法,尤其在回归分析中得到了广泛的应用。

最小二乘法通过最小化残差平方和来估计模型参数,其中b1是线性回归模型中自变量对因变量的斜率估计量。

本文将推导最小二乘估计量b1的方差,以期为线性回归分析提供理论支持。

二、线性回归模型线性回归模型的一般形式为:Y = β0 + β1X1 + β2X2 + ... + βkXk + ε其中,Y是因变量,X1, X2, ..., Xk是自变量,β0是截距,β1, β2, ...,βk是回归系数,ε是误差项。

三、最小二乘估计量根据最小二乘法,估计量b1可以通过以下公式计算:b1 = (X'X)^(-1)X'Y其中,X是设计矩阵,Y是观测值向量,(X'X)^(-1)是X的协方差矩阵的逆矩阵。

四、b1的方差推导为了推导b1的方差,我们需要考虑以下步骤:1. 残差平方和残差平方和(Residual Sum of Squares,RSS)是衡量模型拟合程度的重要指标,其计算公式为:RSS = ∑(Yi - Yi^)²其中,Yi是观测值,Yi^是模型预测值。

2. 残差协方差矩阵残差协方差矩阵(Residual Covariance Matrix,CR)是衡量残差之间关系的矩阵,其计算公式为:CR = (X'X)^(-1)X'X(X'X)^(-1)3. b1的方差根据线性回归模型和残差协方差矩阵,b1的方差可以表示为:Var(b1) = CR[1,1]其中,CR[1,1]表示残差协方差矩阵的第1行第1列元素。

4. 推导过程为了推导Var(b1),我们需要考虑以下步骤:(1)计算残差协方差矩阵CRCR = (X'X)^(-1)X'X(X'X)^(-1)(2)计算CR[1,1]CR[1,1] = (X'X)^(-1)X'X[1,1](X'X)^(-1)其中,[1,1]表示矩阵的第1行第1列元素。

最小二乘估计过程推导在统计学和数学领域中,最小二乘法是一种常用的估计方法,用于拟合一个数学模型与观测数据之间的关系。

它的主要目标是通过最小化残差的平方和来找到最佳的参数估计值。

本文将介绍最小二乘估计的基本原理和推导过程。

最小二乘法的核心思想是找到一组参数,使得模型预测值与观测值之间的差异最小化。

在线性回归问题中,最小二乘估计通过最小化观测值与模型预测值之间的残差平方和来求解最佳参数估计值。

假设我们有一个线性回归模型,其中y表示因变量,X表示自变量,β表示待估计的参数向量。

模型可以表示为:y = Xβ + ε其中ε表示误差项,我们假设它是一个服从正态分布的随机变量。

我们的目标是找到最佳的参数估计值β,使得模型的预测值与观测值之间的差异最小化。

为了求解最佳参数估计值,我们需要定义一个误差函数,通常选择残差的平方和作为误差函数。

我们将所有观测值的残差平方和表示为:S(β) = ∑(y - Xβ)²为了找到最小化误差函数的参数估计值,我们需要对误差函数进行求导,并令导数等于零。

通过求解这个方程组,我们可以得到最佳的参数估计值。

为了简化计算,我们可以将误差函数表示为矩阵形式。

令Y表示观测值的向量,X表示自变量矩阵,β表示参数向量,e表示误差向量,则误差函数可以表示为:S(β) = (Y - Xβ)ᵀ(Y - Xβ)对误差函数进行求导,并令导数等于零,我们得到以下的方程:XᵀXβ = XᵀY这个方程被称为正规方程,它可以用来求解最佳的参数估计值。

当XᵀX是可逆的时候,我们可以通过计算逆矩阵来求解参数估计值:β = (XᵀX)⁻¹XᵀY当XᵀX不可逆时,我们可以通过广义逆矩阵来求解参数估计值。

最小二乘估计方法的优点在于它是一个无偏估计,即当样本量趋向于无穷大时,估计值收敛于真实的参数值。

同时,最小二乘估计方法还具有最小方差性质,即在所有无偏估计中,它的方差是最小的。

最小二乘法是统计学中最常用的估计方法之一。