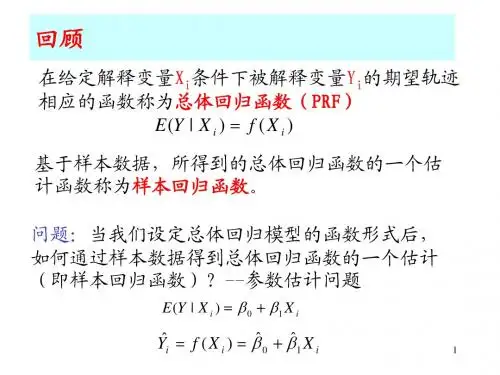

一元线性回归的最小二乘估计

- 格式:ppt

- 大小:222.50 KB

- 文档页数:3

8.2.1一元线性回归模型1.生活经验告诉我们,儿子的身高与父亲的身高相关.一般来说,父亲的身高较高时,儿子的身高通常也较高.为了进一步研究两者之间的关系,有人调查了14名男大学生的身高及其父亲的身高,得到的数据如表1所示.编号1234567891011121314父亲身高/cm 174 170 173 169 182 172 180 172 168 166 182 173 164 180 儿子身高/cm 176 176 170 170 185 176 178 174 170 168 178 172 165 182从图上看,散点大致分布在一条直线附近根据我们学过的整理数据的方法:相关系数r =0.886.父亲身高/cm180 175 170 165 160160 165 170 175180 185 190 ·· ·· · · · 儿子身高/cm· · · · ·185 1).问题1:可以得到什么结论?由散点图的分布趋势表明儿子的身高与父亲的身高线性相关,通过相关系数可知儿子的身高与父亲的身高正线性相关,且相关程度较高.2).问题2:是否可以用函数模型来刻画?不能,因为不符合函数的定义.这其中还受其它因素的影响.3).问题3:那么影响儿子身高的其他因素是什么?影响儿子身高的因素除父亲的身外,还有母亲的身高、生活的环境、饮食习惯、营养水平、体育锻炼等随机的因素,儿子身高是父亲身高的函数的原因是存在这些随机的因素.4).问题4: 你能否考虑到这些随机因素的作用,用类似于函数的表达式,表示儿子身高与父亲身高的关系吗?用x表示父亲身高,Y表示儿子的身高,用e表示各种其它随机因素影响之和,称e为随机误差, 由于儿子身高与父亲身高线性相关,所以Y=bx+a.考虑随机误差后,儿子的身高可以表示为:Y=bx+a+e由于随机误差表示大量已知和未知的各种影响之和,它们会相互抵消,为使问题简洁,可假设随机误差e的均值为0,方差为与父亲身高无关的定值 . 2σ2即E e D eσ:()0,().==我们称①式为Y 关于x 的一元线性回归模型,其中,Y 称为因变量或响应变量,x 称为自变量或解释变量 . a 称为截距参数,b 称为斜率参数;e 是Y 与bx+a 之间的随机误差.2,()0,().Y bx a e E e D e σ=++⎧⎨==⎩① 2、一元线性回归模型如果用x 表示父亲身高,Y 表示儿子的身高,e 表示随机误差.假定随机误差e 的均值为0,方差为与父亲身高无关的定值 ,则它们之间的关系可以表示为2σ4.问题5:你能结合具体实例解释产生模型①中随机误差项的原因吗?产生随机误差e的原因有:(1)除父亲身高外,其他可能影响儿子身高的因素,比如母亲身高、生活环境、饮食习惯和锻炼时间等.(2)在测量儿子身高时,由于测量工具、测量精度所产生的测量误差.(3)实际问题中,我们不知道儿子身高和父亲身高的相关关系是什么,可以利用一元线性回归模型来近似这种关系,这种近似关系也是产生随机误差e的原因.8.2.2一元线性回归模型参数的最小二乘法估计二、自主探究问题1.为了研究两个变量之间的相关关系, 我们建立了一元线性回归模型表达式 刻画的是变量Y 与变量x 之间的线性相关关系,其中参数a 和b 未知,我们如何通过样本数据估计参数a 和b?2,()0,().Y bx a e E e D e σ=++⎧⎨==⎩问题2.我们怎样寻找一条“最好”的直线,使得表示成对样本数据的这些散点在整体上与这条直线最“接近”?从成对样本数据出发,用数学的方法刻画“从整体上看,各散点与蓝色直线最接近”利用点到直线y=bx+a 的“距离”来刻画散点与该直线的接近程度,然后用所有“距离”之和刻画所有样本观测数据与该直线的接近程度.父亲身高/cm180 175 170 165 160160 165 170 175180 185 190 ·· ·· · · · 儿子身高/cm· · · · ·185 父亲身高/cm180 175 170 165 160160 165 170 175 180 185 190·· ·· · · · 儿子身高/cm· · · · ·185设满足一元线性回归模型的两个变量的n 对样本数据为(x 1,y 1),(x 2,y 2),…,(x n ,y n )父亲身高/cm180 175170165 160160165 170 175 180 185 190·· · · · · · 儿子身高/cm· ·· · · 185()()(1,2,3,,-).i i i i i i i i i i i y bx a e i n y bx a e e x y x bx a =++=⋅⋅⋅+=+由),得(显然越小,表示点,与点,的距离越小,()0,.i i i x y =即样本数据点离直线y=bx+a 的竖直距离越小,如上图特别地,当e 时,表示点在这条直线上1-)ni i i y bx a =+∑因此可用(来刻画各样本观测数据与直线y=bx+a 的整体接近程度.()iix y ,y=bx+a()i i x bx a +,·[]21(,)()ni i i Q a b y bx a ==-+∑残差平方和: 即求a ,b 的值,使Q ( a ,b )最小残差:实际值与估计值之间的差值,即 使Q 取得最小值,当且仅当b 的取值为121()()()nii i nii xx y y b xx ==--=-∑∑b.,ˆ,ˆ的最小二乘估计叫做求得a b a b(,).x y 经验回顾直线必经过的符号相同与相关系数r b ˆ最小二乘法我们将 称为Y 关于x 的经验回归方程,也称经验回归函数或经验回归公式,其图形称为经验回归直线,这种求经验回归方程的方法叫最小二乘法.ˆˆˆy bxa =+12111=i ni n22i ni n x x y y ˆb ,x x ˆˆa x y x y x xy b .i i i i i i ΣΣx )n ΣΣ(()()n ====⎧--⎪=⎪⎨-⎪⎪--=⎩-问题2:依据用最小二乘估计一元线性回归模型参数的公式,求出儿子身高Y 关于父亲身高x 的经验回归方程.儿子的身高不一定会是177cm ,这是因为还有其他影响儿子身高的因素,回归模型中的随机误差清楚地表达了这种影响,父亲的身高不能完全决定儿子的身高,不过,我们可以作出推测,当父亲的身高为176cm 时,儿子身高一般在177cm 左右.当x=176时, ,如果一位父亲身高为176cm,他儿子长大后身高一定能长到177cm 吗?为什么?177y ≈083928957ˆy .x .=+的意义?∧b残差的定义,e a bx Y ++=一元线性回归模型,,Y y 对于通过观测得响应到的数据称量为变观测值ˆ,y通过经验回归方程得到称为预报值的ˆ.ˆey y =-残观测值减去预报值称为即差判断模型拟合的效果:残差分析问题3:儿子身高与父亲身高的关系,运用残差分析所得的一元线性回归模型的有效性吗?残差图:作图时纵坐标为残差,横坐标可以选为样本编号,或身高数据或体重估计值等,这样作出的图形称为残差图.从上面的残差图可以看出,残差有正有负,残差点比较均匀地分布在横轴的两边,可以判断样本数据基本满足一元线性回归模型对于随机误差的假设.所以,通过观察残差图可以直观判断样本数据是否满足一元线性回归模型的假设,从而判断回归模型拟合的有效性.所以,只有图(4)满足一元线性回归模型对随机误差的假设图(1)显示残差与观测时间有线性关系,应将时间变量纳入模型; 图(2)显示残差与观测时间有非线性关系,应在模型中加入时间的非线性函数部分; 图(3)说明残差的方差不是一个常数,随观测时间变大而变大图(4)的残差比较均匀地集中在以横轴为对称轴的水平带状区域内.根据一元线性回归模型中对随机误差的假定,残差应是均值为0,方差为 的随机变量的观测值.2σ观察以下四幅残差图,你认为哪一个残差满足一元线性回归模型中对随机误差的假定?1.残差等于观测值减预测值2.残差的平方和越小越好;3.原始数据中的可疑数据往往是残差绝对值过大的数据;4. 对数据刻画效果比较好的残差图特征:残差点比较均匀的集中在水平带状区域内.归纳小结(残差图中带状越窄,精度越高)1.关于残差图的描述错误的是( )A.残差图的横坐标可以是样本编号B.残差图的横坐标也可以是解释变量或预报变量C.残差点分布的带状区域的宽度越窄相关指数越小D.残差点分布的带状区域的宽度越窄残差平方和越小C 三、巩固提升2.根据如下样本数据:得到的经验回归方程为 ,则( ) A. >0, >0B. >0, <0C. <0, >0D. <0, <0 x 2 3 4 5 6 Y42.5-0.5-2-3a $a $a $a$$b $b$b$b $$ybx a =+$ B3.某种产品的广告支出费用x(单位:万元)与销售额Y(单位:万元)的数据如表:已知Y 关于x 的经验回归方程为 =6.5x+17.5,则当广告支 出费用为5万元时,残差为________. x 2 4 5 6 8Y 30 40 60 50 70$y当x=5时, =6.5×5+17.5=50,表格中对应y=60,于是残差为60-50=10.$y10一元线性回归模型的应用例1.经验表明,对于同一树种,一般树的胸径(树的主干在地面以上1.3m处的直径)越大,树就越高.由于测量树高比测量胸径困难,因此研究人员希望由胸径预测树高.在研究树高与胸径之间的关系时,某林场收集了某种树的一些数据如下表所示,试根据这些数据建立树高关于胸径的经验回归方程.编号 1 2 3 4 5 6胸径/cm 18.1 20.1 22.2 24.4 26.0 28.3树高/m 18.8 19.2 21.0 21.0 22.1 22.1编号7 8 9 10 11 12胸径/cm 29.6 32.4 33.7 35.7 38.3 40.2树高/m 22.4 22.6 23.0 24.3 23.9 24.7dh· · ·· · · · · · · · · 解: 以胸径为横坐标,树高为纵坐标作散点图如下:散点大致分布在一条从左下角到右上角的直线附近,表明两个变量线性相关,并且是正相关,因此可以用一元线性回归模型刻画树高与胸径之间的关系.0.249314.84h d =+··· ·· · · · · · · · 用d 表示胸径,h 表示树高,根据据最小二乘法,计算可得经验回归方程为0.249314.84h d =+根据经验回归方程,由胸径的数据可以计算出树高的预测值(精确到0.1)以及相应的残差,如下表所示.编号胸径/cm 树高观测值/m 树高预测值/m 残差/m1 18.1 18.8 19.4 -0.62 20.1 19.2 19.9 -0.73 22.2 21.0 20.4 0.64 24.4 21.0 20.9 0.15 26.0 22.1 21.3 0.86 28.3 22.1 21.9 0.27 29.6 22.4 22.2 0.28 32.4 22.6 22.9 -0.39 33.7 23.0 23.2 -0.210 35.7 24.3 23.7 0.611 38.3 23.9 24.4 -0.512 40.2 24.7 24.9 -0.2以胸径为横坐标,残差为纵坐标,作残差图,得到下图.30252015-1.0-0.5 0.0 0.5 1.0· · · · · · · 残差/m· · · ·· 354045胸径/cm观察残差表和残差图,可以看到残差的绝对值最大是0.8,所有残差分布在以横轴为对称轴、宽度小于2的带状区域内 .可见经验回归方程较好地刻画了树高与胸径的关系,我们可以根据经验回归方程由胸径预测树高.编号1 2 3 4 5 6 7 8 年份 1896 1912 1921 1930 1936 1956 1960 1968 记录/s 11.8010.6010.4010.3010.2010.1010.009.95例2.人们常将男子短跑100m 的高水平运动员称为“百米飞人”.下表给出了1968年之前男子短跑100m 世界纪录产生的年份和世界纪录的数据.试依据这些成对数据,建立男子短跑100m 世界纪录关于纪录产生年份的经验回归方程以成对数据中的世界纪录产生年份为横坐标,世界纪录为纵坐标作散点图,得到下图在左图中,散点看上去大致分布在一条直线附近,似乎可用一元线性回归模型建立经验回归方程.将经验回归直线叠加到散点图,得到下图:76913031.4902033743.0ˆ1+-=t y用Y 表示男子短跑100m 的世界纪录,t 表示纪录产生的年份 ,利用一元线性回归模型来刻画世界纪录和世界纪录产生年份之间的关系 . 根据最小二乘法,由表中的数据得到经验回归方程为:从图中可以看到,经验回归方程较好地刻画了散点的变化趋势,请再仔细观察图形,你能看出其中存在的问题吗?你能对模型进行修改,以使其更好地反映散点的分布特征吗?仔细观察右图,可以发现散点更趋向于落在中间下凸且递减的某条曲线附近.回顾已有的函数知识,可以发现函数y=-lnx的图象具有类似的形状特征注意到100m短跑的第一个世界纪录产生于1896年, 因此可以认为散点是集中在曲线y=f(t)=c1+c2ln(t-1895)的周围,其中c1、c2为未知参数,且c2<0.y=f(t)=c1+c2ln(t-1895)这是一个非线性经验回归函数,如何利用成对数据估计参数c1、c2令x=ln(t-1895),则Y=c2x+c1对数据进行变化可得下表:编号 1 2 3 4 5 6 7 8 年份/t 1896 1912 1921 1930 1936 1956 1960 1968 x 0.00 2.83 3.26 3.56 3.71 4.11 4.17 4.29 记录/s 11.80 10.60 10.40 10.30 10.20 10.10 10.00 9.95将x=ln(t-1895)代入:得 8012653.114264398.0ˆ2+-=x y上图表明,经验回归方程对于成对数据具有非常好的拟合精度.将经验回归直线叠加到散点图,得到下图: 8012653.114264398.0ˆ2+-=x y8012653.11)1895ln(4264398.0ˆ2+--=t y经验回归方程为对于通过创纪录时间预报世界纪录的问题,我们建立了两个回归模型,得到了两个回归方程,你能判断哪个回归方程拟合的精度更好吗?8012653.114264398.0ˆ2+-=x y① 2ˆ0.4264398ln(1895)11.8012653y t =--+② 我们发现,散点图中各散点都非常靠近②的图象, 表明非线性经验回归方程②对于原始数据的拟合效果远远好于经验回归方程①.(1).直接观察法.在同一坐标系中画出成对数据散点图、非线性经验回归方程②的图象(蓝色)以及经验回归方程①的图象(红色).28212811ˆ,ˆQ Q (()0.004)0.669i i i i eu ===≈=≈∑∑8012653.114264398.0ˆ2+-=x y① 2ˆ0.4264398ln(1895)11.8012653yt =--+②(2).残差分析:残差平方和越小,模型拟合效果越好.Q 2明显小于Q 1,说明非线性回归方程的拟合效果 要优于线性回归方程.R 2越大,表示残差平方和越小,即模型的拟合效果越好 R 2越小,表示残差平方和越大,即模型的拟合效果越差. 21212ˆ()11()n i i nii i y y y y R ==-=-=--∑∑残差平方和。

最小二乘法及其应用什么是最小二乘法?最小二乘法(LeastSquaresMethod)是一种常用的统计分析方法,用于找到在一组已知数据上拟合度最高的线性模型。

最小二乘法通常用于在一组可选的模型中自动选择最能够最佳地拟合数据的模型。

它也可以用来估计在未观测到的预测值,从而预测某个变量的取值范围。

最小二乘法可以用于多元统计回归分析,而且也是用来计算一元线性回归系数的主要方法。

最小二乘法的基本思想是拟合所选择的模型,以便使拟合模型的预测结果(横坐标的值)与实际观测结果(纵坐标的值)之间的差异最小化。

最小二乘法的运算步骤是:计算每个观测值(纵坐标)与回归模型(横坐标)之间的差值;然后将这些差值的平方和求和,并选择使平方和最小的回归系数,从而获得最佳拟合。

最小二乘法也可以用来估计不可观测的参数。

例如,在预测一个系统的行为时,可以用最小二乘法进行拟合,找到模型参数的最佳估计值,从而估计系统的行为趋势。

在另一方面,最小二乘法也可以用来预测诸如未来产量或销售额等量化指标。

在应用最小二乘法进行科学研究时,它已成为科学界公认的标准统计方法。

它已经被用于统计分析、估计、预测、演示和建模等多个科学研究领域。

例如,最小二乘法可以用于统计推断,用于探究一些不同因素之间的关系,以及推断出假设条件下的基本模型。

它也可以用于估计参数,比如用于估计一个模型的参数值,从而使模型能够更精确地模拟数据。

最小二乘法也被用于拟合非线性曲线。

当数据不满足线性关系时,可以使用最小二乘法拟合曲线。

曲线拟合有很多方法,比如传统的曲线拟合方法,最小二乘法,最小绝对值拟合,和其他各种复杂的曲线拟合方法等等。

总之,最小二乘法是一种非常常用的统计分析方法。

它可以用来自动选择在一组可选的模型中最能够拟合数据的模型,并且可以用于估计不可观测的参数。

此外,最小二乘法也可以用于拟合非线性曲线,从而更精确地模拟实际数据。

由于这种效率和可靠性,最小二乘法已成为科学研究中一种公认的统计分析方法。

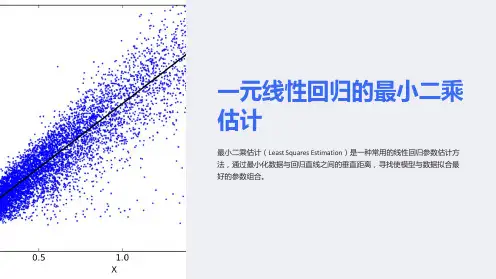

线性回归最小二乘法推导线性回归最小二乘法是一种概率统计模型,用于估计一组数据之间的回归关系。

它根据已知的自变量和因变量之间观察数据,来计算出一个最优的参数用于预测新的观察数据。

线性回归最小二乘法通常应用于研究特定变量的影响因素分析和预测模型的有效性检验。

线性回归模型的推导是根据最小二乘法来完成的,最小二乘法可以用来估计未知参数的模型。

它通常是使用欠拟合的模型,力求尽可能的将模型的结果与真实值拟合的最好。

在实际情况中,最小二乘法寻找形如。

∑i(y-y^)^^2最小的模型,其中y,y^表示真实值和模型值,最小二乘法可以用来估计线性回归参数。

线性回归最小二乘法的推导是从拟合函数的研究开始的,拟合函数的构造也是有用的,这里介绍一下线性模型的拟合函数。

拟合函数定义为,y=f(x)=a+b∗ x,其中a,b是参数,x是观测值,a,b分别表示偏移量和斜率。

根据最小二乘法,拟合函数的最优解是使∑i(y-y^)^^2最小的模型参数。

令M=∑i(y-y^)^^2,求选定拟合函数参数a,b,使其使M函数最小,即对M求导数。

在实际求解过程中,由于拟合函数中只含有一维的参数,可将M表示为M=∑r=1^N(t-t^)^^2,t^=a+b^{符号(X)},其中N是观测数据的个数,X是观测变量。

利用泰勒展开式扩大M求导数,把M改写为M=∑r=1^N(t-t^)^2=∑r=1^N(t-a-b^{符号(X)})^2,对参数a,b求导。

令∂M/∂a=0,可以得出a=∑r=1^NYi-∑r=1^NY^i/N,∂M/∂b=0,可以得出b=∑r=1^N (X)Yi-∑r=1^NX^iY^i/∑r=1^NX^i,将代入原有拟合函数,这样就求出了拟合函数的参数。

最后,它的应用也在不断扩大,可以用来检验经济模型的效用,以及对自变量和因变量之间关系的影响因素分析,不仅在许多学科学习中有重要意义,也在实际应用中发挥了重要作用。

因此,线性回归最小二乘法以其简洁高效的估计和预测功能得到了广泛的应用。

最小二乘法求解线性回归问题最小二乘法是回归分析中常用的一种模型估计方法。

它通过最小化样本数据与模型预测值之间的误差平方和来拟合出一个线性模型,解决了线性回归中的参数估计问题。

在本文中,我将详细介绍最小二乘法在线性回归问题中的应用。

一、线性回归模型在介绍最小二乘法之前,先了解一下线性回归模型的基本形式。

假设我们有一个包含$n$个观测值的数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,其中$x_i$表示自变量,$y_i$表示因变量。

线性回归模型的一般形式如下:$$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_px_p+\epsilon$$其中,$\beta_0$表示截距,$\beta_1,\beta_2,\dots,\beta_p$表示自变量$x_1,x_2,\dots,x_p$的系数,$\epsilon$表示误差项。

我们希望通过数据集中的观测值拟合出一个线性模型,即确定$\beta_0,\beta_1,\dots,\beta_p$这些未知参数的值,使得模型对未知数据的预测误差最小化。

二、最小二乘法的思想最小二乘法是一种模型拟合的优化方法,其基本思想是通过最小化优化问题的目标函数来确定模型参数的值。

在线性回归问题中,我们通常采用最小化残差平方和的方式来拟合出一个符合数据集的线性模型。

残差代表观测值与模型估计值之间的差异。

假设我们有一个数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,并且已经选定了线性模型$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_p x_p$。

我们希望选择一组系数$\beta_0,\beta_1,\dots,\beta_p$,使得模型对数据集中的观测值的预测误差最小,即最小化残差平方和(RSS):$$RSS=\sum_{i=1}^n(y_i-\hat{y}_i)^2$$其中,$y_i$表示第$i$个观测值的实际值,$\hat{y}_i$表示该观测值在当前模型下的预测值。

从统计学看线性回归(1)——⼀元线性回归⽬录1. ⼀元线性回归模型的数学形式2. 回归参数β0 , β1的估计3. 最⼩⼆乘估计的性质 线性性 ⽆偏性 最⼩⽅差性⼀、⼀元线性回归模型的数学形式 ⼀元线性回归是描述两个变量之间相关关系的最简单的回归模型。

⾃变量与因变量间的线性关系的数学结构通常⽤式(1)的形式:y = β0 + β1x + ε (1)其中两个变量y与x之间的关系⽤两部分描述。

⼀部分是由于x的变化引起y线性变化的部分,即β0+ β1x,另⼀部分是由其他⼀切随机因素引起的,记为ε。

该式确切的表达了变量x与y之间密切关系,但密切的程度⼜没有到x唯⼀确定y的这种特殊关系。

式(1)称为变量y对x的⼀元线性回归理论模型。

⼀般称y为被解释变量(因变量),x为解释变量(⾃变量),β0和β1是未知参数,成β0为回归常数,β1为回归系数。

ε表⽰其他随机因素的影响。

⼀般假定ε是不可观测的随机误差,它是⼀个随机变量,通常假定ε满⾜:(2)对式(1)两边求期望,得E(y) = β0 + β1x, (3)称式(3)为回归⽅程。

E(ε) = 0 可以理解为ε对 y 的总体影响期望为 0,也就是说在给定 x 下,由x确定的线性部分β0 + β1x 已经确定,现在只有ε对 y 产⽣影响,在 x = x0,ε = 0即除x以外其他⼀切因素对 y 的影响为0时,设 y = y0,经过多次采样,y 的值在 y0 上下波动(因为采样中ε不恒等于0),若 E(ε) = 0 则说明综合多次采样的结果,ε对 y 的综合影响为0,则可以很好的分析 x 对 y 的影响(因为其他⼀切因素的综合影响为0,但要保证样本量不能太少);若 E(ε) = c ≠ 0,即ε对 y 的综合影响是⼀个不为0的常数,则E(y) = β0 + β1x + E(ε),那么 E(ε) 这个常数可以直接被β0 捕获,从⽽变为公式(3);若 E(ε) = 变量,则说明ε在不同的 x 下对 y 的影响不同,那么说明存在其他变量也对 y 有显著作⽤。

一元线性回归公式一元线性回归(SimpleLinearRegression)是一种简单的回归分析方法,用于研究两个定量变量之间的关系。

一元线性回归是指一个定量变量Y和一个自变量X之间的线性回归模型,它有一个参数β,用来表示X对Y的影响程度。

一元线性回归的公式如下:Y =0 +1X其中,β0表示Y的偏移量或均值,是X=0时Y的值;β1表示X对Y的影响程度,是X的系数。

一元线性回归的原理是通过拟合一条线来求解X和Y的关系,并计算出X对Y的影响程度。

通常,我们需要用到两个原则:最小二乘法(Least Squares)和最大似然估计(Maximum Likelihood)。

最小二乘法是一种优化方法,其目标是最小化残差的平方和。

残差是Y实际值与拟合模型计算值的差,残差的平方和就是拟合的均方差(Mean Squared Error,MSE)。

因此,最小二乘法的目标是最小化拟合均方差。

最大似然估计是一种概率模型估计方法,其目标是最大化模型似然函数。

似然函数是模型参数取某一特定值时,样本出现的概率,因此,最大似然估计的目标是最大化似然函数。

一元线性回归公式的应用非常广泛,可用于检测两个变量之间的因果关系,或者对比不同变量对另一变量的影响程度,或者预测变量值。

比如,在多重回归中,可以用一元线性回归来研究某一变量的影响程度;在财务分析中,可以用它来预测股票价格;在销售分析中,可以用它来预测某一产品的销售量;在投资分析中,可以利用它来估计投资回报率;在决策分析中,可以利用它来估计某一政策的收益;以及在其他应用中也可以利用它来预测变量值。

此外,一元线性回归还可以用于检验变量之间的关系,比如,用相关分析来检验两个变量之间的关系或使用显著性检验来检验X对Y 的影响是否有效。

对于一元线性回归而言,可以通过以下步骤来建模:首先,分析变量间的关系,看看X是否和Y有线性关系;其次,计算拟合系数β1和β0;最后,检验拟合模型的精度。

8.2.2 一元线性回归模型参数的最小二乘估计(第2课时)教学设计一、课时教学内容本节的主要内容是一元线性回归模型,它是线性回归分析的核心内容,也是后续研究两变量间的相关性有关问题的基础.通过散点图直观探究分析得出的直线拟合方式不同,拟合的效果就不同,它们与实际观测值均有一定的偏差.在经历用不同估算方法描述两个变量线性相关关系的过程中,解决用数学方法刻画从整体上看各观测点到拟合直线的距离最小的问题,让学生在此基础上了解更为科学的数据处理方式——最小二乘法,有助于他们更好地理解核心概念“经验回归直线”,并最终体现回归方法的应用价值.二、课时教学目标1.进一步掌握一元线性回归模型参数的统计意义,会用相关统计软件.2.了解非线性回归模型.3.会通过分析残差和利用R2判断回归模型的拟合效果.三、教学重点、难点1.重点:一元线性回归模型的基本思想,经验回归方程,最小二乘法.2.难点:求最小二乘估计,残差分析.四、教学过程设计环节一创设情境,引入课题例经验表明,一般树的胸径(树的主干在地面以上1.3m处的直径)越大,树就越高由于测量树高比测量胸径困难,因此研究人员希望由胸径预测树高,在研究树高与胸径之间的关系时,某林场收集了某种树的一些数据(表8.2-3),试根据这些数据建立树高关于胸径的经验回归方程.表8.2-3出散点,进而得到散点图,再根据散点图推断树高与胸径是否线性相关.如果是,再利用公式(2)计算出b ,a 即可.解:以胸径为横坐标、树高为纵坐标作散点图,得到图8.2-9.在图8.2-9中,散点大致分布在一条从左下角到右上角的直线附近,表明两个变量线性相关,并且是正相关,因此可以用一元线性回归模型刻画树高与胸径之间的关系.用d 表示胸径,h 表示树高,根据最小二乘法,计算可得经验回归方程为0.249314.84h d =+,相应的经验回归直线如图8.2-10所示,根据经验回归方程,由表8.2-3中胸径的数据可以计算出树高的预测值(精确到0.1)以及相应的残差,如表8.2-4所示/cm/cm表8.2-4以胸径为横坐标,残差为纵坐标,作残差图,得到图8.2-11.观察残差表和残差图,可以看到,残差的绝对值最大是0.8,所有残差分布在以横轴为对称轴、宽度小于2的带状区域内.可见经验回归方程较好地刻画了树高与胸径的关系,我们可以根据经验回归方程由胸径预测树高.【师生互动】教师让学生总结建立线性回归模型的一般步骤.建立线性回归模型的基本步骤:(1)确定研究对象,明确哪个变量是解释变量,哪个变量是响应变量.(2)画出解释变量与响应变量的散点图,观察它们之间的关系(如是否存在线性关系等).(3)由经验确定回归方程的类型.(4)按一定规则(如最小二乘法)估计经验回归方程中的参数.(5)得出结果后需进行线性回归分析. ①残差平方和越小,模型的拟合效果越好.②决定系数R 2取值越大,说明模型的拟合效果越好.需要注意的是:若题中给出了检验回归方程是否理想的条件,则根据题意进行分析检验即可. 环节二 观察分析,感知概念问题 人们常将男子短跑100 m 的高水平运动员称为“百米飞人”.表8.2-5给出了1968年之前男子短跑100 m 世界纪录产生的年份和世界纪录的数据,试依据这些成对数据,建立男子短跑100 m 世界纪录关于纪录产生年份的经验回归方程.表8.2-5【师生活动】师:以成对数据中的世界纪录产生年份为横坐标,世界纪录为纵坐标作散点图如下图所示.由散点图可以看出,散点看上去大致分布在一条直线附近,似乎可用一元线性回归模型建立经验回归方程.现在用丫表示男子短跑100m 的世界纪录,f 表示纪录产生的年份,你能利用一元线性回归模型求经验回归方程吗?在图8.2-12中,散点看上去大致分布在一条直线附近,似乎可用一元线性回归模型建立经验回归方程.用Y 表示男子短跑100 m 的世界纪录,t 表示纪录产生的年份,利用一元线性回归模型2,()0,()Y bt a e E e D e σ=++⎧⎨==⎩ 来刻画世界纪录和世界纪录产生年份之间的关系.根据最小二乘法,由表中的数据得到经验回归方程为1ˆ0.020*******.76913031yt =-+.① 将经验回归直线叠加到散点图,得到图8.2-13师:在散点图中画出经验回归直线,你能看出其中存在的问题吗? 生:得到下图:环节三 抽象概括,形成概念布特征,例如,第一个世界纪录所对应的散点远离经验回归直线,并且前后两时间段中的散点都在经验回归直线的上方,中间时间段的散点都在经验回归直线的下方,这说明散点并不是随机分布在经验回归直线的周围,而是围绕着经验回归直线有一定的变化规律,即成对样本数据呈现出明显的非线性相关的特征思考:你能对模型进行修改,以使其更好地反映散点的分布特征吗?仔细观察图8.2-12,可以发现散点更趋向于落在中间下凸且递减的某条曲线附近.回顾已有的函数知识,可以发现函数ln y x =-的图象具有类似的形状特征.注意到100 m 短跑的第一个世界纪录产生于1896年,因此可以认为散点是集中在曲线12()ln(1895)y f t c c t ==+-的周围,其中1c ,2c 为未知的参数,且20c <.【设计意图】目的是使学生明白,不是所有的两个变量的关系都适合用一元线性回归模型刻画.师:这说明散点并不是随机分布在经验回归直线的周围,而是围绕着经验回归直线有一定的变化规律,即成对样本数据呈现出明显的非线性相关的特征.师:你能对模型进行修改,以使其更好地反映散点的分布特征吗?生:仔细观察散点图,可以发现散点更趋向于落在中间下凸且递减的某条曲线附近.回顾已有的函数知识,可以发现函数ln y x =-的图象具有类似的形状特征.【设计意图】提醒学生需熟悉常见非线性函数模型的特点.用上述函数刻画数据变化的趋势,这是一个非线性经验回归函数,其中1c ,2c 是待定参数.现在问题转化为如何利用成对数据估计参数1c 和2c .为了利用一元线性回归模型估计参数1c 和2c ,我们引进一个中间变量x ,令ln(1895)x t =-.通过ln(1895)x t =-,将年份变量数据进行变换,得到新的成对数据(精确到0.01),如表8.2-6所示.表8.2-6型和新的成对数据,对参数1c 和2c 作出估计,进而可以得到Y 关于t 的非线性经验回归方程. 在直角坐标系中画出表8.2-6中成对数据的散点图,如图8.2-14所示,散点的分布呈现出很强的线性相关特征.因此,用一元线性回归模型212()0,()Y c x c uE u D u δ=++⎧⎨==⎩拟合表8.2-6中的成对数据,得到经验回归方程2ˆ0.426439811.8012653yx =-+,(*) 再在图8.2-14中画出(*)式所对应的经验回归直线,得到图8.2-15.(1).直接观察法.在同一坐标系中画出成对数据散点图、非线性经验回归方程②的图象(蓝色)以及经验回归方程①的图象(红色).图8.2-15表明,经验回归方程(*)对于表8.2-6中的成对数据具有非常好的拟合精度.将图8.2-15习图8.2-13进行对比,可以发现x 和Y 之间的线性相关程度比原始样本数据的线性相关程度强得多.将ln(1895)x t =-代入(*)式,得到由创纪录年份预报世界纪录的经验回归方程2ˆ0.4264398ln(1895)11.8012653yt =--+ ② 在同一坐标系中画出成对数据散点图、非线性经验回归方程②的图象(蓝色)以及经验回归方程①的图象(红色),表明非线性经验回归方程②对于原始数据的拟合效果远远好于经验回归方程①.【师生活动】师:对于通过创纪录时间预报世界纪录的问题,我们建立了两个回归模型,得到了两个经验回归方程①②,你能判断哪个经验回归方程拟合的精度更好吗?生:散点图中各散点都非常靠近②的图象,表明非线性经验回归方程②对于原始数据的拟合效果远远好于经验回归方程①.【设计意图】分析两个模型的拟合效果,由比较不同回归模型拟合效果的需要,引出评价模型好坏的指标.环节四 辨析理解 深化概念下面通过残差来比较这两个经验回归方程对数据刻画的好坏.在表8.2-5中,用i t 表示编号为i 的年份数据,用i y 表示编号为i 的纪录数据,则经验回归方程①和②的残差计算公式分别为ˆˆ0.020*******.76913031,1,2,,8;0.4264398ln(1895)11.8012653,1,2,,8.i i i i i i ey t i y t i u=+-==+--=图8.2-15(2).残差分析:残差平方和越小,模型拟合效果越好.两个经验回归方程的残差(精确到0.001)如表8.2-7所示.观察各项残差的绝对值,发现经验回归方程②远远小于①,即经验回归方程②的合效果要远远好于①.表8.2-5的绝对值比另一个模型的小,而另一些散点的情况则相反.可以通过比较残差的平方和来比较两个模型的效果.由82110.)669(i i Q e ==≈∑,8221()ˆ0.004i i Q u==≈∑. 可知2Q 小于1Q .因此在残差平方和最小的标准下,非线性回归模型212ln(1895)()0,()Y c t c uE u D u δ=-++⎧⎨==⎩ 的拟合效果要优于一元线性回归模型 的拟合效果.(3).利用决定系数2R 刻画回归效果.也可以用决定系数2R 来比较两个模型的拟合效果,2R 的计算公式为22121()()ˆ1niii nii y yR y y ==-=--∑∑在2R 表达式中,21()n i i y y =-∑与经验回归方程无关,残差平方和21()ˆni i i y y=-∑与经验回归方程有关.因此2R 越大,表示残差平方和越小,即模型的拟合效果越好;2R 越小,表示残差平方和越大,即模型的拟合效果越差.由表8.2-7容易算出经验回归方程①和②的2R 分别约为0.7325和0.9983,因此经验回归方程②的刻画效果比经验回归方程①的好很多.(4) 用新的观测数据来检验模型的拟合效果另外,我们还可以用新的观测数据来检验模型的拟合效果.事实上,我们还有1968年之后的男子短跑100 m 世界记录数据,如表8.2-8所示.表8.2-8回归直线(红色),以及经验回归方程②所对应的经验回归曲线(蓝色),得到图8.2-17显然绿色散点分布在蓝色经验回归曲线的附近,远离红色经验回归直线,表明经验回归方程②对于新数据的预报效果远远好于①.环节五 概念应用,巩固内化思考:在上述问题情境中,男子短跑100 m 世界纪录和纪录创建年份之间呈现出对数关系,能借助于样本相关系数刻画这种关系的强弱吗? 在使用经验回归方程进行预测时,需要注意下列问题:(1)经验回归方程只适用于所研究的样本的总体.例如,根据我国父亲身高与儿子身高的数据建立的经验回归方程,不能用来描述美国父亲身高与儿子身高之间的关系.同样,根据生长在南方多雨地区的树高与胸径的数据建立的经验回归方程,不能用来描述北方干旱地区的树高与胸径之间的关系.(2)经验回归方程一般都有时效性.例如,根据20世纪80年代的父亲身高与儿子身高的数据建立的经验回归方程,不能用来描述现在的父亲身高与儿子身高之间的关系.(3)解释变量的取值不能离样本数据的范围太远.一般解释变量的取值在样本数据范围内,经验回归方程的预报效果会比较好,超出这个范围越远,预报的效果越差.(4)不能期望经验回归方程得到的预报值就是响应变量的精确值.事实上,它是响应变量的可能取值的平均值.师生互动:学生总结建立非线性回归模型的基本步骤.教师及时补充完善.建立非线性经验回归模型的基本步骤:1.确定研究对象,明确哪个是解释变量,哪个是响应变量;2.由经验确定非线性经验回归方程的模型;3.通过变换,将非线性经验回归模型转化为线性经验回归模型;4.按照公式计算经验回归方程中的参数,得到经验回归方程;5.消去新元,得到非线性经验回归方程;6.得出结果后分析残差图是否有异常.判断模型的拟合效果的依据如下:①残差平方和越小,模型的拟合效果越好.②决定系数斤取值越大,说明模型的拟合效果越好.需要注意的是:若题中给出了检验回归方程是否理想的条件,则根据题意进行分析检验即可.【设计意图】探索非线性回归分析问题的求解方法,培养学生的数学应用意识.环节六归纳总结,反思提升1.本节课学习的概念有哪些?(1)非线性回归模型.(2)决定系数.2.比较两个模型拟合效果的方法:(1)残差法,残差越大,拟合效果越差;残差越小,拟合效果越小.(2)R2法,R2越接近1,拟合效果越好,R2越接近0,拟合效果越差.3.对于线性回归模型与非线性回归模型,当数据的散点图分布在直线带状区域内,则选用线性回归模型刻画;当数据的散点分布在曲线带状区域内,要先对数据进行适当变换,再利用线性回归模型进行拟合.4. 在解决问题时,用到了哪些数学思想?转化与化归思想.【设计意图】通过总结,让学生进一步巩固本节所学内容,提高概括能力。