马尔科夫预测与决策

- 格式:ppt

- 大小:3.02 MB

- 文档页数:47

在控制理论中,马尔可夫决策过程(Markov Decision Process, MDP)是一个经典的数学模型,用于描述具有随机性和不确定性的决策问题。

在MDP中,智能体通过采取一系列动作来与环境互动,从而获得最大的累积奖励。

而在解决MDP问题时,策略迭代算法和模型预测控制是两种常用的方法。

本文将对这两种方法进行比较和分析。

策略迭代算法(Policy Iteration)是一种经典的动态规划方法,用于求解MDP问题的最优策略。

其基本思想是通过不断更新策略和值函数来逼近最优策略。

具体而言,策略迭代算法包括两个主要步骤:策略评估和策略改进。

在策略评估阶段,算法会根据当前策略对值函数进行估计,以确定每个状态的值;在策略改进阶段,算法会根据当前值函数来改进策略,以使得价值函数更加接近最优价值函数。

通过不断迭代这两个步骤,策略迭代算法最终能够找到最优策略。

与策略迭代算法相比,模型预测控制(Model Predictive Control, MPC)是一种基于模型的控制方法,广泛应用于工业自动化领域。

在MDP问题中,MPC方法将系统建模为一个有限步长的预测模型,并通过对未来状态的预测来计算当前最优的控制策略。

MPC方法具有很强的数学基础和稳定性,能够有效处理不确定性和噪声,并且对于多变量和多约束的系统也能够得到很好的应用。

然而,策略迭代算法和模型预测控制方法各有其优缺点。

策略迭代算法的优点在于其简单直观,易于理解和实现。

同时,策略迭代算法能够收敛到全局最优解,保证在有限步内得到最优策略。

然而,策略迭代算法的缺点在于其需要对整个状态空间进行遍历,当状态空间较大时,算法的计算复杂度会急剧增加。

相比之下,模型预测控制方法的优点在于其对于不确定性和噪声的鲁棒性较强,能够在实际工程中得到有效应用。

另外,MPC方法还可以对约束条件进行自然的处理,使得系统更加稳定可靠。

然而,MPC方法的缺点在于其需要建立准确的系统模型,并且对于大规模系统的控制问题,计算复杂度也会很高。

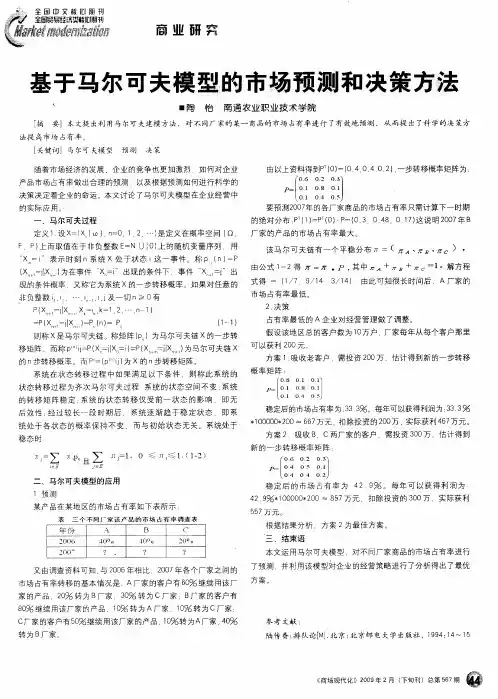

基于马尔可夫决策法的企业市场占有率预测内容摘要:马尔可夫决策法是一种对随机过程未来状况进行预测的有效方法。

本文简要介绍了马尔可夫过程和马尔可夫链,并举例说明了如何利用马尔可夫决策法对企业市场占有率进行预测。

关键词:马尔可夫决策法市场占有率转移概率矩阵马尔可夫决策法概述马尔可夫决策法是指决策者根据每个时刻观察到的状态,从可用的行动集合中选用一个行动作出决策,系统未来的状态是随机的,并且其状态转移概率具有马尔可夫性。

决策者根据新观察到的状态,再作出新的决策,依此反复地进行。

马尔可夫性是指一个随机过程未来发展的概率规律仅仅取决于前一时刻的状态,而与观察之前的历史无关的性质。

也就是说:过程在时刻t0所处的状态为已知的条件下,过程在时刻t>t0所处状态的条件分布与过程在时刻t0之前所处的状态无关。

马尔可夫决策法起源于俄国数学家安德烈·马尔可夫对成链的试验序列的研究。

1907年马尔可夫发现某些随机事件的第n次试验结果常决定于它的前一次(n-1次)试验结果,马尔可夫假定各次转移过程中的转移概率无后效性,用以对物理学中的布朗运动作出数学描述,此后又由一些数学家经过不断的研究后建立了马尔可夫过程的一般理论,并把时间序列转移概率的链式称为马尔可夫链。

如果用分布函数来表述马尔可夫性,假设随机过程{X(t),t∈T}的状态空间为,若对时间t的任意n个数值t1<t2<… <tn(n≥3,ti∈,i=1,2,…,n),在条件X(ti)=xi(xi ∈,i=1,2,…,n-1)下,X(tn)的条件分布函数等于在条件X(tn-1)=xn-1下X(tn)的条件分布函数,即:p{X(tn)≤xnIX(t1)=x1,X(t2)=x2,…,X(tn-1)=xn-1}=p{X(tn)≤xnIX(tn-1)=xn-1}(xn∈R)则称随机过程{X(t),t∈T}具有马尔可夫性,并称此随机过程为马尔可夫过程。

马尔可夫决策过程(Markov Decision Process,MDP)是一种基于随机过程的数学模型,用于描述随机系统的状态转移和决策过程。

它被广泛应用于人工智能、运筹学、控制理论等领域。

在预测模型中,利用马尔可夫决策过程进行预测可以帮助我们更准确地预测未来的状态和行为,从而提高决策的准确性和效率。

马尔可夫决策过程的基本原理是,系统的状态会在不同的状态之间转移,并且每个状态下都存在一定的概率,这种转移过程是随机的。

而在每个状态下,我们可以采取不同的决策,即采取不同的动作。

每个动作都会产生不同的奖励,奖励的大小和方向会受到环境的影响。

基于这些条件,我们希望通过马尔可夫决策过程来找到一个最优的策略,使得系统在不同状态下采取不同的动作,从而最大化长期的累积奖励。

在利用马尔可夫决策过程进行预测时,我们首先需要定义系统的状态空间、动作空间、转移概率以及奖励函数。

通过这些定义,我们可以建立系统的状态转移模型和奖励模型,从而可以利用动态规划、强化学习等方法来求解最优策略。

在实际应用中,马尔可夫决策过程可以用于各种预测问题,如股票交易、网络流量控制、机器人路径规划等。

下面将以股票交易预测为例,介绍如何利用马尔可夫决策过程进行预测。

首先,我们需要定义股票交易系统的状态空间。

状态空间可以包括股票价格、成交量、技术指标等多个维度的变量。

然后,我们需要定义动作空间,即可以采取的交易策略,如买入、卖出、持有等。

接下来,我们需要确定状态转移概率和奖励函数。

状态转移概率可以通过历史数据分析得到,奖励函数可以根据交易的盈亏情况来定义。

在建立了马尔可夫决策过程模型后,我们可以利用动态规划算法来求解最优策略。

动态规划算法可以通过迭代的方式来逐步求解最优值函数和最优策略。

在实际应用中,我们还可以采用强化学习算法,如Q学习、深度强化学习等,来求解最优策略。

通过利用马尔可夫决策过程进行预测,我们可以得到一个最优的交易策略,从而在股票交易中获得更高的收益。

决策与预测第八章马尔可夫预测马尔可夫预测(Markov Prediction)是一种基于马尔可夫模型的预测方法。

马尔可夫模型是一种具有状态转移特性的随机过程,即当前状态的发生只与前一个状态有关,与之前的状态无关。

马尔可夫预测依据这一性质,通过对已有的状态序列进行分析,来预测未来可能的状态。

马尔可夫预测在许多领域都有应用,比如天气预测、股市预测、自然语言处理等。

在天气预测中,我们可以将天气分为晴天、阴天、雨天等若干个状态,通过观察历史天气数据,建立马尔可夫模型,从而预测未来几天的天气情况。

在股市预测中,我们可以将股票价格分为涨、跌、平稳等若干个状态,通过分析历史股价数据,建立马尔可夫模型,从而预测未来股票价格的走势。

马尔可夫预测的关键是确定马尔可夫链的阶数。

马尔可夫链的阶数决定了当前状态只与前几个状态有关。

一般情况下,阶数越高,预测的准确性越高,但计算复杂度也越高。

选择合适的阶数需要根据具体问题进行权衡。

马尔可夫预测的关键步骤包括状态定义、状态转移矩阵的估计和预测结果生成。

首先,需要将观测序列转化为状态序列。

状态定义需要根据具体问题确定,通常是将连续的观测值离散化为若干个状态。

然后,需要估计马尔可夫链的状态转移矩阵。

状态转移矩阵描述了从一个状态转移到另一个状态的概率。

可以通过历史数据来估计状态转移矩阵,常用的方法有最大似然估计和贝叶斯估计。

最后,通过状态转移矩阵和当前的状态,可以通过马尔可夫链进行状态的预测。

马尔可夫预测有一些优点和限制。

优点是简单易用,不需要太多的领域知识,只需要一些历史数据。

同时,马尔可夫预测可以处理非线性和非平稳的数据,具有一定的适应性。

然而,马尔可夫预测也有一些限制。

首先,马尔可夫模型假设当前状态只与前一个状态相关,而与之前的状态无关,这个假设在一些情况下可能不成立。

其次,马尔可夫模型对于状态转移矩阵的估计需要大量的历史数据,否则预测的准确性可能较低。

在实际应用中,马尔可夫预测通常与其他方法结合使用,以提高预测的准确性。

马尔可夫决策过程(MDP)是一种用于研究序贯决策问题的数学框架,通过定义状态、动作、奖励函数等元素来描述一个决策过程。

在MDP中,智能体根据当前状态选择动作,与环境交互,得到相应的奖励,并进入下一个状态。

马尔可夫决策过程的目标是寻找最优策略,使得长期累积奖励最大化。

策略迭代算法是一种经典的动态规划算法,用于求解MDP中的最优策略。

其基本思想是通过不断迭代改进策略,直至收敛于最优策略。

在每一轮迭代中,策略迭代算法分别进行策略评估和策略改进两个步骤。

首先进行策略评估,估计当前策略下各状态的价值函数;然后进行策略改进,根据已经估计出的价值函数,更新策略,使得价值函数更接近最优值。

不断循环迭代,最终得到最优策略。

模型预测控制(MPC)算法是一种用于控制系统的优化算法,通过对系统的数学模型进行预测和优化,实现对系统的有效控制。

在MPC算法中,首先需要建立系统的状态空间模型,然后对未来一段时间内系统的状态进行预测,接着根据预测结果计算出最优控制输入,使得系统在未来的一段时间内达到最优性能。

从算法原理的角度来看,策略迭代算法和模型预测控制算法有一些相似之处。

它们都是通过不断迭代的方式,逐步优化策略或控制输入,以达到最优的目标。

但是在具体应用和领域中,两者还是有一些显著的差异。

首先从应用领域来看,策略迭代算法主要应用于强化学习领域,用于求解MDP中的最优策略。

而模型预测控制算法主要应用于控制系统领域,用于对动态系统进行建模和控制。

其次,在算法的实现和求解过程中也存在一些差异。

策略迭代算法通常需要对MDP进行离散化处理,将连续状态空间离散化为有限状态空间,然后再进行迭代计算。

而模型预测控制算法则需要建立系统的数学模型,并进行预测和优化,涉及到对连续状态空间的处理和优化。

另外,从算法的性能和稳定性来看,模型预测控制算法在一些实际控制系统中表现出更好的性能和鲁棒性。

由于其基于系统的数学模型进行预测和优化,可以更好地适应系统的动态特性和外部干扰。